Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO -

Similars in Google

Similars in Google

Share

Revista Colombiana de Psiquiatría

Print version ISSN 0034-7450

rev.colomb.psiquiatr. vol.40 no.3 Bogotá July/Sept. 2011

Epistemología filosofía de la mente y bioética

El desarrollo conceptual de la ciencia cognitiva. Parte I

The Conceptual Development of Cognitive Science. Part I

Marco Fierro1

1Médico psiquiatra. M. Phil. Profesor de psiquiatría, Universidad del Rosario, Bogotá, Colombia.

Conflictos de interés: El autor manifiesta que no tiene conflictos de interés en este artículo.

Correspondencia

Marco Fierro

Departamento de Psiquiatría

Universidad del Rosario

Calle 103A No. 21-49

Bogotá, Colombia

marcofierro2222@yahoo.com

Recibido para evaluación: 30 de abril del 2011. Aceptado para publicación: 22 de julio del 2011

Resumen

Introducción: La ciencia cognitiva se ha constituido en el paradigma mental más influyente de finales del siglo XX y comienzos del XXI. Sus conceptos, el planteamiento de los problemas y las soluciones a estos han sufrido modificaciones significativas en el curso de pocos años. Método: Presentación y discusión de los fundamentos de la ciencia cognitiva en cuatro etapas: los inicios, el cognitivismo clásico, el conexionismo y la corporalización-en acción. Desarrollo y conclusión: Los inicios están marcados por la construcción de las computadoras modernas y la aparición de la teoría de la información. El cognitivismo clásico comenzó en 1956 con la noción de que todos los sistemas procesadores de información, incluido el cerebro humano, comparten los mismos principios. A partir de la analogía entre la computadora y el cerebro, se consideró apropiado estudiar la mente como si se tratara de un software. El conexionismo, también llamado procesamiento distribuido en paralelo o de redes neuronales, permite explicar la rapidez con que se realizan los procesos cognitivos y su resistencia a los daños. No trabaja con símbolos, sino con patrones de activación y desactivación de las unidades componentes y de transmisión de señales entre ellas. En percepción y memoria se encuentran los casos típicos de tareas realizadas por redes neuronales, por ejemplo, reconocimiento de patrones (rostros, palabras a partir de letras, etc.).

Palabras clave: Ciencia cognitiva, cognición, computación, conexionismo, cognitivismo, representación.

Abstract

Introduction: Cognitive science has become the most influential mental paradigm of the late twentieth and early twenty-first centuries. Its concepts and approach to problems and solutions have changed significantly in the course of a few years. Method: The fundamental concepts of cognitive science are presented and discussed, divided into four stages: The beginnings, classical cognitivism, connectionism, and embodiment-enaction. Development and Conclusion: The beginnings are marked by the construction of modern computers and the advent of information theory. Classical cognitivism began in 1956 with the notion that all information processing systems, including the human brain, share the same principles. From the analogy between computer and brain, it was considered appropriate to study the mind as if it were software. Connectionism, also called parallel distributed processing or neural networks get these names because of their underlying computational architecture. It helps explain the speed with which cognitive processes are performed and resistance to damage, being closer to biology. It does not work with representations, but with patterns of activation and deactivation of the component units and transmission of signals between them. Typical cases of tasks performed by neural networks are found in perception and memory, for example, pattern recognition (faces, words from letters, etc).

Key words: Cognitive science, cognition, computation, connectionism, cognitivism, representation.

Introducción

Se pueden introducir de varias maneras los conceptos centrales de la ciencia cognitiva. Una de ellas es comenzar con algún problema específico para luego adentrarse en los factores que lo expliquen y permitan su comprensión. Otra opción consiste en trazar un paralelo entre el modelo secuencial y el conexionista de procesamiento de señales con el fin de estudiar sus similitudes y diferencias; pero también se puede acudir a la historia para presentar y discutir los temas fundamentales. En este escrito se ha escogido la última, pues no sólo muestra la secuencia en la aparición de los conceptos, sino la manera en que las diversas disciplinas cognitivas han ejercido influencia entre ellas. En sentido estricto, no es un escenario de etapas históricas sucesivas en que una desaparece para dar lugar a la siguiente, sino más bien el relato del surgimiento de nuevas ideas que desnudan ciertos problemas de las anteriores y acrecientan la posibilidad de acercar los modelos a la biología y al mundo vivido. En consecuencia, las etapas segunda, tercera y cuarta (cognitivismo clásico, conexionismo y corporalización-enacción, respectivamente) tienen un comienzo, pero carecen de cierre, pues cada una de ellas sigue influyendo notoriamente hasta la actualidad en el ámbito académico y el de las aplicaciones prácticas.

Quizá sea más apropiado utilizar la expresión paradigma cognitivo para hablar de esta disciplina, pues se trata de un enfoque sobre lo mental, constituido por un conjunto de conocimientos con principios básicos, problemas y soluciones, claramente diferenciados de otros enfoques como el biológico, el psicoanalítico o el social. Pero, como es más frecuente encontrarla con la denominación de ciencia cognitiva, se ha preferido usar este nombre para el resto de la discusión. Habitualmente, la ciencia cognitiva se define como una perspectiva multidisciplinaria acerca de la mente humana y otros sistemas procesadores de información, cuyo fundamento es la similitud en los principios básicos subyacentes a dicho procesamiento en todos esos sistemas. Aunque se suele llamar ciencia (en singular), es más preciso utilizar el plural, pues está constituida por ciertas áreas de varias disciplinas, entre ellas: neurociencia, inteligencia artificial, psicología cognitiva, filosofía de la mente, lingüística y antropología.

La psicología cognitiva, en su concepción más tradicional, tiene como objeto estudiar los fenómenos mentales, con énfasis en los mecanismos de procesamiento de información involucrados en cada uno de ellos, desde la percepción, la memoria y el aprendizaje hasta la toma de decisiones, la planeación de acciones y la generación de la conducta. Vale la pena señalar que las caracterizaciones anteriores se ajustan bastante bien a las tres primeras etapas históricas de la ciencia cognitiva; pero, como se verá más adelante, son seriamente desafiadas por la última.

Los inicios

Según Varela (1), la historia de la ciencia cognitiva puede dividirse en varias etapas. Con algunas modificaciones a lo establecido por él, es posible decir que la primera, llamada cibernética, abarca los años 1940-1955, época en que aparecieron herramientas y teorías fundamentales para el desarrollo venidero. Se construyeron las computadoras modernas, que sentaron la base para la inteligencia artificial; se presentaron los primeros ejemplos de sistemas autoorganizados, y aparecieron la teoría general de los sistemas y la teoría de la información, esta última como un enfoque estadístico acerca de las señales y canales de comunicación. Como resultado surgió, en primer lugar, la idea de que las neuronas son dispositivos que pueden activarse y desactivarse, conectarse entre sí, y a través de esas conexiones realizar operaciones lógicas. Con ello, convierten el cerebro, como un todo, en una máquina de lógica. En segundo lugar, fue posible materializar una vieja idea, propuesta por Leibniz, de entender y convertir el razonamiento en una especie de cálculo.

En el decenio de 1920, el término computador se refería a un ser humano que realizaba cálculos. Poco después se inventaron máquinas capaces de hacer cálculos de manera automática y se les denominó computadoras; llevaban a cabo la tarea siguiendo un algoritmo, esto es, una serie de instrucciones, pasos o reglas claramente especificadas. Muy pronto fue obvio que las máquinas podían hacer mucho más que cálculos matemáticos. En general, las computadoras tienen la capacidad de computar o manipular símbolos o representaciones simbólicas siguiendo un algoritmo.

La máquina no entiende el significado de los símbolos, interactúa solamente con la forma de ellos (en este sentido, realiza operaciones formales), pero aun así es evidente su capacidad para realizar tareas inteligentes, esto es, aquellas que sólo los humanos pueden hacer. En cualquier tarea, los símbolos con que se alimenta la máquina son considerados información, la que a su vez se procesa y da lugar a un resultado; de ahí que sea posible denominar procesamiento de información, al trabajo que ella realiza.

En 1950, Turing se preguntaba si las máquinas pueden pensar (2). Para resolver la duda propuso que una persona, utilizando una terminal de computador, formulara un cierto número de preguntas a dos interlocutores diferentes a quienes no podía ver, uno de ellos humano y el otro una máquina. Si quien preguntaba no conseguía diferenciar la fuente de las respuestas más allá del azar, si no lograba saber cuándo provenían de la máquina y cuándo del humano, la máquina pasaba la prueba. Este juego se conoce desde entonces como el test de Turing, y durante muchos años fue tomado como criterio de inteligencia artificial.

El test sirvió también para mostrar que los materiales con los que está construida una máquina de computación son irrelevantes para entender su comportamiento, lo que cuenta es el programa que se corre en ella. Es más, un mismo programa puede implementarse en máquinas diferentes o una misma máquina puede correr distintos programas. Visto así, el estudio de la inteligencia, sea humana o artificial, debía centrarse en el programa o en el software. Esto, aplicado al ámbito psicológico, quiere decir que el foco de interés no es el cerebro, en su anatomía o fisiología, sino el equivalente a los programas que en éste se procesan.

En el panorama de la psicología, el conductismo había dominado, junto con el psicoanálisis, buena parte de la primera mitad del siglo XX. Al menos en su versión más radical, el conductismo aspiraba a erradicar todo lo mental de la psicología. La mente era un mito, no se necesitaba de ella para explicar la conducta; bastaba la acción mecánica del sistema nervioso. La única forma de hacer ciencia en psicología consistía en el estudio del comportamiento observable de los organismos. De hecho, dos de los teóricos del conductismo más conocidos fijaban su posición en este sentido. Watson era partidario de un modelo fuerte basado exclusivamente en el estímulo y la respuesta; y, según Skinner, no había lugar para postular mecanismos internos intermediarios entre los miembros de dicho dúo. El objetivo del conductismo, y a la vez su gran problema, fue tratar de dar cuenta de los fenómenos mentales sin apelar a la mente, pues no pudo deshacerse completamente de ella e incluso del interior mismo de la disciplina surgieron los ataques.

Según el conductismo tradicional, las conductas complejas podían entenderse a partir del encadenamiento de estímulos y respuestas, explicación que dejó de ser convincente en la década de los cincuenta. Se comenzó entonces a plantear la existencia de funciones centrales encargadas de planear y coordinar conjuntos de acciones. Además, se introdujeron variables intermediarias entre el estímulo y la respuesta, que trasformaron el conductismo inicial en uno de tipo mediador. Como resultado, se abrió la puerta para que los procesos que ocurrían en el interior del cerebro tuvieran un papel causal en el comportamiento. Sin embargo, los teóricos de esta nueva perspectiva conductista carecían de un lenguaje apropiado para estudiar y trabajar con los procesos mediadores, situación remediada con la llegada del procesamiento de información: el estímulo se convirtió en mensaje entrante (input), la respuesta en mensaje saliente (output) y los procesos intermediarios en procesamiento de información.

Segunda etapa: el modelo cognitivo clásico

También se conoce con los nombres de modelo simbolista, representacionalista o de procesamiento secuencial, este último derivado de la arquitectura computacional que lo sustenta. Durante esta etapa se estableció el modelo cognitivista clásico. El año 1956 fue clave y se considera la fecha de su nacimiento. Voces provenientes de campos tan diversos como la informática (Allen Newell), la psicología (George Miller), la inteligencia artificial (Marvin Minsky y John McCarthy), la economía (Herbert Simon) y la lingüística (Noam Chomsky) afirmaban que la inteligencia humana, al igual que cualquier otro tipo de inteligencia, funciona de forma similar a un computador. Particularmente importante en ese año fue el simposio sobre teoría de la información realizado en el Massachusetts Institute of Technology (MIT), donde Newell y Simon presentaron el trabajo titulado La máquina de la teoría lógica, la primera demostración completa de un teorema hecha por un computador. En ese mismo simposio, Chomsky introdujo su modelo transformacional de la gramática y Miller postuló que las representaciones mentales podían entenderse como fragmentos de información codificados y descodificados en la mente (3).

Los resultados de los trabajos anteriores llevaron a concluir que todos los sistemas que procesan información siguen los mismos principios, ya se trate de sistemas biológicos (como los humanos) o de silicio y metal (como las computadoras), por lo que, según Simon, el estudio de dichos principios constituye un campo unificado de estudio: la ciencia cognitiva. La fórmula parece sencilla: cualquier tarea llevada a cabo por los humanos y considerada inteligente, por compleja que sea, puede descomponerse en operaciones simples realizables de manera puramente mecánica. Por otra parte, poco cuentan los materiales con que están construidos los sistemas, pues importan más los algoritmos o instrucciones para procesar, que ahora pasan a llamarse programas. Si bien para todos es obvio que el hardware humano es el cerebro, en términos estrictamente teóricos, siquiera sería necesario estudiarlo, pues lo que debería indagarse -si se quiere conocer la mente- es el software.

El cognitivismo clásico está basado en la idea de que la cognición es un proceso computacional que trabaja sobre símbolos o representaciones y lo hace de manera secuencial. Los estados mentales representan o simbolizan objetos y estados de cosas del mundo, y los procesos computacionales operan sobre esos símbolos o representaciones, los manipulan y trasforman de acuerdo con ciertas reglas y producen como resultado otro estado mental o una determinada acción. El papel central que desempeñan los símbolos o las representaciones en el cognitivismo clásico hace que a éste también se le denomine simbolista o representacionalista.

El representacionalismo fue aceptado casi unánimemente por la ciencia y la filosofía hasta la década de los setenta. Como punto de partida se plantea que hay un mundo externo, objetivo, dado previamente, susceptible de ser conocido. A su vez, existe un sujeto capaz de observarlo y conocerlo a través de las representaciones que de él se forma. Quizá la percepción visual sea el mejor ejemplo, pues se supone que cada vez que se dirige la mirada al mundo, se constituye internamente una imagen de él que lo representa. La visión funcionaría de manera parecida a una cámara fotográfica o de video que guarda los detalles de cada escena captada. Si se pasa de la percepción al pensamiento, o cualquier otra función mental, el esquema permanece igual. Cuando se entiende algo mediante el pensamiento, internamente también se forma una representación del mundo, esta vez no con imágenes visuales, sino mediante símbolos mentales parecidos o iguales al lenguaje.

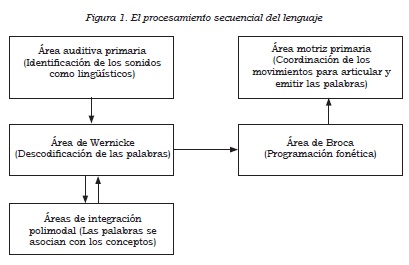

La expresión arquitectura computacional se refiere a la manera en que las unidades componentes de un sistema procesador de información están conectadas y transmiten las señales. En el caso del cognitivismo clásico, corresponde al procesamiento secuencial, esto es, una operación sigue a otra, pero sólo se hace una a la vez. Por ejemplo, de acuerdo con una versión simplificada del modelo clásico del lenguaje (4), el procesamiento de las palabras en el cerebro sigue un curso que comienza con la identificación de los sonidos lingüísticos en la corteza auditiva primaria. De ahí pasan al área de Wernicke, lugar donde se descodifican las palabras. Esta última se comunica con áreas de asociación polimodal, localizadas en varias regiones del cerebro; allí las palabras se asocian con los conceptos y adquieren un significado. Enseguida, vuelven al área de Wernicke y pasan unidireccionalmente al área de Broca. En esta última los conceptos se transforman en palabras; es decir, se realiza la programación fonética, la que se remite al área motriz primaria encargada de coordinar los movimientos precisos de los órganos implicados en la articulación y emisión de las palabras (Figura 1).

En el esquema de la Figura 1 es posible seguir secuencialmente el camino del procesamiento lingüístico. Las palabras, una vez pasan por el oído, se convierten en símbolos que sufren una serie de transformaciones. En cada paso se realizan operaciones o computaciones de acuerdo con una serie de reglas, por ejemplo, se descodifican las palabras, se programa la fonética de lo que se va a emitir, etc. Se trata de trasformaciones combinatorias (formales) de los símbolos, mediante la lógica, sin tener en cuenta su contenido semántico (su significación), aunque se postula que la semántica es preservada a lo largo del proceso, pues se supone que todo cambio formal conlleva también un cambio en la significación.

Considerar la mente un software que opera sobre símbolos o representaciones internos está de acuerdo con la idea de que los estados mentales representan el mundo y pueden explicar causalmente las acciones; explicación que cuenta con las ventajas de ser lineal y cercana al sentido común. Por ejemplo, en circunstancias normales, mi deseo de tener x, junto con la creencia de que al hacer y obtengo x, me llevan a hacer y. Si deseo tomar una ducha y tengo la creencia de que al abrir la llave de la regadera consigo el agua para tal fin, mi conducta será precisamente abrir esa llave. El problema de esta explicación radica en que el software mental procesa los símbolos mediante reglas, un procesamiento netamente sintáctico; pero los símbolos tienen un contenido semántico que debe preservarse a través del procesamiento.

Para ejemplificarlo de una manera sencilla: si deseo repartir seis naranjas entre tres niños y para ello utilizo una calculadora, el resultado es dos, pero cómo hacer para que la máquina tenga presente que la operación se refiere a naranjas y niños, y tiene un fin práctico. La calculadora opera con las reglas de la división (equivalentes a la sintaxis de los símbolos), pero no puede saber que está dividiendo naranjas entre niños (equivalente al contenido semántico de los símbolos).

El cognitivismo clásico adoptó la metáfora del computador. La mente es un programa de software que corre en un hardware cerebral. La idea más simple de un ser humano como procesador de información consiste en imaginarlo como un sistema que recibe información del entorno (percepción), la convierte en símbolos que procesa de acuerdo con un algoritmo (pensamiento) y actúa siguiendo los resultados obtenidos (conducta). El procesamiento de los símbolos se hace de una manera lineal, tanto que podrían seguirse las transformaciones que sufren (como si se movilizaran por una carretera), a través de las diferentes operaciones computacionales. Vale la pena aclarar que la división entre software (mente) y hardware (cerebro) no debe entenderse como un dualismo de sustancias. Para todos los cognitivistas está claro que al hablar del software se alude al funcionamiento del cerebro, pero no descrito en términos anatómicos o fisiológicos, sino computacionales.

Los programas computacionales son un conjunto de reglas para manipular símbolos con el fin de producir un resultado, por ejemplo, resolver un problema algebraico, emitir un diagnóstico o escoger la vía más rápida entre dos lugares. En este sentido, la resolución de problemas abstractos es el prototipo de las conductas que pueden ser explicadas en términos de programas. El éxito al afrontar este tipo de tareas llevó a algunos a olvidar que la figura de la mente como computadora es más parecida a la metáfora que a la analogía. De todas formas, no se puede pasar por alto que se trató en su momento de una nueva concepción del ser humano como máquina de computación y un nuevo lenguaje para hablar sobre los procesos mentales. De hecho, definió y enfocó el objetivo de la psicología en conocer cómo procesan información los seres humanos.

Según Leahey (5), el resto de la historia de la etapa cognitivista clásica sigue de la siguiente manera. George Miller comenzó a utilizar conceptos de procesamiento de información en el estudio de la memoria y la atención humanas en su texto clásico de 1956 El mágico número siete más o menos dos: de ciertos límites en nuestra capacidad de procesar información. En cuanto a la psicología, en 1957, Herbert Simon pronosticó que diez años después sería una rama de las ciencias de los computadores y las teorías psicológicas se redactarían en forma de programas de computador. Neisser, en 1967, observaba que el presagio de Simon no se cumplió, pero desembocó en un renacer de la psicología cognitiva en la medida en que se fue aceptando en su interior la similitud entre humano y computador.

A finales del decenio de los sesenta surgió la psicología cognitiva en su forma actual. Cognitive Psychology de Neisser (6) es considerada la obra que la funda, y de hecho en ella se acuñó el término. La teoría del procesamiento de información se convirtió en el fundamento y terminó suplantando la versión mediadora del conductismo. En los años setenta se fundaron algunas de las revistas más importantes como Cognitive Psychology, en 1970; Cognition, en 1972, y Cognitive Science, en 1977. En 1979, Lachman (7) afirmaba que la revolución cognitiva se había completado y vislumbraba un periodo de calma científica en la psicología: era el triunfo del paradigma cognitivo. Para entonces, la psicología cognitiva fue redefinida como el estudio del modo en que las personas captan información, la codifican y recuerdan, toman decisiones, transforman sus estados cognitivos internos y los traducen al exterior en conductas.

De las bases conceptuales del cognitivismo clásico, las que más críticas han recibido son las relacionadas con el representacionalismo y el significado. En cuanto al primero, la idea de que la función de los sistemas cognitivos es elaborar representaciones del mundo ha sido fuertemente cuestionada tanto desde la filosofía (8) como desde la inteligencia artificial (9,10). Es más benigna esta última al reconocer que en algunos casos el concepto de representación tiene sentido y cumple una función explicativa. Van Gelder (11), por ejemplo, admite que “seguramente, la cognición, en los casos sofisticados, implica representación y procesamiento secuencial; aunque tales fenómenos son mejor comprendidos cuando se los ve emergiendo de un sustrato dinámico que cuando se los ve como constituyentes del nivel básico de la actuación cognitiva”.

En lo atinente al segundo blanco de críticas, es claro que el procesamiento de información se realiza solamente sobre la forma de los símbolos, pero no sobre su significado. De hecho, para un computador los símbolos no se refieren a nada, no tienen un sentido; adquieren un significado solamente cuando un ser humano sentado al frente de la pantalla los aprehende y utiliza, es decir, cuando hay un consumidor. El modelo cognitivista simbolista trata de superar este problema postulando que la semántica (el significado) se preserva a través de la sintaxis (la transformación de símbolos), pero no es claro cómo sucede.

Ahora bien, si el significado implica por principio la existencia de un consumidor, de alguien para quien esos símbolos significan algo, se impone la necesidad de incluirlo en el modelo. Los símbolos mentales internos tendrían que ponerse a disposición de un consumidor interno, de un homúnculo o algo como un fantasma en el interior de la máquina (12). Además, habría una especie de escenario interior que algunos han llamado teatro cartesiano (13), donde ocurren el pensamiento y demás fenómenos mentales. Allí se representaría el mundo, a partir de la información proveniente de los sentidos, para que ese homúnculo o fantasma piense, sienta, razone, decida, etc. El resultado es una regresión al infinito, pues el homúnculo tendrá a su vez un escenario interior donde transcurren sus propios fenómenos mentales, incluido -desde luego- la presencia de otro homúnculo. No parece haber salida; al intentar preservar el significado (la semántica) mediante los cambios formales (la sintaxis), se termina necesitando un homúnculo como consumidor de los resultados del procesamiento simbólico, y de paso cayendo en una regresión al infinito.

La etapa cognitivista clásica no ha finalizado, continúa hasta la actualidad. Se ha erigido como la más influyente, por cuanto contribuyó a formar la psicología cognitiva actual, originó los principios explicativos más conocidos y consolidó el procesamiento de información como la base para entender el comportamiento humano cotidiano y el anómalo. Las etapas venideras, la conexionista y la corporalizada-enactiva no sustituyen a la anterior, se suman a ella aportando una nueva visión sobre la arquitectura computacional, en el primer caso, y la inmersión de la mente en el cuerpo y el mundo, en el segundo. Más bien, las tres etapas se han convertido en variaciones de una perspectiva conceptual más amplia acerca de la mente.

Tercera etapa: el conexionismo

Este modelo también ha recibido los nombres de procesamiento distribuido en paralelo y de redes neuronales, debido a su arquitectura computacional subyacente. Su inicio puede situarse a finales de la década de los setenta. El modelo cognitivista simbolista había recibido críticas desde el comienzo; se decía que no existía un lugar preciso de almacenamiento de información en el sistema nervioso central, tampoco un procesador central, elementos indispensables para su correcto funcionamiento de acuerdo con sus propios planteamientos. Además, había serias dudas acerca de si las reglas de procesamiento utilizadas por el cerebro eran lógicas.

De acuerdo con Varela (1), el surgimiento de esta etapa se debió a que en el cognitivismo clásico se detectaron dos deficiencias que arrojaban dudas acerca de su plausibilidad biológica. La primera se refiere a que el procesamiento de información simbólico es secuencial, es decir, se realiza un paso a la vez, por lo que es preciso terminar uno para comenzar el otro. Pero en tareas como el análisis de imágenes visuales se requiere tal cantidad de operaciones que sería prácticamente imposible realizarlas una por una en un tiempo biológicamente aceptable para los animales que utilizan la luz, con el fin de explorar el entorno. La segunda alude a que el procesamiento simbólico es localizado, así que cualquier daño tiene profundas consecuencias en el funcionamiento de todo el sistema. Es como una carretera que une dos ciudades y se tapona completamente por la caída de las rocas. La vía queda cerrada e impedida toda comunicación terrestre. Sin embargo, la mente es resistente al daño y rara vez se compromete la totalidad de una habilidad. Se puede agregar una tercera: los computadores se comportan de acuerdo con lo que en ellas haya sido programado por quienes las crean; en cambio, la mente humana no está constreñida de esa manera, pues posee un pensamiento creativo difícilmente explicable por el proceso secuencial.

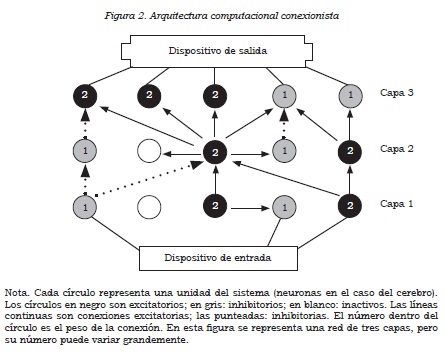

Una red computacional conexionista, también llamada sistema de procesamiento en paralelo o de redes neuronales, según Ramos (14), está constituida por los siguientes componentes y puede ser representada como aparece en la Figura 2:

- Un dispositivo de entrada de información.

- Un dispositivo de salida que transduce los patrones de activación.

- Un determinado número de unidades interconectadas entre sí con estas características:

- Las unidades pueden estar organizadas en diferentes capas o módulos funcionales.

- Algunas de estas unidades están conectadas a los dispositivos de entrada y de salida.

- Las unidades del sistema tienen como función enviar o recibir señales de otras unidades.

- Las conexiones entre las unidades son de tipo inhibitorio o excitatorio.

- Las conexiones tienen diferentes pesos entre sí (peso es algo parecido a la fuerza con que están conectadas dos unidades y se expresa con un valor).

- Los patrones de conexión, al menos los iniciales, son establecidos por quien programa el sistema.

- El mismo sistema puede modificar los patrones de conexión de acuerdo con una determinada entrada y una determinada salida, esto es, “aprende” a cambiarse a sí mismo.

- La modificación del peso de las conexiones se hace siguiendo alguna regla de aprendizaje.

- La mayoría de las reglas de aprendizaje son variables de la regla de Hebb, esto es, entre más veces se conecten dos unidades, más se fortalece esa conexión.

- Hay también reglas de corrección de errores aplicables cuando se presenta una diferencia entre las señales de salida deseadas y las que produce el sistema.

Vale la pena utilizar un ejemplo para hacer más clara la explicación. Imagine una máquina diseñada para leer textos en inglés. Está provista con un dispositivo de entrada para reconocer letras impresas sobre papel y un dispositivo de salida para emitir sonidos lingüísticos (habla). En medio de ellos hay una serie de unidades electrónicas conectadas entre sí con diversos pesos y programadas con ciertas reglas de aprendizaje. Esta red no dispone de reglas codificadas, solamente de una capacidad de aprendizaje que le permite resolver los problemas mediante la exposición a un gran número de ejemplos de parejas texto-fonemas. Una vez el dispositivo de entrada capta la señal (la palabra impresa), la información sobre la palabra impresa se convierte (distribuye) en un patrón de activación y desactivación de las unidades electrónicas y de transmisión de señales entre ellas. Finalmente, cuando las señales llegan al dispositivo de salida, se transducen mediante una especie de altavoces en sonidos que al principio pueden ser diferentes al deseado. A medida que se modifican algunos pesos de conexión por parte del programador, o mediante reglas de corrección de la máquina misma, se consigue la emisión de los sonidos deseados. Es posible seguir paso a paso el aprendizaje: comienza con balbuceos entrecortados para seguir con palabras medio formadas y llegar a una simulación aceptable de la pronunciación normal. Poco a poco aprende a leer textos de forma correcta. Esta máquina, llamada NETtalk, fue programada para generar nuevas estrategias (no especificadas de manera explícita) y aprender de la experiencia (15).

El modelo conexionista también puede utilizarse para diseñar máquinas encargadas del reconocimiento de patrones (por ejemplo, de rostros), que con sólo detectar una parte del estímulo (labios, nariz u ojos) reproducen el patrón total de activación desencadenado habitualmente por el estímulo completo, de tal manera que la identificación se realiza de manera rápida sin necesidad de disponer de la totalidad del objeto, lo que guarda gran parecido con la manera natural de reconocer patrones de los humanos y otros animales.

Valiéndose del ejemplo de la máquina para leer textos en inglés, se puede mostrar una diferencia importante entre el modelo conexionista y el simbolista. En el modelo conexionista, tan pronto como las letras impresas entran al sistema, se transforman en una serie de patrones de activación y desactivación y de transmisión de señales por parte de los componentes de la red; no se convierte en un símbolo ni es posible seguir linealmente su camino de transformaciones como sucede en la arquitectura secuencial del modelo cognitivista clásico. En el conexionismo, los símbolos o representaciones desaparecen o no cumplen ninguna función. Así, quedan sin lugar la perspectiva tradicional de varias psicologías y otras disciplinas, expresada en que la mente trabaja con símbolos.

El modelo conexionista parece más cercano a la biología, pues permite explicar la rapidez con que se realizan los procesos cognitivos y su resistencia a los daños, esto es, muy rara vez se compromete la totalidad de una habilidad; casi siempre queda parcialmente preservada. Tiene la ventaja adicional de que no es necesario representar simbólicamente la totalidad del entorno para navegar en él, basta interactuar con ciertas partes para lograr comportamientos útiles destinados a solucionar problemas específicos. Desde la perspectiva del conexionismo, se puede afirmar que la mente trabaja sobre una arquitectura computacional de interconexiones masivas distribuidas en paralelo y que la conectividad se modifica mediante la experiencia y el aprendizaje.

Según Ramos (14), desde finales de los años ochenta, el modelo conexionista ha tomado gran fuerza en la ciencia cognitiva, pues explica de mejor manera fenómenos como el rápido acceso a los contenidos de memoria, las características clínicas de las amnesias, diversos aspectos de la percepción visual, el olvido de lo aprendido y la competencia lingüística. En el último caso con la ventaja de no tener que acudir a hipótesis sobre una gran cantidad de reglas sintácticas y fonéticas codificadas en la mente. Basada en éste, se ha desarrollado una línea de investigación denominada simulación conexionista, que ha permitido explorar funciones cerebrales que por razones éticas o prácticas han sido difíciles de abordar experimentalmente (16).

El modelo conexionista no ha desplazado al cognitivista clásico en la caracterización de la mente; ambos conviven en la mayoría de los ámbitos académicos, aun cuando quizá el cognitivista es más conocido. Al parecer, en ciertas circunstancias, los dos describen apropiadamente y permiten comprender el funcionamiento del cerebro, pues dependiendo del tipo de tareas, éstas pueden ser realizadas con más facilidad y eficiencia por la arquitectura computacional de uno u otro modelo, e incluso mediante la participación cooperativa de ambos, como lo muestran algunos trabajos sobre atención, percepción visual, toma de decisiones, sistemas de recompensa y corteza prefrontal (17,18). Si bien algunos teóricos defienden una posición radical, en cuanto a que la mente procesa la información exclusivamente con una de esas dos arquitecturas; otros como Dennett (19), llegan a plantear que la mente es una máquina virtual secuencial montada sobre una arquitectura computacional en paralelo.

En resumen, el modelo cognitivista clásico y el conexionista tienen en común que sustentan el funcionamiento mental en procesos computacionales. El primero mediante una arquitectura secuencial y el segundo a través de procesamiento distribuido en paralelo; de ahí que al conjunto de los dos pueda denominarse cognitivismo computacionalista o computacionalismo. Se diferencian en que el cognitivismo clásico se compromete fuertemente con las representaciones y tiene como prototipo de lo mental el razonamiento abstracto; mientras que para el conexionismo las representaciones dejan de ser la materia prima con que trabaja la mente y el mejor ejemplo de lo mental son las actividades de reconocimiento de rostros y el aprendizaje del lenguaje.

Hurley (20) denominó al computacionalismo la visión del input-output. La percepción es el input desde el mundo hasta la mente; la acción es el output de la mente al mundo, y el pensamiento es el proceso mediador. Si este planteamiento es correcto, debería ser posible, en principio, disociar las capacidades de percepción, acción y pensamiento, lo que para muchos de los representantes de la etapa siguiente de la historia no es posible, siquiera concebible seriamente.

Referencias

1. Varela F. El fenómeno de la vida. Santiago de Chile: Dolmen; 2000. [ Links ]

2. Turing A. Computing machinery and intelligence. Mind. 1950;59:433-63. [ Links ]

3. Thagard P. Mind: introduction to cognitive science. 2nd ed. Cambridge, Massachusetts: MIT Press; 2005. [ Links ]

4. Geschwind N. Specializations of the human brain. Sci Am. 1979;241:180-99. [ Links ]

5. Leahey T. Historia de la psicología. Madrid: Debate; 1996. [ Links ]

6. Neisser U. Cognitive psychology. New York: Appleton-Century-Crofts; 1967. [ Links ]

7. Lachman R, Lachman JL, Butterfield C. Cognitive psychology and information processing: An introduction. Hillsdale, New Jersey: Lawrence Erlbaum Associates; 1979. [ Links ]

8. Rorty R. Philosophy and the mirror of nature. Princeton: Princeton University Press; 1979. [ Links ]

9. Port RF, Van Gelder T. Mind as motion. Cambridge, Massachusetts: MIT Press; 1998. [ Links ]

10. Nöth W. Representation in semiotics and in computer science. Semiotica. 1997;115:203-14. [ Links ]

11. Van Gelder T. Dinamics and cognition. En: Haugeland J. ed. Mind desing II. Cambridge, Massachusetts: MIT Press; 1997. p. 421-50. [ Links ]

12. Ryle G. El concepto de lo mental. Barcelona: Paidós; 2005. [ Links ]

13. Damasio A. El error de Descartes. Barcelona: Crítica; 1996. [ Links ]

14. Ramos J. Simbolismo vs. conexionismo: la estructura de las representaciones. En: Botero J, Ramos J, Rosas A (comp.). Mentes reales: la ciencia cognitiva y la naturalización de la mente. Bogotá: Siglo del hombre; 2000. p. 155-179. [ Links ]

15. Clark A. Estar ahí: cerebro, cuerpo y mundo en la nueva ciencia cognitiva. Barcelona: Paidós; 1999. [ Links ]

16. Aróztegui J, Prados JM. Simulación conexionista en neuropsicología. Rev Neurol. 2009; 48:317-21. [ Links ]

17. Deco G, Rolls ET. Attention, short-term memory, and action selection: a unifying theory. Prog Neurobiol. 2005;76:236-56. [ Links ]

18. Dehaene S, Changeux JP. Reward-dependent learning in neuronal networks for planning and decision making. Prog Brain Res. 2000;126:217-29. [ Links ]

19. Dennett D. La conciencia explicada. Barcelona: Paidós: 1995. [ Links ]

20. Hurley SL. Consciousness in Action. Cambridge, Massachusetts: Harvard University Press; 1998. [ Links ]