Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO -

Similars in Google

Similars in Google

Share

Biomédica

Print version ISSN 0120-4157

Biomédica vol.33 no.1 Bogotá Jan./Mar. 2013

https://doi.org/10.7705/biomedica.v33i1.804

REVISIÓN DE TEMA

doi: http://dx.doi.org/10.7705/biomedica.v33i1.804

Contribución de los autores:

Ambos autores participaron en la recopilación, unificación y síntesis de los antecedentes más destacados en el área de la compresión, mediante la discusión de la información publicada sobre el tema. Además, estructuraron las metodologías ya existentes para la compresión de imágenes médicas, aportando un guía base para las personas que desean introducirse en el área.

Recibido: 10/06/11; aceptado:14/08/12

La medicina moderna es una actividad cada vez más compleja, basada en la información proveniente de múltiples fuentes: historias clínicas, dictáfonos e imágenes y vídeos provenientes de múltiples dispositivos. Las imágenes médicas constituyen una de las fuentes de mayor importancia, por cuanto ofrecen un apoyo integral del acto médico: el diagnóstico y el seguimiento. Sin embargo, la cantidad de información generada por los dispositivos de adquisición de imágenes sobrepasa rápidamente la disponibilidad de almacenamiento que tienen los servicios de radiología, lo cual genera costos adicionales en equipos de cómputo con mayor capacidad de almacenamiento. Además, la tendencia actual de desarrollo de aplicaciones en la "nube de cómputo", tiene limitaciones por cuanto, aunque el almacenamiento es virtual y está disponible desde cualquier sitio, la conexión se hace a través de internet. En estos dos casos, el uso óptimo de la información requiere necesariamente de algoritmos de compresión potentes y adaptados a las necesidades de la actividad médica. En este artículo se presenta una revisión de las técnicas de compresión más utilizadas para el almacenamiento de imágenes, así como un análisis crítico de éstas desde el punto de vista de su uso en ambientes clínicos.

Palabras clave: procesamiento de imagen asistida por computador, compresión de datos, metodologías computacionales.

doi: http://dx.doi.org/10.7705/biomedica.v33i1.804

Medical image compression: a review

Modern medicine is an increasingly complex activity , based on the evidence ; it consists of information from multiple sources : medical record text , sound recordings , images and videos generated by a large number of devices .

Medical imaging is one of the most important sources of information since they offer comprehensive support of medical procedures for diagnosis and follow-up . However , the amount of information generated by image capturing gadgets quickly exceeds storage availability in radiology services , generating additional costs in devices with greater storage capacity . Besides , the current trend of developing applications in cloud computing has limitations, even though virtual storage is available from anywhere, connections are made through internet . In these scenarios the optimal use of information necessarily requires powerful compression algorithms adapted to medical activity needs .

In this paper we present a review of compression techniques used for image storage , and a critical analysis of them from the point of view of their use in clinical settings.

Key words : Image processing, computer-assisted; data compression, computing methodologies.

doi: http://dx.doi.org/10.7705/biomedica.v33i1.804

Las imágenes médicas son hoy en día parte fundamental de la exploración diagnóstica de un paciente en muchas situaciones clínicas. Las diferentes modalidades de adquisición han permitido mejorar la calidad del diagnóstico y, por ello, su uso se ha extendido prácticamente a todas las ramas de la actividad médica. Con la integración de las técnicas digitales en la adquisición y el desarrollo de herramientas de análisis y procesamiento de imágenes, el flujo de trabajo del acto médico también se ha modificado y se ha estructurado sobre la base de información visual, que se ha convertido en fuente fundamental del conocimiento.

El impacto de estas técnicas ha aumentado considerablemente las necesidades computacionales y, con ellas, la capacidad requerida de almacenamiento. Por ejemplo, el Hospital General de Ginebra reportó para el año 2008 una producción de 70.000 imágenes por día, aproximadamente. Además, se observó que el tamaño de los archivos, generados por los dispositivos de adquisición, puede alcanzar fácilmente el orden de los 1.000 gigabytes (GB) (Pitkanen MJ, Xin Zhou Hyvarinen, A Muller. Using the grid for enhancing the performance of a medical image search engine. IEEE International Symposium on Computer-Based Medical Systems, 2008), razón por la cual la mayoría de los servicios de radiología almacenan la información por un máximo de 30 días en los discos duros locales. Esta información se guarda después en algún tipo de dispositivo físico, circunstancia que, por supuesto, limita la disponibilidad de estos datos. Los recursos computacionales y de comunicación para la gestión y manejo de estas imágenes, deben diseñarse para facilitar su disponibilidad y la interacción con ellas. En este contexto, las técnicas de compresión se constituyen en herramientas fundamentales, no solo para optimizar el espacio y el costo de transmisión, sino para lograr un acceso rápido y eficiente a los datos (1-3), bajo la restricción de que el tratamiento de los datos no tiene por qué influir sobre la calidad del diagnóstico (4-6).

Por otra parte, el tratamiento de estas imágenes médicas debe hacerse bajo una legislación asociada que regule tanto la forma de desplegar la imagen, como los tipos de datos manejados y los métodos de compresión utilizados sobre ellas. Esta legislación debe apoyarse en estudios psicofísicos (7), dirigidos a establecer el compromiso entre el grado de tratamiento de estas imágenes y la confiabilidad de los datos luego de ser tratados.

Existe un gran número de dispositivos de adquisición, para cualquiera de las diferentes modalidades; por ejemplo, la radiografía convencional permite generar imágenes de diferentes órganos, con diferentes parámetros físicos y diferentes especificaciones. Las imágenes obtenidas, dependientes de la técnica y el órgano específico, pueden ir desde simples imágenes bidimensionales (mamografías, radiografías de tórax), hasta imágenes tridimensionales (tomografía computadorizada, resonancia magnética cardiaca) e, incluso, texto y gráficos. El propósito evidente de una estrategia de compresión es reducir el tamaño de los datos obtenidos para su almacenamiento y transmisión, pero con la condición de mantener la integridad de la información crucial para el diagnóstico.

En el contexto actual, la información circula por la red global con el fin de facilitar el intercambio e impulsar la generación de conocimiento. Esta tendencia moderna afecta también el ejercicio médico, con lo cual se requiere que, además de la compresión de los datos, las estrategias permitan la interacción adecuada con ellos, en términos de las necesidades de un usuario. El paradigma de la estrategia está, entonces, dirigida por el tipo de flujo de trabajo impuesto según las circunstancias clínicas.

El impacto de la compresión en el flujo del trabajo médico se ilustra con el siguiente ejemplo: un estudio de resonancia magnética cardiaca (4D) usualmente cuenta con:

- 10 series de imágenes 4D.

- Cada volumen con 10 cortes en promedio.

- 30 muestras en el tiempo, con una resolución de 512 x 512.

Con tal cantidad de información para un único estudio, cuando estos estudios se requieren para análisis a distancia, los tiempos de transmisión se pueden convertir en un cuello de botella en el flujo de trabajo. Es claro que frente a la magnitud de la información generada, los avances tecnológicos para su transmisión y almacenamiento no solucionan las dificultades introducidas por el volumen de los datos requeridos para una interacción adecuada. Bajo esta perspectiva, la compresión de las imágenes médicas es factor fundamental del uso eficiente de recursos: disminución de costos y del espacio de almacenamiento, y utilización del canal de comunicación.

El grado de compresión aplicado sobre una imagen puede, por supuesto, variar el tamaño de los archivos, con lo cual la aplicación médica particular es la que determina el grado de compresión adecuado. Los métodos con elevadas tasas de compresión destruyen cierta información contenida en la imagen, generalmente altas frecuencias espaciales, que pueden resultar cruciales en términos diagnósticos.

De forma general, existen dos clases principales de algoritmos de compresión en función de la degradación que sufre la imagen al ser procesada: los algoritmos sin pérdida (lossless ),que pueden reconstruir exactamente la imagen original, y los algoritmos con pérdida (lossy ),con los cuales se obtiene solo una representación aproximada de los datos después de la reconstrucción (Sahni S, Vemuri BC, Chen F, Kapoor C, Leonard C, Fitzsimmons J. State of the art lossless image compression algorithms. 1997) (5,8).

La compresión de una imagen mediante algún método requiere de un conocimiento profundo del dominio, que permita definir cuál es la información innecesaria, de tal manera que se logre un equilibrio entre la cantidad de información perdida y la cantidad de información relevante conservada. Bajo estas circunstancias, se podría afirmar que el tipo y el grado de compresión dependen principalmente del contexto en el cual la imagen se va a usar, de la modalidad de la misma y de las características de los objetos representados en ella.

En la actualidad, existe una amplia discusión sobre el grado de compresión que puede utilizarse en las imágenes médicas. Una opinión al respecto podría ser simplemente que este tipo de imágenes requiere métodos de compresión sin ningún tipo de pérdida; otra, un poco más arriesgada y defendida por algunos autores (9-13), es que la enorme cantidad de datos y el costo asociado, limitan el beneficio que se obtiene de las imágenes digitales, por lo cual una solución un poco idealista pero muy pertinente, promueve unas apropiadas tasas de compresión con pérdidas.

Clasificación de los algoritmos de compresión desde el punto de vista de la estrategia usada

Los métodos de compresión, además de clasificarse en técnicas de compresión con pérdida o sin ella, pueden clasificarse en: métodos de codificación, métodos de compresión del dominio espacial y métodos de compresión por transformación del dominio (5).

Los métodos de codificación se aplican directamente a los datos crudos de la imagen, tratándola como una secuencia de números discretos. Entre los métodos más comunes se pueden encontrar: codificación aritmética, codificación de Huffman y codificación run length .

Los métodos de compresión del dominio espacial son una combinación de algoritmos del dominio espacial y de métodos de codificación, que no solo operan sobre los valores de grises de una imagen, sino que tratan de eliminar la redundancia espacial.

Los métodos de compresión por transformación del dominio representan la imagen usando un conjunto apropiado de bases; entre los más destacados se encuentra la transformación discreta del coseno y la transformación wavelet (Deering M. The limits of human vision. 2nd International Immersive Projection Technology Workshop, 1998) . En la actualidad, existen numerosas técnicas de compresión destinadas a la optimización de aplicaciones particulares, ya sea de manera conjunta o separada.

Percepción visual: medida de la calidad en una imagen

Las leyes fundamentales que regulan la percepción del sistema visual humano, se estudian y caracterizan por medio de experimentos psicofísicos (7). De forma genérica, el sistema visual humano puede estudiarse desde tres ángulos diferentes, pero complementarios (14): el primero caracteriza la sensibilidad relativa a los niveles de luminancia del fondo y la variación de frecuencia espacio-temporal; el segundo se concentra en la vía visual, y el tercero describe la formación de una imagen en la corteza visual.

A pesar de su gran complejidad y eficiencia, el sistema visual humano tiene ciertas limitaciones. Un ejemplo de ello es que el ojo humano puede percibir de forma simultánea apenas una docena de variaciones en la intensidad. Esta adaptación no es lineal; existe una pérdida de sensibilidad no lineal en los extremos inferior y superior del rango de estímulos posibles, con lo cual el intervalo de intensidades que se pueden percibir no es infinito (Deering M. The limits of human vision. 2nd International Immersive Projection Technology Workshop, 1998). Esta afirmación resulta fundamental, pues significa que aun para un experto entrenado hay límites en la cantidad de intensidades que puede percibir y que cierto nivel de pérdida es justificable.

Por otra parte, el ojo humano también procesa la frecuencia, de tal forma que lo que se percibe en un punto depende de lo percibido en puntos vecinos (15). Existe una frecuencia espacial máxima, por encima de la cual no se perciben las variaciones, sino que se uniforma lo observado (Watson AB, Solomon JA, Ahumada AJ. Visibility of DCT basis functions: Effects of display resolution. Data Compression Conference, March 29-31, 1994). En algunos estudios se ha reportado que el poder resolutivo espacial del ojo humano es, en promedio, de 60 ciclos por grado, es decir que el sistema visual humano es capaz de apreciar una variación senoidal en el brillo, a lo largo de una línea, viendo 60 ciclos en un ángulo de un grado. Si una imagen se considera uniforme, sin variación espacial de brillo, cuya luminosidad varía en forma sinusoidal con el tiempo, el ojo es capaz de apreciar esta variación de brillo (parpadeando) hasta que su frecuencia alcanza unos 70 ciclos por segundo, lo cual puede interpretarse como la resolución temporal del ojo (16). Sin embargo, es importante resaltar que, dentro del margen de frecuencias espaciales perceptibles, no se pueden despreciar las altas frecuencias, puesto que el ojo humano es muy sensible a los bordes.

Por su parte, las técnicas de compresión han aprovechado las limitaciones del ojo humano, intentando eliminar la información que no es perceptible para el sistema visual humano e incorporando estas estrategias a los algoritmos de compresión. Estos modelos de predicción permiten al individuo observar e interpretar una imagen muy similar a la original, sin supresión de detalles significativos en el contenido de la imagen.

El desempeño de un algoritmo de compresión se mide usando sistemas métricos encargados de determinar las diferencias entre dos imágenes (17). El resultado de estos sistemas métricos de calidad puede ser un número que representa la probabilidad de que el ojo humano pueda detectar una diferencia entre las dos imágenes o un número que cuantifica la similitud en su percepción.

Los sistemas métricos para la evaluación de la calidad en una imagen pueden dividirse en subjetivos y objetivos (18). Los sistemas subjetivos incluyen información que el sistema visual humano procesa de manera selectiva; por ejemplo, le da más importancia a las frecuencias bajas. En general, estos sistemas métricos utilizan algún tipo de análisis estadístico de la apreciación de diferentes observadores en un conjunto particular de imágenes de prueba, con lo cual suelen ser métodos costosos en tiempo y recursos. Por el contrario, la evaluación objetiva se apoya en la estructura misma de los datos y calcula algún tipo de distancia entre ellos, determinando algún valor numérico que representa la fidelidad a la imagen original. Entre los sistemas objetivos más comunes se encuentran el error cuadrático medio, y alguna de sus variantes, como la relación señal a ruido de pico, métodos utilizados en múltiples aplicaciones (19).

Sin embargo, estas medidas tienen la limitación de que no están diseñadas para encontrar diferencias entre la información relevante de dos imágenes. En los últimos años se han desarrollado técnicas que evalúan de forma estructural la diferencia entre objetos, como por ejemplo, la similitud de estructura (20,21), y que se conocen como sistemas métricos de calidad, puesto que evalúan las diferencias entre imágenes desde el punto de vista de la diferencia entre información relevante. En particular, la similitud de estructura se basa en que las estructuras de los objetos de las escenas son independientes de la iluminación, de forma tal que la influencia de esta debe aislarse del cálculo de la calidad de la imagen. En este método se calculan tres componentes de forma independiente: la luminancia, el contraste y la estructura, describiendo cada una de estas características con un vector que contiene la media, la desviación estándar y la covarianza. Este sistema métrico se correlaciona mejor con el desempeño del sistema visual humano, es decir, la medida es capaz de obtener la información relevante de la imagen y establecer la similitud entre dos imágenes de manera muy parecida a como lo hace el sistema visual. El principio es que los descriptores de bajo nivel, luminancia, contraste y estructura, son calculados localmente sobre ventanas cuadradas de un tamaño determinado (21).

Estos sistemas métricos de calidad han permitido una mejor evaluación de las técnicas de compresión; por ejemplo, Krupinski (22-24) intenta optimizar la información visualizada en mamografías, mediante modelos del sistema visual humano, llegando incluso a hacer predicciones sobre el rendimiento del observador. Zhang (25) usa un esquema de cuantificación del sistema visual humano que permite mejorar el rendimiento del observador en tareas de detección sobre angiogramas coronarios. Johnson, por su parte (26), busca introducir nuevos sistemas métricos para determinar la calidad de las imágenes radiológicas.

Los sistemas métricos de calidad evalúan la eficiencia y validez de un método de compresión. El desempeño de dichos métodos depende del tipo de información en la imagen, con lo cual las técnicas de medida de desempeño deben usarse según el contexto, el tipo de datos y la modalidad de adquisición de las imágenes, entre otros factores. Todos ellos influyen directamente en la eficiencia de la compresión de un método y, por ende, en los resultados obtenidos con los sistemas métricos de calidad.

Compresión de imágenes

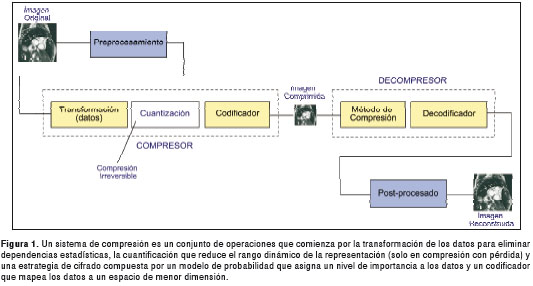

El objetivo principal de la compresión de imágenes digitales es reducir la cantidad de datos necesarios para su representación. Este proceso está destinado a producir una representación compacta de la imagen, que permite reducir no solo el espacio requerido en memoria para su almacenamiento, sino la transmisión de los datos a través de las redes de comunicación (27). La compresión se logra mediante la reducción o eliminación de uno de los tres tipos de redundancia: de codificación, de pixeles y psicovisual (28) . La redundancia de codificación está presente cuando se usan símbolos con códigos muy largos para representar una imagen. La redundancia de pixeles resulta de la correlación entre los pixeles de una imagen. La redundancia psicovisual se fundamenta en los datos que son ignorados por el sistema visual humano.

Las técnicas de compresión buscan reducir el número de bits requeridos para representar una imagen, aprovechando cualquiera de los tres tipos de redundancias, mientras se mantiene la resolución y la calidad visual de la imagen, reconstruidas tan cercanas a las de la imagen original como sea posible.

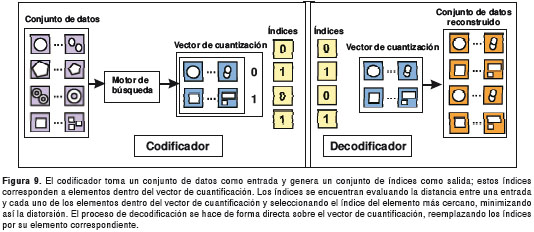

Un sistema de compresión para imágenes está compuesto por un codificador y un descodificador (figura 1).

Compresión sin pérdida

Las técnicas de compresión sin pérdida tienen como objetivo fundamental buscar que la información original de la imagen sea preservada después de la reconstrucción, manteniendo así la relación entre la alta compresión y la calidad (29-31). Todas estas técnicas y sus variantes pueden aplicarse a la codificación de imágenes usando la redundancia estadística y la codificación entrópica. El esquema de codificación entrópica tiene en cuenta la frecuencia de aparición de los signos a la hora de asignarles un código binario de representación con longitud variable. La codificación entrópica es típicamente usada en la codificación de Huffman, run length y codificación aritmética, entre otras.

Algunas de las técnicas más destacadas en la compresión reversible son:

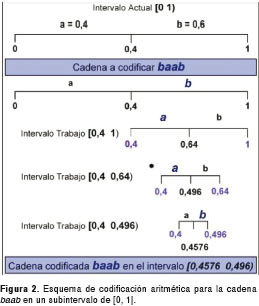

Codificación aritmética: en este tipo de compresión un conjunto de símbolos se asocia a algún subintervalo del intervalo [0, 1] (32), con la particularidad de que a este subintervalo se le asocia un identificador único, generalmente su media o su valor más pequeño . Como cualquier algoritmo de codificación, la codificación aritmética se hace en dos etapas. En la primera se calcula la probabilidad de un símbolo y, en la segunda, se le asocia alguna cantidad que represente esa cadena de símbolos, en este caso, un identificador del intervalo de codificación. La probabilidad de presentación de los símbolos determina la eficiencia de compresión, así como los rangos del intervalo de los símbolos.

Este concepto se ilustra con el siguiente ejemplo. Se van a codificar dos símbolos {a, b} con probabilidad de presentación de 0,4 y 0,6, respectivamente. El primer símbolo que se va a codificar tiene probabilidad de presentación de 0,4, con lo cual el intervalo [0, 1] se divide en dos subintervalos [0, 0,4] y [0,4, 1], como se observa en la figura 2. Por convención, cuando el símbolo es "a" , se escoge el subintervalo de la izquierda, con lo cual los subintervalos sucesivos asociados a los símbolos de la cadena, se buscan en el primer subintervalo [0, 0,4]. Al final, la secuencia de símbolos quedará asociada a algún subintervalo único entre [0,1].

En la figura 2 se presenta un ejemplo de codificación aritmética para una cadena "baab" en un subintervalo de [0, 1]; se inicia tomando el intervalo [0, 1]; el primer símbolo por codificar es "b" y la probabilidad asociada es 0,6, con lo cual se toma el intervalo [0,4, 1]. El segundo símbolo es "a", con una probabilidad asociada de 0,4, y, por lo tanto, el nuevo subinteravalo es [0,4, 0,64]. El tercer símbolo de entrada es "a" y con la probabilidad de 0,4 el subintervalo es [0,4, 0,496]. Finalmente, la cadena queda asociada al subintervalo [0,4576, 0,496], subintervalo del último símbolo "b". Por último, se selecciona algún valor dentro de este subintervalo, por ejemplo, la media o el límite inferior, y este valor representará la secuencia codificada.

En este tipo de codificación existe una familia de codificadores llamada codificadores aritméticos binarios (Chevion D, Karnin ED, Walach E. High efficiency, multiplication free approximation of arithmetic coding. Memoirs, Data Compression Conference, 1991; p.43-52). Su principal característica es que los valores posibles son binarios. Aunque esto los hace limitados, son muy sencillos y potentes. El Q-coder (Feygin G, Gulak PG, Chow P. Architectural advances in the VLSI implementation of arithmetic coding for binary image compression. Memoirs, Data Compression Conference , 1994; p. 254-63) es uno de los integrantes de la familia de codificadores aritméticos binarios que, además, constituye el núcleo del MQ-coder , base de la codificación del estándar JPEG2000 (33,34). En la actualidad, este estándar se ha constituido en uno de los más eficaces en la compresión de imágenes, por permitir una representación granular y un acceso eficiente a los datos.

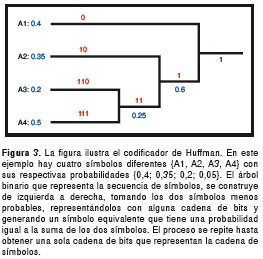

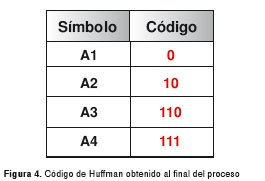

Codificación Huffman: esta es una técnica general para la codificación de símbolos, basada en la frecuencia de su presentación estadística (probabilidad) (35,36). Los pixeles en la imagen son tratados como símbolos, los símbolos que se presentan con mayor frecuencia son asignados a un número pequeño de bits, mientras que los símbolos con menor frecuencia son asignados a un número de bits más grande (Dong-hui Xu, Arati Kurani, Jacob Furst, Daniela Raicu. Run-length encoding for volumetric texture. The 4th IASTED International Conference on Visualization, Imaging, and Image Processing- VIIP 2004, Marbella, Spain, September 6-8, 2004) (37-39) (figura 3 y figura 4).

El código de Huffman es un código prefijo, lo cual significa que el código de algún símbolo no se repite en ningún otro símbolo. Una de las principales ventajas de esta técnica de codificación es que permite tasas de compresión considerablemente altas.

Recientemente, Mohandass desarrolló una implementación del algoritmo de Huffman que permite mejorar la eficacia del método convencional (40). El algoritmo propuesto fue evaluado en diversos tipos de imágenes médicas, como tomografía axial, resonancia magnética, ultrasonido y radiología convencional. El modelo de sustitución propuesto mejora el rendimiento en términos de compresión en 5,4 %, con lo cual aumenta la transferencia de datos, de fundamental importancia en algunas aplicaciones en telemedicina.

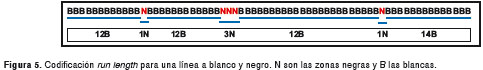

Codificación run length: es un método de compresión muy simple, usado para datos secuenciales. Esta técnica sustituye las secuencias de símbolos idénticos (pixeles) llamados runs por símbolos cortos (41). La codificación run length para imágenes en escalas de grises es representada por una secuencia {Vi, Ri}, en la cual Vi es la intensidad del pixel y Ri hace referencia al número consecutivo del pixel con una intensidad Vi. Ambos Vi y Ri son representados por un byte (figura 5). Dada la sencillez de su implementación y eficiencia en términos de velocidad, esta técnica ha logrado buenos resultados con imágenes de tomografía computadorizada (42), mostrando una mejora de 3 dB a 4 dB en su relación señal a ruido de pico, en comparación con otras técnicas de compresión sin pérdida.

Interpolación jerárquica:es un método piramidal de una representación que se construye utilizando la operación de submuestreo. La idea básica es que, partiendo de una versión de baja resolución de la imagen original, la cual ha sido obtenida submuestreando dicha imagen, se generan versiones sucesivas de mayor resolución mediante interpolación. De esta forma, lo que se transmite o almacena después de codificar cada imagen es, en primer lugar, la imagen de menor resolución. De la menor resolución de la imagen se obtiene la versión con el siguiente nivel de resolución, calculando los nuevos pixeles entre los anteriores por medio de algún método de interpolación. La representación sin pérdidas es obtenida por codificación y transmisión sucesiva de los residuos de la interpolación entre los niveles subsecuentes de resolución (43). Algunas investigaciones han demostrado buenos resultados en cuanto a tasas de compresión para imágenes de 12 bits de resonancia magnética cardiaca de 512 x 512 y para imágenes angiográficas de 9 bits de 512 x 512 (44).

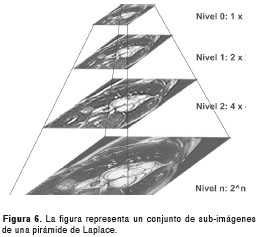

Pirámide de Laplace: fue desarrollada por Burt (Rath G, Guillemot C.Compressing the Laplacian pyramid. Proceedings of the 8th IEEE Workshop on Multimedia Signal Processing (MMSP ´06) . Victoria, BC, Canada, October 2006. p. 75-9) y Burt y Adelson la aplicaron a la compresión de imágenes (45). Esta técnica utiliza una representación de la imagen como una pirámide de imágenes, obtenidas filtrando la imagen original con una secuencia de pequeños filtros similares al gaussiano (46), cuyo radio es variable (figura 6). Cada una de las versiones filtradas corresponde a un componente con diferente información de frecuencia que, cuando se ensamblan como un solo objeto, se conoce como la pirámide de Laplace (Liu X, Tang J, Xiong S, Feng Z, Wang Z. A multiscale contrast enhancement algorithm for breast cancer detection using Laplacian pyramid. IEEE International Conference on Information and Automation, 2009) (46). La reconstrucción es exacta e independiente de la elección de los filtros. La pirámide completa se construye de manera iterativa, filtrando y submuestreando´ la subbanda´ de frecuencias bajas.

Está técnica, además de ser adecuada para la compresión de imágenes, es particularmente útil en tareas de transmisión progresiva a través de un canal de baja capacidad. La transmisión progresiva se logra mediante el envío ordenado de los coeficientes de las capas de menor a mayor resolución. Una de las principales desventajas de esta técnica es que los errores en la cuantificación de las subbandas´ de mayor frecuencia, no permanecen en estas, sino que aparecen en la imagen reconstruida como ruido blanco, es decir, como ruido compuesto de un número muy alto de diferentes frecuencias.

Este método de codificación se ha utilizado en el desarrollo de algoritmos de contraste multiescala para imágenes de mamografía (47). Estos algoritmos buscan modificar los coeficientes iterativamente, nivel por nivel, hasta obtener una imagen mejorada en el nivel más bajo. Los resultados muestran un mejor contraste en las imágenes de mamografía.

Compresión con pérdida

Las técnicas de compresión con pérdida son las más habituales en la codificación de señales de vídeo y audio. Evidentemente, las pérdidas son tolerables siempre y cuando que la calidad de la señal descodificada sea aceptable (48). El principio general sobre el cual se sustenta la codificación con pérdidas, es que no resulta necesario codificar aquellas componentes de la información que no son observables por los sistemas de percepción humana. La principal ventaja de estas estrategias de compresión es que consiguen factores de compresión muy superiores a los que se obtienen con los métodos sin pérdidas (49,50).

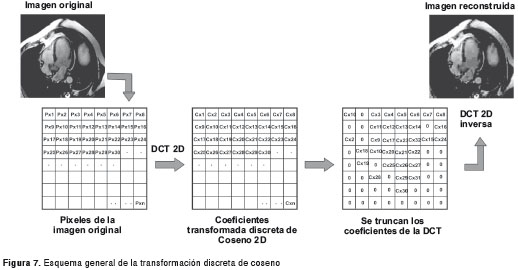

Transformación discreta de coseno: fue desarrollada por Ahmed (51), y ha sido estudiada y utilizada ampliamente desde entonces. Expresa una señal cualquiera, en este caso una imagen, como la suma de señales sinusoidales con distintas frecuencias y amplitudes (figura 7). Es una de las transformaciones más ampliamente utilizadas en la compresión de imágenes (51,52), debido a permite expresar la información de la imagen como una combinación de unas pocas frecuencias.

La transformación discreta del coseno está bastante relacionada con la discreta de Fourier; de hecho, es equivalente a la parte real de esta transformación, razón por la cual se compone exclusivamente de funciones coseno.

Recientemente, esta transformación se ha utilizado en la formulación de algoritmos de codificación híbrida (transformación discreta de coseno y transformación discreta wavelet ) para imágenes y videos de endoscopia (53), con resultados que demuestran un mejor desempeño en comparación con el formato JPEG (basado en la transformación discreta de coseno) y la transformación discreta wavelet ( DWT, discrete wavelet transform : transformación que representa una señal en términos de versiones trasladadas y dilatadas de una onda finita. La propiedad fundamental de la wavelet es su capacidad de localización en tiempo y frecuencia) convencional, en términos de calidad visual de la imagen, relación señal a ruido de pico y tasas de compresión.

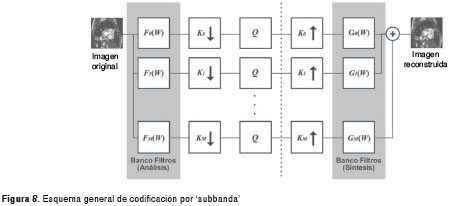

Codificación por subbanda´: en esta técnica se lleva a cabo un conjunto de operaciones iterativas sobre una imagen para dividirla en componentes espectrales o bandas (54-57). Su funcionamiento general parte del hecho de que la señal debe atravesar un conjunto de filtros pasa-banda para ser descompuesta en subbandas´ de frecuencia (figura 8). El número de bits asignados a cada banda puede variar en función de su importancia. La técnica de codificación en subbandas´, además de ser una de las más sencillas, permite obtener tasas de compresión del orden de un bit por pixel. La idea fundamental en esta técnica es dividir la imagen en bandas de frecuencia, para submuestrear´ y codificar cada una de forma separada, logrando con ello que el ruido de cuantificación que se produce en cada banda quede confinado a la misma. La importancia de esta técnica es que cuando se reconstruye la señal, uniendo la información de todas las subbandas´, el ruido confinado en cada una se anula por el efecto que tiene la suma de la información de todas las subbandas´. Esta técnica de codificación resulta muy útil en aplicaciones médicas, en las cuales se pretende transmitir gran cantidad de información a través de canales limitados (58).

Cuantificación vectorial: es una generalización del método de cuantificación escalar y se usa para la compresión de imágenes y de sonido. En la práctica, esta técnica se usa comúnmente para la compresión de datos que han sido digitalizados a partir de una fuente análoga (figura 9). Algunos resultados muestran que el vector de cuantificación es una de las técnicas de compresión con pérdidas, más eficaces para imágenes radiológicas (Kekre HB, Sarode TK. An efficient fast algorithm to generate codebook for vector quantization. First International Conference on Emerging Trends in Engineering and Technology, ICETET-2008, Nagpur, India, 16-18 July, 2008) (59). Su principal limitación se encuentra en la gran complejidad computacional en tiempos de búsqueda (60,61). El vector de cuantificación es extremadamente eficiente en compresión de regiones uniformes de una imagen (62). Además, esta técnica se usa comúnmente en la compresión de imágenes de mamografía, puesto que permite la detección y clasificación de las anormalidades presentes en este tipo de imágenes (63,64).

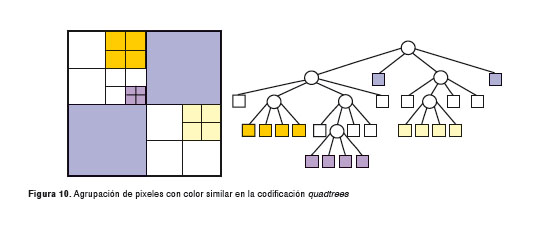

Quadtree: la idea fundamental de esta técnica es que cualquier imagen puede ser dividida en cuatro cuadrantes, un proceso que se repite de manera iterativa en cada uno de ellos (figura 10). En un quadtree, la imagen es representada por un nodo padre, mientras que los cuatro cuadrantes están representados por cuatro nodos hijo, en un orden predeterminado. Una imagen de un solo color puede ser representada por un quadtree consistente de un solo nodo; en general, un quadtree necesita ser subdividido solo si los pixeles de la imagen son de diferentes colores.

El principio de compresión de este método consiste en aprovechar la dependencia estadística que tienen los pixeles de una imagen, es decir que si seleccionamos un pixel de la imagen en forma aleatoria, existe una buena probabilidad de que sus vecinos inmediatos tengan un color similar (65). Esta técnica escanea el mapa de bits, región por región, buscando las que están compuestas de pixeles idénticos. Los quadtrees han sido utilizados recientemente para la compresión de imágenes de tomografía axial computadorizada y resonancia magnética, con resultados muy prometedores en comparación con los métodos de compresión sin pérdida (66).

Transformación ortogonal superpuesta ( Lapped Orthogonal Transform, LOT) : fue desarrollada con el objetivo de reducir los efectos de bloqueo (discontinuidades en la reconstrucción de la señal en los límites del bloque) en la codificación de la imagen (67). Con el fin de mantener la transformación directa e inversa (la transpuesta) de las matrices, cada función base de la transformación ortogonal superpuesta debe serlo, no solo a las otras funciones del mismo bloque, sino a las de los dos bloques adyacentes (68). La transformación ortogonal superpuesta tiene buen desempeño y posee un algoritmo de rápida implementación basada en la transformación discreta del coseno .

Codificación fractal: la idea principal de este método de codificación es descomponer la imagen en segmentos, utilizando las técnicas estándar de procesamiento de imágenes, tales como separación de colores, detección de bordes y espectro de análisis de textura. Cada segmento es, entonces, buscado en un repositorio de fractales. La librería contiene códigos llamados sistemas de funciones iterativas, los cuales son conjuntos compactos de números. Usando un procedimiento sistemático, se determina un conjunto de códigos para una imagen dada, de forma que, cuando los códigos de los sistemas de funciones iterativas se aplican a un conjunto adecuado de bloques de la imagen, se obtiene una aproximación muy cercana a la original (69). Este esquema es muy eficiente para la compresión de imágenes que tienen buena regularidad y autosimilitud.

Visión general de las técnicas de compresión para imágenes

Formato JPEG ( Joint Photographic Experts Group )

El JPEG es el formato de compresión más usado actualmente. Ofrece flexibilidad para seleccionar una imagen de alta calidad, con una tasa de compresión razonable o una tasa de compresión muy alta con menor calidad en la imagen. Una imagen comprimida con JPEG no muestra una diferencia visual con la imagen original sin comprimir. La compresión de imágenes JPEG contiene una serie de técnicas avanzadas como lo son la transformación discreta del coseno, seguida por una cuantificación .

Formato JPEG para movimiento

Una secuencia de video puede ser representada como una serie de imágenes en formato JPEG. Las ventajas son las mismas que con las imágenes estáticas, tanto en términos de calidad como en tasas de compresión. La principal desventaja del formato JPEG para movimiento es que sólo utiliza una serie de imágenes estáticas sin hacer uso de las técnicas de compresión de vídeo. El resultado es una tasa de compresión ligeramente inferior para secuencias de vídeo, en comparación con otras técnicas de compresión de vídeo.

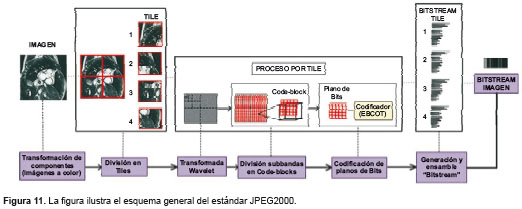

Estándar JPEG2000

Desde hace ya algunos años, este estándar se ha convertido en el sucesor del JPEG estándar. La base de este utiliza los nuevos avances en la investigación en el área de la compresión de imágenes. El estándar JPEG2000 (70), en lugar de la transformación discreta del coseno, utiliza una transformación wavelet. El estándar JPEG2000 se ha desarrollado con el propósito de ofrecer buenas tasas de compresión y un acceso progresivo a la información de la imagen, todo esto gracias a la gran granularidad y escalabilidad en la compresión de los datos. Estas funcionalidades resultan muy útiles desde el punto de vista de las necesidades de la compresión de imágenes médicas. Tales funcionalidades son: progresividad por calidad y resolución, compresión con pérdidas y sin ellas, acceso aleatorio a diferentes regiones espaciales y acceso a cualquier otra información de la imagen .

Visión general del algoritmo EBCOT

El Embedded Block Coding with Optimized Truncation , más conocido como EBCOT, es el motor central de codificación en el estándar de compresión de imágenes JPEG2000. En este estándar, como primera medida, la imagen es transformada con una descomposición wavelet ; en un paso posterior, esta transformación permite dividir cada subbanda´ en bloques relativamente pequeños, con dimensiones típicas de 64 x 64 o 32 x 32 muestras cada uno. Cada bloque de código se codifica de manera independiente, produciendo un bitstream embebido con muchos puntos de truncamiento (figura 11).

Conclusiones

En este trabajo se revisaron las técnicas más relevantes para la compresión de imágenes, analizando en profundidad aquellas que han tenido un mayor impacto en el área médica. Existen básicamente dos categorías de técnicas de compresión, la compresión sin pérdida y la compresión con pérdida . La comparación del desempeño entre técnicas de una u otra categoría, se torna una labor compleja, a menos que los conjuntos de datos utilizados para la experimentación y las medidas de desempeño sean idénticas, así como el propósito de aplicación.

Algunos trabajos (49,66,67) nos permiten concluir que las técnicas de compresión vector de cuantificación y la pirámide de Laplace hacen posible detectar y caracterizar anormalidades mucho más eficientemente en las imágenes de mamografía. Ambas técnicas deben su eficiencia de compresión a la uniformidad presente en los datos médicos. Es de resaltar que el método vector de cuantificación, a pesar de ser una técnica de compresión con pérdida, permite resultados equivalentes en mamografía a los obtenidos por el de pirámide de Laplace, lo cual demuestra que la redundancia intrínseca de los datos médicos puede eliminarse sin perder información relevante para el diagnóstico.

En otros estudios se demuestra que la codificación de Huffman se mantiene como un método sencillo que permite tasas de compresión eficientes en diferentes modalidades de imagen (41): tomografía axial, resonancia magnética, ultrasonido y rayos X, entre otros. Esto se debe a la eficiencia del método en la agrupación de un número arbitrario de símbolos durante la codificación que, en general, se adaptan a las estadísticas de entrada reales. Las técnicas de compresión sin pérdida más recientemente aplicadas a las imágenes médicas, como los quadtrees, han producido resultados prometedores en la compresión de imágenes de tomografía axial computadorizada y resonancia magnética (69), debido a que su representación por regiones (agrupamiento de pixeles idénticos) permite aprovechar la redundancia existente en los datos médicos. La trasformación discreta del coseno, por su parte, se ha constituido en el ícono de la compresión, dada su capacidad de concentrar la mayor parte de la información en pocos coeficientes del dominio de frecuencias, lo que permite tasas de compresión considerablemente altas en cualquier tipo de imagen (57).

Los métodos clásicos para la evaluación de la calidad de las técnicas de compresión presentan poca correlación con el sistema visual humano . A pesar de esto, siguen siendo ampliamente usadas por cuanto registran una estimación objetiva sobre la similitud entre dos imágenes, en este caso, entre la imagen original y la imagen reconstruida luego de ser comprimida. Sin embargo, el nivel de relevancia en una imagen médica no es homogéneo, es decir que toda la imagen no tiene el mismo nivel de información. Es por ello que un experto se concentra en zonas específicas de la imagen, que le permiten tomar decisiones óptimas en un tiempo mínimo (71). En consecuencia, un sistema métrico debería medir no la simple distancia euclidiana entre dos objetos, sino la distancia semántica entre las dos imágenes. Las técnicas métricas de calidad adaptadas con la funcionalidad del sistema visual humano, permitirían una evaluación no solo de la distancia de bajo nivel, sino del nivel de relevancia de la imagen reconstruida.

Se ha tratado de capturar esta información relevante mediante diferentes enfoques; por ejemplo, los modelos propuestos que mayor atención han recibido en los últimos años, convirtiéndose en línea base para muchas de las implementaciones actuales, son el modelo de predicción de diferencia visible de Daly y el modelo de discriminación visual de Lubin. Ambos representan un progreso significativo en la incorporación de modelos visuales para conseguir evaluaciones de calidad mucho más eficientes. Estos modelos hacen uso de resultados psicofísicos para conseguir un modelo del sistema visual humano completo, los cuales se caracterizan por tener estímulos físicos como entrada y respuestas cognitivas como salida.

El paradigma actual es el uso restringido de la compresión con pérdidas, sin importar el gasto de recurso y los beneficios colaterales que existen. Como se ha analizado a lo largo del presente trabajo, la elección de una técnica de compresión depende enteramente del tipo de datos utilizados y de la finalidad de la aplicación, es decir, de las características dentro de la imagen que se pretenden conservar para una aplicación particular: transmisión de la información por canales limitados (telemedicina), clasificación de anormalidades, visualización u optimización de espacio, entre otras. El uso racional de la compresión con pérdidas, definitivamente optimiza el manejo de recursos en situaciones clínicas que cada vez tienen una necesidad mayor de interacción con volúmenes gigantescos de datos.

En conclusión, la enorme cantidad de datos que generan los sistemas de adquisición de imágenes médicas (Pitkanen MJ, Hyvarinen XZ, Muller A. Using the grid for enhancing the performance of a medical image search engine. IEEE International Symposium on Computer-Based Medical Systems, 2008), y la necesidad de almacenamiento y transmisión por redes de comunicación de esta información, mantienen a las técnicas de compresión con representaciones flexibles y manejo eficiente de los datos, como una de las líneas fundamentales de la investigación biomédica.

No existe inguno.

Certificamos no haber recibido apoyo financiero de ninguna compañía u otra fuente comercial, para el desarrollo de este artículo de revisión.

Correspondencia: Eduardo Romero, Centro de Telemedicina, Universidad de Colombia, Bogotá, D.C., Colombia. Teléfono: (571) 316 500, extensiones 15025 y 15183; fax: (571)

316 5491 edromero@unal.edu.co

1. Hwang WJ, Chine CF, Li KJ. Scalable medical data compression and transmission using wavelet transform for telemedicine applications. IEEE Trans Inf Technol Biomed. 2003;7:54-63. http://dx.doi.org/10.1109/TITB.2003.808499 [ Links ]

2. Ibariana L, Lindstrom P, Rossignac J, Szymczak A. Out-of-core compression and decompression of large n-dimensional scalar fields. Computer Graphics Forum. 2003;22:343-8. http://dx.doi.org/10.1111/1467-8659.00681 [ Links ]

3. Salomon D. Data compression: The complete reference. Fourth edition. London: Springer-Verlag; 1997. p. 1-1092. [ Links ]

4. Clunie D. Lossless compression of gray scale medical images – effectiveness of traditional and state of the art approaches. Proceedings of SPIE Medical Imaging. 2000;3980:74-84 . [ Links ]

5. Rabbani M, Jones PW. Digital image compression techniques. Washington: SPIE Press; 1991. p. 1-221. [ Links ]

6. Young SS, Whiting BR, Foos DH. Statistically lossless image compression for CR and DR. Proceedings of SPIE Medical Imaging. 1999;3658: 406-19 . [ Links ]

7. Xie Kai, Jie Y, Min ZY, Liang LX . HVS-based medical image compression. Eur J Radiol. 2005;55:139-45. http://dx.doi.org/10.1016/j.ejrad.2004.09.007 [ Links ]

8. Rabbani M, Jones P. Image compression techniques for medical diagnostic imaging systems. J Digit Imaging. 1991; 4:65-78. http://dx.doi.org/10.1007/BF03170414 [ Links ]

9. Rebelo MS, Furuie SS, Munhoz AC, Moura L, Melo CP. Lossy compression in nuclear medicine images. Proc Annu Symp Comput Appl Med Care. 1993;824-8. [ Links ]

10. Cox GG, Cook LT, Insana MF, McFadden MA, Hall TJ, Harrison LA, et al. The effects of lossy compression on the detection of subtle pulmonary nodules. Med Phys. 1996;23:127-32. [ Links ]

11. Erickson BJ . Irreversible compression of medical images. J Digit Imaging. 2002;15:5-14. [ Links ]

12. Eraso FE, Analoui M, Watson AB, Rebeschini R. Impact of lossy compression on diagnostic accuracy of radiographs for periapical lesions. Oral Surg Oral Med Oral Pathol Oral Radiol Endod. 2002;93:621-5. http://dx.doi.org/10.1067/moe.2002.122640 [ Links ]

13. Kang BJ, Kim HS, Park CS, Choi JJ, Lee JH, Choi BG. Acceptable compression ratio of full-field digital mammography using JPEG 2000. Clin Radiol. 2011;66:609-13. http://dx.doi.org/10.1016/j.crad.2011.02.004 [ Links ]

14. Wandell B. Foundations of vision. Sunderland, MA, US: Sinauer Associates; 1995. [ Links ]

15. Kai X, Jie Y, Min ZY, Liang LX. HVS-based medical image compression. Eur J Radiol. 2005;55:139-45. http://dx.doi.org/10.1016/j.ejrad.2004.09.007 [ Links ]

16. Vicente del Fraile . Evolución de la televisión (I). Fecha de consulta: 7 de octubre de 2011. Disponible en: http://vivianita.cadiretes.cesca.cat/index.php/Buran/article/view/175749/240052 [ Links ]

17. Loizou CP, Pattichis CS, Pantziaris M, Tyllis T, Nicolaides A. Quality evaluation of ultrasound imaging in the carotid artery based on normalization and speckle reduction filtering. Med Biol Eng Comput. 2006;44:414-26. http://dx.doi.org/10.1007/s11517-006-0045-1 [ Links ]

18. Wang Z, Bovik AC. Modern image quality assessment. New York: Morgan & Claypool Publishers; 2006. p. 1-156 . [ Links ]

19. Wang Z, Bovik AC. Mean squared error: Love it or leave it? A new look at signal fidelity measures. IEEE Signal Processing Magazine. 2009;26:98-117. http://dx.doi.org/10.1109/MSP.2008.930649 [ Links ]

20. Wang Z, Bovik AC . A universal image quality index. IEEE Signal Processing Letters. 2002;9:81-4. http://dx.doi.org/10.1109/97.995823 [ Links ]

21. Wang Z, Bovik AC, Sheikh HR, Simoncelli EP. Image quality assessment: From error visibility to structural similarity. IEEE Trans Image Processing. 2004;13:600-12. http://dx.doi.org/10.1109/TIP.2003.819861 [ Links ]

22. Krupinski EA, Johnson J, Roehrig H, Lubin J. Using a human visual system model to optimize soft-copy mammography display: Influence of display phosphor. Acad Radiol.2003;10:161-6. http://dx.doi.org/10.1016/S1076-6332(03)80040-5 [ Links ]

23. Krupinski EA, Johnson J, Roehrig H, Engstrom M, Fan J, Nafziger J, et al. Using a human visual system model to optimize soft-copy mammography display: Influence of MTF compensation. Acad Radiol. 2003;10:1030-5. http://dx.doi.org/10.1016/S1076-6332(03)00293-9 [ Links ]

24. Krupinski EA, Lubin J, Roehrig H, Johnson J, Nafziger J . Using a human visual system model to optimize soft-copy mammography display: Influence of veiling glare. Acad Radiol. 2006;13:289-95. http://dx.doi.org/10.1016/j.acra.2005.11.006 [ Links ]

25. Yani Zhang, Pham BT, Eckstein MP. Task-based model/human observer evaluation of spiht wavelet compression with human visual system-based quantization. Acad Radiol. 2005;12:324-36. http://dx.doi.org/10.1016/j.acra.2004.09.015 [ Links ]

26. Johnson JP, Krupinski EA, Roehrig H, Lubin J, Nafziger J. Human visual system modeling for selecting the optimal display for digital radiography. Int J Comput Assist Radiol Surg. 2004;1268:335-40. http://dx.doi.org/10.1016/j.ics.2004.03.152 [ Links ]

27. Hilton ML. Wavelet and wavelet packet compression of electrocardiograms. IEEE Trans Biomedical Engineering. 1997;44:394-402. http://dx.doi.org/10.1109/10.568915 [ Links ]

28. González R, Woods R. Tratamiento digital de imágenes. Primera edición. Delaware: Addison-Wesley; 1996. p. 1-773. [ Links ]

29. Unser M, Aldroubi A, Laine A . Wavelets in medical imaging. IEEE Trans Medical Imaging. 2003;22:285-8. 10. http://dx.doi.org/1109/TMI.2003.809638 [ Links ]

30. Xiong Z, Wu X, Cheng S, Hua J. Lossy-to-lossless compression of medical volumetric data using three-dimensional integer wavelet transforms. IEEE Trans Medical Imaging. 2003; 22:459-70. http://dx.doi.org/10.1109/TMI.2003.809585 [ Links ]

31. Unser M, Aldroubi A. A review of wavelets in biomedical applications. Proceedings of the IEEE. 1996;84:626-38. http://dx.doi.org/10.1109/5.488704 [ Links ]

32. Witten IH, Neal RM, Cleary JG . Arithmetic coding for data compression. Communications of the ACM. 1987;30:520-40. [ Links ]

33. Rissanen J, Langdon GG. Arithmetic coding. IBM Journal of Research and Development. 1979;23:149-62. http://dx.doi.org/10.1147/rd.232.0149 [ Links ]

34. Rissanen J, Mohiuddin KM . A multiplication-free multialphabet arithmetic code. IEEE Trans Communications. 1989;37:93-8. http://dx.doi.org/10.1109/26.20074 [ Links ]

35. Huffman DA . A method for the construction of minimum redundancy codes. Proceedings of the Institute of Radio Engineers. 1952;40:1098-101. http://dx.doi.org/10.1109/JRPROC.1952.273898 [ Links ]

36. Jas A, Ghosh-Dastidar, Mom-Eng Touba NA. An efficient test vector compression scheme using selective Huffman coding. IEEE Trans Computer-Aided Design of Integrated Circuits and Systems 2003;22:797-806. http://dx.doi.org/10.1109/TCAD.2003.811452 [ Links ]

37. Stabno M, Wrembel R. RLH: Bitmap compression technique based on run-length and Huffman encoding. Journal Information Systems. 2009;34:400-14. http://dx.doi.org/10.1016/j.is.2008.11.002, [ Links ]

38. Tsai CW, Wu JL. On constructing the Huffman-code-based reversible variable-length codes. IEEE Trans Communications. 2001;49:1506-9. http://dx.doi.org/10.1109/ 26.950335 [ Links ]

39. Gonciari PT, Al-Hashimi BM, Nicolici N. Variable-length input Huffman coding for system-on-a-chip test. IEEE Trans Computer-Aided Design. 2003;22:783-96. http://dx.doi.org/10.1109/TCAD.2003.811451 [ Links ]

40. Mohandass D, Janet J. An improved three pattern Huffman compression algorithm for medical images in telemedicine. Information Processing and Management. 2010;70: 263-8 . http://dx.doi.org/10.1007/978-3-642-12214-9_43 [ Links ]

41. Rhodes ML, Quinn JF, Silvester J. Locally optimal run-length compression applied to CT images. IEEE Trans Med Imaging. 1985;4:84-90. http://dx.doi.org/10.1109/TMI.1985.4307701 [ Links ]

42. Todd-Pokropek A. Image data compression: A survey. Mathematics and Computer Science in Medical Imaging. 1988;39:167-95. [ Links ]

43. Roos P, Viergever M, Dikje MV, Peters H . Reversible intra frame compression of medical images. IEEE Trans Med Imaging. 1988;7:328-36. http://dx.doi.org/10.1109/42.108588 [ Links ]

44. Burt PJ. Fast filter transforms for image processing. Journal Computer Graphics and Image Processing . 1981;16:20-51. http://dx.doi.org/10.1016/0146-664X(81)90092-7 [ Links ]

45. Burt PJ, Adelson EH . The Laplacian pyramid as a compact image code. IEEE Trans Communications. 1983;31:532-40. http://dx.doi.org/10.1109/TCOM.1983.1095851 [ Links ]

46. Chew LW, Ang LM? Seng KP. Lossless image compression using tuned degree-k zerotree wavelet coding. Proceedings of the International MultiConference of Engineers and Computer Scientists. 2009;1:779-82. [ Links ]

47. Baker KD, Sullivan GD . Multiple bandpass filters in image processing. IEEE Proceedings Computers and Digital Techniques. 1980;127:173-84. http://dx.doi.org/10.1049/ip-e:19800040 [ Links ]

48. Said A, Pearlman WA. An image multiresolution representation for lossless and lossy compression. IEEE Trans Image Processing. 1996;9:1303-10. http://dx.doi.org/10.1109/83.535842 [ Links ]

49. Al-Shaykh OK, Mersereau RM . Lossy compression of noisy images. IEEE Trans Image Processing. 1998;7:1641-52. http://dx.doi.org/10.1109/83.730376 [ Links ]

50. Aberle DR. The effect of irreversible image compression on diagnostic accuracy in thoracic imaging. Invest Radiol. 1993;28:398-403. [ Links ]

51. Ahmed N, Natarajan T, Rao RK. Discrete cosine transform. IEEE Trans Computers. 1974;23:90-3. http://dx.doi.org/10.1109/T-C.1974.223784 [ Links ]

52. Wu YG, Tai SC. Medical image compressions by discrete cosine transform spectral similarity strategy. IEEE Trans Information Technology in Biomedicine. 2001;5:236-43. http://dx.doi.org/10.1109/4233.945294 [ Links ]

53. Villasenor JD. Alternatives to the discrete cosine transform for irreversible tomographic image compression. IEEE Trans Med Imaging. 1993;12:803-11. http://dx.doi.org/10.1109/42.251132 [ Links ]

54. Shrestha S, Wahid KA. A sub-sample based hybrid DWT-DCT algorithm for medical imaging applications. Journal of Selected Areas in Bioengineering. 2010;1:1-12. [ Links ]

55. Antonini M, Barlaud M, Mathieu P, Daubechies I. Image coding using wavelet transform. IEEE Trans Image Processing. 1992;1:205-20. http://dx.doi.org/10.1109/83.136597 [ Links ]

56. Simoncelli EP, Adelson EH. Subband transforms. In: Woods J, editor. Subband coding. Norwell, MA: Kluwer Academic Press; 1990. p. 143-93. [ Links ]

57. Woods JW, O´Neil SD. Subband coding of images. IEEE Trans Acoustics, Speech and Signal Processing. 1986;34:1278-88. http://dx.doi.org/10.1109/TASSP.1986.1164962 [ Links ]

58. Chen YY. Medical image compression using DCT-based subband decomposition and modified SPIHT data organization. Int J Med Inform. 2007;76:717-25. http://dx.doi.org/10.1016/j.ijmedinf.2006.07.002 [ Links ]

59. Makhoul J, Roucos S, Gish H. Vector quantization in speech coding. Proceedings of the IEEE. 1985;73:1551-88. http://dx.doi.org/10.1109/PROC.1985.13340 [ Links ]

60. Nasrabadi NM, King RA. Image coding using vector quantization: A review. IEEE Trans Communications. 1988;36:957-71. http://dx.doi.org/10.1109/26.3776 [ Links ]

61. Kekre HB, Tanuja K, Saylee M. Vector quantization for tumor demarcation of mammograms. Inf Process Manag. 2010;70:157-63. http://dx.doi.org/10.1007/978-3-642-12214-9_27 [ Links ]

62. Gaudeau Y, Moureaux JM . Lossy compression of volumetric medical images with 3D dead-zone lattice vector quantization. Annals of Telecommunications. 2009;64:359-67. http://dx.doi.org/10.1007/s12243-008-0079-5 [ Links ]

63. Cosman PC, Gray RM, Vetterli M. Vector quantization of image subbands: A survey. IEEE Trans Image Processing. 1996;5:202-25. http://dx.doi.org/10.1109/83.480760 [ Links ]

64. Kekre HB, Sarode TK, Gharge SM. Tumor detection in mammography images using vector quantization technique. International Journal of Intelligent Information Technology Application. 2009;2:237-42. [ Links ]

65. Hunter GM, Steiglitz K. Operations on images using quad trees. IEEE Trans Pattern Analysis and Machine Intelligence. 1979;2:145-53. http://dx.doi.org/10.1109/TPAMI.1979.4766900 [ Links ]

66. Sandeep J, Ankush M, Sujoy R. Model-based image compression framework for CT and MRI images. Int J Med Eng Inform. 2011;3:40-52. http://dx.doi.org/10.1504/IJMEI.2011.039075 [ Links ]

67. Malvar HS, Staelin DH. The LOT: Transform coding without blocking effects. IEEE Trans Acoustics, Speech and Signal Processing. 1989;37:553-9. http://dx.doi.org/10.1109/29.17536 [ Links ]

68. Malvar HS . Lapped transforms for efficient transform/subband coding. IEEE Trans Acoustics, Speech and Signal Processing. 1990;38:969-78. http://dx.doi.org/10.1109/29.56057 [ Links ]

69. Jacquin AE . Fractal image coding: A review. Proceedings of the IEEE. 1993;81:1451-65. http://dx.doi.org/10.1109/5.241507 [ Links ]

70. International Organization for Standardization. ISO/IEC 15444-1. JPEG2000 Image Coding System. Switzerland: ISO International Organization for Standardization; 2004. p. 1-194. [ Links ]

71. Gómez F, Villalón J, Gutiérrez R, Romero E. Finding regions of interest in pathological images: An attentional model approach. Proceedings SPIE Medical Imaging. 2009;7260:72603G. http://dx.doi.org/10.1117/12.811446 [ Links ]