Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO -

Similars in Google

Similars in Google

Share

Ingeniería e Investigación

Print version ISSN 0120-5609

Ing. Investig. vol.28 no.1 Bogotá Jan./Apr. 2008

Ibsen Chivatá Cárdenas1

1 Ingeniero civil. M.Sc., en Medio Ambiente y Desarrollo. Investigador, Instituto de investigaciones sobre incertidumbre, INCER. 57-6-8835250, Manizales, Colombia. ibsen_13@yahoo.es

RESUMEN

Se muestra el proceso de estimación de un modelo de susceptibilidad por deslizamientos inducidos por lluvia para la ciudad de Manizales, capital en donde la ocurrencia de deslizamientos es el principal problema ambiental. Se emplearon las herramientas de la teoría de los conjuntos difusos, la teoría de la posibilidad y la teoría de la evidencia, dadas las circunstancias y contenidos de incertidumbre que se presentan en la modelación, que en la localidad se refieren a la ausencia de datos representativos y a la necesidad de articular sistemáticamente informaciones subjetivas. El enfoque adoptado para la estimación de la susceptibilidad se refiere al tratamiento de las incertidumbres asociadas y consiste en su estimación y conservación a través del procesamiento de los datos. El modelo de susceptibilidad desarrollado procesa los datos de vulnerabilidad de las masas en la localidad y sus incertidumbres. Los datos finales del modelo se expresan mediante un mapa definido en categorías lingüísticas o etiquetas inciertas como: baja, media, alta, muy alta susceptibilidad, que se consideran adecuadas para la comunicación del riesgo. Se desarrolló igualmente un espectro difuso con el cual se clasifican los niveles de susceptibilidad a partir de la percepción y opinión de expertos. El modelo muestra que en la zona de estudio se presentan niveles de susceptibilidad que comprenden grados de bajos a altos, siendo más frecuentes las susceptibilidades medias. El artículo despliega los detalles del procesamiento sistemático de los datos. Se introduce el concepto de parámetro difuso, útil en la modelación de fenómenos con incertidumbre, complejos y no lineales. Se indica que la modelación de la susceptibilidad puede ser factible a través de estas teorías y herramientas de incertidumbre. Se señala en el papel, igualmente, la alta conveniencia de incorporar la incertidumbre en los procesos de modelación y de toma decisiones. Se concluye que si en una modelación se incorporan incertidumbres como las identificadas, la cuantificación de la susceptibilidad no es adecuada, en cuanto que no es consistente reducir la información de salida de un modelo dado, a cantidades numéricas exactas o reales, cuando la naturaleza de las variables es particularmente incierta. Lo anterior puede hacerse extensivo a la estimación del riesgo. El trabajo realizado puede considerarse como una investigación analítica-sintética.

Palabras claves: deslizamientos, susceptibilidad, incertidumbre, conjuntos difusos, teoría de posibilidad, teoría de la evidencia.

ABSTRACT

For the city of Manizales a landslide susceptibility model was developed. The landslides occurrence have been main environmental problem in the city. Fuzzy sets, Possibility Theory and Theory of Evidence were used in the model construction process, due set of circumstances involving uncertainty. In this particular case uncertainty contents concern to lack of representative data and the need of articulating systematically subjective information. The strategy adopted for the estimation of the susceptibility was the estimation and conservation of uncertainty through modelling process. The model contains data of masses vulnerability and their uncertainties. The output data are expressed in a map defined by linguistic categories or uncertain labels as: lower susceptibility, medium susceptibility, high susceptibility and very high susceptibility. This way of representation is considered appropriate for susceptibility communication. It was developed a fuzzy spectrum which classifies the susceptibility levels according perception and experts' opinion. The model shows, in the study area, levels of susceptibility between lower susceptibility to high susceptibility, being more frequent medium susceptibility. The issue shows the details on systematic data processing. The concept of Fuzzy Parameter is introduced, it is useful in modeling phenomena with uncertainty, complexity and nonlinear performance. It is shown susceptibility modeling can be feasible through these theories and tools of uncertainty. It is shown equally in the paper, the high convenience of incorporating the uncertainty in modeling process and decision-making. It was concluded if in a modeling process that incorporate uncertainties like identified ones, susceptibility quantification is not adequate because is not convenient to reduce model outputs information into exact or real numerical quantities, when the nature of the variables is particularly uncertain. The latest concept is applicable in risk assessment. This work can be considered like an analytic-synthetic research.

Keywords: landslides, susceptibility, uncertainty, possibility theory, evidence theory.

Recibido: septiembre 3 de 2007

Aceptado: febrero 20 de 2008

Introducción

La estimación de la susceptibilidad, amenaza y a su vez riesgo por fenómenos de deslizamientos, es una tarea que además de ser ardua enfrenta una serie de escollos, como el alto grado de complejidad e incertidumbres que implican dicha estimación (Millán, 1999; Van Westen, Van Asch y Soeters, 2006; Chivatá, 2007). Van Westen, Van Asch y Soeters (2006) discuten las dificultades que se tienen en la modelación de los fenómenos de los deslizamientos, como por ejemplo, para: disponer permanentemente de información actualizada relacionada con los fenómenos, la estimación de la magnitud de las masas deslizadas, la determinación de las probabilidades espaciales y temporales de ocurrencia, la modelación de las trayectorias de los movimientos y la estimación de la vulnerabilidad de los elementos expuestos a estos procesos. Pero para el autor las dificultades radican en que los paradigmas actuales de conocimiento están apuntando inadecuadamente a la idea de cuantificar el riesgo, la amenaza o susceptibilidad, es decir, expresarlo en términos exactos mediante números reales, cuando los altos contenidos de complejidad e incertidumbre de las variables obligan a recurrir a otras formas de estimación y expresión. Cardona (2001) ampliamente debate la imposibilidad de cuantificar el riesgo en lo relacionado con eventos amenazantes naturales. Los nuevos desarrollos en las prácticas de estimación se están orientando a la estrategia de incorporar la incertidumbre en las modelaciones. Para tal efecto, se recurre al tratamiento de distintos tipos de incertidumbre como las correspondientes a la aleatoriedad y cambio de los procesos, y a la incertidumbre epistemológica, entendida esta como la dificultad para conocer y tomar decisiones.

La aplicación de las teorías de incertidumbre en la modelación de estos fenómenos ha tenido algunos desarrollos en los últimos años: Juang, Lee y Sheu (1992), Binaghi et al. (1998), Juang, Jhi y Lee (1998), Millán (1999), Portilla (1999), Dodagoudar y Venkatachalam (2000), Portilla (2000), Benedikt, Reinberg y Riedl (2002), Ercanoglu y Gokceoglu (2002), Chi, Park y Chung (2002), Pistocchi, Luzi y Napolitano (2002), Gorsevski, Gessler y Jankowski (2003), Remondo et al.; (2003), Tangestani (2003), Islam (2004), Lee (2006) y Chivatá (2007), han dado a conocer algunos trabajos. Los resultados de estas investigaciones muestran la necesidad de incorporar estas teorías en la modelación, para poder tratar coherente y sistemáticamente las incertidumbres, las cuales se deben principalmente a la escasez de información, el bajo conocimiento que se tiene sobre algunos componentes de estos procesos y el problema de la subjetividad en la toma de decisiones.

En este artículo se exhibe un ejercicio típico de estimación de la susceptibilidad ante deslizamientos, incorporando algunas de las incertidumbres que pueden ser tratables conforme a la longitud de este papel. En Chivatá (2007) se presenta una estimación de un modelo de susceptibilidad y amenaza que incorpora otras fuentes y formas de incertidumbres.

El artículo inicialmente identifica las incertidumbres en la modelación de deslizamientos, luego describe de manera breve las teorías de los conjuntos difusos y las teorías de la posibilidad y de la evidencia, muestra seguidamente los pasos de desarrollo de la estimación y presenta una discusión de los resultados y conclusiones.

Incertidumbres en la modelación de deslizamientos

Se pueden identificar algunas formas y fuentes de incertidumbres asociadas a los fenómenos de los deslizamientos y a su modelación.

La variabilidad y complejidad espacial y temporal de las variables (factores): La imposibilidad práctica y eficiente de controlar (medir) todos los puntos necesarios en el dominio del espacio-tiempo, induce a contenidos de incertidumbre. Este es el caso de factores que inciden en los deslizamientos como: la distribución de las precipitaciones, la ocurrencia de formaciones y de estructuras geológicas y de las propiedades mecánicas de los suelos, la distribución de la vegetación, entre otros.

Aleatoriedad: Las precipitaciones y sismos son eventos generadores de deslizamientos. Su ocurrencia puede identificarse como estocástica o parcialmente aleatoria (Chow, Maidment y Mays, 1996), y finalmente incierta.

Ambigüedad: El problema de la ambigüedad es típico en los procesos de toma de decisiones, de clasificación, de evaluación y en las relaciones evidencias-proposición, en situaciones de escasa información. El caso particular corresponde al proceso de establecer categorías o niveles de riesgo o susceptibilidad y en el caso de la modelación no paramétrica de frecuencias.

Escasez de información: En las modelaciones de deslizamientos, también se presenta el problema de no disponer con información y datos suficientes para definir con rigor matemático o estadístico la variabilidad de factores que inciden en su ocurrencia.

Incertidumbre en las interacciones y relaciones de los factores de los deslizamientos: En la modelación puede llegarse a no identificar algunos de los factores que inciden, a no entender cómo discurren en el tiempo y en el espacio, la forma en que itineran o permanecen las interacciones entre las variables y a desconocer la importancia relativa de los factores.

Teorías para el tratamiento de la incertidumbre

Teoría de los conjuntos difusos

La teoría tiene su origen en la clásica booleana de los conjuntos. Dicha teoría fue extendida con los trabajos de Zadeh (1965), que introdujo la lógica difusa2, y la teoría de los conjuntos difusos (Klir y Yuan, 1995). Su razón de ser obedece a la necesidad de tratar problemas con los conceptos de valores de verdad parcial dentro de los términos de absoluta verdad o certeza y de falsedad completa, en problemas que tratan de describir los fenómenos de la vaguedad3 y la ambigüedad4 (Gorsevski, Gessler y Jankowski, 2003; Novák, 2005). La teoría de los conjuntos difusos se refiere en su aspecto más elemental a la representación de la realidad, en clases, categorías, estados de cosas o conjuntos, mediante funciones de pertenencia o membresía que miden el grado de asociación de un determinado elemento a una agrupación o clase dentro de las condiciones de pertenencia y no pertenencia absolutas.

La teoría provee un gran número de herramientas teóricas para lidiar con la incertidumbre, que permiten establecer los arreglos axiomáticos, reglas adecuadas en su lógica y aritmética, de acuerdo al fenómeno estudiado (Kreinovich y Nguyen, 2006; Behounek y Cintula, 2006).

Los conjuntos difusos son cuyas fronteras no son precisas. Un conjunto difuso es una pieza de información con incertidumbre que está especificada mediante una función que mapea el grado de pertenencia o certeza con la que se asocia cierto elemento a las diferentes categorías, atributos, estados de cosas o conjuntos que conforman el dominio. A su vez, un conjunto difuso es información que contiene a la vez datos objetivos y subjetivos: la información objetiva es el conjunto de elementos posibles que representan una determinada entidad o variable. La información subjetiva está asociada a una función de pertenencia que define el grado de creencia, certeza, soporte, confianza, evidencia, preferencia, sobre determinados valores5 del conjunto de datos posibles correspondientes a una variable.

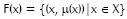

De manera formal, puede escribirse: un dato o información difusa puede ser considerado como un conjunto difuso U para el cual los valores x asociados al dato exhiben un grado de pertenencia expresada mediante una función μ(x) de tal forma que 0 ≤ μ(x) ≤ 16, donde:

y donde (x, μ(x)), para todo x que pertenece a X representa la función de pertenencia y X es el dominio de la función μ(x) y del conjunto x (Kovitz y Christakos, 2004).

Los elementos anteriores permiten introducir el concepto de cantidad difusa (x) (Mares, 1977); esta cantidad se define mediante una función de pertenencia μ(x) cuyas variables son cantidades en la línea real7. μ(x) mide el grado en el cual x se asocia o se asemeja a una categoría o atributo. De otro modo, el valor dado de μ(x), y en otros casos α8, indica el grado de confianza o soporte para un determinado valor numérico de x. Para α=1.0 o μ(x) = 1.0 en el Figura 1, se tiene la mayor confianza o credibilidad de que la variable x está definida entre el intervalo [b, c]. Para un nivel α=0.0, que corresponde a la menor creencia, la variable x está comprendida entre los valores contenidos entre a y d. Para valores intermedios de α los valores de x están definidos por una función μ(x).

Para el tratamiento aritmético de la teoría, se aplica el principio de extensión introducido por Zadeh (1975). Así, las operaciones aritméticas y algebraicas pueden ser definidas en analogía a las operaciones de los conjuntos clásicos o crisp (exactas, por ejemplo los números reales); a través del principio de extensión (Makropoulos y Butler, 2006). En general, este principio posibilita extender la aplicación de las reglas de la aritmética a cualquier tipo de operaciones con conjuntos difusos, lo cual se ha denominado aritmética difusa (Kentel y Aral, 2005).

A pesar de los sobresalientes desarrollos de la teoría, persiste una deficiente interpretación de esta: se considera como un simple arreglo matemático que permite lidiar con el uso del lenguaje natural; se interpreta como una herramienta más que trata de incorporar el conocimiento subjetivo; como un medio para procesar el razonamiento humano y como una simple tecnología para el diseño de sistemas de control (Kandel, Martins y Pacheco, 1995; Laviolette et al., 1995; Kreinovich y Nguyen, 2006). Todavía no es común que se identifiquen sus potencialidades en el conocimiento e interpretación de la complejidad: se cree que la teoría, sus axiomas y herramientas pueden representar más fielmente la realidad que la que se puede dar en los rígidos y sobrecodificados arreglos simbólicos de la matemática clásica booleana. Es necesario reconocer sus potencialidades para: la comunicación más efectiva de los resultados de una modelación (Klir y Yuan, 1995), su contribución al enriquecimiento de los paradigmas convencionales (Leung, 1983), las facilidades que ofrece para las síntesis de datos e información y para la construcción de modelos con pobre información, simples y menos costosos.

La discusión sobre las reales contribuciones de la teoría al conocimiento aún continúa (Novák, 2005).

Para dar brevedad al texto principal del artículo, remitimos al lector al apéndice 1 para obtener detalles adicionales sobre la teoría.

Teoría de la posibilidad

Dentro de la teoría de la posibilidad, los conjuntos difusos se interpretan como un tipo especial de conjuntos con variables de características aleatorias. Se pueden definir funciones de pertenencia asociados a diferentes cantidades probabilistas. Ello da lugar a la teoría de la posibilidad, que finalmente es una sencilla representación de probabilidades imprecisas. En la teoría de la posibilidad los conceptos de tendencias centrales y las desviaciones de la teoría estadística pueden ser procesados por la teoría de los conjuntos difusos de la misma forma en que la teoría de la probabilidad lo hace con las distribuciones de probabilidad (Dubois, 2005). La teoría de la posibilidad puede ser interpretada como una herramienta numérica que permite tratar la incertidumbre de una información aleatoria en términos de frecuencias y probabilidades de ocurrencia de un proceso. Las abstracciones posibilistas esencialmente tratan de representar cada pieza de información como una familia de distribuciones de probabilidad (Dubois y Prade, 1993; cita de Martin-Clouaire, Cazemier y Lagacherie, 2000).

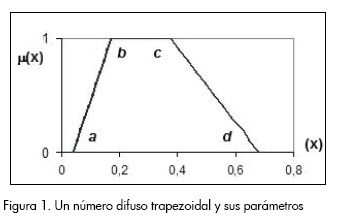

Para esta teoría, lo que es conocido sobre una variable X es representado por una función de distribución de posibilidad ?x (Zadeh, 1978; Dubois y Prade, 1988; cita de Martin-Clouaire, Cazemier y Lagacherie, 2000), que se mapea en el dominio de X dentro del intervalo [0,1]. Una distribución de posibilidad es una representación de lo que un observador conoce o cree posible sobre los valores de una variable X en determinado espacio. Representa una familia de subconjuntos o intervalos consonantes o anidados en la cual cada subconjunto se asocia a un nivel de posibilidad, confianza, creencia o soporte.

Πx puede ser visto como una función de pertenencia del conjunto difuso de posibles valores de X. Para cada elemento s en X, Πx (s) es el grado de posibilidad de que X=s.

De acuerdo con la Figura 2, Πx (s)=0 indica que X no puede tomar el valor de s, si Πx (s)=1, significa que no hay nada que pueda prevenir que X tenga un valor s. En otras palabras s es un valor muy posible, usual, normal, común, creíble, plausible. En la zona de transición donde los grados de posibilidad están estrictamente comprendidos entre 0 y 1, la distribución de posibilidad expresa que si Πx (s1) > Πx (s2), s1 es un valor más posible o factible que s2 para la variable X (Benferhat, Dubois y Prade; 2001). También se puede concluir que Πξ(s1) ofrece mejor información que Πx (s2).

Así mismo, puede decirse que si una distribución de posibilidad Πx (s)=0, para cualquier s en el dominio de X, se expresa ignorancia total del valor de X.

El conjunto de valores s donde Πx (s)=0 es identificado como el soporte de la distribución. Cuando Πx (s) =1, para un conjunto de elementos de X, dicha colección se denomina el núcleo de la distribución. El intervalo que contiene todos los valores de X referidos a un nivel o grado de posibilidad ≥α, es llamado corte α (Baudrit, Guyonnet y Dubois, 2005).

Sobre la teoría se pueden consultar más detalles en Dubois (2006).

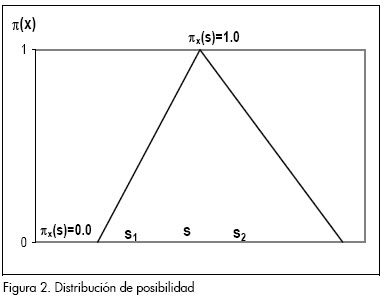

La teoría de la evidencia

Un caso típico de un problema con ambigüedad, es el de establecer la interacción entre una proposición y la evidencia que soporta esa proposición. El grado de verdad de una proposición podría ser medido de acuerdo al grado de solapamiento entre la evidencia y la proposición (Kikuchi y Pursula, 1998). La teoría de la evidencia (también llamada teoría de Dempster-Shafer) es una herramienta enfocada a la medición del grado de verdad de una proposición. Es un medio que permite combinar y sintetizar evidencias. Consiste en cuantificar el grado en que algún conjunto de evidencias soportan una observación. Descrito más formalmente, la medición establece el grado de evidencia o certeza de que un elemento pertenezca a un conjunto. Asigna un valor a cada conjunto en el conjunto universal, mostrando el grado de evidencia o creencia de que un elemento en particular pertenezca al conjunto.

Los campos de aplicación de la teoría se dan en problemas de clasificación, evaluación del desempeño de un sistema o la toma de decisiones con incertidumbre (Kikuchi y Pursula, 1998), como se muestra en la Figura 3.

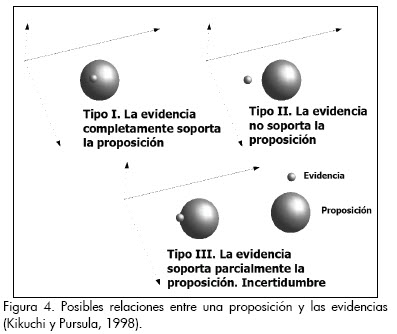

Dada una proposición, x es A, su grado de verdad se mide mediante el grado en que x pertenece al conjunto A. La información sobre x es la evidencia. Las relaciones entre la proposición y las evidencias pueden ser una de las siguientes: (1) la evidencia soporta completamente la proposición; (2) la evidencia no soporta la proposición en ninguna parte; y (3) la evidencia soporta parcialmente la proposición. Lo anterior se muestra en el Figura 4 (Kikuchi y Pursula, 1998).

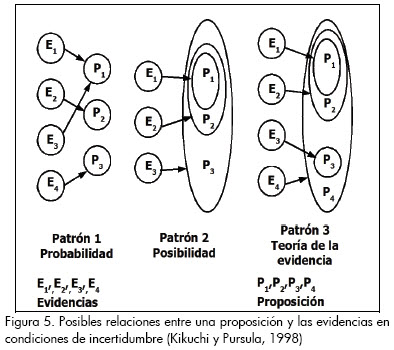

La incertidumbre ocurre en el tercer caso y se dan también tres posibles situaciones: (1) dadas varias piezas de evidencia (por ejemplo, resultados experimentales), cada pieza de evidencia apunta a un solo subconjunto (una proposición), como se ve en el patrón 1 de la Figura 5; (2) el cuerpo de la evidencia apunta a conjuntos anidados, así que una pieza de evidencia soporta todos los conjuntos de proposiciones (patrón 2); y (3) hay un patrón que es la combinación de los anteriores (patrón 3).

La medición de la incertidumbre, en cada caso, es efectuada a través de la medición de probabilidad para el patrón 1, medición de posibilidad en el caso del patrón 2 y medición de creencia para el patrón 3. Las mediciones de incertidumbre apuntan a determinar el grado de soporte o fortaleza de una determinada proposición A, de acuerdo con la evidencia. Cada patrón está asociado a cierto nivel de incertidumbre que muestra las limitaciones de la evidencia. El patrón 1, que describe incertidumbre aleatoria, está definido por piezas crisp, los demás se refieren a la incertidumbre de la vaguedad y pueden ser representadas con estructuras difusas o piezas no excluyentes de evidencias.

En el apéndice 2 se muestran algunos detalles adicionales de esta teoría que posibilitan el entendimiento de su aplicación en el presente artículo..

Con esta revisión de las teorías que permiten el tratamiento de la incertidumbre, se tienen herramientas suficientes para la evaluación de un problema con incertidumbre, puesto que se definen técnicas para incorporar la estocasticidad y vaguedad de variables (teoría de la probabilidad, teoría de la posibilidad, teoría de los conjuntos difusos) y la evaluación y clasificación de las salidas de un modelo para el proceso de toma de decisiones (teoría de la evidencia).

Aplicación de las teorías de incertidumbre al problema de la estimación de la susceptibilidad ante deslizamientos inducidos por lluvia

El trabajo que sigue procesa las incertidumbres correspondientes a las vulnerabilidades de las masas de suelo, mediante conjuntos difusos. La técnica consiste en tratar la incertidumbre de los factores que inciden en la ocurrencia de los deslizamientos mediante la construcción de funciones de pertenencia para cada entidad geográfica según sus atributos o factores que concurren en este. Además se define un espectro para la clasificación de la susceptibilidad que permite categorizar las cuantificaciones de la susceptibilidad en clases semánticas, ello con el apoyo de la teoría de la evidencia, lo cual tiene el doble propósito de conservar la incertidumbre para mejorar la toma de decisiones y asegurar una mejor comunicación del riesgo.

La zona de estudio

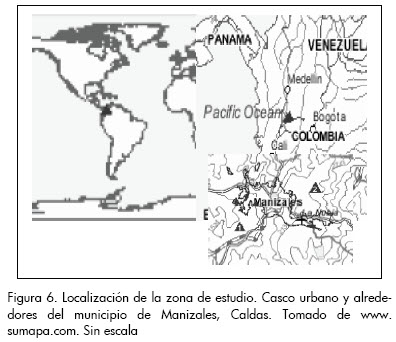

La zona de estudio (Figura 6) corresponde al área urbana y alrededores del municipio de Manizales, Colombia, Suramérica. El sector está delimitado por los siguientes vértices en coordenadas planas: Datum Magna-Sirgas (WGS84): vértice inferior 1169997.487E, 1047236.014N, vértice superior 1184997.487E, 1054986.014N.

Además de que en la ciudad de Manizales existen condiciones topográficas, geológicas, geotécnicas e hidrológicas favorables para la ocurrencia de deslizamientos, se evidencia una intervención intensa de las laderas: se ha presentado la ejecución de grandes adecuaciones de terreno, de cortes y explanaciones de suelos para la construcción de facilidades urbanísticas y edificaciones, lo que ha incidido adicionalmente en las susceptibilidades por la generación de zonas potencialmente inestables. Tales intervenciones han afectado principalmente cauces y propiciado la eliminación de la cobertura vegetal (Arango, 2000). Históricamente se han registrado procesos de remoción en masa y fenómenos erosivos, que han afectado la vida de la comunidad a tal punto que se consideran el mayor problema ambiental en la ciudad. Los deslizamientos son los movimientos más frecuentes y afectan principalmente las laderas perimetrales del casco urbano, en sitios donde se ha desprovisto la cobertura vegetal, en zonas de explanación y en rellenos artificiales de drenajes (Colpade, 2003).

En los días 18 y 19 de marzo, 28 y 29 de octubre, y 4 de diciembre, de 2003, se presentaron cerca de 215 deslizamientos que afectaron 1.600 viviendas y causaron la muerte de 40 personas (Colpade, 2003, 2003ª). Posteriormente se presentó una emergencia, el día 10 de junio de 2005, también con afectaciones, daños y víctimas. Los anteriores antecedentes justifican un estudio ampliado de las susceptibilidades.

Variables consideradas

Para el modelo se consideraron las siguientes variables, que corresponden a las de mayor incidencia, identificadas en la ocurrencia de los deslizamientos en la zona.

Inclinación del terreno: a partir del modelo de elevación y con la ayuda de un sistema de información geográfica, se logró configurar un modelo de inclinación que permite determinar para cada porción de terreno la pendiente media medida en grados.

Forma de ladera: corresponde a la curvatura de la sección normal, la cual es tangente a los contornos del mapa de curvas de nivel, en el modelo de elevación del terreno, para cada porción del terreno. La unidad de medición de esta variable esta definida en radianes..

Escurrimiento potencial acumulado: es un índice que trata de identificar el potencial de acumulación de agua de escorrentía y subsuperficial que puede llegar a una locación dada. Es un importante parámetro para la determinación de las características significativas de la hidrología y el drenaje. El índice es utilizado para cuantificar intensidades de flujo y potenciales de acumulación o erosión (Yesilnacar y Topal, 2005). En el modelo, el índice es equivalente al número de unidades de discretización de la zona de estudio que drenan a una porción de terreno dada.

Formaciones superficiales: se trata de información correspondiente a la ocurrencia de suelos y rocas en superficie definida en las siguientes clases: 1-Rellenos ladera, 2-Rellenos cauce, 3-Suelo orgánico, 4-Cenizas volcánicas, 5-Formación Casabianca, 6- Formación Manizales, 7- Formación Quebradagrande.

Uso y cobertura del suelo: se trata de información categorial que se escaló en las siguientes clases: 1-Suelo desnudo, 2-Pastos, 3-Rastrojo, 4-Bosque, 5-Tratamientos de estabilización, 6-Cultivos, 7-Áreas construidas o urbanizadas.

Las variables consideradas, en buena parte, revelan las condiciones de alteración de los terrenos y su condición actual, por cuanto se derivan de información reciente. La información relevante fue extraída de modelos de elevación e imágenes, recuperadas en los años 1999 y 2003, respectivamente.

Espectro de clasificación de la susceptibilidad

Para permitir que los usuarios finales del modelo visualicen de manera sencilla y fácil la información de susceptibilidad de los terrenos, se estila dividir el espectro o dominio de susceptibilidad (conjunto de posibles valores de susceptibilidad), en dos o más clases. Igualmente, es más recomendable emplear un espectro con leyendas y etiquetas de susceptibilidad alta, media o baja que con valores numéricos, porque la mayoría de los usuarios finales del modelo entienden y utilizan mejor los mapas (Beguería, 2006). Se piensa que esta estrategia de clasificación tiende a garantizar que la comunicación de la susceptibilidad, es más significante y efectiva y da facilidades para la interpretación y la definición de prioridades de acción, sin que se elimine la incertidumbre inherente a las estimaciones. Dicha estrategia, en comparación con la utilización de la escala numérica, permitiría informar mejor a cualquier usuario, siendo este paso de importancia significativa en la gestión del riesgo.

Para la discretización del espectro (en categorías o niveles de susceptibilidad) convencionalmente se emplean técnicas como: los quiebres naturales, la definición de cuantiles, de intervalos iguales, y los múltiplos de desviaciones estándar9. Cada una de las técnicas ofrece diferentes resultados. Sin embargo muchos autores prefieren que en el caso del mapeo de susceptibilidades y amenaza de deslizamientos se emplee la opinión de expertos, a cambio de estas técnicas estadísticas y numéricas (Ayalew, Yamagishi y Ugawa, 2004).

Por lo anterior, se decide que dicho espectro debe ser consultado con expertos locales. Ello se respalda en lo sugerido por Morgenstern (1995) y Christian (2004), quienes indican que la definición de las categorías del espectro es un proceso subjetivo y particular al área de estudio y al problema.

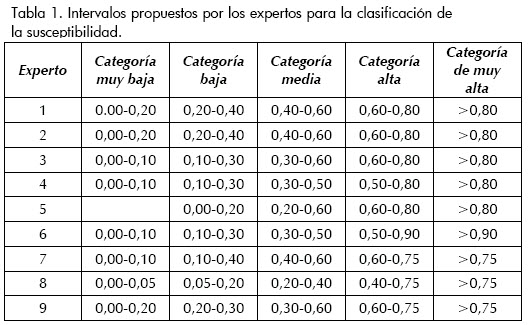

Para tal efecto se hace uso de la teoría de los conjuntos difusos. Se consultaron nueve expertos de la localidad, con perfiles y experiencias muy similares. Después de una breve presentación de la investigación en curso, se les preguntó:

- Si un modelo para la evaluación de la susceptibilidad ante deslizamientos en la ciudad de Manizales pudiera cuantificar las magnitudes de susceptibilidad debido a deslizamientos inducidos por lluvia,¿cuántas categorías, clases o niveles de susceptibilidad semántica o lingüística establecería?

- ¿Dentro de qué cuantiles definiría cada clase o nivel?

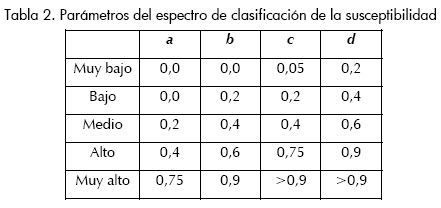

La mayoría de los resultados de la consulta tuvieron como punto en común que pueden definirse cinco categorías de susceptibilidad. Se identificaron en las clases muy bajo, bajo, medio, alto y muy alto. Cada uno de ellos definió los intervalos mostrados en la Tabla 1.

Lo que se aprecia en la Tabla 1 es que las percepciones varían de evaluador en evaluador. Lo anterior puede obedecer a las diferencias entre la experiencia y conocimiento de cada experto, y a la percepción particular del riesgo, que puede ser de aversión o de optimismo, entre otras. Estas circunstancias eran esperadas. Para establecer el espectro de clasificación de la susceptibilidad se recurre al apoyo de la teoría de los conjuntos difusos y las técnicas de agregación de percepciones. En este caso el proceso de agregación consiste en agrupar los intervalos sugeridos en orden de acuerdo con la amplitud de arriba hacia abajo (los de menor amplitud arriba y los de mayor amplitud abajo), conformándose así el espectro de números difusos trapezoidales asociados a las categorías de susceptibilidad.

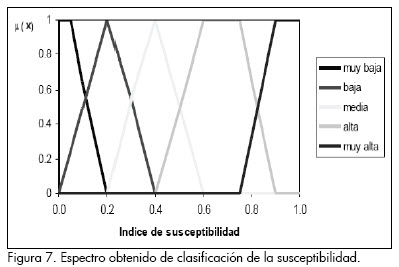

El espectro de categorización de la susceptibilidad es así definido en cinco categorías, y se indica en la Figura 7 y en la Tabla 210.

Estimación de los coeficientes de importancia de las variables identificadas

La insuficiente información sobre la importancia o frecuencia relativa de las variables que inciden en la ocurrencia de deslizamientos no permite estimar con precisión las importancias relativas o parámetros (de ahora en adelante) de cada variable. Se recurre a una estimación estadística en intervalos de confianza para los parámetros. Lo anterior conduce a que a cambio de identificar los parámetros del modelo como valores reales exactos, son más bien piezas de información difusas11, porque contienen incertidumbre.

Para estimar los parámetros se deben hacer suposiciones sobre el tamaño de la población a partir de la cual se hacen las estimaciones muestrales. En el caso específico, se cuenta con una población no definida, porque no se sabe con precisión la extensión de terreno en la cual son válidos el modelo y los parámetros. Para la estimación de los parámetros se requiere definir con algunos criterios la extensión sobre la cual se establece la modelación.

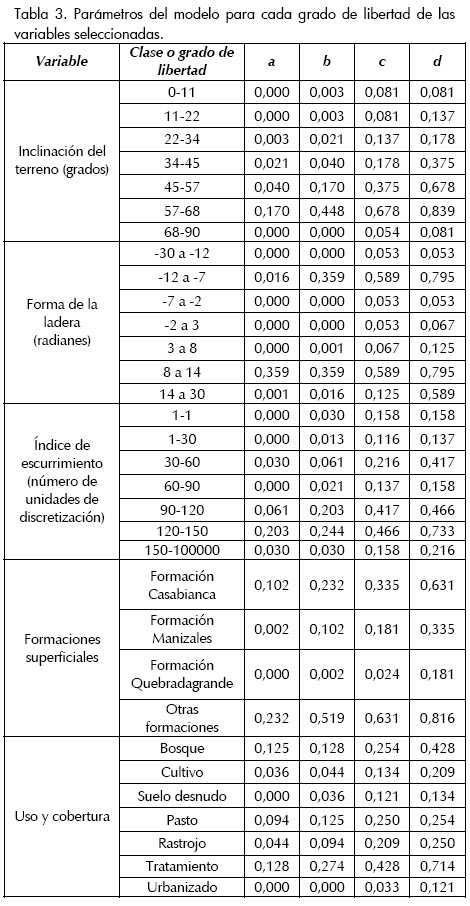

Para la estimación de los parámetros del modelo fue preciso delimitar el área de investigación que define la población estadística. De esta forma, la extensión que sirvió de base para las estimaciones es el área que de acuerdo con el modelo de distribución de lluvias desarrollado para los eventos de desastre en la zona, el 18 y 19 de marzo de 2003, muestra lluvias diarias superiores a 70 mm, que es el umbral de precipitación que potencia la ocurrencia de deslizamientos identificado por las autoridades de la municipalidad.

Para la estimación de los parámetros se empleó el análisis univariado, que consiste en relacionar una variable dependiente (en este caso la ocurrencia de deslizamientos) con una variable independiente a la vez. La importancia de cada factor o variable es analizada separadamente. Este método está basado en la suposición de que los factores más determinantes pueden ser cuantificados mediante la estimación de la densidad de deslizamientos para cada grado de libertad o clase de cada variable. Para evaluar estas relaciones se efectúa un cruce entre los mapas o modelos de distribución de las variables y el mapa de distribución de un grupo de deslizamientos ocurridos.

La estimación de frecuencias relativas se efectuó mediante el cálculo de intervalos de confianza con un nivel de confianza del 95% para cada grado de libertad de cada variable. Para tal efecto se empleó el algoritmo de Goodman (1965) presentado en Masson y Denoeux (2006), que se detalla en Chivatá (2007). El algoritmo emplea modelos de distribución de probabilidad multinomiales. De esta forma, los parámetros estimados se muestran en la Tabla 3. ella, los valores b y c se refieren a los extremos de los intervalos de confianza para cada grado de libertad de cada variable. El conjunto de datos definidos por b y c corresponden a las frecuencias relativas más esperadas, porque corresponden a la estimación de la frecuencia relativa media de cada grado de libertad. En el conjunto de valores comprendido en este intervalo no se puede preferir alguno de los datos. Los valores a y d corresponden a los datos intermedios de las categorías adyacentes a cada clase. Los valores de a y d pueden representar el efecto de la ambigüedad de las evidencias y se asumen como los valores de frecuencia crisp menos creíbles. Dicha ambigüedad obedece a la escasez de información sobre la frecuencia relativa o incidencia de cada clase: en este caso los parámetros asociados a una clase bien podrían asociarse a los grados de libertad adyacentes. Lo anterior puede entenderse esquemáticamente de acuerdo con el contraste de los patrones I con el II o III, de la Figura 5: si las evidencias son suficientes se tiene un patrón de relaciones de evidencias-proposiciones en condiciones de certeza representada por el tipo I (probabilista-crisp); cuando la información no es suficiente los patrones pueden ser representados por los tipos II-III (posibilista-ambiguo). Esta ambigüedad obedece también a la precisión de las funciones multinomiales, la cual corresponde a la amplitud de las clases. Existe una fuerte dependencia entre la precisión de los modelos discretos de probabilidad multinomiales y el número de evidencias o eventos representativos asociados a una clase. Para el empleo de modelos de probabilidad discretos y multinomiales existe el requisito de un número mínimo de evidencias o eventos muestrales asociados a cada clase, lo cual afecta la amplitud de las clases, es decir, la precisión de la distribución. Sobre este aspecto se encuentran mejores detalles en Masson y Denoeux (2006).

El conjunto de valores de frecuencias delimitado por a, b, c y d constituye un número difuso trapezoidal y corresponde precisamente a los pesos o parámetros, en este caso difusos, asociados a cada clase en una variable.

Estimación de la susceptibilidad

La susceptibilidad corresponde a la favorabilidad del ambiente físico de los elementos inherentes de las masas de terreno y superficie como la geología, geomorfología, el uso y cobertura del suelo, etc., para potenciar deslizamientos. En este caso la incidencia de la lluvia no es considerada como un factor de susceptibilidad, sino más bien representa un factor detonante, dados los mecanismos de falla identificados en la zona de estudio. El factor de la lluvia termina por establecer el paso siguiente en la estimación del riesgo: la estimación de la amenaza.

Así, la estimación de la susceptibilidad está representada en la de índices relativos de la favorabilidad para la ocurrencia de los deslizamientos. Con el fin de estimar la susceptibilidad total de una porción de terreno, los parámetros difusos asociados a cada grado de libertad de una variable y que determinan la incidencia de cada factor considerado son agregados convenientemente. Para tal efecto, se tienen que adelantar ciertos procedimientos de discretización de los modelos de las variables, calibración y validación de los posibles modelos de síntesis. Una detallada experimentación de estos pasos dados es mostrada en Chivatá (2007).

Se obtuvieron mapas de susceptibilidad, en la forma de un número difuso trapezoidal, para los puntos crisp: a, definido en el nivel α=0.00; b y c, correspondientes al intervalo más creíble, y d, extremo superior del intervalo en α=0.00 (Figuras 8 a 11).

Los resultados se pueden presentar e interpretar así: la Figura 9 corresponde al modelo de distribución de susceptibilidad en el punto crisp a, menor, del vector difuso de respuestas estimadas para un nivel de creencia nulo o de poca relevancia. Este modelo identifica la zona de estudio casi en toda su extensión como de susceptibilidad muy baja a baja si se clasifica dentro del espectro de susceptibilidad estimado. La Figura 9, corresponde al modelo de distribución de susceptibilidad en el punto crisp b, menor, del vector difuso de respuestas estimadas para un nivel de creencia de la más alta posibilidad o más esperado. Si se clasifica dentro del espectro de susceptibilidad estimado, el modelo sugiere que la zona de estudio contiene niveles de susceptibilidad desde niveles bajos hasta niveles altos. La Figura 10 muestra el modelo de distribución de susceptibilidad en el punto crisp c, mayor, del vector difuso de respuestas estimadas para un nivel de creencia de la más alta calificación. Los niveles de susceptibilidad se clasifican entre las categorías medias a altas. La Figura 11, exhibe el modelo de distribución de susceptibilidad en el punto crisp d, mayor, del vector difuso de respuestas estimadas para un nivel de poca o nula credibilidad. Los niveles de susceptibilidad se clasifican entre las categorías medias a altas, con una mayor proporción de zonas de susceptibilidad alta.

Los mapas 8 a 11 corresponden a las posibles salidas del modelo, asociadas a los niveles extremos de credibilidad. En realidad se tienen muchas salidas, pero están acotadas por estos puntos crisp identificados. Sin embargo, el conjunto de posibles salidas del modelo puede ser representado incorporando la incertidumbre mediante un mapa de categorización que se establece en el aparte 4.6.

Categorización del modelo de susceptibilidad

Insistiendo en que se debe procurar comunicar en las formas más efectivas la información de los modelos, es que los mapas de distribución de la susceptibilidad, que se expresan en números difusos, deben ser reclasificados de acuerdo al espectro de categorización estimado.

Para la clasificación de la susceptibilidad, el problema es comparar un conjunto difuso de salida que representa la susceptibilidad de una porción de terreno (mapas 8 a 11) con el espectro de clasificación difuso de susceptibilidades definido por los expertos (Figura 7). Este proceso se puede desarrollar de manera consistente empleando las métricas de la teoría de la evidencia.

Dentro de la teoría de la evidencia existen métricas que miden el grado de solapamiento entre dos números difusos, problema que es similar al planteado. Para este trabajo se emplea el indicador de Vanegas (2000), quien propuso una métrica sencilla y confiable, representada por el máximo producto de las funciones de pertenencia de los conjuntos difusos comparados:

p = max([μA (x) μB (x)])

Esta métrica en realidad es una defusificación12 del tipo punto central, es decir que la clasificación de cada conjunto de salida del modelo se da de acuerdo con su punto central. Se implementó una modificación cuyo objeto es que se mida la masa de la salida y se compare con la masa de cada categoría difusa del espectro de clasificación de la susceptibilidad, con el propósito de que se conserve la incertidumbre. De esta forma:

p = max([μAi (x) μBj(x)])

Siendo Ai, el conjunto difuso que representa la salida del modelo para una determinada entidad geográfica y Bi el conjunto difuso que representa una categoría dada que proviene del espectro de susceptibilidad; se asigna al objeto Ai la categoría Bj que maximiza el valor de p. El detalle del procedimiento se ilustra en la Figura 12.

La Figura 12 muestra el modelo de clasificación de susceptibilidad final estimado. El modelo corresponde a la defusificación de la respuesta difusa estimada. Se redujo el conjunto de posibles respuestas a este modelo crisp, de acuerdo al espectro difuso de clasificación de susceptibilidad hallado (Figura 7), en términos de las categorías difusas lingüísticas definidas.

Análisis de resultados obtenidos

Más allá de realizar todo un análisis sobre las condiciones de susceptibilidad de la zona de estudio, de lo cual se han presentado los datos más importantes, se prefieren presentar aquí algunos aspectos que muestran la pertinencia y la eficiencia de la aplicación de las teorías de incertidumbre mostradas.

El primer lugar debe señalarse que los altos contenidos de incertidumbre que se presentan en esta modelación se refieren a la ausencia de datos y a la necesidad de recurrir a percepciones que midan el grado de susceptibilidad; incertidumbres que no pueden dejar de ser consideradas en una modelación. Las circunstancias de incertidumbre que rodean esta modelación no pueden ser desestimadas, por cuanto se incurriría en un desafortunado proceso de toma decisiones, al no conocerse cuá es la magnitud de la incertidumbre que afecta la modelación. Las teorías de incertidumbre aplicadas aquí se emplearon particularmente para extraer y representar información escasa, para incorporar la opinión de expertos, para procesar incertidumbre sistemáticamente para proveer información útil y de fácil comunicación.

La teoría de los conjuntos difusos fue útil en todo el proceso de modelación de la susceptibilidad en la localidad. La teoría proporciona los elementos necesarios para emplear la teoría de la posibilidad y de la evidencia. La teoría de la posibilidad permitió estimar los parámetros difusos del modelo de susceptibilidad. La teoría de la evidencia facilitó representar en un solo mapa el modelo de susceptibilidad preservando los contenidos de incertidumbre. La teoría de los conjuntos difusos permitió definir un espectro que consolida las percepciones sobre la susceptibilidad definida por un grupo de expertos. Todas estas actividades hubieran sido muy difíciles de ejecutar, sino imposibles, siguiendo los arreglos axiomáticos de la lógica booleana.

Se debe notar otra condición que caracteriza la modelación de la incertidumbre mediante las teorías reseñadas y fue su bajo uso de recursos.

Se ha extraído información que se considera de alto valor para la gestión del riesgo en la localidad: un espectro de clasificación de la susceptibilidad, basado en la percepción de expertos; una colección de parámetros o factores de peso asociados a las variables que más inciden en la ocurrencia de los deslizamientos expresada en números difusos trapezoidales, que proveen información sobre la importancia relativa de los factores seleccionados y que pueden orientar la priorización de actividades en la reducción del riesgo; se produjo un mapa final que consolida la información sobre la susceptibilidad de las masas, en términos comprensibles para los tomadores decisiones, todo ello preservando las incertidumbres propias del fenómeno modelado y del proceso de modelación, finalmente contribuyendo a la toma de decisiones con criterios de precaución y de seguridad.

El desarrollo anterior, introduce también el concepto de parámetro difuso, que se considera de alta utilidad y probablemente un salto paradigmático en la modelación de fenómenos con incertidumbre, complejos y no lineales, ya que el concepto no ha tenido un reconocimiento que sea proporcional a sus potencialidades.

La modelación anterior podría indicar un alto nivel de sofisticación que haría difícil su adopción en los trabajos normales de estimación de la susceptibilidad, no obstante se cree que una modelación de este tipo, ofrece mejor información y contribuye a un proceso de toma de decisiones más acertada, lo cual no se puede sustituir por el empleo de modelos simples y poco confiables e informativos.

Estos resultados muestran las potencialidades de las teorías de incertidumbre en la modelación de fenómenos complejos, por lo que es fácil prever su aplicación en la modelación y en la toma de decisiones de otras problemáticas.

De otro lado debe destacarse la importancia que juega el uso de sistemas de información geográfica para la modelación de fenómenos con incertidumbre, herramienta que interactúa fácilmente con los algoritmos de las teorías aplicadas.

Conclusiones

Después de la experimentación realizada, es notorio que la modelación de la susceptibilidad tiene altos contenidos de incertidumbre. En primer lugar, las incertezas se deben a la escasa información disponible, lo cual impide emplear con rigor las técnicas estadísticas y matemáticas exactas. De otro lado, en todo caso hay que recurrir a suposiciones y a información subjetiva por efecto del proceso de percepción del riesgo, la toma de decisiones, la comunicación de los resultados, entre otros. En estas condiciones puede resultar inadecuada una modelación que no incorpore las incertidumbres asociadas.

Se propone el uso integrado de las teorías de la incertidumbre como: la teoría de la posibilidad, la de los conjuntos difusos y de la evidencia, como medios para construir modelos difusos de abstracción y decisión, apropiados para la estimación del riesgo, cuando los fenómenos estudiados presentan altos contenidos de incertidumbre, referida a la ausencia de información de sus variables y parámetros, al requerimiento de la incorporación de información subjetiva y a la toma de decisiones en condiciones de incertidumbre.

La cuantificación de la susceptibilidad y de la amenaza y el riesgo; puede ser considerada como una labor inocua en la modelación de fenómenos con incertidumbre: al incorporar los contenidos de incertidumbre no es conveniente definir de manera exacta un nivel numérico único asociado a cada porción de terreno susceptible, amenazado o en riesgo. La reducción de la incertidumbre asociada a una información, a piezas exactas, es un ejercicio que afecta la confiabilidad del modelo y por consiguiente, la toma de decisiones, la comunicación y la efectividad de las acciones y se distancia de la naturaleza incierta del fenómeno. Es recomendable, entonces, establecer categorías difusas de susceptibilidad, amenaza o riesgo. Lo anterior indica que al incorporar en una modelación la incertidumbre, lo más pertinente es estimar el riesgo en grados de libertad no numéricos o difusos.

La experimentación realizada, puede suponer un gran esfuerzo conceptual y computacional, no obstante la expansión y adopción de nuevos paradigmas y el desarrollo tecnológico, ahora hacen eficaz y eficiente el proceso de modelación y toma de decisiones.

Apéndice 1. Complemento teoría de los conjuntos difusos

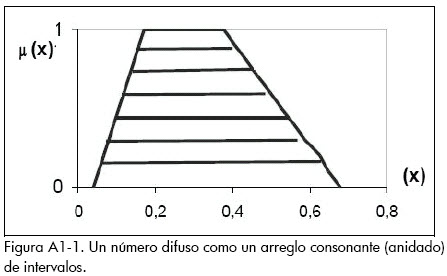

Para una mejor comprensión del concepto de conjunto difuso, se acude a una descripción alternativa, en la que se muestra su relación con otro medio para representar incertidumbre: los intervalos.

Un conjunto difuso puede ser visto como un conjunto de intervalos (Figura A1-1): un intervalo es un conjunto de valores asociados a una variable real. Este intervalo está definido por un valor máximo y uno mínimo, dentro de los cuales se tiene la confianza de que los valores de una variable siempre van a estar contenidos en dicho intervalo. Un número difuso, es un arreglo de intervalos anidados que definen una pieza de información. Cada intervalo está asociado a un nivel de confianza, certeza, creencia o preferencia al cual se le asigna un valor μ(x) o α definido dentro del intervalo [0,1], generalmente. La forma de la función de μ(x) es determinada por la preferencia de los decisores, en el proceso de construcción de los números difusos. Las funciones de pertenencia suelen ser representadas por funciones sigmoidales, gaussianas, semicirculares, entre otras, pero una de las funciones más manejables son las trapezoidales.

Apéndice 2. Complemento teoría de la evidencia

Con fines explicativos, se presentan en este apéndice elementos adicionales de la teoria, que permiten entender su aplicación.

La teoría de la evidencia es aplicada en este papel para realizar un proceso de clasificación de información con incertidumbre en otra información con las mismas condiciones. En términos generales el problema particular de evaluación o clasificación, consiste en comparar dos conjuntos, uno que podría corresponder al desempeño de un sistema o salida de un modelo y el otro a un objetivo, meta deseada o restricción o dominio de clasificación; ambas informaciones con incertidumbre, que se pueden representar mediante piezas de información difusa.

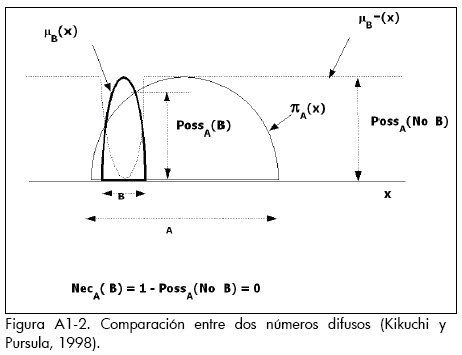

En este caso tanto la respuesta como el objetivo o la categoría de clasificación son representados como números difusos πA(x), μB(x). El grado de verdad de la proposición A satisface B es determinado por las métricas de posibilidad y necesidad como se muestra en la Figura A1-2, donde A está dado por la distribución de posibilidad πA(x) y B está dado por el conjunto difuso μB(x) y:

PossA (B) = Max Min {μB(x), πA(x)} para todo x ( posibilidad )

NecA (B) = 1 – [Max Min {[1 –μB(x)], πA(x)} para todo x ( necesidad )

Estos indicadores provienen de otras métricas más generales de la teoría de la evidencia que son las funciones de creencia, cuyos detalles se pueden consultar en Klir y Yuan (1995).

Nomenclatura

μ(x): función de pertenencia de un número difuso, cuyo conjunto de valores posibles corresponden a la variable x en el espacio X

a: punto que corresponde a la pareja de valores x y μ(x) de un número difuso trapezoidal definido por la tupla (a, b, c, d), donde a acota el extremo inferior del intervalo de valores menos creíbles de la pieza de información difusa.

b: punto que corresponde a la pareja de valores x y μ(x) de un número difuso trapezoidal definido por la tupla (a, b, c, d), donde b acota el extremo inferior del intervalo de valores más creíbles de la pieza de información difusa.

c: punto que corresponde a la pareja de valores x y μ(x) de un número difuso trapezoidal definido por la tupla (a, b, c, d), donde c acota el extremo superior del intervalo de valores más creíbles de la pieza de información difusa.

d: punto que corresponde a la pareja de valores x y μ(x) de un número difuso trapezoidal definido por la tupla (a, b, c, d), donde d acota el extremo superior del intervalo de valores menos creíbles de la pieza de información difusa.

α: nivel de creencia de una distribución de probabilidad, cuyo espacio de discurso es el intervalo [0,1]

αA: es un corte α de un conjunto difuso A, definido como el subconjunto {x| A (x) ≥ α}, es el intervalo que contiene todos los valores de A referidos a un nivel o grado de posibilidad ≥α.

πx: distribución de posibilidad de una variable x

πx (s): es el grado de posibilidad, creencia, soporte o confianza de que x = s

E1,E2,...,En: conjunto de evidencias

P1,P2, ,Pn: conjunto de proposiciones que soportan las evidencias E1,E2,...,En.

g(A): función que mide la fortaleza de la proposición de x es A.

πA (x): número difuso que representa la respuesta de un modelo con contenidos de incertidumbre, representada por un conjunto difuso A

μB (x): número difuso que representa el objetivo o la restricción con contenidos de incertidumbre

PossA (B): indicador o métrica que mide el grado de posibilidad de que el conjunto difuso B satisfaga o soporte al conjunto A

Max: operador que devuelve el valor máximo de un conjunto de salidas de funciones o variables

Min: operador que devuelve el valor mínimo de un conjunto de salidas de funciones o variables

NecA (B) : indicador o métrica que mide el grado de necesidad de que el conjunto difuso B satisfaga o soporte al conjunto A, es equivalente al complemento de la métrica de la posibilidad, evaluada sobre la proposición de que el conjunto difuso B no satisfaga o soporte al conjunto A

p : otra métrica que mide el grado en que se satisfacen, intersecan o solapan un par de conjuntos difusos.

μAi (x): función de pertenencia del conjunto difuso Ai, para un determinado elemento o entidad i en un modelo distribuid.

μBj(x): función de pertenencia del conjunto difuso Bi, para una categoría de decisión o clasificación.

2 La lógica difusa describe las leyes de la verdad correspondientes al razonamiento de fenómenos caracterizados por la vaguedad (Behounek y Cintula, 2006; Novák, 2006). La lógica difusa está direccionada al tratamiento de los fenómenos que contienen vaguedad, y se empeña en el desarrollo de herramientas para su modelación a través de la graduación de la verdad. La lógica clásica es considerada como un caso especial de la lógica difusa (Novák, 2006).

3 La vaguedad expresa el grado con el cual una frontera de un conjunto no es crisp, no es exacta, no es precisa.

4 La ambigüedad implica relaciones uno-a-muchos entre elementos. Son relaciones no funcionales o multívocas entre elementos. Para Novák (2005) la ambigüedad surge cuando se tratan de agrupar objetos o evidencias de acuerdo con determinada propiedad: al clasificar elementos en ciertas categorías, algunos pueden pertenecer a una determinada clase o varias y en distintos grados de asociación.

5 Una pieza de información puede ser una cantidad o una cualidad. Por ello se prefiere emplear el término valor, que reúne estos dos tipos de información.

6 En la teoría, el conjunto típico utilizado correspondiente a los valores de verdad es el intervalo entero [ 0, 1 ]. Así, para cada apreciación S de un perceptor, en la teoría de los conjuntos difusos se describe la certidumbre o confianza de cada apreciación por un número contenido en el intervalo [ 0, 1 ] (Kreinovich y Nguyen, 2006). De una manera más general, el intervalo [ 0, 1 ] puede ser remplazado por cualquier intervalo lineal ordenado, finito o no (Benferhat, Dubois y Prade; 2001)

7 Dentro de los distintos tipos de conjuntos difusos, los que están definidos en R (conjunto de los números reales), son de especial importancia. El concepto de número o cantidad difusa juega un rol fundamental en la formulación en las variables cuantitativas difusas. Estas son variables cuyos estados o grados de libertad son números difusos. Cuando estos representan conceptos lingüísticos, tal como: muy pequeño, pequeño, mediano, etc., estas usualmente son llamadas varia-bles lingüísticas.

8 Un corte α, αA es un conjunto definido como: αA = {x| A (x) ≥ α}

9 El esquema de clasificación que se basa en los cortes naturales identifica puntos de quiebre mediante la identificación de patrones inherentes en la serie de datos de la respuesta. En la clasificación de acuerdo a los cuantiles, los elementos son agrupados en categorías con la misma cantidad de elementos. En el esquema de categorías de iguales intervalos, se divide todo el espectro en regiones de igual extensión. En el caso del uso de desviaciones estándar los datos son clasificados de acuerdo a la dispersión de la respuesta con respecto al valor medio del espectro (Ayalew, Yamagishi y Ugawa, 2004).

10 En la tabla se muestran los valores de susceptibilidad mediante los elementos de un número difuso trapezoidal: un número difuso trapezoidal A es definido por la tupla A = (a, b, c, d), donde a y d acotan el intervalo de valores mínimo y máximo de la pieza de información difusa, y b y c son los valores que acotan el intervalo con µ(x) o α = 1,0 que corresponde al intervalo con mayor certeza dentro del conjunto de valores contenidos en el intervalo [ a, b ].

11 El concepto de parámetro difuso, es una consecuencia de las propiedades no estacionarias y la incertidumbre de los procesos complejos. Esta propiedad también tiene su origen en condiciones de escasa información y deficiencias de conocimiento y las propiedades no lineales que pueda tener un sistema dado. El concepto de parámetro difuso es aplicado por Abo-Sinna, Amer y El Sabed, (en impresión).

12 En el dominio de los números difusos se dan dos tipos de transformaciones que permiten modificar la información. Una entidad difusa puede ser defusificada. La aproximación de una pieza de información difusa a una cantidad o categoría crisp, es denominada defusificación. En el proceso de defusificación, las cantidades y valores difusos son aproximados mediante un punto crisp o dato duro único factible equivalente (Facchinetti y Pacchiarott, 2006, Kovitz y Christakos, 2004). La fusificación es el proceso contrario.

Bibliografía

Abo-Sinna, M. A., Amer, A.H., El Sabed, H. H., An interact-tive algorithm for decomposing the parametric space in fu-zzy multiobjective dynamic programming problem., A-pplied Mathematics and Computation, en impression, 2005. [ Links ]

Arango, J. D., Relaciones lluvias-deslizamientos y zonifica-ción geotécnica en la comuna dos de la ciudad de Manizales., Monografía presentada a la Facultad Nacional de Minas de Universidad Nacional de Colombia, para optar por el grado de Especialista en Aprovechamiento de Re-cursos Hidráulicos, 2000. [ Links ]

Ayalew, L., Yamagishi, H., Ugawa, N., Landslide suscep-tibility mapping using GIS-based weighted linear combination, the case in Tsugawa area of Agano River., Niigata Prefecture, Japan, Landslides, Vol. 1, No. 1, 2004. [ Links ]

Baudrit, C., Guyonnet, D., Dubois, D., Postprocessing the Hybrid Method for Addressing Uncertainty in Risk Assessment, Journal of Environmental Engineering, Vol. 131, No. 12, 2005. [ Links ]

Beguería, S., Validation and Evaluation of Predictive Models in Hazard Assessment and Risk Management., Natural Hazards, Vol. 37, No. 3, 2006. [ Links ]

Behounek L., Cintula P., From fuzzy logic to fuzzy mathematics: A methodological manifesto., Fuzzy Sets and Sys-tems, Vol. 157, No. 5, 2006. [ Links ]

Benedikt, J., Reinberg S., Riedl, L., A GIS application to enhance cell-based information modeling., Information Sciences, Vol. 142, 2002. [ Links ]

Benferhat, S., Dubois, D., Prade, H., Possibilistic Logic Handling of Preferences., Applied Intelligence, Vol. 14, 2001. [ Links ]

Binaghi, E., Luzi, L., Madella, P., Rampini, A., Slope Instability Zonation: a Comparison Between Certainty Factor and Fuzzy Dempster–Shafer Approaches., Natural Hazards, Vol. 17, 1998. [ Links ]

Cardona, O., Estimación holística del riesgo sísmico utilizando sistemas dinámicos complejos., tesis presentada a la Escuela Técnica Superior de Ingenieros de Caminos, Canales y Puertos de la Universidad Politécnica de Cataluña, para optar el grado de Doctor, 2001. [ Links ]

Chi, K-H., Park, N-W, Chung, C-J., Fuzzy logic integration for Landslide Hazard Mapping using Spatial Data from Boeun., Korea, Proceedings of Symposium on Spatial Theory, Processing and Applications, Ottawa, International Society for Photogrammetry and Remote Sensing, 2002. [ Links ]

Chivatá, I., Contribuciones para el tratamiento de la incertidumbre en la estimación de la amenaza por fenómenos de remoción en masa., tesis presentada a la Universidad Nacional de Colombia, para optar al grado de Magíster en Medio Ambiente y Desarrollo, 2007. [ Links ]

Chow, V. T., Maidment, D. R. y Mays, L. W, Hidrología Aplicada., McGraw-Hill Interamericana. S.A., 1996. [ Links ]

Christian, J. T., Geotechnical Engineering Reliability: How Well Do We Know What We Are Doing?., Journal of Geo-technical and Geoenvironmental Engineering, Vol. 130, No. 10, 2004. [ Links ]

COLPADE., Comité local para la prevención, atención y recuperación de desastres, Primer informe emergencia., Marzo 18 y 19 de 2003, Manizales, Col., Alcaldía de Manizales, 2003. [ Links ]

COLPADE., Comité local para la prevención, atención y recuperación de desastres, Primer informe emergencia,. Octubre 28 y 29 de 2003, Manizales, Col., Alcaldía de Manizales, 2003a. [ Links ]

Dodagoudar, G. R., Venkatachalam, G., Reliability analysis of slopes using fuzzy sets theory., Computers and Geotechnics, Vol. 27, 2000. [ Links ]

Dubois, D., Prade, H., Fuzzy sets and probability: misunderstandings, bridges and gaps., In: Proceedings of the 2nd IEEE International Conference on Fuzzy Systems (FUZZ-IEEE93), San Francisco, CA, 1993. [ Links ]

Dubois, D., Prade, H., Possibility Theory. An Approach to Computerized., Processing of Uncertainty, Plenum Press, New York, 1988. [ Links ]

Dubois, D., Forty years of fuzzy sets., Fuzzy Sets and Systems, Vol. 156, 2005. [ Links ]

Dubois, D., Possibility theory and statistical reasoning., Computational Statistics & Data Analysis, Vol. 51, 2006. [ Links ]

Ercanoglu, M., Gokceoglu, C., Landslide Susceptibility Zoning North of Yenice., (NW Turkey) by Multivariate Statis-tical Techniques, Natural Hazards, Vol. 32., 2004. [ Links ]

Facchinetti, G., Pacchiarotti, N., Evaluations of fuzzy quantities., Fuzzy Sets and Systems, Vol. 157, 2006. [ Links ]

Goodman, L. A., On simultaneous confidence intervals for multinomial proportions., Technometrics, Vol. 7, No. 2, Disponible en http://links.jstor.org, 1965. [ Links ]

Gorsevski, P. V., Gessler, P. E., Jankowski, P., Integrating a fuzzy k-means classification and a Bayesian approach for spatial prediction of landslide hazard., Journal of Geographic Systems, Vol. 5, 2003. [ Links ]

Islam, Z., Fractals and fuzzy sets for modelling the heterogenity and spatial complexity of urban landscapes using multiscale remote sensing data., Tesis presentada a Curtin University of Technology, para optar al título de Doctor of Philosophy, 2004. [ Links ]

Juang, C. H., Lee, D. H., Sheu, C., Mapping Slope Failure Potential Using Fuzzy Sets., Journal of Geotechnical Engineering, Vol. 118, No. 3, 1992. [ Links ]

Juang, C. H., Jhi, Y-Y., Lee, D.-H., Stability analysis of existing slopes considering uncertainty, Engineering Geology, Vol. 49, Np. 2, 1998. [ Links ]

Kandel, A., Martins, A., Pacheco, R., Discusión de On the Very Real Distinction Between Fuzzy and Statistical Methods, Technometrics, Vol. 37, No. 3, Disponible en http://links.jstor.org, 1995. [ Links ]

Kentel, E., Aral, M. M., 2D Monte Carlo versus 2D Fuzzy Monte Carlo health risk assessment., Stochastic Environmental Research on Risk Assessment, Vol. 19, 2005. [ Links ]

Kikuchi, S., Pursula, M., Treatment of Uncertainty in Study of Transportation: Fuzzy Set Theory and Evidence Theory., Journal of Transportation Engineering, Vol. 124, No. 1, 1998. [ Links ]

Klir, G., Yuan, B., Fuzzy sets and Fuzzy Logic., Theory and applications, Prentice Hall PTR (ed), New Jersey, 1995. [ Links ]

Kovitz, J.L., Christakos, G., Assimilation of fuzzy data by the BME method., Stochastic Environmental Research, Vol. 18, 2004. [ Links ]

Kreinovich, V., Nguyen, H. T., Which fuzzy logic is the best: Pragmatic approach (and its theoretical analysis)., Fuzzy Sets and Systems, Vol. 157, No. 5, 2006. [ Links ]

Laviolette, M., Seaman, J. W., Barrett, D., Woodall, W. H., A probabilistic and statistical view of fuzzy methods: Reply Technometrics, Vol. 37, No. 3, Disponible en http://links.jstor.org, 1995. [ Links ]

Lee, S., Application and verification of fuzzy algebraic ope-rators to landslide susceptibility mapping., Environmental Geology, 2006. [ Links ]

Leung, Y, Fuzzy sets approach to spatial analysis and planning, a nontechnical evaluation., Geografiska Annaler. Series B. Human Geography, Vol. 65, No. 2, Disponible en http://links.jstor.org, 1983. [ Links ]

Makropoulos, C. K., Butler, D., Spatial ordered weighted averaging: incorporating spatially variable attitude towards risk in spatial multi-criteria decision-making., Environmental Modelling & Software, Vol. 21, 2006. [ Links ]

Mares, M., How to handle fuzzy quantities?., Kybernetika, Vol. 13, No. 1, 1977. [ Links ]

Martin-Clouaire, R., Cazemier, D., Lagacherie, P., Representing and processing uncertain soil information for mapping soil hydrological properties., Computers and Electronics in Agriculture, Vol. 29, 2000. [ Links ]

Masson, M. H., Denoeux, T., Inferring a possibility distribution from empirical data., Fuzzy sets and systems, Vol.157, 2006. [ Links ]

Millán, J., Evaluación sistemática de procesos y efectos de fenómenos de remoción en masa en Santafé de Bogotá. –Propuesta metodológica., Memorias del VIII Congreso Colombiano de Geotecnia, Bogotá D.C., Sociedad Colombiana de Geotecnia,1999. [ Links ]

Morgenstern, N., Managing risk in geotechnical engineering., Memorias del 10mo Congreso Panamericano de Mecánica de Suelos e Ingeniería de Fundaciones, Vol. 4, México, Sociedad Mejicana de Mecánica de Suelos, 1995. . [ Links ]

Novák, V., Are fuzzy sets a reasonable tool for modeling vague phenomena?, Fuzzy Sets and Systems, Vol. 156, 2005. [ Links ]

Novák, V., Which logic is the real fuzzy logic?, Fuzzy Sets and Systems, Vol. 157, No. 5, 2006. [ Links ]

Pistocchi, A., Luzi, L., Napolitano, P., The use of predictive modeling techniques for optimal exploitation of spatial databases: a case study in landslide hazard mapping with expert system-like methods., Environmental Geology, Vol. 41, 2002. [ Links ]

Portilla, M. E., Aplicación de los Sistemas de Lógica Difusa en el Análisis de la Susceptibilidad a Fenómenos de Remoción en Masa., Geología Colombiana, Vol. 26, 2000. [ Links ]

Portilla, M. E., Evaluación de la Amenaza por Deslizamiento en Málaga, Santander, Aplicando la Metodología de los Conjuntos Difusos: Un Tema de Geología Ambiental., Geología Colombiana, Vol. 24, 1999. [ Links ]

Remondo, J., González-Díez, A., Diaz, J. R., Cendrero, A., Landslide Susceptibility Models Utilising Spatial Data Analysis Techniques., A Case Study from the Lower Deba Valley, Guipúzcoa (Spain), Natural Hazards, Vol. 30, 2003. [ Links ]

Tangestani, M. H., Landslide susceptibility mapping using the fuzzy gamma operation in a GIS, Kakan catchment area., Iran Conference Proceedings Map India , Disponible en http://www.gisdevelopment.net/proceedings/mapindia/2003, 2003. [ Links ]

Van Westen, C. J, Van Asch, T. W. J., Soeters, R., Landslide hazard and risk zonationwhy is it still so difficult?, Bulletin of Engineering Geology and the Environment, 2006. [ Links ]

Vanegas, L., A fuzzy approach to design evaluation, Scientia et technica, No. 12, 2000. [ Links ]

Yesilnacar, E., Topal, T., Landslide susceptibility mapping: A comparison of logistic regression and neural networks methods in a medium scale study, Hendek region (Turkey)., Engineering Geology, Vol. 79, 2005. [ Links ]

Zadeh, L., Fuzzy Sets. Information and Control, Vol. 8, 1965. [ Links ]

Zadeh, L., Calculus of Fuzzy restrictions., in: L.A. Zadeh, KS. Fu, K. Tanaka and M. Shimura, eds., Fuzzy Sets and Their Applications to Cognitive and Decision Processes, Academic Press, New York, 1975. [ Links ]

Zadeh, L., Fuzzy sets as a basis for a theory of possibility., Fuzzy Sets and Systems, Vol. 1, No. 1, 1978. [ Links ]