Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO -

Similars in Google

Similars in Google

Share

Estudios de Filosofía

Print version ISSN 0121-3628

Estud.filos no.45 Medellín Jan./June 2012

ARTÍCULOS DE INVESTIGACIÓN

Datos, fenómenos y teorías*

Data, phenomena and theories

Por: Germán Guerrero Pino**

**Grupo de investigación Episteme: filosofía y ciencia

Departamento de Filosofía

Universidad del Valle

Cali, Colombia

E-mail: germangpino@gmail.com

Fecha de recepción: 31 de noviembre de 2011

Fecha de aprobación: 14 de febrero de 2012

Resumen: El presente escrito se propone presentar el modelo de tres niveles del conocimiento científico (datos, fenómenos y teorías) desde los recientes resultados de la filosofía de la ciencia obtenidos por dos perspectivas filosóficas particulares: el nuevo experimentalismo y el enfoque semántico de las teorías. Para ello contrasta los planteamientos principales de estas dos perspectivas con el modelo de dos niveles del conocimiento científico (observación y teoría) del positivismo lógico, que dominó el panorama de la filosofía de la ciencia en las primeras seis décadas del siglo XX.

Palabras claves: Datos, fenómenos, teorías, nuevo experimentalismo, enfoque semántico.

Abstract: The present written work presents the model of three levels of scientific knowledge (data, phenomena and theories) bearing on the recent results of the actual Philosophy of Science obtained through two particular philosophical perspectives: The New Experimentalism and the Semantic Approach of Theories. In order to do so, it contrasts of the main approaches of these two perspectives with the model of two levels of scientific knowledge (observation and theory) which belong to Logical Positivism, and that dominated the outlook of the Philosophy of Science during the first six decades of the 20th Century.

Key words: Data, Phenomena, Theories, New Experimentalism, Semantic Approach.

1. Introducción

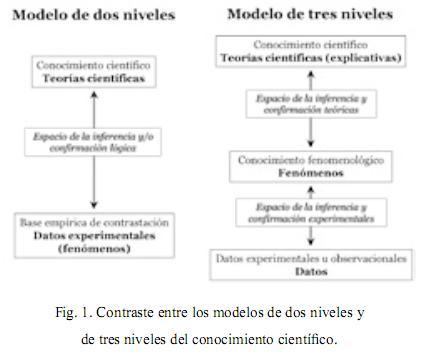

El presente escrito se propone abordar el tema de la estructura del conocimiento científico desde los recientes resultados de la filosofía de la ciencia obtenidos por dos perspectivas filosóficas particulares: el nuevo experimentalismo (New Experimentalism) y el enfoque semántico o modelista de las teorías. Para ello contrasta los planteamientos principales de estas dos perspectivas con los planteamientos correspondientes de los empiristas o positivas lógicos, que dominaron el panorama de la filosofía de la ciencia en las primeras seis décadas del siglo XX. La imagen que propone el nuevo experimentalismo de la estructura del conocimiento científico es de tres niveles: datos, fenómenos y teoría; en tanto que la imagen propuesta por los empiristas lógicos tenía sólo dos, fenómenos o datos (no establecen diferencia alguna entre ellos) y teoría. Además, podríamos decir que esta última imagen corresponde a la idea más extendida o dominante entre filósofos y científicos.

Pero las diferencias no sólo radican en el número de elementos estructurales del conocimiento científico y sus relaciones sino también en la forma de entender cada uno de ellos. Respecto a la comprensión de las teorías científicas se produce un cambio importante en la década de los setenta, cuando los promotores del enfoque semántico de las teorías plantean que es más apropiado concebir una teoría como un conjunto de modelos (estructuras) o idealizaciones que como un conjunto de enunciados (leyes más sus derivaciones lógicas), tal y como propusieron los empiristas lógicos. El enfoque semántico permite, además, clarificar la función primaria que tienen las leyes o principios de una teoría, pues éstas más que describir aspectos de la realidad lo que hacen es definir (describir) los modelos o idealizaciones correspondientes a una teoría.

2. Modelo de dos niveles y enfoque lingüístico de las teorías

Desde una perspectiva ampliamente compartida sobre la ciencia, podríamos decir que la ciencia nos proporciona conocimiento del mundo natural, y que para ello, en su forma más elaborada o acaba, construye teorías que explican y predicen de manera sistemática lo que sucede en la naturaleza, esto es, los hechos o fenómenos naturales. Se supone entonces que los fenómenos naturales tienen que ver con objetos, propiedades y sucesos que son observables, que pueden percibirse por medio de los sentidos o, en algunos casos, con ayuda de instrumentos.

Ahora bien, el carácter sistemático del conocimiento científico se logra en gran parte mediante elaboración de teorías que proponen o postulan principios o leyes que establecen relaciones entre conceptos que refieren a supuestos objetos, propiedades y sucesos que no son observables por los sentidos, de ahí que se les califique de teóricos a este tipo de conceptos. Al parecer los conceptos teóricos se encuentran en una posición paradójica al ser, al mismo tiempo, necesarios e incognoscibles: necesarios por permitir sistematizar el conocimiento e incognoscibles por referir a inobservables. De nuevo, bajo esta arquitectura general de las teorías, una teoría debe dar cuenta de fenómenos (observables).

La mecánica newtoniana permite una buena ilustración de lo anterior. Por una parte, esta teoría explica distintos fenómenos que tienen que ver con el movimiento de cuerpos sobre la Tierra y cuerpos celestes. En el primer caso, tenemos movimientos como la caída de los cuerpos, el de los proyectiles, el plano inclinado y el pendular; y, en el segundo caso, movimientos como el de la Luna, el de los planetas y el de la Tierra. Por la otra, podríamos decir que éste poder explicativo de la teoría radica en haber introducido nuevos conceptos, como masa y fuerza (piénsese en particular en la fuerza de gravedad), que se relacionan entre sí y con conceptos ya conocidos como el de aceleración, a través de las conocidas leyes de movimiento y la ley de gravitación universal. El carácter teórico (inobservable) de la fuerza de gravedad radica en que no es una fuerza que actúa por contacto sino a distancia, que se trasmite a una gran velocidad (al parecer infinita) y sin gasto de energía. La gravedad se trasmite en el vacío, no requiere de ningún medio para ello, y no es posible detectarla directamente sino a través de los efectos que produce entre cuerpos suficientemente masivos.

En la anterior imagen dominante de la ciencia, del conocimiento científico, predominan dos niveles, el observacional y el teórico. Esta idea general fue recogida, sistematizada y radicalizada en la filosofía de la ciencia desarrollada por los positivistas o empiristas lógicos, la cual presentaron bajo una perspectiva dominada por el análisis semántico del lenguaje científico (véase la parte izquierda de Fig.1). El lenguaje de una teoría particular se divide en lenguaje observacional y lenguaje teórico. El lenguaje observacional contiene conceptos que refieren a entidades, propiedades y sucesos que son observables, tales como caliente, blanco, mesa y coincidencia. El lenguaje teórico contiene conceptos que denotan entidades, propiedades y sucesos no observables, tales como electrón, átomo, campo gravitacional e impulso psicológico. Los conceptos teóricos son introducidos por las teorías y hacen parte de sus principios o leyes. Los enunciados observacionales contienen únicamente términos observacionales y, por tanto, dado ese carácter observacional, su verificación no es problemática: directamente a través de la observación es posible determinar la verdad o falsedad de un enunciado de observación. Aún más, la significatividad de los enunciados observacionales es igualmente no problemática puesto que el positivismo lógico ligó el tema semántico del significado (empírico o cognitivo) de un enunciado con el tema epistemológico de su verificación a través de su criterio verificacionista del significado, de acuerdo con el cual un enunciado es significativo si y sólo si es en principio verificable y su significado está dado por las condiciones en que es verificado (véase Carnap, 1963: 45). Tal procedimiento de verificación y de significatividad (mediante la observación directa) no es posible aplicarlo a enunciados teóricos como los principios de una teoría, pues éstos contienen términos teóricos que no son directamente observables. El significado y la verificación de los enunciados teóricos sólo es posible, de acuerdo con el positivismo lógico, teniendo en cuenta que dentro de una teoría hay una serie de enunciados mixtos (llamados por algunos reglas semánticas y por otros reglas de correspondencia) que relacionan los conceptos teóricos con los observacionales, tendiéndose así una especie de puente entre los niveles observacional y teórico. De no existir tal puente, los conceptos teóricos serían asignificativos por completo y los enunciados teóricos serían en principio inverificables.

En un principio los positivistas lógicos creyeron que era posible tener total certidumbre de los principios de una teoría, esto es, verificarlos (lo cual no admite grados); pero después, en su etapa de liberalización del empirismo, se aferraron al carácter hipotético de los principios: los principios no son verificables mediante pruebas observacionales sino que son más o menos confirmados o no por la evidencia observacional disponible (véase Carnap, 1963: 57 y 59). Este cambio de parecer se debió a que si la función de las reglas de correspondencia fuese la de proporcionar una definición (que debe ser completa) de los conceptos teóricos en términos que designen observables, entonces los conceptos ya no serían teóricos sino observacionales, lo cual contradeciría el punto de partida de que el conocimiento científico está estructurado en dos niveles. Por tanto, los conceptos teóricos tienen un carácter abierto en cuanto a su significado, no son completamente interpretables (definibles) mediante las reglas de correspondencia; y, por la misma razón, no son verificables totalmente a través de la experiencia, sólo son confirmables en cierto grado. En otras palabras, la evidencia empírica a favor de un enunciado teórico depende de la evidencia disponible a favor de los enunciados observacionales con los que está vinculado en la teoría. La experiencia sigue jugando un papel protagónico en la justificación lógica de las teorías, aunque ya no absoluto: la experiencia no asegura la infalibilidad del conocimiento científico, sólo su fiabilidad.

Este modelo de dos niveles del conocimiento científico va acompañado de una noción relativamente precisa de lo que es una teoría científica. Una teoría es un conjunto de enunciados organizados deductiva o axiomáticamente, en sentido estricto. En términos más precisos, una teoría científica es un cálculo (o sistema) formal axiomatizado, cuyos axiomas representan las leyes fundamentales (o principios) de la teoría y que está parcialmente interpretado mediante reglas de correspondencia (o de interpretación) que relacionan términos teóricos con términos observacionales (véase Carnap, 1939: 125). Esta perspectiva sobre las teorías científicas se conoce como enfoque sintáctico (o concepción heredada o enfoque sintáctico-axiomático o concepción enunciativa o enfoque lingüístico) porque todo cálculo formal se encuentra asociado con la sintaxis de un lenguaje formal y, además, la derivabilidad en un lenguaje formal es una noción sintáctica. Una ilustración, bajo esta perspectiva la mecánica newtoniana equivale, básicamente, a las tres leyes de movimiento con la ley de gravedad, más todos los demás enunciados que de esas leyes se deducen lógicamente. Además, se dice que este es un enfoque lingüístico de las teorías debido al énfasis que hace en los enunciados de la teoría.

La presentación de arriba sólo subraya los elementos centrales de la epistemología de los empiristas lógicos, con el propósito de destacar su concepción de la estructura del conocimiento científico formado por dos niveles y su noción de las teorías científicas como conjuntos de enunciados, la cual se integra perfectamente con el modelo de dos niveles del conocimiento. De modo que la presentación deja muchos detalles técnicos e históricos sin profundizar, para pasar a desarrollar, eso sí con mayor detalle, las principales tesis del nuevo experimentalismo y el enfoque semántico de las teorías. Pero antes vale puntualizar la principal crítica que hace cada uno de estos programas filosóficos a la propuesta empirista lógica.

Así, en la orientación del nuevo experimentalismo, cabe preguntarse: ¿qué papel desempeña la experimentación en el conocimiento científico bajo este enfoque de los dos niveles? Este enfoque se caracteriza por no hacer ningún tipo de reflexión directamente sobre la experimentación, pero dados sus planteamientos no es difícil inferir lo que está presuponiendo acerca de ésta: la experimentación se equipara por completo con la observación1 y, por tanto, la función de los experimentos (como la de la observación) en la ciencia es exclusivamente la de confirmar o refutar teorías. Esto es, en los términos lingüísticos de la reflexión precedente, la observación y la experimentación proporcionan los enunciados observacionales que sirven para contrastar una teoría, y no más.

Ahora bien, frente a la concepción de teoría, existe un amplio consenso en cuanto que la principal dificultad que enfrenta esta forma de caracterizar las teorías radica en su dependencia lingüística, en implicar que las teorías son entidades lingüísticas, ya que todo cálculo formal se encuentra bajo el yugo de la sintaxis de un lenguaje formal. De modo que aquí la sintaxis no es secundaria y, entonces, el enfoque enfrenta la siguiente dificultad: intuitivamente, como en la práctica científica, es claro que podemos tener distintas formulaciones de una misma teoría, es decir, podemos presentar una misma teoría mediante lenguajes diferentes; pero esta situación no queda explicada por el enfoque sintáctico sino que este implica todo lo contrario, pues el tener dos formulaciones distintas equivale a tener dos sintaxis, dos lenguajes distintos, lo cual equivale a tener dos teorías diferentes. En definitiva, para la concepción sintáctica cambios en los enunciados (en el lenguaje) de una teoría implica un cambio de teoría. Pero para los físicos es claro que, por ejemplo, la mecánica newtoniana se puede presentar, formular, en términos algebraicos, diferenciales, lagrangianos o hamiltonianos. También se tiene el caso bien conocido de la mecánica cuántica, en donde la teoría de las transformaciones de Dirac y Jordan demuestra la equivalencia de la formulación de Born, Heisenberg y Jordan (teoría de las matrices) y la formulación de Schrödinger (mecánica ondulatoria). J. von Neumann demostró la equivalencia de las dos formulaciones demostrando que contienen las mismas estructuras,2 y este hecho es precisamente lo principal que busca resaltar el enfoque semántico: las distintas formulaciones de una misma teoría, si lo son, describen con distintos recursos lingüísticos y matemáticos las mismas estructuras matemáticas. De modo que a este conjunto de estructuras matemáticas abstractas se le puede llamar teoría con toda propiedad, y no a las formulaciones particulares.

3. El nuevo experimentalismo: modelo de tres niveles

El nuevo experimentalismo hace parte del movimiento más amplio en filosofía de la ciencia que ha promovido el giro del estudio de las teorías científicas hacia el estudio más amplio de la práctica científica, el cual es apoyado por un número creciente de filósofos, historiadores y sociólogos de la ciencia, desde comienzos de la década de los ochentas del siglo pasado. El giro historicista en filosofía de la ciencia, liderado por Kuhn a comienzos de la década de los sesentas, influyó positivamente en este movimiento más amplio.

Aunque no hay una agenda programática que agrupe a los integrantes del nuevo experimentalismo, una tesis central que comparten es que el estudio de la experimentación, la instrumentalización y las prácticas de laboratorio en la ciencia ''puede ofrecer un recurso importante, aunque ampliamente sin explotar, para reorientar los problemas clave en filosofía de la ciencia'' (Mayo 1994: 270), como, por ejemplo, el de la estructura del conocimiento científico, la evaluación de las teorías, la estructura de las teorías y el papel de la observación y la experimentación en el conocimiento científico. Ackermann (1989) es quien introduce la expresión Nuevo experimentalismo en la reseña que hace del libro The Neglect of Experiment (1986) de Allan Franklin, para subrayar la tesis central mencionada; y, además, allí considera que ''Hacking (1983) proporciona un contexto filosófico para el trabajo de Franklin'' (Ackermann, 1989: 186), y por tanto de dicha tesis. Efectivamente hay que reconocer que fue Hacking, en su libro Representar e intervenir (1983), uno de los primeros en llamar la atención sobre la importancia de la epistemología de la experimentación para la filosofía de la ciencia y también en desarrollar una propuesta sistemática al respecto. El valor de esta obra dentro del nuevo experimentalismo es tal que el eslogan ''La experimentación tiene una vida propia'' (Hacking, 1983: xiii y 150),3 consignado, ilustrado y justificado allí por Hacking, suele utilizarse como un medio para identificar dicho movimiento. ¿Qué se quiere decir con ello? Es posible identificar cuatro sentidos del eslogan en los que cada uno de ellos enuncia un tema puesto de relieve por los promotores de dicho movimiento.

1) Es importante distinguir entre observación y experimentación, la experimentación no se reduce a observar, tal y como promovió la filosofía de la ciencia clásica: ''la observación y el experimento no son la misma cosa, ni siquiera los polos opuestos de un continuo'' (Hacking, 1983: 173). La diferencia central radica en que en la experimentación los científicos intervienen activamente en los objetos y sistemas naturales que están investigando. Además, el único objetivo de los experimentos no es el de comprobar o contrastar teorías científicas generales de alto nivel,4 tal y como también subrayó la filosofía de la ciencia clásica. La investigación experimental puede ser conducida por múltiples motivos: hay experimentos de carácter exploratorio, que descubren nuevos fenómenos o regularidades experimentales que los científicos intentarán explicar posteriormente por medio de teorías (véase Hacking, 1983; Franklin, 2007; Woodward, 2009; Ferreirós y Ordóñez, 2002); algunos experimentos pueden suministrar evidencia suficiente sobre la existencia de las entidades postuladas por las teorías (Hacking, 1983; Franklin, 2007); otros pueden dar pistas sobre la estructura o forma matemática de una teoría (Franklin, 2007); y, desde luego, otros se diseñan con el propósito expreso de comprobar una teoría.

2) La experimentación también incluye actividades que tienen que ver con técnicas experimentales, diseños experimentales, diseño de instrumentos, comprobación de instrumentos, control de factores extraños, distinguir los efectos reales de los artificiales, procedimientos de análisis de datos, realización de cálculos precisos y cálculo de los efectos de los factores de fondo (véase Woodward, 2009; Mayo, 1994; Ferreirós y Ordóñez, 2002). Estas actividades, así como los distintos propósitos mencionados, normalmente se desarrollan en forma relativamente independiente de teorías o del teorizar. En particular, la evidencia experimental no tiene por qué estar cargada de teoría de tal modo que la invalide como fundamento empírico de una teoría (véase Woodward, 2009).

3) El conocimiento experimental tiene su propia estabilidad interna, normalmente sobrevive a grandes transformaciones teóricas de alto nivel. Los logros experimentales (en particular la estabilización de una regularidad fenoménica) perduran a los cambios de teoría, de modo que estos pueden constituirse en un referente clave para resolver disputas entre teorías y para la comprensión del progreso científico.

4) La arquitectura del conocimiento científico contiene, por los menos, tres niveles: datos, fenómenos y teorías explicativas5 (véase la parte derecha de Fig. 1). Con las palabras de Bogen y Woodward:

Los datos son la evidencia para la existencia de los fenómenos porque en gran parte pueden ser sencillamente observados. Sin embargo, normalmente los datos no son predecibles o explicados sistemáticamente por una teoría. En contraste, las teorías científicas bien desarrolladas predicen y explican hechos sobre fenómenos. Los fenómenos son detectados mediante el uso de datos, pero en muchos casos los fenómenos no son observables, en el sentido interesante del término... Los hechos sobre fenómenos también sirven como evidencia, pero lo común es que sean evidencia para las teorías generales de alto-nivel, que son las que los explican (Bogen y Woodward, 1988: 305-306).

Así que entre las principales preocupaciones del nuevo experimentalismo no sólo está la de distinguir entre observación y experimentación sino también entre datos y fenómenos. Los positivistas lógicos también asumieron como equivalentes estos dos últimos; en últimas, estas cuatro categorías fueron reducidas a la función que tienen las oraciones observacionales.

Este cuarto punto de la caracterización del nuevo experimentalismo, el modelo de tres niveles del conocimiento, es el que está siendo objeto de profundización en el presente trabajo, descuidando en buena medida los detalles sobre el resto de elementos y sus relaciones particulares que desarrolla dicho programa. La figura de abajo, recogida de Suárez (2003) con pequeños cambios, muestra los elementos básicos de los dos modelos del conocimiento científico.

De acuerdo con Bogen y Woodward, las teorías generales de alto nivel o las grandes teorías o teorías fundamentales o, simplemente, las teorías explicativas tienen la capacidad de proporcionar explicaciones relativamente detalladas y sistemáticas de los fenómenos, tal y como se entienden en el presente contexto (véase Woodward, 2009: 2). Estas teorías son lo mismo que las teorías de principios que contienen leyes básicas o principios teóricos (matemáticos) como las leyes de Newton, la ecuación de Schröedinger, el principio de relatividad, el principio de selección natural y las leyes de la genética mendeliana, que buscan explicar los fenómenos de sus respectivos dominios de investigación. Este tipo de teorías no proporcionan simplemente una explicación causal de un fenómeno en la que se enuncie meramente el factor causal que produce el resultado, sino que más bien la explicación es detallada y sistemática en el sentido que los principios de las teorías permiten determinar en forma detallada y cuantitativa los distintos factores causales y la forma como estos intervienen para producir el resultado. Así, por ejemplo, con la ilustración de Woodward (2009), en el caso bien conocido de la predicción de la teoría general de la relatividad del fenómeno de desviación de los rayos de luz en las cercanías del Sol, dicha teoría no simplemente dice que el campo gravitatorio del Sol es el que causa la desviación, sino que también, lo cual es más importante, la teoría permite determinar el valor de la desviación a partir de sus principios. Por tanto, en el presente contexto, las teorías explicativas sólo cubren un pequeño sector del gran espectro del teorizar científico en general.

En términos generales, el modelo de tres niveles plantea, en primer lugar, que los datos experimentales y/o observacionales son los que proporcionan la evidencia necesaria para dar por existente un fenómeno y sus propiedades; esto es, los fenómenos y sus propiedades son inducidos a partir de los datos. También plantea que son los fenómenos los que conforman la base de contrastación empírica, la evidencia, de una teoría; pero en sentido inverso las cosas no son equivalentes, en tanto que una teoría explica ciertos fenómenos, los fenómenos como tales no explican datos. Además, no hay una relación directa entre teoría y datos, los fenómenos median entre ellos.

¿Qué de la noción de fenómeno? Veamos lo que dicen dos de los representantes del nuevo experimentalismo. Hacking: ''un fenómeno, para mí, es algo público, regular, posiblemente con forma de ley, pero tal vez excepcional... Yo sigo el uso de esta palabra en la física y la astronomía'' (1983: 222). En palabras de Woodward, ''los fenómenos son estables, efectos repetibles o procesos que son objetos potenciales de predicción y explicación sistemática por parte de teorías generales, los cuales pueden servir de evidencia para tales teorías'' (2000: S163). Así, los fenómenos son regularidades apreciables del mundo natural y social; es decir, son patrones generales, estables y distinguibles. Los fenómenos no son simples observaciones, ni son datos de los sentidos ni descripciones de experiencias sensoriales o percepciones sensoriales, y no necesariamente tienen que ser observables. Los fenómenos, por lo general, se establecen mediante procedimientos experimentales. Entre las funciones de los experimentos están las de crear,6 producir, refinar y estabilizar fenómenos. La estabilización experimental de un fenómeno consiste en darle identidad al fenómeno, en mostrar que es repetible y que lo es bajo distintos contextos y condiciones.

Desde esta perspectiva el concepto de fenómeno incluye distintas categorías ontológicas, tales como objetos, propiedades de objetos, sucesos, procesos y estados; y el hecho que estos no estén, en cierta forma, directamente dados, tal y como pensaban los positivistas lógicos, no significa que sean constructos científicos en el sentido de no pertenecer al orden natural. Los fenómenos hacen parte del mundo natural, aunque para hacerlos evidentes se requiera en la mayoría de los casos tanto de un proceso de conceptualización como de experimentación.

Pues bien, se sigue manteniendo que las teorías explican y predicen fenómenos, que la base empírica de contrastación de las teorías explicativas la conforman hechos acerca de fenómenos; pero esta afirmación dista mucho de aquella más común, que resulta siendo demasiado simple y errónea, de acuerdo con la cual las teorías se contrastan directamente con la observación o experiencia, pues aquí fenómeno no equivale simplemente a lo que es observable. Establecer y precisar esta idea es el objetivo central del artículo de Bogen y Woodward (1988), idea que ya había sido desarrollada antes por Hacking (1983): ''si empleamos observar para decir percibir o detectar mediante procedimientos que son normalmente vistos como extensiones de la percepción, entonces las teorías científicas normalmente no predicen y explican lo que observamos'' (Bogen y Woodward, 1988: 305). Cuando la observación se entiende estrechamente vinculada con la percepción humana, tiene muy poco valor en la actividad experimental y científica en general;7 aunque, desde luego, ésta se requiere en la toma de datos, ya sea directamente o mediante instrumentos, de ahí que hablemos de datos observacionales o experimentales.

Pero, tal como lo adelantamos y lo veremos a continuación, tampoco es correcto sostener que las teorías se contrastan contra un conjunto de datos (observacionales o experimentales), pues el papel de los datos es servir de evidencia para la existencia de un fenómeno o de sus propiedades. Teoría y datos no están vinculados directamente, sino de manera indirecta a través de una larga y compleja serie de enunciados que describen fenómenos. En general, no hay una relación lógica directa entre datos y teoría, es posible establecer relaciones lógicas entre una teoría y enunciados fenomenológicos, pero incluso el tipo de razonamiento que lleva de la experimentación (los datos) a la determinación de los hechos fenoménicos no es por completo de carácter lógico.

En el presente contexto, como decíamos, ''los datos son registros públicos... producidos por mediciones y experimentos que sirven como evidencia para la existencia de los fenómenos o para ciertas propiedades poseídas por estos'' (Woodward, 2000: S163). Los datos son el resultado de observaciones precisas de aparatos de medida, tales como el desplazamiento nulo del patrón de interferencia en el experimento de Michelson-Morley, las líneas espectrales de Balmer, destellos en una pantalla fluorescente, rastros en una cámara de burbujas, etc.; y estos datos pueden ser representados como puntos en una gráfica. Así, son los datos y no los fenómenos los que se encuentran asociados con la observación en el sentido usual. Al ser los datos el resultado de experimentos particulares, dependen del contexto experimental que los genera y, por tanto, tienen una existencia contingente, efímera; los datos cambian cuando los instrumentos se hacen más precisos y los experimentos se mejoran, los viejos datos son reinterpretados y archivados, dejando paso a los nuevos. En este sentido, los fenómenos son mucho más estables que los datos, incluso sobreviven a los grandes cambios teóricos, aunque los últimos proporcionan la evidencia empírica de los primeros, y no de las teorías explicativas. Es cierto que, normalmente, las predicciones de una teoría explicativa tienen la forma de datos, es decir, se predice el valor que tomaría cierta magnitud (cierta propiedad del fenómeno) bajo ciertas circunstancias, pero en la mayoría de los casos lo que se busca es que el valor predicho sea relativamente aproximado bajo ciertos parámetros, lo cual equivale a que haya una buena predicción del fenómeno como tal antes que de los datos mismos, en una forma exacta.

Veamos algunas ilustraciones de las tres categorías, datos, fenómenos y teorías. Lo que normalmente llamamos leyes empíricas (que son diferentes de las leyes teóricas) son fenómenos, pues en realidad son regularidades que persisten. Leyes tan generales y corrientes como los metales se dilatan con el calor y el agua se evapora cuando se calienta en un recipiente abierto refieren a fenómenos. Leyes empíricas como la ley de Kepler, de acuerdo con la cual los planetas tienen movimientos regulares elípticos alrededor del Sol, y la ley de Galileo, según la cual los cuerpos caen con la misma aceleración en el vacío, son fenómenos que son explicados en sus distintos detalles por una teoría de principios (o leyes teóricas) como la mecánica newtoniana. La conocida ley de Boyle para los gases es una ley empírica, un fenómeno, que describe el comportamiento macro de los gases mediante la ecuación que relaciona presión, temperatura y volumen de un gas; y este fenómeno queda explicado por la teoría cinética de los gases que consiste básicamente en una aplicación de las leyes de Newton (leyes teóricas) a la composición molecular de los gases, de modo que son estas leyes las que verdaderamente describen el comportamiento interno de los gases y no la de Boyle.

Las constantes también hacen parte de los fenómenos, pues una constante simplemente es una propiedad de un cierto suceso, de un fenómeno. La constante g de la gravedad describe una de las propiedades de la caída libre de Galileo, algo semejante sucede con la constante c de la velocidad de la luz, la carga electromagnética e del electrón y con el punto de fusión del plomo, por ejemplo.

Los llamados efectos por los físicos, tales como efecto Hall, efecto Faraday o magneto-óptico, efecto Compton, efecto Zeeman, efecto fotoeléctrico, efecto anómalo de Zeeman, efecto Josephson, etc., también hacen parte de los fenómenos. En realidad la diferencia en el empleo de estos dos términos es una cuestión de grado y no de categoría, de contenido. La principal diferencia radica en que la mayoría de los fenómenos (los efectos) de la física moderna se producen artificialmente, no se encuentran directamente en la naturaleza, de modo que, como plantea Hacking: ''los fenómenos y los efectos son cosas del mismo tipo: regularidades valiosas discernibles... Los fenómenos nos recuerdan... sucesos que pueden ser registrados por el observador bien dotado que no interviene en el mundo... Los efectos nos recuerdan a los grandes experimentadores... que intervinieron en el curso de la naturaleza, para crear regularidades'' (Hacking, 1983: 225).

Con el objetivo de fijar aún más las ideas anteriores, veamos en extenso un ejemplo trabajado por Bogen y Woodward (1988: 308), el del punto de fusión del plomo, es decir, el hecho de que el plomo se funde a una temperatura de 327, 5 ± 0,1°C. Los físicos no llegan a este valor (a esta constante) mediante una única medición de la temperatura a la que una muestra de plomo se funde al ser expuesta a altas temperaturas, sino que en realidad hacen múltiples mediciones, y en este proceso gran cantidad de datos son desechados, descartados o reinterpretados. Desde luego, aunque se hayan controlado las posibles fuentes de error en las mediciones, las temperaturas de fusión obtenidas no son todas iguales, sino muy próximas. Estos valores medidos son los datos experimentales, en el sentido aquí precisado, y propiamente no son el punto de fusión del plomo, que es el fenómeno en el que se está interesado. Para obtener este último se requiere analizar los datos gráfica y estadísticamente, de tal manera que si, por ejemplo, se considera que los datos medidos se distribuyen normalmente, esto debe hacerse bajo ciertos supuestos sobre la forma como se comportan las distintas causas conocidas y desconocidas que llevan a que el plomo se funda a cierta temperatura; es decir, hay que tener en cuenta que la fusión de una muestra de plomo es consecuencia de múltiples relaciones causales que son las que llevan a que los resultados experimentales varíen en alguna medida. En definitiva se tiene un conjunto de datos que muestra una fuerte correlación temporal, en donde cada uno de ellos se aleja sistemáticamente de la media. Por tanto, se concluye, la media de la distribución de los datos es una buena estimación del punto de fusión del plomo (327, 5°C), de modo que el resultado final se suele expresar con el respectivo error estándar de la distribución, así por ejemplo: 327, 5 ± 0,1°C.

Un caso como el anterior pone en graves aprietos el modelo de dos niveles de la estructura del conocimiento científico propuesto por los positivistas lógicos, pues el enunciado ''el punto de fusión del plomo es 327,5°C'' no es ni observacional ni teórico. No es observacional porque lo que se ha observado, medido, son los datos, los distintos valores de temperatura y el punto de fusión (el fenómeno) es una media de la distribución de los datos, y como tal no describe una observación particular que se haya hecho. Incluso es posible que el punto de fusión (el fenómeno) no corresponda a ninguna de las mediciones realizadas, porque éste se ha obtenido a través de una inferencia o estimación estadística a partir de los datos observados. Así, son los datos los que proporcionan la evidencia para el punto de fusión. Por otra parte, dicho enunciado tampoco es teórico, pues no hace parte de un sistema teórico, y es por ello que no explica ni los datos de las temperaturas ni nada. En realidad, el enunciado es descriptivo y general, describe una propiedad general (el punto de fusión, 327,5 ± 0,1°C) de ciertas entidades del mundo (aquellas que son plomo) y no es una generalización acerca de los cuerpos en general como el enunciado ''los cuerpos son inertes''. Igualmente no es correcto afirmar que el punto de fusión proporciona la evidencia de los distintos datos. Lo que requiere explicación es el punto de fusión del plomo, lo cual hacen los físicos a través de una teoría de principios sobre la estructura molecular de la materia.

Finalmente, el presente ejemplo justifica muy bien la negativa a las implicaciones fuertes de la tesis de la carga teórica de la observación para la confirmación empírica de las teorías, ya que muestra no sólo que la base de contrastación de las teorías explicativas son los fenómenos, y no los datos observacionales, sino también que los datos, y en consecuencia los fenómenos, no dependen de ningún modo de la teoría explicativa que se está contrastando. En realidad, los procesos de selección, interpretación, evaluación y análisis de los datos es independiente de las teorías que dan cuenta de los respectivos sistemas que producen tales datos (véase Bogen y Woodward, 1988: 327). Así por ejemplo, para saber qué datos deben descartarse o reinterpretarse, es necesario saber si pueden replicarse los datos, si se han controlado apropiadamente las distintas fuentes de error, si se han presentado los argumentos de inferencia estadística correctamente, si se han llevado a cabo en forma correcta el tratamiento y análisis de los datos. Desde luego que en todos estos procesos interviene algún tipo de reflexión teórica, pero esta no tiene nada que ver con las supuestas teorías que explican los sistemas en estudio y que arrojan los respectivos datos. Algo semejante sucede con los fenómenos respecto a los datos; como puede observarse, debido a su reproducibilidad, los fenómenos son independientes de las condiciones concretas y métodos empleados en los experimentos diseñados para demostrarlos, y perduran en general mucho más de lo que perdura cualquier dato, incluso de lo que sobrevive cualquier teoría elaborada para explicarlos. Estas ideas del nuevo experimentalismo permiten dar cuenta del aumento del conocimiento científico al nivel experimental sin necesidad de suponer que debe venir acompañado por un crecimiento correspondiente al nivel teórico. En realidad los fenómenos se acumulan incluso durante los cambios radicales de teoría.

4. Enfoque semántico de las teorías

Como se anticipó, la idea central que defiende el enfoque semántico es que una teoría empírica hay que identificarla8 con un conjunto de modelos, estructuras matemáticas; o, metodológicamente,9 una teoría queda mejor comprendida como un conjunto de modelos, como el conjunto de modelos caracterizados o identificados a través de las leyes o principios de la teoría. A esta concepción se le califica de semántica o modelo-teórica debido al énfasis que hace en los modelos y a que en semántica formal (o teoría de modelos) el concepto de modelo representa una propiedad semántica. Hagamos uso, una vez más, de la mecánica newtoniana para ilustrar lo anterior: en la presentación de la teoría el énfasis no hay que hacerlo en sus leyes (como propone la concepción sintáctica) ni en la supuesta descripción que esas leyes hacen de (parte de) la realidad, sino más bien en los modelos (o sistemas idealizados) que las leyes describen, caracterizan o definen. Tipos de modelos como el siguiente: un conjunto de partículas puntuales con masa que interactúan entre sí mediante fuerzas de diversos tipos, de modo que las interacciones se dan de acuerdo con las leyes de Newton.

El enfoque semántico se originó, a mediados del siglo pasado, a partir de tres fuentes de trabajo principalmente: los estudios sobre los fundamentos de la mecánica cuántica realizados por el físico John von Neumann y el lógico holandés Evert W. Beth; la teoría de modelos de Alfred Tarski; y los métodos de axiomatización conjuntista informal de las teorías implementados por Patrick Suppes. En la actualidad podemos hablar de distintas versiones de la concepción semántica de las teorías en el sentido de que todas ellas comparten la idea central de que las teorías son conjuntos de modelos, pero discrepan en detalles como la noción de modelo involucrada, si los modelos son los únicos elementos constitutivos de una teoría, el instrumental matemático apropiado para representar las teorías, etc. Así, tenemos los trabajos de P. Suppes, cuya versión la podemos calificar de concepción semántica estándar, ya que identifica las teorías únicamente con el conjunto de modelos. Por otra parte están los trabajos de C. B. van Fraassen, R. Giere y F. Suppe, quienes identifican los modelos de las teorías a través de espacios de estados e introducen las hipótesis teóricas como parte de la identidad de una teoría. J. Sneed, W. Stegmüller, W. Balzer y C. U. Moulines han desarrollado el programa estructuralista, quienes utilizan, como Suppes, las herramientas de la teoría de conjuntos en el análisis de las teorías, las cuales identifican con un conjunto de estructuras más un conjunto de aplicaciones intencionales. En Europa también se encuentran otros intentos por analizar las teorías como predicados conjuntistas empleando las técnicas semánticas de Tarski. Entre los filósofos de la ciencia que lideran estos estudios son destacables el grupo de M. L. Dalla Chiara y G. Toraldo di Francia en Italia, y el grupo de Marian Przełecki y Ryszard Wójcicki. En esta misma dirección, también son muy importantes los trabajos del grupo de Newton da Costa y Steven French en Brasil.10

De acuerdo con la perspectiva que aquí se defiende sobre el enfoque semántico, recogida principalmente de van Fraassen y Giere, un modelo de una teoría científica tiene dos funciones, en un caso es una estructura que satisface una descripción y en el otro una estructura que representa aspectos de ciertos sistemas reales, tal y como a continuación precisaremos. Así, el término 'modelo' posee dos sentidos, pero la función relevante en el presente contexto sería la de representación. Además, estos dos sentidos no coincide con el de modelo semántico,11 aunque hay una tendencia generaliza a hacer tal equivalencia. Por tanto, para una mejor comprensión del tema, veamos lo que es modelo semántico, modelo ajustado a descripciones, modelo representacional y modelo teórico.

Un modelo semántico es un modelo de acuerdo a la teoría de modelos, esto es, una estructura no lingüística que proporciona una interpretación a un conjunto de enunciados y los hace verdaderos, los satisface en el sentido técnico de Tarski. Así, un modelo semántico es un modelo hacedor de verdad que adicionalmente proporciona una interpretación de un enunciado o conjunto de enunciados; en este sentido, un modelo semántico es realmente un modelo interpretativo.

De acuerdo con la teoría de modelos, una estructura (o sistema) A es una entidad abstracta compleja, compuesta por un conjunto no vacío A y una serie destacada de individuos a, de funciones f y de relaciones R. Al conjunto A se le llama universo de la estructura; a, f y R están definidos sobre el universo; y la estructura se representa así:

A = < A, <a1,..., ai>, <f1,..., fj>, <R1,.., Rk>>.

Ahora bien, la estructura A es un modelo de los enunciados del lenguaje de primer orden L, adecuado a la estructura A, si existe una función de interpretación I tal que hace que los nombres de L denoten individuos de A, que los predicados de L se correspondan con relaciones de A y que los enunciados de L adquieran un valor de verdad, esto es, que se conviertan en verdaderos o falsos en A. En otras palabras, si φ es un enunciado de L, entonces A es un modelo de φ o A satisface a φ o φ es verdadero en A o φ es satisfecho en A.

En el presente contexto diremos que A es un modelo semántico. Obsérvese que un modelo semántico siempre está vinculado a un lenguaje formal porque precisamente tiene como función interpretar un lenguaje. Veamos una ilustración. Supongamos los siguientes tres enunciados desinterpretados: ''a R b'', ''b R c'' y ''a ~R c''. Ahora podemos interpretar los símbolos del siguiente modo: a, b y c refieren a personas o vehículos, y R es la relación ''estar en contacto con'', de modo que ~R es la relación ''no estar en contacto con''. Pues bien, una fila formada por tres personas unidas y otra por tres vehículos unidos serían dos modelos del conjunto de enunciados; en otras palabras, los dos sistemas de filas son dos estructuras distintas que satisfacen, hacen verdaderos los tres enunciados iniciales. Obsérvese que hay infinitas interpretaciones posibles de los enunciados, y por tanto modelos de los mismos.

En segundo lugar, un modelo ajustado a descripciones12 es un sistema que hace verdaderos a los miembros de un conjunto de enunciados completamente interpretados, enunciados como los de los lenguajes ordinarios o científicos. De modo que estos modelos y los semánticos son modelos hacedores de verdad, pero un modelo ajustado a descripciones no es, en sentido estricto, un modelo interpretativo como el semántico. Veamos un ejemplo, consideremos el siguiente enunciado E de la física,

E: Toda resistencia se calienta cuando pasa una corriente por ella.

Este enunciado está completamente interpretado, así que no se trata de un enunciado semejante al del caso anterior. Ahora bien, dados dos sistemas o circuitos eléctricos particulares (R1, I1) y (R2, I2), con resistencia R1 y R2, y por los que pasan las corrientes I1 y I2, respectivamente; tenemos que estos dos circuitos satisfacen,13 hacen verdadero el enunciado E o, si se quiere, la descripción E. De ahí que se acostumbre a decir que estos sistemas o circuitos son modelos del enunciado E, son modelos que se ajustan (ajustados) a la descripción E.

Giere llama modelos teóricos14 a los modelos de las teorías de principios o explicativas, en el sentido precisado más arriba. Los modelos teóricos son estructuras matemáticas que cumplen dos condiciones: se ajustan a la descripción de los principios teóricos y representan aspectos del dominio de investigación. Puesto que la clase de modelos de la teoría queda definida o caracterizada mediante sus leyes; y dado que estas son enunciados; entonces es claro que los modelos satisfacen o se ajustan a las leyes, a las descripciones que estas proporcionan. Veamos esto en detalle, en términos de las teorías físicas, en donde un sistema es una entidad física que evoluciona en el tiempo, de modo que puede tener ciertos estados y cambiar de un estado a otro. Por tanto, los sistemas físicos tienen un espacio de estados posibles conformado por los posibles estados que pueden tener mientras cambian en el tiempo. Así, como plantea van Fraassen (1989: 223), un modelo, en un espacio de estados particular, equivaldría a un dominio de objetos más una función de historia que asigna a cada objeto una historia, es decir, una trayectoria en ese espacio. Un modelo seleccionaría entre todos los estados posibles de un sistema aquellos que en realidad podría tener; esto es precisamente lo que hace una ley: expresa los estados realmente posibles y los cambios realmente posibles en un espacio de estados. Aún más, cada espacio de estados tendría asociado, entonces, una clase de modelos. De modo que una teoría empírica tendría muchas clases de modelos, en donde cada clase tendría su propio espacio de estados; por tanto, presentar una teoría consistiría en describir la clase de los tipos de espacios de estados.

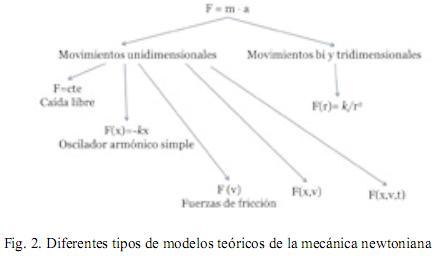

La mecánica newtoniana nos sirve una vez más como ilustración. Esta no puede reducirse estrictamente a las tres leyes de Newton, pues a partir de ellas no se sigue nada de mayor interés. Es por ello que en los libros de texto, después de enunciar las tres leyes se pasa a presentar los distintos tipos de fuerza (las funciones fuerza) o, por lo menos, las más importantes. Se comienza, entonces, por clasificar los movimientos de acuerdo a sus dimensiones en unidimensionales, bidimensional y tridimensionales. A continuación se especifican los tipos de fuerza en cada uno de ellos; así, por ejemplo, en el movimiento en una dimensión se tienen fuerzas uniformes (ley de caída libre), fuerzas en función de la posición (ley de Hooke), fuerzas en función de la posición y la velocidad, y fuerzas en función de la posición, la velocidad y el tiempo (como el oscilador armónico amortiguado). En el movimiento de dos o tres dimensiones se tienen, por ejemplo, las fuerzas centrales inversamente proporcional al cuadrado de la distancia. Véase la siguiente figura.

Como puede observarse, cada tipo de fuerza define un tipo de modelo y los distintos grupos de modelos están relacionados por la segunda ley de Newton. En definitiva, la mecánica newtoniana es un conjunto de conjuntos de modelos. Cada modelo es un sistema idealizado, abstracto, que tiene todas y únicamente las propiedades que se le adscriben a través de las leyes. Por ejemplo, el oscilador armónico simple es una entidad abstracta cuya característica distintiva es que satisface la ley f=-kx, de modo que dicha entidad o sistema se ajusta a la descripción de la correspondiente ley. Como esta ley es un enunciado interpretado, como lo son todas las leyes de las ciencias empíricas, entonces el oscilador armónico simple no es un modelo semántico sino uno que se ajusta a descripciones.

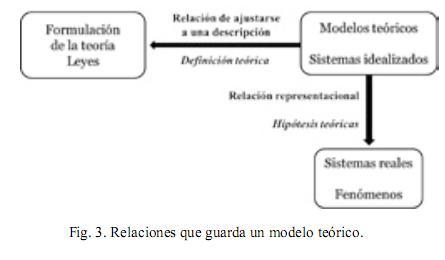

Lo anterior nos permite sintetizar algunas de las funciones que cumple una ley dentro de una teoría, aspectos que normalmente quedan ocultos bajo la concepción sintáctica de las teorías. Las leyes funcionan como definiciones o caracterizaciones de un modelo teórico, de un sistema idealizado. A través de ellas se precisan los distintos aspectos del modelo teórico, como por ejemplo las características de los cuerpos y la forma como interactúan entre sí. Por tanto, y en principio, las leyes aparecen como el medio a través del cual describimos los modelos teóricos y no propiamente el mundo; así que es más apropiado entenderlas, en un primer momento, como leyes o principios de las teorías que como leyes de la naturaleza. En segundo lugar, es claro que las leyes son verdaderas en los modelos teóricos correspondientes, la ley f=-kx es verdadera en el oscilador armónico simple (idealizado), pues una condición del modelo es que se ajuste a lo descrito por la ley. Pero esto no implica que la ley sea verdadera, en el mismo sentido anterior, en un sistema concreto del mundo real. Hasta aquí sólo hemos precisado la relación que guardan las leyes con los modelos teóricos y falta hablar de la relación que éstas tienen con los fenómenos, con los sistemas reales. Precisamente esa última relación tiene que ver con el carácter representacional de los modelos teóricos, que pasaremos a detallar.

La figura de abajo destaca esas dos relaciones de un modelo teórico, la relación de ajuste que tiene con la formulación de la teoría, con las leyes, y la relación de representación que mantiene con los fenómenos reales. Así que, como puede observarse, las leyes no están vinculadas directamente con los sistemas empíricos sino que dicha relación está mediada por los modelos teóricos.

En otros términos, para caracterizar una teoría no es suficiente con presentar el conjunto de modelos teóricos sino que también es necesario destacar su carácter representacional. Podríamos decir que este último aspecto se hace evidente, de acuerdo con van Fraassen y Giere, con las hipótesis teóricas asociadas a una teoría. De ahí que ellos formulen de una manera más completa la noción de teoría, respecto a su formulación estándar como un conjunto de modelos: ''presentar una teoría es definir un cierto tipo (o varios tipos) de sistemas más una o más hipótesis acerca de la relación de ciertos (tipos de) sistemas reales con la(s) clase(s) definida(s). Hablamos entonces de la definición teórica y de las hipótesis teóricas que conjuntamente constituyen la formulación de la teoría dada'' (van Fraassen, 1989: 226).15 Así, por ejemplo, para el caso anterior de la mecánica newtoniana, el conjunto de modelos teóricos caracterizados a través de las leyes de la mecánica, tal y como se hizo anteriormente, iría acompañado de una serie de hipótesis teóricas, de enunciados que relacionan los sistemas reales, los fenómenos, con algunos de los modelos teóricos o sistemas mecánicos idealizado; enunciados tales como: nuestro sistema solar es aproximado a tal sistema mecánico; la caída de los cuerpos sobre la Tierra es aproximado a tal otro sistema mecánico definido, etc. En síntesis, en la presentación de una teoría hay que tener en cuenta los siguientes elementos: la formulación (los principios), los modelos teóricos, los fenómenos y las hipótesis teóricas.

Ahora bien, tal y como plantea Giere (1999), el aspecto representacional de los modelos se puede comprender mejor a través de la función representacional que le asignamos a un mapa, por ejemplo a un mapa de una ciudad, en la que podemos subrayar las siguientes características.

i) El mapa no es una entidad lingüística, sino un objeto físico.

ii) Usualmente los mapas no son pensados como instanciando (o hacedores de verdad de) una forma lingüística o ajustándose a una descripción, sino como objetos que representan a otros.

iii) La relación de representación aquí involucrada es tríadica: se utiliza (los usuarios) un objeto (el mapa) para representar otro objeto (la ciudad). En otras palabras, hay una relación de representación entre la ciudad (el objeto representado) y el mapa (el objeto que representa), establecida y utilizada por los usuarios (quienes representan). Es en este sentido preciso que se acostumbra a decir que el mapa es un modelo de la ciudad.

iv) El mapa representa a la ciudad en ciertos aspectos (no en todos) y con cierto grado (aproximación y no igualdad).

Lo anterior puede expresarse del siguiente modo en términos de teorías empíricas.

i) Las teorías no son entidades lingüísticas, son entidades abstractas, estructuras matemáticas, modelos, idealizaciones.

ii) Las teorías no son modelos semánticos que proporcionen una interpretación de un lenguaje y hagan verdaderos o falsos a sus enunciados.

iii) Los científicos (quienes representan) construyen teorías (lo que representa) para dar cuenta de ciertos aspectos de un dominio de investigación (lo representado). Los científicos modelan sus dominios de investigación a través de teorías.

iv) Una teoría representa el dominio de investigación correspondiente en algunos aspectos y con cierto grado de aproximación,16 no en forma completa e idéntica.

Obsérvese, una vez más, que en este caso de los mapas, de los modelos representacionales, no tiene sentido preguntarse si los modelos son semánticos o se ajustan a una descripción, pues precisamente la relación que se está privilegiando es la de representación, la cual excluye las otras dos. Aunque, desde luego, el modelo también podría ser semántico o ajustarse a una descripción, desde otro punto de vista.

Para finalizar, sólo insistir una vez más en que el objetivo ha sido mostrar los elementos más sobresalientes de la arquitectura del conocimiento científico y que para ello ha sido necesario desentenderse de muchos detalles presentes en esa arquitectura. Buena parte de la literatura filosófica aquí referida se ocupa de muchas de las cuestiones más particulares que pueden surgir a partir del presente artículo, en tanto que las otras están a la espera de ser investigadas de manera sistemática.

Bibliografía

1. ACKERMANN, R. (1989) ''The New Experimentalism'', en: Brit. J. Phil. Sci., 40, pp. 185-190. [ Links ]

2. BOGEN, J. Y WOODWARD, J. (1988) ''Saving the Phenomena'', en: Philosophical Review, 97, pp. 303-352. [ Links ]

3. BUNGE, M. (2001) Philosophy in Crisis: The Need for Reconstruction. New York: Prometheus Books. [ Links ]

4. CARNAP, R. (1939) Foundations of Logic and Mathematics. Chicago: University of Chicago Press. [ Links ]

5. CARNAP, R. (1963) ''Intellectual Autobiography'', en: Schilpp, P. A. (ed.). The Philosophy of Rudolf Carnap. La Salle, Illinois: Open Court, pp. 3-84. [ Links ]

6. FERREIRÓS, J. Y ORDÓÑEZ, J. (2002) ''Hacia una filosofía de la experimentación'', en: Crítica, Vol. 34, No. 102, diciembre, pp. 47–86. [ Links ]

7. FRANKLIN, A. (2007) ''The Role of Experiments in the Natural Sciences: Examples from Physics and Biology'', en: Kuipers, T. (ed.). Handbook of the Philosophy of Science. Amsterdam: Elsevier B.V., pp. 219-274. [ Links ]

8. FRENCH, S. (2008) ''The structure of theories'', en: Psillos, S. y Curd, M. (ed.). The Routledge Companion to Philosophy of Science. New York: Routledge, pp. 269-280. [ Links ]

9. GIERE, R. (1988) Explaining Science. The Cognitive Approach. Chicago: University of Chicago Press. [ Links ]

10. GIERE, R. (1999) ''Using Models to Represent Reality'', en: Magnani, L. et al. (ed.). Model-Based Reasoning in Scientific Discovery. New York: Dordrecht, Kluwer, pp. 41-57. [ Links ]

11. GUERRERO, G. (2010) ''La noción de modelo en el enfoque semántico de las teorías'', en: Praxis Filosófica, No. 31, Julio-Diciembre, pp. 169-185. [ Links ]

12. HACKING, I. (1983) Representing and Intervening. Cambridge: Cambridge University Press. [ Links ]

13. MADRID, C. M. (2007) ''De la equivalencia matemática entre la Mecánica Matricial y la Mecánica Ondulatoria'', en: La Gaceta, vol. 10, no. 1, pp. 103-128. [ Links ]

14. MAYO, D. G. (1994) ''The New Experimentalism, Topical Hypotheses, and Learning from Error'', en: Philosophy of Science Association, Volume 1, pp. 270-279. [ Links ]

15. SUÁREZ, M. (2003) ''Hacking Kuhn'', en: Revista de Filosofía, Vol. 28, Núm. 2, pp. 261-284. [ Links ]

16. THOMSON-JONES, M. (2006) ''Models and the Semantic View'', en: Philosophy of Science, 73, pp. 524-535. [ Links ]

17. VAN FRAASSEN, B. C. (1989) Laws and Symmetry. Oxford: Clarendon Press. [ Links ]

18. VON NEUMANN, J. (1932) Mathematical Foundations of Quantum Mechanics. Princeton: Princeton University Press, 1955. [ Links ]

19. WEBER, M. (2005) Philosophy of Experimental Biology. Cambridge: Cambridge University Press. [ Links ]

20. WOODWARD, J. (2000) ''Data, Phenomena, and Reliability'', en: Philosophy of Science, Vol. 67, Supplement, pp. S163-S179. [ Links ]

21. WOODWARD, J. (2009) ''Data and phenomena: a restatement and defense'', en: Synthese, Volume 182, Number 1, Published online: 07 July 2009. [ Links ]

Notas al pie

* El presente artículo hace parte del trabajo de investigación adelantado durante el año sabático que me concedió la Universidad del Valle durante el año 2011. Versiones anteriores de este trabajo las presenté como conferencia en el 3er Encuentro Nacional sobre la Enseñanza de la Mecánica, Universidad Pedagógica Nacional, Departamento de Física, 22 y 23 de mayo de 2009; y como ponencia en el XVII Foro Nacional de Filosofía, Departamento de Filosofía (50 Años), Universidad de Caldas, 15 al 18 de septiembre de 2009.

1 Como dice Weber: para los empiristas lógicos, ''tal distinción no tiene una relevancia sistemática para la epistemología'' (2005: 129).

2 Véase, von Neumann (1932) y Madrid (2007).

3 Enunciaciones semejantes en Hacking: ''el experimento puede tener una larga vida autónoma'' y ''la experimentación tiene muchas vidas propias'' (1983: 160 y 165).

4 La expresión es de Bogen y Woodward (1988: 306), the high-level general theories, y veremos a continuación qué se ha de entender por este tipo de teorías.

5 Woodward (2009) habla de la imagen de tres niveles de las teorías, en tanto que Suárez (2003) habla de tres nivel del conocimiento científico, de modo que yo recojo este último uso por parecerme más adecuado al referirse al conocimiento científico en general, en tanto que la referencia de Woodward a ''teorías'' es ambigua, pues al parecer refiere a teorías en general, incluyendo teorías de alto nivel y teorías de niveles bajos.

6 Hacking es quien enfatiza en que la novedad de la actividad experimental contemporánea radica en la creación de fenómenos, que son excepcionales, más que en su descubrimiento (véase el capítulo 13 de Hacking, 1983). Pero tal idea no la comparten Bogen y Woodward (1988: 306), por ejemplo.

7 En palabras de Woodward (2009): ''en muchos casos las discusiones normales sobre el papel de la observación en ciencia arroja poca claridad sobre cómo los fenómenos son detectados o sobre las consideraciones que hacen fiable a los razonamientos que van de los datos a los fenómenos... La fiabilidad de tales razonamientos tiene muy poco que ver con cómo trabaja la percepción humana''.

8 Criterio de identificación.

9 Criterio metodológico. Las expresiones criterio de identificación y criterio metodológico las recojo de Thomson-Jones (2006).

10 Véase French (2008).

11 De modo que aquí hay que darle la razón a Bunge cuando insiste en que ''la palabra modelo no significa lo mismo en lógica y matemáticas que en las ciencias fácticas y en las tecnológicas. En matemáticas... todo modelo lo es de una teoría abstracta (no interpretada)... En cambio, en las ciencias fácticas y las tecnológicas, un modelo teórico es una teoría de cosas concretas de una clase restringida, tal como la clase de los átomos de helio o la colección de los supermercados'' (Bunge, 2001: 209). Las ideas que siguen sobre la noción de modelo en el enfoque semántico las he desarrollado más ampliamente en Guerrero (2010).

12 Esta expresión la recojo de Thomson-Jones (2006).

13 Esta palabra no se emplea aquí en el sentido técnico de Tarski.

14 Véase Giere (1988) y Giere (1999).

15 Véase Giere (1988: 85).

16 Este aspecto vale la pena resaltarlo, con las palabras de Giere: ''para el físico, la verdad exacta y literal no es lo importante. Lo que importa es un grado suficiente de aproximación para el propósito que se persigue, cualquiera que este sea... La idealización y la aproximación forman parte de su esencia [de la ciencia empírica]. Una teoría adecuada de la ciencia debe reflejar este hecho en sus conceptos más fundamentales'' (Giere, 1988: 102).