Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO -

Similars in Google

Similars in Google

Share

Cuadernos de Economía

Print version ISSN 0121-4772On-line version ISSN 2248-4337

Cuad. Econ. vol.21 no.37 Bogotá July/Dec. 2002

CONVENCIONES EN JUEGOS PUROS DE COORDINACIÓN SIMÉTRICA 2 × 2

Jhon James Mora

Departamento de Economía, Universidad ICESI; correo: jjmora@icesi.edu.co. Agradezco los comentarios de Brian Skyrms, de California University, y de Yanis Varaufakis, de Sydney University. De igual forma, agradezco los valiosos comentarios de dos evaluadores anónimos. Como es usual, los errores que persisten son de mi absoluta responsabilidad. Artículo recibido el 20 de febrero de 2001 y aprobado por el Consejo Editorial el 27 de septiembre de 2002.

Resumen

Este ensayo analiza la formación de convenciones en juegos de coordinación simétrica 2 × 2. En particular, el análisis se restringe a juegos con iguales niveles de seguridad y se discute que tanto puede explicar la teoría de juegos la formación de convenciones.

Palabras clave: coordinación, convenciones, juegos evolutivos. JEL: C70, C72, D41

Abstract

This essay analyzes the formation of conventions in symmetrically coordinated 2 × 2 games. The analysis is specifically restricted to games in which all players are exposed to the same level of risk. We discuss to what extent theory can explain the establishment of conventions.

Key words: coordination, conventions, evolutionary games. JEL: C70, C72, D41

INTRODUCCIÓN

Una convención es una regularidad del comportamiento de los miembros de una comunidad en una situación recurrente que es una costumbre esperada y mutuamente consistente [Lewis 1969]. Entre los ejemplos de convenciones más citados se encuentra el de dos conductores que conducen en sentidos contrarios: con el fin de pasar al otro lado, deberán elegir entre conducir a la izquierda o a la derecha. Sin embargo, aunque la probabilidad de usar cualquier lado es igual, los conductores eligen conducir por la derecha. Otro ejemplo: dos individuos que pertenecen a una misma población deciden encontrarse en el centro de alguna ciudad en algún país. Aunque cualquier lugar tiene la misma probabilidad para dicho encuentro, independientemente de donde vivan y sin ninguno comunicarle al otro dónde será el sitio de encuentro, ellos terminan encontrándose en el determinado lugar.1

Observando estos hechos, surgen las siguientes preguntas: ¿Cómo logra una serie de individuos (jugadores) coordinarse en exactamente una estrategia? ¿Qué tan estable es esta coordinación? ¿Es esta coordinación más deseable que otra? Estas preguntas son lógicas, ya que la convención muestra a jugadores que se han coordinado sobre una estrategia, pudiéndose coordinar sobre la otra. Además, no es claro por qué prefieren una estrategia en particular, ni cómo, una vez alcanzada la coordinación, esta situación es de equilibrio. ¿Qué hace, entonces, que una población de jugadores prefiera un equilibrio en particular cuando son posibles, por ejemplo, dos equilibrios?

Para Schelling [1960], los jugadores preferirán un equilibrio cuando éste sea más conspicuo que los otros, en lo que se conoce también como "puntos focales". Mientras que para Harsanyi y Selten [1988], los jugadores pueden preferir un equilibrio si éste domina débilmente en riesgo al otro. Siguiendo estos resultados, Foster y Young [1991] y Young [1993], con dinámicas estocásticamente estables, en juegos con diferentes niveles de seguridad, muestran cómo la coordinación en un equilibrio se obtiene cuando hay dominio en riesgo, en el sentido de Harsanyi y Selten [1988]. Así, una convención es estocásticamente estable si domina en riesgo a otra convención.

Sin embargo, la coordinación de las expectativas y la formación de convenciones requieren que los jugadores estén de acuerdo en torno a usar algún principio para seleccionar un equilibrio. Como señalan Rankin, Van Huyck y Battalio [1998], la convención requiere que los integrantes de una comunidad coloquen su atención en algún concepto deductivo derivado en parte de situaciones similares en juegos pasados y que usen dicho concepto para solucionar el problema de coordinación.2 En juegos estáticos puros de coordinación simétrica 2 × 2,3 no existe nada en la estructura del juego que les diga a jugadores estrictamente racionales, poseedores de información común de lo que es una convención, cómo coordinarse en torno a la convención. En un ambiente evolutivo, la habilidad de los jugadores para recibir, decodificar y actuar sobre la información que obtienen en el curso del juego será limitada y, por lo tanto, también será limitada su capacidad de coordinarse entorno de algún principio para seleccionar un equilibrio, lo cual significa:

1. que los jugadores reaccionarán imitando a antiguos jugadores,

2. o que no todos los jugadores reaccionarán instantáneamente,

3. o que, cuando jueguen, cometerán errores y tendrán una capacidad limitada para procesar la información.

Cualquier jugador en un ambiente evolutivo observará que una estrategia, en este tipo de juego, es un "concepto" complicado, que especifica las acciones que deberá realizar cuando ocurra una serie de hechos no esperados y observables.

Sin embargo, las observaciones no son perfectas; su conocimiento de cómo los pagos dependen de sus elecciones puede ser tenue, pues podría inferir imperfectamente el tamaño de la población.

Los resultados aquí encontrados muestran, en primer lugar, que, en un juego puro de coordinación simétrica 2 × 2, no existe una explicación de cómo deben coordinarse los jugadores sobre exactamente una estrategia; esto es valido tanto en un ambiente estático como en un ambiente dinámico. Por lo tanto, la formación de convenciones, en este tipo de juegos, es un problema abierto. En segundo lugar, que, a diferencia de la teoría clásica de juegos, la teoría de juegos evolutivos brinda un espacio para pensar la formación de la convención como el resultado de la interacción evolutiva entre los integrantes de una población. Y, en tercer lugar, que, si bien es cierto que la teoría de juegos evolutivos no es clara sobre las reglas que deben usar los jugadores para coordinarse, a partir de ésta si se pueden deducir las condiciones mínimas para que una estrategia se convierta en una convención que podría ser usada por todos los jugadores de una población.

Este artículo se encuentra dividido de la siguiente forma: en la segunda parte se define qué es un juego de coordinación, en la tercera se discute la formación de convenciones en un ambiente evolutivo, considerando, en primer lugar, dos tipos de miopía: determinística y estocástica. La miopía determinística mostrará jugadores que observan el tamaño de la población y hacen elecciones dependiendo de lo que la población elige e imitando a jugadores que ya han jugado el juego. La miopía estocástica nos dirá que los jugadores observan imperfectamente el tamaño de la población, de tal forma que observan, con una determinada probabilidad, cómo la población elige una estrategia. En segundo lugar, se supondrá que la capacidad del jugador para procesar la información de juegos anteriores es limitada, por lo cual los jugadores deberán extraer una serie de m juegos, de todos los juegos posibles, con el fin de buscar la coordinación sobre estos juegos. En la cuarta sección se presentan las conclusiones.

JUEGOS DE COORDINACIÓN

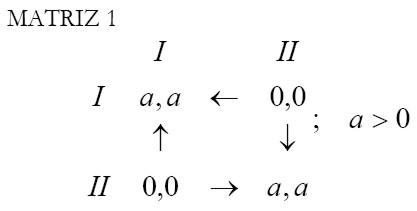

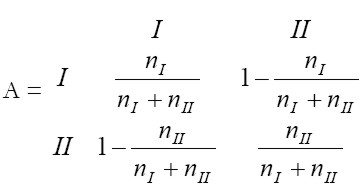

Suponga que los jugadores {h,r} juegan el siguiente juego simétrico de coordinación:

|

La teoría estándar de juegos muestra, en la Matriz 1, que hay tres equilibrios de Nash: ambos jugadores eligen la estrategia I, ambos jugadores eligen la estrategia II, o se elige una estrategia mixta con probabilidad de ½. Esto implica que no existe una regla que les diga a los jugadores sobre qué estrategia coordinarse, pues claramente los jugadores se coordinan en la estrategia I o la II, y no hay diferencia entre una u otra coordinación.

Harsanyi y Selten [1988] desarrollan el concepto de dominio en riesgo, el cual también es débil en proveer una regla de coordinación, pues la estrategia I es la mejor respuesta a la estrategia II, con una probabilidad de ½, y la probabilidad de que la estrategia II sea la mejor respuesta a la estrategia I también es de ½. Por lo tanto, la estrategia I no domina estrictamente en riesgo a la estrategia II, debido a que a no puede ser mayor que a.

Como se puede observar, no existe nada en la estructura del juego que les diga a los jugadores, aun siendo estrictamente racionales, sobre qué estrategia coordinarse. Suponga que el juego es jugado por agentes tipo {h,r}, cuyas elecciones en el tiempo se ven influenciadas por las elecciones de toda una población que es homogénea en términos de su función de utilidad, pero que se divide en dos grupos, cada uno de los cuales prefiere coordinarse en torno a una estrategia en particular: I o II. ¿Es posible la coordinación evolutiva de todos los jugadores en torno a una estrategia? Esto es lo que discutiremos a continuación.

LA FORMACIÓN DE CONVENCIONES

En tanto la convención es:4

- el resultado de la interacción entre los jugadores que hacen parte de una población homogénea,

- la coordinación evolutiva sobre una estrategia en particular,

Una convención puede surgir en el juego de coordinación simétrico G = [N, s, u(s)i ], donde N es la población de jugadores homogéneos, si es la estrategia i del jugador y u(s)i es la función de utilidad cuando el jugador usa la estrategia i. Los jugadores {h,r} ∈ N son extraídos de una población homogénea para jugar el juego cuyos pagos se representan en la Matriz 1.

El modelo de dinámica de réplica5

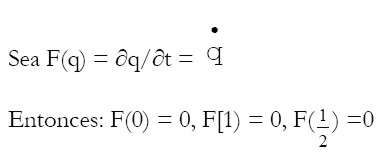

Considere un conjunto de jugadores que tienen disponible un número finito de estrategias que consisten en su elección.6, 7 Sea q la fracción de agentes que elige la estrategia I y 1 - q la fracción que elige la estrategia II. El estado espacio del juego es un símplex tal que Q = {(q , 1 - q) ∈ R² : 0 ≤ q ≤ 1}. La interacción está determinada por los pagos dados en la Matriz 1, los cuales, en un juego evolutivo, estarán en función de su propia estrategia y del estado corriente de la población de agentes. Los pagos se asumen lineales en su propia estrategia y continuamente diferenciables en el estado de la población [q ∈ Q]. El elemento final de la estructura dinámica se especifica a partir de un estado q que evoluciona en tiempo continuo, cuya derivada en el tiempo,  = δq / δt, se representa por una función F : q → R² tal que

= δq / δt, se representa por una función F : q → R² tal que  = F(q). Éste es un sistema autónomo de ecuaciones diferenciales ordinarias donde la curva de solución q (t), dadas las condiciones iniciales q(0) ∈ Q, describe la evolución de la población comenzando en algún estado de interés.

= F(q). Éste es un sistema autónomo de ecuaciones diferenciales ordinarias donde la curva de solución q (t), dadas las condiciones iniciales q(0) ∈ Q, describe la evolución de la población comenzando en algún estado de interés.

Estabilidad: Sea q (t) el estado en el tiempo t, un sistema dinámico admisible (δq / δt) = F(q) genera una curva de solución única q(t) dada una condición inicial q(0) ∈ Q. Un estado q es un punto fijo de F(•) si todos los componentes de F(q) son cero. El estado q es un punto fijo en el sentido de que si q(0) es un punto fijo de F(•), entonces F(q(0)) = 0 y q(t) = q(0) ∀ t > 0. Un estado q* es un punto fijo estable de F(•) si F(q*) = 0 y éste tiene un conjunto abierto D  Q tal que q(t) → q* cuando t → ∞ y q(0) ∈ D. La unión de todas las curvas de solución que llevan hacia q* cuando t → ∞ se denomina la base de atracción de q* y se denota como B(q*). Finalmente, una estrategia es evolutivamente estable, (EEE), siempre que q* ∈ B(q*). El anterior sistema dinámico explica la formación de una convención si dado el estado inicial q(0), en el cual la curva de solución q(t) ∈ B(q*), la dinámica lleva a que los agentes adopten una estrategia.8

Q tal que q(t) → q* cuando t → ∞ y q(0) ∈ D. La unión de todas las curvas de solución que llevan hacia q* cuando t → ∞ se denomina la base de atracción de q* y se denota como B(q*). Finalmente, una estrategia es evolutivamente estable, (EEE), siempre que q* ∈ B(q*). El anterior sistema dinámico explica la formación de una convención si dado el estado inicial q(0), en el cual la curva de solución q(t) ∈ B(q*), la dinámica lleva a que los agentes adopten una estrategia.8

Bajo este tipo de dinámica, la experiencia se hereda de generaciones anteriores y los nuevos jugadores reciben información de antiguos jugadores. Así, los jugadores en el juego aprenden usando dinámicas de réplica, lo que significa que imitan el comportamiento de otros jugadores, debido a que la convención disminuye los costos de coordinación [Mora 2001].

Proposición 1: Si se forma una convención ésta será evolutivamente estable y robusta.

Demostración: ver Apéndice.

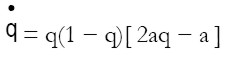

La anterior proposición establece sólo que cualquiera de las dos estrategias podría ser una convención. De esta forma, la demostración indica que las estrategias I,I y II,II son evolutivamente estables y robustas. Revisando, en cada momento del tiempo, la proporción de jugadores que está eligiendo una estrategia, los jugadores se darán cuenta de cuál estrategia será un comportamiento esperado. De esta forma, en el tiempo, la población usará dinámicas de réplica. Se puede establecer que la ecuación de dinámica de réplica correspondiente será:

| [1] |

|

Si un nuevo jugador observa el diagrama de fases (Gráfica 1), se dará cuenta de que la mitad de la población ha elegido la estrategia II y la otra mitad la estrategia I. ¿Qué estrategia elegirá? No existe ninguna razón para que el nuevo jugador elija una estrategia en particular, pues puede asignarles a ambas una probabilidad de ½.

El juego de coordinación simétrica pura de 2 × 2 con dinámicas de réplica muestra que cualquiera de las dos estrategias será una convención si más de la mitad de la población usa una de las dos estrategias en el estado inicial. Sin embargo, si las dos estrategias son usadas en igual proporción por la población, la convención, vista como la coordinación evolutiva sobre una estrategia en particular, no ocurre.9

El modelo estocástico de mejor respuesta con inercia 10

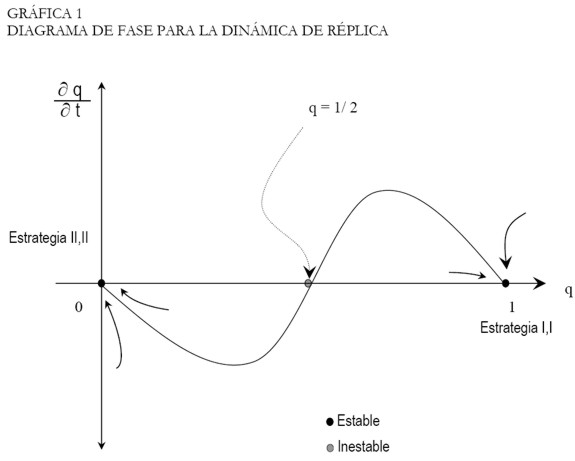

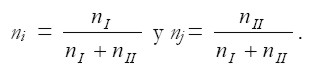

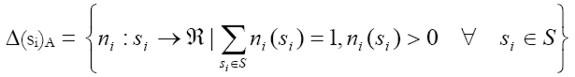

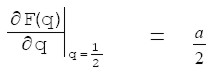

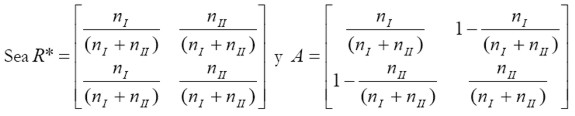

Sea nI el número de jugadores que usa la estrategia I y nII el número de jugadores que usa la estrategia II. Los jugadores se mueven de la estrategia i a la estrategia j con una probabilidad

|

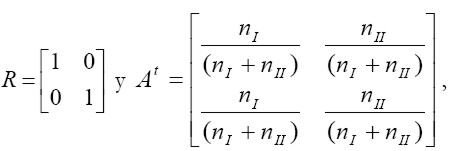

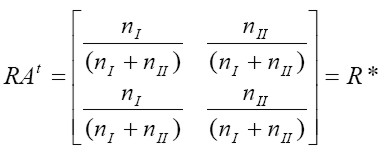

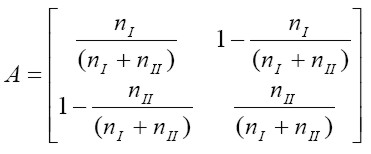

La elección de cada estrategia pertenece a un conjunto finito de resultados donde el estado espacio del sistema es S: {si × sj } siendo i,j las estrategias. De esta forma, el jugador se encuentra usando la estrategia si en el t-ésimo período. En cada par de estrategias {si × sj } se establece la probabilidad nij de que sj sea elegida después de que haya sido elegida si. En cada período, después de que los jugadores hayan jugado el juego, ellos podrían cambiar sus estrategias a la luz de la experiencia. El proceso por el cual los jugadores cambian sus estrategias se denominará mecanismo de selección. De esta forma, un mecanismo de selección se define a partir de la matriz de transición sobre el estado espacio S que identifica, para cada estado que el sistema podría ocupar en el tiempo t, la probabilidad de que el sistema se mueva entre los estados en S en el período t+1. Esto configura un proceso estocástico que se denomina cadena de Markov finita, donde nij serán las probabilidades de transición. A continuación denominaremos A a la matriz de transición, que se definirá como:

|

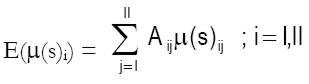

La distribución de probabilidad sobre S, Δ(si)A será:

| [2] |

En el t-ésimo estado de la cadena markoviana, el jugador {h,r} obtiene u(s)ij cuando realiza una transición desde la estrategia i a la estrategia j. Este movimiento define la utilidad esperada de la transición para el estado i, como:

| [3] |

donde la utilidad esperada en el tiempo puede definirse como:

| [4] |

El proceso markoviano cumple las siguientes propiedades (ver el Apéndice.):

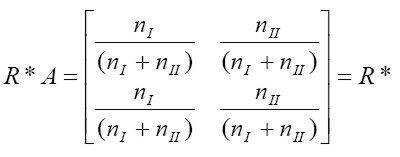

1. El proceso markoviano definido por Δ(si)A tiene una única distribución estacionaria R*, tal que R*A = R*.

2. R* es estable. Para alguna distribución inicial R, RAt → R* cuando t → ∞.

3. R* es ergódico.11 Independientemente de la condición inicial, la distribución de la población viene dada asintóticamente por R*.

4. Si R* existe, entonces existe una única distribución estacionaria que satisface E(µ(s), R) → E(µ(s), R*) ↔ R → R* cuando t → ∞.

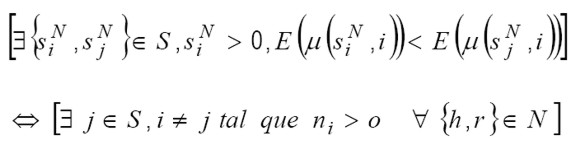

Equilibrio de Nash: suponga que el sistema viene dado por S y considere un jugador {h,r}, quien juega la estrategia si en el estado de la población N, lo que se denotará como SN i. Sea E(µ( SN i, i)) la utilidad esperada de jugar la estrategia SN i en el estado i. Un esquema de aprendizaje es compatible con el equilibrio de Nash [Samuelson 1994] si:

| [5] |

La condición anterior implica que existe una probabilidad positiva de que el jugador cambie de estrategia, en el estado del sistema, si y solo si, para alguna estrategia, SN i, el jugador obtiene una utilidad esperada menor que en la estrategia j. Es decir, se asume que el jugador cambia de estrategia, a través del mecanismo de aprendizaje, si y solo si, la estrategia que ha sido elegida por la población tiene una menor utilidad esperada.

Sea Brh(R) el conjunto de estrategias puras, para los individuos de tipo {h,r} ∈ N, que son las mejores respuestas a S. El jugador cambia de estrategia a una mejor respuesta en el período, dependiendo de las acciones de la población de jugadores. Esto conformará un sistema dinámico de mejor respuesta con inercia, lo que significa que usualmente los jugadores repiten estrategias que han realizado en el pasado y ocasionalmente cambiarán de estrategias. En situaciones con una población grande calcular acciones óptimas es costoso, consume demasiado tiempo y se puede inferir mal el tamaño de la población, razón por la cual, simplemente repetir acciones pasadas podría ser la mejor forma de jugar este juego.

Definición 1: Un perfil de estrategia R* ∈ × Δ (Si) es un equilibrio de Nash si R* es la mejor respuesta de R* a si mismo.

Definición 2: Si la estrategia R* es la mejor respuesta extraída de un estado absorbente, entonces R* es una convención. Si Δ(Si)A tiene una solución asintóticamente estable, R* es la mejor respuesta a cualquier equilibrio, y si R* es un estado absorbente, entonces R* será la estrategia que toda la población usará.

En juegos puros de coordinación, como el anterior, el comportamiento de largo plazo, al introducir ruido, muestra que el sistema gasta la mitad del tiempo en un equilibrio de Nash y la otra mitad en el otro equilibrio [Canning 1992; Kandori et al. 1993].

Este resultado es lógico; usando las propiedades 1 a 4 y las definiciones [1] y [2] se obtiene:

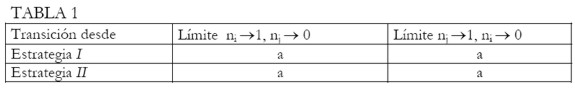

|

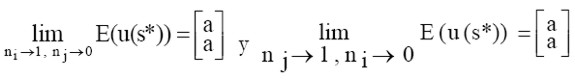

La primera columna de la Tabla 1, muestra la transición de la estrategia I a la estrategia II. En la segunda columna se muestra la utilidad esperada, en la distribución estacionaria R*, cuando la estrategia I es un estado absorbente. Y en la tercera columna se denota la utilidad esperada, en la distribución estacionaria R*, cuando la estrategia II es un estado absorbente. La Tabla 1 se debe entender de la siguiente forma: si el proceso comienza en la estrategia I o II y, la estrategia I es una convención, los jugadores obtienen una utilidad esperada de a por transición. Si el proceso comienza en la estrategia I o II y la convención es la estrategia II, entonces el jugador obtiene una utilidad esperada de a por transición. De esta forma, la utilidad esperada en la distribución estacionaría R*, cuando los jugadores se coordinan en torno a cualquier convención, es la misma y, por lo tanto, no existe una regla que asigne la estrategia que deberán elegir los agentes.

Si el sistema oscila entre los dos equilibrios que son Pareto eficientes, ¿qué hace que los jugadores se coordinen en torno a uno? Para Kandori et al. [1993] y Foster y Young [1991], es la historia del juego la que lleva a elegir uno en particular con probabilidad de 1. Al fin y al cabo, como mencionan Foster y Young [1991], "los jugadores coordinan la mayor parte del tiempo sobre exactamente uno de los equilibrios". En los juegos de mejor respuesta con inercia, la historia se asume como toda la secuencia de juegos hasta el período t. El papel de la historia en el juego consiste en proveer a los jugadores de las mejores respuestas que han jugado, de tal forma que aprendan y nunca se equivoquen. Sin embargo, no podrán coordinarse sobre un equilibrio en particular, pues las historias de los juegos vienen distribuidas de igual forma en ambas estrategias. A continuación exploraremos qué sucede cuando los jugadores se equivocan en la secuencia.

El modelo estocástico perturbado12

Suponga que en el período t un individuo es extraído aleatoriamente y asignado a desempeñar un papel en el juego. El juego se juega una vez en cada período. El jugador i = {h,r} elige su estrategia pura si(t) del espacio de estrategias. La estrategia s(t) = [sh(t), sr(t)] se referirá al juego en el tiempo t. La historia del juego en el tiempo t es la secuencia g(t) = [s[1), s(2),...,s(t)]. Las historias son anónimas: no importa quien haya jugado una estrategia en un período dado; sólo importa que el juego haya sido jugado por alguien.

Los jugadores deciden cómo elegir sus estrategias de la forma siguiente: fijen dos enteros k y m, tales que 1 ≤ k ≤ m. En el período t + 1 (t ≥ m) cada jugador inspecciona k juegos extraídos sin reemplazo de los más recientes m periodos t, t-1, t-2,...,t-m+1. El jugador se detiene cuando ha aprendido acerca de k diferentes juegos en los últimos m períodos, debido a que ha alcanzado la máxima capacidad de procesar información. La fracción k/m mide cuándo se alcanza esta capacidad de procesar información por parte del agente.

Los primeros juegos son jugados aleatoriamente y se tomará una muestra que comienza en el período t = m + 1 de alguna secuencia arbitraria de m juegos, g(m) = [s(1), s(2),..., s(m)]. De esta forma se obtiene una cadena de Markov finita sobre el estado espacio G, consistente en todas las secuencias de longitud m extraídas de S, comenzando en algún estado inicial arbitrario g(m).

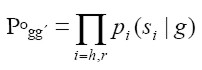

Sea g´ ∈ G un sucesor de un estado g ∈ G. El proceso se mueve del estado corriente g al estado sucesor g´ en cada período de acuerdo con la siguiente regla de transición: para cada s ∈ Si sea pi(s|g) la probabilidad de que el agente i elija s. Sea pi(•) la distribución de mejor respuesta en el sentido de que pi(s|g) > 0 si y solo si existe una muestra de tamaño k para la cual s es la mejor respuesta para el jugador i y pi(s|g) es independiente de t. Si s es el elemento a la derecha de g, la probabilidad de moverse de g a g´ es:

| [6] |

Si Po gg´ = 0, entonces g´ no es un sucesor de g. Po define una dinámica evolutiva con una historia inicial de m juegos, parámetros de información k y una distribución de mejor respuesta. Lo cual puede también entenderse como un juego adaptativo con memoria m.

Proposición 2: Sean {h,r} jugadores extraídos de N [h∈ Nh , r ∈ Nr ,Nh = Nr y Nh + Nr = N]. Sea k un entero tal que minh ∈ Nh kh y minr ∈ Nr kr. Si k≤ m/2 entonces el juego adaptativo tiene dos estados absorbentes del proceso Po: uno para cada equilibrio de coordinación (I,I) y (II,II).

Demostración: ver Young [1993; 1995; 1998].

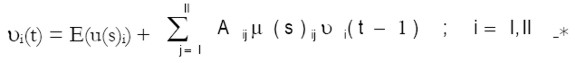

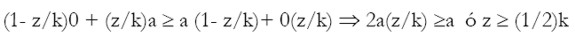

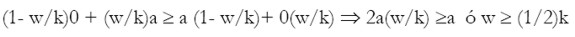

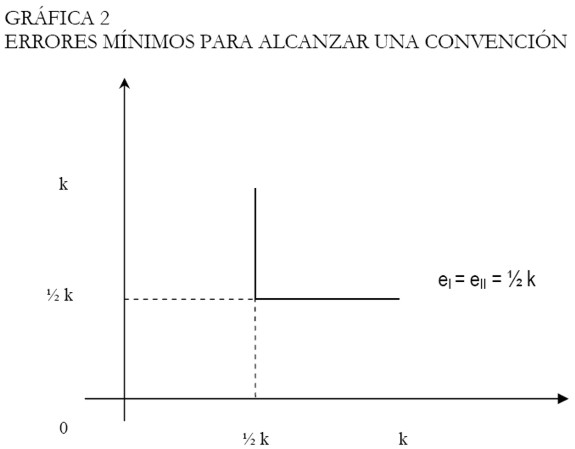

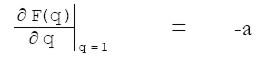

Sean g1 el estado absorbente en el cual (I,I) se repite m veces en la sucesión y g>2 el estado absorbente en el cual (II,II) se repite m veces en la sucesión. Para determinar si uno de los dos estados es una convención, se deberán computar eI, el menor número de errores para el proceso perturbado que se mueve de gI a gII y eII, el menor número de errores para el proceso perturbado que se mueve de gII a gI. La convención gI es estable en el sentido de Young [1995] si eI > eII, la convención gII es estable si eI < eII y, los estados gI y gII son estables si eI = eII . Para ir de gI a gII se requiere que al menos un jugador haya elegido la estrategia II por error. Sin embargo, el jugador habrá elegido la estrategia II si ésta es óptima en una muestra de tamaño k, de la siguiente forma:

- El jugador h, con el mínimo de información muestral k, que incluye z errores(estrategia II) y k-z elecciones previas (estrategia I), se cambiará a la estrategia II si y solo si el pago esperado es mayor:

| [7] |

- El jugador r elige la estrategia II por error w veces en una sucesión. Este jugador con el mínimo de información muestral K, que incluye w errores (estrategia II) y k – w elecciones previas (estrategia I), cambiará a la estrategia II si y solo si el pago esperado es mayor:

| [8] |

De lo anterior se deduce que eI = min{1/2k,1/2k} = 1/2k = eII = min{1/2k,1/2k} = 1/2k. Por lo tanto, gI y gII son estados estables:

|

De la Gráfica 2, se deduce que no existe una única convención para un valor entero positivo k, pues ambas estrategias son estados estables para valores de k y m cuando k es una muestra de tamaño común para ambos jugadores y k ≤ m/2. Dos resultados merecen nuestra atención:

1. Si los jugadores se equivocan exactamente k/2 no existe una convención.

2. Los jugadores retienen información hasta k/m 1/2 períodos.

Esto significa que los jugadores pueden procesar información hasta la mitad de los juegos jugados y que si se extrae una muestra de estos juegos y los jugadores han cometido errores en la mitad de los juegos en los cuales pueden "retener en su memoria", entonces no existe ninguna forma de coordinarse en torno a una estrategia y formar una convención.

CONCLUSIÓN

Samuelson [1997] considera que, en juegos de coordinación pura, lo mejor que se puede decir es que uno de los resultados podría aparecer y que la descripción de la coordinación en una estrategia, necesariamente, incluiría precedentes históricos y accidentes que estarían por fuera de la descripción del juego comúnmente usada para modelar el problema.13

Es claro, entonces, que sólo una explicación evolutiva del juego, que incluya la historia, podría ofrecer una visión razonable de la formación de convenciones. Sin embargo, hay que ser consciente de que existen muchos eventos que no se pueden modelar, aunque podrían explicar cómo se forma una convención en particular.

Aun así, la explicación evolutiva es invaluable, pues ayuda a pensar las condiciones mínimas que se requieren para formar una convención. La solución al problema de un único equilibrio no es simple, pues es claro que sólo en juegos muy específicos y bajo circunstancias explicadas por él mismo, es posible mostrar una convención.

¿Qué es lo nuevo, entonces, que aporta la teoría de juegos evolutivos? Que la estrategia mixta, como resultado, no puede explicar como se forma una convención. Si la teoría de juegos evolutivos desea explicar la convención, debe ser capaz de eliminar la estrategia mixta como uno de los posibles equilibrios entre los jugadores, como aquí se ha mostrado. Sólo que la teoría de juegos evolutivos no nos puede decir, en el caso de los juegos puros de coordinación simétrica 2 × 2, sobre cuál estrategia deben coordinarse los jugadores, pues a los jugadores les son indiferentes las dos estrategias antes de que la convención surja.

En juegos evolutivos con dinámica de réplica, ambas estrategias pueden ser una convención en el caso de que más de la mitad de la población elija dicha estrategia en el estado inicial. Sin embargo, si la población viene distribuida simétricamente alrededor de las dos estrategias es imposible que se forme una convención. Entonces la única vía para que se conforme una convención consistirá en que se rompa la simetría por alguna razón. ¿Qué motivos explican el rompimiento de la simetría? Cualquier explicación de las exploradas por Samuelson [1997] funcionaría, sólo que la evolución del juego no nos dice por qué la simetría se rompe.

En juegos estocásticos de mejor respuesta con inercia se requiere de un "super-jugador" que le asigne una mayor probabilidad a una de las dos estrategias que está eligiendo la población cuando él juega su mejor respuesta con inercia. La forma por medio de la cual asigna una mayor probabilidad a la estrategia no es clara, pues ambas estrategias dan iguales ganancias esperadas por transición, razón por la cual el juego no provee los criterios con los cuales nuestro jugador determinará cuál estrategia será una convención.

Finalmente, el "super-jugador" deberá equivocarse en un período adicional a aquel en que los otros jugadores se equivocan para que la convención se forme. Esta equivocación adicional no proviene del juego o de la forma como juegan los jugadores, pues un jugador aleatorio se equivocaría exactamente en la mitad de sus estrategias, en m juegos previos, y exactamente se equivocaría en la otra mitad en la otra estrategia.

Así las cosas, la explicación de cómo se forma una convención, en juegos puros de coordinación simétrica 2 × 2, sigue siendo un problema abierto.

NOTAS AL PIE

1 Otro ejemplo, igual de fascinante, es la convención formada alrededor de la venta de automóviles usados en Argentina. Cuando alguien desea vender un automóvil, coloca encima un tarro; el tarro no posee ninguna marca o señal que indique la venta del mismo: el solo hecho de colocar el tarro es una señal de la venta de éste.

2 Lo cual significa que los jugadores deberán tener esquemas conceptuales iguales en torno a lo que es una convención y usar un lenguaje común, en el sentido de Sugden [1995].

3 Defino un juego de coordinación "puro" como un juego en el cual los niveles de seguridad son iguales para todos los jugadores. Es decir, un juego donde los pagos para el jugador i son iguales a los pagos para el jugador j.

4 Ver también Hargreaves-Heap y Varaufakis [1995] para un modelo alternativo de la convención a partir de juegos extensivos.

5 El modelo de dinámica de réplica fue planteado originalmente por Taylor [1979] y Maynard Smith [1982]. Para Borges y Sarin [1993], existe un "reforzamiento positivo" de las acciones cuando los jugadores usan dinámica de réplica. Björnerstedt y Weibull [1996], Friedman [1991], Cressman [1992] y Samuelson [1994] muestran las diferentes propiedades de este tipo de modelos. Para una aplicación desde la teoría del caos, ver Skyrms [1992].

6 La versión de la dinámica de réplica más aplicable aquí sigue el trabajo de Fudenberg y Levine [1998] al usar el concepto de aprendizaje social, el cual consiste en suponer que, en cada período, algún fragmento de los agentes deja el sistema. Los agentes que dejan el sistema son reemplazados por nuevos agentes, quienes aprenden algo sobre el estado prevaleciente. Cada nuevo agente observa la estrategia y los pagos del agente que ha sido reemplazado y de otro, extraído al azar de la misma población. Los nuevos agentes adoptan la estrategia con el pago observado más alto o, en el caso de que esté relacionado con el agente que ha dejado el sistema, "heredará" la estrategia del agente que ha reemplazado. Sin embargo, si el agente con que se enfrenta está usando la misma estrategia que "heredo", el agente no cambia, aun cuando esa estrategia dé un menor pago.

7 Como anota uno de los evaluadores anónimos, en la versión tradicional de la dinámica de réplica, cada jugador tiene un comportamiento predeterminado, y no hay necesidad de explicar cómo el jugador debería jugar. Sin embargo, siguiendo a Fudenberg y Levine [1998], en la versión del aprendizaje social de la dinámica de réplica la explicación es importante para mostrar la convención como un resultado del aprendizaje social.

8 Para una revisión de estas propiedades, ver De La Fuente [2000].

9 Suponga que un agente de cada población sale del juego y es reemplazado por otro agente que hereda la estrategia del agente reemplazado. Entonces el agente tipo I hereda la estrategia tipo I y el agente tipo II hereda la estrategia tipo II ¿Existe alguna razón por la cual el agente tipo I deba adoptar la estrategia tipo II? No, ya que la población se distribuirá simétricamente entre las estrategias I y II, y la convención no se conformará.

10 Los modelos de mejor respuesta con inercia fueron planteados originalmente por Samuelson [1994] y Kandori, Mailath y Rob [1993].

11 Foster y Young [1991] definen la propiedad de ergodicidad como el hecho de que exista una probabilidad positiva de moverse de un estado a otro en m períodos o menos.

12 Propuesto por Foster y Young [1991] y Young [1993; 1995].

13 Samuelson [1997] también sostiene que usar el concepto de equilibrios de Nash en juegos puros de coordinación simétrica es muy fuerte y que más bien debería usarse el concepto de "estrategias racionalizables", el cual nos diría que todas las estrategias del juego de la Matriz 1 son racionalizables. Yo estoy de acuerdo en usar este concepto en juegos de coordinación estáticos, pero si la convención es un problema evolutivo que involucra a una población, el concepto de estrategia racionalizable no aporta mucho a la explicación de la formación de convenciones, a diferencia de los juegos evolutivos, que pueden eliminar la estrategia mixta como una estrategia para alcanzar una convención.

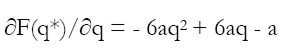

Demostración de la Proposición 1

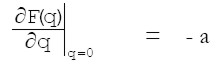

En la vía a demostrar esta proposición consideraremos que una convención puede verse como una estrategia evolutivamente estable (EEE) en un juego que tiene dos o más estrategias evolutivamente estables. La idea consiste en que una convención es una regla de comportamiento. De esta forma, en cumplimiento de la propiedad de estabilidad dinámica, deberemos demostrar que las raíces en (0) y (1) correspondientes a la elección de las estrategias I y II son evolutivamente estables (EEE) y que la raíz q = 1 / 2 es inestable:

| [9] |

| [10] |

| [11] |

| [12] |

| [13] |

Las raíces en (0) y (1) que corresponden a las convenciones II y I respectivamente, son estables, ya que F(q*) = 0 y δF(q *)/δq < 0 lo cual cumple con la propiedad de estabilidad. La raíz q = 1 / 2 es inestable, ya que si a > 0, entonces  ; por lo tanto, es inestable.

; por lo tanto, es inestable.

Dado que las raíces (0) y (1) son estables si la población se coordina en torno a alguna de las dos estrategias ésta será una convención. De esta forma, una de éstas raíces se convertirá en una convención en tanto la dinámica lleva a uno de los dos estados y, por lo tanto, será una regularidad del comportamiento de los integrantes de una comunidad en una situación recurrente

Robustez de la convención

Suponga que existe una función continuamente diferenciable y definida positiva V(q): D  Rn → R, siendo D un conjunto abierto que contiene al origen y sea δV / δq negativa semidefinida para algún q ∈ D. Entonces, existe una solución al sistema δq / δt = F(q) que es asintóticamente estable. En particular sea V(q) = ½ q 2 entonces δ V(q) / δt = (δV / δq)(δq / δt) = qF(q). Dado que F´(q*) < 0 [de la demostración anterior] y F(q*) = 0 de esto se sigue que F es decreciente en todo q* ∈ B(q*). Por lo tanto, una solución q* del sistema δq / δt = F(q) que sea asintóticamente estable conducirá a una convención robusta (

Rn → R, siendo D un conjunto abierto que contiene al origen y sea δV / δq negativa semidefinida para algún q ∈ D. Entonces, existe una solución al sistema δq / δt = F(q) que es asintóticamente estable. En particular sea V(q) = ½ q 2 entonces δ V(q) / δt = (δV / δq)(δq / δt) = qF(q). Dado que F´(q*) < 0 [de la demostración anterior] y F(q*) = 0 de esto se sigue que F es decreciente en todo q* ∈ B(q*). Por lo tanto, una solución q* del sistema δq / δt = F(q) que sea asintóticamente estable conducirá a una convención robusta (

Propiedades del proceso markoviano

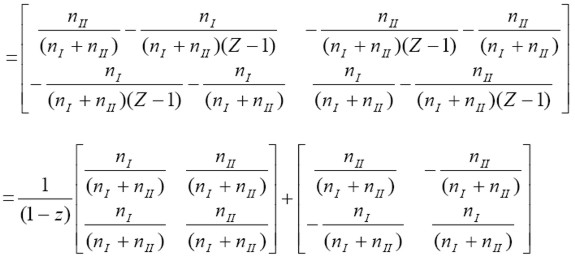

|

Entonces se obtiene:

|

Suponga una distribución inicial:

|

Siendo At = A × A × .... × A, t veces, entonces:

|

Cálculo de la utilidad esperada

Si

|

entonces (I – ZA)-1

|

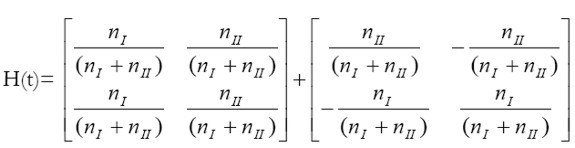

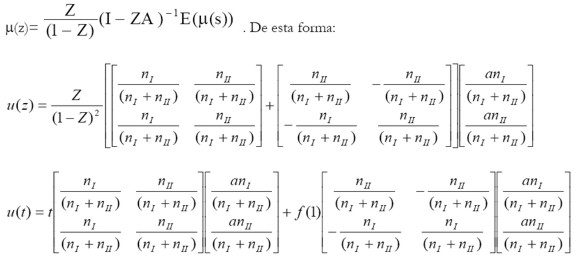

De la transformada de Z se conoce que 1 / 1 - Z, la función en el tiempo, es de un paso unitario, por lo cual:

|

lo cual se puede escribir también como:

H(t) = R*+ ξ

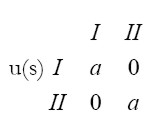

Donde R* es la matriz de distribuciones estacionarias y ξ es una matriz de perturbaciones aleatorias. A continuación, sea u(s) la matriz simétrica de pagos:

|

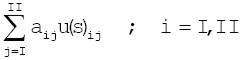

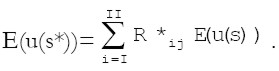

Defínase E(u(s)), la matriz de pagos esperados como E(u(s))=

donde aij es el elemento ij de la matriz A. De esta forma, E(u(s)) será igual a: E(u(s))=

Por otro lado, defínase

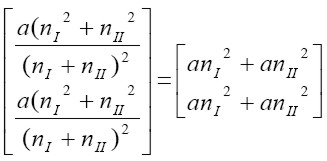

Entonces: E(u(s*))=

Observe que

Para encontrar la función de utilidad esperada en el tiempo, defínase

REFERENCIAS BIBLIOGRÁFICAS

1. Arrow, K.J., E. Colombatto y Ch. Schmidt (compiladores). 1996. The rationality Foundations of Economics, Macmillan, Londres. [ Links ]

2. Björnerstedt, J. y J. Weibull. 1996. "Nash Equilibrium and Evolution by Imitation", en Arrow, K. et al. [1996]. [ Links ]

3. Borges, T. y R. Sarin. 1993. "Learning through reinforcement and replicator dynamics", Laser-script. En http://econpapers.hhs.se/paper/elsesrcls/051.htm [ Links ]

4. Canning, D. 1992. "Average behavior in learning models", Journal of Economic Theory, 57, 442-472. [ Links ]

5. Cressman, R. 1992. "The stability concept of evolutionary game theory: a dynamic approach", Lecture Notes in Biomathematics, 94, Springer Verlag. [ Links ]

6. De La Fuente, A. 2000. Mathematical Methods and Models for Economists, Cambridge University Press. [ Links ]

7. Foster, D. y H.P. Young. 1991. "Cooperation in the short and in the long run", Games Economic Behavior, n. 3, 145-156. [ Links ]

8. Friedman, D. 1991. "Evolutionary Games in Economics", Econometrica, v. 59, n. 3, 637-666. [ Links ]

9. Fudenberg, D. y D. Levine. 1998. The Theory of Learning in Games, MIT Press, Cambridge, Mass. [ Links ]

10. Hargreaves-Heap, S. y Y. Varoufakis. 1995. Game Theory: A Critical Guide. Routledge, Londrés y Nueva York. [ Links ]

11. Harsanyi, J. y R. Selten. 1988. A General Theory of Equilibrium Selection in Games, MIT Press, Cambridge, Mass. [ Links ]

12. Kandori, M., G.J. Mailath y R. Rob. 1993. "Learning, Mutation and Long Run Equilibria in Games", Econometrica, v. 61, n. 1, 29-56. [ Links ]

13. Lewis, D. 1969. Convention: A philosophical study, Harvard University Press. [ Links ]

14. Maynard Smith, J. 1982. Evolution and the Theory of Games, Cambridge University Press. [ Links ]

15. Mora, J.J. 2001. "El papel de los costos de transacción en la formación de convenciones", Revista Estudios Gerenciales, 78, enero - marzo, 43-54. También se puede obtener en http://www.icesi.edu.co/~jjmora/contransaccion.pdf [ Links ]

16. Rankin, F., J. van Huyck y R. Battalio. 1998. "Strategic similarity and emergent conventions: Evidence from scrambled payoff perturbed stag hunt games", Laser script en http://econlab10.tamu.edu/JVH_gtee/C3.htmhttp://econlab10.tamu.edu/JVH_gtee/C3.htm [ Links ]

17. Samuelson, L. 1998. Evolutionary Games and Equilibrium Selection, MIT Press, Cambridge, Londres. [ Links ]

18. Samuelson, L. 1994. "Stochastic stability in games with alternative best replies", Journal of Economic Theory, 64, 35-65. [ Links ]

19. Schelling, T.C. 1960. The Strategy of Conflict, Harvard University Press, Cambridge, Mass. [ Links ]

20. Sudgen, R. 1989. "Spontaneous Order", Journal of Economics Perspectives, n. 3, 85-97. [ Links ]

21. Skyrms, B. 1992. "Chaos and the explanatory significance of equilibrium: Strange attractors in evolutionary game dynamics" en The Dynamics of Norms. Bicchieri, C., R. Jeffrey y B. Skirms (comps.), MIT Press, Cambridge. [ Links ]

22. Taylor, P.D. 1979. "Evolutionarily stable strategies with two types of players", Journal of Applied Probability, v. 16, 76-83. [ Links ]

23. Weibull, J. 1995. Evolutionary Game Theory. MIT Press, Cambridge. [ Links ]

24. Young, H.P. 1998. Individual strategy and social structure: An evolutionary theory of institutions, Princeton University Press. [ Links ]

25. Young, H.P. 1996. "The Economics of Conventions", Journal of Economics Perspectives, v. 10, n. 2, 105-122. [ Links ]

26. Young, H.P. 1995. "Equilibrium selection through adaptation and experimentation" en Learning and Rationality in Economics, Kirman y Salmon, editores. [ Links ]

27. Young, H.P. 1993. "The Evolution of Conventions", Econometrica, v. 61, n. 1, 57-84. [ Links ]