Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO -

Similars in Google

Similars in Google

Share

Cuadernos de Economía

Print version ISSN 0121-4772On-line version ISSN 2248-4337

Cuad. Econ. vol.28 no.51 Bogotá July/Dec. 2009

LA EVALUACIÓN DE IMPACTO Y LA EVALUACIÓN DE PROCESO EN UN SISTEMA GENERAL DE EVALUACIÓN. INTRODUCCIÓN AL TEMA MEDIANTE UN ESTUDIO DE CASO: EL PROGRAMA TORTILLA

J. Mario Herrera Ramos*

* Doctor en Economía, se desempeña como profesor-investigador de la Facultad Latinoamericana de Ciencias Sociales (FLACSO), Sede Académica de México. E-mail: mherrera@flacso.edu.mx. Dirección de correspondencia: Carretera al Ajusco 377, Col. Héroes de Padierna, C.P. 14200 México D.F.

Este artículo fue recibido el 15 de noviembre de 2008 y su publicación aprobada el 19 de junio de 2009.

Resumen

En México se ha institucionalizado la cultura de la evaluación de los programas sociales. A pesar de los esfuerzos del Consejo Nacional de Evaluación de la Política Social la evaluación de proceso, a diferencia de la de impacto, no ha recibido la atención que merece dentro de esa cultura. Mediante una regresión de Poisson, se presenta un ejemplo de la utilidad que tiene la evaluación de proceso para identificar puntos críticos en la eficiencia y la gestión de un programa. El caso de estudio se construye con la información de un programa que inicia en 1986 y desaparece en 2003: el Programa Tortilla.

Palabras clave: evaluación de proceso, evaluación de impacto, regresión de Poisson, desempeño del gobierno. JEL: C31, D73, H11, H59.

Abstract

The culture of evaluation of social programs has been institutionalized in Mexico. However, in spite of the efforts of the National Council for Social Policy Evaluation, process evaluation, contrary to impact evaluation, has not received the attention it deserves. This paper presents an example of the usefulness of process evaluation to identify critical aspects in the efficiency of processes and administration of a program by means of a Poisson regression. The example uses information from a program that started in 1986 and disappeared in 2003: the Programa Tortilla.

Key words: process evaluation, impact evaluation, Poisson regression, government performance. JEL: C31, D73, H11, H59.

Résumé

Au Mexique la culture de l´évaluation des programmes sociaux a été institutionnalisée. Malgré les efforts du Conseil National de l´Évaluation de la Politique Sociale, à différence de celle d´impact, l´évaluation du processus en soi n´a pas reçu l´attention qui mérite dans cette culture. Grâce à une régression de Poisson, on présente un exemple de l´utilité qui a l´évaluation du processus pour identifier des points critiques dans l´efficacité et la gestion d´un programme de politique sociale. Le cas d´étude est construit à partir de l´information sur un programme qui commence en 1986 et disparaît en 2003 : le Programme Tortilla.

Mot clés : évaluation de processus, évaluation d´impact, régression de Poisson, déroulement du gouvernement. JEL : C31, D73, H11, H59.

Los gobiernos de Latinoamérica han reconocido, en forma creciente, la importancia que tiene contar con un sistema de evaluación y seguimiento para mejorar la calidad de sus servicios. Existen diferencias en la manera de llevar a cabo los procesos de evaluación; sin embargo, hay un acuerdo sobre la utilidad de la evaluación en tres áreas: mejora la asignación de presupuesto, aumenta la calidad de la información con respecto al desempeño de las acciones de gobierno y es un medio adecuado de rendición de cuentas. De igual manera es posible encontrar un consenso sobre la necesidad de institucionalizar la práctica de la evaluación para obtener sus beneficios.

Es difícil encontrar experiencias similares en el proceso de institucionalización1 y en la práctica de la evaluación. En algunos casos como México, se crea un organismo responsable directo de la evaluación. En Brasil cada ministerio tiene un comité y en la mayoría de ellos existe una unidad de evaluación y seguimiento. En Chile se cuenta con un sistema de evaluación y seguimiento bajo la responsabilidad del Ministerio de Hacienda.

Con respecto a los tipos e instrumentos de evaluación también se identifican grandes diferencias: indicadores de desempeño, evaluación de impacto, análisis costo beneficio. Ante la diversidad de alternativas y prácticas de evaluación es relevante documentar todas las experiencias relacionadas con el tema.

Este trabajo es un esfuerzo por documentar una experiencia relacionada con un tipo particular de evaluación: la de proceso. La experiencia se presenta en el contexto de la institucionalización de la evaluación en México.

Desde principios de la década de 1970 es posible encontrar diferentes experiencias relacionadas con la práctica de la evaluación en algunos programas de desarrollo en México; por ejemplo, el Programa Integral de Desarrollo Rural (PIDER) que inició en 1973 y finalizó en 1983, incluía entre sus actividades la evaluación de sus efectos sobre los beneficiarios. El programa tenía un departamento de evaluación de impacto y un grupo externo de evaluación.

En la siguiente década se diseña y ejecuta el Programa de Becas de Capacitación para Trabajadores Desempleados (PROBECAT)2 que a partir de 1992 se evaluó en distintas ocasiones y es quizá uno de los programas con mayor seguimiento en el país (Cuevas, 2000). Sin embargo, la experiencia determinante para formalizar la práctica de la evaluación de la acción pública proviene del Programa de Educación, Salud y Alimentación (PROGRESA). Se instituyó en 1997 como un programa de transferencias condicionadas a madres para apoyar la educación, la salud y la alimentación de hogares seleccionados, ubicados inicialmente en zonas rurales. Una de las características sobresalientes fue que en su diseño se incorporó explícitamente la posibilidad de evaluar su impacto sobre la población beneficiada.

La primera evaluación de PROGRESA la realizó el International Food Policy Research Institute (IFPRI), con participación de personal mexicano que en ese momento trabajaba en el programa.

Por mandato legal en el presupuesto de egresos la evaluación de programas públicos es una actividad que se inicia formalmente en 1999. A partir de ese año, se encuentran los inicios de la sistematización e institucional ización de la evaluación en México.

La ley General de Desarrollo Social (LGDS) aprobada en 2004 (DOF, 2004), el Reglamento de la Ley General de Desarrollo Social (RLGDS) (DOF, 2006) y el Decreto por el que se regula el Consejo Nacional de Evaluación (CONEVAL) (DOF, 2005) proporcionan la base jurídica que le dan plena formalidad a la evaluación como una práctica obligatoria para todos los programas relacionados con subsidios y transferencias3.

Actualmente, en la práctica de la administración pública mexicana existen diferentes tipos de evaluación: de impacto; la realizada a partir de indicadores de satisfacción de los beneficiarios; de desempeño; y de proceso. Estas modalidades son complementarias e intentan responder a diferentes necesidades dentro del sistema de presupuesto por resultados, que es el enfoque propuesto por la presente administración. En este documento se sostiene que la evaluación es un proceso que inicia con el diseño y la ejecución del programa, le siguen las actividades de seguimiento y finaliza con las evaluaciones de proceso, desempeño e impacto. Esta secuencia retroalimenta al programa para mejorar su diseño y ejecución, con el fin de que cumpla sus objetivos con mayor eficiencia y eficacia.

Considerando los diversos tipos de evaluación propuestos por el CONEVAL, así como la enorme disparidad en el diseño de los múltiples programas federales, una de las primeras acciones de este organismo fue homogeneizar esta práctica en la administración pública federal. Con tal objetivo, en 2007, se realizó la evaluación de Consistencia y Resultados para todos los programas que el Presupuesto de Egresos de la Federación consideraba en el rubro de subsidios o transferencias y que estaban sujetos a Reglas de Operación (RO).

En 2009 el CONEVAL ordenó realizar cinco evaluaciones de proceso; sin embargo, se presentan dos problemas básicos. Primero, no existen antecedentes sobre este tipo de evaluación en México. Segundo, y quizá como consecuencia del anterior, no se cuenta con información adecuada para llevar a cabo el proceso. Por esta razón las evaluaciones habrán de generar su propia información con base en metodologías como grupos focales o entrevistas a profundidad.

El presente artículo tiene dos objetivos principales. El primero es contribuir a la reducción de la carencia de antecedentes y experiencias relacionadas con la evaluación de proceso. El segundo es presentar evidencia sobre los beneficios que este tipo de evaluación tiene dentro de un sistema institucionalizado de evaluación. Para ello, y a diferencia de las evaluaciones de proceso que actualmente se están realizando, se usa información generada por el programa, y se analiza mediante técnicas cuantitativas4. Adicionalmente, podría convertirse en una experiencia útil para otros países de América Latina como Argentina, Chile, Colombia o Perú que están llevando a cabo acciones dirigidas hacia la institucionalización de la evaluación, independientemente de las distintas alternativas que para ello han seguido.

El documento destaca la importancia y utilidad de la evaluación de proceso, mediante su aplicación a un programa que desapareció en 2003, pero que generó información útil para realizarla: el Programa Tortilla. Se argumenta que este tipo de evaluación es un complemento indispensable dentro de un sistema institucionalizado de evaluación de programas públicos. El objetivo de la evaluación de proceso es analizar la eficiencia en los procesos de operación de un programa y la relación con su gestión. Una de las facetas del análisis la constituye precisamente, el patrón de comportamiento de los beneficiarios con respecto a los servicios que ofrece el programa. Entre los resultados esperados del análisis se encuentra la identificación de puntos críticos en su operación.

Conviene aclarar la razón para usar el Programa Tortilla y su información, y es oportuno resumir su evolución y características principales. Inicia en 1986 como un subsidio generalizado al consumo de maíz y tortilla, y finaliza en 2003 como un subsidio focalizado para el consumo de tortilla. El Programa pasó por varias etapas en relación con su diseño y ejecución. En sus orígenes no se diseñó para evaluar sus resultados; sin embargo, en la fase final el programa experimentó varios cambios en su diseño, se aplicó una encuesta socioeconómica a todos los beneficiario, se institucionalizó la verificación del padrón, se mejoraron los medios de control, se elaboró una encuesta de satisfacción de beneficiarios, y se incorporaron, como en otros programas, indicadores de desempeño.

Estas modificaciones permitieron realizar evaluaciones de impacto y obtener información sobre patrones de asistencia para recoger el beneficio en las tortillerías participantes. Esto último es útil para realizar la evaluación de proceso –al menos parcialmente–, y de esta manera, proporciona un caso y un antecedente sobre el tema.

El análisis de la evolución del programa hace posible que en este documento se destaque un requisito indispensable de la política social. El conjunto de normas que regulan el desarrollo social obliga a que cualquier política social se diseñe para que sea evaluada. Ante la falta de esta condición la evaluación no puede cumplir con sus objetivos.

En este contexto, el documento estudia lo que se conoce en la literatura como evaluación de proceso y enfatiza la conveniencia de practicarla en conjunción con la evaluación de impacto. En el ejemplo se usa una regresión de Poisson para analizar los determinantes relacionados con las tasas de inasistencia de los beneficiarios a recoger el kilogramo de tortilla diario en las tortillerías participantes, sin costo, al que tenían derecho. Para ello se usa información generada por la administración del programa5.

El documento está dividido en seis partes. En la primera, se documenta los antecedentes de la evaluación desde el punto de vista de su institucionalización y se describen las acciones realizadas por el CONEVAL en 2007 para homogeneizar la práctica de la evaluación de la política social en México, así como la inclusión de dicha práctica en el marco de la administración de presupuesto por resultados aplicado por la actual administración. La segunda aborda el problema central de la evaluación como preámbulo para discutir la diferencia entre la evaluación de impacto y de proceso. En el tercer apartado se trata el tema de la evaluación de proceso. En la cuarta sección se presenta la evolución del padrón de beneficiarios del Programa Tortilla, destacando el hecho que fue uno de los programas de subsidio dirigido más importante de los años 1990 (este es un elemento básico para entender tanto el funcionamiento del programa, como el problema del control de asistencia por parte de los beneficiarios). La quinta parte analiza la administración del padrón, los patrones de asistencia a recoger el beneficio para el año 2001 y se aplica una regresión de Poisson para estudiar los factores asociados con las altas tasas de inasistencia (en algunos estados alcanzaban hasta el 60% de los beneficiarios)6. En la sexta sección se presentan las conclusiones.

La evaluación de proceso permitió identificar tres problemas con el funcionamiento del programa. Primero, las inasistencias afectaban principalmente a los hogares más pobres, los cuales otorgaban una mayor valoración a un ingreso adicional que al beneficio en especie. Segundo, la falta de credencial y las dificultades para obtener su reposición se encontraban entre las principales causas de los altos porcentajes de inasistencias. Tercero, los hogares con mayor ingreso relativo tenían una mayor propensión a no recoger su beneficio. De esta manera la evaluación de proceso permite identificar que el programa Tortilla tenía tres grandes fallas: focalización, diseño y administración (en términos de las acciones relacionadas con la reposición de la tarjeta de acreditación).

LA INSTITUCIONALIZACIÓN Y HOMOGENEIZACIÓN DE LA EVALUACIÓN DE PROGRAMAS Y POLÍTICAS PÚBLICAS EN MÉXICO

La institucionalización de la evaluación de la política social

La conveniencia de valorar y evaluar regularmente las acciones del gobierno es un hecho incontrovertible. Es de interés general, en una sociedad democrática, responder a preguntas como las siguientes: ¿qué efecto tiene la acción pública? ¿La acción pública cumple con los objetivos que justifican su elaboración y su ejecución? Si los cumple ¿en qué grado lo hace? En caso contrario, se requiere conocer si se debe a problemas de diseño, de ejecución, ambos, o definitivamente se debe a otras causas como ineficiencias e insuficiencias en su financiamiento o problemas de administración pública.

En el fondo, la pregunta de interés es la siguiente: ¿una acción pública en particular es la forma más eficiente para resolver un problema público determinado? La evaluación es una alternativa para responder a esta cuestión, ya que permite obtener evidencia sobre la eficiencia de la acción pública. Parafraseando a Heckman et al. (1999) el estado democrático moderno requiere conocimiento objetivo, contrastable sobre los efectos del gasto público. La institucionalización de la evaluación, además de proporcionar esa evidencia, fortalece al estado democrático al fortalecer la rendición de cuentas.

Actualmente, es posible encontrar un creciente interés por instaurar sistemas de evaluación y seguimiento de las decisiones de gobierno en diversos países, tanto en América Latina como en otros continentes (África, por ejemplo). A partir de la literatura que documenta y analiza estas experiencias se obtienen cuatro conclusiones importantes. La primera señala que no existe una sola alternativa para lograr exitosamente la institucionalización. Segunda, que el avance en ese proceso no es homogéneo, ni lineal; por esta razón se sugiere que incluso la experiencia de algunos países africanos –el continente con mayores necesidades en esta materia–, puede ser útil para otros países que estén ejecutando programas para reducir la pobreza (Mackay, 2006). Tercera, la institucionalización surge como una respuesta a la demanda ciudadana de mejorar el desempeño del gobierno; en particular, es un complemento necesario del enfoque conocido como "administración por resultados" en la administración pública y del gasto público. La cuarta, se relaciona con la existencia de una especie de acuerdo sobre los temas clave a considerar en el proceso de institucionalización, que sugiere el creciente número de estudios sobre el tema (Mackay, 2006).

Con base en este acuerdo, Mackay define a la institucionalización como:

[...]la creación de un sistema de SyE7 cuyos resultados sean valorados positivamente por las partes interesadas y se utilicen en la búsqueda del buen gobierno, siempre que haya una demanda suficiente de la función de SyE para garantizar su funcionamiento y su sustentabilidad en el futuro previsible (2006, 5).

Sin embargo, esta definición no es enteramente adecuada. En particular, porque destaca la necesidad de la demanda y el acuerdo de las partes involucradas, que se refiere más a las agencias de ayuda externa. Mackay (2006) afirma que para institucionalizar la evaluación es insuficiente estar de acuerdo en que la evaluación es una práctica positiva en sí misma; si no hay demanda y no se usan sus conclusiones y sugerencias, entonces no hay institucionalización.

Por el contrario, se procura argumentar que para establecer la institucionalización se requiere solamente el reconocimiento de la necesidad, la conveniencia y la operación de la evaluación, y que éste se respalde en un cuerpo normativo. La demanda es parte del proceso de rendición de cuentas y de un gobierno democrático.

El proceso de institucionalización de la evaluación como una práctica administrativa inicia en México a fines de la década pasada (Hernández, 2006; Feinstein y Hernández, 2008; Herrera, 2007; Behrman, 2007). En el Decreto de Presupuesto de la Federación de 1999 aparecen los inicios de la práctica sistemática de la evaluación de la acción pública en México. En el capítulo VI, sobre transferencias y subsidios, el apartado II del artículo 68 establece los requisitos que deben cumplir las Secretarías de Estado (entidades a las cuales se les asigna presupuesto bajo esta modalidad). Se menciona que para su operación y administración se debería procurar que facilite:

[...] la obtención de información y la evaluación de los beneficios económicos y sociales de su asignación y aplicación, así como evitar que se destinen recursos a una administración costosa y excesiva, en detrimento de los recursos asignados a la población objetivo (DOF, 1999).

El artículo 73 faculta a la Secretaría para aprobar las reglas de operación y los indicadores de evaluación de los subsidios y transferencias a fin de garantizar el cumplimiento de los objetivos del programa. El artículo 80 del capítulo II (de la evaluación y control) trata de la evaluación y establece que la Secretaría realizará la evaluación financiera del ejercicio del presupuesto. La entonces Secretaría de la Contraloría (actualmente Secretaría de la Función Pública) tenía un papel importante en el proceso de evaluación financiera. El presupuesto de 1998 tenía un espíritu similar, pero es interesante notar que el capítulo II se titulaba de la evaluación y verificación (ya no de control); sin embargo, el artículo décimo segundo transitorio establecía que la Coordinación Nacional del Programa de Educación, Salud y Alimentación (PROGRESA), debería publicar en el segundo bimestre del ejercicio los Lineamientos Generales para su operación (Reglas de Operación, RO). Entre éstos destaca la obligación de la Coordinación del programa de nombrar un Consejo Técnico de Evaluación y Seguimiento del Programa que incluía a instituciones académicas honorarias. La Coordinación informaría a la Secretaría de la Contraloría sobre los resultados de la evaluación y seguimiento del Programa.

Las referencias a la evaluación de las acciones públicas eran muy generales; solamente consideraban la obligación de incorporar mecanismos periódicos de evaluación y monitoreo de los programas de subsidio y transferencia. Inclusive la estructura organizacional no era la adecuada. En 1999, por ejemplo, la Secretaría de Desarrollo Social (SEDESOL) tenía una Dirección General de Evaluación, que dependía de la Subsecretaría de Desarrollo Regional. Su responsabilidad era cumplir con la normatividad de la evaluación de los programas del Ramo 26 (Desarrollo Social y Productivo en Regiones de Pobreza). La evaluación se limitó a la definición de indicadores de evaluación y gestión.

Sin embargo, ya existía el interés de medir los impactos socioeconómicos de los programas de subsidios y transferencias sobre las condiciones de vida de la población objetivo (Behrman, 2007). El Consejo Consultivo Ciudadano de la SEDESOL había sugerido que se establecieran mecanismos de supervisión, seguimiento y evaluación de los programas con recursos de subsidios y transferencias. La intención del mencionado artículo transitorio, era someter a evaluación externa el impacto de algunos programas seleccionados sobre las condiciones de vida de la población objetivo.

En el Decreto de Presupuesto de Egresos de la Federación para el año 2000 la situación fue totalmente distinta. Se especificaron los programas que deberían sujetarse a RO. El artículo 73 ordenaba que los programas de subsidios y transferencias, sujetos a RO, y que carecieran de un mecanismo de evaluación externa, tendrían que constituir un Consejo Técnico de Evaluación y Seguimiento que incluyera instituciones académicas. Por tanto, deberían evaluarse externamente y los resultados –a partir de 2001, los programas del Ramo 20–, se enviarían a la cámara de Diputados por conducto de la Comisión de Presupuesto y Cuenta Pública.

El camino hacia la sistematización e institucionalización de la evaluación de la acción pública en México –en particular la relacionada con los programas de subsidios y transferencias–, se consolidó con la aprobación de la Ley General de Desarrollo Social (LGDS) a principios de 2004. Esta ley amplió el concepto de desarrollo al incluir áreas diferentes a las relacionadas con la lucha contra la pobreza, incrementando el número y el tipo de programas que se deberían evaluar8.

De acuerdo con esta ley, la política de desarrollo social sería coordinada por la Comisión Intersecretarial de Desarrollo Social. Esta Comisión presidida por la SEDESOL, está integrada por las secretarías de Hacienda, Educación, Salud, Medio Ambiente, Comunicaciones y Transportes, Función Pública, Trabajo, Reforma Agraria y Turismo. Su título trata de la evaluación de la política de desarrollo social, y el artículo 72 ordena que la responsabilidad de dicha evaluación estuviera a cargo del Consejo Nacional de Evaluación de la Política de Desarrollo Social (CONEVAL). La evaluación sería independiente del organismo encargado de ejecutar el o los programas y su objetivo sería: "...revisar periódicamente el cumplimiento del objetivo social de los programas, metas y acciones de la Política de Desarrollo Social, para corregirlos, modificarlos, adicionarlos, reorientarlos o suspenderlos total o parcialmente" (DOF, 2004). Las evaluaciones las llevarían a cabo instituciones de educación superior, investigación científica u organizaciones no lucrativas.

La evaluación sería anual y en algunos casos multianual. El CONEVAL: "...será un organismo público descentralizado, con personalidad jurídica, patrimonio propio, autonomía técnica y de gestión de conformidad con la Ley Federal de Entidades Paraestatales" (DOF, 2004) y tendría dos objetivos centrales: normar y coordinar las evaluaciones de las políticas y programas sociales ejecutadas por las dependencias públicas; y establecer criterios y lineamientos para definir, identificar y medir la pobreza.

Uno de los problemas de la LGDS es que solamente regula la acción de evaluar. Quienes la elaboraron dieron por sentado que los programas y acciones públicas son en sí mismas evaluables, simple y sencillamente porque así se decidió. Nada más alejado de la realidad. Para que un programa sea evaluado con propiedad es necesario, indispensable, que haya sido diseñado para que se evalúe (Todd y Wolpin, 2006). Dos ejemplos contrastantes son de gran utilidad para documentar este punto: el PIDER y Solidaridad-Progresa Oportunidades. El primero no se diseñó para ser evaluado, mientras que el segundo sí, en particular la fase conocida como Progresa.

El Reglamento de la LGDS y el Decreto que regula al CONEVAL intentan enmendar esta falla (como es de esperarse). El artículo 5 del Decreto promueve la institucionalización de la "cultura de la evaluación". En particular el apartado X de dicho artículo y el artículo 7 del Reglamento aseguran que todos los programas de desarrollo social se diseñen (o rediseñen según sea el caso) para que puedan ser evaluados de forma periódica (DOF, 2005).

Es el CONOVAL el organismo que tiene la responsabilidad de definir ese diseño. Por ejemplo, el artículo 3 del Decreto indica que su objeto es: "[N]ormar y coordinar la evaluación de la Política Nacional de desarrollo Social...". Por su parte el artículo 76 del Reglamento señala que el CONEVAL definirá "...los criterios para elaborar indicadores de resultados, de gestión y servicios para medir cobertura, calidad e impacto de los programas sociales" (DOF, 2005).

En atención a esta normatividad el CONEVAL ha definido diferentes tipos de evaluación, Pero se han encontrado problemas asociados con la falta de antecedentes y experiencias con respecto a cierto tipo de evaluaciones como las de proceso9. Por esta razón, quizás, una de las primeras acciones del CONEVAL fue tratar de homogeneizar la evaluación, con esta labor se inicia el "rediseño" de los programas para que puedan evaluarse.

Si bien las evaluaciones serán externas, el apartado XIII del artículo 5 del Decreto, señala que los responsables de la operación de programas y acciones de desarrollo social podrán realizar las propias atendiendo siempre los lineamientos y criterios que para el caso establezca el CONEVAL.

En el curso de una década, aproximadamente, México ha institucionalizado la evaluación y el seguimiento de programas sociales. La cultura de la evaluación está en proceso de convertirse en una práctica regular en la administración pública. La institucionalización de la evaluación se basó en una secretaría de estado fuerte10, poderosa y de reconocida capacidad técnica en la materia como SEDESOL11 (Hernández, 2006).

Como parte de la institucionalización dicha secretaría se reestructuró para darle mayor importancia a la evaluación. En 2001 se crea la Subsecretaría de Prospectiva, Planeación y Evaluación, y de ella depende la Dirección General de Evaluación y Monitoreo de Programas Sociales. La práctica de la evaluación se fortaleció en una secretaría y después se extendió a otros programas y secretarías del gobierno mexicano.

El proceso de homogeneización de la evaluación de la política social

Se puede considerar la homogeneización del diseño de programas sociales desde dos puntos de vista –no necesariamente excluyentes. Un punto, restringido, sugeriría que este esfuerzo del CONEVAL es indispensable para llevar a cabo sus funciones, es decir, simple conveniencia administrativa del CONEVAL. Otro, más amplio, indica que este proceso es parte indispensable de la estrategia de "administración de presupuesto por resultados".

Ésta supone un gobierno efectivo y eficiente, como condiciones básicas para lograr los objetivos de crecimiento económico, reducción de la pobreza y disminución de la desigualdad.

El presupuesto por resultados se basa en el establecimiento de objetivos y metas cuantificables a fin de documentar y mostrar a los ciudadanos el desempeño del gobierno. Para reconocer los resultados exclusivamente obtenidos por la asignación del gasto público, es importante diseñar y construir un sistema de seguimiento y evaluación basado en el desempeño. Los indicadores estratégicos y de gestión que proporciona este sistema, permiten verificar el cumplimiento de los objetivos establecidos en los programas y políticas que ejecuta la administración pública. Esta información es fundamental para elaborar subsecuentes ejercicios presupuestales.

La segunda interpretación del proceso de homogeneización es la que se usará en este apartado. De hecho, este esfuerzo es un elemento importante del Sistema de Evaluación del Desempeño y forma parte del enfoque de "administración por resultados" propuesto por la actual administración.

Se mencionó anteriormente que el proceso de institucionalización de la evaluación en México se fortaleció gracias al apoyo de SEDESOL. Esta secretaría logró homogeneizar el diseño y la evaluación de los programas de desarrollo social bajo su responsabilidad. Al inicio de las operaciones del CONEVAL, tal como era de esperarse, los programas supeditados a RO y por tanto sujetos potenciales de evaluación, eran diversos en su diseño e incluso algunos tenían objetivos similares y en ocasiones incluso contradictorios.

Este hecho en sí mismo es un ejemplo de falta de coordinación entre las diferentes secretarías responsables de los programas. Una idea de la magnitud del problema se puede obtener al considerar el número de programas potencialmente sujetos de evaluación y el presupuesto asignado. En 2007, de acuerdo con CONEVAL, y a partir de una revisión sistemática de la información disponible, había 179 programas bajo la responsabilidad de 14 secretarías. De los 179, 72% pertenecían a cinco secretarías (agricultura, educación, salud, desarrollo social y hacienda), que a su vez concentraban poco más del 85% del presupuesto asignado (CONEVAL, 2008).

Antes de 2006 las evaluaciones externas eran muy diversas. Las había de impacto propiamente como en los casos de Progresa-Oportunidades o PROBECAT, y otras –la gran mayoría– solamente informaban sobre las acciones del programa y sus aparentes resultados. Las razones de esta gran diversidad en la evaluación de programas sociales pueden ser varias, pero destacan dos. La primera corresponde a que muchos programas no fueron diseñados para que se evaluaran. En su Informe 2008 el CONEVAL señala que 47% de los 106 programas evaluados en 2007-2008, no tenían definida la población total que presenta el problema que atienden. Más grave aún es el hecho que solamente 35% pudieran medir el logro de sus resultados esperados de conformidad con el nivel de sus objetivos (CONEVAL, 2008).

La segunda razón radica en la falta de criterios homogéneos sobre la evaluación. Cada entidad tenía que elaborar los términos de referencia de la evaluación, por tanto, su interpretación de lo que entendían por ésta y lo que esperaban como producto final eran determinantes para orientar dicha actividad. Adicionalmente, esta diversidad de interpretaciones estaba relacionada con la falta de personal capacitado en estos temas.

A partir de 2007 se inicia el proceso de homogeneización en todos los programas sujetos a RO. La publicación en Diario Oficial de los "Lineamientos generales para la evaluación de los Programas Federales de la Administración Pública Federal" por parte de la Secretaría de Hacienda, la Secretaría de la Función Pública y el CONEVAL proporciona el marco institucional de este proceso (DOF, 2007).

La homogeneización de la evaluación de la política social se realizó con base en el enfoque conocido como Matriz de Marco Lógico (MML) para elaborar la matriz de indicadores. La MML es un insumo para planear y administrar proyectos basados en resultados. Permite estructurar los principales elementos de un programa o proyecto, destacando los vínculos lógicos entre insumos, actividades planeadas y resultados esperados (Baccarini, 1999; Gasper, 1997, 2000).

Por otro lado, se definieron diferentes tipos de evaluación. El artículo 16 de los Lineamientos generales establece dos clases de evaluación: de programas y estratégicas. Entre la evaluación de programas se establecieron cinco tipos:

1. Evaluación de consistencia y resultados cuyo objetivo es analizar el diseño y el desempeño general del programa mediante la matriz de indicadores.

2. Evaluación de indicadores que consiste en el análisis (mediante trabajo de campo) de la pertinencia y el alcance de los indicadores de un programa para el logro de sus resultados.

3. Evaluación de proceso cuyo objetivo es analizar (mediante trabajo de campo) los procesos del programa, en términos de la eficacia y eficiencia de sus procesos de operación y su contribución a la gestión del mismo.

4. Evaluación de impacto que consiste en el análisis de las modificaciones en los indicadores de resultados que se atribuye a la ejecución del programa.

5. Evaluación específica que corresponde a toda evaluación de programas que no está comprendida en las anteriores.

La evaluación estratégica consiste en el análisis de uno o varios programas en relación con las estrategias, las políticas y las instituciones.

El proceso de homogeneización inició con la obligación de que todas las entidades responsables de programas sujetos a RO, elaboraran su respectiva MML. Como parte del proceso se capacitó al personal encargado dentro de cada entidad responsable. Posteriormente, con base en dicha MML, evaluadores externos, llevaron cabo –entre agosto de 2007 y marzo de 2008– la evaluación de consistencia y resultados de todos los programas.

En el diseño y ejecución de este tipo de evaluación se identificaron dos características sobresalientes. Primero, la evaluación se organizó alrededor de seis temas. Segundo, se diseñó con base en respuestas concretas a cien preguntas. Los temas y el número de preguntas son los siguientes (CONEVAL, 2007a):

1. Diseño (34).

2. Planeación estratégica (14).

3. Cobertura y focalización (8).

4. Operación (36).

5. Percepción de la población objetivo (3).

6. Resultados (5).

El CONEVAL también elaboró un programa anual de evaluación, en el cual señaló los programas que serían sometidos a los distintos tipos de evaluación (CONEVAL, 2007b). Vale la pena mencionar que el Consejo está autorizado para llevar a cabo determinados tipos de evaluación.

En estos últimos ocho años en México se ha pasado de la institucionalización de la evaluación de la política social a la homogeneización de su práctica12.

EL PROBLEMA CENTRAL DE LA EVALUACIÓN DE IMPACTO

La evaluación de impacto de políticas o programas de gobierno consiste fundamentalmente, en realizar algún tipo de inferencia causal sobre sus resultados. En principio, los individuos tienen la posibilidad de obtener el beneficio de un programa de gobierno, en este contexto, el problema de interés en la evaluación de impacto es comparar la situación del individuo que recibió el beneficio, con aquella en caso de no haberlo recibido.

El obstáculo principal para la inferencia causal es precisamente, que no es posible observar al individuo beneficiado al mismo tiempo que si no lo fuera. Es imposible analizar los efectos del programa, y a la vez, el resultado correspondiente ante su ausencia, sobre el mismo individuo beneficiario. Este es en esencia, lo que Holland (1986) denomina "el problema principal de la inferencia causal".

Rubin, en una serie de publicaciones (2006) estableció el marco de análisis dominante en el análisis causal y en la evaluación de impacto. El autor emplea el enfoque experimental y lo desarrolla para el caso de estudios basados en observaciones. Estos últimos, a diferencia de los experimentales, se caracterizan por la ausencia de aleatoriedad en la asignación del tratamiento o programa, términos que se usan como sinónimos en la literatura sobre el tema. La ausencia de aleatoriedad hace imposible que se tenga alguna certeza de que las estimaciones de su efecto sean insesgadas.

Si el tratamiento no es aleatorio, los resultados observados pueden haber sido causados por variables diferentes a las que controla el programa. Es decir, otras variables pueden estar detrás de ellos y "confunden" la inferencia causal. Básicamente, el "modelo causal de Rubin" como lo denominó Holland (1986), propone interpretar una afirmación causal como la comparación de dos estados potenciales. Esto es, la comparación de dos resultados para un mismo individuo, considerando diferentes niveles de exposición a los beneficios del programa. En este modelo causal es muy importante la relación entre el programa y los resultados potenciales.

Se considera una población de individuos de tamaño N. Para el individuo i el modelo causal de Rubin establece que existen dos resultados potenciales13 yi0 (resultado que obtendría i si no participara en el programa) y yi1 (resultado que obtendría i si participara en el programa).

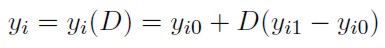

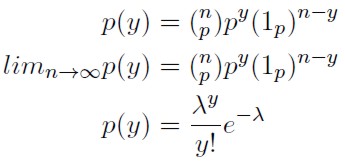

El individuo puede participar o no en el programa, pero es imposible que tome ambas decisiones al mismo tiempo. Solamente puede observarse uno de ellos, y el otro, dado el observado se convierte en resultado "contrafactual". De esta manera, el resultado observado yi está dado por:

| [1] |

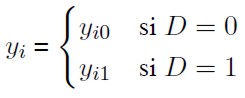

Donde

D es una variable binaria, que toma el valor de 1 cuando el individuo es beneficiario del programa y 0 en caso contrario.

Una forma simple de definir el efecto causal del programa para el individuo i es la diferencia yi1 - yi0. Debido al problema fundamental de la inferencia causal no es posible calcular esta diferencia para el mismo individuo, especialmente cuando, como es común en estudios observacionales de evaluación de impacto de programas, existe una gran heterogeneidad. Sin embargo, también es de interés analizar el efecto promedio del tratamiento (EPT o ATE por sus siglas en inglés): EPT = E[y1 - y0].

O el efecto promedio del tratamiento sobre los tratados o beneficiados (EPTT o ATET por sus siglas en inglés): EPTT = E[y1 - y0|D = 1].

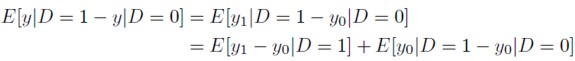

La comparación de resultados para los beneficiarios y los no beneficiarios, usualmente, presenta problemas de sesgo.

| [2] |

Donde E[y1 - y0 |D = 1] es el efecto promedio condicionado a la participación en el programa y E[y0 |D = 1 - y0|D = 0] es la diferencia esperada en el efecto o resultado del programa sin él, entre quienes participan o reciben el beneficio y quienes no lo hacen.

El segundo término de esta ecuación resulta de lo que se conoce como problema de selección y frecuentemente es diferente de cero. La simple comparación de resultados observados entre quienes reciben el beneficio del programa y quienes no lo reciben, no ofrece una medida útil o con posibilidades de interpretación analítica.

El marco del modelo causal de Rubin ofrece una alternativa para enfrentar este problema. El mecanismo de asignación es la probabilidad condicional de recibir el beneficio del programa como función de los resultados observados y potenciales (Imbens y Wooldridge, 2008). Uno de los tres diferentes tipos de asignación que distinguen estos autores es, precisamente, aquél que mantiene la independencia entre la asignación del programa y los resultados potenciales, y0, y1 ⊥ D|xi, donde xi es el vector de covariables.

Una vez controladas las variaciones que introducen en el resultado las diferencias en las covariables, la participación en los beneficios del programa no depende de los resultados potenciales (Cameron y Trivedi, 2005; Wooldridge, 2002). Este tipo de mecanismo de asignación del beneficio recibe diversos nombres; por ejemplo, Cameron y Trivedi (2005) lo denominan independencia condicional, Rubin (2006) lo llama asignación sin confusión o en otros casos selección con base en observables (Imbens y Wooldridge, 2008, 8).

Los métodos para estimar EPT o EPTT basados en el mecanismo de asignación sin confusión, es decir, suponiendo independencia condicional, son los más usados. En este grupo de métodos se encuentran los conocidos como el "empate en el marcador de la propensión" (propensity score matching), es decir, el empate basado en la probabilidad condicional de obtener el beneficio del programa. Sin este supuesto de independencia no existe una perspectiva general para estimar el efecto causal de un programa.

Se cuentan con diferentes formas de llevar a cabo la evaluación de impacto de un programa cuando existe "confusión". Entre estas alternativas se encuentra el uso de variables instrumentales, el diseño de regresión discontinua o el método de diferencia en diferencias, entre otros (Imbens y Wooldridge, 2008).

LA EVALUACIÓN DE PROCESO

El punto central de la evaluación de impacto es contestar a la pregunta ¿qué hubiera pasado si no existiera el programa? El interés radica en buscar si el programa causa los efectos esperados, establecidos en sus objetivos. Es decir, si se obtienen los objetivos del programa (reducir la pobreza, por ejemplo) el problema de la evaluación de impacto consiste en cuantificar en qué medida ello se debe a al programa y no a otra causa. Sin embargo, en el proceso de elaboración y análisis de políticas públicas se requiere saber si el diseño del programa es adecuado para la obtención de los objetivos establecidos; si funciona en forma apropiada; la medida en que se han cumplido los objetivos; entre otros. La evaluación de proceso tiene por objetivo contestar a la pregunta ¿cómo está operando el programa? ¿Se están cumpliendo los objetivos de acuerdo con lo planeado? Como afirman Rossi y otros la evaluación de proceso analiza la efectividad y la fidelidad en la ejecución del programa (Rossi et al., 2004).

La evaluación de proceso procura entender los medios a través de los cuales el programa tiene impacto (o carencia de impacto). Preguntas específicas relacionadas con la evaluación de proceso serían las siguientes: ¿Cuántos de quienes se identifican como población beneficiaria del programa usan sus servicios? ¿El programa beneficia a la población a la cual está dirigido? ¿Quiénes no usan el beneficio o lo han dejado de recibir? ¿El programa se lleva a cabo como se planeó? ¿Su ejecución se realiza con normas de calidad en el servicio?

En cierta medida, la evaluación de la satisfacción de los beneficiarios con el programa es una parte de la evaluación de proceso. La calidad de insumos y productos, y la experiencia y opinión de los beneficiarios constituyen medidas importantes de la evaluación de proceso. Precisamente porque intenta responder algunas de las preguntas mencionadas anteriormente, con frecuencia se lleva a cabo mediante técnicas como grupos focales o la aplicación de encuestas a profundidad.

Conviene distinguir la evaluación de proceso y el seguimiento (monitoreo) del programa. El seguimiento es una actividad que se realiza regularmente y en periodos cortos; es una función continua y sistemática en la administración del programa en relación con sus progresos, uso de recursos, entre otros. En la evaluación de proceso se establecen criterios de funcionamiento que los administradores del programa –de acuerdo con las reglas de operación– consideran importantes, por ejemplo, incorporar determinado número de hogares pobres al programa en localidades urbanas en un año; extender la cobertura médica a cierto número de familias rurales en dos años, etcétera. Es en este contexto que tiene sentido el establecimiento de indicadores de desempeño (Heckman et al., 2002; Heinrich, 1999).

La literatura especializada (Rossi et al., 1999) menciona que la evaluación de proceso se puede llevar a cabo en forma separada, independiente o como parte de un programa general de evaluación que incluye tanto proceso como impacto. Antes de 2000 en México se usaba con mayor frecuencia el seguimiento y la evaluación de proceso como formas predominantes de evaluación de las acciones públicas, aunque no de manera formal.

La evaluación de impacto y la de proceso deben integrar un ordenamiento institucionalizado de evaluación de programas públicos. Ambas actividades son parte de una cadena de resultados que se tomaron en consideración en el así llamado "marco lógico" del programa. Éste se basa en una serie de relaciones del tipo "si· · · entonces"; por ejemplo, "si existen los recursos, entonces realizamos tales actividades", "si realizamos tales actividades entonces tendremos ciertos resultados", etcétera. En otras palabras en el marco lógico se construyen cadenas de relaciones entre asignación de recursos, insumos, productos, resultados e impactos del programa público. Los resultados de la evaluación de proceso permiten revisar el diseño del programa y mejorar tanto su ejecución como la rendición de cuentas.

Se inició esta parte mencionando que la evaluación de impacto tiene interés en buscar la causa de cierto resultado, se puede finalizar diciendo que la evaluación de proceso asume que existe causalidad. A diferencia de los enfoques tradicionales para la realización de la evaluación de proceso (grupos focales, entrevistas a profundidad) se aplica una variante de estudio de caso (Windsor et al., 2000), con un enfoque diferente, en función del propio diseño del Programa. Se emplea información administrativa, que generó el Programa Tortilla para controlar las diferentes fases que integraban el proceso de entrega de la ayuda a los beneficiarios. El proceso se resume en las siguientes etapas:

1. Solicitud de afiliación al programa, condicionado a que el potencial beneficiario viviera en las zonas marginadas urbanas de acuerdo con el Fideicomiso para la Liquidación al Subsidio de la Tortilla (FIDELIST).

2. Aplicación de una cédula socioeconómica.

3. FIDELIST califica la solicitud de acuerdo con un sistema de puntaje basado en las características del solicitante.

4. Aprobación o rechazo de la solicitud de acuerdo con ese puntaje.

5. Asignación de una tarjeta electrónica para controlar el retiro diario de su beneficio; sin ella no se podía obtener el beneficio. FIDELIST le proporcionaba a cada industrial de la tortilla participante un lector digital de la tarjeta, que era el medio de control y de comprobación para que se le pagaran los kilogramos retirados por los beneficiarios. En caso de pérdida, el beneficiario tenía que solicitar una reposición.

6. Control diario del total de kilogramos de tortilla adquiridos por los beneficiarios en cada zona.

7. Pago semanal al industrial participante en el programa, de acuerdo con los kilogramos de tortilla retirados por los beneficiarios.

8. Los industriales de la tortilla que participaban en el programa debían cumplir con una serie de requisitos y su aprobación la realizaba un consejo creado expresamente para ello.

Considerando que la base del trabajo empírico de este artículo proviene de la información generada por la administración del padrón de beneficiario, conviene presentar su evolución. Al mismo tiempo, se verá cómo se modificó el diseño y la ejecución del programa, al pasar de ser uno de apoyo a industriales a uno de desarrollo social.

LA EVOLUCIÓN DEL PADRÓN DE BENEFICIARIOS DEL PROGRAMA TORTILLA

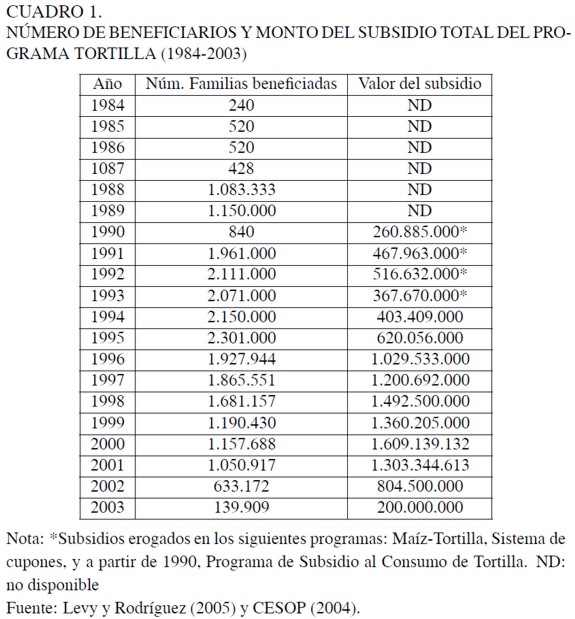

Se distinguen cinco etapas en la evolución del programa. La primera, bajo el nombre de Programa Maíz-Tortilla (que substituyó al de Compra de Maíz, que era de subsidio generalizado), es un intento por transferir el subsidio a la producción y otorgarlo directamente al consumo de tortilla. El Programa lo administró la Compañía Nacional de Subsistencias Populares (CONASUPO) y era un subsidio menos generalizado que el de Compra de Maíz; consistía en la venta de "tortibono" o cupones para adquirir 1 ó 2 kilos de tortilla a precio menor que el oficial, que se canjeaba en tortillerías afiliadas. El subsidio se otorgaba a familias con ingresos menores a dos salarios mínimos y lo operó la Distribuidora CONASUPO S.A. (DICONSA) en 36 ciudades entre 1986 y 1990. El 60% de los beneficiarios de este programa se localizaba en el Distrito Federal.

A principios de la década de 1990, los programas de subsidios generalizados se substituyeron por programas focalizados. En este contexto se presenta la segunda etapa en la evolución del padrón, que inicia en noviembre de 1990, con la creación del Programa de Subsidio al Consumo de Tortilla. Éste se focalizaba hacia la población en condiciones de pobreza urbana y por ello el "tortibono" substituyó temporalmente al "tortivale". Los criterios de focalización más importantes fueron el ingreso (menos de dos salarios mínimos) y el geográfico: el beneficiario potencial debía vivir en zonas urbanas marginadas, seleccionadas a partir de "mapas de pobreza".

En el inicio de esta etapa el Programa operó con el padrón de beneficiarios de CONASUPO. Las familias de este registro tenían derecho a un kilo diario de tortilla gratis. Las modificaciones al programa se realizaron es dos fases. En la primera (noviembre 1990 - abril 1991) se emitieron "tortivales" y fue una etapa de transición hacia la asignación focalizada. Los beneficiarios recibían directamente (por correo) sus vales para canjearlos por un kilogramo de tortilla en los establecimientos afiliados. Durante esta época se calcula que el Programa benefició a cerca de 1,8 millones de familias. La segunda fase inicia en mayo de 1991, en la cual se substituyó al "tortivale" por tarjetas de plástico con código de barras, que se asignaron a los beneficiarios inscritos en el padrón. A los industriales de la tortilla se les entregó un lector óptico para registrar las tarjetas de los beneficiarios cuando les entregaban su kilogramo de tortilla. El Programa se extendió a 36 nuevas ciudades, de manera que operó en las 71 ciudades más importantes del territorio mexicano.

Con las modificaciones el programa también aumentó su cobertura, entre julio y diciembre de 1991 se expandió a 131 nuevas ciudades. Se aplicó una cédula socioeconómica en las nuevas ciudades y se incorporaron 383.000 familias al padrón. También se aplicó en las 71 ciudades mencionadas anteriormente y como resultado incorporó otras 335,000 familias.

En esta segunda etapa el padrón de beneficiarios estaba integrado aproximadamente, por 2.100.000 familias atendidas por casi 15.000 industriales afiliados (tortilleros). Una empresa filial del Banco Nacional de México (Banamex), que descargaba la información capturada en los lectores, emitía certificados de pago contra el que CONASUPO expedía un cheque.

Tomando en cuenta la forma como se elaboró el padrón no era extraño encontrar fallas de focalización. En particular, la primera parte del padrón (1.400.000 familias) se integró con beneficiarios que pertenecían a DICONSA (afiliados a sindicatos y asociaciones de colonos) y beneficiarios del Programa de Abasto Social de Leche registrados en Leche Industrializada CONASUPO (LICONSA), por tanto, respondían a reglas de operación diferentes.

Para resolver diferentes problemas asociados con la operación del Programa, que iban desde la administración del padrón (se presentaba una reducción en la recepción de los beneficiarios) hasta la oportunidad en los pagos a industriales, en abril de 1992 se constituye el FIDELIST. El objetivo era separar las acciones de operación y las de liquidación. En 1993 se aprueban las reglas de operación del FIDELIST; a fines de ese año inicia el proceso de modificación del marco cartográfico y se realiza la verificación aleatoria del padrón para depurar beneficiarios. Con esta acción se eliminaron cerca de 600.000 hogares favorecidos.

La tercera etapa en la evolución del padrón inicia en 1994 con la fusión de la Dirección de Programas Sociales de CONASUPO con el FIDELIST y con la transferencia de la coordinación del programa de la entonces, Secretaría de Comercio y Fomento Industrial a la Secretaría de Desarrollo Social. En los primeros tres años de operación se incluyeron nuevas localidades y municipios, aunque el padrón se mantuvo en 2, 1 millones de beneficiarios. En ese año el Banco Mundial elaboró un estudio relacionado con la focalización del Programa, este trabajo sugería que era posible aumentar la precisión de la focalización mediante el uso de unidades espaciales menores (Grosh, 1994). Al mejorar la focalización se redujo la "fuga" de recursos y se hizo más eficiente el aumento de la cobertura (Grosh, 1994, 97).

En 1998 inicia la cuarta etapa con la ejecución del Programa de Verificación. Además de actualizar el marco cartográfico:

[...] se identificaron de manera precisa las zonas donde el Fideicomiso tenía presencia, considerando la información geográfica y estadística del Instituto Nacional de Estadística Geografía e Informática. Así mismo, se actualizaron los niveles socioeconómicos de colonia, lo cual permitió evaluar las condiciones de pobreza y marginación de las zonas atendidas (SEDESOL, 1999, 405).

También se verificó la ubicación de las familias beneficiadas y se rediseñó la Cédula de Evaluación Socioeconómica, que se aplicó en las colonias de nivel socioeconómico bajo y medio bajo, donde operaba el Programa. En 1998 el padrón estaba integrado por 1.680.000 familias beneficiadas y para 2000 había decrecido en 34, 73%.

La etapa final se presenta en noviembre de 2000 con la extinción del FIDELIST y con el traslado de la administración del Programa bajo la responsabilidad de LICONSA. El Cuadro 1 presenta la evolución del número de familias beneficiadas, y para algunos años, el monto de su presupuesto anual.

ADMINISTRACIÓN DEL PADRÓN Y PATRONES DE ASISTENCIA. EVALUACIÓN DE PROCESO MEDIANTE LA REGRESIÓN DE POISSON

En esta parte se muestran las ventajas de analizar el padrón de beneficiario para mejorar la administración y el diseño del programa, mediante la evaluación de proceso. La evaluación de proceso, como se dijo en un apartado anterior, tiene como objetivo analizar la ejecución y operación del programa. Las preguntas de interés que trata de contestar son ¿cuántas personas decidieron entrar/salir del programa, y por qué? ¿Quiénes fueron admitidos? ¿Cómo se comparan los admitidos con los rechazados? ¿Cuánto cuesta la ejecución del programa? ¿Cuáles la calidad del servicio? ¿Qué opinan los beneficiarios?

La evaluación de proceso presentada en este trabajo se concentra en el estudio del comportamiento de los beneficiarios, referente a la frecuencia con que acudían a retirar el beneficio que les otorgaba el programa.

Su diseño requería controlar la asistencia a recoger el kilogramo de tortilla gratuito al que tenía derecho el beneficiario. Como se mencionó anteriormente a partir de 1998 se realiza un "inventario" del padrón y se censa a más de dos millones de beneficiarios registrados. Uno de los resultados fue la generación de información sobre las características socio-demográficas actualizadas de los beneficiarios. Por otra parte, el control de asistencia mediante registro electrónico produjo información sobre los patrones de asiduidad de los beneficiarios "verificados". La información permite investigar uno de los problemas más acuciantes que enfrentó el programa: el alto porcentaje de inasistencias a recoger el kilogramo de tortilla y la reducción del padrón de beneficiarios.

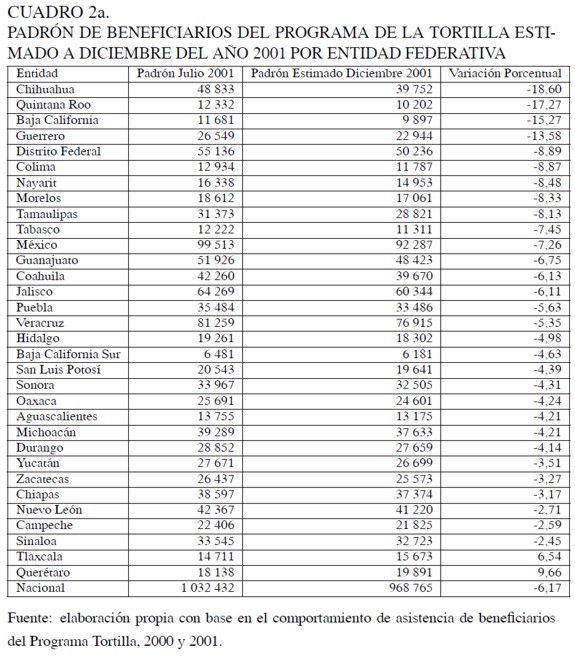

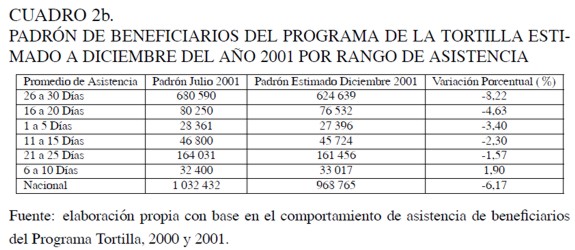

El diseño del programa tenía varias características que en principio lo harían atractivo a los beneficiarios. El beneficio consistía en un bien básico en la dieta, era gratuito y las tortillerías participantes estaban localizadas a menos de diez minutos de camino en cada zona de servicio. Consecuentemente, era de esperar que la falta de asistencia de los beneficiarios a recoger su beneficio fuera esporádica. Sin embargo, este no fue el caso; por ejemplo, en el mes de junio de 2001, 31, 12% de los hogares beneficiados en el estado de Baja California y 18, 60% en Chihuahua asistieron menos de 15 días a recoger el kilogramo de tortillas. Si la tendencia se hubiera mantenido, entonces el padrón a fines de año se hubiera reducido 6, 17%. Estados como Chihuahua y Baja California sufrirían las reducciones más importantes: 18, 60% y 15, 27%, respectivamente. Por alguna razón los usuarios que asistían con mayor frecuencia a recoger su kilogramo de tortilla serían los que se reducirían en mayor proporción, 8, 22%.

El estudio de este comportamiento es importante para evaluar un programa –y tiene que ver con la administración de padrones y el diseño del programa–, porque ayuda a entender el comportamiento de los beneficiarios con respecto a los objetivos del mismo. En primera instancia, el alto grado de inasistencia parecería inexplicable; sin embargo, podría ser un ejemplo de " votar con los pies", es decir, que los beneficiarios no consideraban el beneficio de este programa como importante o el programa estaba mal diseñado. En ambos casos se estaría ante una falla del programa cuya existencia y causa debe ser parte de la evaluación.

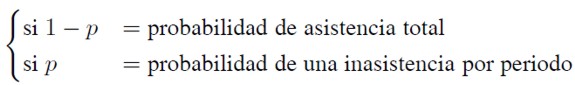

El problema de inasistencia es similar al de encontrar la distribución de probabilidad que un beneficiario no acuda a recoger su beneficio en un periodo determinado. En cada uno de estos periodos, la probabilidad de inasistencia es diferente de cero. Este problema está relacionado con la distribución binomial y cuando el número de periodos tiende a infinito se convierte en una distribución de Poisson.

Puesto que solamente se podía asistir una vez al día a recoger el kilogramo de tortilla, la probabilidad de más de una inasistencia por periodo es cero.

Si np = λ, siendo n el número de pruebas idénticas y obteniendo el límite de la probabilidad de y, el evento inasistencia, se tiene:

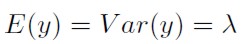

Donde λ es el número de veces que ha ocurrido la inasistencia por unidad de tiempo, esta última expresión es la función de distribución de Poisson. La función tiene algunas propiedades importantes que vale señalar; una de ellas es que la media y la varianza son iguales:

| [3] |

Esta propiedad se conoce como equidispersión y de no cumplirse el modelo sería inadecuado para estudiar el fenómeno de interés. Una segunda propiedad consiste en que a mayor valor de λ, la probabilidad de que se encuentren cero inasistencias disminuye.

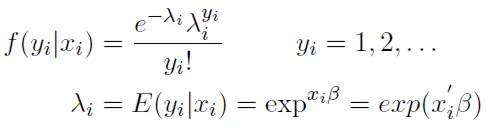

El número de inasistencias sigue la distribución de Poisson, en la cual la media condicional depende de las características de los beneficiarios del programa y cuyo modelo es el de la función media exponencial:

El modelo de regresión de Poisson se especifica por las dos ecuaciones anteriores. Este modelo es lineal en logaritmos:

| [4] |

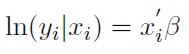

La función de máxima verosimilitud está dada por:

| [5] |

Cuando existe sub o sobre dispersión, es decir: E(y) ≠ Var(y) ≠ λ ⇒ E(y) < Var(y);E(y) > Var(y), la distribución proporciona estimadores ineficientes, por tanto, los errores estándar estarán subestimados. Una forma de superar este problema es mediante la función binomial negativa. Es decir, mediante el uso de una función de probabilidad que relaje la propiedad de equidispersión (Cameron y Trivedi 1998, 2005; Wooldridge 2002).

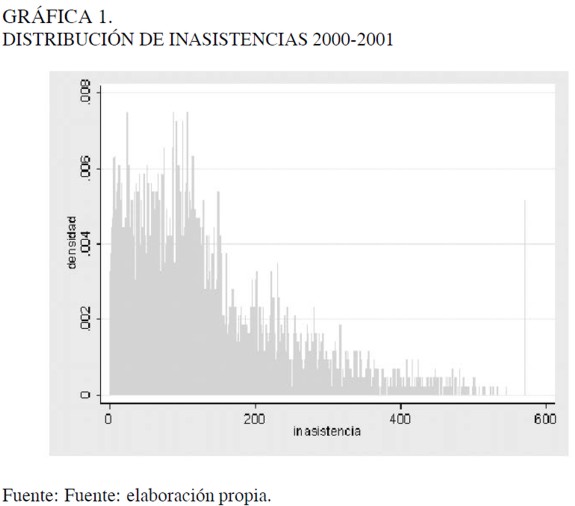

La mayor parte de los casos de información con datos de cuenta violan la condición de equidispersión. El estudio de inasistencia del Programa Tortilla no es la excepción: la prueba Chi cuadrada de bondad de ajuste el modelo de Poisson sugiere que no es apropiado. La Gráfica 1 también muestra que una regresión lineal tampoco es adecuada, puesto que la distribución está sesgada hacia la izquierda; la media es igual a 134,53 y la varianza es igual a 12.189,34.

El uso de la distribución binomial negativa estaría entonces, plenamente justificado.

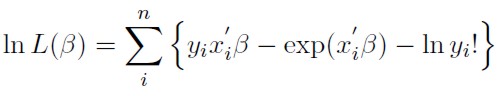

Una forma de introducir la binomial negativa es mediante el concepto de heterogeneidad no observada –se requiere relajar la condición de media igual a varianza.

| [6] |

Donde el error aleatorio puede deberse a la especificación o como en el caso del programa Tortilla, que emplea información de corte transversal, a la heterogeneidad no observada. Además, diferentes valores de las covariables generan distintos valores en la media esperada. Por su parte u = exp(εi) es la distribución condicionada de yi respecto a las covariables y al término de error, u es Poisson.

| [7] |

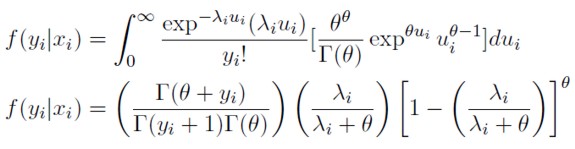

La distribución f(yi | xi) se puede obtener mediante su valor esperado promediando por el valor de ui:

| [8] |

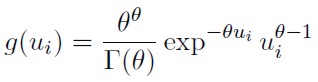

Para evaluar esta función se requiere especificar la función de densidad de ui14. Se suele asumir que ui = exp(εi) se distribuye como una función gama:

| [9] |

y substituyendo se obtiene:

| [10] |

La media condicional es la misma que en el caso de la distribución Poisson λi = ui, pero la varianza es Var = λi(1 + (1 / θ) λi).

Para estimar este modelo se empleará la información proveniente de la muestra de "reverificación" 2001 elaborada por LICONSA y el Programa Tortilla. Se agrupan los hogares por decil de ingreso, los puntos asignados por el sistema de puntaje que usaba el programa para admitir beneficiarios en el padrón, los patrones de gasto en alimentos y tortilla, y su promedio semestral de asistencia. En el Cuadro 3 no se observa diferencia entre el decil de ingreso y el promedio de asistencia; en todos los deciles el promedio es de aproximadamente de 23 días mensuales. Sin embargo, si se desagrega el promedio de asistencia en tres categorías, menos de 16 días, entre 16 y 19 días, más de 20 días, se encuentran algunas regularidades interesantes.

Los hogares en esta muestra que asisten menos de 16 días al mes corresponden a 10, 15%. Los hogares que pertenecen a los deciles 1 y 3 asignan cerca de 7% de su gasto alimentario a la compra de tortillas. Las familias en los deciles 2, 4 y 5 asignan aproximadamente 11% de su gasto alimentario a la compra de tortilla. Los hogares en los dos últimos deciles tienen un ingreso mayor a dos salarios mínimos y asignan una menor proporción de su gasto a tortilla (5%), y son los que presentan un menor promedio de asistencia. En el primer semestre de ese año este grupo aumentó su promedio de asistencia en dos días.

Los hogares con asistencia promedio entre 16 y 19 días, representan casi 10% de la muestra, pero tienen un ingreso mayor que los hogares con asistencia menor a 16 días. Sin embargo, asignan una proporción mayor de su gasto en alimentos a la adquisición de tortilla y su promedio de asistencia se incrementó en cada semestre.

Los hogares con asistencia mayor a 19 días representan 80% de la muestra y asignan menos de tres cuartas partes de su ingreso al consumo de alimentos. El gasto en tortilla con respecto al gasto en alimentos representa entre 14 y 23%; en promedio representa 10, 06% del gasto en alimentos. Su asistencia a recoger el kilogramo de tortilla se mantiene constante alrededor de 25 días mensuales.

Los hogares con mayor asistencia son los que asignan una proporción mayor de su gasto a la compra de tortillas. En la medida que esta afirmación sea cierta, debe haber preocupación sobre la tendencia a la disminución del padrón. Es probable que dicha reducción se deba a causas diferentes al no deseo de ir a recoger el kilogramo.

Para el análisis de costo-efectividad del programa existen al menos dos alternativas. El programa generaba información diaria sobre los patrones de asistencia de los beneficiarios, con ellos se integraba el pago a los industriales. Adicionalmente, para mantener el control del padrón, LICONSA elaboraba muestras para verificarlo. Para este análisis se tuvo acceso a la muestra levantada en el primer trimestre del 2001 y los patrones de asistencia mensual entre enero de 2000 y julio del 2001.

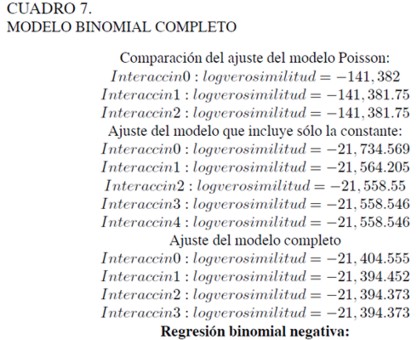

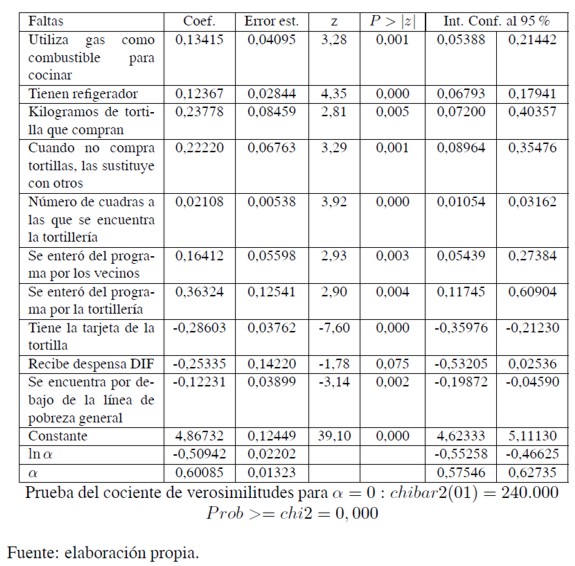

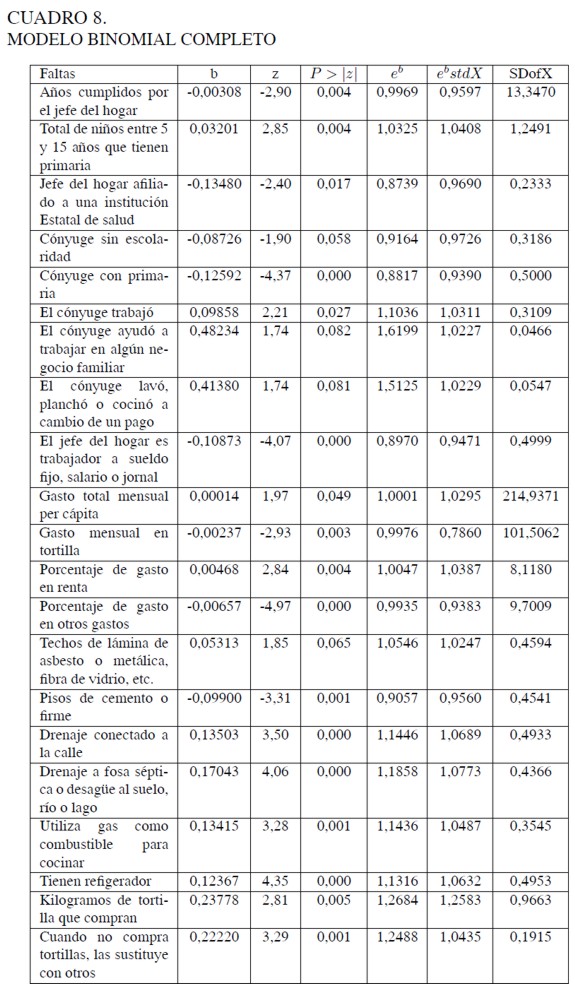

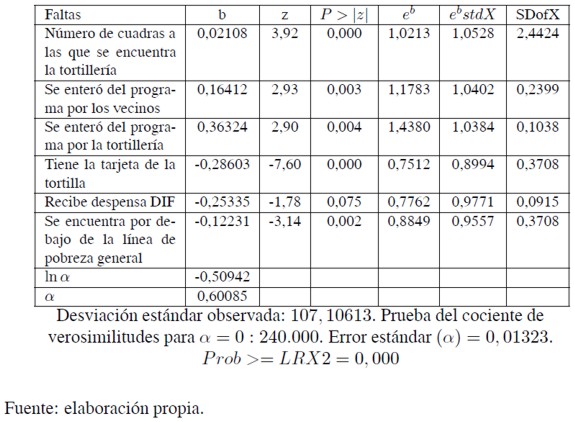

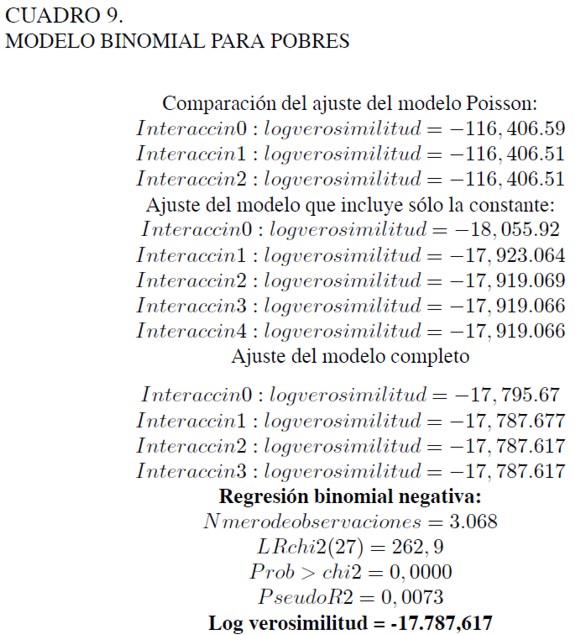

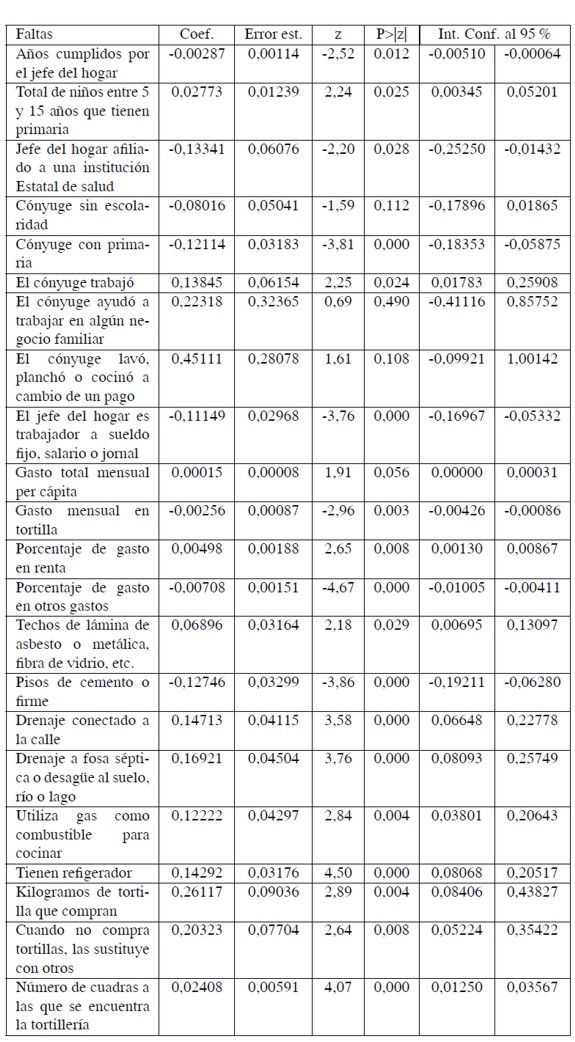

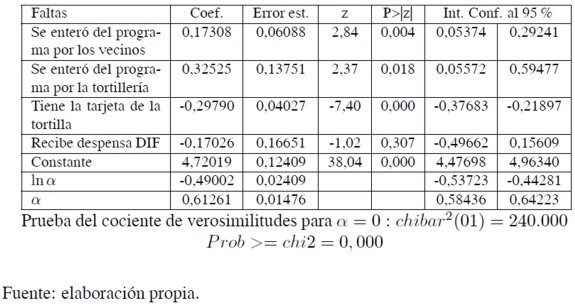

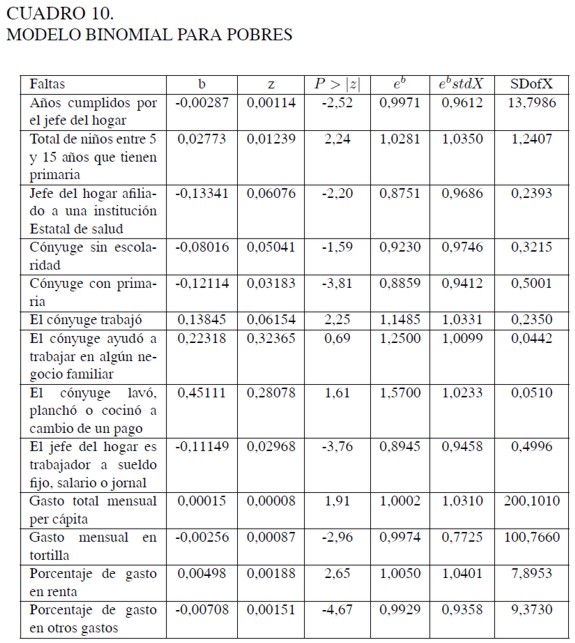

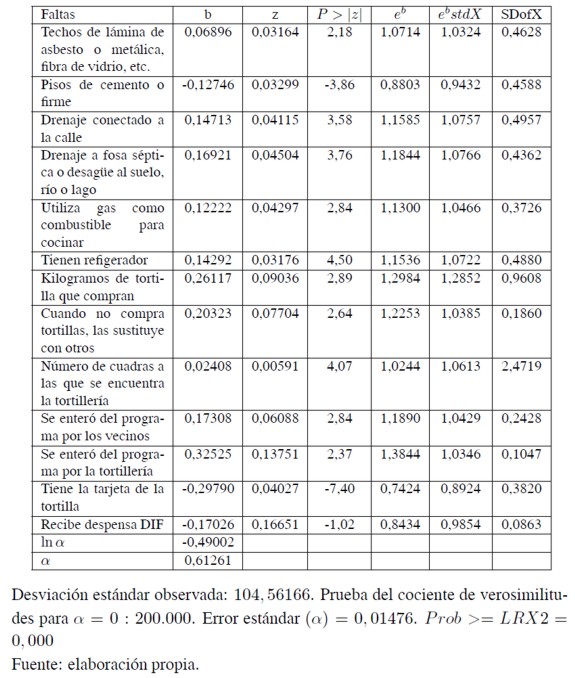

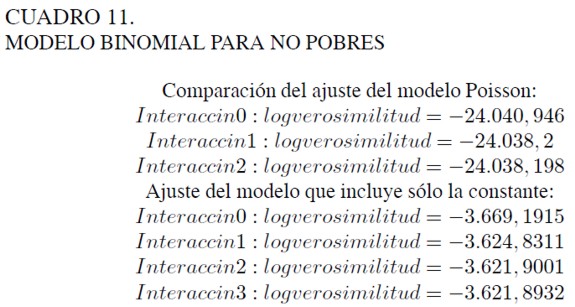

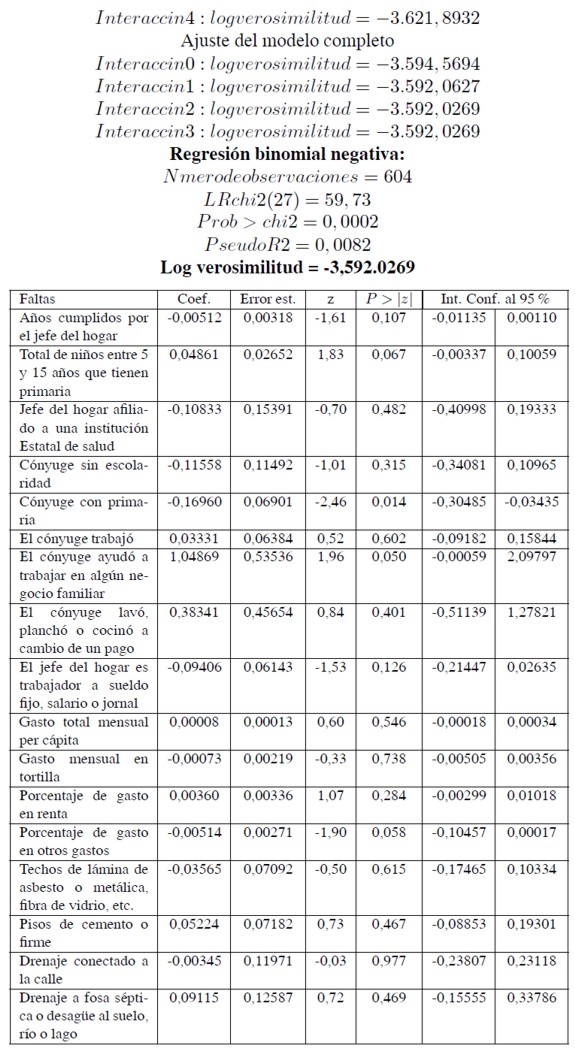

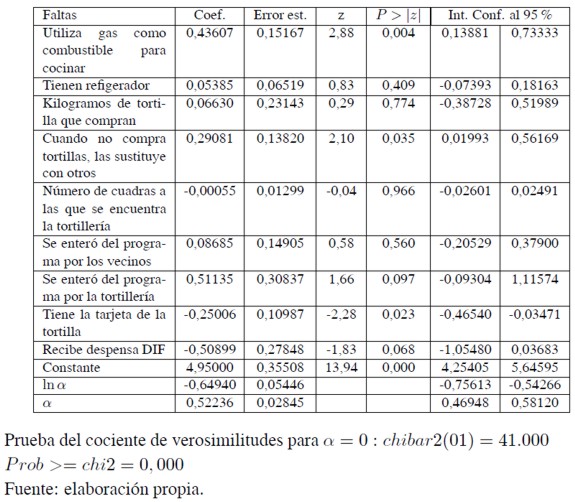

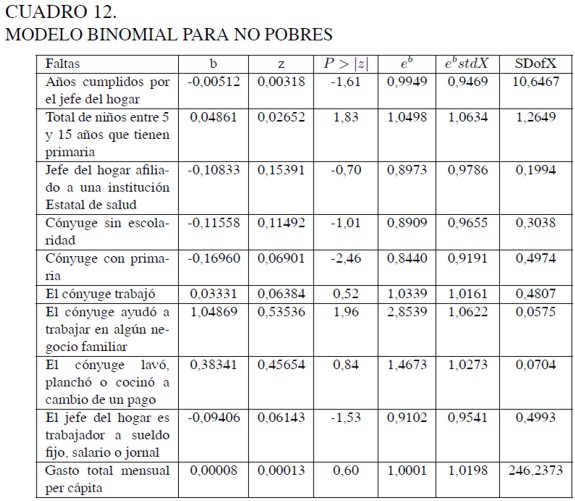

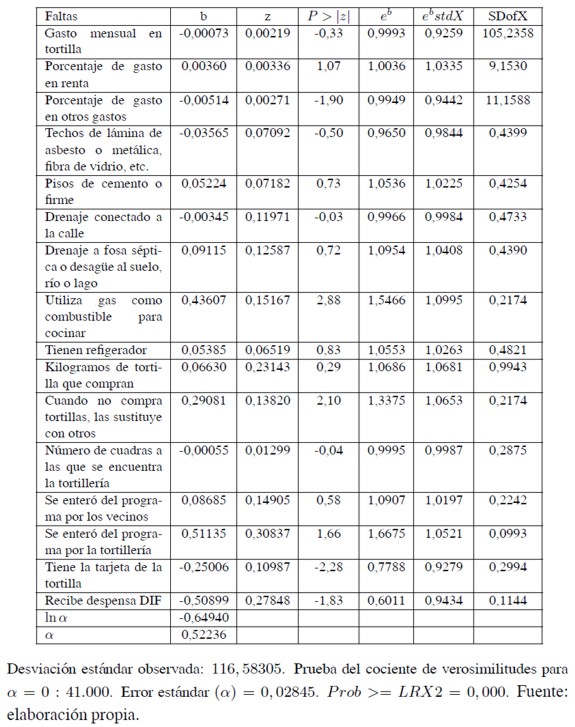

De los 570 días que deberían haber recogido su kilogramo, la media de asistencia fue 437 días. Los resultados del análisis se presentan en los cuadros 7 a 1215. La variable dependiente es la media de faltas en el periodo. En los cuadros 7 y 8 se observa que, por ejemplo, tener hijos entre 5 y 15 años de edad aumenta la probabilidad de inasistencia en casi 4%. Sin embargo, cuando el cónyuge ayuda a trabajar al jefe del hogar, la probabilidad de inasistencia es de casi 62% y si el cónyuge realizó actividades del hogar por pago (lavar, cocinar, planchar) la probabilidad de inasistencia es de 51%.

Las variables que tienen un efecto positivo sobre la asistencia son la disponibilidad de tarjeta (25%), si recibe la despensa del DIF (Desarrollo Integral de la Familia) (23%) y si es pobre (12%)16.

En los cuadros 8, 10 y 12 se presentan los resultados considerando el hecho de si los hogares se encuentran debajo de la línea de pobreza o no. Se aprecia que, en general, son las variables asociadas con pobreza las que aumentan la probabilidad de una mayor asistencia. La separación de la muestra permite también un mejor ajuste.

En el Cuadro 8 (que presenta los resultados para toda la muestra sin dividir entre hogares pobres y no pobres) se encuentra que ser pobre reduce el número esperado de inasistencias en un factor de 0, 36; es decir, que ser pobre reduce el número esperado de faltas en casi 13%. Por otra parte, tener tarjeta reduce el número esperado de inasistencias en casi 25%, en realidad esta es la variable que más reduce el número esperado de inasistencias. Si el jefe del hogar está afiliado a una institución estatal de salud y si recibe despensa del DIF reduce el número esperado de inasistencias en 16,5% y 18,6% respectivamente. Si el jefe del hogar trabajó por salario entonces el número esperado de inasistencias se reduce en 11%.

Entre las variables que más aumentan el número esperado de inasistencias se encuentran las relacionadas con que el cónyuge tenga que trabajar fuera del hogar. La variable que más afecta el número esperado de inasistencias es que el cónyuge trabaje en un negocio familiar, reflejado en un incremento de casi 54%. Si el cónyuge lavó, planchó o cocinó a cambio de un pago, entonces aumenta el número esperado de inasistencias en 49,5%. Si el cónyuge trabajó (de manera regular) el número esperado de inasistencias aumenta en 10%. Pereciera que las inasistencias están relacionadas con "emergencias" económicas de los hogares. Siempre que falte ingreso y el cónyuge tenga que trabajar se afectará el patrón de asistencia de los beneficiarios del programa.

Existen otras dos variables que aumentan el número esperado de inasistencias y que están relacionadas con la capacidad de substituir tortilla por otro bien o el hecho de comprar más de un kilogramo de tortilla. En este último caso se incrementa el número esperado de inasistencias en 42,5%, y en el primero en 23%.

Estos resultados muestran que existían por lo menos dos grandes grupos de beneficiarios. El de los pobres del programa que ante modificaciones inesperadas en su ingreso familiar tienen que realizar actividades que les impiden recoger su kilogramo de tortilla. El otro grupo estaba integrado por los hogares beneficiados que no eran pobres17 y que tenían más capacidad para adquirir ya sea más kilos de tortilla o podían sustituir su consumo por algún otro bien.

La información obtenida obligaba a realizar un estudio más profundo, porque ponía en tela de juicio los resultados positivos encontrados con la evaluación de impacto. El programa presentaba dos grandes problemas: uno el relacionado con su diseño, ya que el acudir a recoger el kilogramo dependía de que algún miembro de la familia tuviera el tiempo disponible. Segundo, al parecer había una cantidad importante de hogares que carecían de la credencial que les acreditaba como beneficiarios del programa y que según los análisis podría reducir la inasistencia en 25%.

Sumado a lo anterior, la existencia de evidencia que mostraba problemas en la administración del padrón de beneficiarios, lleva a considerar la necesidad y la conveniencia de un rediseño del programa.

CONCLUSIONES

En México la evaluación de los programas y políticas de gobierno está plenamente institucionalizada. La LGDS, su Ley Reglamentaria, la creación de CONEVAL y el Decreto que regula su funcionamiento son el sustento jurídico, fiscal e institucional que la respaldan. CONEVAL ha homogeneizado los distintos programas con RO, y por tanto, sujetos de evaluación. También ha definido distintos tipos de evaluación, entre los que se encuentra la de proceso.

Por diferentes razones, y no hay crítica en ello, se ha enfatizado la evaluación de impacto; solamente hasta el año 2009 se han efectuado cinco evaluaciones de este tipo. Sin embargo, existen dos problemas básicos para llevarlas a cabo: la falta de antecedentes y experiencias, y la aplicación exclusiva de métodos cualitativos como los grupos de enfoque y entrevistas a profundidad.

La evaluación de proceso es un elemento fundamental para identificar fallas en la operación del programa. Los resultados obtenidos apoyan la conveniencia de integrar este tipo de evaluaciones dentro de un programa institucional de evaluación.

En el artículo se ha presentado un ejemplo de evaluación de proceso usando una variante del estudio de caso. Mediante el uso de la regresión de Poisson se analizaron los patrones de asistencia de los beneficiarios del Programa Tortilla.

De acuerdo con la evidencia presentada, el programa debía haber atendido el problema de inasistencia, en primer lugar, porque afectaba a los beneficiarios más pobres. La evidencia sugería le necesidad de revisar el diseño del Programa.

Se encontró que los hogares relativamente más pobres daban una mayor valoración a un ingreso adicional que al beneficio generado por un kilogramo gratis de tortilla. Por su parte, los hogares con ingreso más elevado tenían mayor disponibilidad a faltar a recoger su beneficio.

Una posible falla en el proceso de administración del programa se presenta en los resultados, y ésta se relaciona con la falta de la credencial que acreditaba el derecho y controlaba el retiro del kilogramo de tortilla. Un porcentaje elevado de inasistencias podría ser el resultado de dificultades en su reposición.

De esta manera, la evaluación de proceso mediante información administrativa sugiere tres puntos críticos del Programa Tortilla. Uno era la focalización, el segundo su diseño y tercero la administración con respecto a la reposición de la credencial.

El Programa, a pesar de que no se diseñó para que fuera evaluado, a lo largo se sus diferentes etapas de reestructuraciónïncorporó mecanismos que permitieron su evaluación. Un elemento adicional en el proceso de institucionalización de la evaluación es precisamente, que el diseño de los programas de desarrollo social se haga con el fin de que sean evaluados. En caso contrario la evaluación puede ser incluso una actividad innecesaria.

En este sentido es probable que las acciones emprendidas por el CONEVAL para homogeneizar, primero el diseño de programas y segundo su evaluación, puedan resultar en una mayor efectividad de la política social. La evaluación de proceso es un elemento fundamental en esta actividad; sin embargo, es importante destacar que no todos los programas generan información adecuada para realizar la evaluación de proceso.

En el futuro, quizás el CONEVAL también tenga que emprender acciones encaminadas a que las diferentes entidades responsables de los programas, generen y sistematicen la información requerida para llevar a cabo la evaluación de proceso.

NOTAS AL PIE

1 Para los fines de este trabajo se entiende por institucionalización de las acciones de evaluación y seguimiento de programas de gobierno la creación de un sistema que promueva y fomente esas funciones mediante el apoyo jurídico, legal y presupuestal que garantice su práctica. La institucionalización de la evaluación y seguimiento es una de las condiciones para que un gobierno democrático funcione como tal.

2 El Programa se llamó PROBECAT dese 1984 hasta 2000; a partir de 2001 se reestructuró y su nombre cambió a BÉCATE.

3 No se mencionará en este documento los problemas jurídicos que existen en relación con este cuerpo legal.

4 Esta afirmación no significa que las técnicas cuantitativas sean superiores a las cualitativas; son complementarias y su elección depende de las circunstancia.

5 Conviene aclarar que no se discutirán dos temas que son de interés respecto al programa. Uno se relaciona con las razones por las cuales se eliminó completamente el programa. El segundo tema es el relacionado con el propio diseño, y la eficiencia de las transferencias en especie respecto a las transferencias en efectivo.

6 Los apartados 3 a 5 constituyen un ejemplo de la evaluación de proceso con base en información proveniente de registros administrativos.

7 Seguimiento y Evaluación (nota del autor).

8 Además de las políticas de superación de la pobreza (educación, salud, alimentación, generación de empleo e ingreso, autoempleo y capacitación), se incluyen políticas de seguridad social y asistencial; desarrollo regional; infraestructura social básica y fomento al sector social de la economía. Es decir, considera políticas de bienestar social, y sobre todo de fomento económico.

9 Junto con estas carencias se encuentra la falta de personal capacitado.

10 En Chile, por ejemplo, donde también la institucionalización de la evaluación se basó en una secretaría poderosa, fue del Ministerio de Hacienda el punto de partida de la fuerza institucional.

11 La Secretaría de la Contraloría (hoy Secretaría de la Función Pública), que inicialmente tenía la responsabilidad administrativa de organizar y supervisar las evaluaciones de programas sujetos a RO, carecía tanto de la fuerza, como del reconocimiento técnico necesario para llevar a cabo esas funciones.

12 Incluso se intentó extender la evaluación hacia todas las acciones de gobierno. En 2007, en la iniciativa de presupuesto el ejecutivo propuso que el CONEVAL se convirtiera en el Consejo Nacional de Evaluación de Política Pública. Este intento, finalmente rechazado por la Cámara de diputados, es parte de la administración del presupuesto con base en resultados.

13 Se les denomina resultados potenciales porque ambos son posibles antes de que el individuo tome la decisión de participar o no.

14 Para esta parte se sigue a Greene (2003, 744-745).

15 Los cuadros 7, 9, 11 presentan las pruebas de ajuste del modelo de Poisson comparando con el binomial negativo. Los cuadros 8, 10 y 12 presentan los resultados del modelo binomial negativo.

16 Se estimó una línea de pobreza para todos los beneficiarios de este programa con el propósito de discriminar a quienes fueron incluidos en el padrón y no eran pobres en comparación con quienes sí lo eran. Se calcularon dos líneas: una para pobreza extrema (13,68 pesos diarios) y otra para pobreza moderada (27,59 pesos diarios). Este trabajo fue parte de la evaluación de impacto del Programa Tortilla de 2001.

17 Se trata de pobreza en términos relativos, puesto que en principio todos los beneficiarios del programa eran pobres al encontrarse por debajo de las líneas de pobreza nacionales.

REFERENCIAS IBLIOGRÁFICAS

1. Baccarini, D. (1999). The Logical Framework Method for defining project success. Project Management Journal, 30(4), 25-32. [ Links ]

2. Behrman, J. R. (2007). Policy-Oriented Research Impact Assessment (PORIA) Case Study on The International Food Policy Research Institute (IFPRI) and The Mexican PROGRESA anti-poverty and human resource investment conditional cash transfer program. Impact Assessment Discussion Paper N° 27. Washington, D.C.: IFPRI. [ Links ]

3. Cameron, C.A. y Trivedi, P.K. (1998). Regression analysis of count data. Cambridge: Cambridge University Press. [ Links ]

4. Cameron, C.A. y Trivedi, P.K. (2005). Microeconometrics. Methods and applications. Cambridge: Cambridge University Press. [ Links ]

5. Centro de Estudios Sociales y de Opinión Pública (CESOP) - Cámara de Diputados LIX Legislatura (2004). Los programas de abasto social en México: Abasto social de leche y tortilla. México: CESOP. [ Links ]

6. Consejo Nacional de Evaluación de la Política de Desarrollo Social (2007a). Modelo de términos de referencia para la evaluación de consistencia y resultados. México: CONEVAL. [ Links ]

7. Consejo Nacional de Evaluación de la Política de Desarrollo Social (2007b). Programa anual de evaluación para el ejercicio fiscal 2007 de los Programas Federales de la Administración Pública Federal. México: Secretaría de Hacienda y Crédito Público, Secretaría de la Función Pública y Consejo Nacional de Evaluación de la Política de Desarrollo Social. [ Links ]

8. Consejo Nacional de Evaluación de la Política de Desarrollo Social (2008). Síntesis de las evaluaciones externas 2006 de los programas sociales Federales. México: Secretaría de Hacienda y Crédito Público, Secretaría de la Función Pública y Consejo Nacional de Evaluación de la Política de Desarrollo Social. [ Links ]

9. Cuevas Rodríguez, E. (2000). La experiencia de evaluación de programas de capacitación en México: El caso de PROBECAT. Revista Mexicana del Trabajo y la Previsión Social, 2 (segundo semestre), 131-218. [ Links ]

10. Diario Oficial de la Federación (DOF) (1999). Decreto de presupuesto de la Federación, 1999. México: Poder Ejecutivo Federal, 28 de diciembre. [ Links ]

11. Diario Oficial de la Federación (DOF) (2004). Ley general de desarrollo social. México: Poder Ejecutivo Federal, 20 de enero. [ Links ]

12. Diario Oficial de la Federación (DOF) (2005). Decreto por el que se regula el Consejo Nacional de Evaluación de la Política de Desarrollo Social. México: Poder Ejecutivo Federal, 4 de agosto. [ Links ]

13. Diario Oficial de la Federación (DOF) (2006). Reglamento de la Ley General de Desarrollo Social. México: Poder Ejecutivo Federal, 18 de enero. [ Links ]

14. Diario Oficial de la Federación (DOF) (2007). Lineamientos generales para la evaluación de los Programas Federales de la Administración Pública Federal. México: PoderEjecutivo Federal, 30 de marzo. [ Links ]

15. Gasper, D. (1997). Logical frameworks: A critical assessment. Working Paper 278. The Hague: Institute of Social Studies. [ Links ]

16. Gasper, D. (2000). Evaluating the logical frameworks approach. Towards learning oriented development evaluation. Public Administration and Development, 20(1), 17- 28. [ Links ]

17. Greene, W. (2003). Econometric analysis. Upper Saddle River. New Jersey: Prentice Hall, 5th edition. [ Links ]

18. Grosh, M. E. (1994). Administering targeted social programs in Latin America. From platitudes to practice. Washington, D. C.: The World Bank. [ Links ]

19. Heckman, J.J., Lalonde, R.J. y Smith, J.A. (1999). The economics and econometrics of active labor markets programs. En Orley C. Ashenfelter and David Card (eds.), Handbook of labor economics, vol. 3A. (pp. 1865-2097). Amsterdam: Elsevier Science. [ Links ]

20. Heckman, J. J., Heinrich, C. y Smith, J.A. (2002). The performance of performance standards. Journal of Human Resources, 3(4), 778-811. [ Links ]