Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO -

Similars in Google

Similars in Google

Share

Innovar

Print version ISSN 0121-5051

Innovar vol.25 no.57 Bogotá July/Sep. 2015

Estrategia y Organizaciones

Doi: http://dx.doi.org/10.15446/innovar.v25n57.50325.

Comprensión del concepto de emergencia, desde el aporte de Holland, Kauffman y Andrade

Understanding the Concept of Emergence from the Contributions by Holland, Kauffman and Andrade

Comprendre le concept d'émergence, d'après la contribution de holland, kauffman et andrade

Compreensão do conceito de emergência, a partir da contribuição de holland, kauffaman e andrade

Iván Alonso Montoya RestrepoI, Luz Alexandra Montoya RestrepoII

I Doctor en Ciencias Económicas Universidad Nacional de Colombia Medellín, Colombia, Correo electrónico: iamontoyar@unal.edu.co

II Doctora en Ciencias Económicas Universidad Nacional de Colombia Medellín, Colombia, Correo electrónico: lamontoyar@unal.edu.co

Correspondencia: Carrera 80 No 65-223 - Núcleo Robledo. Medellín, Colombia.

Citación: Montoya Restrepo, I. A., & Montoya Restrepo, L. A. (2015). Comprensión del concepto de emergencia, desde el aporte de Holland, Kauffman y Andrade. Innovar, 25(57), 27-44. Doi: 10.15446/innovar.v25n57.50325. Enlace doi: http://dx.doi.org/10.15446/innovar.v25n57.50325.

Clasificación JEL: L22, M21, B52.

Recibido: mayo 2012, Aprobado: febrero 2015.

Resumen:

Los procesos evolutivos están vinculados con el problema de la emergencia, la cual suele entenderse como una "aparición", que es explicada desde concepciones diferentes. Por una parte, en el programa de investigación de Holland en sistemas complejos adaptables (SCA), la adaptación de los agentes va a generar complejidad y emergencias. En el aporte de Kauffman, se sugiere que la biosfera se fabrica por sí misma, mediante la emergencia y persistente coevolución de agentes autónomos que desempeñan ciclos de trabajo. Finalmente, Andrade propone el papel de la forma como concepto que resuelve polaridades entre información digital y analógica, y el papel del registro y compresión de la información en la emergencia de nuevas posibilidades de organización. Ei presente documento explora estos aportes y presenta una visión conjunta.

Palabras Clave: Evolución, entropía, semiótica.

Abstract

Evolutionary processes are linked to the problem of emergence, which is usually understood as an "occurrence" explained through different conceptions. On the one hand, in Holland's research program about complex adaptive systems (SCA, in spanish), the adaptation of agents will generate complexity and emergencies. According to Kauffman's contributions, it is suggested that the biosphere builds itself through the emergence and the persistent coevolution of autonomous agents that perform work cycles. Finally, Andrade proposes the role of form as a concept that solves polarities between digital and analogical information, and the role of the record and the understanding of information in emergence of new possibilities for organization. This work explores these contributions and presents a joint vision of the three approaches on emergence.

Keywords: Evolution, entropy, semiotics.

Résumé

Les processus évolutifs sont liés au problème de l'émergence, qui est habituellement comprise en tant qu'une «apparition», qui est expliquée à partir de conceptions différentes. D'une part, au sein du programme de recherche de Holland sur les systèmes complexes adaptatifs (CAS), l'adaptation des agents génère la complexité et des émergences. La contribution de Kauffman suggère que la biosphère se construit par elle-même au moyen de l'émergence et de la coévolution persistante d'agents autonomes qui exercent des cycles de travail. Enfin, Andrade propose la forme et son rôle comme le concept qui résout des polarités entre l'information numérique et analogique, aussi que le rôle de l'enregistrement et de la compression de l'information dans l'émergence de nouvelles possibilités d'organisation. Cet article explore ces contributions en y présentant un aperçu d'ensemble.

Mots-clés: Évolution, entropie, sémiotique.

Resumo:

Os processos evolutivos estão vinculados com o problema da emergência, que costuma entender-se como uma "aparição", a qual é explicada a partir de concepções diferentes. Primeiro, no programa de pesquisa de Holland em sistemas complexos adaptáveis (SCA), a adaptação dos agentes vai gerar complexidade e emergências. Na contribuição de Kauffman, sugere-se que a biosfera fabrica-se por si própria, mediante a emergência e persistente coavaliação de agentes autônomos que desempenham ciclos de trabalho. Finalmente, Andrade propõe o papel da forma como conceito que resolve polaridades entre informação digital e analógica e o papel do registro e compreensão da informação na emergência de novas possibilidades de organização. O presente documento explora estas contribuições e apresenta uma visão conjunta.

Palavras-chave: evolução, entropia, semiótica.

Introducción: variedad en el concepto de emergencia

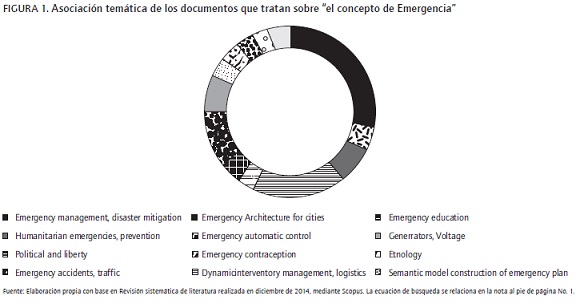

Lo que se entiende por emergencia (Hudson, 2011; Johnson, 2009; Corning, 2002; Addiscott, 2011; Huneman, 2008; Ryan, 2007) puede ser considerado de diversas maneras, y su construcción teórica es un campo novedoso para la elaboración de explicaciones. Al realizar ejercicios de revisión sistemática de la literatura, se encuentran relativamente pocos artículos que discuten el "concepto de emergencia"1. Las temáticas principales en las publicaciones que indagan sobre el concepto de emergencia pueden apreciarse en la Figura 1.

Los documentos encontrados muestran una preocupación por definir conceptualmente la emergencia en cada área específica de conocimiento. También se aprecia una dispersión en los aportes, tanto por investigadores, como por instituciones y países donde se originan, y una intencionalidad instrumental en la elaboración de las mencionadas concepciones. Para algunos de los mismos, la preocupación por lo semántico jugó también un papel relevante. En resumen, un concepto de emergencia, que resulte transversal a las disciplinas científicas, todavía es un espacio fértil para realizar contribuciones, que acojan los debates entre las posibilidades de agenciamientos teóricos entre diferentes disciplinas y que enriquezcan la oportunidad de comprender mejor diversos campos de conocimiento.

Dos concepciones centrales en el concepto de emergencia

En Rodríguez, Torres, Cubillos, Romero y Albis (2004) se sugiere que la teoría de la emergencia puede establecerse desde dos modos diferentes. En el primero, la emergencia (Fromm, 2004) se equipara con el afloramiento de propiedades que se ubican en niveles más altos en una estructura jerarquizada, y que no resultan previsibles desde lo existente en los niveles que están más abajo (con lo cual la emergencia es el resultado de la interacción de elementos en un nivel más bajo que en el que se presenta la propiedad emergente); este es un enfoque ampliamente explicado, que proviene de las aportaciones en biología y teoría de sistemas, en que además participan investigadores tan prestigiosos como Francisco Varela, y es el enfoque que mejor se corresponde con las aportaciones en modelamiento propuestas por John Holland (2004, 2008, 2010), en donde se aprecia que la emergencia y la consiguiente complejidad es resultado de adaptaciones. El segundo enfoque hace referencia a que, dada la existencia de propiedades más simples y formas de organización ya existentes, una teoría de la emergencia alude a las explicaciones sobre el avance creativo de la naturaleza, dando lugar a estructuras y características más complejas y nuevas. A este último enfoque es al que apunta principalmente Stuart Kauffman (2003, 1993, 1995), quien sugiere que el problema de la emergencia está relacionado con una especial cualidad que es producto de la organización, inseparable de un sistema considerado como un todo y que puede presentarse a nivel global del sistema y ocasionalmente en los componentes. Para el autor, hablar de emergencia implica una novedad con relación a las propiedades de los componentes considerados de manera aislada u organizados en una configuración diferente. La emergencia proviene de la interacción y conexión de componentes, origina una novedad en el sistema considerado como un todo y retroactúa sobre las partes. Así considerada, la emergencia es un producto de la organización del sistema, y resulta una novedad indisociable de la unidad global (Morin, 1996; Rodríguez et al., 2004). Esta diferenciación, aunque parece sutil, es relevante, puesto que Maldonado (2004) indica que:

El estudio de la emergencia se sitúa en las relaciones entre las partes de un sistema y el sistema como un todo, esto es, en un nivel meso. La importancia de determinar este nivel consiste en que es en él en donde se cruzan los niveles o escalas micro y macro (p. 7).

Además, aclara Maldonado, citando a Bar-Yam, que:

De un lado, existe una complejidad emergente, la cual consiste en un sistema -dinámico-, compuesto por partes simples en el que el comportamiento colectivo es complejo. En contraste, de otra parte, puede decirse que un sistema puede ser caracterizado como de simplicidad emergente cuando está compuesto por partes complejas cuyo comportamiento colectivo es simple. En este último caso, el sistema colectivo posee un comportamiento en una escala diferente que el de sus partes (Bar-Yam, 1997: 5) (p.7).

Concluye Maldonado que se puede entonces diferenciar entre una emergencia local, en la que el comportamiento colectivo se puede apreciar en niveles pequeños del sistema, y una emergencia global, que hace parte del sistema como un todo (Maldonado, 2004).

La indagación de los autores sobre el concepto de emergencia ha conducido a identificar tres aportaciones centrales realizadas por parte de Holland, Kauffman y Andrade. A continuación se presentan aspectos que confluyen en la dificultad para concebir dicho concepto.

Problemática en la elaboración del concepto

El papel de agentes en la generación de emergencia

Kurz (2008) muestra el problema de la emergencia proveniente de innovaciones en un modelo de dos sectores de la economía. El autor discute el problema de las innovaciones y los beneficios desde un enfoque Schumpeteriano de destrucción creativa, empleando herramientas analíticas modernas. Asimismo, Kurz retoma el concepto de "flujo circular" y lo formaliza para explorar la suposición de "beneficio cero y beneficios transicionales", propuesta por Schumpeter (Schumpeter, 1934). Así, Kurz introduce una tipología de procesos de innovación a través de un modelo de dos sectores, y encuentra que incrementos en la productividad del trabajo llevarán a aumentar los salarios reales. El argumento es generalizado a procesos de innovación en producción de desechos con producción conjunta, de forma que un "mal", que es costoso de disponer adecuadamente, puede convertirse en un "bien" que puede ser mercadeado rentablemente. Este enfoque muestra que variaciones de otros agentes en el entorno en su productividad o innovaciones, incluso cambios insignificantes, pueden terminar en revolucionar por completo el sistema económico y forzar a productores a comprometerse en decisiones y acciones que no habían planeado o anticipado previamente.

Constreñimientos asociados al problema de emergencia y disposiciones organizativas

Rodríguez et al. (2004) llaman la atención sobre los constreñimientos, al sugerir que toda relación organizacional ejerce restricciones en los elementos o partes que le están sometidos, y de esta forma se presentan constreñimientos cuando los elementos componentes no pueden adoptar todos sus estados posibles individuales, debido al ejercicio de la asociación. Los constreñimientos van a ser ejercidos por las partes de manera interdependiente, por las partes sobre el todo, y por el todo sobre las partes (Rodríguez et al., 2004).

Las emergencias y los constreñimientos también pueden producirse por nuevas disposiciones organizacionales como resultado de cambios en las relaciones de los componentes o partes de un sistema. Los cambios pueden ser espontáneos, naturales o inducidos por agentes internos o externos al sistema. Así, la organización es la disposición particular de orden y desorden en un sistema y es fruto de esta disposición donde surge la emergencia o constreñimiento global del sistema. El proceso de inducción por agentes para instituir algo nuevo al sistema se denominará creación (Rodríguez et al., 2004). En Morin (1994), se explica la creación como un producto del aumento de interrelaciones entre ellas y con el medio, y como resultado de procesos auto-organizativos.

Con relación al concepto de emergencia, Kauffman (2003) sugiere que el problema se enfoca en cómo prorrumpen estructuras concretas. El autor piensa que la respuesta radica en la expansión y enfriamiento del universo y en las secuencias asociadas de ruptura de simetrías. Esta expansión, en términos de diversidad molecular y de otras clases, sugiere que el universo y la biosfera han avanzado siempre sistemáticamente hacia lo adyacente posible. En concreto, el programa de investigación de Kauffman se orienta a indagar sobre las razones que originan la emergencia de entidades y el surgimiento de procesos y estructuras en sistemas fuera del equilibrio. En estos sistemas, tales entidades descubren e identifican fuentes de energía, se adaptan a ellas y logran extraer trabajo, y al hacerlo propagan energía generando diversidad en las adyacencias de un universo evolutivo. Como se elaborará en una sección más adelante, Kauffman (2003) va a proponer que, en promedio, "[...] las biosferas y el universo crean novedad y diversidad lo más rápidamente que le es posible, sin destruir la organización propagativa acumulada, la cual constituye el nexo fundamental mediante el que tal novedad es descubierta e incorporada a dicha organización" (p. 124).

La emergencia como complejidad fruto de la adaptación

En Holland (2004), la emergencia va a traducirse, inicialmente, en la aparición de comportamientos complejos a partir de interacciones agregadas de agentes menos complejos. Para ello, el autor encuentra una primera noción hacia la emergencia fundada sobre la existencia de mecanismos para facilitar la interacción selectiva entre agentes. Estos mecanismos van a permitirles a los agentes seleccionar a otros agentes con propósitos de discriminación, especialización y cooperación. Así, se produce para el autor la primera noción de emergencia vinculada con la aparición de meta-agentes y de interrelaciones, vía agregación-interacción, que persisten incluso si sus componentes están cambiando continuamente.

Un segundo camino en el autor hacia la emergencia (Holland, 2004; Pereda y Zamarreño, 2011) sucede cuando los agentes que participan en flujos cíclicos provocan que el sistema retenga sus recursos. Los recursos retenidos pueden ser explotados más adelante, ya que ofrecen nuevos nichos para ser ocupados por nuevas clases de agentes; las partes que promueven la ampliación del reciclaje son las que más proliferan; las partes que no favorecen el reciclaje pierden sus recursos a favor de las que sí lo hacen. Holland (2004) menciona que esta es la forma como opera el mecanismo de selección natural, la cual debe ser entendida en términos de un proceso que conduce al incremento de la diversidad, y como origen de la emergencia, a través del incremento del reciclaje. El autor sugiere que la existencia de ambientes diferentes posibilita el surgimiento de la especialización y que la aparición de nuevos niveles de organización en un proceso evolutivo depende de que cada nuevo nivel pueda recopilar y proteger recursos a un costo inferior al que tiene que pagar por el incremento de la complejidad de su estructura.

Emergencia entendida como surgimiento de la forma

En Andrade (2003), la compresión de información está asociada a la emergencia de nuevos niveles de organización. El autor sugiere que epistemológicamente es necesario insistir en la complementariedad entre las leyes físicas y las mediciones. Además, el autor muestra cómo desde el enfoque mecanicista se trata de evitar esta ruptura epistémica al considerar la información como algo objetivo y cosificado que existe en el mundo físico independientemente de los sistemas observadores. Este punto de vista, dice el autor, facilita la obtención de descripciones físicas de los sistemas sin preocuparse de su funcionalidad y aplicabilidad en los procesos de construcción, medición, predicción y regulación. Pero este modo de utilizar la información, aunque sea consistente con las teorías físicas, no tiene sentido para los sistemas biológicos que han sido seleccionados por su funcionalidad y significación (Andrade, 2003).

Esto quiere decir que la función y el significado no son propiedades íntimas y propias de las estructuras sino que afloran por acción de la selección. Valga decir, que así como la medición requiere un proceso previo de selección por parte del observador, la generación de función y significado biológico también precisan de la selección natural (Andrade, 2002, 2003). El autor continúa aclarando que la formación de registros comprimidos y el flujo entre información analógica del medio y digital va a asociarse a la noción de forma como patrón persistente, y que juega un papel importante en la emergencia de nuevas interacciones y patrones. Además, propone que la forma cuenta como unidad básica de procesamiento de información, en cuanto posee una naturaleza tríadica semiótica que incluye tanto los componentes de información digital y analógica, como la actividad intrínseca del proceso de conversión. Esta conversión, centrada en el papel de la forma, que puede ser entendida como un patrón y una actividad originados en un sistema material, y que implícitamente refiera cierta inteligibilidad independiente de las experiencias y sensibilidades de mundo experimentado, proporciona una herramienta para entender la emergencia de jerarquías en la naturaleza (Andrade, 2002, 2003).

Andrade (2002) va a explorar cómo emerge la forma mediante la semiótica Peirceana y las nociones de primeridad, segundidad y terceridad. Para ello, reconoce que la forma, desde tal percepción, va a jugar el papel de identidad (segundidad), coherente pero también cambiante, que se mantiene entre la potencialidad e indeterminación (primeridad), y la actualidad y determinación (terceridad). Para el autor, la forma va a mediar entre la energía y la materia a través de la codificación (Andrade, 2002). Por su parte, desde que la producción de entropía está mediada por la información, también va a darse un flujo en dirección contraria. El proceso cíclico alrededor de la forma presenta dos momentos en la disipación de entropía, uno a partir de la forma hacia información digitalmente registrada y codificada (como en la filogenia), y el contrario que inicia en información digital codificada y termina en la forma (ontogenia)2 (Andrade, 2002).

El autor señala, por demás, que no puede entenderse la información digitalmente registrada sin hacer referencia a la red completa de interacciones que es característica de la forma. Andrade propone que los patrones organizacionales están presentes en la idea de forma y que los cambios en la forma pueden entenderse como codificaciones de información análoga, la cual podrá ser empleada, especialmente como condicionamiento para la codificación de información digital, en la realización de los procesos de selección (Andrade, 2002).

Con este marco, y en cuanto a emergencia se refiere, Andrade comenta cómo la mayoría de las teorías jerárquicas acepta que niveles pueden emerger por encima de niveles más bajos adyacentes. Aunque esto es parcialmente cierto para Andrade, el autor recuerda que el nivel ecológico (análogo) está siempre presente, dada la continuidad creada por las interacciones entre unidades existentes. Tal nivel no resulta estático y está en permanente proceso de "formación", incluyendo entidades recién "emergidas" de niveles más bajos. Andrade reconoce como condicionamientos para la emergencia de un nuevo nivel que haya una saturación en el espacio de conformaciones (shapes) que corresponden a un espacio de información análoga, en el nivel adyacente más bajo, y que haya un decrecimiento de información mutua entre registros digitales y análogos en el nivel previo, así la presencia de un nuevo nivel emergente es requerido para preservar la cohesión del sistema (Andrade, 2002, 2003).

Finalmente, Andrade (2002) menciona que cada nivel de organización, así concebido, tiene información digital y analógica. Las jerarquías de sistemas análogos en las cuales el componente digital no es evidente, como en las jerarquías ecológicas, deben poseer una contraparte digital que es realizada aparentemente cuando la dimensión temporal es considerada. La secuencia de eventos a lo largo del ciclo de transformaciones puede llevarse a una representación digital en tanto los símbolos sean definidos. Para el autor, la entropía disipada hacia afuera por los niveles más bajos se convierte en entropía internamente disipada por los niveles de mayor orden, de forma que la producción de entropía interna por el sistema de mayor orden también resulta de su comportamiento y dinámica.

La emergencia en el enfoque evolutivo de Holland y los sistemas complejos adaptables

Holland (2004) se enfoca sobre el problema de la adaptación en sistemas complejos adaptables (SCA), lo que conduce a la aparición de comportamientos complejos en dichos sistemas. El autor sostiene que los sistemas cambian o se adaptan pero preservan una sorprendente coherencia. Estos sistemas exhiben un agregado de identidad "emergente" -lo cual alude al tema de la forma explicado anteriormente gracias a las investigaciones de Andrade-, que aprende rápidamente y con gran facilidad, y cuyo comportamiento depende de una profusa cantidad de interacciones, modificadas por los cambios aprendidos, que produce una habilidad única de todo el sistema para anticiparse a las consecuencias de sus acciones por medio de la modelación (la capacidad de hacer un modelo mental) de sus mundos, o modelos internos, basados en la experiencia.

Holland asocia la coherencia bajo acoso y la persistencia de cada sistema (y de allí su denominación como sistema adaptable) a la existencia de una gran cantidad de interacciones, la agregación de diversos elementos y la adaptación o el aprendizaje (Holland, 2004).

Lara (2008a, 2008b) explica el discurso elaborado por Gell-Mann (1995) para describir la evolución del proceso cognitivo en el cual se da el procesamiento de información por parte del agente. Según Lara (2008) el ciclo de procesamiento inicia cuando el agente percibe regularidades, a partir de datos previos, que luego sintetiza en un esquema o modelo interno. Así, la existencia de estos esquemas permite al agente realizar un aprendizaje ex-ante, y anticipar consecuencias de su interacción con el entorno, que le permitan elegir la mejor forma de interacción como posible alternativa.

Siguiendo a Holland (2004), en la formación de modelos internos, se encuentra que es más fácil descubrir y probar una regla general que una específica. La acumulación de experiencias permite que los modelos internos sean modificados por la agregación de reglas de excepción, las cuales interactuarán con las reglas genéricas. Holland denomina al fruto de esta interacción como modelo de jerarquía por omisión. Así, se puede formular que la jerarquía por omisión se expande a través del tiempo desde lo genérico hacia excepciones específicas (Holland, 1989, 2004).

Uso de esquemas

Por otra parte, Holland plantea la pregunta sobre cómo puede abordarse el tema de sintaxis de "paquetes de aprendizaje" que permitan al agente descomponer escenas complejas en bloques, al igual que se hace en los juegos de construcción para niños con fichas estandarizadas plásticas. La idea de bloques de construcción le resulta particularmente útil a Holland, pues le permitirá sugerir que la innovación es resultado de una combinación particular de bloques bien conocidos. Para llegar a estos bloques, mediante el empleo de reglas, Holland (2004) acude a la sintaxis de reglas ya empleadas, de manera que se puedan aprovechar valores en sus posiciones dentro de la secuencia (que constituye la regla), como posibles bloques de construcción, a la manera de una metáfora sobre cómo los genes individuales se articulan dentro de la estructura cromosómica. Existen dos importantes dificultades en relación con esta posición. En primer lugar, un alelo dado puede tener diferentes efectos en diferentes ambientes. Pero además, Holland recupera parte de la discusión de Kauffman (1993) según la cual los alelos inte-ractúan entre sí: ciertos genes particulares afectan muchas características y los efectos de los diferentes genes se traslapan. En síntesis, sostiene Holland, la capacidad para la adaptación a un medio ambiente dado es una función no lineal de los alelos, estos últimos como formas alternativas de los genes (Holland, 2004). Cuando Holland pasa al trabajo con las reglas SI/ENTONCES, la parte condicional de la regla (SI) selecciona automáticamente el medio ambiente en el que esta actuará; así que la evaluación de las partes de la regla procede únicamente en ambientes para los que está diseñada. La segunda dificultad (no li-nealidad) es el principal reto (Holland, 2004).

Dice Holland que la metáfora de la genética puede ser ampliada para que oriente hacia un procedimiento factible para la discusión de la generación de nuevas reglas verosímiles3. Tratándose de los agentes basados en reglas, no es posible disponer de una lista de características que se quieran favorecer para los cruzamientos por medio de la selección de los parentales que exhiben tales características. La única unidad de medida es la fuerza total de cada regla, puesto que los bloques de construcción individuales dentro de la regla no poseen valores individuales. Frente a los bloques de construcción individuales, Holland propone que es necesario explorar la pregunta sobre cómo calificar el valor de los bloques de construcción con algún tipo de especificidad (esquemas) cuando los únicos datos se reducen al tamaño de las fuerzas del conjunto de reglas (Holland, 2004). Además, invoca a Kauffman, y señala que cada esquema podría ser un punto dentro de un paisaje, cuyo promedio correspondiente será la altura del paisaje en ese punto. El objetivo sería localizar las "colinas" que fueran más altas que las otras ya exploradas. En la realidad, los esquemas como los subconjuntos de un espacio de posibilidades forman una complicada retícula de inclusiones e intersecciones. Kauffman (1993) desarrolla versiones de estos paisajes, conocidos como paisajes N-K4, que tienen interconstruidas simetrías que hacen posible el análisis matemático. Holland piensa que el número de esquemas podría resultar muy grande y afirma que no es factible llevar a cabo un cálculo detallado de los promedios del esquema que conducirían a un estudio detallado, y los modelos analíticos complicados solo proporcionan una guía limitada.

El autor va a concluir que la evolución genera y selecciona continuamente bloques de construcción a todos los niveles, y de estos selecciona las combinaciones de bloques mejor establecidos, los cuales se convierten en los bloques de construcción del siguiente nivel superior. La evolución innova continuamente, pero en cada nivel conserva algunos elementos, los cuales son recombinados para producir dichas innovaciones. Cuando es descubierto un nuevo bloque de construcción en cualquiera de los niveles, este generalmente crea una amplia gama de posibilidades debido a su potencial para crear nuevas combinaciones con los demás bloques ya existentes, de lo cual resultan cambios tremendos y sobrevienen avances (Holland, 2004).

Modelamiento de agentes adaptables

Holland ofrece un poderoso método para modelar agentes adaptables (Keymer, Fuentes y Marquet, 2011) y para investigar sus interacciones. El autor sugiere que el primer paso para hacer avanzar una teoría apropiada consiste en hacer una cuidadosa selección de mecanismos y propiedades. Sugiere que pueden estructurarse problemas en términos de flujos de recursos entre diferentes clases de agentes y que puede hacerse un contacto estable con los modelos matemáticos si se plantean dos supuestos simplificadores: 1) los agentes pueden ser útilmente agregados en especies o clases y 2) hay una mezcla rápida de recursos entre los agentes de cada clase. En Holland, en términos generales, y a partir de sus aportaciones en la competencia entre reglas y la conformación de agentes complejos agregados, la emergencia se asemeja con el nacimiento de propiedades en niveles más altos. Existe otra forma de plantear la problemática de la emergencia que corresponde a las investigaciones de Stuart Kauffman.

Las investigaciones de stuart Kauffman

Los aportes de Kauffman en sus libros Origins of Order (1993) y At Home in the Universe (1995) se orientan a evidenciar los procesos de auto-organización en Biología y a mostrar la necesidad de reformular la teoría evolutiva como una fusión de dos fuentes de orden biológico: la auto-organización y la selección. El autor introduce conceptos como relieves adaptativos, avalanchas coevolutivas, inesperados comportamientos ordenados de redes genéticas reguladoras, y modelos sobre el origen de la vida, entre otros. Su aportación confronta la moderna teoría evolutiva, basada en el concepto darwiniano de descendencia con variaciones heredables, que la selección natural tamiza, reteniendo los cambios adaptativos, y que acostumbra a ver la selección como la única fuente de orden en los organismos. Kauffman indica cómo simetrías en las formas también pueden surgir sin el concurso de la selección natural.

Las aportaciones del autor provienen de su observación sobre el hecho que la mayor parte del orden en los organismos es espontáneo y organizado. La auto-organización se entremezcla con la selección natural en formas aún apenas comprendidas para dar lugar a la magnificencia de esta desbordante biosfera. En su crítica a la ortodoxia neodarwinista, Kauffman señala que la teoría evolutiva de Darwin es una teoría de la descendencia con modificación, que no explica la gnosis de las formas, sino cómo se transforman estas una vez han sido generadas, mediante una suerte de gradualismo (Kauffman, 2003). Kauffman aprecia la importancia de la recombinación como un útil procedimiento de búsqueda para una población evolutiva y va a elaborar un discurso que permita explicarse la razón de las formas (Kauffman, 2003).

El autor muestra el concepto de relieve adaptativo como eficacias medidas de genotipos en un espacio N dimensional que incluye el conjunto de los miembros de una especie posibles con genotipo diferente. En los relieves adaptativos, la mutación, recombinación y selección pueden conjuntarse para llevar las poblaciones evolutivas hacia picos de alta eficacia y, según el autor, resulta fácil demostrar que la recombinación es un procedimiento de exploración útil tan solo en los relieves adaptativos suaves. Así, la suavidad de un relieve puede ser definida matemáticamente por una función de correlación que da la similitud de las eficacias o alturas, entre dos puntos del relieve separados por una distancia mutacional dada (Kauffman, 2003). Asimismo, Kauffman aprecia cómo, de alguna forma, la evolución ha producido el tipo de relieves suaves sobre los cuales la recombinación funciona.

Macready y Wolpert, citados por Kauffman, elaboraron un teorema que dice que, como promedio sobre todos los relieves adaptativos posibles, ningún procedimiento de búsqueda aventaja a cualquier otro. Kauffman argumenta que el teorema es cierto. En ausencia de todo condicionante o conocimiento sobre el relieve adaptativo, cualquier método de exploración, como media, es igual de correcto (o incorrecto). Desde este punto en la argumentación, el autor empieza a apreciar que, si la mutación, recombinación y la selección solo trabajan bien sobre ciertas clases de relieves, la mayoría de los organismos son sexuados -es decir, usan la recombinación-, y todos los organismos usan la mutación como mecanismo de búsqueda, entonces tiene sentido preguntarse de dónde vienen esos relieves adaptativos tan adecuados y suaves (Kauffman, 1993, 2003).

Esta pregunta origina el programa de trabajo de Investigations (Kauffman, 2003). La respuesta, considera el autor, está asociada al nicho de un organismo, entendido como la forma en que este se gana la vida. Las formas de ganarse la vida, los juegos naturales, hábilmente encontrados y perfeccionados por las estrategias de búsqueda evolutiva de los organismos -es decir, mutación y recombinación- constituyen precisamente los nichos que las poblaciones de organismos en proceso de especiación y diversificación serán capaces de ocupar y dominar. Las formas de ganarse la vida que presenten relieves adaptativos del tipo de los que pueden ser explorados mediante los procedimientos de que disponen los organismos serán, obviamente, las que perdurarán como tales (Kauffman, 2003). De este modo, los organismos, sus nichos y los procedimientos de búsqueda se construyen unos a otros, conjunta y autoconsistentemente.

Su argumentación a favor de la coevolución conducirá a su proposición central en Investigations, asociada con que la biosfera se fabrica a sí misma mediante la emergencia y persistente coevolución de los agentes autónomos.

Investigaciones

En su libro Investigations, el autor conceptualiza sobre los agentes autónomos y su coevolución. Para el autor, un agente autónomo es un sistema autorreproductor capaz de desarrollar al menos un ciclo de trabajo termodinámico (Kauffman, 2003). El concepto que involucra es el de ciclos de trabajo, el cual es utilizado para elaborar condicionantes a la liberación de energía, lo cual se constituye en un nuevo trabajo. Dice Kauffman: "Es un círculo virtuoso: el trabajo produce restricciones, aunque se requieren precisamente restricciones a la liberación de energía para obtener trabajo" (2003, p.21).

La idea de agentes y ciclos de trabajo conduce a Kauffman a preguntarse sobre la relación entre emergencia de condicionantes en el universo y en la biosfera y la diversificación de los patrones de liberación controlada de energía, que constituyen trabajo y el uso de ese trabajo para construir nuevas restricciones de la liberación de energía. Kauffman encuentra que un elemento central en su argumentación va a ser la imagen del demonio de Maxwell, "diablo" que mediante la realización de medidas sobre un sistema permite que la información que sea obtenida pueda ser empleada para extraer trabajo. Así, "[...] lo que sucede en la biosfera es que agentes autónomos construyen y propagan conjuntamente organizaciones de trabajo, de elaboración de restricciones y subsiguiente obtención de trabajo, que proliferan y se difunden, diversificando a su vez la organización" (Kauffman, 2003, p. 22).

Bajo este enfoque, dice el autor, el misterio de la emergencia supone la capacidad de determinar todas las potenciales adaptaciones que podrían surgir en la biosfera, o lo que es lo mismo, preestablecer el espacio de configuraciones de esta (Kauffman, 2003). Kauffman intuye que los agentes autónomos deben estar desplazados del equilibrio termodinámico puesto que los ciclos de trabajo no pueden tener lugar en dicho equilibrio. Por ello el concepto de agente autónomo es inherente a un concepto de no equilibrio, y ello lo deja por fuera de la respuesta de Schrõdinger (1992) sobre su conceptualización de lo que es la vida, a manera de una secuencia aperiódica de bases y como una materialización de un sólido aperiódico caracterizado por un microcódigo, cuya simetría hace que la arbitrariedad de la secuencia sea consistente con el mecanismo de replicación de moldes (Kauffman, 2003).

A medida que los agentes autónomos construyen conjuntamente una biosfera, cada uno es capaz de clasificar y actuar sobre el mundo en su propio beneficio. Los agentes autónomos coevolucionan en el sentido de efectuar la máxima diversidad de discriminaciones fiables sobre las que basan sus actos. Las comunidades de agentes coevolucionarán hacia una "frontera del caos" entre los comportamientos superrígido y superfluido. Por otra parte, los agentes autónomos avanzan continuamente hacia la novedad; este avance hacia la novedad se formalizará mediante el concepto matemático de lo "adyacente posible", persistentemente explorado por un universo que jamás podría fabricar todas las secuencias de proteínas posibles, todas las especies bacterianas posibles o todos los sistemas legales posibles (Kauffman, 2003).

Puede que, en promedio, las biosferas alcancen lo adyacente posible tan rápido como sea sostenible, y de igual modo actuarían quizá las econosferas. La supuesta cuarta ley de la termodinámica para tales sistemas autoconstructivos diría, de acuerdo con Kauffman, que estos tienden a maximizar su dimensionalidad, el número de clases de eventos que pueden tener lugar a continuación. Este enfoque basado en coevolución de agentes autónomos conduce a una nueva visión sobre el origen de la vida, basada en conjuntos de moléculas colectivamente autocatalíticos y no en la replicación de moldes por sí misma; la emergencia de esos conjuntos no es improbable para el autor, sino que se convierte en casi segura en redes de reacciones químicas de suficiente diversidad. Así, la vida es una propiedad emergente y esperada de las redes complejas de reacciones químicas, bajo condiciones bastante generales, y a medida que se incrementa la diversidad de las especies moleculares en un sistema reactivo, se alcanza un umbral más allá del cual la formación de conjuntos de moléculas colectivamente autocatalíticos5 es casi inevitable (Kauffman, 2003).

Agentes autónomos de Kauffman

Para Kauffman, el agente autónomo ha de ser un sistema termodinámico abierto impulsado por fuentes externas de materia y energía que mantenga al sistema fuera del equilibrio. Kauffman sugiere que estos agentes enlazan procesos espontáneos y no espontáneos mediante complejas redes de interacciones que dan por resultado la reproducción y los persistentes ciclos de trabajo con los que actúan sobre el mundo. El agente autónomo molecular es un sistema dotado de dos características fundamentales de los sistemas vivos: autorreproducción y metabolismo. El segundo punto a resaltar es que este agente autónomo es necesariamente un sistema fuera de equilibrio; la tercera característica es el ciclo de trabajo llevado a cabo por el agente autónomo; un cuarto punto es que, como la máquina de Carnot o los motores de vapor, gasolina o eléctricos, el agente autónomo ejecuta un ciclo. Al concluir dicho ciclo el sistema está listo para iniciarlo de nuevo. Se alcanza una organización repetitiva del proceso. Visto de otra manera, el construir un agente autónomo, dotado de un sistema catalítico acoplado a un ciclo de trabajo, supone una ventaja selectiva respecto a un sistema autoca-talítico exergónico simple (Kauffman, 2003; Paulo, Nelson y Vrba, 2011).

La principal conclusión a extraer es que los agentes autónomos que acoplan ciclos autocatalíticos y de trabajo constituyen una forma totalmente plausible de redes de reacciones químicas abiertas y fuera de equilibrio. Para entender el funcionamiento del agente autónomo es necesario reexaminar el concepto físico de trabajo en el contexto de los ciclos de trabajo, en el sentido de entenderlo como una liberación restringida de energía. Las propias restricciones a esa liberación de energía, esenciales para que el trabajo se produzca, son los equivalentes de las ruedas y bielas de una máquina ordinaria. Se requiere normalmente trabajo para construir las restricciones a la liberación de energía que hacen que el trabajo se obtenga. La organización coherente en la construcción de conjuntos de restricciones a la liberación de energía para obtener trabajo, el cual a su vez es empleado en la creación de nuevos condicionantes en la extracción de energía (cuyo resultado es la obtención de una copia del agente mismo), es un concepto nuevo de cuya adecuada formulación se derivará el genuino concepto de organización (Kauffman, 2003).

Organización propagativa

El cierre catalítico y los ciclos de trabajo mediante los que un agente autónomo fabrica una copia de sí mismo, enlazando hábilmente procesos exergónicos y endergónicos, son hechos perfectamente observables para el autor. Para reconocer la "organización propagativa", Kauffman argumentará que un sistema solo es útil en condiciones fuera de equilibrio y tendrá en mente la imagen del demonio de Maxwell. En esta clase de condiciones, la medida puede ser almacenada y empleada para extraer trabajo del sistema medido. El demonio de Maxwell (Viau y Moro, 2010; Parrondo y Horowitz, 2011) es el lugar de la física donde más claramente se dan cita la materia, la energía y la información. Aun así, su actuación es incompleta. En efecto, solo algunas de las características medibles en un sistema fuera del equilibrio revelan desplazamientos respecto a dicho equilibrio a partir de los cuales es posible, en principio, extraer trabajo. Otras, aunque sean medidas, resultan útiles para detectar tales fuentes de energía. Por ello es fundamental determinar las características que debe medir el demonio, precisar cómo distingue entre las útiles de las inútiles y cómo, una vez medidas, se crean los acoplamientos que llevan a cabo en la práctica la extracción del trabajo (Kauffman, 2003). El autor señala que el trabajo es una liberación restringida de energía en el marco de un número reducido de grados de libertad. En la mayoría de los casos se requiere de trabajo para crear las propias restricciones.

Emergencia de estructuras

Parte de la respuesta de Kauffman (2003) a la emergencia de estructuras concretas radica en la expansión y enfriamiento del universo y en las secuencias asociadas de ruptura de simetrías. En términos de diversidad molecular y de otras clases, el universo y la biosfera han avanzado siempre, sistemáticamente, hacia lo adyacente posible. El autor quiere encontrar un modo de razonar sobre la emergencia de entidades que miden y descubren fuentes de energía en sistemas fuera de equilibrio y sobre la aparición de estructuras y procesos que se acoplan a tales fuentes, que extraen trabajo para elaborar restricciones y propagan esa energía liberada bajo control, haciendo que surjan estructuras, restricciones y procesos más diversos aun en lo adyacente posible, en un universo evolutivo (Kauffman, 2003).

El autor piensa que, cuanto mayor sea la diversidad de las estructuras, potenciales reacciones, transformaciones estructurales, procesos y dispositivos de medida, entes interconectados y restricciones de partida para crear una red ramificada de estructuras propagativas, reacciones, trabajo, medidas, restricciones y construcción de acoplamientos, será más fácil para el sistema en su conjunto generar nuevas clases de moléculas u otras estructuras, sin destruir la organización propagativa acumulada (Kauffman, 2003).

El demonio de Maxwell

El macroestado de equilibrio es un conjunto de mi-croestados que tienen en común el hecho de que las partículas -por decir de un gas- estén casi uniformemente distribuidas en el recipiente y que sus velocidades presenten una distribución típica del equilibrio que el propio Maxwell (Collier, 1990; Binder y Danchin, 2011) caracterizó. Ese macroestado de equilibrio posee dos importantes propiedades, a saber, que la inmensa mayoría de los mi-croestados del sistema forman parte del macroestado de equilibrio y que bastan unas pocas características macroscópicas -temperatura, presión y volumen- para especificar el macroestado de equilibrio6 (Kauffman, 2003).

Una curiosa circunstancia de la física consiste en que los experimentadores, que teóricamente se hallan fuera del "sistema", ocupen su tiempo en preparar intencionadamente los experimentos y en llevar los sistemas cuánticos al estado deseado. Epistemológicamente hablando, Kauffman se pregunta si no sería plausible una teoría unitaria en la cual los experimentadores mismos, agentes autónomos, formaran parte del experimento.

Szilard en 1929 presentó como aportación el cálculo que enlazaba, por primera vez, la entropía y el recién nacido concepto de información (Szilard, 1929, citado en Andrade, 2003). La entropía de un sistema es una medida de su desorden. Por otra parte, todo macroestado tiene también una probabilidad de ser "ocupado" por el sistema. Si se multiplica el logaritmo del número de microestados que componen un macroestado por dicha probabilidad y se adiciona el resultado obtenido para todos los macroestados del sistema, se obtiene la entropía total de ese sistema (Nicolis y Prigogine, 1989; Kauffman, 2003; Andrade, 2003).

Estadísticamente, la entropía de un sistema a lo largo del tiempo o bien se incrementa o permanece constante. En el equilibrio la entropía es constante. Szilard razonó por primera vez sobre concepto de información de Shannon y Weaver (Shannon y Weaver, 1949). Estos autores jerarquizan los problemas de comunicación en tres niveles, de acuerdo con diversas finalidades del acto comunicativo: 1) un problema técnico relacionado con la precisión, 2) un problema semántico vinculado con la significación y 3) un problema de efectividad, sobre el impacto en la conducta del significado. La idea de información se le debe a Shannon y Weaver (1949), quienes sugirieron que la in -formación, de manera mínima, podía enviarse en forma binaria, y sugirieron la entropía de una fuente al enviar una presunta señal, como el conjunto de todos los mensajes posibles, ponderado cada uno con la probabilidad de que fuera realmente transmitido. La recepción del mensaje suponía reducir la entropía o la incertidumbre de los potenciales mensajes frente al que haya sido enviado en realidad. (Shannon y Weaver, 1949; Kauffman, 2003). En cuanto al conjunto de mensajes, cada uno de los cuales se puede imaginar ocupando un volumen en el espacio de mensajes posibles, Shannon y Weaver tomaron el logaritmo del vo -lumen ocupado por un mensaje en el espacio de mensajes posibles. Shannon definió la información como entropía, o como la incertidumbre del observador con respecto al número de mensajes posibles que pueden ser emitidos por una fuente determinada. La información es independiente del significado o efecto que produce el sistema que procesa la información. Así, la entropía es una medida de información, para caracterizar distribuciones estadísticas. La entropía es una magnitud extensiva que representa una propiedad de tamaño, pero no representada directamente por el número de combinaciones posibles o microestados, sino por el logaritmo de este número (Andrade, 2003).

Szilard observó que, cuando el demonio dejaba pasar una partícula de gas más caliente o más frío a la cámara derecha o izquierda, respectivamente, la entropía total del sistema se reducía un poco. Entonces, estimó la cantidad de trabajo que debe realizar el demonio para discriminar si la partícula es más rápida o más lenta que la media. Resulta que dicho trabajo, la energía utilizada, iguala a la que cabe extraer cuando se han separado las partículas lentas y rápidas en las dos cámaras. Como el trabajo realizado por el demonio es igual al que se puede extraer más tarde del sistema, el trabajo neto es nulo. Kauffman sugiere que es importante notar que existe un observador implícito en esta discusión sobre la entropía. Un físico diría, por ejemplo, que la entropía de un sistema se debe a nuestra tosca manera de subdividirlo en macroestados aleatoriamente elegidos. Si se tiene más información sobre los estados microscópicos de aquel, una subdivisión más fina, reduciría la entropía desde nuestro punto de vista (Kauffman, 2003).

Zurek concluye que, a medida que el demonio opera, su conocimiento sobre el sistema de gas aumenta, y como consecuencia, la entropía de dicho sistema disminuye. Pero a la vez, al crecer la información que acumula el demonio, la longitud de la descripción más compacta del sistema a que ello equivale también lo hace. De hecho, dicha longitud se incrementa exactamente al mismo ritmo que se reduce la entropía de aquel (Zurek, 1989; Kauffman, 2003). Zurek (1989, 1990) describe un agente semiótico como un sistema colector (gathering) y usuario de información, conocido en la literatura como IGUS7 y concebidos como observadores internos, es decir, como sistemas físicos interesados en la cantidad de trabajo extraíble. Andrade (1999, 2003) ha extendido el concepto a entidades vivientes. Tales agentes semióticos tienen una propensión general a interactuar que puede aproximarse a la idea de un IGUS que hace pruebas de sus alrededores mediante la medición y procesamiento de resultado, lo cual emplea para optimizar la cantidad de trabajo empleable (Andrade, 2003).

Andrade (2003) explica cómo Zurek mostró que la extracción de energía se hace posible solamente a través de la compresión del registro que depende de una codificación eficiente dada por la habilidad del IGUS para percibir su mundo de experiencia en términos de regularidades. Para que un IGUS funcione se requiere de apertura termodinámica, lejanía del equilibrio y memoria. Conforme aumenta la longitud de esa descripción compacta BIT a BIT, su contenido en información también se incrementa. Por cada BIT de reducción en la entropía del sistema obtenido, Zurek sugiere que la suma de entropía del sistema de gas más el conocimiento del observador de ese sistema es constante para el estado de equilibrio. Solo ciertas características de un sistema fuera de equilibrio revelan, una vez medidas, un desplazamiento respecto a dicho equilibrio que es posible emplear efectivamente para extraer trabajo. Otras, en cambio, son inútiles a tal efecto en cualquier sistema dado (Kauffman, 2003). Los registros son estados macroscópicos correlacionados que identifican fuentes de energía de la que es posible extraer trabajo. La mutación, recombinación y selección actualizan los dispositivos de registro respecto a las cambiantes fuentes de energía, oportunidad o peligro (Kauffman, 2003). Las medidas útiles que detectan características de los desplazamientos respecto al equilibrio muestran fuentes de energía capaces de proporcionar posibilidad de realizar trabajo. Esas medidas participan, junto con la emergencia de dispositivos que extraen trabajo, en el crecimiento gradual de la diversidad de las estructuras y procesos de una biosfera. Para Kauffman, ese crecimiento acumulativo es precisamente una de las razones por las cuales el universo es complejo y solo ciertas características de un sistema fuera del equilibrio dado, si son medidas, permiten la detección de fuentes de energía, las cuales podrían ser acopladas a otros procesos específicos que, mediante el trabajo obtenido, propagarían cambios macroscópicos en el universo (Kauffman, 2003). Finalmente, sugiere Kauffman que una biosfera evolutiva se caracterizaría por la emergencia de esa clase de organización autoconstructiva y en diversificación permanente (Kauffman, 2003).

Semántica

Kauffman argumenta que una vez existe un agente autónomo, habrá cierta semántica asociada a la triada semiótica de Peirce, Hartshorne y Weiss (1935): signo, significado, significante, puesto que el signo tiene relación causal con lo que significa. Kauffman señala que parece del todo legítimo asignar los conceptos de signo, significado y significante al código genético. Kauffman muestra que no se puede preestablecer el espacio de configuraciones de una biosfera y por lo tanto, no es posible deducir cómo se desplegará. Entonces es necesario hacer uso de las historias para entender las secuencias de acciones desarrolladas por los agentes en sus mundos respectivos. La semántica de un suceso es un subconjunto de la gama completa de implicaciones causales, dependientes del contexto, que conlleva el suceso o señal en cuestión (Kauffman, 2003).

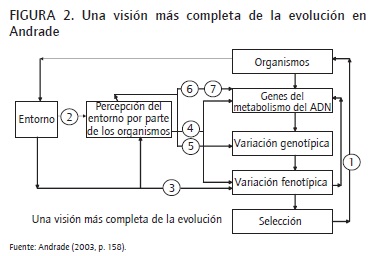

Aportaciones de Andrade

Las aportaciones de Andrade son numerosas en cuanto a la problemática de los agentes internos. Adicional al problema de la emergencia, ilustrado en el apartado anterior, el autor reconoce el sistema biológico como un sistema cognitivo que mide e interioriza (registra) su entorno y, al interpretarlo, propone un ramillete de soluciones o ajustes estructurales. Así, innovaciones podrían estar canalizadas por las dinámicas internas del sistema, como resultado de los ajustes estructurales internos ocurridos durante la interacción, y no tanto por fuerzas externas como se propone en la selección natural clásica. En su visión de la evolución, Andrade presenta la siguiente visión más completa a aquella de: organismos > variantes > selección, la cual incluye los siguientes aspectos:

- El medio ambiente actúa como agente de selección.

- El medio ambiente es percibido por parte del organismo.

- El organismo modifica algunos procesos fisiológicos, según la percepción del medio ambiente.

- El metabolismo genético se afecta por la percepción del medio ambiente.

- El medio ambiente afecta directamente el DNA induciendo mutaciones.

- El medio ambiente interactúa con el DNA por medio del metabolismo de DNA.

- El organismo modifica la interacción ambiental con el genoma (Andrade, 2003).

Andrade considera que la aplicación del modelo de los sistemas colectores y usuarios de información IGUS a sistemas materiales que convierten información analógica en digital elimina de un modo definitivo las explicaciones vitalistas aunque preserva la idea de la actividad cognitiva asociada a la vida. El autor sugiere que el modelo de Zurek considera los demonios como sistemas materiales abiertos ubicados lejos del equilibrio y permite la extrapolación a la biología evolutiva y del desarrollo. Andrade, con base en Salthe, propone que en la curva de disipación de entropía (unidad de masa contra tiempo) se dan los estadios de desarrollo temprano, madurez y senescencia, con las siguientes particularidades (Figura 2):

- Estadio de desarrollo temprano, lejanía del equilibrio y predominio de la información analógica. Se presenta una tensión entre el IGUS y su entorno, lo que conduce a un potencial para establecer acoplamientos y produce los máximos valores de H. La medición obliga a establecer distinciones forzadas por la tendencia de acoplarse con algo, dejando las otras opciones sin posibilidad. H muy alta y K muy baja (Andrade, 2003).

- Estadio de madurez, transición del desequilibrio al equilibrio y máxima conversión de información analógica en digital. El IGUS puede incitar el establecimiento de nuevos acoplamientos, los cuales tienen una mayor probabilidad de involucrar constituyentes estructurales suficientemente semejantes o cercanos en el espacio de formas. Incrementa K, mientras que H disminuye (Andrade, 2003).

- Estado de senilidad, aproximación al equilibrio y predominio de la información digital. La constitución interna lleva la versión codificada de algunos referentes externos y permite la estabilización del IGUS en un entorno constante, lo que hace llegar al máximo valor de información K. El cerramiento estructural hace al IGUS cada vez más dependiente de la información internalizada y, por lo tanto, menos susceptible de interactuar con nuevos referentes. A medida que la estabilización se va dando, la disipación de entropía hacia el exterior disminuye y el IGUS sufre incrementos internos de entropía que conllevan aumento de redundancia y acumulación de variaciones neutras (Andrade, 2003).

Una aportación muy notable en Andrade (2002, 2003) propone que los agentes interpretantes poseen algún sistema de representación que les permite generar una imagen interna del entorno que experimentan. El autor menciona que, evolutivamente, no hay conocimiento a priori independiente de la experiencia, de forma que los seres vivos fueron aprendiendo, elaborando registros, generando patrones de conectividad (y adaptándose) durante la evolución. De esta manera, las estructuras presentes llevan módulos o improntas de las "mediciones y ajustes" que se efectuaron en la filogenia. Como contrapartida, en la ontogénesis sí hay conocimiento a priori, el cual está dado por patrones de reconocimiento incorporados a la estructura de partida (heredados). Hay patrones innatos que seleccionan del mundo externo los elementos que forman parte de la experiencia perceptiva y del mundo de interacciones (Andrade, 2002, 2003).

Dice Andrade: "Ha sido característico de la tradición científica la eliminación total de la capacidad cognitiva en los sistemas materiales. La ruptura cartesiana entre sujeto y objeto produjo que la capacidad cognitiva quedara monopolizada por parte del sujeto, quien identifica exhaustivamente al objeto desde afuera" (2003, p.180).

Andrade (2000, 2002, 2003) además plantea que la forma tiene una prioridad cuya naturaleza explica la aparición de registros codificados digitalmente. La forma, es uno de los conceptos en los que las tres categorías de Peirce no pueden diferenciarse fácilmente. Representan en orden de primeridad, segundidad y terceridad las nociones de cualidad, relación y representación. Andrade sugiere que en cuanto la forma se asocia a la terceridad, se resuelve la polaridad entre información analógica y digital, continuidad y discontinuidad y macro y micro dinámicas. El autor concluye que la forma está íntimamente asociada al proceso que conduce al establecimiento, transferencia y conservación de un conjunto específico de interacciones no aleatorias. Esta aproximación rompe con el idealismo clásico para hacerse más afín a la perspectiva internalista de la ciencia (Andrade, 2002, 2003).

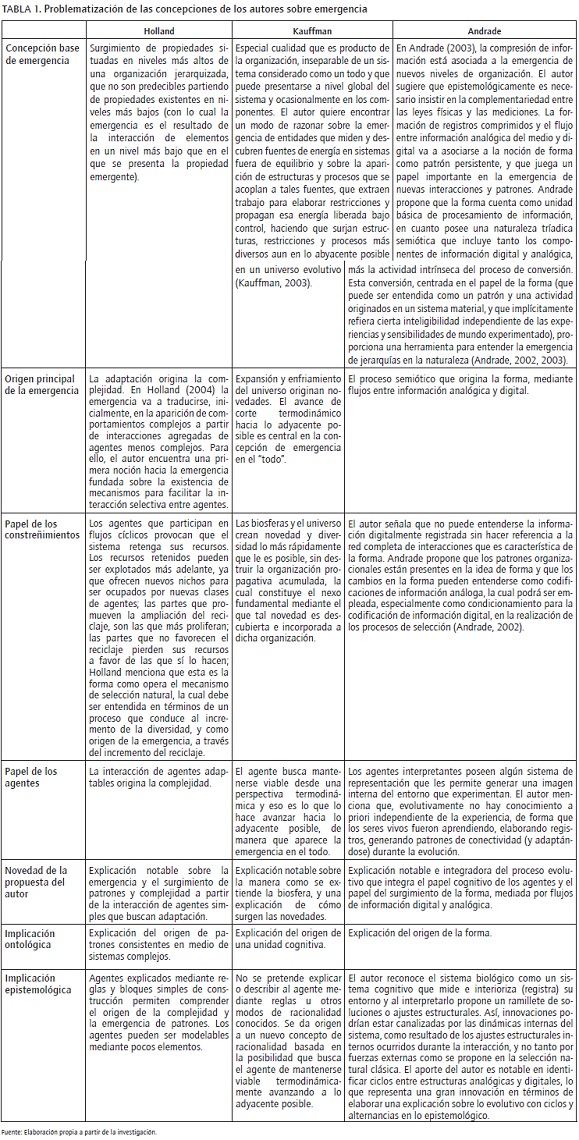

Posturas comparadas de los autores

La Tabla 1 resume la problemática vinculada al tema central de conceptualizar sobre la emergencia.

Apreciaciones finales

El presente documento recoge aportaciones destacadas en su explicación sobre cómo los procesos evolutivos están vinculados con el problema de la emergencia. Por una parte, el programa de investigación de Holland (2004), en sistemas complejos adaptables SCA, va a procurar modelar intuiciones sobre los SCA y la emergencia de la complejidad vía adaptación. En su propuesta, la adaptación de agentes va a generar complejidad y emergencias. Por su parte, Stuart Kauffman sugiere que la biosfera se fabrica por sí misma, mediante la emergencia y persistente coevolución de agentes autónomos que desempeñan ciclos de trabajo, desde una perspectiva termodinámica. Andrade propone el papel de la forma como concepto que resuelve polaridades entre información digital y analógica, y el papel del registro y compresión de la información en la emergencia de nuevas posibilidades de organización.

Pie de página

1 La búsqueda a través de Scopus fue realizada mediante la siguiente ecuación de búsqueda: TITLE-ABS-KEY ("concept of emergency") AND SUBJAREA (mult OR agri OR bioc OR immu OR neur OR phar OR mult OR ceng OR CHEM OR comp OR eart OR ener OR engi OR envi OR mate OR math OR phys OR mult OR arts OR busi OR deci OR econ OR psyc OR soci) AND PUBYEAR > 1979 AND (LIMIT-TO (SUBJAREA, "ENGI") OR LIMIT-TO (SUBJAREA, "SOCI") OR LIMIT-TO (SUBJAREA, "COMP") OR LIMIT-TO (SUBJAREA, "DECI") OR LIMIT-TO (SUBJAREA, "BUSI")). Dicha ecuación es amplia y, sin embargo, solamente recupera 28 documentos, de los cuales solamente el 25% corresponde a artículos científicos y 68%, a ponencias en conferencias. Fecha 12/12/2014.

2 Los agentes interpretantes poseen algún sistema de representación que les permite generar una imagen interna del entorno que experimentan. Evolutivamente no hay conocimiento a priori independiente de la experiencia. Los seres vivos fueron aprendiendo, elaborando registros, generando patrones de conectividad (adaptándose) durante la evolución y, de esta manera, las estructuras presentes llevan módulos o improntas de las "mediciones y ajustes" que se efectuaron en la filogenia (de la forma hacia la información digital). Como contrapartida, en la ontogénesis sí hay conocimiento a priori, que está dado por patrones de reconocimiento incorporados a la estructura de partida (heredados), y hay patrones innatos que seleccionan del mundo externo los elementos que forman parte de la experiencia perceptiva y del mundo de interacciones (de la información digital codificada hacia la forma) (Andrade, 2003).

3 La genética matemática generalmente asigna un valor numérico, llamado aptitud, a cada cromosoma. Este valor indica la capacidad del organismo correspondiente para producir descendencia con capacidad de supervivencia. De manera similar, la fuerza asignada a una regla bajo la asignación de crédito mide la utilidad de la regla, así que la supervivencia viene a ser la utilidad de la regla y podemos decir que es su aptitud (Holland, 2004). Holland también concluye que la fuerza es la contraparte de la aptitud. Los organismos aptos son padres exitosos que producen descendencia. Así, las reglas fuertes serán los padres, de donde se desprende que:

- Las reglas fuertes representan el conocimiento ganado. En competencia, las reglas fuertes generalmente son las que determinan las acciones del agente.

- Los descendientes no son idénticos a sus padres, lo cual constituye un genuino descubrimiento.

Ellos constituyen las nuevas hipótesis que van a ser probadas en el medio ambiente. Para el autor, es la recombinación de conjuntos de alelos lo que resulta más interesante desde el punto de vista del descubrimiento de reglas (Holland, 2004).

4 El relieve está conformado por un espacio de genotipos N dimensional, con participantes de la especie próximos a uno dado, que son los que difieren de este en una única mutación. La eficacia de cada genotipo se representa en una altura sobre su posición en el espacio de genotipos, y las alturas resultantes formarían un relieve adaptativo sobre el espacio de genotipos (Kauffman, 1993, 2003). Los aspectos esenciales de su investigación en Origins of Order y At Home in the Universe se reúnen en estos relieves adaptativos, y en el modelo NK. El modelo NK, en palabras de Kauffman, es un sencillo mundo de juguete en el que un organismo posee N genes. Todos ellos presentan dos versiones o "alelos" 0 y 1. Cada alelo de un gen hace una contribución a la eficacia global del organismo que depende de sí mismo y de los alelos de otros K genes. En genética, esos K genes se consideran entradas "epistáticas" a la aportación de eficacia de un gen dado, las 2 a la N combinaciones de alelos de N genes constituyen los vértices de un hipercubo N-dimensional. La eficacia de cada tipo de organismo aparece junto al vértice respectivo y cabe imaginarla como una altura. De ese modo, el modelo NK genera un relieve adaptativo sobre el hipercubo booleano. Por simplicidad, el autor supone que las criaturas tienen un único cromosoma. Tras elegir N y K, la aportación de un gen se ve afectada por un total de K+1 genes. Para estudiar las propiedades genéricas de este tipo de sistemas se asigna una "contribución a la eficacia" aleatoria a cada una de las 2 a las k+1 combinaciones de alelos posibles (Kauffman, 1993, 1995, 2003). Cuando K = 0, los N genes son independientes. Existe un alelo óptimo para cada uno de ellos y, por lo tanto, un genotipo óptimo a nivel global. Cualquier otro genotipo es inferior, pero puede ascender tranquilamente hacia la cima haciendo mutar cualquier gen que presente el alelo menos favorable al alelo opuesto, 0 o 1. El relieve es una única cumbre de suaves laderas. Cuando K adopta el valor máximo, N = 1, cada gen influye en la contribución a la eficacia de todos los demás. Se trata de un sistema totalmente interconectado, y el relieve resultante es por completo aleatorio. Una característica fundamental de los relieves aleatorios, es que presentan un número casi exponencial de picos locales. De hecho, ese número equivale a 2N /(N+1) (Kauffman, 1993, 1995, 2003).

El autor demuestra cómo encontrar el óptimo es enormemente improbable: el sistema siempre queda atrapado en algún pico local. Otras propiedades son que la longitud de los recorridos hasta puntos vecinos más aptos crece con el logaritmo de N y que el número de senderos ascendentes va disminuyendo a medida que se alcanza más altura. Así, el autor encuentra que la coevolución es una danza de relieves acoplados que se deforman (Kauffman, 1993, 2003). En resumen, en el trabajo previo a Investigations, existen leyes poco comprendidas todavía que permiten la construcción coevolutiva de una complejidad acumulativa. Y parece que dicha coevolución alcanza una criticalidad auto-organizada.

5 Las moléculas son objetos combinatorios para Kauffman. A medida que su diversidad se incrementa, la de las reacciones entre ellas lo hace más rápidamente aún. Ello implica que la autocatálisis colectiva se hace más probable conforme el número de reacciones posibles para cada especie molecular se eleva. Para que exista un conjunto colectivamente autocatalítico solo se requiere que al menos una reacción final de las que dan lugar a cada miembro del conjunto esté catalizada por algún otro miembro de ese conjunto.

Este conjunto aparece si un número suficientemente grande de reacciones elegidas al azar resulta catalizado por miembros de un grafo reactivo, y cabría esperar la formación casual de algunos de tales conjuntos (Kauffman, 2003).

6 En opinión de Kauffman, Maxwell pide que imaginemos el recipiente con N partículas de gas en su interior pero ahora el recinto está dividido en dos cámaras separadas por una pared dotada de una pequeña trampilla. Cuando se abre esta trampilla, las partículas de gas pueden pasar de la cámara izquierda a la derecha y viceversa. Supóngase que el estado inicial del gas en el recipiente corresponde al macroestado de equilibrio. No es posible obtener trabajo macroscópico a partir del sistema en tal situación, pues hay una gran cantidad de energía en los movimientos aleatorios de las partículas, pero no hay forma de extraer trabajo mecánico de ella. Maxwell sugiere una criatura que controla la trampilla de modo que, cuando se acerque a ella una partícula más rápida que la media, proveniente de la cámara izquierda en dirección a la cámara derecha, la deje pasar, y que cuando se aproxime una partícula lenta, que intenta pasar de la derecha a la izquierda, también le permita el paso. Al poco tiempo, la cámara izquierda estará fría y la derecha caliente. En ese momento, de acuerdo con la presentación que hace Kauffman de Maxwell, podrá usarse la diferencia macroscópica de temperatura entre las dos cámaras para obtener trabajo mecánico y mover un pistón (Kauffman, 2003).

7 Andrade (2003) explica que, para Zurek, es posible establecer una definición de entropía que reúne simultáneamente la entropía probabilística de Shannon con la entropía algorítmica de Chaitin. Andrade expone que la propuesta de Chaitin se deriva de una teoría de algoritmos enfocada al estudio de objetos individuales, y que Kolmogorov y Chaitin definieron entropía o complejidad como la longitud del algoritmo más corto necesario para generar una serie de símbolos por computador. Según Chaitin, dice Andrade (2003), la versión más comprimida que se puede obtener de una secuencia de símbolos es aleatoria; es decir, la presencia de un símbolo determinado en una posición nada dice sobre la probabilidad de ocurrencia de un símbolo en las posiciones siguientes. La longitud del programa o algoritmo más corto que específica la secuencia es la entropía de la secuencia.

Relata Andrade que, para Zurek, representar la entropía como una cantidad híbrida es posible desde el punto de vista de un referencial interno u observador interesado en la extracción de trabajo útil (Andrade, 2003). Andrade (2003) explica que Zurek define "entropía física" (S) como la cantidad de energía libre que puede convertirse en trabajo útil por acción de un demonio de Maxwell. Zurek, continúa Andrade (2003), imagina un observador interno representado como Sistema Colector y Usuario de Información (IGUS) que estima la cantidad de trabajo que una máquina de cómputo puede extraer, teniendo en cuenta el balance total de entropía producida a causa del procesamiento de los datos. Este IGUS puede imaginarse como un observador que sondea su entorno por medio de la ejecución de una serie de mediciones, y que procesa los resultados con el fin de definir las acciones que conducen a una optimización de la cantidad de trabajo útil. A medida que el número de definiciones tiene lugar, su incertidumbre acerca del entorno disminuye y la información ganada incrementa el tamaño del registro (Andrade, 2003).

La explicación que nos brinda Andrade (2003) es la siguiente: Zurek vincula las concepciones a partir de hacer S = H + K (con H como la entropía de Shannon y K la complejidad algorítmica de Chaitin). Las mediciones disminuyen la ignorancia acerca del entorno físico, pero incrementan el tamaño (aleatoriedad algorítmica) del registro que describe la información obtenida. La diferencia entre H y K determina la ganancia en trabajo neto. El modelo explica cómo la cantidad de energía que puede ser usada por el IGUS depende de la complejidad algorítmica del registro, puesto que entre más comprimido esté el registro (menor valor de K), mayor será la cantidad de trabajo W que puede ser extraído lejos del equilibrio (en tal situación AH > AK). El trabajo neto AW obtenido a temperatura T por el IGUS está determinado por AW = AW(+) + AW(-), donde AW(+) es el trabajo ganado debido al cambio en entropía de Shannon, dado por AW(+) = T(Hfinal-Hinicial). AW(-) es el costo de la actualización de la memoria del observador que reemplaza el registro desactualizado correspondiente a las condiciones iniciales ri, con el registro rf, que describe su conocimiento acerca del estado final (r es el tamaño del programa mínimo en bits), dado por AW(-) = T(Kf-Ki) = (T((rf)-(ri))). Toda esta aclaración proviene de Andrade (2003).

Referencias bibliográficas

Addiscott, T. (2011). Emergence or self-organization? Look to the soil population. Commun Integr. Biol. 4(4), 469-470. [ Links ]

Andrade, L. E. (2000). From External to Internal Measurement: A Form Theory Approach to Evolution. Biosystems, 57(2), 49-62. [ Links ]

Andrade, L. E. (2003). Los demonios de Darwin. Semiótica y termodinámica de la evolución biológica. Bogotá: 2a Ed. Universidad Nacional de Colombia, Facultad de Ciencias, Departamento de Biología. [ Links ]

Andrade, L. E. (2002). The Organization of Nature: Semiotic Agents as Intermediaries between Digital and Analog Informational Spaces. Seed Journal (Semiosis Evolution Energy Development), 2(1), 56-84. [ Links ]

Binder, P. M., & Danchin, A. (2011). Life's demons: Information and order in biology. EMBO reports, 12(6), 495-499. [ Links ]

Collier, J. (1990). Two Faces of Maxwell's Demon Reveal the Nature of Irreversibility. Studies in the History and Philosophy of Science, 21, 257-268. [ Links ]

Corning, P. (2002). The re-emergence of "emergence": A venerable concept in search of a theory, Complexity, 7(6), 18-30. [ Links ]

Fromm, J. (2004). The Emergence of complexity. Germany: Kassel University. [ Links ]

Gell-Mann, M. (1995). The Quark and the Jaguar: Adventures in the Simple and the Complex. Macmillan. [ Links ]

Holland, J. (2004). El orden oculto, de cómo la adaptación crea la complejidad. México: Fondo de Cultura Económica. [ Links ]

Holland, J. (2008). Biology's Gift to a Complex World. Scientist 22(9), 36-43. [ Links ]

Holland, J. (2010). Echoing emergence: Objectives, rough definitions, and speculations for Echo-class models. En: G.A. Cowan, D. Pines & D. Meltzer (eds.). Complexity: Metaphors, Models and Reality. MA: Addison-Wesley, Reading. [ Links ]

Hudson, J. W. (2011). Risk Assessment and Management for Efficient Self-Adapting Self-Organizing Emergent Multi-Agent Systems (Doctoral dissertation, University of Calgary). [ Links ]

Huneman, P. (2008). Emergence and Adaptation. Minds and Machines, 18, 439-520. [ Links ]

Johnson, C. W. (2009). What are Emergent Properties and How Do They Affect the Engineering of Complex Systems? Scotland, UK: Department of Computing Science, University of Glasgow. [ Links ]

Kauffman, S.A. (2003). Investigaciones. España: Metatemas. [ Links ]

Kauffman, S. A. (1993). The Origins of Order: Self-Organization and Selection in Evolution. New York: Oxford University Press. [ Links ]

Kauffman, S. (1995). At home in the universe: The search for the laws of self-organization and complexity. Oxford University Press. [ Links ]

Keymer, J., Fuentes, M., &. Marquet, P. (2011). Diversity Emerging: From Competitive Exclusion to Neutral Coexistence in Ecosystems. Santiago: Center for Advanced Studies in Ecology and Biodiversity (CASEB) y Departamento de Ecología, Facultad de Ciencias Biológicas, Pontificia Universidad Católica de Chile. [ Links ]

Kurz, H. D. (2008). Innovations and profits: Schumpeter and the classical heritage. Journal of Economic Behavior & Organization, 67(1), 263-278. [ Links ]

Lara, A. (2008a). Agente adaptable, aprendizaje y estructura del ambiente: Un enfoque alternativo. Disponible en: www.Laisumedu.Org/Desin_Ibarra/Desin/Fronteras/Lara-Cm.Pdf. [ Links ]

Lara, A. (2008b). Sistemas complejos adaptables y teoría de la empresa: el programa de investigación. Economía Informa, 352, 65-92. [ Links ]

Maldonado, C. E. (2004). Explicando la sorpresa. Un estudio sobre emergencia y complejidad. Causalidad o emergencia, diálogo entre filósofos y científicos. Bogotá, Universidad de la Sabana/Sociedad Colombiana de Filosofía de la Ciencia, ISBN 958-12-0227-7, pp. 31-63. [ Links ]

Morin, E. (1994). Introducción al pensamiento complejo. Editorial Gedisa, Barcelona. [ Links ]

Morin, E. (1996). Entrevista en París con Edgar Morin: el pensamiento complejo contra el pensamiento único. En: Revista de sociología y política, "nueva época", Universidad Iberoamericana, (8), 2-10. [ Links ]

Nicolis, G., & Prigogine, I. (1989). Exploring Complexity. An Introduction. New York: W.H. Freeman and Company. [ Links ]

Parrondo, J., & Horowitz, J. (2011). Viewpoint: Maxwell's demon in the quantum world, Departamento de Física Atómica, Molecular y Nuclear and CISC. Madrid, Spain: Universidad Complutense de Madrid. [ Links ]

Paulo, L., Nelson, R., & Vrba, P. (2011). Multi-Agent System for On-demand Production Integrating Production and Quality Control. Heidelberg: Springer Berlin. [ Links ]

Peirce, C. S., Hartshorne, C., & Weiss, P. (Eds.) (1935). Collected papers of charles sanders peirce (Vol. 5). Harvard University Press. [ Links ]

Pereda, M., & Zamarreño, J.M. (2011). Agent-based modeling of an activated sludge process in a batch reactor, 19th Mediterranean Conference on Control and Automation Aquis Corfu Holiday Palace, Corfu, Greece. [ Links ]

Rodríguez, J.M., Torres, L.C., Cubillos, C., Romero, U.R., & Albis, N. (2004). Organizaciones para la creación de un Enfoque Complejo - El caso de la Universidad Nacional de Colombia, Sede Bogotá. Grupo Complexus. Bogotá: Universidad Nacional y Siglo XXI Eds. [ Links ]

Ryan, A. (2007). Emergence is coupled to scope, not level. Complexity, 13, 67-77. [ Links ]

Schumpeter, J.A. (1934). The Theory of Economic Development. An Inquiry into Profits, Capital, Credit, Interest, and the Business Cycle. Cambridge, Ma.: Harvard. University Press. [ Links ]

Schrõdinger, E. (1992). What is life?: With mind and matter and autobiographical sketches. Cambridge University Press. [ Links ]

Shannon, C., & Weaver, W. (1949). The Mathematical Theory of Communication, Urbana. Ill.: University Of Illinois. [ Links ]

Viau, J., & Moro, L. (1990). El Cuento del Demonio de Maxwell, una Propuesta Didáctica para la Enseñanza de Conceptos Básicos de Termodinámica. Formación Universitaria, 3(1), 3-10. [ Links ]

Zurek, W.H. (1989). Algorithmic Randomness and Physical Entropy. Physical Review A. 40(8), 4731-4751. [ Links ]

Zurek, W.H. (1990). Physics, mathematics, and minds (Review of Penrose's "The Emperors New Mind"). Science, 248, 880-881. [ Links ]