Introducción

En las últimas décadas se ha extendido el uso del análisis conjunto (AC) hacia el estudio de los factores que subyacen en las decisiones empresariales como, por ejemplo, qué criterios utilizan los inversores de capital riesgo a la hora de seleccionar empresas donde invertir (Shepherd y Zacharakis, 1999), cómo detectar oportunidades de negocio (Lohrke, Holloway y Woolley, 2010), qué elementos determinan el autoempleo como salida profesional (Lévesque, Shepherd y Douglas. 2000), cómo gestionar la sucesión en las empresas familiares (Shepherd y Zacharakis, 2000) e, incluso, qué criterios se utilizan para valorar los planes de negocio (Franke, Gruber, Harhoff y Henkel, 2008). Esta extensión del uso del AC se ha interpretado como un avance frente a los métodos habituales de recolección de datos, de tipo post-hoc, para el estudio de las decisiones empresariales (Shepherd y Zacharakis, 1999).

En los métodos tradicionales los entrevistados utilizan cuestionarios que cumplimentan personalmente y valoran todos aquellos factores que piensan que fueron relevantes en las decisiones tomadas en el pasado. Precisamente el hecho de utilizar una valoración a posteriori, basada en el recuerdo, se considera una fuente de distorsión capaz de sesgar los resultados (Golden, 1992). Por ejemplo, en los estudios del comportamiento del consumidor tienen, cada vez, mayor incidencia los diferentes estados en los cuales los sujetos toman sus decisiones, como por ejemplo, el estado de flujo (Csikszentmihalyi, 1990) o de intuición (Bargh y Ferguson, 2000). Estos estados, totalmente alejados de la racionalidad cognitiva, difícilmente pueden ser recordados o rememorados sin incorporarles alguna lógica cognitiva que explique de manera racional la actuación pasada. Así, se han detectado motivaciones de los entrevistados para predisponer sus respuestas de manera que parezcan favorables al entrevistado (March y Feldman, 1981) y, también, se han remarcado las limitaciones perceptuales y cognitivas de los individuos al rememorar las decisiones pasadas (Fischhoff, 1982). Como consecuencia de estas distorsiones, los resultados de las autoevaluaciones generan estimaciones con un mayor número de variables significativas y, además, con un peso relativo superior de los criterios menos importantes, en comparación con otros métodos de análisis más sofisticados (Shepherd y Zacharakis, 1999).

Por consiguiente, el AC se presenta como una técnica que puede contribuir a superar algunos de los inconvenientes de la autovaloración retrospectiva, dado que le propone al sujeto replicar, de forma experimental, un proceso de toma de decisión teniendo en cuenta las variaciones de las variables consideradas relevantes (DeSarbo, MacMillan y Day, 1987; Shepherd y Zacharakis, 1999). El AC utilizado en el estudio de la toma de decisiones consiste en que los entrevistados comparan y evalúan una serie de perfiles, prototipos, conceptos o escenarios, formados por una combinación de niveles de factores o atributos, y del resultado se puede descomponer la estructura subyacente del proceso de decisión. Originalmente el AC fue utilizado en psicología, pero a partir de 1970 se introdujo en el estudio sobre las preferencias de los consumidores y en la investigación de mercados (Gustafsson, Herrmann, y Huber, 2007).

Un requisito previo del AC es disponer de los posibles atributos o factores que pueden influir en el proceso de decisión y que representan características del entorno, cuya combinación configura los escenarios a evaluar. Para obtener estos atributos se recurre a la investigación cualitativa con ejecutivos, proveedores, clientes entre otros, así como a la literatura para recabar información que ayude a definir los protocolos verbales o frases que definen a los factores. Por ejemplo, para determinar los factores relevantes en los estudios cualitativos se suele seguir el procedimiento de la categorización inductiva, que consiste en asignar una etiqueta a las recurrencias semánticas que se encuentran en el texto (Spiggle, 1994). Un proceso similar se utiliza en el análisis de contenido para identificar relaciones entre las diferentes recurrencias semánticas (Tax, Brown y Chandrashekaran, 1998). Estos párrafos forman los niveles de los factores y pueden describir tanto alternativas categóricas, es decir nominales, y codificarse mediante valores parciales (1, 0), como también relaciones crecientes, decrecientes u opciones contrarias y, en ese caso, se pueden codificar de forma vectorial (-1, 1) (Raghavarao, Wiley y Chitturi, 2011).

A partir de las descripciones verbales se configuran los escenarios, lo más reales y plausibles, combinando diferentes niveles de los factores, y el proceso continúa con la evaluación de los diferentes escenarios como si se tratara de diferentes planes de negocios, siguiendo el orden propuesto por un diseño experimental. La valoración se puede hacer tanto en función de la probabilidad de invertir en ellos como mediante cualquier otro tipo de escala de calificación. Por último, se estima mediante análisis de regresión la influencia que tienen los diferentes factores del entorno en la valoración del escenario.

La literatura sobre el diseño experimental, su desarrollo y el análisis conjunto ha sido muy prolífera con el fin de encontrar diseños estadísticos eficientes (por ejemplo, Street y Burguess, 2007; Toubia y Hauser, 2007; Vermeulen, Goos y Vandebroek, 2008). Los diseños estadísticamente eficientes requieren un número menor de entrevistados, produciendo ahorros en el trabajo de campo y, a la vez, permiten a los investigadores extraer una mayor cantidad de información y más precisa sobre las preferencias de los consumidores (Louviere, Islam, Wasi, Street y Burgess, 2008). No obstante, como advierte Louviere (2001), la utilización de diseños cada vez más eficientes puede generar consecuencias no buscadas en las respuestas de los entrevistados debido a sus limitaciones cognitivas.

El objetivo de este trabajo es estudiar cómo el cambio en el diseño experimental puede influir en la respuesta de los encuestados y cómo diferentes grados de complejidad (en concreto, el cambio en el número de factores incluidos en cada escenario) afectan en la estimación de los resultados, cuando se trabaja con escenarios construidos mediante descripciones de los atributos por párrafos de texto, los cuales aportan una cantidad importante de información. Además, se propone un diseño experimental novedoso en la literatura resultado de la combinación de un diseño en bloques ortogonal con un diseño de bloques incompletos balanceados (BIB), con el objetivo de mejorar la validez interna de estos experimentos.

Este diseño propuesto sacrifica la eficiencia estadística pero aprovecha la necesidad de utilizar un número de réplicas elevado, hecho habitual en los experimentos que utilizan personas como sujeto experimental (Gilmour y Trinca, 2006), para alcanzar mayor eficacia utilizando subdiseños de menor tamaño y diferentes para cada entrevistado. Una idea similar fue sugerida por Louviere, Hensher y Swait (2000), quienes plantean el uso de diferentes fracciones de un factorial completo para estimar los factores principales y las interacciones, donde cada entrevistado recibe solo una porción del diseño completo (Green, 1974) reduciendo así la carga de trabajo. Y, además, como sugiere Sándor y Wedel (2005), proporcionando una mayor variación en la elección de la respuesta, lo que permite recoger de manera más eficiente las variaciones de las variables independientes.

Este artículo se estructura en cuatro partes: en la primera, se plantea el problema de la saturación informativa y la hipótesis del trabajo; a continuación, se presentan dos opciones diferentes de diseño experimental en bloques; en tercer lugar, se describe el contexto en el que se realiza el experimento; luego, se presentan los resultados y, por último, las conclusiones y futuras extensiones de la investigación.

La saturación informativa con las descripciones en párrafo

El método habitual que utiliza AC para recoger los datos es el denominado diseño de perfil completo, que consiste en que cada entrevistado valora un conjunto de alternativas y, cada una de ellas, presenta una combinación de los niveles de todos los factores incluidos en el estudio. Su uso se justifica porque ofrece la descripción más realista de los estímulos y, dentro de un número limitado de factores y en un entorno con factores correlacionados, el diseño de perfil completo es probablemente el mejor en términos de capacidad predictiva (Green y Srinivasan, 1990). Pero, por otro lado, tiene la desventaja de que, a medida que se incorpora un número mayor de factores en la formación de los perfiles, la labor del entrevistado se hace cada vez más compleja, al tener que evaluar numerosos factores a la vez y, es posible, que la cantidad de información sobrepase su capacidad cognitiva, recurriendo a heurísticas simplificadoras que dejen de lado las variaciones de los factores menos importantes. Los resultados obtenidos no serían representativos de un comportamiento real y redundaría en su capacidad predictiva (Green y Srinivasan, 1978).

Los estímulos que se presentan a los entrevistados suelen implicar variaciones y combinaciones de tres presentaciones básicas: verbales, en párrafos y en imágenes, siendo los más utilizados y, a gran distancia del resto, las tarjetas de perfil completo con descripciones verbales (Green y Srinivasan, 1990). No obstante, Hauser y Urban (1977), quienes utilizaron presentaciones en párrafo para definir conceptos de productos, consideran que este tipo de representación proporciona la descripción más realista y completa de los estímulos. Aunque también están de acuerdo en que el número total de estímulos debe ser muy reducido, ya que de otra manera cuando se estiman modelos para cada individuo las estimaciones de los parámetros son muy imprecisas. Sin embargo, consideramos que esta forma de presentar los estímulos descritos por párrafos de texto sería la más conveniente para estudiar la toma de decisiones empresariales, puesto que describe de forma más precisa los escenarios que mediante la simple cita de los atributos.

La literatura sobre investigación de mercados también ha analizado las causas que generan una alta variabilidad de las respuestas y las ha dividido en causas generadas por los sujetos (Baumgartner y Steenkamp, 2001) y causas derivadas del diseño del protocolo, como puede ser el número de ítems que forman el cuestionario o el formato en que se suministra a los entrevistados (Paulhus, 1991), siendo la influencia del diseño uno de los aspectos menos tratados por la literatura (Louviere et al., 2008). Este estudio pretende aportar evidencias sobre la respuesta diferente que puede generar el uso de protocolos procedentes de diseños experimentales distintos en AC cuando se utilizan frases para presentar los atributos.

Otro de los temas documentados por la literatura es el efecto que tiene la complejidad de la tarea a la que se enfrenta el entrevistado sobre el error aleatorio de la respuesta (DeShazo y Fermo, 2002). La variabilidad de las respuestas no explicada por los factores analizados se denomina grado de "consistencia en la elección" y se puede dividir entre: a) la variabilidad procedente de la complejidad cognitiva del diseño y b) la variabilidad generada por sensibilidades y preferencias distintas de los individuos frente a los atributos. La existencia de estas dos fuentes de variabilidad se podría equiparar a un problema de control de calidad. Por un lado hay una variabilidad derivada de la diferente sensibilidad de los individuos, que podría considerarse variación natural, aleatoria o común de la respuesta y que no tiene sentido considerarla individualmente como la razón de la desviación del resultado. Y, por otro lado, la variabilidad fruto de la complejidad cognitiva derivada del diseño y que se puede considerar una variación accidental, especial o producida por causas asignables y, por tanto, es posible encontrar la razón específica que la produce y tomar las medidas correctivas. La idea, por tanto, es que es posible encontrar diseños que reduzcan la variabilidad por causas asignables y, por consiguiente, se incremente la variabilidad explicada por el modelo y, por tanto, su fiabilidad.

Existe un respaldo teórico a considerar, que el diseño puede contribuir a generar una mayor carga cognitiva, por ejemplo, cuando el individuo debe evaluar muchas opciones.

Mientras que, por un lado, la teoría económica considera que un amplio surtido favorece la elección del individuo, dado que ofrece una mayor probabilidad de encontrar entre el amplio surtido la opción que mejor se ajuste a sus preferencias (Lancaster, 1990), por otro lado, investigaciones posteriores pusieron en duda esta suposición, sugiriendo que el incremento del número de alternativas puede tener consecuencias adversas llegando a abrumar y confundir al sujeto, haciéndole retrasar su elección o incluso acabar renunciando a ella (Iyengar y Lepper, 2000). Así Huffman y Kahn (1998) dedujeron que el esfuerzo cognitivo requerido para valorar un amplio surtido es tan elevado que es capaz de reducir e incluso eliminar el atractivo generado por la amplia variedad. Por ejemplo, Malhotra (1982) piensa que los encuestados son capaces de procesar hasta diez atributos sin una excesiva presión. No obstante, en sus primeros estudios, Green y Srinivasan (1978) recomendaban no utilizar más de seis atributos simultáneamente. Y, en concreto, que la sobrecarga informativa que representa el incremento del número de factores y perfiles que debe evaluar cada sujeto incrementa la variabilidad de la respuesta y hace que disminuya la fiabilidad de los resultados (Huber, Herrmann y Gustafsson, 2007).

Respecto al uso de párrafos como forma de presentar los factores, Louviere (2001) advierte que una carga cognitiva importante puede reducir la consistencia de la elección. En esta línea, Swait y Adamowicz (2001) utilizan el concepto de entropía2 para medir la complejidad que comporta elegir entre los elementos de un conjunto, y demuestran que la cantidad de información que deben analizar los entrevistados es un revulsivo para la consistencia de la elección resultante. Por consiguiente, cuanto más complejo sea el proceso de elección, menos acertado y consistente será el resultado final (Payne, Bettman y Johnson, 1993). Además, aunque se considere una muestra de sujetos homogénea en cuanto a sus preferencias, cada uno de ellos puede presentar habilidades diferentes para realizar la elección y, por tanto, conforme la complejidad se vaya incrementando, los menos hábiles tenderán a cometer mayores errores en su elección (De Palma, Myers y Papageorgiou, 1994). En definitiva, se sugiere que cuando los sujetos se enfrentan a un problema de elección utilizan una estrategia adecuada a las circunstancias que representa un equilibrio entre el esfuerzo cognitivo en evaluar las opciones (coste) y el beneficio de tomar una decisión acertada.

Por tanto, se espera que un diseño en BIB, que reduce a la vez el número de alternativas y el número de factores que compone cada perfil, mejore la consistencia del proceso de elección. Dado que trabajos anteriores como DeShazo y Fermo (2002) han analizado el grado de complejidad que genera la utilización de diferentes factores en la construcción de escenarios, en este trabajo se propone considerar el grado de complejidad derivado del número de factores que configura cada escenario, además que hace análisis en un diseño en bloques incompletos balanceados, permitiendo que los entrevistados no solo evalúen escenarios con menos atributos, sino que además estos atributos sean distintos de un entrevistado a otro.

Por tanto, la hipótesis de este trabajo es la siguiente:

H1: La evaluación de escenarios estructurados, siguiendo un diseño experimental en bloques incompletos balanceados, proporciona un resultado más consistente y fiable que la estructurada, siguiendo un diseño factorial fraccionado en bloques, cuando los escenarios son descritos por párrafos, debido a diferente complejidad cognitiva.

Para verificar esta hipótesis se propone un experimento en el que dos grupos de individuos evaluarán dos diseños experimentales sobre una misma materia, con los mismos factores y niveles, pero con diferentes estructuras: un diseño factorial fraccionado en bloques (n b < q) y otro BIB (n b = q), donde n b es el tamaño del bloque y q el número de variables. Se considerará como criterio de evaluación de consistencia y fiabilidad el número de factores significativos y el coeficiente de determinación ajustado. Estos criterios ya han sido utilizados anteriormente en la literatura, por ejemplo, por Huber, Herrmann y Gustafsson (2007).

Diseños factoriales en bloques y diseños en bloques incompletos balanceados (BIB)

Como señalan Scarpa y Rose (2008), cuando se generan diseños experimentales eficientes se asume que es una sola persona la que tiene que evaluar todos los escenarios y a esto se le denomina diseño homogéneo (Sándor y Wedel, 2005). Ahora bien, cuando el diseño genera un número de opciones muy elevado, lo normal es dividir el diseño completo en diferentes subdiseños utilizando, para ello, la técnica de bloqueo. A estos diseños se les denomina heterogéneos (Sándor y Wedel, 2005) y hay que tener en cuenta que la división en bloques puede distorsionar su eficiencia debido a la presencia de correlación entre los factores analizados y las variables de bloqueo, tal y como demuestran Gilmour y Trinca (2006).

La literatura recomienda construir diseños experimentales ortogonales (Green y Srinivasan, 1978) puesto que permiten estimar el peso de los factores sin estar correlacionados entre sí, proporcionando unos resultados menos ambiguos (Johnston y DiNardo, 2001). Sin embargo, en los diseños ortogonales a medida que crece el número de factores crece de manera exponencial el número de perfiles a evaluar. Por otro lado, existen diseños quasiortogonales que permiten alcanzar resultados con pequeñas correlaciones entre algunos factores pero con un número más reducido de perfiles. No obstante, según la teoría econométrica, si los coeficientes de correlación entre dos factores está por debajo de 0,4, esto indicaría la presencia de problemas no muy severos de multicolinealidad para la estimación de las β (Verhoef y Leeflang, 2009). Es decir que la correlación entre atributos debe mantenerse lo más pequeña posible, pero no es necesario que sea cero para estimar el peso de los factores.

Los diseños factoriales en bloques

En muchas circunstancias, aunque se considere un diseño factorial fraccionado, es imposible replicarlo en un solo experimento aunque se haya diseñado siguiendo alguno de los criterios de optimización propuestos por la literatura, por ejemplo un diseño D-óptimo (Toubia y Hauser, 2007). La única alternativa es trocear el diseño completo en subconjuntos más pequeños denominados bloques y suministrar cada uno de estos bloques de perfiles a un entrevistado. Sin embargo, este troceado del diseño experimental en bloques más pequeños no se realiza de manera aleatoria, sino que sigue el diseño propuesto por el generador de bloques. Este generador indica qué perfiles deben ir juntos en un bloque y, además, qué interacción de factores se ha utilizado para su generación. En la mayoría de libros sobre diseño estadístico de experimentos, como por ejemplo en Box, Hunter y Hunter (1999) o Myers y Montgomery (2002), se publican tablas con los generadores de bloques para el rango de factores más habituales.

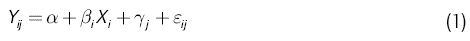

Cuando en un diseño experimental se presentan los perfiles agrupados en bloques, esto significa una restricción a la variabilidad de los estimadores y una pérdida de precisión en el ajuste del modelo. En el caso de considerar un modelo lineal, el efecto de esta restricción se puede representar añadiendo una nueva variable al modelo. Este cambio se recoge en la siguiente ecuación:

Donde:

Y ij = |

recoge la valoración otorgada al i-ésimo perfil en el bloque j-ésimo |

α = |

es la constante del modelo (media general) |

β i = |

es el estimador de la variable i-ésima |

X i = |

representa la codificación de la variable i-ésima |

γ j = |

recoge el efecto de aplicar el bloque j-ésimo |

ε ij = |

es el error aleatorio NID (0, σ). |

En este caso, cada sujeto evalúa un número reducido de perfiles formados por la combinación de todos los factores.

Los diseños en bloques incompletos balanceados

Otra forma de agrupar los perfiles en bloques es recurrir al diseño BIB que se utilizan como instrumento para disminuir la varianza del error experimental y proporcionar comparaciones más precisas que con el diseño de bloques completos. El uso de diseños BIB se desarrolló a finales de los años treinta y uno de los pioneros fue Yates (1937), quien introdujo el concepto de bloques incompletos balanceados. La idea consistía en utilizar un número reducido de perfiles en cada unidad experimental en lugar de todos los perfiles que formaba el diseño factorial completo. También se ha utilizado en el análisis conjunto, para estudios agregados, asignando un grupo de consumidores a cada bloque (Green, 1974).

Una de las ventajas de utilizar el diseño BIB es que permite reducir el número de variables que se incorpora a cada escenario, de tal forma que el entrevistado los evalúa teniendo en cuenta un número menor de factores. Se trata de un arreglo en el que todas las variables aparecen el mismo número de veces y, además, cada pareja de variables aparece en cada bloque un número igual de veces, por eso se le denomina balanceado. Es decir que, aunque cada entrevistado haya evaluado un número reducido de variables, el conjunto de toda la muestra habrá evaluado todas las variables un mismo número de veces. El objetivo, al igual que en el resto de bloques, es tener un control sistemático sobre la variabilidad debida a fuentes de perturbación externas. Cuando estas fuentes de variabilidad existen, como es en el caso de la variabilidad por causas asignables debido a la dificultad cognitiva de evaluar escenarios presentados por combinaciones de frases, es posible organizar arreglos por bloques capaces de separar y reducir esta variabilidad del resto de los efectos creados por los factores de interés.

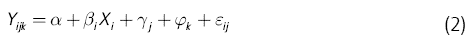

En este artículo se presenta una nueva estrategia para construir el diseño experimental que consiste en combinar de forma sistemática los dos generadores de bloqueo. Esta idea se inspira en el trabajo de Box y Behnken (1960), quienes desarrollaron una familia de diseños eficientes para evaluar factores de tres niveles (1, 0, -1) y para ajustar un modelo definido por una ecuación de segundo grado, basando su construcción en la utilización de BIB. En este estudio, el diseño es bastante más complejo, adaptado a dos niveles y a un modelo definido por una ecuación de primer grado. Una de las características de los diseños Box-Behnken es que cumplen los criterios de ortogonalidad para los factores principales y, por tanto, las estimaciones serán eficientes. De nuevo, el proceso de separación en bloques puede perder algo de eficiencia incorporando en el modelo una nueva variable que recoge el efecto de BIB, con lo que la ecuación sería:

Donde φ k recoge el efecto que genera la nueva agrupación en bloque k-ésimo dentro de cada escenario.

En la literatura es bastante habitual considerar que la organización de los perfiles en bloques tienen un efecto fijo y aditivo en el modelo estimado y, por tanto, que no existe ningún tipo de interacción entre las agrupaciones en bloques y los factores estimados (Yang y Draper, 2003). En esta investigación se ha realizado el mismo supuesto, añadiendo una variable aditiva a la ecuación (1) y otra más a la ecuación (2) y, por último, se han estimado los dos modelos por mínimos cuadrados ordinarios (Perreault y Darden, 1975).

El experimento

Para validar la hipótesis se propone un experimento que simule un proceso de análisis del entorno previo a la toma de decisiones. Se plantea el caso de determinar cómo los individuos analizan el entorno, identifican las oportunidades, las evalúan viables y las deciden explotar (Brush et al., 2003). Para ilustrar este proceso, se llevó a cabo un experimento con estudiantes del último curso de Ingeniería de Telecomunicaciones. Se considera que los especialistas en telecomunicaciones forman una parte esencial de la formación del capital intelectual de las empresas y, además, su estudio se considera un factor clave para el desarrollo económico, político y social de una nación (Herrera, 2004). Esto contrasta con la situación que se vive en España que, entre el año 2001 y 2010, redujo el número de estudiantes matriculados en ingenierías de telecomunicaciones en un 40% (EVERIS, 2012).

Dentro de este contexto, se quería determinar cómo estos futuros ingenieros percibían la gestión del capital intelectual en las empresas españolas e intentar determinar cómo esta percepción puede condicionar su actitud y conducta frente a las capacidades que consideran útiles adquirir. Se trata, pues, de un análisis de percepciones en el que entrevistado debe determinar el grado de proximidad en el que el escenario propuesto refleja la realidad (Green y DeSarbo, 1978).

La gestión del conocimiento y la formación de capital intelectual (CI) se consideran una de las fuentes críticas para asumir una ventaja competitiva sostenible tanto para las organizaciones como para los individuos. Uno de los retos teóricos importantes es intentar comprender cómo el conocimiento que se genera dentro de la empresa es capaz de crear capacidades para estimular su crecimiento y garantizar su supervivencia (Kogut y Zander, 1992). Este desafío se concreta en dos pasos: 1) intentar identificar qué factores del CI permiten desarrollar las capacidades y el potencial de innovación de la empresa y 2) comprender cómo estos factores intervienen e interactúan para alcanzar una ventaja competitiva sostenible.

Dado que la innovación es un proceso no lineal, dinámico y conducido por el CI, se requiere para su desarrollo la generación de un entorno de trabajo donde elementos "conductores" y "facilitadores" estén integrados. Desgraciadamente, además de la falta de concreción de la definición de innovación, muchos investigadores han omitido determinar cuáles son estos "conductores" y "facilitadores" (Ottaviano, 2004). En este trabajo se entiende que los "conductores" hacen referencia a aquellos elementos de gestión estratégica que permiten la innovación en cualquiera de sus formas -por ejemplo, en el diseño de producto, en el desarrollo de nuevos procesos, en la innovación de la organización y la gestión-. De manera similar, se entiende que los "facilitadores" de la innovación serían todos aquellos elementos intangibles que pueden aumentar la probabilidad de éxito de las innovaciones potenciales -típicamente, la cultura empresarial y el sistema de valores, etc.-. Una conjetura importante es intentar conocer la naturaleza dinámica de estos instrumentos y su capacidad de intercambiarse unos con otros para alcanzar un mejor resultado.

Para conocer la percepción que tienen los estudiantes que finalizan sus estudios de ingeniería de telecomunicaciones sobre la gestión del capital intelectual en las empresas españolas, se propuso un experimento mixto que combina un análisis entre sujetos junto a un análisis conjunto intersujetos. La variable dependiente recoge el grado de semejanza que perciben los entrevistados entre el escenario presentado, descrito por la combinación de frases "facilitadoras" y "obstaculizadoras", según prescribe el diseño experimental, y la realidad de la industria española (Green y DeSarbo, 1978), siguiendo el procedimiento propuesto por Shepherd y Zacharakis (1999).

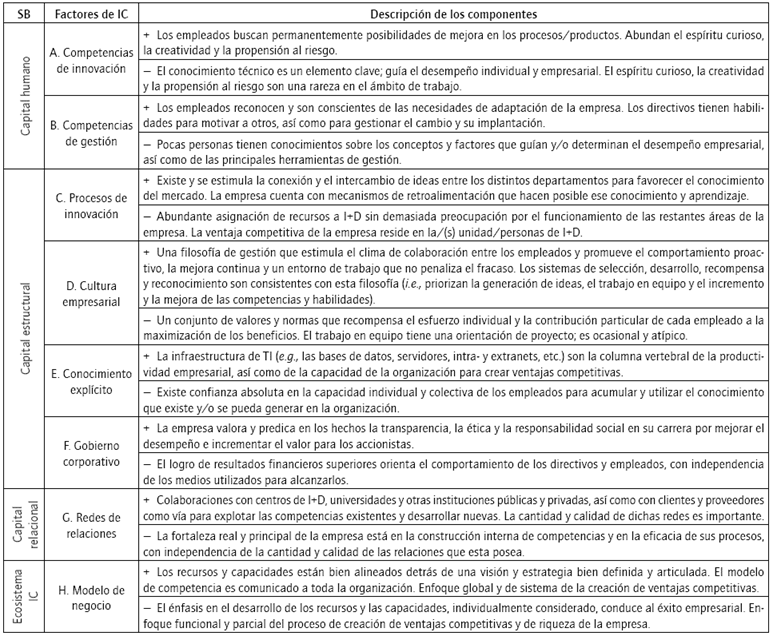

El AC requiere que los investigadores conozcan a priori y propongan los factores relevantes en el proceso de valoración de escenarios (Sawyer, Worthing y Sendak, 1979). En este trabajo se han considerado ocho elementos "facilitadores" agrupados en capital humano, estructural, relacional y ecosistema, que se recogieron mediante entrevista personal con expertos de varias naciones durante la organización en Barcelona, en 2007, del 8th European Conference on Knowledge Management, y se han calificado tanto desde una perspectiva positiva y "facilitadora" como negativa y "obstaculizadora". La Tabla 1 recoge los párrafos de los factores relevantes de CI para la gestión de la innovación y la transformación de sus variables codificadas según un sistema vectorial (1, -1).

Se tomó una muestra de estudiantes y se dividió de forma aleatoria en dos grupos de igual tamaño y, a cada uno de los grupos, se le suministró un diseño experimental distinto. Se ha asumido que el entrevistado conoce la situación de la empresa en España, ya sea fruto de la información recibida durante los cursos de economía y gestión de empresas o de otras fuentes externas directas e indirectas y, además, que exista un alto grado de homogeneidad dentro del grupo. Para ambos escenarios se han construido perfiles con los "facilitadores" tanto positivos como negativos propuestos en la Tabla 1, combinados según los diferentes diseños experimentales. Y, para su evaluación, se ha pedido a los participantes que los puntúen en una escala de semejanza (de 1 al 10), según que el perfil representara peor o mejor la realidad percibida de la empresa española. Se trata, por tanto, de un tipo de experimento similar a los utilizados en la detección de oportunidades y amenazas del entorno empresarial que condicionarán su conducta (Lohrke, Holloway y Woolley, 2010). Los experimentos se llevaron a cabo durante el curso 2007-2008.

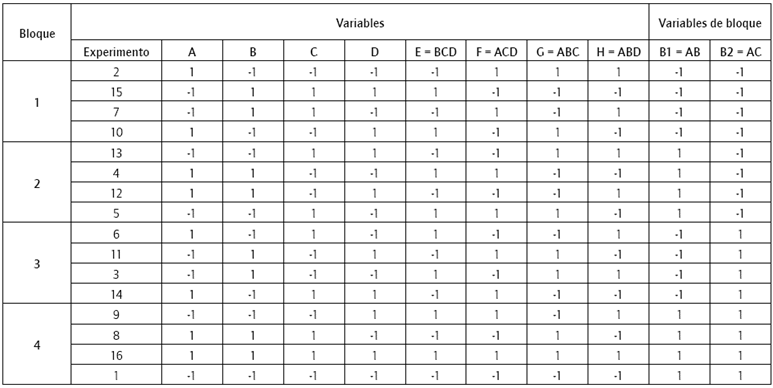

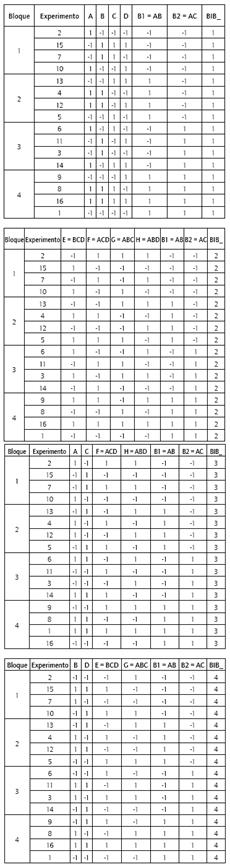

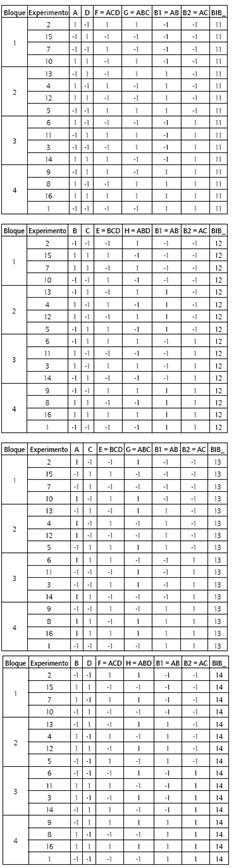

Para el primer grupo se utilizó un diseño factorial fraccionado, 1/6 del factorial completo, lo que representa 28-4 IV , es decir, 16 escenarios. Para su construcción se recurrió a un generador de diseño que confunde cuatro de los factores con las interacciones de tercer grado, E = ± BCD, F = ± ACD, G = ± ABC, H = ± ABD, lo que indica que los niveles de los factores de las cuatro últimas variables se construyen a partir del producto de los niveles de los factores de las cuatro primeras (por ejemplo, en la Tabla 2 se puede ver que en el experimento 2 el nivel de la variable E = -1 y, a su vez, es igual al producto de BCD, -1 x -1 x -1). El generador se ha tomado de Myers y Montgomery (2002). Dado que los perfiles están formados por protocolos verbales descritos en párrafos, se consideró que 16 escenarios aún eran demasiados para ser evaluados y se procedió a un diseño de bloques. En este caso se utilizaron como generadores de bloques B 1 = AB y B 2 = AC, construyendo bloques de cuatro escenarios, lo cual facilita la labor de evaluación del estudiante (por ejemplo, en la Tabla 2 se puede ver cómo en el bloque 1 el signo de B1 = AB, -1, para todos los escenarios agrupados en el mismo bloque). Este tipo de diseños se denominan de orden IV y generan, de forma eficiente, las estimaciones de los efectos principales, pero no de las interacciones de dos variables que estarán confundidas con el generador de bloques. La Tabla 2 muestra el primer diseño, donde 1 indica la versión positiva del "facilitador" y -1 la negativa.

En el segundo experimento se ha utilizado un diseño más complejo y desagregado, dadas las posibilidades que ofrece el diseño BIB de reducir el número de perfiles y, además, el número de variables o párrafos que definen cada perfil. Así, en este estudio, en lugar de valorar combinaciones de 8 variables "facilitadoras" expresadas por 8 párrafos en cada escenario, se ha pasado a evaluar solo 4 variables expresadas en cuatro párrafos. El objetivo era determinar si esta reducción del número de párrafos mejoraba el resultado del experimento medido tanto por el número de factores significativos como por el grado de ajuste del coeficiente de determinación corregido. El diseño propuesto ha sido fruto de la combinación de los dos generadores de diseños de bloques, uno basado en la confusión y otro en BIB. En esta investigación se ha utilizado el diseño de bloques incompletos "Plan 9A.6", formado por 8 variables que se presentan de cuatro en cuatro en cada perfil, en una combinación de 14 bloques, con una eficiencia de diseño el 86% y que tiene la siguiente estructura de generadores de bloque: (1,2,3,4) y (5,6,7,8); (1,3,6,8) y (2,4,5,7); (1,2,5,6) y (3,4,7,8); (1,4,5,8) y (2,3,6,7); (1,2,7,8) y (3,4,5,6); (1,4,6,7) y (2,3,5,8); (1,3,5,7) y (2,4,6,8) (Kuehl, 2001, p. 331). El procedimiento para construir el diseño combinado ha sido el siguiente: partiendo de un diseño factorial fraccionado en bloques de cuatro, tal y como se describe en la Tabla 2, se le ha aplicado el "Plan 9A.6" de tal manera que, por ejemplo, si el primer generador de bloque es (1,2,3,4) en la primera tabla del diseño combinado solo se han contemplado las cuatro primeras variables (A,B,C,D), y si el segundo generador es (5,6,7,8), esto indica que en la segunda tabla solamente se han utilizado las cuatro últimas variables (E,F,G,H), y así sucesivamente. El resultado es un diseño complejo constituido por 14 tablas que se presentan en el Anexo y que representa una innovación en la literatura.

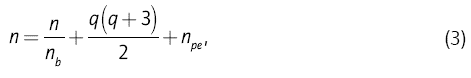

Para determinar el número mínimo de réplicas que se deben evaluar para que el resultado sea significativo se ha seguido la "ecuación de recurso" propuesta por Mead (1988). En esta ecuación se requiere, al menos, n experimentos en bloques de tamaño n b , donde

Siendo q el número de variables y n pe , un pequeño número (típicamente entre 5 y 15), para generar más grados de libertad. El resultado indica que el número de escenarios mínimos es 78 y, además, sirve para indicar el tamaño mínimo de la muestra. No obstante, para el trabajo de campo del primer experimento se han utilizado 4 bloques de 4 escenarios cada uno replicado 28 veces y evaluados por 112 estudiantes, recogiéndose los resultados de 448 escenarios. Para el segundo experimento se utilizaron los 14 diseños de 4 bloques cada uno, es decir, un total de 56 bloques, evaluado cada uno por dos estudiantes, en total 112, recogiéndose también resultados de 448 escenarios evaluados. Los cuestionarios fueron cumplimentados durante el periodo de clase y se obtuvieron como resultado las puntuaciones sobre el grado de semejanza del escenario frente al objeto real. El peso de los factores se estimó mediante un análisis de regresión por mínimos cuadrados ordinarios, obteniéndose funciones de semejanza parciales y los valores de las β que representan la importancia que tiene cada factor en ajustar el perfil a la realidad (Green y DeSarbo, 1978).

Resultados

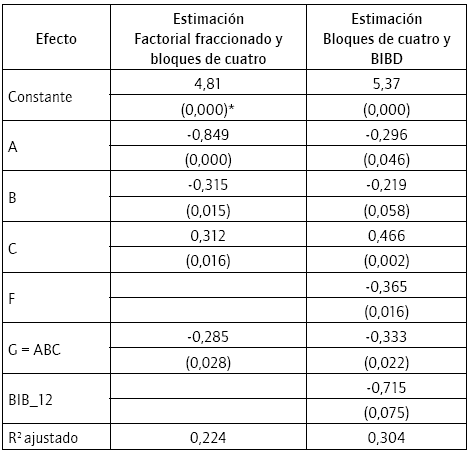

La Tabla 3 recoge los resultados comparados de los dos experimentos. En primer lugar, se puede apreciar que en ambos experimentos los signos de las variables son los mismos y el peso de los factores parecidos en la mayoría de los atributos, siendo esto un indicio claro de la validez interna del experimento. Por otro lado, en el modelo del diseño factorial fraccionado en bloques el número de factores significativos ha sido de 4 (A, B, C y G) de los 8 considerados, más la constante, mientras que en el diseño BIB se ha conseguido estimar 5 (A, B, C, F y G) más la constante y una posible interacción (BIB 12), representando una mejora del 50% en el número de variables significativas. Respecto a la bondad del ajuste, el diseño BIB presenta una varianza explicada superior al diseño factorial fraccionado en bloques (R 2 adj = 0,304, frente a 0,224 para el diseño fraccional), lo que representa una mejora del 35%. Ninguna de las variables de bloqueo ha aparecido significativa, tal y como suele ser habitual en los experimentos, a excepción de BIB_12, para el diseño BIB, lo que hace sospechar la existencia de una posible interacción aunque, en esta ocasión, no es posible su interpretación al estar confundida con las variables de diseño AB y AC.

Todos estos indicios apuntan hacia una mejora del rendimiento como consecuencia de reducir el número de atributos que debe evaluar cada sujeto dentro de un mismo conjunto de elección. Esto sugiere, por tanto, que el grado de complejidad atribuido a un número elevado de atributos perjudica el rendimiento del modelo de ajuste y confirmándose la hipótesis que los diseños en bloques combinados, que reducen el número de atributos o variables que compone cada perfil, mejoran la consistencia del proceso de elección reflejado en el incremento de variación explicada. No obstante, se esperaban unos resultados más contundentes, ya que la carga cognitiva se había reducido a la mitad y, seguramente, el reducido tamaño de la muestra puede haber condicionado estos resultados.

Una de las diferencias más relevantes del análisis comparativo de diseños experimentales es la dispersión del peso de los factores. Por ejemplo, si se consideran solo los factores principales de cada modelo, se puede apreciar una mayor dispersión en la distribución del peso de los factores en el diseño BIB (cinco factores en un recorrido es 0,831) frente al factorial fraccionado en bloques (cuatro factores en un recorrido de 1,161). Por tanto, de estos resultados subyace que un incremento en la complejidad en el conjunto de elección no solo incrementa el error en los resultados sino que, además, se produce la adopción de heurísticas simplificadoras, según la cual cuanto mayor es el número de factores que intervienen en el conjunto de elección menor ha sido el número de los considerados para su valoración, y eso deriva en una mayor concentración de las puntuaciones. Los resultados de este trabajo apuntan que el cambio en el peso de las variables obedece también a cambios en la estrategia de decisión. Trabajos recientes inciden en esta misma línea apuntando la necesidad de estudiar los cambios de estrategia de decisión como consecuencia de los cambios de complejidad derivados del diseño (Dellaert, Donkers y Van Soest, 2012). Los resultados muestran que ignorar el componente de error, derivado de la complejidad del diseño, hace que se generen valoraciones más extremas en algunos factores del diseño experimental.

Aunque el objetivo del estudio es una comparación de dos diseños experimentales, se comentan brevemente algunos de los resultados del caso de estudio. Los resultados obtenidos de la estimación de los dos modelos muestran una percepción muy pesimista sobre la gestión del capital intelectual en la industria española de los estudiantes de Ingeniería de Telecomunicaciones. Tanto en el modelo BIBD con cinco estimadores de las variables independientes como en el modelo factorial fraccionado con cuatro, solo en uno de los factores, el C (BIBD: β = 0,466, p < 0,01; Factorial fraccionado: β = 0,312, p < 0,05) es significativo el nivel positivo que determina el carácter "facilitador" mientras que en el resto de factores son significativos los niveles negativos. El factor C, en su nivel positivo, viene definido por la frase "Existe y se estimula la conexión y el intercambio de ideas entre los distintos departamentos para favorecer el conocimiento del mercado. La empresa cuenta con mecanismos de retroalimentación que hacen posible ese conocimiento y aprendizaje" y dando a entender que los entrevistados ven a la industria española interesada por la innovación comercial y atentos al mercado. El resto de factores significativos lo han sido en la acepción negativa, el factor A (BIBD: β = -0,849, p < 0,001; Factorial fraccionado: β = -0,249, p < 0,05) concretado en la frase "El conocimiento técnico es un elemento clave; guía el desempeño individual y empresarial. El espíritu curioso, la creatividad y la propensión al riesgo son una rareza en el ámbito de trabajo", es decir, se considera que la industria apuesta más por la productividad y la eficiencia que por la creatividad; la B (BIBD: β = -0,315, p < 0,05; Factorial fraccionado: β = -0,219, p < 0,1), "Pocas personas tienen conocimientos sobre los conceptos y factores que guían y/o determinan el desempeño empresarial, así como de las principales herramientas de gestión" lo que indica una visión obscurantista donde la información relevante está reservada a unos pocos; la F, aunque solo es significativa para el modelo BIBD (β = -0,365, p < 0,5) definida por la frase "El logro de resultados financieros superiores orienta el comportamiento de los directivos y empleados, con independencia de los medios utilizados para alcanzarlos", es decir, que en la industria el fin financiero justifica cualquier medio para alcanzarlo y, por último, la G (BIBD: β = -0,285, p < 0,05; Factorial fraccionado: β = -0,333, p < 0,05) "La fortaleza real y principal de la empresa está en la construcción interna de competencias y en la eficacia de sus procesos, con independencia de la cantidad y calidad de las relaciones que ésta posea", indicando una visión de la organización centrada exclusivamente en las estructuras internas sin el deseo de abrir canales relacionales fuera de la organización. En definitiva, el dominio de los factores "obstaculizadores" define una percepción mecanicista y cerrada de la organización, centrada en alcanzar la máxima productividad y el beneficio a corto plazo, interesada, eso sí, en el mercado pero sin ningún escrúpulo a la hora de actuar sobre él.

Según la proposición realizada por Normann (2001), la percepción de la realidad que tienen los futuros ingenieros les va a condicionar sobre el tipo de conocimientos y habilidades que consideran necesarios adquirir para poder integrarse como equipo humano en la industria. No obstante, esta visión tan pesimista de la gestión del capital intelectual puede obedecer al hecho de que el experimento se ha realizado con una muestra de estudiantes y no con empleados de la industria, lo que le resta validez externa (Nevin, 1974). Pero tampoco se puede obviar que se trata de dos muestras aleatorias enfrentadas a unos diseños experimentales muy complejos que contribuyen a una alta validez interna y al hecho de que, de las cinco variables significativas, solo una tenga signo positivo y, todo esto, en un entorno de pérdida de un 40% de estudiantes de Ingeniería de Telecomunicaciones (EVERIS, 2012).

Conclusiones

En la primera parte de este trabajo se han discutido algunos aspectos relacionados con el uso del AC como instrumento capaz de superar una serie de inconvenientes que presenta la autoevaluación retrospectiva en el estudio del proceso de toma de decisiones empresariales. No obstante, el AC con el formato de párrafos descriptivos también presenta inconvenientes relacionados con la complejidad cognitiva derivada del diseño. Estos conceptos se han discutido a partir de las aportaciones realizadas por la literatura donde no solo se presentan los componentes que influyen y su efecto en los resultados, sino que también se apuntan posibles soluciones para prevenir o reducir tales influencias. No obstante, la mayoría de estudios que analizan el diseño y el formato en la presentación de estímulos en AC se han centrado en el análisis de las descripciones verbales de los atributos y, cabe destacar, los pocos trabajos que analizan las descripciones en párrafos, cuya comprensión requiere más tiempo y esfuerzo.

La utilización de estímulos descritos mediante párrafos de texto representan un tipo de formato difícil de utilizar en los estudios del comportamiento del consumidor, ya que la lógica dominante en sus procesos de elección está cada vez más alejada de la racionalidad y de los modelos compensatorios, como son los estados de flujo (Csikszentmihalyi, 1990) o de intuición (Bargh y Ferguson, 2000). Aunque Hauser y Urban (1977) mostraron la bondad de este tipo de presentaciones en párrafo para definir conceptos de productos mucho más realistas, también señalaron que el número de estímulos tienen que ser muy reducidos para recoger respuestas coherentes de los consumidores.

Sin embargo, su uso puede tener mucha más utilidad para estudiar procesos de decisión más complejos como son las decisiones empresariales. Y en los que se consideran sujetos con una capacidad cognitiva elevada, capaces de diferenciar y evaluar escenarios complejos formados por conjuntos de frases. Para este marco de referencia también los estudiantes universitarios pueden ser público objetivo, ya que están acostumbrados al análisis y resolución de problemas.

A continuación, se ha llevado a cabo un experimento para encontrar la posible conexión entre la selección de método de diseño y sus resultados. En conclusión, se podría afirmar que la utilización de los dos diseños presenta diferencias moderadas en los ajustes del modelo (un 35% la variación explicada). Sin embargo, los resultados son más contundentes en cuanto al número de factores explicados por el modelo (un 50% el número de variables relevantes recogidas) y, sobre todo, por las diferencias en el peso de los factores. En este sentido, se confirmaría la hipótesis que los diseños en bloques combinados que reducen el número de atributos o variables que componen cada experimento, mejoran la consistencia del proceso de elección reflejado en el incremento de variación explicada y factores significativos. Sin duda, el resultado más sorprendente es que diseños distintos perfilan estrategias de respuesta diferentes.

Se tomó una muestra de conveniencia de 224 (112 + 112) estudiantes de Ingeniería de Telecomunicaciones por razones de tiempo, dinero y organización. Aunque fueron asignadas de manera aleatoria a las dos condiciones experimentales y se trata de dos grupos homogéneos en cuanto a su estructura de edad y género, el hecho de que solo se hiciera un experimento siempre suscita la duda de si la diferencia en la respuesta obedece al experimento o a algún tipo de diferencias entre los grupos.

Una de las limitaciones se deriva del uso de experimentos desarrollados en un entorno controlado. Hempel y Daniel (1993) han criticado el uso de los experimentos de laboratorio, que se caracterizan por un entorno artificial y controlado por el experimentador, para generar inferencia estadística debido al sesgo en las decisiones que muestran los entrevistados respecto a los entornos naturales. En los procesos de toma de decisiones en entornos reales los individuos se enfrentan a diferentes fuentes de información que complican la decisión (por ejemplo: alternativas con componente de riesgo o incertidumbre, conflictos de intereses, actividades que interfieren, ruido, etc.), que probablemente conducen a una mayor extensión de reglas de decisión que el simple modelo compensatorio del experimento.

Por último, en este trabajo se ha introducido un diseño mixto combinando dos estructuras de bloque que permite mejorar la eficacia del AC al utilizar descriptores de los factores en frases. Sin embargo, una limitación de este trabajo está en el tamaño ajustado de la muestra que impide acabar de definir la significatividad de alguna de las variables principales. Y, por otro lado, la estructura del diseño en bloques de cuatro, que confunde los factores de segundo orden entre ellos y con el diseño de bloques que solo permite estimar los efectos principales. Una posible extensión sería la mejora del diseño aprovechando las réplicas para modificar la estructura de bloques, que permita no solo la evaluación de los factores principales, sino también de las iteraciones de segundo orden sin confusión. Draper y Guttman (1997) muestran cómo para un diseño 2 k se necesitan k2 k réplicas para estimar todos los efectos principales y las interacciones. Este es un tema en el que se está investigando.