Introducción

LAS PRUEBAS psicológicas son los instrumentos de medición por excelencia en psicologia. Además de su utilidad en la investigación son las herramientas que proveen información para sustentar el criterio profesional en diagnósticos, identificación de riesgos, planeación de estrategias de intervención, seguimiento de procesos o tratamientos, etcétera. Los resultados de las pruebas se utilizan como información para sustentar evaluaciones que apoyan decisiones que afectan la vida de los evaluados, por lo tanto es crucial que el profesional seleccione las pruebas que tengan la calidad técnica que respalde su uso en la población de interés y para el propósito del proceso evaluativo.

Varios autores (Bartram, 1998; Muñiz et al., 2001; Evers et al., 2012, entre otros) han reconocido que el desconocimiento de aspectos técnicos referentes a la fundamentación teórica y estadistica de las pruebas es uno de los principales determinantes del uso indiscriminado de las mismas y las inadecuadas prácticas profesionales, lo cual afecta la validez de las interpretaciones de los resultados y las decisiones que ellas sustentan.

Una de las estrategias usada para hacerle frente a esta situación es la elaboración y divulgación de guias o recomendaciones técnicas como Standards for Psychological Testing de la American Educational Research Association, la American Psychological Association y el National Council on Measurement in Education (1999, 2014), las Guidelines de la Internacional Test Commission (2001, 2014, 2016, 2018, 2019) o la norma ISO 10667 (Organización Internacional de Normalización, 2011); esta última, desarrollada por iniciativa de los representantes alemanes en la Organización Internacional de Estandarización, para el ámbito laboral.

Otra estrategia implementada por algunas asociaciones gremiales de psicologia para promover buenas prácticas en el uso de pruebas es la evaluación de su calidad técnica y la amplia divulgación de sus resultados, de manera que los profesionales dispongan de información precisa para seleccionar las pruebas (Prieto & Muñiz, 2000; Evers et al., 2012).

Generalmente los sistemas de evaluación de la calidad de las pruebas se desarrollan y administran por parte de mesas de trabajo, comités, institutos anexos o divisiones de las organizaciones que regulan el ejercicio profesional, y requieren articular decisiones politicas, requerimientos técnicos y consideraciones éticas con recursos económicos, humanos e institucionales. Por tanto, el desarrollo de un sistema de evaluación conlleva discusiones, acuerdos y esfuerzos gremiales que se concretan en una infraestructura que permita la gestión del proceso por parte de organizaciones con la autoridad, el reconocimiento y la capacidad para adelantarlo y para divulgar los resultados de las evaluaciones.

El aspecto central en cualquier sistema de evaluación de las pruebas es la adopción de un modelo que defina los criterios técnicos para valorar la calidad de las mismas. Directrices como los estándares antes mencionados de la American Educational Research Association (AERA), la American Psychological Association (APA) y el National Council on Measurement in Education (NCME) o las guia de la International Test Commission (ITC) proponen lineamientos útiles para este propósito, pero deben ser traducidos en términos de indicadores de calidad adaptados a un contexto particular, generalmente nacional.

Aunque el primer comité de evaluaciones nació en el seno de la APA en 1895 (Evers, 2012); solo a partir de mediados de siglo XX se han desarrollado de algunos sistemas de evaluación de pruebas. El primero proceso de revisión de pruebas surgió en Estados Unidos gracias a la iniciativa del entonces estudiante de maestria de la Universidad de Columbia, Oscar Krisen Buros, quien convocó a un grupo profesional para revisar algunas pruebas, estas evaluaciones se publicaron en 1938 bajo el titulo MentalMeassurement Yearbook (Buros, 1938), dando origen a la publicación con mayor trayectoria de esta naturaleza. Hoy se publica de manera periódica cada tres anos por The Buros Center for Testing, del Departamento de Educación de la Universidad de Nebraska, cuenta con 20 ediciones publicadas en inglés y más recientemente inició una serie sobre pruebas publicadas en español (Schlueter, Carlson, Geisinger & Murphy, 2013; Schlueter, Anderson, Carlson & Geisinger, 2018).

En sus origenes el sistema Buros se basaba en una metodologia de foro con participación de diferentes expertos que valoraban los aspectos de calidad de las pruebas. Hoy se adelanta un procedimiento sistemático de 11 pasos que van desde la identificación de las pruebas a revisar hasta la revisión y aprobación de los conceptos técnicos por parte de los editores y la publicación de resultados. En la evaluación participan expertos de diferentes nacionalidades, quienes reciben guias que orientan el desarrollo de la revisión, tomando en consideración los estándares ya citados de la APA, la AERA y el NMEC. El concepto técnico sobre la prueba evaluada está compuesto por cinco apartes: descripción, resumen del desarrollo de la prueba, fundamentación técnica, comentarios sobre fortalezas y debilidades y conclusiones de la revisión (Carlson & Geisinger, 2012, Buros Center of testing, 2014).

A lo largo del siglo pasado y lo corrido del actual se han desarrollado algunos sistemas nacionales en diferentes paises; una revisión de algunos de ellos se encuentra en León (2017). Aunque todos tienen elementos similares, cada uno adoptó un modelo de calidad que se concreta en un instrumento o protocolo para el desarrollo de la evaluación. La Tabla 1 muestra las principales categorias de contenidos de algunos de ellos, aunque en la actualidad varios paises han adoptado el instrumento de la European Federation of Psycchologists' Association (EFPA).

En primer lugar, el sistema alemán cubre una serie de pasos que van desde selección de las pruebas hasta la publicación de la valoración, incluyendo una revisión inicial para verificar que la prueba cumple con unos criterios básicos para ser evaluada. Una vez superada esta fase, se adelanta el proceso de evaluación utilizando un modelo basado en la norma alemana DIN 33430 (ver https://www.din33430portal.de/din33430/portal) que formula criterios de calidad para los procesos de evaluación (DIN, 2005 citado en Kersting & Hornke, 2006). Este modelo organiza los criterios de evaluación de las pruebas en ocho categorias (Hagemeister, Kersting, & Stemmler, 2012), como se muestra en la Tabla 1.

El modelo español, inicialmente propuesto en el 2000 (Prieto & Muñiz, 2000), es un formulario muy exhaustivo compuesto por tres partes: Descripción de la prueba, valoración de las caracteristicas de la prueba y valoración final. La primera parte contiene 31 items con información sobre nombre de la prueba, autor, constructo medido, ámbito de aplicación, etcétera. La segunda parte incluye indicadores sobre la calidad de los materiales y los items, la fundamentación teórica, los procesos de adaptación o traducción, la confiabilidad, validez y las normas de calificación. Finalmente, se incluye una valoración general que recoge los principales comentarios e impresiones de los evaluadores.

Uno de los sistemas de referencia en Europa es el holandés, administrado por el Comité Holandés de Pruebas (Dutch Committee on Testing, COTAN) de la Asociación Holandesa de psicologia (Dutch Psychological Association, NIP). Su modelo de evaluación ha tenido cinco actualizaciones desde la publicación de 2006. La más reciente organiza los criterios de evaluación en siete categorias que incluyen, además, de los criterios de confiabilidad, validez y normas, la calidad de los materiales de la prueba y la compresibilidad del manual (Evers, 1996; Evers, Sijtsma, Lucassen & Meijer, 2010).

El modelo de la Sociedad Británica de Psicologia (British Psychological Society, BPS) ha puesto su énfasis en la cualificación de los usuarios de pruebas; sin embargo, en ese proceso de desarrollaron estrategias para brindar a los profesionales, información de calidad sobre las pruebas (Bartram, 1996, 1998). El primer modelo de 1990 consistia en una publicación de la revisión de varias pruebas en la que se evaluaba la calidad de los materiales, la confiabilidad, la validez y las normas de calificación; sin embargo, a partir de la publicación del modelo de la EFPA, la Sociedad Británica decidió adoptar este modelo (Lindley & Bartram, 2012).

Con base en la revisión de los modelos de evaluación de varios paises europeos, la EFPA desarrolló un modelo de evaluación de pruebas (Bartram, 2002) que ha tenido varias revisiones durante las dos décadas de este siglo. La última actualización publicada en 2013 (Evers, et al, 2013) está compuesta por tres secciones, una descriptiva, una valorativa y las referencias bibliográficas utilizadas para la evaluación, como aparece en la Tabla 1. En la primera parte se describe detalladamente la prueba desde su identificación hasta las condiciones y costos para acceder a ella. Incluye la información sobre sus contenidos, usos y población a la que se dirige; composición, número y tipo de items; forma de aplicación, calificación y transformación de puntajes; y formas y caracteristicas de los reportes de resultados. En la segunda parte se incluyen indicadores que son calificados en una escala liket de 0 a 4 y evalúan la calidad de la información presentada, de los materiales de prueba y de los informes generados por computadora, asi como los aspectos técnicos involucrados en la obtención de las normas de calificación y de las evidencias de fiabilidad y validez.

Actualmente el modelo ha sido acogido por varias asociaciones nacionales de psicologia de paises europeos, entre ellas las de los cuatro modelos presentados aqui: España, Alemania, Holanda y Reino Unido.

El único sistema suramericano es el del Consejo Federal de Psicologia de Brasil (Sistema de Avaliação de Testes Psicológicos, SATEPSI). A diferencia de los sistemas europeos, SATEPSI tiene carácter restrictivo y no solamente informativo, ya que solo las pruebas que han pasado el proceso de evaluación técnica y han obtenido resultados satisfactorios pueden ser legalmente usadas en el pais (Conselho Federal De Psicologia, 2003). El modelo de revisión de calidad sigue un protocolo de tres partes que examinan seis aspectos de calidad a partir de indicadores bien definidos. Según Porto Noronha (2012), este protocolo se basa en el modelo propuesto por Prieto y Muñiz (2000) en España y considera las directrices técnicas de la ITC (2001) y de la APA (1999). Una particularidad de este modelo es que el protocolo puede ser utilizado con pruebas proyectivas.

Aunque los modelos revisados difieren en su nivel de estructuración, todos evalúan contenidos similares sobre todo en lo referente a la justificación teórica y técnica de la prueba. Este trabajo tuvo como objetivo desarrollar y pilotear un instrumento para evaluar las calidades técnicas de las pruebas publicadas en español y en particular, las usadas en Colombia.

Método

El trabajo adoptó la estrategia metodológica y los perfiles de participantes propuestos por Herrera (2009) como plan de acción de la División de Medición, Evaluación y Estadistica Aplicada del Colegio Colombiano de Psicólogos (COLPSIC). El procedimiento cubrió tres fases: Desarrollo de la primera versión del instrumento, evaluación por pares de la versión del instrumento y pilotaje y conformación de la versión definitiva del instrumento.

Desarrollo de la versión preliminar

Para la definición de los criterios e indicadores de calidad se buscó conformar un grupo de profesionales de las diferentes regiones del pais. El equipo de trabajo se conformó mediante invitación directa a los profesionales que cumplieran con el perfil previamente establecido, se les convocó a actividades de capacitación y, una vez acordada la participación en el proyecto, se solicitó el respectivo aval institucional. 31 profesionales participaron en las sesiones de capacitación y, finalmente, se conformó un equipo de 18 psicólogos profesionales, además de las autoras, con experiencia en psicometria o evaluación psicológica, docentes e investigadores vinculados a 12 universidades de 6 regiones del pais, o al Instituto Colombiano para la Evaluación de la Educación - ICFES.

Se desarrollaron dos talleres de capacitación con profesores internacionales, una sobre el modelo de construcción de pruebas con modelo análisis IRT con apoyo del mapa conceptual (Curso taller: Introduction irt: the rasch model for measurement) y otro especifico sobre la experiencia brasilena en evaluación de calidad de las pruebas (Curso Consideraciones sobre la calidad de las pruebas. Desarrollo de los procesos de evaluación de pruebas psicológicas).

La primera versión del instrumento se desarrolló en trece sesiones presenciales de trabajo. En las primeras tres sesiones se presentó un panorama general de los instrumentos utilizados en varios paises, se definió la estructura general del instrumento colombiano y se conformaron cuatro mesas de trabajo para definir los criterios e indicadores de los cuatro últimos. A partir de la cuarta sesión de trabajo se presentaron y discutieron los avances de cada mesa de trabajo sobre los criterios de calidad, los indicadores, descriptores de los niveles de cumplimiento y la escala de calificación.

Revisión por pares

La primera versión del instrumento se sometió a revisión por parte de un grupo de cinco jueces, tres profesionales de amplio reconocimiento nacional y trayectoria en medición y evaluación, y dos internacionales, lideres de los procesos de evaluación de calidad de las pruebas, en sus respectivos paises. A los jueces se les pidió que revisaran el contenido del instrumento, la pertinencia de los indicadores y la claridad y graduación de los niveles de cumplimiento de los descriptores de cada indicador. Después de finalizada la revisión, se adelantó una sesión conjunta de los jueces con el equipo de trabajo para discutir y aclarar las observaciones y sugerencias de los jueces.

Una vez ajustada esta primera versión, se sometió a una nueva revisión por parte de un panel de expertos con participación de once profesionales expertos en psicometria o evaluación, vinculados a diferentes instituciones de diez ciudades del pais, quienes conformaron el equipo de trabajo para el diseño del Sistema de Evaluación de la Calidad de las Pruebas Psicológicas, en desarrollo actualmente. Los resultados de estas revisiones permitieron realizar ajustes tanto al instrumento y al instructivo para su uso.

Pilotaje y conformación de la versión final del instrumento

La primera versión del instrumento fue sometida también a una prueba piloto mediante la aplicación en la valoración de seis pruebas se-leccionadas con base en los resultados del estudio para identificar los instrumentos más usados por los psicólogos en el pais (Herrera & León, 2015). Se seleccionaron seis pruebas de las más usadas y se conformó un grupo de evaluadores diferente al que habia participado en el desarrollo del instrumento, de manera que cada prueba fuera evaluada por un experto en el área de aplicación de la misma y un experto en psicometria. Los evaluadores participaron en un taller de capacitación sobre uso del instrumento y se les pidió que anotaran todas las observaciones o dudas que surgieran durante el proceso. Estas observaciones permitieron hacer nuevos ajustes tanto al instrumento como al instructivo que lo acompaña.

Resultados

Versión preliminar y pilotaje del instrumento

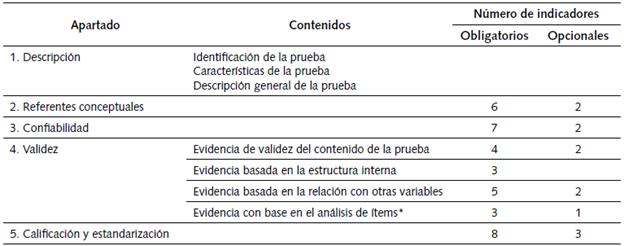

El primer resultado de este trabajo estuvo constituido por la versión preliminar del instrumento para la evaluación de la calidad de las pruebas y un instructivo con los fundamentos conceptuales y técnicos necesarios para evaluar los indicadores, asi como las instrucciones de uso del instrumento (Herrera, et al., 2018a). La primera versión del instrumento quedó compuesta por los cinco (5) apartados que aparecen en la Tabla 2. El primero de ellos es una ficha técnica que describe en detalle la prueba evaluada, y los cuatro restantes incluian 47 indicadores de calidad que valoran el nivel de cumplimiento de cada uno de ellos con base en la información reportada en el manual y material de prueba.

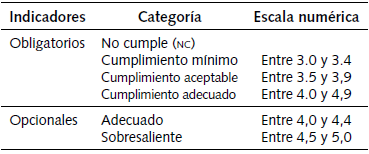

Uno de los aspectos caracteristicos de este instrumento es la inclusión de indicadores opcionales y obligatorios. Los obligatorios recogen información que se considera indispensable para garantizar un nivel de calidad aceptable en una prueba, cada uno de ellos se valora en una escala de cuatro niveles de cumplimiento: no cumple, cumplimiento minimo, aceptable y adecuado. Se esperaria que una prueba debiera cumplir por lo menos en el nivel minimo todos los indicadores obligatorios. Los indicadores opcionales hacen referencia a condiciones deseables en una prueba pero que en la actualidad no son muy frecuentes en los desarrollos de estas y por tanto no suelen estar incluídos en los manuales. Estos solo tienen dos niveles de cumplimiento: adecuado y sobresaliente y pueden ser calificados con puntuaciones entre 4,0 y 5,0, como se muestra en la Tabla 3. La versión preliminar del instrumento contenía 32 indicadores obligatorios y 15 opcionales.

Los resultados de las revisiones por pares y del pilotaje de la versión preliminar evidenció la necesidad de hacer ajustes importantes sobre todo en tres aspectos. En primer lugar, se aumentó el número de ítems de la ficha técnica que pasó de 10 a 14, con el fin de recoger información detallada sobre la composición de la prueba en términos de dimensiones del constructo medido, número y tipo de ítems en cada una de ellas y procedimientos para las adaptaciones o traducciones en los casos en que aplica. En segundo lugar, se aumentó de 32 a 36 el número de indicadores obligatorios, se disminuyó de 15 a 12 el número de indicadores opcionales y se precisó la redacción de los criterios de calificación en 28 de ellos. Los indicadores nuevos hacen referencia a la actualización de los referentes conceptuales y de los estudios que soportan empíricamente la confiabilidad y la validez de la prueba, así como a las características de la muestra normativa y la actualización de las tablas de calificación; por el contrario, se disminuyó el número de indicadores relacionados con el análisis de los ítems por considerar que algunos de ellos parecían repetidos o no resultaban aplicables para la mayoría de las pruebas. Finalmente, una de las modificaciones más notorias fue la ampliación de las explicaciones técnicas y conceptuales del instructivo para uso del instrumento con el fin de detallar los criterios de calificación y reducir las diferencias que se observaron entre los profesionales que participaron en el pilotaje en cuanto a la interpretación de los mismos (León, 2017).

Descripción del instrumento final

La estructura general del instrumento final se muestra en la Tabla 2 y los indicadores y criterios de calificación aparecen en el anexo. El instrumento definitivo incluye 48 indicadores de calidad, de los cuales 36 son obligatorios y 12 opcionales, como se muestra en la Tabla 2.

Tabla 2 Estructura general del instrumento definitivo de evaluación de la calidad técnica de las pruebas psicológicas

Fuente: Adaptado de (Herrera et al., 2018b)

En lo referente a los contenidos específicos evaluados por el instrumento, en el anexo aparecen los indicadores y los descriptores de los niveles de cumplimiento para cada categoría en cada uno de ellos. El segundo apartado se ocupa de valorar la información que el manual brinda al usuario de la prueba sobre los referentes conceptuales que la sustentan. Los indicadores obligatorios valoran la información sobre el constructo que evalúa la prueba, su definición conceptual y operacional, la definición de las dimensiones que lo componen y su justificación de uso para la población objeto. Los dos indicadores opcionales se refieren a información que permite identificar el constructo como parte de un desarrollo estructurado científicamente, donde se entiende la evolución del concepto desde una perspectiva amplia.

El tercer apartado evalúa la información sobre los estudios de confiabilidad. Los indicadores obligatorios valoran la información sobre las fuentes de error aleatorio y el diseño y los resultados de los estudios empíricos que sustentan la precisión de la medida. Los indicadores opcionales hacen referencia a la justificación y la coherencia en la selección del diseño del estudio o estudio de confiabilidad y del estadístico o estadísticos para estimarla.

Para la definición de los indicadores de validez se adaptó la categorización de evidencias de validez propuesta por los últimos estándares de AERA, АРА, NOME (2014). Este apartado incluye entonces cuatro subapartados según el tipo de evidencia de validez: relacionada con el contenido de la prueba, basada en la relación con otras variables, relacionada con estructura interna de la prueba y evidencia sobre el análisis de ítems. Los indicadores del último subapartado solo se califican si la prueba evaluada se compone de ítems o tareas.

Finalmente, el apartado 5 evalúa aspectos relacionados con el estudio o estudios que soportan la construcción de las tablas de calificación y la precisión de la información para calificar, trasformar los puntajes y reportar los resultados. Los indicadores obligatorios valoran la claridad en la definición de la población objeto, así como la calidad de la muestra normativa y los procedimientos para transformar e interpretar los puntajes obtenidos.

Conclusiones

El instrumento desarrollado es producto del trabajo de un amplio número de profesionales de todo el país, expertos en medición y evaluación o en alguna de las áreas aplicadas de la psicología, y por tanto recoge los acuerdos, productos de muchas discusiones, sobre las condiciones técnicas mínimas que un manual de prueba debería reportar para considerar que la misma cuenta con una calidad técnica adecuada. Además, dado que el desarrollo del instrumento se basó en una revisión cuidadosa de los modelos existentes a nivel internacional, recoge y capitaliza dichas experiencias.

A pesar de que uno de los propósitos del equipo de trabajo que participó en la primera fase el estudio fue desarrollar una herramienta de fácil uso para la mayoría de los profesionales de la psicología, los resultados de la aplicación piloto mostraron que su adecuado manejo implica una lectura detallada del manual técnico y una adecuada formación en temas relacionados no solo con el uso de las pruebas, sino con algunos conceptos y metodologías propias de la psicometría. A futuro se espera que el grupo de evaluadores esté conformado por profesionales que reciban una capacitación específica en el uso del instrumento y los elementos conceptuales y metodológicos que sustentan los criterios de calificación.

Además, aunque el objetivo principal del instrumento es proponer una herramienta que permita proveer información relevante para que los profesionales dispongan de elementos técnicos que apoyen su decisión sobre la elección de las pruebas en su ejercicio profesional, este puede convertirse en una guía que ayude a orientar la formación en psicometría por parte de los programas de psicología. Si bien el instructivo que acompana al instrumento (Herrera et al., 2018b) no pretende ser un texto de psicometría o de evaluación, ni ser exhaustivo en el tratamiento de los temas, recoge elementos técnicos que cualquier usuario de pruebas debería conocer.

En lo referente a los resultados de las evaluaciones piloto de las seis pruebas más usadas, aunque el objetivo del ejercicio era pilotear la claridad y la comprensión del instrumento, vale la pena destacar dos resultados: Una amplia disparidad de los resultados en los cuatro apartes valorativos del instrumento, y la ausencia de tablas de calificación levantadas con muestras normativas colombianas en los manuales técnicos evaluados.

Finalmente, vale la pena destacar el avance que representa para el país contar con una primera versión de un Instrumento para Evaluar las Calidades Técnicas de las Pruebas adecuado para obtener información sobre los instrumentos que usan los profesionales en ejercicio. Aunque seguramente serán necesarias varias actualizaciones antes de disponer de un modelo maduro, este instrumento, producto de un trabajo colectivo muy arduo y que recoge muchas discusiones y mirada diferentes de los aspectos deseables en la principal herramienta de trabajo de los psicólogos, constituye una herramienta muy útil que seguramente impactará el ejercicio profesional en lo relacionado con el uso de pruebas.