Un número indeterminado de sistemas algorítmicos continuamente extraen y procesan datos sobre nuestros gustos, prácticas y preferencias, con el fin de encasillarnos en perfiles y recomendarnos productos de forma personalizada. Dentro del emergente campo de estudios críticos de datos y algoritmos (Boyd y Crawford, 2012; Iliadis y Russo, 2016; Kitchin y Lauriault, 2018; Pasquale, 2015; Tello, 2020) se ha indagado profusamente en los procesos de minería de datos y los propios sistemas algorítmicos, dejando de lado muchas veces las percepciones y experiencias que las personas desarrollan en su cotidianidad al respecto. A la fecha, permanece poco explorado cómo las personas sienten y comprenden los procesos de datificación y los modos en que los sistemas algorítmicos median en su vida cotidiana (Kennedy, 2018).

Teniendo en cuenta el carácter propietario, opaco e inescrutable de los sistemas algorítmicos de las principales plataformas digitales, incipientes estudios en Australia y Europa han dado cuenta de las ambivalentes y oscilantes respuestas de las personas al preguntarles sobre sus percepciones al respecto. Se constata en tales estudios que sienten una falta de control sobre sus datos, que no comprenden bien cómo funcionan los sistemas algorítmicos y que desconocen a qué tipo de predicciones algorítmicas son sujetas, así como las implicancias concretas de tales sistemas en sus vidas (Andrejevic, 2014; Gran, Booth y Bucher, 2020; Kennedy, 2018; Kennedy, Elgesem y Miguel, 2017; Lupton y Michael, 2017; Pybus, Coté y Blanke, 2015; Ruckenstein y Granroth, 2020). Como han planteado Gran et al. (2020), el ser conscientes del funcionamiento y los impactos de los algoritmos de las plataformas y buscadores se ha convertido en una competencia crucial en la actualidad, aunque estaría distribuida de forma diferenciada en las sociedades contemporáneas.

Estos estudios han contribuido enormemente a valorar y estudiar las experiencias y afectos de las personas no expertas sobre los datos digitales y algoritmos. Sin embargo, salvo recientes excepciones (Siles et al., 2020), a la fecha permanecen desatendidas las voces, sensibilidades y relaciones de las personas en Latinoamérica con los sistemas algorítmicos de las grandes plataformas. Se vuelve crucial, entonces, comenzar a indagar cómo se experimentan, interpretan y problematizan en Latinoamérica las predicciones algorítmicas que muchas veces se producen desde marcos y lenguajes foráneos. Esto adquiere especial relevancia en una región en que persisten profundas desigualdades digitales y en donde se normalizan formas de colonialidad en el desarrollo y uso cotidiano de tecnologías digitales, imponiéndose límites epistemológicos y ontológicos que dejan a Latinoamérica de forma asimétrica con los polos de innovación digital del Norte Global, como Silicon Valley (Escobar, 2017; Ricaurte, 2018).

Para subsanar este vacío, en 2019 iniciamos el proyecto "Identidades algorítmicas" entre investigadores de la Pontificia Universidad Católica de Chile y la Universidad de Warwick (Reino Unido), con el propósito de indagar cómo personas de diferentes contextos -como Chile y Reino Unido- sienten, reaccionan y tematizan la extracción de datos digitales e inferencias algorítmicas sobre su personalidad, gustos y comportamientos. Ahora bien, en lugar de preguntar directamente a las personas sobre sus percepciones o niveles de conocimientos sobre algoritmos -como hi cieron varios de los estudios mencionados-, en el proyecto consideramos necesario explorar sus entendimientos y sentimientos con una aproximación inventiva y práctica (Lury y Wakeford, 2012; Lury et al., 2018). En la intersección de la computación, la sociología y el diseño, adoptamos un enfoque de "hacer crítico" (Ratto, 2011; DiSalvo, 2014; 2016) y diseño descolonial (Escobar, 2017; 2018; Fry, 2017), desde el cual se despliegan las herramientas del diseño, no para resolver problemas de manera rápida, sino para someter a la crítica las situaciones presentes y abrir preguntas y futuros alternativos, indagando acerca de las condiciones, relaciones y reacciones que generan ciertos temas públicos.

Con este enfoque, estamos "prototipando" (véase Corsín, 2018a) una aplicación que denominamos Big Sister, que emula los sistemas de perfilamiento y recomendación algorítmica de las grandes plataformas. A través de este prototipo, buscamos abrir espacios para un hacer, pensar y sentir descoloniales que problematicen los principios y lógicas coloniales en los cuales se fundan estos sistemas algorítmicos. El prototipado de esta aplicación se acompañó de entrevistas cualitativas con participantes voluntarios, con el objetivo de indagar y provocar problematizaciones en torno al creciente extractivismo de datos y a los múltiples procesos algorítmicos que median nuestras vidas cotidianas y que generalmente permanecen sin explicitación ni articulación. De esta manera, ideamos este proceso metodológico con Big Sister y las entrevistas, como un espacio para provocar y obtener reflexiones sobre nuestras relaciones cotidianas con datos y sistemas algorítmicos, y de esa manera ampliar el debate sobre las implicancias y posibilidades de estas tecnologías.

En este artículo exploramos cómo la experiencia del prototipado de una aplicación, hecho con un enfoque crítico y descolonial, puede avanzar hacia una aproximación "problematizadora" de la datificación y los sistemas algorítmicos en Latinoamérica. Para ello, nos concentramos en describir y reflexionar en torno al proceso de prototipado de Big Sister y algunos de los hallazgos preliminares con participantes de Santiago de Chile. Como argumentamos más adelante, el prototipo ha servido de dispositivo de investigación social en un doble sentido: por un lado, el proceso iterativo de prototipado nos ha permitido producir conocimiento con base en un hacer y deshacer práctico, reorientando servicios algorítmicos existentes para interrogar -con un enfoque descolonial- sus suposiciones, lógicas y límites. Por otro lado, el prototipo investigativo nos ha permitido acceder de forma novedosa a las experiencias, afectos y relaciones cotidianas de las personas con los sistemas algorítmicos. Yendo más allá del "universalismo de datos" y en línea con la agenda de investigación "Big Data from the South" (Milan y Trere, 2019), mostramos que existe una heterogeneidad de formas de habitar y habituarse a los datos y algoritmos, fuertemente vinculadas a las capacidades y contextos locales de las personas.

Recogiendo elementos de autores latinoamericanos, como el antropólogo Arturo Escobar, el comunicólogo ibero-colombiano Jesús Martín-Barbero y el educador brasileño Paulo Freire, discutiremos las capacidades descoloniales, provocativas y pedagógicas que activa el prototipo de Big Sister para una problematización de los algoritmos y datos digitales desde Latinoamérica. Como mostraremos, avanzar en perspectivas y herramientas descoloniales que permitan desnaturalizar la penetración de los sistemas algorítmicos y valorar los entendimientos y competencias que las personas no expertas generan en su relación cotidiana con tales algoritmos en los contextos plurales de Latinoamérica se vuelven cuestiones ineludibles para lograr una mejor comprensión de las formas de opresión algorítmica de nuestras sociedades latinoamericanas y de cómo transformarlas.

Este artículo consta de cinco secciones: en la primera, exponemos la metodología del proyecto, revisando las particularidades de nuestro prototipo y el formato de las entrevistas desarrollado para este estudio. En la segunda sección, examinamos los conocimientos que fuimos logrando a partir del diseño y prototipado de esta aplicación en la reorientación crítica y descolonial de sistemas algorítmicos. En la tercera sección, describimos algunos hallazgos preliminares de las entrevistas con participantes de Santiago de Chile, poniéndolos en tensión con planteamientos de Martín-Barbero. En la cuarta sección, revisamos el pensamiento de Paulo Freire para analizar el prototipo de aplicaciones a la luz de las capacidades de la pedagogía crítica. Posteriormente, en las conclusiones, ofrecemos algunas notas sobre cómo especular en una pedagogía problematizadora y descolonial de la datificación y los sistemas algorítmicos desde Latinoamérica.

Metodología

Desde el Big Brother de Orwell, pasando por el sobrenombre de Big Blue de la IBM, hasta la actual fascinación con los macrodatos (big data) o el Big Other criticado por Shoshana Zuboff (2015), continuamente se ha magnificado y singularizado el poder de las tecnologías para monitorear a la población. Pero con el neoliberalismo se han multiplicado y distribuido estas tecnologías por diferentes espacios e instituciones públicas y privadas. Armand Mattelart y André Vitalis (2015) han planteado que ya no es el Big Brother quien amenaza, sino una multitud de little sisters, las que, a partir de un profundo conocimiento de la personalidad y preferencias del consumidor, pueden influenciar y orientar sus compras. De forma irónica, llamamos Big Sister a nuestro prototipo para agregar un nuevo miembro a la familia, jugando con el carácter realmente precario y frágil de nuestra aplicación, en comparación con las expresiones de poder de las grandes plataformas. Big Sister aparece como una aplicación dentro de las millones que existen actualmente, aunque su propósito no es satisfacer una necesidad o solucionar un problema, sino desdiseñar estos dispositivos con un enfoque descolonial y crear problemas y cuestionamientos frente a esta familia de conceptos y sistemas algorítmicos que rondan en el debate público.

En lugar de observar de manera externa cómo otros codifican y ponen el mundo en algoritmos, el esfuerzo ha estado en explorar el potencial de la indagación a través del diseño de este prototipo y las posibilidades que se abren en cada nueva versión. Sin embargo, nuestro proceso de prototipado no fue completamente abierto. En lugar de desarrollar nuestros propios sistemas de recomendación, decidimos reorientar servicios algorítmicos existentes para explorar en sus usos, configuraciones y lógicas. De esta manera, nos fuimos involucrando desde un hacer práctico, a menudo incómodo e inestable, en aspectos como las interfaces de programación de aplicaciones (application programming interface - API), analíticas de lingüística, dispares regulaciones de privacidad, entre otros.

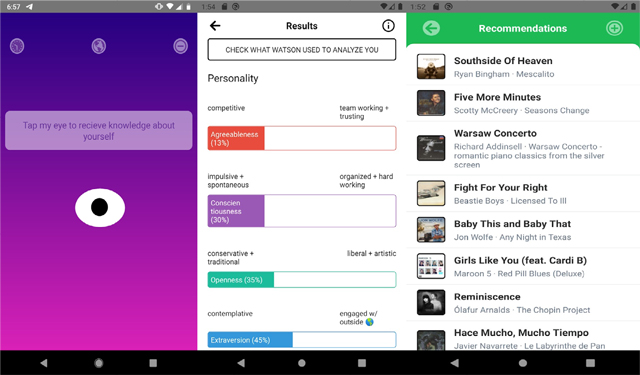

En concreto, Big Sister puede generar inferencias rudimentarias sobre rasgos de personalidad, preferencias de consumo y recomendaciones musicales. Como primer paso, la aplicación le pide a la persona usuaria la autorización para extraer las publicaciones textuales más recientes en sus cuentas de Facebook y/o Twitter a través de las API de estas plataformas. Si no se desea proporcionar acceso a sus publicaciones en redes sociales, la aplicación da una tercera opción de escribir o pegar una cantidad de texto.

Estos textos son usados como datos de entrada (inputs) para generar un perfil de rasgos de personalidad de la supuesta persona autora de los textos recopilados, basándose en una solicitud a la API del servicio de IBM Personality Insight, del cual ya hablaremos más en profundidad. Este servicio entrega como resultado una serie de puntuaciones en un modelo convencional de rasgos de personalidad conocido como los Cinco Grandes y a partir de ese perfil calcula una serie de inferencias sobre las preferencias de la persona. Por ejemplo, se estima la probabilidad de que la persona prefiera "la calidad al comprar ropa", "lea con frecuencia", "tenga una membresía de gimnasio", "participe en iniciativas de voluntariado", "tenga experiencia interpretando música", "le guste las películas de ciencia ficción", entre muchas otras.

A partir de un grupo de estas inferencias de Personality Insight -la probabilidad de que a la persona le gusten ciertos géneros musicales-, Big Sister puede entregar recomendaciones musicales realizando una última solicitud a la API de Spotify para recibir canciones cercanas a los géneros musicales identificados en el paso anterior. De esta manera, en concreto, la aplicación recomienda, de forma extraña y contraintuitiva, un listado de canciones a partir de cómo las personas escriben. Como era de esperar, este listado incluye a ratos canciones muy disímiles entre sí y se entrecruza con las prácticas de cada usuario en Spotify.

Junto con esto, la persona puede comparar sus resultados de perfilamiento, diferenciados por fecha y fuente de información de cada prueba en un gráfico interactivo, y comprobar cómo cambian las predicciones de personalidad entre diferentes redes sociales o a lo largo del tiempo. Todos los datos y resultados se almacenan solo en el dispositivo de la persona usuaria, por lo que nunca tenemos acceso directo a sus datos y resultados. En resumen, a través de Big Sister, las personas pueden experimentar cómo son predichas por las infraestructuras algorítmicas, modificar los textos utilizados como inputs y jugar con sus inferencias algorítmicas.

Fuente: elaboración propia.

Figura 1 Capturas de pantalla de la app Big Sister, 31 de octubre de 2020

Nuestro interés no estuvo en desarrollar la aplicación de forma clausurada para una futura comercialización ni lograr las predicciones más precisas posibles, sino emular con precisión un sistema de perfilamiento y recomendación algorítmica para explorar en las experiencias, reacciones y conexiones que desarrollan las personas con este y otros sistemas algorítmicos. De esta manera, todos los aciertos, así como los problemas y las fallas en el trabajo de perfilar o recomendar del prototipo, fueron incorporados dentro del proyecto como situaciones empíricas y a la vez pedagógicas para problematizar los algoritmos y datos digitales.

Una vez alcanzado un prototipo funcional, iniciamos en noviembre de 2019 una convocatoria abierta, invitando a voluntarios de Chile y el Reino Unido a utilizar Big Sister para ser entrevistados sobre sus experiencias. Dimos un mínimo de dos semanas para que pudieran interactuar, jugar y familiarizarse con la aplicación y experimentar con sus resultados. Posteriormente, llevamos a cabo entrevistas cualitativas cercanas a lo que Elizabeth Dubois y Heather Ford (2015) denominan "entrevistas de rastros". Ideadas originalmente para el estudio de la comunicación política en las redes sociales, en este tipo de entrevistas se le pide a la persona entrevistada que reflexione sobre sus rastros digitales a través de la recopilación, visualización y discusión de los datos digitales del participante dentro del proceso mismo de la entrevista (Dubois y Ford, 2015; Latzko, Bonneau y Millette, 2017).

En contraste con la distante minería de datos masivos, este formato de entrevistas contribuye a dar voz a la persona creadora de las trazas digitales y a agregar "capas de espesor" o contextualizar los datos de redes sociales a partir de la propia experiencia situada de los individuos. Además, permite indagar en las emociones y significados que les atribuyen las personas a los datos, indicar qué datos faltan, resultan inexactos o carecen de sentido, y conocer los contextos donde se generaron tales datos y cómo se generaron, lo que propicia una reflexión situada acerca de los procesos de datificación. Resulta ser "una forma de co-análisis de datos de trazas por parte del investigador y el sujeto cuyas trazas son examinadas" (Latzko et al., 2017, p. 203). En este sentido, se abren formas de diálogo e interactividad entre investigadores y sujetos investigados.

En nuestro proyecto no nos enfocamos solo en los rastros digitales, sino también en los sistemas algorítmicos de creación de perfiles y recomendaciones. De tal manera, el prototipo Big Sister se empleó como una "sonda cultural" (Boehner, Gaver y Boucher, 2012; Lupton y Michael, 2017) para suscitar problematizaciones, emociones y reacciones en las personas sobre sus relaciones con los sistemas algorítmicos y las inferencias que reciben respecto de sus identidades. Por ejemplo, preguntamos "¿qué predicciones sobre usted fueron sorprendentes?", "¿cómo cree que el sistema algorítmico llega a inferir X cosa sobre ti?" o "¿le hace sentido que se intente inferir este tipo de características a partir de sus datos en redes sociales?". También incluimos una especie de mapa -Big Sister Kit- con la figura de una persona en el centro. Cada vez que un participante mencionaba un tipo de dato, algoritmo, plataforma u objeto cultural, le pedíamos que ubicara una nota o post-it en relación con su persona. Este ejercicio permitió materializar y contrastar las relaciones y proximidades entre las personas y sus identidades con múltiples infraestructuras digitales.

Hasta la fecha, hemos podido realizar una primera fase de entrevistas presenciales para probar el prototipo (cuatro en Santiago de Chile y cinco en Londres), las cuales duraron entre una hora y una hora y media. Las entrevistas realizadas en Santiago fueron transcritas y codificadas con base en temas relevantes mediante el software Atlas.ti. En paralelo, hemos estado rediseñando algunas funciones de la aplicación y durante el 2021 se realizará una nueva fase de entrevistas con más participantes, lo que nos ha obligado a repensar la convocatoria y la realización de las entrevistas en un contexto de pandemia.

Prototipado y rediseño de algoritmos para la investigación descolonial

En el marco de este proyecto, el proceso de prototipado fue mucho más que una simple herramienta o método. Por el contrario, el prototipado devino en un espacio para dilucidar las lógicas, supuestos y límites de los servicios algorítmicos en los que se basa Big Sister. En particular, por medio del proceso iterativo del prototipado de la aplicación, se fueron reorientado y problematizando los marcos ontoló gicos y epistémicos movilizados por el servicio de Personality Insight de IBM, que derivan de las particulares visiones del mundo de sus diseñadores e ingenieros.

En una fase preliminar, los desarrolladores del servicio de IBM buscaban sensibilizar o generar conciencia sobre la imagen que provocamos en los demás con nuestros rastros digitales. Basándose en autores como Erving Goffman, pensaban Personality Insight como un método computacional para la gestión de impresiones en las redes sociales (Xu et al., 2017). Pero, de acuerdo con su documentación pública actual, Personality Insight está fuertemente orientado a lograr un marketing hiperpersonalizado que permita a las empresas un perfilamiento y segmentación de los clientes más receptivos a productos y marcas. En los casos prácticos de adquisición de clientes se menciona como ejemplo:

Las personas cuyas personalidades muestren una mayor tendencia por el orden, la autodisciplina y la precaución y menos falta de moderación son más proclives a canjear cupones que la población alea toria. Asimismo, la propensión de las personas para comprar tipos de productos específicos se correlaciona con sus características de personalidad. Por ejemplo, los compradores cuyas personalidades tiendan hacia la apertura y la responsabilidad son más propensos a comprar leche, frutas y verduras orgánicas. (IBM, 2019)

De este modo se liga la personalidad a prácticas de consumo específicas, justificándose la valía del sistema algorítmico en su capacidad de personalizar servicios y aumentar la eficiencia en la atención y fidelización de clientes, entre otros casos de usos mencionados.

Si bien el servicio se ofrece para generar "retratos" de consumidores sobre características de personalidad y preferencias a partir de comunicaciones de redes sociales, datos empresariales y otras comunicaciones digitales, el modelo detrás de Personality Insight fue entrenado exclusivamente con una gran base de datos de usuarios de Twitter, utilizando sus tuits como textos de entrada. Mientras que para el inglés recopilaron tuits de un millón de usuarios, para el español recopilaron datos de ochenta mil. Esta gran diferencia no habría sido relevante para sus desarrolladores, porque se alcanzó un nivel de correlación suficiente para el caso de los usuarios hispanohablantes. Para validar y evaluar la precisión del modelo, recopilaron respuestas de test psicométricos y tuits de entre 1.500 y 2.000 participantes (más de 200 tuits de autoría propia para cada usuario).

Todo el servicio de Personality Insight parte de la premisa de relaciones transitivas (Lury y Day, 2019) en que el modo de escribir de una persona en redes sociales reflejaría aspectos de su personalidad, de manera que estos rasgos de personalidad predecirían, a su vez, su comportamiento y preferencias de consumo. Además, el servicio asume que el texto está en un solo idioma y que fue escrito por un solo autor, que sería un usuario humano. Además, se establece que la precisión del modelo se estabiliza, una vez superadas las cerca de 3.000 palabras en el texto de entrada, por lo que el servicio solo usa los primeros 250 KB de un documento para su análisis. ¿Qué pasaría si alguien comparte su cuenta de redes sociales con otras personas, delega la redacción de sus publicaciones a otras personas o genera contenido en diferentes idiomas?, ¿cómo se define que las primeras 3.000 palabras son más relevantes que todas las que le puedan seguir en un texto de entrada? y ¿cómo se incorpora la vivacidad de nuestras identidades en la predicción algorítmica?

Estas preguntas sobre las prescripciones y normatividades del sistema algorítmico nos hablan de los límites de este esfuerzo de IBM por predecir la personalidad de forma casi universal. Es más, como se consigna en la documentación, el sistema tiene importantes limitaciones respecto al lenguaje y consideraciones culturales. Por ejemplo, el servicio se basa en un inglés estadounidense, lo cual genera problemas al usar textos en inglés de otras culturas. Para textos en árabe y coreano, el servicio no puede devolver resultados significativos relativos a ciertas características de personalidad. IBM, además, desaconseja usar el servicio para analizar obras de ficción o textos traducidos de otro idioma, recibiendo a veces perfilamientos diametralmente opuestos entre una traducción y el texto original.

En nuestro proceso de rediseño, no esperábamos abrir la caja negra de sistemas como Personality Insight. En otras palabras, no pretendíamos un white-boxing del Servicio de Personality Insight -utilizando el concepto de Corsín Jiménez (2018b), porque no podemos negar sus "límites propietarios" o su objetivo de marketing hiperpersonalizado. En su lugar, hicimos una especie de "ingeniería en reversa" crítica (Bucher, 2018), al rediseñar y reorientar estos servicios hacia el estudio crítico y descolonial de datos y algoritmos. Sin tener acceso a los datos utilizados para entrenar los modelos e incluso sin conocer directamente la serie de pasos de Personality Insight, probamos, tensionamos y jugamos con lo que hace (Bucher, 2018). Experimentamos con una variedad de textos como inputs, desde discursos presidenciales, novelas y poemas y sus correspondientes traducciones, para conocer cómo cambiaban los resultados y examinar críticamente los múltiples límites y presupuestos de este servicio. De este modo, fuimos tomando parte como investigadores críticos y como usuarios del servicio.

Siguiendo este enfoque experimental, en una nueva versión de la aplicación incluimos la posibilidad de que los participantes modifiquen los textos de entrada o excluir tuits o posteos para ver cómo cambian sus resultados. También incorporamos la función de comparar sus resultados de personalidad con figuras públicas como la Reina Isabel o la poeta chilena Gabriela Mistral. Más recientemente agregamos la opción de que las personas puedan componer textos al estilo de Frankenstein, combinando una secuencia de fragmentos de diferentes autores famosos, lo que rompe la lógica de Personality Insight en el proceso. Todas estas modificaciones iterativas fueron emergiendo en el prototipado, a través del juego, las fallas, los usos y testeos múltiples que permiten manifestar la falibilidad y volatilidad de las predicciones algorítmicas.

Esta estrategia de rediseñar y redireccionar el servicio de IBM para la confección de Big Sister como herramienta de investigación, en un sentido más general, constituye un medio para la descolonización de los diseños y dispositivos del Norte Global como Personality Insight. Tal como lo ha señalado Arturo Escobar (2018), el diseño moderno se ha transformado en un medio para la materialización de una modernidad/colonialidad que expande ontologías y concepciones del mundo que reclaman universalidad y superioridad, con lo que se borran y olvidan los contextos relacionales y situados. En este sentido, el resto de un diseño descolonial -o para la autonomía, como lo llama Escobar- consiste en problematizar las operaciones conceptuales y hegemónicas, sobre las que se fundan los instrumentos del sistema de desarrollo actual, generando diseños que permitan abrir futuros y relaciones alternativas que vayan más allá de la matriz eurocéntrica, individualista e instrumental (2017; 2018). En este hacer y deshacer descolonial, Escobar ve el surgimiento de un diseño político capaz de proponer y abrir nuevos escenarios de civilización existentes o potenciales, basado en la pluralidad de mundos y tradiciones.

Importante señalar que el carácter descolonial del proceso de rediseño del servicio de IBM no supuso una ruptura absoluta con la matriz eurocéntrica ni pretendió hacer una regresión esencialista a un estado puro o sin influencia alguna. En efecto, tal como se señaló, el proceso de rediseño se llevó a cabo con la valiosa colaboración de investigadores del Reino Unido y las decisiones sobre el redireccionamiento de la aplicación fueron tomadas concertadamente. Más aún, esperamos en el futuro poder contrastar experiencias de uso mediante entrevistas con usuarios de Chile y de Reino Unido. En esta línea, la intención descolonial del proyecto se orientó más bien por una apertura a epistemologías fronterizas (Mignolo, 2013), es decir, asumimos reflexivamente, como parte del proceso de rediseño, las tensiones geopolíticas involucradas en el diseño de servicios algorítmicos, las grandes diferencias en regulaciones de datos personales y los formatos de colaboración con investigadores distantes en otros marcos. En otras palabras, situar el proyecto en una aproximación descolonial no significó una exclusión de todo tipo de diálogo con el Norte, ni menos homogenizar el Norte Global, sino reconocer y enfatizar un pensar y hacer situado, apropiándonos material y socialmente de los conocimientos y tecnologías disponibles para nuevos fines problematizadores atendiendo a los distintos contextos, como Chile o Reino Unido, rechazando a su vez cualquier pretensión de neutralidad de los saberes movilizados durante el proyecto.

Habitar algoritmos desde el Sur: reacciones iniciales ante el prototipo

Hasta la fecha aún no tenemos suficientes entrevistas para evaluar de manera exhaustiva los resultados del proyecto, pero sí contamos con hallazgos preliminares que nos sugieren un positivo potencial de provocar y obtener reacciones mediante la aplicación. En lo que sigue describimos algunos puntos de nuestras primeras entrevistas con participantes de Chile, que manifiestan las capacidades críticas de las personas para problematizar las múltiples mediaciones de sistemas algorítmicos en sus vidas.

Los participantes nos contaron que con Big Sister se enfrentaron a resultados inesperados o impactantes y que la aplicación se asemejaba a otras técnicas del yo, como la Astrología o el Horóscopo. Las preguntas especulativas respecto del servicio de Personality Insight planteadas más arriba también fueron surgiendo en las entrevistas con los participantes. Algunos problematizaron la traducción de su forma de escribir en rasgos de personalidad, preferencias de consumidores y recomendaciones musicales, otros comentaron sobre la valorización de ciertos idiomas en lugar de otros o cuestionaban los significados de ciertos perfilamientos.

Algunos rasgos de personalidad y preferencias de consumo inferidas por Big Sister les resultaron sorprendentemente "correctos" o "muy cercanos" a su personalidad y preferencias de consumo. Sin embargo, la mayoría recibió perfiles extraños y recomendaciones musicales que no tenían sentido aparente. En lugar de meros errores, estas disonancias sirvieron para saber cómo los participantes especulaban posibles explicaciones. Por ejemplo, un participante de Chile asoció sus resultados altamente neuróticos con el contexto de protestas masivas en el país:

Siempre me salía en la última barra [Neuroticismo] que yo era muy ansioso o muy estresado. Yo dije: "Sí, podría ser por todo lo que está pasando [en Chile], probablemente estoy dando muchos likes a noticias de los pacos [policías] pegándole a la gente". Entonces creo yo, hice esa relación, que si en verdad le estoy dando puros likes a esas noticias, así como el "incendio en Australia", cosas medias caóticas, puede que haya una relación con la ansiedad de mi perfil [...] todas las veces que la revisé, que habrán sido unas cuatro veces, siempre era el mismo resultado, yo decía "no puede ser que esté todo ansioso". (Hombre, 30 años)

Esta cita muestra el carácter situado de las asociaciones que hacen las personas para explicar los perfilamientos y recomendaciones algorítmicas disonantes que reciben en su día a día. Más aún, la cita revela la relación temporal que este participante estableció con la aplicación y cómo la repetición habitual de múltiples pruebas a lo largo del tiempo le llevó a sospechar y problematizar la veracidad de los resultados, sin ver ningún código de la aplicación. Y, efectivamente, una excesiva neurosis se debió a un error de configuración de la aplicación que fue posteriormente corregido, de modo que las entrevistas no solo sirvieron para conocer las reacciones de los usuarios, sino que también fueron instancias significativas dentro del propio proceso de prototipado.

En las entrevistas pudimos registrar reflexiones no solo sobre el prototipo, sino también sobre las múltiples relaciones de los participantes con los datos y algoritmos en general. Tuvimos la oportunidad de hablar sobre las prácticas cotidianas de uso de plataformas digitales, así como recuerdos de servicios en línea que han dejado de funcionar. Y el Big Sister Kit (Figura 2) permitió una comparación de diferentes sistemas algorítmicos para que los participantes tomarán conciencia de tales relaciones y su proximidad a sus identidades. Como decía un participante: "con este ejercicio puedo ver la cantidad de cosas que tenía; antes, si me hubieses preguntado en la calle -con esas encuestas rápidas-, te hubiese dicho tres cosas, pero tengo doce y probablemente hay otras más. Entonces eso fue como 'wow, no hay que olvidarse de eso'" (Hombre, 30 años).

Junto con el ejercicio de toma de conciencia, los participantes propusieron críticas relevantes a los sistemas algorítmicos. Una primera línea de críticas repetida por ellos apunta a que los sistemas algorítmicos se ba san exclusivamente en acciones pasadas, lo cual sería particularmente rele vante al hablar de recomendaciones musicales. Por ejemplo, pensando en Spotify, un participante señaló: "el descubrir cosas nuevas tiene que ver con no repetir lo pasado, como que a veces he dejado estilos atrás a los cuales no quiero volver. Si este algoritmo se mete en mi pasado y dice 'oh, mira, vuelve a escuchar Backstreet Boy', no quiero escuchar eso, ya pasé esa etapa" (Hombre, 30 años).

Una segunda línea de críticas a los sistemas algorítmicos se concentró en la poca sensibilidad a los contextos culturales de los participantes:

¿Quién hizo esto [Personality Insight]? En realidad, me imagino que lo hicieron en el primer mundo, me da la impresión, porque [lee uno de sus resultados] "es probable que no vayas al gimnasio", pucha, aquí puedes andar en bicicleta, ir a yoga, no sé, un amigo hace Tai chi; yo no sé qué hace la gente en Estados Unidos o Europa, en Brasil caminan y trotan mucho. ¿IBM, no sé, sabe cómo es la gente en Chile, cómo se comporta en Chile o en Santiago, Santiago Centro? (Hombre, 47 años)

Siguiendo esta misma línea de crítica, en las entrevistas preliminares fue problematizado qué se entiende por "música latina" como género musical dentro del perfilamiento dado por Personality Insight. Una participante relataba: "[Big Sister] me decía 'no es probable que le guste la música latina' y me gusta la música latina, o sea, soy latina [risas]. Me imagino que las apps consideran las mismas variables en todos los contextos geográficos, pero igual hay un factor contexto importante" (Mujer, 26 años). Nuevamente vemos que, en el uso cotidiano de sistemas algorítmicos, las personas son capaces de plantear críticas relevantes, que son ampliamente discutidas en la literatura especializada.

En paralelo a estas críticas, los participantes evidenciaban prácticas específicas para "educar" o entrenar a los algoritmos, alimentándolos periódicamente con ciertos datos, a fin de recibir mejores recomendaciones. Por ejemplo, un participante nos contaba de su experiencia al recomendarle a su pareja usar la aplicación Pocket: "yo le dije 'oye, usa Pocket porque está buena' y, de repente, me dijo 'me recomienda puras tonteras', yo le dije 'pero tienes que educarlo' y literalmente al mes estaba recomendando cosas buenas" (Hombre, 30 años). Los participantes también rememoraron que en ciertas ocasiones evitaban realizar ciertas acciones para no recibir recomendaciones molestas o indeseadas. Una persona marcaba videos en YouTube como "no me interesa" u "ocultaba" noticias que no le interesaban, para evitar que le aparecieran contenidos similares en el futuro: "de alguna manera igual le estoy diciendo qué cosas me gustan y qué cosas no me gustan, [le estoy diciendo] 'no, esto no me gustó; no más y no me lo muestren más'. [...] Si lo piensas, tiene ese trasfondo de ir enseñándole lo que está bien y lo que te está recomendando mal" (No binario, 26 años).

Estos hallazgos ponen en duda las descripciones monolíticas que dibujan los algoritmos y las grandes plataformas digitales como controladores de nuestras vidas y obligan a repensar estos aparatos dentro de una espesa red de mediaciones y hábitos. Las formas de problematización aquí revisadas sugieren que las personas ya desarrollan cierta conciencia y competencias críticas en el uso cotidiano de plataformas y sistemas algorítmicos. Esto nos hace retomar el pensamiento de Jesús Martín-Barbero en sus estudios sobre el melodrama en América Latina. Ante la lógica del sistema productivo en la que los medios de comunicación universalizan un modo de vivir occidentalizado, este autor reivindica las lógicas plurales y las competencias culturales que se activan en los usos. "Hablantes del 'idioma' de los géneros, los telespectadores, como indígenas de una cultura textualizada, 'desconocen' su gramática, pero son capaces de hablarlo" (1987, p. 242). De un modo parecido, al revalorizar los usos cotidianos que les dan las personas a los sistemas algorítmicos de perfilamiento y recomendación, nos encontramos con que las competencias algorítmicas no son exclusivas de quienes diseñan estos algoritmos, ya que también se activan en su uso habitual. Al habitar culturas algorítmicas, las personas pueden "desconocer" la gramática de estos sistemas algorítmicos, pero llegan a ser capaces de hablar ese idioma: es posible sugerir explicaciones de su funcionamiento y plantear críticas apelando a la falta de contexto a la hora de prescribir algo como "música latina" o definir prácticas de consumo que no se ajustan a las culturas latinoamericanas. Si aplicamos la ya clásica sugerencia de Martín-Barbero de abandonar el mediacentrismo e indagar en las mediaciones, podemos sugerir que en los estudios críticos de los algoritmos y datos digitales no solo se requiere indagar por las plataformas, sus sistemas algorítmicos y las estrategias de sus programadores, sino también estudiar las mediaciones algorítmicas que permitan reconocer "su otro lado" (Martín-Barbero, 1987, p. 10): el de las reinterpretaciones, resistencias, complicidades y apropiaciones que se dan en los usos cotidianos de las personas.

Capacidades pedagógicas de Big Sister

No obstante, paralelo a las formas de reorientar algoritmos o indagar por las reacciones de las personas participantes, el prototipo fue cargándose de ciertas capacidades pedagógicas tanto para ellas como para nosotros como investigadores. Una pregunta siempre presente en el proyecto fue si debíamos orientar la aplicación hacia una instancia en la que se pudiera "educar" sobre cómo los sistemas algorítmicos extraen datos personales para perfilar y recomendar productos o concentrarnos exclusivamente en un proceso investigativo distante y descriptivo sobre cómo otros usan y experimentan con la aplicación.

Ante tal problema, nos resultó provechoso recoger elementos del trabajo del educador brasileño Paulo Freire. En su perenne Pedagogía del oprimido (1970), Freire critica una concepción "bancaria" de la educación que la reduce a un mero acto de depositar o transferir conocimientos, al margen de toda praxis. En este modelo se establece una separación entre el educador, como dueño del saber que prescribe el proceso educativo, y los educandos, que serían juzgados como ignorantes pasivos que deben ser "llenados" con los contenidos del educador. En otro trabajo con Antonio Faundez, Freire habla de una "pedagogía de respuestas" en la que los maestros inducen a los alumnos a repetir y memorizar respuestas "correctas" predeterminadas, con lo que castran toda curiosidad o capacidad inventiva en el proceso educativo (Freire y Faundez, 1985).

En contraste, Freire propone una "educación problematizadora" o una "pedagogía de la pregunta" volcada al descubrimiento crítico y la toma de conciencia (conscientização) o continua problematización de las situaciones opresivas en que se encuentran las personas del Sur en sus relaciones con el mundo, para apropiarse de sus situaciones como realidad histórica y, como tal, promover su transformación. En una palabra, en la educación problematizadora, antes que concebir la opresión de forma fatalista, "propone a los hombres su situación como problema" (1970, p. 99). Desde esta perspectiva se debe superar la distinción entre educador y educando para pasar a entender una relación dialógica en que las personas se educan en comunión y el mundo es el mediador. "De este modo el educador problematizador rehace constantemente su acto cognoscente en la cognoscibilidad de los educandos. Estos, en vez de ser dóciles receptores de los depósitos, se transforman ahora en investigadores críticos en diálogo con el educador, quien a su vez es también un investigador crítico" (p. 93).

Este enfoque ha sido de gran valor para repensar nuestra relación con las tecnologías digitales, al inspirar modos de alfabetización crítica de datos (Tygel y Kirsch, 2016), formas de enseñar a estudiantes para ser etnógrafos de su propia vida digital (Markham, 2019) o para problematizar el papel de la ciudadanía y las y los científicos en las iniciativas de ciencia ciudadana (De Alburquerque y De Almeida, 2020). En nuestro proyecto, los planteamientos de Freire nos motivaron a problematizar, partiendo de un hacer y pensar desde Latinoamérica, los alcances de nuestro proyecto.

En nuestro afán por conocer las emociones y tematizaciones de las personas sobre sus relaciones con datos y algoritmos, no habría que esperar respuestas predefinidas ni, en ningún caso, intentar depositar en las mentes de los participantes algún conocimiento técnico sobre cómo funcionan los algoritmos. Siguiendo la aproximación problematizadora de Freire, el desafío estaba en activar preguntas y reacciones afectivas por medio del prototipo. En otras palabras, desplegamos Big Sister como un dispositivo para estimular la reflexión con los participantes acerca de sus relaciones cotidianas con sistemas algorítmicos, enfatizando en la historicidad y multiplicidad de contextos de uso de estos sistemas y, en definitiva, convertir la situación de la creciente datificación y mediación algorítmica en un problema a indagar críticamente para su transformación. Con tal fin, en las entrevistas alentamos a las personas a especular creativamente sobre posibles explicaciones acerca de sus resultados disonantes, por ejemplo, conectando sus contextos y procesos locales con los resultados de su personalidad, como en el caso de quien conectaba resultados de inestabilidad emocional con el "estallido social" chileno.

Por lo tanto, en lugar de considerar a los participantes como ignorantes o recipientes vacíos, como pasa en la concepción bancaria criticada por Freire, en nuestra aproximación fuimos reposicionando y valorando la experiencia y conocimiento vernáculo de las personas no expertas al coexistir y habituarse a datos y algoritmos. Como decíamos anteriormente, las personas pueden desarrollar competencias críticas en la praxis cotidiana de uso de estos sistemas de perfilamiento y recomendación algorítmica. Esto nos fuerza a considerar no solo cómo las personas son moldeadas por algoritmos -tema que ha sido objeto de gran discusión en el último tiempo-, sino también cómo habitan, se habitúan y problematizan los algoritmos en su vida cotidiana de forma dialógica. Mediante los usos mundanos y situados de sistemas algorítmicos, las personas pueden aprender acerca de sus efectos prácticos y renegociar el valor de sus perfiles y recomendaciones o tomar ciertas medidas para lograr los perfiles y sugerencias deseadas.

Conclusión: prototipos para pedagogías descoloniales ante la opresión algorítmica

En su reconocido libro Algorithms of oppression, Safiya Umoja Noble analiza los motores de búsqueda, como Google, para plantear que los sistemas algorítmicos, lejos de ser neutrales, ejercen una opresión algorítmica o formas de discriminación sobre ciertos grupos de personas por su raza o género y refuerzan estereotipos y creencias sexistas o racistas que repercuten en la sociedad en su conjunto. "Algorithmic oppression is not just a glitch in the system but, rather, is fundamental to the operating system of the web. It has direct impact on users and on our lives beyond using Internet applications" (Noble, 2018, p. 10).

De aquí surge la pregunta por cómo avanzar hacia una pedagogía de las y los oprimidos algorítmicamente (véase Markham, 2019). Nuestra propuesta es proyectar dispositivos pedagógicos que propicien capacidades críticas ante el avance de formas de opresión algorítmica realizada por compañías tecnológicas desde una matriz colonial y racial. En diálogo con autores como Arturo Escobar, Jesús Martín-Barbero o Paulo Freire, y a la luz de los hallazgos y reflexiones que surgen de la intervención metodológica del proyecto "Identidades algorítmicas", en este artículo mostramos que el proceso de rediseñar o redireccionar un sistema algorítmico como el de IBM puede constituir una herramienta para cuestionar, problematizar y descolonizar los modos que en que las personas habitan los algoritmos.

En primer lugar, Big Sister, como herramienta de investigación, puso de relieve la importancia de reposicionar el rol de los sujetos de estudio, redistribuyendo la autoridad epistémica y las capacidades críticas que normalmente se le atribuyen al investigador social (Marres, 2017). Muy a menudo en la investigación social se llama a adoptar una "ruptura epistemológica" respecto de las representaciones del sentido común y una actitud vigilante ante los riesgos de reproducir el saber ordinario. La capacidad crítica sería un recurso analítico que autoriza al investigador social para denunciar los mecanismos invisibles que gobiernan nuestras acciones y entornos, asumiendo que los sujetos que se estudia están atrapados por el devenir de las circunstancias (algorítmicas, en este caso) y, por lo mismo, carecen de los instrumentos de emancipación.

Es precisamente este tipo de premisas epistemológicas las que buscamos interrogar en nuestra intervención metodológica. Basándonos en los autores latinoamericanos ya mencionados, asumimos que una aproximación problematizadora de la datificación y los sistemas algorítmicos debe ser elaborada con las personas oprimidas por algoritmos y no para ellas. En vez de ser tratados como dóciles usuarios "receptores" de recomendaciones algorítmicas, sin espacio para complicidades o resistencias, se debe propiciar un involucramiento de las personas participantes como investigadoras críticas de su propia situación. No es tarea exclusiva de los científicos sociales definir las opresiones, exclusiones y arbitrariedades que movilizan los sistemas algorítmicos, sino que es necesario buscar los métodos y herramientas que permitan restituir las capacidades críticas y reflexivas que las propias personas movilizan en sus prácticas, usos y representaciones de los algoritmos. A pesar de la fantasía de muchos científicos sociales, los sujetos que estudiamos no necesitan de expertos en algoritmos para juzgar sus normatividades, estereotipos y mediaciones. Más bien, la pregunta es: ¿a través de qué tipo de interfaces, herramientas o prototipos podemos propiciar esas capacidades críticas? O, como propone Paulo Freire, ¿cómo contribuir a que las personas oprimidas empiecen a decir "por qué' ' ? (1970, p. 101) . Traducidas al lenguaje de esta investigación, las preguntas serían: ¿por qué infieren mis gustos musicales de la manera como escribo?, ¿por qué mi personalidad se reduce a cinco barras?, ¿por qué estiman que es altamente improbable que participe en iniciativas de voluntariado, con base en mis tuits? En nuestro caso, por medio de la intervención metodológica, intentamos recoger los saberes críticos de las personas, hacerlas tematizar los límites de los sistemas algorítmicos y generar preguntas sobre formas alternativas o subalternas de relacionarse con el mundo de las plataformas digitales.

En segundo lugar, la intervención metodológica sugiere ir más allá de las generalidades sobre el extractivismo de datos, para abordar estas operaciones de extracción colonialista, como las analizan Mejías y Couldry (2019) con un enfoque situado y contextual, recogiendo la experiencia relacional y cotidiana de las personas oprimidas (Tygel y Kirsch, 2016). Es especialmente relevante, en contextos como el latinoamericano, de profundas inequidades y formas de colonialismo (véase Ricaurte, 2018), desarrollar dispositivos de investigación que activen las formas de autonomía, reconociendo las relaciones y vivencias de las personas e interpretando sus posibilidades (Escobar, 2018). Esto no quiere decir que en el diseño de los sistemas algorítmicos no se consideren sus contextos de implementación, sino que se vuelve clave interrogar cómo, quiénes y con qué intereses se definen los contextos de los sistemas algorítmicos (Seaver, 2015). Por medio del prototipo Big Sister y las entrevistas respecto de rastros digitales fue posible poner en evidencia los problemas y disonancias que surgen al intentar reorientar y experimentar en Latinoamérica estos servicios algorítmicos desarrollados en polos de innovación globales, por ejemplo, al emerger problematizaciones sobre el predominio del inglés en servicios de personalización algorítmica o sobre quiénes definen lo que es la "música latina" como género musical. Estos cuestionamientos manifiestan los siempre plurales contextos, interpretaciones y capacidades involucradas en las mediaciones algorítmicas y tensionan los principios naturalizados y colonialistas que muchas veces se terminan por inscribir en estas tecnologías, al ser configuradas y difundidas de acuerdo con cánones modernos -o anglosajones, en nuestro caso-.

En tercer lugar, la intervención metodológica permitió explorar otras formas de pensar el rol del diseño en la sociedad digital, para activar maneras de problematizar nuestras relaciones con los datos y algoritmos y desafiar los modelos y racionalidades hegemónicas de la modernidad occidental, que orientan muchas veces los diseños algorítmicos. Es decir, movilizamos el proceso de prototipado no como una herramienta para generar productos o servicios que legitiman, refuerzan y sostienen el statu quo, desplegando una única posibilidad de funcionamiento, uso y significado. Por el contrario, en nuestro proyecto el diseño fue desplegado en alianza con la investigación social para descolonizar y reconocer las formas de autonomía (Escobar, 2018) que las personas y comunidades pueden desarrollar en sus relaciones con datos y algoritmos. A pesar de la indudable dificultad de cambiar la trayectoria de los sistemas algorítmicos hacia futuros alternativos en relación con sus lógicas extractivistas, la intervención metodológica analizada en este artículo abre un camino posible para pensar y diseñar críticamente y busca posibilitar modos alternativos y descoloniales de aproximarse a los diferentes mundos que surgen en la relación con los algoritmos.

Cualquier intento de hacer una pedagogía o alfabetización crítica de datos y algoritmos centrada en el Sur, más que buscar la adquisición de conocimiento o habilidades técnicas, debe avanzar en procesos de autonomía y emancipación de los contextos locales, posibilitando una problematización de las agendas, valores e ideologías implicadas en estos sistemas algorítmicos. Por una parte, esto supone desarrollar estrategias de diseño descoloniales que permitan criticar y desafiar las formas en que las tecnologías ingresan en nuestras vidas, cuestionando las limitaciones que estas imponen a las personas a través de sus definiciones y normatividades. Por otra parte, se deben considerar las competencias críticas de las personas, facilitando espacios de escucha donde ellas puedan desarrollar indagaciones y asociaciones reflexivas sobre las prescripciones de los sistemas algorítmicos y sus relaciones de propiedad. Problematizar las implicaciones y contextos de uso de estos sistemas algorítmicos no puede basarse únicamente en el análisis de expertos, sino que debe incluir la construcción de dispositivos pedagógicos que permitan visibilizar las competencias críticas de las personas, explorando futuros que van más allá de los modelos hegemónicos.

En la medida en que más actividades de nuestro cotidiano vivir son traducidas a procesos de extracción de datos o delegadas a la inteligencia de los sistemas algorítmicos, más relevante se vuelve promover intervenciones metodológicas en y con el Sur, que problematicen los supuestos, modelamientos y lógicas de las grandes corporaciones tecnológicas del Norte. El prototipo de intervención analizado en este artículo permite interrogar la pretensión de universalidad que caracteriza las lógicas de datificación y regulación algorítmica, haciendo emerger la heterogeneidad de usos y competencias críticas de los individuos, e invita también a explorar nuevos métodos investigativos performativos a través de la práctica del prototipado. En este sentido, uno de los aportes de este enfoque, localizado en Latinoamérica y Reino Unido, reside en la posibilidad de diluir la epistemología tradicional y racionalista entre pensamiento y práctica, entre generar ideas y generar cosas, movilizando herramientas donde ambos planos están íntimamente enmarañados. De cierta forma, por medio del proceso de prototipado testeamos una modalidad de "metodología descolonial" que permite avanzar hacia formas de justicia epistémica (Santos, 2017), una donde el hacer material y la reflexión conceptual se entrecruzan de manera simétrica para problematizar los límites de la racionalidad algorítmica.

Si consideramos los complejos sistemas algorítmicos que invaden nuestras vidas como parte de la matriz occidental, moderna y colonial del poder, entonces promover intervenciones metodológicas críticas y situadas en Latinoamérica es una condición necesaria para descolonizar las epistemologías y ontologías inscritas en estos servicios e infraestructuras algorítmicas.