1. INTRODUCCIÓN

La palabra gesto tiene su origen en el latín gestus, que hace referencia a una forma de comunicación no verbal basada en lenguajes corporales. Los gestos son expresiones o movimientos faciales, de las manos o cualquier parte del cuerpo, a través de los cuales se manifiestan pensamientos, sentimientos o estados de ánimo. Su propósito es el de intercambiar eficientemente un mensaje entre quien emite el gesto y quien lo interpreta.

Adicionalmente, el latín gestus tiene relación con gerere, que a su vez significa “llevar a cabo”; de allí la relación de la palabra gesto con otras como ‘gestionar’, ‘gestar’ o ‘gerencia’ [1]. En español, gesto también se utiliza para referir a un conjunto de acciones que tienen un significado o intencionalidad particular [2].

En el área de la interacción humano-computador (hci) se investiga la utilización de gestos como medio de comunicación con dispositivos de cómputo, en las que el cuerpo es un agente principal en la comunicación. Adicionalmente, en algunas ocasiones se utiliza para evaluar la experiencia del usuario al enfrentarse a ciertas interacciones; por ejemplo, para estimar las emociones que genera una interacción de acuerdo con los gestos que hace el usuario [3]. La investigación posee dos enfoques relevantes: uno técnico -¿cómo construir interfaces que permitan a los dispositivos computacionales reconocer gestos de las personas? [4], [5], ¿cómo representar computacionalmente los gestos? [6], [7], [8], ¿de qué manera las máquinas pueden representar información a través de gestos por los cuales las personas sientan empatía? [9], [10], [11]-; y otro humano (psicológico, cultural, social) - ¿cómo los gestos se transforman por la inclusión de dispositivos de cómputo en la cotidianidad? [12], [13], ¿qué factores intervienen en la aceptación/apropiación social de las interacciones basadas en gestos? [13], ¿cuál es la influencia cultural en los gestos y cómo esa influencia interfiere en la estandarización de los procesos de reconocimiento y representación computacional de gestos? [14]-[16]-.

Este artículo presenta una revisión crítica de literatura académica y de divulgación científica enfocada en las interacciones basadas en gestos, que responde algunas de las preguntas enunciadas anteriormente. La sección 2, metodología, corresponde al proceso llevado a cabo para hacer la revisión, los criterios de búsqueda, la agrupación y la sistematización de la información recolectada. En la sección 3, se discuten los resultados obtenidos en el proceso de búsqueda, los cuales son presentados en subsecciones a manera de relatos y esquemas, con referencias que invitan al lector a profundizar sobre los temas de interés; asimismo, se formulan preguntas que buscan indagar acerca de los potenciales temas de investigación, desafíos, riesgos y aplicaciones de las interacciones basadas en gestos. El artículo finaliza con las conclusiones, que sintetizan los hallazgos y ofrecen una reflexión crítica sobre las interacciones humano-computador basadas en gestos, la cual pone en evidencia el interés de la comunidad científica en este tema y la necesidad de abordarlo desde perspectivas técnicas, sociales y culturales. Así mismo, finaliza con el planteamiento de la posibilidad de estudiar otras direcciones de interacción, como los gestos que una máquina puede hacer a un humano.

2. METODOLOGÍA

La revisión presentada en este artículo parte del interés en desarrollar métodos y herramientas de interacción entre las personas y los computadores, en los que la frontera entre lo material -objetos, ambiente, sujetos- y lo inmaterial -bits, datos, representaciones abstractas- sea difusa. Con frecuencia este tipo de interacciones son referidas en áreas de hci como interfaces tangibles de usuario [17], [18], interfaces orgánicas (oui) [19] o interfaces naturales de usuario (nui) [20].

En todos los casos, es común encontrar al cuerpo como agente principal, que percibe y actúa.

Igualmente, cuando se hace una búsqueda del papel del cuerpo en procesos de comunicación e interacción entre humanos y entre el humano y la máquina, frecuentemente se asocia a los gestos, entendidos como medio no verbal de comunicación. En razón a esto, se decidió hacer una revisión que permitiera condensar algunos de los hechos más relevantes de las interacciones humano-computador mediadas por gestos.

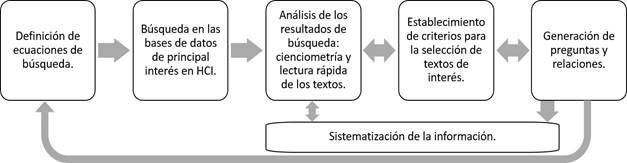

La búsqueda se desarrolló con base en el proceso metodológico presentado en la Fig. 1. La primera etapa consistió en definir una versión inicial de las ecuaciones de búsqueda y establecer cuáles serían las principales fuentes de información. La segunda, en buscar dichas ecuaciones en las fuentes de información establecidas, especialmente desde un enfoque científico/académico -bases de datos-, pero también desde uno de divulgación -magacines, redes sociales-.

La tercera etapa involucró actividades de revisión y análisis de los resultados de la búsqueda. Esta revisión se hizo en términos cienciométricos para determinar la cantidad de resultados obtenidos, las principales conferencias y revistas de publicación, los autores con mayor cantidad de textos, los años de publicación y las palabras frecuentes en los resultados, entre otros. Adicionalmente, y en un continuo ir y venir con la siguiente etapa metodológica, se esbozó una aproximación inicial a los textos: lectura de título, resumen y palabras clave. La cuarta etapa metodológica consistió en el establecimiento de los criterios para seleccionar o no un texto, hacer únicamente una lectura rápida (adicionar títulos de secciones, gráficos, tablas y conclusiones) o leerlo con mayor detalle.

Finalmente, se sistematizó información a partir de la generación de relaciones y preguntas que derivaron de las etapas previas. La metodología es iterativa, en el sentido de que las etapas están estrechamente conectadas y la sistematización de la información resultante generó continuamente nuevas ecuaciones de búsqueda y nuevas necesidades en torno a la profundidad del análisis de ciertos textos.

3. RESULTADOS Y DISCUSIÓN

3.1 Ecuaciones de búsqueda, bases de datos y criterios de selección

La primera fase consistió en la definición de los términos principales de búsqueda, con base en los grandes temas de investigación: i) gestos, ii) reconocimiento de gestos, iii) interacción.

Con esta información como insumo, se seleccionaron los sinónimos y otros términos relacionados. Después de definidas las ecuaciones de búsqueda, se eligieron las bases de datos para la revisión de artículos, para lo cual se utilizó como fuente las páginas web de Special Interest Group on Computer-Human Interaction (sigchi) [21], International Federetion for Information Processing (ifip) [22] y ieee Systems, Man and Cybernetics Society ieee (smc) [23], por ser los principales referentes en el área de hci.

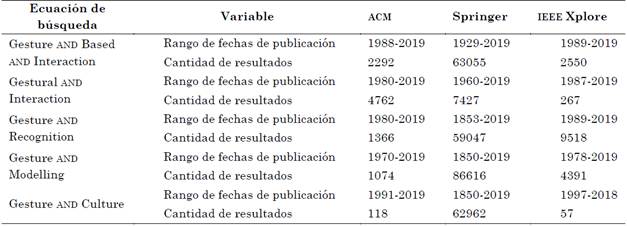

La Tabla 1 resume las ecuaciones de búsqueda más significativas y los resultados obtenidos en las bases de datos de mayor publicación y consulta.

De acuerdo con la información de la Tabla 1, se infiere que la cantidad de resultados en Springer es significativamente mayor que en acm o ieee, debido a que tiene repositorios de áreas del conocimiento diversas: psicología, medicina, estudios culturales y sociales, ciencias de la computación, entre otras.

Tabla 1 Ecuaciones de búsqueda principales, junto con las fechas y la cantidad de resultados encontrados en las principales bases de datos de consulta

Fuente: elaboración propia.

Cuando la búsqueda se filtra por fechas en Springer, se encuentra que antes de los años noventa la mayoría de los resultados obedecen a las áreas de medicina y psicología; pero, a partir de dicha década, se concentran en ciencias de la computación. Sobre los resultados en ieee y acm, se observa que ieee tiene más resultados en temas técnicos: reconocimiento de gestos y modelado de gestos; mientras que acm arroja más resultados, comparativamente, cuando se incluyen palabras clave más asociadas a lo humano como “interacción” o “cultura”.

Adicionalmente, en los medios de divulgación se encuentran: acm Interactions [24], Communications of the acm [25], Interaction Design Foundation [26]; y, en Latinoamérica, la revista de diseño de interacción Faz [27], así como redes sociales y plataformas de video usadas por conferencias destacables como Conference on Human Factors in Computing Systems (chi) [28], Tangible, Embedded and Emboided Interactions (tei) [29] o, de la comunidad latinoamericana, Conferencia Latinoamericana en Interacción Humano Computador (clihc) [30] y Conferencia Latinoamericana en Informática (clei).

El ordenamiento para la aproximación a los textos fue inicialmente por relevancia, posteriormente, por número de citaciones y, finalmente, del más reciente al más antiguo. La selección de textos para una lectura más detallada dependió de la información encontrada en la primera aproximación, para lo cual se tuvieron en cuenta factores como: conferencia o revista en la que se publicó, relevancia de los autores (número de publicaciones y citaciones), rigurosidad en la descripción del texto en el resumen (por ejemplo, si presenta un método, describe una herramienta, algoritmo, o experimento con usuarios). Adicionalmente, se hizo una búsqueda específica en revistas en español (Faz [27]) y en fuentes de publicación latinoamericanas.

3.2 El gesto como medio de interacción

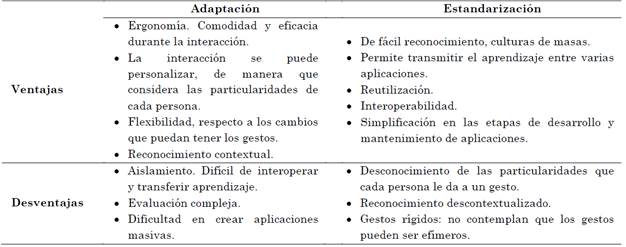

Los gestos son, en esencia, un medio de comunicación. Si bien se suelen considerar como naturales, de acuerdo con Norman [16], las expresiones gestuales no son naturales ni innatas ni fáciles de aprender, comprender o recordar. Más aún, los gestos son expresiones culturales [31] y muchos de ellos pueden ser efímeros para adaptarse a condiciones particulares del contexto espacial o temporal en el que ocurren [16]. Así, existen dos escenarios posibles: i) desarrollar estrategias computacionales para el reconocimiento de gestos culturalmente aceptados-apropiados (adaptación) o ii) proponer gestos que sean reconocidos por los dispositivos computacionales y que puedan ser aprendidos y apropiados por las personas (estandarización). El primer escenario es el más complejo, por la diversidad y variabilidad de los gestos, entre una cultura y otra. El segundo escenario es el más común, y ha permitido la estandarización de gestos para la interacción humano-computador, por entidades formales o por convención a través de la popularización de su uso [32].

La Tabla 2 presenta una comparación de los dos enfoques, en cuanto a ventajas y desventajas. En ambos casos, la comprensión del gesto es muy amplia y aplica para diferentes partes del cuerpo: estos faciales [33], con las manos [5], [34], [35], con los dedos [4], [5], [20], o de cuerpo entero [8], [36]. En algunos casos, la complejidad técnica de reconocer la secuencia de acciones que definen un gesto ha llevado a que se utilicen objetos que restrinjan la interacción [11], [18].

Tabla 2 Ventajas y desventajas comparativas entre las dos estrategias utilizadas en hci para el uso de gestos como medios de interacción

Fuente: adaptada de [32].

3.3 Reconocimiento de gestos

El proceso de reconocimiento de los gestos requiere seguir los fundamentos de hci: definir modelos de expresión, establecer un rango posible de acciones, restringir el espectro de interacciones, reconocer respuestas -deseadas e indeseadas- del sistema [16], [37].

Así mismo, exige afrontar nuevos desafíos que se encuentran en todas las etapas del proceso de reconocimiento de gestos, en este texto, comprendido en dos grandes etapas: entrenamiento y clasificación/regresión (Fig. 2).

El reconocimiento del gesto se aplica tanto para procesos de clasificación, en los que se etiqueta un conjunto de acciones del usuario, como para procesos de regresión, en los que se anticipa una acción consecuente, a partir de unas acciones previas.

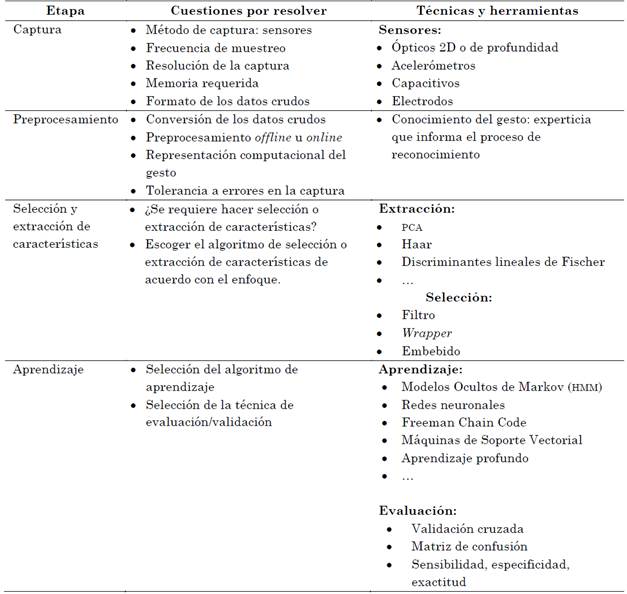

En los dos casos, el proceso de entrenamiento ocurre en cuatro etapas, resumidas en la Tabla 3: captura, pre-procesamiento, selección y extracción de características y aprendizaje. La captura de gestos se suele hacer con diferentes tipos de sensores, entre los que se encuentran: ópticos (cámaras como la PlayStation Eye y cámaras de profundidad como Kinect o LeapMotion) [36], [38], [39]; acelerómetro (SteamVR tracker, Wii Mote); capacitivos (touchpad, pantallas táctiles de dispositivos móviles); giróscopos y electrodos para detección de movimientos musculares (emg-Myo-, eeg-Emotiv-) [37].

Tabla 3 Resumen de las diferentes etapas a considerar en el proceso de reconocimiento de gestos, incluidas las cuestiones que se deben resolver en cada etapa, técnicas y herramientas.

Fuente: elaboración propia.

Además de la selección de sensores, el diseño de la captura de gestos debe responder a cuestiones como: ¿cada cuánto tiempo se captura un dato?, ¿cuál es la resolución requerida para el convertidor analógico-digital?, ¿cuánto almacenamiento se requiere para guardar los datos crudos que provee el sensor?

El preprocesamiento, así como la extracción y selección de características, dependen de la aplicación particular y de la forma en que se reconozcan los gestos (por ejemplo, [40], [41], [42], [43]). Estas etapas varían según el método de captura y la técnica de reconocimiento y pueden utilizar desde procesos estadísticos (análisis por componentes principales pca [44] o discriminantes de Fisher), hasta algoritmos propios del contexto de aplicación como el de Haar [45], [46].

Algunas de las cuestiones que deben ser respondidas en estas etapas son: ¿qué ventana de tiempo es adecuada para preprocesar un conjunto de datos crudos?, ¿cómo se filtran los datos crudos?, ¿de qué manera se pueden comprimir los datos crudos para mantener la información más relevante, sin demandar demasiado espacio de memoria?, ¿se preprocesa el gesto luego de capturarlo completamente (offline) o se va preprocesando en tiempo real, a medida que la persona lo hace (online)?, ¿cómo se representa computacionalmente el gesto? Y, si se pierde un segmento de la información, ¿cómo se conserva el gesto.

Para el aprendizaje de máquina y la etapa de clasificación o regresión, se han utilizado diferentes técnicas, entre las que destacan: Modelos Ocultos de Markov (hmm) [15], [33], [34], [47], Redes Neuronales [34], Freeman Chain Code [44], Máquinas de Vectores de Soporte [48], [49], [50], evolución neuronal [35] y aprendizaje profundo [51], [52].

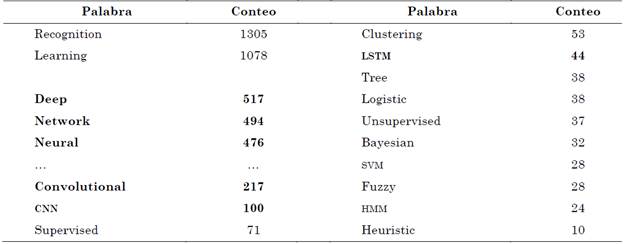

Para revisar las tendencias sobre algoritmos de reconocimiento utilizados en la clasificación o regresión de gestos, se hizo una búsqueda filtrada por la fecha de publicación, en la cual se escogieron solo artículos del presente año: 2019. Asimismo, se utilizó la ecuación de búsqueda: “Gesture and (Classification or Regression or Recognition)”. Luego, se concatenaron los textos de título, resumen y palabras clave de los resultados y se contaron las palabras para estimar cuáles son los algoritmos más utilizados actualmente.

Los hallazgos muestran que el aprendizaje profundo (deep learning) y, en particular, las redes neuronales convolucionales son los algoritmos utilizados con mayor frecuencia (ver Tabla 4).

Tabla 4 Palabras más frecuentes en relación con los algoritmos de aprendizaje, en los títulos, resúmenes y palabras clave resultantes de la ecuación “Gesture and (Classification or Regression or Recognition)”

Fuente: elaboración propia.

Adicionalmente, se encontró también la existencia de palabras frecuentes como clustering y unsupervised, asociadas a técnicas no supervisadas; o tree y fuzzy, asociadas a árboles de decisión y lógica difusa como técnicas no estadísticas.

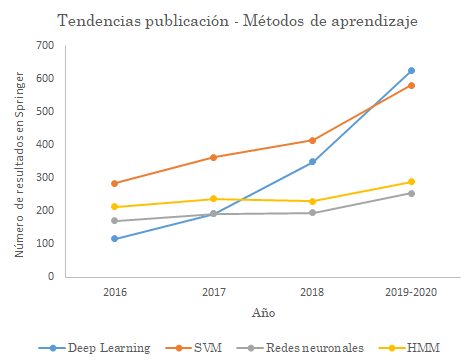

El análisis sobre las tendencias finalizó con la selección de la fuente de búsqueda Springer, debido a que tenía una mayor cantidad de resultados en las publicaciones referentes a reconocimiento y a modelado.

Como indicador se obtuvo la cantidad de publicaciones en las que se mencionara el algoritmo o técnica de clasificación, de acuerdo con las siguientes ecuaciones de búsqueda: i) Deep Learning: Gesture and (“deep learning” or “convolutional neural network”), ii) svm: Gesture and (“Support Vector Machine” or “svm” or “SVR”, iii) Redes neuronales: Gesture and “neural networks” and not “Deep” and not “convolutional”, iv) hmm: Gesture and (“hidden markov model” or “hmm”).

Las publicaciones incluidas en el conteo fueron separadas por año y limitadas a las áreas de ingeniería y ciencias de la computación. Los resultados se muestran en la Fig. 2.

3.4 Aplicaciones y desafíos

En las áreas de aplicación de las interacciones basadas en gestos que se encuentran más a menudo [5], sobresalen la de robótica [15], [33], [47], [53], en particular el campo de la robótica suave; las tareas recurrentes en hci como seleccionar, maximizar, arrastrar, copiar, pegar [54]; la preservación cultural [44]; la computación incluyente que involucra grupos poblacionales particulares como niños, adultos mayores, personas con capacidades limitadas o movilidad reducida; o los videojuegos [55], [56], [57].

En esos campos, se detectaron los siguientes desafíos de interés actual: i) Segmentación [58]. En aplicaciones en las que un gesto siga al siguiente, ¿cómo reconocer cuándo acaba un gesto e inicia el otro?, ¿cómo separar un gesto del contexto en el que ocurre? (del fondo). ii) Concurrencia. Si un gesto es capturado con múltiples sensores, del mismo o diferente tipo, o usando diferentes máquinas, ¿cómo fusionar los datos?; si el sistema de cómputo es utilizado por múltiples personas a la vez, ¿cómo diferenciar los gestos de una persona respecto a otra?, ¿existen los gestos colectivos, que son ejecutados por más de una persona?

En caso tal, ¿cómo reconocer dichos gestos? iii) Experiencia de usuario. ¿Cómo garantizar que el usuario puede completar una tarea con un gesto?, ¿cómo realimentar al usuario cuando no puede completar una acción a través de un gesto?, ¿qué herramientas se proveen al usuario en caso de que no pueda hacer un gesto?, ¿cómo enseñarle al usuario a hacer gestos que sean reconocidos por la máquina? iv) Estudios culturales. ¿Cómo representar computacionalmente los gestos?, ¿es posible estandarizar esa representación?, ¿cómo afecta el contexto cultural el proceso de reconocimiento computacional de gestos?, ¿de qué manera desarrollar estudios culturales relacionados con las expresiones gestuales de una comunidad, desde el área de hci? v) Adaptación. ¿Cómo diseñar máquinas que no solo reconozcan gestos específicos, sino que puedan adaptarse a los gestos de sus usuarios?, ¿de qué forma se pueden adaptar los algoritmos de reconocimiento de gestos para que sea posible que se modifiquen cuando los gestos de las personas cambian?

4. CONCLUSIONES

El tema de interacciones basadas en gestos se percibe como reciente. Sin embargo, la interacción de los humanos con herramientas, máquinas e instrumentos musicales, a través de gestos, es innata.

No por esto se puede considerar que las interfaces basadas en gestos son naturales; si bien la comunicación no verbal es parte de la naturaleza humana, los gestos con los que se lleva a cabo varían de una cultura a otra, son efímeros, pueden cambiar con el contexto o el tiempo.

De otro lado, la investigación en gestos como medio de interacción con los computadores se ha centrado en la dirección humano a máquina; esto es, cómo los computadores reconocen gestos para que el sistema responda a ciertas intenciones o acciones del usuario.

Sin embargo, queda abierta la posibilidad de preguntarse acerca de la comunicación en sentido contrario: ¿pueden las máquinas expresar gestos por los que los humanos sientan empatía (o apatía)? En temas de inteligencia artificial, se hace referencia a la solución de problemas por sistemas artificiales, lo que ha derivado en sistemas que resuelven problemas como el juego de go. Sin embargo, en problemas en los que se requiere un componente corporal y de empatía, como en un juego de póquer, ¿cuál es el rol de la máquina?, ¿será posible resolver este tipo de problemas y que la máquina “le gane'” al humano?

Así mismo, la interacción humano-computador también ha estudiado los gestos como un medio para evaluar la interacción entre el humano y la máquina, de acuerdo con las expresiones faciales y corporales del usuario durante la interacción.

Finalmente, la investigación y desarrollo tecnológico de métodos y herramientas que permitan la comunicación entre el humano y el computador, a través de gestos, es un tema vigente, de interés tanto para la comunidad académica como para la industria. El trabajo es aún incipiente, pero ha facultado la formulación de diversas preguntas de investigación, algunas mencionadas en el presente artículo. Es de gran importancia una visión holística de las interacciones basadas en gestos, que permita afrontar desafíos técnicos, también desde dimensiones culturales, sociales y psicológicas.