Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO -

Similars in Google

Similars in Google

Share

Acta Colombiana de Psicología

Print version ISSN 0123-9155

Act.Colom.Psicol. vol.16 no.1 Bogotá Jan./June 2013

ARTÍCULO

CUESTIONARIO DE ESTRATEGIAS PARA LA ESCRITURA DE ENSAYOS ARGUMENTATIVOS

QUESTIONNAIRE ON STRATEGIES FOR ARGUMENTATIVE ESSAY WRITING

QUESTIONÁRIO DE ESTRATÉGIAS PARA A ESCRITURA DE ENSAIOS ARGUMENTATIVOS

ALBA LUCÍA MENESES BÁEZa

UNIVERSIDAD DE GRANADA- ESPAÑA

a Universidad de Granada- España. alba.meneses@gmail.com. Este trabajo hace parte de la tesis para optar por el título de Doctor en Didáctica Curriculum y Organización escolar de la Universidad de Granada bajo la dirección de Rosario Arroyo Ph.D. y Francisco Salvador Mata Ph.D. La autora agradece a Rosario Arroyo y a Francisco Salvador Mata, directores de la tesis doctoral por su apoyo para el desarrollo del presente trabajo.

Recibido, noviembre 12 /2012

Concepto evaluación, abril 5/2013

Aceptado, mayo 27/2013

Resumen

El presente artículo presenta los resultados de la investigación cuyo objetivo fue establecer indicadores de confiabilidad y validez a la versión abreviada del Cuestionario de Estrategias para la Escritura de Ensayos (Meneses Báez & Salvador Mata, 2006) de 37 ítems tipo Likert (1= nunca y 4= siempre) que mide planificación, transcripción, revisión y meta cognición fue aplicada a 540 estudiantes voluntarios de pregrado. El análisis se realizó con 486 estudiantes que no presentaban puntajes extremos. Se estimaron indicadores de confiabilidad y validez utilizando el modelo Rasch y evidencia para validez de criterio. Los resultados sustentan unidimensionalidad y ajuste de la medida, coeficientes de consistencia interna y confiabilidad Rasch para personas e ítems >.90; estadísticos de separación para personas e ítems >2; ítems distribuidos a lo largo de la regla Rasch; categorías de respuesta con progresión monótona y distancia entre categorías apropiada; las correlaciones entre CEEEA-37 y las escalas de Autorregulación y Percepción de Autoeficacia en la Escritura fueron >.5 (p<.05). Esta prueba puede contribuir a mejorar la evaluación e intervención en la escritura de ensayos argumentativos en universitarios, se deben elaborar ítems con mayor dificultad y realizar un nuevo estudio de campo.

Palabras clave: Estrategias cognitivas, ensayos argumentativos, universitarios, escala, modelo Rasch

Abstract

This article presents the results of a research project aimed to identify reliability and validity indicators for the abreviated version of the Cuestionario de Estrategias para la Escritura de Ensayos (Questionnaire on Strategies for Essay Writing) (Meneses Baez & Salvador Mata, 2006) consisting of 37 Likert-type items (1 = never and 4 = always) which measures planning, transcript review and meta cognition and was administered to 540 undergraduate student volunteers. The analysis was performed with 486 students who obtained no extreme scores. Reliability and validity indicators were estimated using Rasch model and evidence for criterion validity. Results support unidimensionality and measurement adjustment; Rash coefficients for internal consistency and reliability for people and items were>.90; separation statistics for people and items were >2; items were distributed along the Rash rule; response categories with monotonous progression and appropriate distance between categories; correlations between the CEEEA-37 and the Self-regulation and Self-efficacy Perception Scales on writing were> 0.5 (p <.05). This test can help improve assessment and intervention in writing argumentative essays in college. Items with greater level of difficulty should be constructed and another field study should be carried out.

Key words: cognitive strategies, argumentative essays, college students, scale, Rasch model.

Resumo

O presente artigo apresenta os resultados da pesquisa cujo objetivo foi estabelecer indicadores de confiabilidade e validade para a versão abreviada do Questionário de Estratégias para a Escritura de Ensaios (Meneses Báez & Salvador Mata, 2006) de 37 itens tipo Likert (1= nunca e 4= sempre) que mede planejamento, transcrição, revisão e meta cognição foi aplicada a 540 estudantes voluntários de graduação. A análise foi feita com 486 estudantes que não apresentavam pontuações extremas. Estimaram-se indicadores de confiabilidade e validade utilizando o modelo Rasch e evidência para validade de critério. Os resultados sustentam unidimensionalidade e ajuste da medida, coeficientes de consistência interna e confiabilidade Rasch para pessoas e itens >.90; estatísticos de separação para pessoas e itens >2; itens distribuídos ao longo da regra Rasch; categorias de resposta com progressão monótona e distância entre categorias apropriada; as correlações entre CEEEA-37 e as escalas de Autorregulação e Percepção de Autoeficácia na Escritura foram >.5 (p<.05). Este teste pode contribuir com o melhoramento da avaliação e intervenção na escritura de ensaios argumentativos em universitários, deve-se elaborar itens com maior dificuldade e realizar um novo estudo de campo.

Palavras chave: Estratégias cognitivas, ensaios argumentativos, universitários, escala, modelo RaschIntroducción

La escritura de ensayos argumentativos es una de las tareas académicas que con mayor frecuencia deben realizar los estudiantes de pregrado, tanto en artes, como en ciencias sociales (Díaz, 1999, 2002; Hounsell, 1997; Read & Francis, 200; Torres, 2004). Esta competencia se considera esencial para el éxito académico de dicha población, pues sirve como una estrategia de evaluación y como un medio de aprendizaje (Camps, & Miliam, 2000; Nussbaum & Cardas, 2005; Read & Francis, 2001; Rijlaarsdam, Couzijn, Janssen, Braaksma, & Kieft, 2006; Hounsell, 1997 Tolchinsky, 2000; Torrance, Thomas & Robinson, 2000).

El ensayo más utilizado en el medio universitario es un texto que permite la descripción y el análisis de un tema en una extensión limitada, con una estructura específica que le exige al autor asumir una posición personal y sustentarla con evidencia empírica y/o teórica (Frias 1996). Aunque existen diferentes tipos de ensayos, para el presente estudio se aborda aquél que tiene como propósito defender una tesis con argumentos, mediante citas o referencias, datos concretos de experiencias investigativas, alusiones históricas, políticas u otras, fundamentos epistemológicos, filosóficos o de otra índole. En este contexto, un ensayo es un texto argumentativo que presenta una de las siguientes estructuras: a) planteamiento de un problema, formulación de una hipótesis implícita o explícitamente alrededor del problema planteado, desarrollo de argumentos y elaboración de conclusiones para confirmar o refutar la hipótesis; b) planteamiento de una tesis, opinión o hecho que se desea argumentar, desarrollo de los argumentos y elaboración de conclusiones y c) combinación de las dos estructuras anteriores, esto es, plantear un problema y formular una hipótesis, presentar alternativas de diversas tesis y argumentos como propuestas de solución al problema y finalmente, plantear la conclusión (Meneses Báez, Salvador Mata & Ravelo, 2007). Por lo tanto, para escribir un ensayo los estudiantes requieren, además del dominio crítico de un área de conocimiento, la utilización efectiva del lenguaje para comunicarse apropiadamente (Díaz, 1999, 2002; Read & Francis, 2001).

En la investigación sobre escritura de ensayos se ha prestado insuficiente atención a los patrones de trabajo que los estudiantes de pregrado realizan cuando hacen ensayos (Torrance et al, 2000). En este estudio se privilegiará el enfoque de proceso, por cuanto establece los procesos cognoscitivos que ocurren durante la construcción de un ensayo y su identificación, que pueden contribuir al desarrollo de una intervención que propicie la construcción de ensayos de alta calidad (Zamel, 1987, citado por Salvador Mata, 2005). De acuerdo con este autor, el enfoque de proceso aborda a) procesos cognoscitivos que desarrolla el escritor en la composición escrita (planificación, revisión y transcripción); b) habilidades metacognitivas implicadas en el desarrollo de los procesos de conocimiento del proceso de la escritura y de su significado: conocimiento de la estructura textual, conocimiento de las propias capacidades, capacidad de auto-regular los procesos; c) componente afectivo: actitud ante la escritura, auto-percepción de la propia eficacia para escribir y d) adquisición y desarrollo de la competencia para escribir (Salvador Mata, 2005).

Por otra parte, la evaluación estandarizada de ensayos es incipiente en Colombia; aunque se considera una herramienta necesaria para la evaluación de las intervenciones en el aula de clase. Meneses Báez y Salvador Mata (2006) desarrollaron un cuestionario de estrategias para escritura de ensayos a partir de la propuesta de guía de entrevista cognitiva sobre el proceso escritor (Salvador Mata, 2005). El cuestionario consta de 68 ítems tipo Likert en una escala de 1= muy en desacuerdo hasta 5 = muy de acuerdo, que evalúan la forma en que los estudiantes escriben los ensayos, en relación con las estrategias utilizadas de planificación (ítems 1 al 34), revisión (ítems 35 a 49) y meta cognición (50-68). El cuestionario presenta un coeficiente de consistencia interna alpha de Cronbach de 0.93 para la prueba total; para las subpruebas de estrategias de planificación, estrategias de revisión y estrategias metacognitivas los coeficientes de consistencia interna alpha de Cronbach son de 0.89, 0.80 y 0.83, respectivamente. El cuestionario no incluía estrategias de transcripción que se consideran como un elemento importante a tener en cuenta en el proceso de construcción de textos, y el número de ítems (68) lo hacían dispendioso para el aula de clase. Por esta razón los autores decidieron diseñar una versión abreviada del cuestionario, agregando el componente de estrategias de transcripción, con base en el sistema de categorías conceptuales propuestas por Salvador Mata (2005) y los miembros de su grupo ED. INVEST de la Universidad de Granada para evaluar los procesos de planificación, transcripción, revisión y las estrategias metacognitivas.

Dicha red conceptual se fundamenta en el modelo propuesto Flower y Hayes (1980, 1981), modificado por Hayes (1996), como en el modelo de Bereiter y Scardamalia (1987), los cuales se enmarcan en la psicología cognitiva y se derivan del modelo de solución de problemas, propuesto por Newell y Simon (1972) (citado por Torrance y Galbraith, 2006). Estos autores aplicaron el modelo de solución de problemas y la metodología de pensar en voz alta al proceso escritor para evidenciar las diferencias entre el comportamiento cognitivo de un experto y un novato. Los procesos propuestos por los modelos antes enunciados han sido validados por diferentes estudios (Breetvelt, Van den Bergh & Rijlaarsdam, 1994; Meneses-Báez, Hernández, Lesser-Sanabria y Sáenz-Correal, 2009; Meneses Báez, Salvador Mata & Ravelo, 2007; Rau & Sebrechts, 1996; Van den Bergh & Rijlaarsdam, 1999; Whitaker, Berninger, Johnston, & Swanson, 1994).

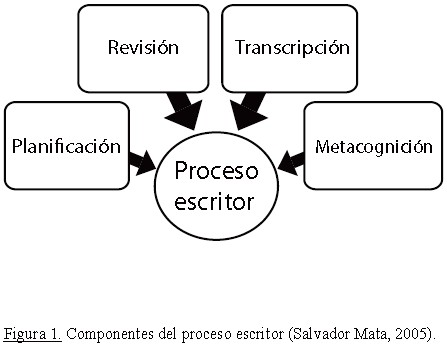

Como se enunció antes, el cuestionario de estrategias para la escritura de ensayos argumentativos, objeto de este estudio comprende los procesos de planificación, la revisión, la transcripción y la metacognición propuestos en la Guía de entrevista cognitiva desarrollada por Salvador Mata y su grupo de investigación (2005). De acuerdo con esta guía la planificación se refiere a los procesos de pensamiento del sujeto sobre el contenido, la organización y los objetivos de la composición escrita e incluye las operaciones cognitivas de génesis de ideas, audiencia, objetivos y finalidades de la intención (véase figura 1).

El proceso de planificación incluye, tanto los objetivos de la composición con base en la tarea, el tipo de escrito y la audiencia, como la generación de contenido o ideas, en relación con lo que se va a escribir (planificar contenido) o cómo se va a escribir (planificar proceso), lo cual implica búsqueda de información en la memoria a largo plazo. Para ello, se utilizan estrategias como la selección y secuenciación de ideas, búsqueda de fuentes de ideas, registro de ideas, entre otras (véase figura 2). La selección y organización del contenido se realiza con base en los objetivos planeados para el texto como en su estructura, para lo cual es necesario que el escritor conozca la estructura del texto que pretende escribir. Para planificar un texto, el escritor debe conocer el tema, tener capacidad para recuperar el conocimiento de su memoria a largo plazo, poseer estrategias adecuadas para hacer búsqueda de información, conocer la estructura del texto y mantener continuidad temática a través del mismo.

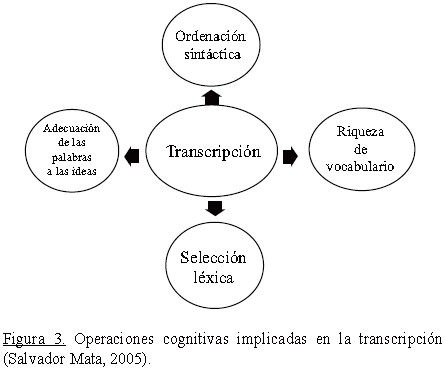

El proceso de transcripción permite la génesis del texto, o sea, la estructuración de las ideas en palabras, oraciones y estructuras discursivas; así como la transcripción de las ideas de la memoria verbal de trabajo a símbolos ortográficos (véase figura 3). Por lo tanto, en este proceso, el escritor pone de manifiesto el dominio que posee en relación con la ortografía de las palabras y la correspondencia gráfica de las palabras al signo oral; así como con los procesos cognitivo-lingüísticos de elección lexical (vocabulario y uso de palabras en relación con las reglas gramaticales), de construcción morfológica (género, número, tiempo, aspecto, los sufijos en la composición de las palabras) y sintáctica (construcción de oraciones, relaciones de coordinación y subordinación entre preposiciones). Además, el escritor requiere del dominio de la gramática textual que le permita dar forma a las ideas y articularlas, así como conocer la estructura de los distintos tipos de texto.

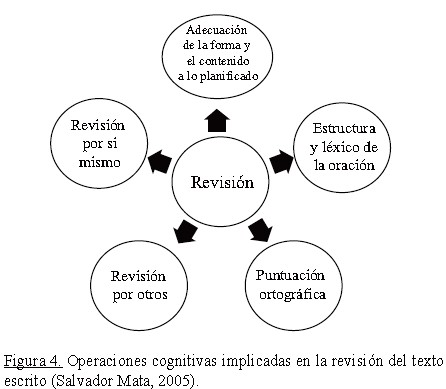

El proceso de Revisión contribuye a cualificar la calidad comunicativa del texto; para ello el escritor debe leer el texto pensando en el lector al que va destinado para detectar fuentes posibles de ambigüedad y añadir información nueva, si fuera necesario, para hacer más explícito el significado, así como solicitar la revisión por otros (véase figura 4).

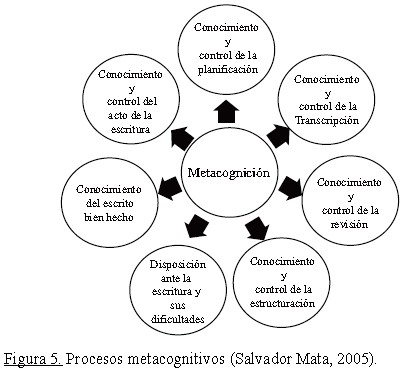

Los procesos meta-cognitivos: en el proceso escritor hacen referencia a los procesos de alto nivel (véase figura 5), que supervisan o controlan los procesos ejecutivos (planificación, transcripción y revisión).

Según Salvador Mata (2005), los contenidos o referentes de los procesos metacognitivos en el proceso escritor se refieren al conocimiento del proceso, de la estructura textual y de la autorregulación. El primero se refiere al conocimiento consciente, declarativo, procedimental y condicional. El declarativo se refiere al conocimiento consciente de lo que implica saber escribir bien -procesos ejecutivos, estructura y forma del texto, estrategias que deben seguirse y actitudes a adoptar. El procedimental tiene que ver con cómo y cuándo hay que aplicar los conocimientos descritos en una situación específica, al escribir un texto. El condicional hace alusión al tipo de estrategias que se deben utilizar para elaborar un texto. El segundo tiene que ver con el conocimiento de sus capacidades (capacidad para evaluar sus conocimientos, ejecución y habilidades). El tercero se refiere, tanto al control y regulación del proceso escritor, como a la calidad del texto producido. Las dificultades que tienen los escritores con los procesos meta cognitivos pueden deberse a la falta o insuficiencia de conocimiento de las estructuras textuales, así como a deficiencia de estrategias cognitivas auto - regulatorias o lingüísticas, o a la falta de conciencia de los conocimientos y las capacidades que se requieren para ejecutar los procesos escritores.

Método

Tipo de estudio

La presente investigación es un estudio psicométrico que pretende establecer evidencia sobre indicadores de confiabilidad y validez de la prueba CEEEA-37.

Participantes

La muestra estuvo conformada por 540 estudiantes de pregrado de una universidad privada con edades comprendidas entre 16 y 46 años (M=21,38 DE=4,32) y el análisis se realizó con 486 estudiantes sin puntajes extremos (véase Tabla 1).

Instrumentos

A continuación se describen los instrumentos utilizados:

Cuestionario de estrategias para la escritura de ensayos argumentativos (CEEEA-37), realizada por los autores de este estudio, con base en la desarrollada por Meneses Báez & Salvador Mata (2006), pretende medir las estrategias cognitivas que utiliza un estudiante universitario de pregrado en la construcción de un ensayo argumentativo. Esta prueba consta de 37 ítems tipo Likert (1 = nunca y 4 = siempre) y cuatro sub-escalas: Planificación (14 ítems), transcripción (6 ítems), revisión (6 ítems) y metacognición (11 ítems). Es un instrumento de autorreporte que se puede aplicar de manera individual o grupal con una duración de entre 10 y 20 minutos.

Escala de estrategias metacognitivas de autorregulación de Pintrich, Simith, García & McKeachie (1991, 1993) adaptada al castellano para este estudio, está conformada por 17 ítems positivos tipo Likert (1= totalmente de acuerdo a 4= totalmente en desacuerdo). Presenta un coeficiente de consistencia interna Alpha de Chronbach de 0.86.

Escala de Auto-percepción de la Eficacia en la Escritura: evalúa cómo el estudiante considera sus habilidades como escritor. Es una adaptación hecha por Meneses Báez & Salvador Mata (2006), a la propuesta por Graham, Schwartz & MacArthur (1993). Se realizó un ajuste y la escala adaptada para este estudio consta de 14 ítems con respuesta tipo Likert (1 = muy en desacuerdo hasta 4 = muy de acuerdo) y presenta un coeficiente de consistencia interna Alpha de Cronbach de 0.81.

Procedimiento

1. Se realizó una revisión preliminar de los 68 ítems de la prueba original y se crearon diez nuevos ítems para la dimensión de estrategias de transcripción. Los ítems se sometieron a evaluación por ocho jueces expertos en cuanto a su pertinencia por dimensión y lo adecuado de la redacción. A partir de las sugerencias presentadas por los jueces, se ajustaron nuevamente los ítems, se re escribieron cuando fue necesario y se eliminaron los que se consideraron redundantes; con base en este procedimiento de depuración se seleccionaron 47 ítems, con los cuales se realizó la entrevista cognitiva con cuatro usuarios potenciales, con el fin de depurar la prueba en cuanto a comprensión de instrucciones y vocabulario, solicitándoles que indicaran aquellos ítems que consideraban poco claros; una vez identificados los ítems en esta situación se les explicó el objetivo de medición y se les solicitó que dieran sus sugerencias para mejorar la redacción.

2. Con base en esta última evaluación se ajustaron dos ítems y la prueba quedó conformada por 47 ítems. Luego se realizó un pilotaje de esta prueba con 180 estudiantes; con base en los resultados se eliminaron nueve ítems que presentaron índice de correlación biserial (entre elemento y prueba) inferior a .30 y/o presentaban estadísticos de ajuste (infit y outfit) con valores que exceden los criterios de aceptación del modelo Rasch (Bond y Fox, 2007).

3. La prueba ajustada con 38 ítems se aplicó a 20 grupos en clase para un total de 540 estudiantes, previa firma de consentimiento informado, junto con las escala de estrategias metacognitivas de autorregulación y de auto-percepción de la eficacia en la escritura.

4. El análisis de datos se realizó con 486 estudiantes que no presentaron datos extremos; se establecieron indicadores de confiabilidad y validez utilizando el programa Win Steps versión 3.73.0 y aplicando la teoría de respuesta al ítem modelo Rasch. Adicionalmente, se estimó el grado de asociación entre el desempeño en la prueba y las variables criterio.

5. Se estimó el DIF para la variable sexo utilizando varios métodos (Bond y Fox, 2007; Linacre, 2012; ETS citado por Elosua & López Jáuregui, 2007 & López Jáuregui, 2007) y la conclusión fue eliminar un ítem (sé de dónde sacar ideas para escribir un texto realmente bueno), ya que el procedimiento de Mantel fue significativo (p<.05); el valor estimado del tamaño del efecto fue -.36 (>.25), el cual se considera indicador de un DIF severo (ETS citado por Elosua & López Jáuregui, 2007) y coincide con lo encontrado cuando se graficó la regresión del nivel de dificultad del ítem para hombres y mujeres con intervalo de confianza del 95%; este ítem fue el único atípico que quedó por fuera del intervalo de confianza (Linacre, 2012).

6. Finalmente, se evaluó el ajuste de las puntuaciones a la curva normal de cada una de las escalas (CEEEA-37, estrategias metacognitivas de autorregulación y de auto-percepción de la eficacia en la escritura) utilizando la prueba de Kolmogorov Smirnov con el programa SPSSv19; se estimó la correlación entre la prueba CEEEA-37 y las escalas enunciadas como evidencia para validez de criterio.

Análisis estadístico

Para ítems politómicos el modelo Rasch está dado por la probabilidad, Pnij, que la persona n con habilidad Bn presente la categoría j en una escala de valoración aplicada al punto i de dificultad Di en oposición a la probabilidad Pni (j-1) de ser observado en la categoría (j-1); en una escala de Likert, j podría ser "estar de acuerdo" y j-1 sería "neutral", donde Fj sería la dificultad de la categoría (Andrich, 1978, citado por Linacre, 2012c).

loge(Pnij / Pni(j-1) ) = Bn - Di - Fj

Uno de los supuestos del modelo es la unidimensionalidad de la medida, proporcionando estimaciones que sustentan la validez de constructo cuando los datos se ajustan al modelo (Bond & Fox 2007; Conrad & Smith, 2004; Linacre, 2012a; Pardo & Rocha, 2010; Wilson, 2005). Para ello, se estiman los estadísticos de ajuste cercano (infit) y lejano (outfit) para los ítems como para las personas.

En este estudio los estadísticos infit y outfit indican ajuste al modelo para ítems y personas en el rango entre .60 y 1.40 (Bond & Fox, 2007) y cuando el valor obtenido en la correlación biserial producto momento punto medida (PTME) de cada ítem es ≥. 4 (Linacre, 2006; Wilson, 2005). Adicionalmente, se toma como evidencia para unidimensionalidad de la medida, el análisis de componentes principales de residuos, (Linacre, 1998; Smith, 2002). En este análisis se considera fuerte la medida de una dimensión cuando la varianza explicada por la medida es ≥ 40% (Linacre, 2006); moderada cuando es ≥ 30% (Conrad, Conrad, Riley & Funk, 2011; Conrad, Dennis, Bezruczko & Funk, 2007; Conrad, Iris, Ridings, Langley & Wilber, 2010) y mínima aceptable cuando es ≥ 20% (Reckase, 1979). También se asume como evidencia para la unidimensionalidad de la medida la razón de 3 a 1 para la varianza explicada por la medida sobre la varianza no explicada por el primer contraste; así como el valor de <3 para los eigenvalues obtenidos por la varianza no explicada en el primer contraste (Linacre, 2011).

Se estimó la confiabilidad Rasch para personas como para ítems y el criterio utilizado para evaluar este coeficiente fue ≥.80 (Linacre, 2012b), valor similar al estándar propuesto por Nunnally (1978). Otro indicador de confiabilidad fue la medida de separación que señala el número de niveles en unidades de error estándar, en el que la muestra de ítems y de personas pueden agruparse (Green & Frantom, 2002). El valor esperado es ≥2 (Linacre, 2012b). Adicionalmente, se tuvo en cuenta el error estándar de medición que establece la precisión de la medida y se espera que sea cercano a cero (Pardo y Rocha, 2010).

Un estadístico adicional es el de discriminación que indica el nivel de variación de las respuestas a un ítem en relación con el nivel de habilidad y señala el grado en que el reactivo fue respondido correctamente por las personas de alta habilidad e incorrectamente por las personas de baja habilidad. Se consideran adecuados los ítems con valores en discriminación superiores o iguales a 0.7 (Pardo & Rocha, 2010).

Para la evaluación del funcionamiento de las opciones de respuesta tipo Likert según el modelo Rasch se analizó la frecuencia de respuestas, su forma de distribución, los estadísticos de ajuste y los umbrales de cada una de ellas (Bond & Fox, 2007; Linacre, 2002; Linacre 1999).

Para evaluar la invarianza de la medida a través de los subgrupos se estimó el DIF y el DTF. Un contraste significativo de DIF es aquel que presenta una diferencia .5 logitos con p≤.05 cuando se estima el estadístico de Mantel-Haenszel para todas las comparaciones, que es aproximadamente la mitad de una desviación estándar (DE) para el nivel de habilidad de las personas (Bond & Fox, 2007). Por otra parte, se obtuvo el valor del tamaño del efecto para determinar si el DIF era severo (≥ .25), moderado ( ≥18 ≤24) o insignificante ≤ .17 (Educational Testing Service (ETS), citado por Elosua & López Jáuregui, 2007).

El DTF compara el desempeño de una medida en dos grupos, como si fueran dos pruebas utilizando un gráfico de dispersión (Linacre, 2012a). Según este autor, dicho análisis muestra información del sesgo de la prueba en función del grupo, estima la dificultad de cada ítem por grupo en un sistema de coordenadas x y y, donde el eje x presenta el nivel de dificultad de los ítems para un grupo y el eje y el nivel de dificultad de los ítems para otro grupo. La línea punteada, denominada línea de comunalidad, predice los valores de x a partir de los valores de y e igualmente, los valores de y son predichos a partir de los valores de x, teniendo en cuenta la media + 2DE de ambas distribuciones, aproximadas a un 95% de intervalo de confianza.

Resultados

A continuación se describen los resultados del proceso de validación de la prueba CEEEA-37 con base en las puntuaciones obtenidas por 486 estudiantes de pregrado. Se presentan evidencias para confiabilidad, unidimensionalidad de la medida, análisis de categorías de respuesta, análisis de funcionamiento diferencial de los ítems (DIF) y de la prueba (DTF).Así mismo se presenta evidencia para validez de criterio de la prueba CEEEA-37 con las escalas de los instrumentos sobre Estrategias Metacognitivas de Autorregulación, y Auto-percepción de la Eficacia en la Escritura.

Confiabilidad

La confiabilidad de personas Rasch fue .90 y el estadístico de separación de personas fue de 2.98 ; el coeficiente Alpha de Cronbach fue de .92. La confiabilidad de los ítems Rasch fue .98 y el estadístico de separación de los ítems fue de 7.43.

Unidimensionalidad de la prueba CEEEA-37

La varianza explicada por la medida (37 ítems) fue de 31.7 %; la varianza residual explicada por el primer contraste fue de 7.2%. El número de eigenvalues para la varianza residual del primer contraste fue de 2.7. La razón obtenida del porcentaje total de varianza explicada por los ítems y el porcentaje de la varianza no explicada por el primer residual fue de 4.40.

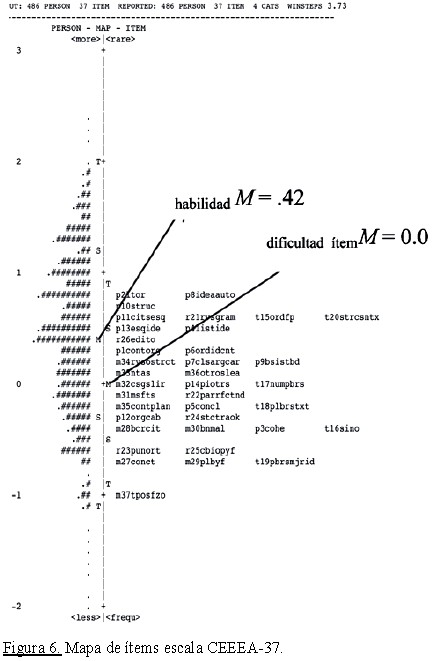

El mapa de Wright (véase figura 6) presenta la regla de Rasch para la versión de CEEEA-37. La escala de medida en logitos está en el rango de -2 a +3. Los 37 ítems se encuentran al lado derecho de la línea punteada. La media de habilidad de las personas fue habilidadM = .42 ( DE = .77) y la media de la dificultad de los ítems fue dificultadM = .00 (DE =. 47).

Estadísticos de Ajuste de los Ítems de CEEEA-37 al Modelo Rasch

En cuanto a los estadísticos de ajuste estimados infit y/o outfit, 36 ítems de la prueba CEEEA-37 se ajustan al modelo Rasch (0.6 - 1.4). El ítem m36otroslea presenta valores por encima de los esperados por el modelo para el infit y outfit, la correlación de cada uno de los 37 ítems con la prueba fue r ≥.4, el error de estimación de cada uno de los 37 ítems oscila entre .06 y .07 y 34 ítems presentan una discriminación >.65; los ítems m36otroslea, p8ideaauto y r23punort presentan un valor de discriminación <.65 (véase Tabla 2).

Análisis de categorías de respuesta

Las opciones de respuesta presentan una frecuencia > 10, progresión monotónica de una categoría a otra; las categorías presentan una distribución regular, los valores de los estadísticos de ajuste lejano y cercano se encuentran entre ≥.6 y ≤1.4 y la distancia entre categorías está ≥1.40 y ≤ 5.

Análisis DIF y DTF

Se estimó el DIF y DTF para sexo y para jornada. Los ítems t17numpbrs y r23punort presentan un DIF significativo (p< .005) para sexo con Mantel Haenzel, pero, la diferencia entre grupos es insignificante en razón a que la DE para personas de la prueba CEEEA-37 = .77; = .385 logitos, (t17numpbrs: (-.19 - .08 = -.27) y r23punort: (-.74 - (-.36= -.38). Por lo tanto, la diferencia para ambos ítems es menor a .385 .5 logitos. Cuando se estimó la medida del tamaño del efecto (SMD/Si) para t17numpbrs (SMD/Si = -.18) y r23punort (SMD/Si = .19), ambos ítems presentan DIF moderado (> .17 y <.25). Por otra parte, cuando se estimó el DTF para sexo con intervalo de confianza del 95%, los 37 ítems se ubican dentro del intervalo de confianza.

El ítem t17numpbrs presenta un DIF significativo (p< .005) para Jornada (diurna y nocturna) con el estadístico de Mantel Haenzel. Pero cuando se toma en cuenta que CEEEA-37DE = .77; = .385 logitos, se concluye que la diferencia entre grupos para este ítem es insignificante (-.08-.12 = -.2 < .385 .5 logitos). Así mismo, la medida del tamaño del efecto (SMD/Si) confirma que el DIF es insignificante (SMD/Si = .13 < .17). Por otra parte, el DTF para los grupos de horario diurno y nocturno con intervalo de confianza del 95%, indica que los ítems se encuentran ubicados en el límite del intervalo de confianza.

Validez de criterio

De acuerdo con lo propuesto por Campbell y Fiske (1959), como evidencia para la validez de criterio se estimó la correlación de Pearson entre las puntuaciones de la prueba CEEEA-37 y las escalas de estrategias metacognitivas de autorregulación (EMA), y de auto-percepción de la eficacia en la escritura (AAE), previo cálculo de la prueba de Kolmogorov-Smirnov (N>30) para evaluar el ajuste de las puntuaciones de cada prueba a la curva normal (p≤ 0.05). Los coeficientes de correlación obtenidos fueron significativos (p<.05) y moderadamente altos con la escala EMA (.531) y AAE (.579)

Discusión

Las pruebas estadísticas realizadas utilizando el modelo Rasch sustentan la unidimensionalidad de la prueba CEEEA-37, indicando que los diferentes componentes de la prueba hacen parte del constructo latente de estrategias para la construcción de ensayos argumentativos (Bond y Fox, 2007; Conrad & Smith, 2004; Linacre, 2011; Linacre, 2012c; Pardo & Rocha, 2010; Wilson, 2005). Un ejemplo es el porcentaje de la varianza residual explicada por el primer contraste (7.2%) (Reckase, 1979). Por otra parte, el porcentaje de varianza explicada siempre es mayor a 30%, tanto para la muestra completa como cuando se extrae por cada grupo de sexo y jornada; dichos valores superan bien el criterio mínimo propuesto para que se considere que la prueba mide un solo factor (Reckase, 1979). Igualmente, los valores obtenidos por el PTME (>.4) para los 37 ítems sugieren que la prueba mide un solo constructo (Crocker & Algina, 1986; Linacre, 2006; Wilson, 2005).

El valor estimado del coeficiente de consistencia interna, utilizando el método Alpha de Cronbach, sugiere precisión en la medida y que todos los ítems aportan a éste (Crocker & Algina, 1986; Linacre, 2011; Linacre, 2012c, Nunnally, 1978). Así mismo, los indicadores estimados de confiabilidad Rasch para las personas y para los ítems confirman precisión en la prueba (Bond y Fox, 2007; Crocker & Algina, 1986; Wilson, 2005).Igualmente, el estadístico obtenido de separación para personas e ítems indica que la medida no muestra redundancia en los ítems por cuanto presenta más de tres grupos de habilidad de las personas y más de siete grupos de dificultad de los ítems (Green & Frantom, 2002; Linacre, 2012b).

El mapa de Wright muestra que el nivel de la dificultad de la prueba es adecuado para la mayoría de personas con el mismo nivel de habilidad, hecho que se sustenta en que los valores de la media de dificultad de los ítems y de habilidad de las personas están a menos de un logito (Bond y Fox, 2007; Conrad & Smith, 2004; Pardo & Rocha, 2010; Wilson, 2005) así como en el hecho que los ítems de la prueba CEEEA-37 se distribuyen a lo largo de la regla Rasch, lo cual sugiere que estos miden un solo constructo; sin embargo, se requiere incluir ítems de mayor dificultad para evaluar a personas que tienen un mayor nivel de habilidad.

Con respecto al estadístico de discriminación Rasch, los ítems que presentan un índice inferior al criterio son p8ideaauto y m36otrosle; el primero corresponde a la dimensión de planificación y el último a revisión, datos que implican violación al supuesto de discriminación (Crocker y Algina, 1986; Hambleton & Jones, 1993). Aunque, de acuerdo con Harris (1989), este supuesto puede ser transgredido cuando la muestra no es grande.

No se elimina ningún ítem como resultado de este estudio de campo, a pesar de que el ítem m36otroslea presenta los estadísticos de ajuste >1.4, por cuanto los estadísticos obtenidos no cumplen con todo lo propuesto (Infit y Outfit >1.4 y el valor estimado PTME <.3 (Wilson, 2005). Una posible causa de acuerdo con Hambleton y Jones (1993), entre otras, podría ser el no haber utilizado una muestra grande (N>500).

Finalmente, los resultados de los procedimientos utilizados para evaluar la invarianza de las estimaciones del nivel de dificultad de los ítems de la prueba CEEEA-37 a través de los grupos de sexo y jornada sugieren que no hay DIF (Bond & Fox, 2007) ni DTF (Linacre, 2012a). Sin embargo, cuando se estima el tamaño del efecto (SMD/Si) para los ítems t17numpbrs y r23punort para la variable sexo, los resultados indican que ambos ítems presentan DIF moderado (Elosua & López Jáuregui, 2007), razón por la cual no se eliminaron.

Se concluye que los ítems del cuestionario CEEEA-37 presentan una adecuada calibración de acuerdo con el modelo Rasch, lo cual sugiere que la prueba mide un solo constructo; pero es necesario incluir ítems con mayor nivel de dificultad que midan altos niveles de habilidad; obtener nuevamente evidencia para validez de contenido, así como incrementar el tamaño de la muestra y realizar un nuevo estudio de campo que permita obtener evidencias adicionales de validez de constructo y de criterio, e indicadores de confiabilidad para contar con un instrumento de calidad que contribuya a la evaluación, intervención y seguimiento de la escritura de ensayos en estudiantes de pregrado.

Referencias

1. Bereiter, C. & Scardamalia, M. (1987). The Psychology of Written Composition. Hillsdale. NJ: Lawrence Erlbaum Associates. [ Links ]

2. Breetvelt, I, Van den Bergh, H. & Rijlaarsdam, G. (1994). Relations between writing processes and text quality: When and how? Cognition and Instruction 12, 103-123. [ Links ]

3. Bond, T.G. & Fox, C.M. (2007). Applying the Rasch Model: Fundamental measurement in the human sciences. (2nd Ed.) Mahwah, NJ: Erlbaum Associates. [ Links ]

4. Campbell, D. T. & Fiske D. W. (1959). Convergent and discriminant validation by the multitrait-multimethod matrix. Psychological Bulletin. 56, 81-105. [ Links ]

5. Camps, A. Miliam, M. (2000). La actividad metalingüística en el aprendizaje de la escritura. M. Miliam & A. Camps (eds.) El Papel de la Actividad Metalingüística en el Aprendizaje de la Escritura. Rosario, Santafé, Argentina: Homo Sapiens. [ Links ]

6. Conrad, K. J., Conrad, K. M., Riley, B.B. and Funk, R. (2011). Validation of the Substance Problem Scale (SPS) to the Rasch Measurement Model, GAIN Methods Report. Chicago, IL: Chestnut Health Systems, 1-32. [ Links ]

7. Conrad, K. J., Iris, M., Ridings, J. W. Langley, K. & Wilber, K. (2010). Self-report Measure of Financial Explotation of Older Adults. The Gerentologist, 50, 6, 758-773. doi:10.1093/geront/gnq054. [ Links ]

8. Conrad, K. J., Dennis, M.L., Bezruczko, N. & Funk, R. (2007). Substance use disorder symptoms: Evidence of differential item functioning by age. Journal of Applied Measurement, 8 (4), 373-387. [ Links ]

9. Conrad, K.J. & Smith, E.V. (2004). International conference on objective measurement: Applications of Rasch analysis in health care. Medical Care, 2004; 42 (suppl I) 1-6. [ Links ]

10. Crocker, L. & Algina, J. (1986). Introduction to Classical and Modern Test Theory. New York: Harcourt Brace Jovanovich College Publishers. [ Links ]

11. Elosua, P. & López Jáuregui, A. (2007). Aplicación de cuatro procedimientos de detección de funcionamiento diferencial sobre ítems politómicos. Psicothema, 19, 002, 329-336. [ Links ]

12. Graham, S., Shwartz, S. y MacArthur, C. (1993). Learning disabled students and normally achieving student's knowledge of writing and the composing process, attitude toward writing, and self-efficacy for students with and without learning disabilities. Journal of Learning Disabilities, 26, 237-249. [ Links ]

13. Green, K. E. & Frantom, C.G. (2002). Survey development and validation with the Rasch model. A paper presented at the International Conference on Questionnaire Development Evaluation, and Testing, Charleston SC, November 14-17. [ Links ]

14. Flower, L. S. & Hayes, J. R., (1981). A cognitive process theory of writing. College Composition and Communication, 32, 365-387. [ Links ]

15. Flower, L. S. & Hayes, J. R., (1980). The dynamics of composing: Making plans and juggling constraints. In L. W. Greeg & E. R. Steinberg (Eds.), Cognitive Processes in Writing. 31-50. Hillsdale, N. J.: Erlbaum. [ Links ]

16. Frias, M. (1996). Procesos Creativos para la construcción de textos. Bogotá, Colombia: Cooperativa Magisterio. [ Links ]

17. Hambleton, R. y Jones R. (1993). Comparison of Classical Test Theory and Item Response Theory and Their Application to Test Development. ITEMS: The Instructional Topics in Educational Measurement Series, 12 (3), 253-262. [ Links ]

18. Harris, D. (1989). Comparison of 1-, 2-, and 3-Parameter IRT Models. ITEMS: The Instructional Topics in Educational Measurement Series, 8 (1), 35-41. [ Links ]

19. Hayes, J.R. (1996). A new framework for understanding cognition and affect in writing. In C. M. Levy, & S. Ransdell (Eds.), The science of writing: Theories, methods, individual differences and applications (pp. 1-27). Mahwah, NJ: Lawrence Erlbaum Associates. [ Links ]

20. Hayes, J. R., & Flower, L. S. (1980). Identifying the organization of writing process. In L. W. Greeg & E. R. Steinberg (Eds.), Cognitive Process in Writing. Hillsdale, NJ: Lawrence Erlbaum Associates. [ Links ]

21. Hounsell, D. (1997). Contrasting Conceptions of Essay-Writing in The Experience of Learning: Implications for Teaching and Studying in Higher Education, Ed. R. Marton; D. Hounsell & N. Entwistle, p. 106-125, Edinburgh: Scottish Academic Press, 0-7073-0749-X. [ Links ]

22. Linacre, L. M. (2012a). Winsteps Tutorial 4. June. Recuperado de http://www.winsteps.com/a/winsteps-tutorial-4.pdf en enero 12 de 2012 [ Links ]

23. Linacre, L. M. (2012b). Winsteps Tutorial 3. June. Recuperado de http://www.winsteps.com/a/winsteps-tutorial-3.pdf en enero 12 de 2012 [ Links ]

24. Linacre, L. M. (2012c). Winsteps Tutorial 2. June. Recuperado de http://www.winsteps.com/a/winsteps-tutorial-2.pdf enero 12 de 2012 [ Links ]

25. Linacre, J.M. (2011). Winsteps Rasch Measurement (Version 3.73.0).http://www.winsteps.com. Author [ Links ]

26. Linacre J.M. (2006). Data Variance Explained by Measures, Rasch Measurement Transactions, 20:1 p. 1045. [ Links ]

27. Linacre, J.M. (2002). Optimizing Rating Scale Category Effectiveness. Journal of Applied Measurement 3, 1, 85-106. [ Links ]

28. Linacre, J. M. (1999). Investigating Rating Scale Category Utility. Journal of Outcome Measurement. 3, 2, 103-122 [ Links ]

29. Linacre, J.M. (1998). Structure in Rasch residuals: Why principal components analysis (PCA)? Rasch Measurement Transactions, 1 (2), 636. [ Links ]

30. Meneses Báez, A. L., Hernández, C., Lesser-Sanabria, N. & Sáenz-Correal (2009). Procesos cognitivos implicados en la construcción de un ensayo en estudiantes universitarios. Cuadernos Hispanoamericanos de Psicología, 10, 2, 7-19. [ Links ]

31. Meneses Báez, A. L. & Salvador Mata, F. (2006). Procesos cognitivos en la escritura de estudiantes universitarios. Departamento de Psicología Evolutiva y de la Comunicación: Universidad de Vigo. [ Links ]

32. Meneses Báez, A. L., Salvador Mata, F. & Ravelo, E. R. (2007. Descripción de los procesos cognitivos implicados en la escritura de un ensayo. Acta Colombiana de Psicología, 10 (1), 83-98. [ Links ]

33. Nunnally, J. C. (1978). Psychometric Theory (2nd ed.). New York: McGraw-Hill. [ Links ]

34. Pardo, C. y Rocha, M. (2010). Manual para el procesamiento y análisis de datos aplicación piloto. En Compendio de los manuales del Serce. Oficina Regional de Educación para América Latina y el Caribe (OREALC/UNESCO Santiago) y del Laboratorio Latinoamericano de Evaluación de la Calidad de la Educación (LLECE), 225-263. [ Links ]

35. Pintrich, P. R., Simith, D., Garcia, T., & McKeachie, W. J. (1993). Reliability and predictive validity of the Motivated Strategies for Learning Questionnaire (MSLQ). Educational and Psychological Measurement, 53 (3), 801-813 [ Links ]

36. Pintrich, P. R., Smith, D. A. F., Garcia, T., & McKeachie, W. J. (1991). A Manual for the Use of the Motivated Strategies for Learning Questionnaire (MSLQ). Ann Arbor, MI: National Center for Research to Improve Postsecondary Teaching and Learning [ Links ]

37. Read, B. & Francis, B. (2001). Playing safe: undergraduate essay writing and the presentation of the student voice. British Journal of Sociology of Education. 22, 387-399. [ Links ]

38. Reckase, M. (1979). Unifactor latent trait models applied to multifactor tests: Results and implications. Journal of Educational Statistics, 4, 207-230. [ Links ]