Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO -

Similars in Google

Similars in Google

Share

Revista de Economía Institucional

Print version ISSN 0124-5996

Rev.econ.inst. vol.3 no.5 Bogotá Jul./Dec. 2001

¿QUÉ TAN RACIONAL ES EL PRINCIPIO DE RACIONALIDAD DE POPPER?

HOW RATIONAL IS POPPER’S RATIONALITY PRINCIPLE?

Boris Salazar*

* Profesor de la Universidad del Valle. El autor agradece los comentarios de los asistentes al Seminario de Investigación del Departamento de Política Económica de la Universidad Complutense de Madrid, y de los participantes en el grupo de Teoría Económica del Departamento de Economía de la Universidad del Valle.

RESUMEN

[Palabras clave: racionalidad, metodología económica, juegos evolutivos, convenciones sociales, equilibrio de Nash, JEL: B41, D79, C70]

Este artículo muestra la pertinencia del principio de racionalidad de Popper para entender la reciente oleada de investigaciones, libros y artículos en los campos de la racionalidad, el aprendizaje y los juegos evolutivos. A diferencia de los rígidos preceptos del Popper falsacionista, este principio cubre una amplia gama de comportamientos compatibles con la idea mínima de actuar en forma adecuada a la situación’. Se argumenta en forma amplia la relevancia de entender los procesos mediante los cuales se forman convenciones sociales o los agentes aprenden a jugar un equilibrio de Nash’.

ABSTRACT

[Key words: rationality, economic methodology, evolutionary games, social conventions, Nash equilibrium, JEL: B41, D79, C70]

This paper shows the relevance of Popper’s Rationality Principle (RP) for the appraisal of the impressive mass work emerging, in recent years, in the fields of rationality, learning, evolutionary games and behavioral economic theory. In contradistinction to the well-known rigid criteria of the falsacionist Popper, the RP covers a large and diverse spectrum of behaviors compatible with the minimal idea of acting in accordance with the situation’. Its relevance to understand the formation of social conventions or how agents learn to play Nash equilibrium’ is argued at length here.

En febrero de 1963, en una conferencia que dictara por invitación del Departamento de Economía de Harvard, Karl Popper (1994) declaró su absoluta admiración por la teoría económica. Habría sido su contacto con ella, 25 años antes, el que le habría permitido arribar a sus puntos de vista acerca de la metodología de las ciencias sociales. Por cierto, sus puntos de vista acerca de lo que se debía hacer con respecto al método en las ciencias sociales no eran ni tímidos ni circunstanciales. La propuesta de Popper era clara y contundente: las ciencias sociales deberían adoptar el método de la economía teórica si querían alcanzar el cielo prometido, pero difícil, de la ciencia contemporánea. Popper era claro, también, en reconocer sus deudas intelectuales al respecto. Habría sido su lectura del texto de Hayek (1937) sobre la lógica de la elección la que lo habría conducido a su formulación de la lógica de la situación como pieza fundamental de su construcción metodológica para las ciencias sociales.

La anécdota suena extraña en los oídos medianamente informados acerca de la metodología de la economía1. Al fin y al cabo, durante años, los miembros de la profesión que se dedicaban a esos menesteres menores habían tenido que viajar hasta las tierras difíciles y exigentes de la falsación popperiana para aplicarla, de regreso, en el ambiguo mundo de la teoría económica.

¿Qué era lo que Sir Karl encontraba tan atractivo en el método de la teoría económica? Una recomendación metodológica fundamental: la observación sistemática del principio de racionalidad. ¿En qué consiste ese principio? En que los agentes relevantes para entender una cierta situación social actúan en forma adecuada o apropiada. Obsérvese la relación entre el principio de racionalidad y la idea de situación social. Para Popper, lo que la economía enseñaba, y él proponía extender a todas las ciencias sociales, era una combinación sistemática de acción racional humana y de situaciones sociales típicas. Una situación social era una interacción típica entre agentes sociales que podía ser reconstruida o representada mediante un modelo que captara los elementos básicos que la constituían. En el centro de todo estaba, por supuesto, un agente racional que era capaz de entender la situación social en la que se encontraba, y elegir el curso de acción más adecuado.

Conjeturo que la combinación del análisis situacional y del principio de racionalidad de Popper han recobrado vigencia, y pueden ayudar a entender el sorprendente y vertiginoso desarrollo en la última década de investigación de frontera en los campos de la racionalidad económica y del aprendizaje en contextos de interacción estratégica y de juegos evolutivos. Esta conjetura puede parecer paradójica y contradictoria. ¿Qué relación puede haber entre un principio tan general como el propuesto por Popper y un desarrollo teórico concreto? ¿Cómo se puede evaluar un principio que excluye tan poco, que parece compatible con tantos tipos de comportamiento? ¿Cómo puede ser compatible esta idea tan general con el uso muy concreto y específico de una idea de racionalidad (la maximización sujeta a restricciones) en la teoría económica convencional de las últimas décadas? Este artículo intenta responder esas preguntas.

¿Qué es lo que excluye el principio de racionalidad de Popper? Todos los comportamientos que no siguen cursos de acción apropiados para la situación que intentan resolver. Pero, ¿qué es lo apropiado? ¿La mejor acción posible? ¿O una acción que, al menos, satisfaga las aspiraciones o las metas alcanzables de los agentes involucrados? Ambas preguntas pueden tener respuestas positivas. Si ambas son posibles, ¿qué es lo que predice, entonces, el principio de racionalidad si todo cabe bajo su protección metodológica? No, lo que en realidad implica el principio de racionalidad es que todo lo que no está definido por la situación representada en el modelo no debe ser considerado ni por los agentes involucrados en la situación que el modelo pretende entender ni por el investigador que lo construye. Se trata de un principio de exclusión débil en el sentido de que no excluye, a priori, un conjunto de comportamientos que no serían consistentes con un criterio definido de racionalidad. Es débil, también, porque no hace una apuesta a favor del predominio de ningún tipo de racionalidad específico, ni de ningún procedimiento racional en particular. Y es débil, en últimas, y de forma deliberada, porque no hace predicción empírica alguna acerca del comportamiento real de ningún tipo de agente. Como dice el mismo Popper, el principio de racionalidad no tiene nada que ver con la afirmación empírica o psicológica de que el hombre actúa racionalmente siempre o, en lo fundamental, en la mayoría de los casos (Popper, 1994, 167).

Al deslindarse en forma tan radical de lo empírico y de lo psicológico, ¿dónde puede situarse, entonces, el principio de racionalidad de Popper? Si no intenta predecir nada, ¿qué es lo que demarca? ¿Qué es lo que prescribe? ¿En qué es fuerte, entonces, el principio de Popper? Es fuerte en un sentido poco considerado por la bibliografía en la materia. Lo es, primero, porque demarca como su dominio a lo metodológico. Segundo, porque considera como lo único relevante, desde ese punto de vista, a lo que está definido en forma explícita dentro de los límites del modelo. Obsérvese el contraste con la actitud de Popper frente a las ciencias naturales. En ese dominio, el criterio de demarcación popperiano requería que toda teoría científica estuviera abierta a la refutación o estuviera hecha, de forma deliberada e imprescindible, para la refutación. En el campo de las ciencias sociales, el principio de racionalidad exige, en cambio, concentrar todo el esfuerzo investigativo en aquello que se hace explícito dentro de los límites del modelo (y es también el modelo el que se debe someter a la refutación de sus predicciones). Consideraciones ad hoc, opiniones, cambios en los conjuntos de información, que no estaban definidos en forma explícita dentro del modelo, no pueden ser considerados como relevantes para entender la situación en la que agentes racionales intentan elegir un curso de acción apropiado. De aquí se desprende que, al construir el modelo, el investigador debe ser transparente en el diseño de los agentes y de los procesos en los que estarán activos. Es decir, en aquello que conocen y pueden conocer los agentes acerca de la situación que intentan entender (restricciones económicas, informativas e institucionales).

Todo esto debe fundamentarse en el papel crucial que tiene el modelo en la metodología de Popper para las ciencias sociales. Para él, las ciencias en general intentan resolver dos tipos de problemas distintos: los que intentan predecir o explicar acontecimientos singulares, y los que intentan explicar o entender acontecimientos típicos. Los pertenecientes al primer tipo pueden resolverse recurriendo a leyes universales y a la fijación de las condiciones iniciales del problema. Los otros requieren de la construcción de modelos que representen situaciones o acontecimientos típicos. Las ciencias naturales, por su desarrollo y por el carácter de sus problemas, han tendido a favorecer el primer tipo de problema. Las ciencias sociales, por la dificultad evidente que enfrentan en la fijación de condiciones iniciales y de leyes universales, han tenido que favorecer el segundo tipo de enfoque en cuestiones de método. La cuestión no se reduce a la dificultad inherente en la fijación de las condiciones iniciales en un modelo propio de las ciencias sociales. Hay algo más: distintas condiciones iniciales, dadas las características del proceso que se desenvuelve a continuación, pueden generar dinámicas y puntos de llegada muy diferentes. Incertidumbre y diversidad entran en el juego, entonces, en forma privilegiada. Por eso, el horizonte de su búsqueda debe reducirse a la construcción de situaciones sociales típicas, cuyo papel sería equivalente al que juegan las condiciones iniciales en las ciencias naturales. La exigencia metodológica de actuar dentro de los límites fijados por el modelo no es entonces caprichosa: es una consecuencia de las limitaciones estrictas que el objeto de las ciencias sociales le impone a la construcción de conocimiento en sus dominios. En ese sentido, los agentes de un modelo social típico sólo pueden hacer explícito, a través de sus acciones, lo que ya estaba implícito en la formulación de la situación considerada.

Esta interpretación implicaría que las limitaciones metodológicas de que habla Popper son estructurales y permanentes en el desarrollo de la economía teórica. Sin embargo, no es ése el caso. Puede decirse, más bien, que la situación devino esa, como consecuencia del avance del programa de investigación de la economía neoclásica y, en particular, de la consolidación del núcleo axiomático del equilibrio general en los años cincuenta y sesenta. Koopmans (1957) definió con precisión las implicaciones metodológicas de lo que estaba ocurriendo en la teoría económica en esos años: la teoría económica se había transformado en una colección de modelos y su avance vendría en la forma de nuevas familias de modelos, construidas a partir de cambiar, relajar o transformar los supuestos y las interpretaciones de los modelos existentes. Es en ese contexto en el que la aseveración de Popper puede ser entendida, y es también allí donde se deben estudiar las consecuencias de sus posiciones metodológicas. Sin embargo, la posición de Popper con respecto a la racionalidad tiene, por supuesto, consecuencias que van más allá del predominio histórico de ese tipo de enfoque metodológico en teoría económica. Más aún: debe tenerse en cuenta que Popper no aceptaría esta interpretación: la historia, o al menos el historicismo, no contaban mucho para él.

Si el avance del conocimiento en las ciencias sociales debiese tomar la forma de investigaciones sobre el curso de acción más apropiado a cada situación social específica, la racionalidad observada por los agentes en cada modelo se convierte, entonces, en un objeto de investigación en sí mismo. Es decir, la descripción de cada situación social y la construcción del modelo correspondiente implicarían una investigación acerca del tipo de racionalidad adecuado a esa situación y a ese modelo de referencia. No habría, entonces, una sola racionalidad práctica aplicable en forma indiscriminada y atlética a todos los problemas de las ciencias sociales. En su lugar, habría un vasto rango de situaciones sociales, susceptibles de ser representadas en modelos formales, cuyo eje central de investigación y de creación de conocimiento es la búsqueda del tipo de racionalidad adecuado a esa situación. La racionalidad, entonces, no sería un atributo de los individuos, sino una propiedad emergente de múltiples procesos de interacción social, ocurridos en escalas temporales muy diversas, y dependiente de las condiciones típicas delimitadas por cada modelo específico.

Pero hay algo más. Popper, al escoger el método de la teoría económica como modelo para todas las ciencias sociales, está aplicando al proceso de construcción de conocimiento científico en ese campo, los elementos y la forma de interacción que él cree predominantes en el mundo social. El paralelismo entre los dos procesos es claro. Los investigadores, como agentes individuales, se plantean situaciones por resolver, construyen modelos adecuados a cada una de ellas, sacan las implicaciones pertinentes y las corroboran frente a lo observable. Pueden, y deben, volver a hacerlo, porque otros, al mismo tiempo, no han dejado de hacerlo. La interacción entre múltiples agentes de este tipo debe producir una selección natural’ de los modelos que han logrado acertar en elegir y aplicar el tipo de racionalidad más adecuado a los límites y restricciones de la situación estudiada. Un cierto tipo de orden emerge de la acción espontánea e individual de muchos agentes que no siguen ningún plan común. Pero la emergencia de orden no se detiene, como tampoco se detiene el proceso de selección y filtración: la racionalidad estaría, entonces, en permanente construcción, en estado de permanente emergencia. El cuadro capta dos de los elementos básicos de la interacción social: su carácter espontáneo y la emergencia permanente de novedad y de orden. ¿Suena familiar? Sí, por supuesto, se trata de la historia que comenzó a contar Adam Smith para la teoría económica, y que continuó, a su manera, Frederich Hayek, y que en otro contexto, y con otras restricciones epistemológicas, propuso Darwin, y que ha sido continuada por los practicantes de la biología evolutiva (Maynard Smith, 1982).

Aquí, sin embargo, se debe plantear en forma explícita un problema que continúa sin resolver. Cualquiera puede percibir en la posición de Popper una cierta lectura de la evolución de la teoría económica en las últimas décadas. Un proceso de selección natural habría favorecido a las teorías de tipo neoclásico, que aplican en forma juiciosa su núcleo de postulados a un conjunto creciente de problemas económicos y no económicos. A pesar de su desdén por la historia, Popper parece suscribir aquel relato de la evolución de la teoría económica, que mostraría, en forma tautológica, a la teoría neoclásica como el conjunto de modelos sobrevivientes de la puesta en marcha de un proceso de selección natural. ¿Es éste un relato de marcha inevitable hacia un óptimo global? No lo sabemos, por supuesto. Como tampoco sabemos en dónde terminará el proceso evolutivo que Popper vislumbra en el desarrollo de la teoría económica. Lo que sí sabemos es que es casi imposible aislar la marcha evolutiva de la teoría económica de las últimas décadas de los acontecimientos históricos que cambiaron el panorama de la economía teórica en Occidente. Sin embargo, hay indicios claros de que la dirección de los eventos no coincide con la conjetura de Popper. Bowles y Gintis (2000), por ejemplo, ven en la creciente expansión de los juegos evolutivos, el nuevo institucionalismo, las teorías de la interacción social y las nuevas teorías de la cooperación un desarrollo alternativo al agotamiento del paradigma walrasiano predominante. Daniel Friedman (1999), por su parte, lee en el desarrollo creciente de los juegos evolutivos y en su paso triunfante a la economía convencional una probable toma’ de la fortaleza ortodoxa por las nuevas fuerzas de la evolución y las instituciones.

Es obvio que este enfoque metodológico de la racionalidad no describe lo que en realidad venía ocurriendo en la teoría económica hasta finales de los ochenta y comienzos de los noventa. Hasta allí había predominado, más bien, la situación inversa. La racionalidad sustantiva aparecía en la mayor parte de los modelos como un supuesto muy fuerte que aseguraba la conducta maximizadora de los agentes involucrados y el equilibrio como el resultado de sus interacciones. Al hacerlo, los practicantes de la teoría convencional no podían ver en la racionalidad de los agentes un problema por investigar. Por eso, el avance del programa de investigación neoclásico tomó la forma de una expansión acelerada hacia nuevos campos y disciplinas. Si la investigación fundamental en el núcleo duro del programa ya estaba más o menos terminada, salvo desarrollos menores, su carácter progresivo dependía de su aplicación exitosa en otros campos del conocimiento y de la vida social. En ese sentido, el principio de racionalidad de Popper, al estar ligado de forma crucial a una metodología que recomienda investigar cuál es el estado de racionalidad apropiado para cada modelo y situación típica, no era un buen predictor de lo que estaba ocurriendo en la teoría económica. Es bien sabido, sin embargo, que la metodología por sí misma no puede garantizar nada. ¿Qué papel puede, entonces, tener hoy el principio de racionalidad de Popper?

En realidad, la súbita importancia actual del principio de racionalidad de Popper no estaría sino en la corroboración de una relación más general entre la súbita importancia de los problemas metodológicos y el arribo de épocas de buenos tiempos’ para el avance de la teoría, que puede expresarse a través de una fórmula esquemática: sólo cuando está cambiando la forma de hacer las cosas vale la pena discutir cómo se hacen las cosas. Es decir, los problemas metodológicos tienen su mejor momento, o tienen consecuencias prácticas para el trabajo de los investigadores, en aquellas épocas privilegiadas en que las formas de hacer teoría económica atraviesan por un cambio dramático. La fecha original de la propuesta de Popper, 1963, permite corroborar un aspecto de esta conjetura. Es la época de la publicación de los teoremas y libros fundamentales del equilibrio general (Debreu, 1959; Arrow y Debreu, 1954), del rápido desarrollo del nuevo programa de axiomatización de la teoría económica y de la aparición de los grandes textos metodológicos de la economía contemporánea, los Tres ensayos sobre el estado de la ciencia económica de Koopmans (1957) y el Ensayo sobre la metodología positiva en Economía de Milton Friedman (1953). Es, también, la ocasión de uno de los últimos grandes debates metodológicos en la economía contemporánea: el sostenido, en la American Economic Review, alrededor de la validez de la propuesta metodológica de Friedman. Ahora, al parecer, estaríamos ante un regreso del principio metodológico de Popper. Sin embargo, si leemos con más precisión lo que está ocurriendo, más que un supuesto regreso del principio de racionalidad de Popper, estamos ante un resurgir de la importancia de los problemas metodológicos, como respuesta esperada a los rápidos cambios que han venido sucediendo en la forma de hacer teoría económica formal en la última década.

Si tenemos en cuenta lo ocurrido en las últimas décadas, pueden distinguirse al menos tres formas distintas de enfocar el problema de la racionalidad en la teoría económica. La primera es la más conocida y la que ha predominado por varias décadas en la profesión: la racionalidad es un supuesto. En la tradición de la metodología positiva de Friedman (1953), esto puede interpretarse en los términos de su célebre, y debatido, como si’: Los agentes económicos actúan como si’ maximizaran algún tipo de función (ya sea de utilidad o de retornos a la inversión). El supuesto no dice que los agentes, en la realidad y en forma consciente, planteen, resuelvan y calculen las soluciones de sus problemas de maximización. Sólo dice que es preferible modelar con agentes que ya han resuelto su problema de racionalidad: racionalidad es maximizar, dadas ciertas restricciones y preferencias. ¿Es compatible este tipo de supuesto con el principio de racionalidad de Popper? Sí, en el sentido limitado de que es una de las formas de racionalidad que los agentes pueden escoger cuando se enfrentan a la tarea de elegir un curso de acción entre varios. No, en el sentido de que la racionalidad no es un problema de investigación y, por tanto, no asegura el progreso de ese programa de investigación. No, también, en el sentido de que pone todo su énfasis en el poder deductivo de los modelos de racionalidad usados.

La segunda forma sólo difiere de la anterior en que toma en serio la idea de que la racionalidad es una hipótesis positiva en la teoría económica. En palabras de Tilman Börgers:

la hipótesis de racionalidad simplemente dice que el comportamiento de los agentes económicos puede ser interpretado como la solución de un problema de optimización. No dice que esto ocurre porque los agentes económicos resuelven conscientemente problemas de optimización (Börgers, 1996, 2).

Para que la racionalidad sea una hipótesis debe ser confrontada con la realidad empírica. Esa confrontación debe servir para evaluar hasta qué punto cubre el comportamiento observado de los agentes económicos. Pero no es fácil hacerlo. En momentos en que la mayor parte de los teóricos de primer orden se dedicaban a ampliar las fronteras de aplicación del núcleo conocido y aceptado de la teoría económica, no tenía mucho sentido dedicar tiempo escaso a la investigación de la pertinencia de la racionalidad como una hipótesis positiva acerca del comportamiento real de agentes económicos individuales. Ahora bien, investigar, en términos empíricos y teóricos, si el tipo de racionalidad postulado es compatible con el observado, tiene profundas implicaciones para la forma en que se hace teoría económica. Si, por ejemplo, y como ha ocurrido en general, los resultados empíricos no son muy alentadores para la hipótesis de la racionalidad como conducta optimizadora, el camino a seguir es iniciar otro tipo de investigación. Como mostraré más adelante, el que la evidencia empírica no sea favorable a la racionalidad sustantiva implica investigar en serio el aprendizaje y la evolución del comportamiento de los agentes económicos en distintas situaciones.

La tercera interpretación está muy ligada al trabajo pionero, y muy poco aceptado en la teoría convencional, de Herbert Simon (1955, 1976, 1982, 1997). Para Simon, se requiere hacer una distinción decisiva entre la racionalidad sustantiva, propia de la teoría convencional, que sólo aplica un algoritmo a la solución de un problema, teniendo en cuenta los datos provenientes del entorno considerado, y la racionalidad limitada, que tiene en cuenta los procedimientos reales de deliberación racional de agentes dotados de limitadas capacidades de computación y de inferencia lógica. Los puntos de vista de Simon siempre han sido citados, con rapidez, en aquellos lugares en los que se requiere modelar con agentes menos que racionales, en el sentido estricto de la racionalidad sustantiva, pero no ha logrado convertirse en un programa de investigación aceptado por los practicantes del programa de investigación neoclásico.

¿Y SI LA RACIONALIDAD SUSTANTIVA DEJARA DE SER UN SUPUESTO?

Una vez que la racionalidad sustantiva deja de ser un supuesto, ya no es posible modelar siguiendo los caminos normales. No se trata, por supuesto, de abandonar la metodología individualista ni el diseño de modelos basado en agentes individuales que han sido tan fructíferos hasta el momento. El punto es que ahora los agentes racionales de la teoría convencional no pueden confiar, en forma exclusiva, en la introspección. Si antes podían resolver su problema buscando, en el espacio apropiado, la técnica y los procedimientos de optimización que les permitieran encontrar la acción más adecuada a sus fines, ahora saben que no siempre puede optimizar, o no siempre tienen la suerte de interactuar con agentes provistos de la misma racionalidad sustantiva o, aún peor, no saben qué consecuencias inferir de la información disponible. Ahora, la pregunta crucial es ¿cómo modelar el arribo a un tipo de equilibrio o a otro?, y si hay diversos equilibrios, ¿cómo escoger entre ellos? El énfasis pasa de la aplicación del algoritmo de optimización adecuado, a la construcción de procesos de ajuste y de convergencia plausibles. Como ya habían señalado varios autores (Arrow, 1959; Hahn, 1984), la teoría convencional no era muy fuerte en este terreno. Desde los tiempos de Walras, el problema de conocer los procesos a través de los cuales se arribaba al equilibrio del sistema había sido resuelto mediante juegos metafóricos: el subastador walrasiano o el famoso proceso de tatônnement son los dos ejemplos más ilustres en la historia de ese tipo de procedimiento.

Se abrieron, entonces, varias vías de acción. Con agentes que ya no disfrutaban de la infinita capacidad computacional de la racionalidad sustantiva, una primera aproximación fue buscar formas de modelar la evolución de conductas que llevaban hacia algún equilibrio. Los modelos evolutivos de la biología parecían brindar un enfoque apropiado para diseñar la conducta de agentes sin infinita capacidad computacional que, sin embargo, arribaban a algún equilibrio estable a través de su interacción. El trabajo pionero de John Maynard Smith (1982) había logrado un primer encuentro entre la teoría de juegos y la biología evolutiva, en el que mostraba que era posible modelar la conducta de equilibrio de agentes individuales que interactúan en forma sistemática. A pesar de que los agentes del modelo de Maynard Smith diferían demasiado de los agentes racionales de la teoría convencional, su propuesta metodológica, en el terreno de la racionalidad, resultó definitiva para lo que estaba por venir. Vale la pena citar el punto clave sugerido por Maynard Smith:

Segundo, y más importante, al buscar la solución de un juego, el concepto de racionalidad humana es reemplazado por aquel de estabilidad evolutiva. La ventaja aquí es que hay buenas razones teóricas para esperar que las poblaciones evolucionen hacia estados estables, mientras que hay bases para dudar que los humanos siempre se comportan de manera racional (Smith, 1982, vii).

Más allá del cambio dramático, que no gradual, en la capacidad de deliberación que se les concedía a los agentes, lo que proponía el autor era un método nuevo para tratar el problema del equilibrio en situaciones de interacción estratégica. Con simplicidad impresionante Maynard Smith justifica su movimiento: mientras que es fácil dudar de la racionalidad de los humanos, no es difícil aceptar, en forma intuitiva, la idea de poblaciones que son capaces de evolucionar hacia resulados estables. Visto con los ojos de cualquier teórico convencional de hoy, la idea suena, por decir lo menos, poco práctica: ¿Para qué dedicarnos a investigar los procesos evolutivos que conducen o no a un determinado punto de equilibrio, si podemos emplear nuestro tiempo en aplicar de forma juiciosa y optimista la hipótesis de racionalidad? Lo que, por supuesto, Maynard Smith no podía prever en toda su dimensión eran las consecuencias radicales que su conjetura tendría para el desarrollo de la economía teórica unos años después.

No debemos olvidar, sin embargo, las dificultades iniciales derivadas de este nuevo tipo de enfoque. Es obvio que se trataba de un viraje hacia el otro extremo del espectro de la racionalidad. Agentes con nula capacidad de deliberación seguían ciegamente las estrategias que brindaban pagos mayores al promedio observado. ¿Cómo llegaban a esa conclusión? Porque el mecanismo de selección natural sólo permitía la reproducción de aquellos que siguieran las estrategias que brindaran pagos por encima del promedio observado en la población. En términos heurísticos, las fuerzas de la selección natural y de la herencia eran las que determinaban, en forma exclusiva, la dinámica del modelo. Los agentes individuales ni aprendían ni sabían nada: sólo se reproducían. Si comparamos esta situación con la sabiduría convencional y sus agentes dotados de racionalidad sustantiva y perfecta, el cambio sugerido era de un carácter extremo. Pero sólo se trataba de un primer paso.

Sin embargo, esos mismos agentes ciegos, con casi nula capacidad de deliberación, son capaces de arribar a resultados similares a los que podrían alcanzarse por la vía de la aplicación disciplinada de la maximización y el equilibrio. Como plantea Krugman (1996), puede constatarse una coincidencia sorprendente entre el método de la biología evolutiva y el de la teoría neoclásica. Ambos aplicaban en forma juiciosa los principios de maximización y de equilibrio para describir el comportamiento interactivo de agentes o de genes. Ambos, también, suponían que los agentes, o los sistemas conformados por la interacción entre esos agentes, se encontraban ya en una situación de equilibrio, resultante del ejercicio de la maximización de algún tipo de función (de utilidad, en el caso de la economía, o de capacidad de reproducción en el caso de la biología evolutiva). Pero esta sorprendente coincidencia nos devuelve, otra vez, al punto inicial: si siempre nos encontramos en situaciones caracterizadas por equilibrios alcanzados mediante la maximización de algún tipo de función, ¿mediante qué procesos se arribó a esa situación? ¿Cuál o cuáles fueron los procesos de ajuste que condujeron a esa situación de equilibrio?

Un contexto natural o propicio para investigar los tipos de procesos que podrían o no converger a equilibrios estables era, por supuesto, el de la teoría de juegos. Al igual que ocurría con el equilibrio en la teoría convencional, en la teoría de juegos no era claro cómo la interacción de agentes dotados de racionalidad sustantiva llevaba al equilibrio de Nash. Pero había una ventaja heurística: era más fácil, o más natural, preguntarse cómo aprendían los jugadores a escoger estrategias que constituyeran un equilibro de Nash, que preguntarse, en un contexto de equilibrio general, cómo podría arribar la economía al equilibrio. Nótese que el contexto en el que se investiga el problema de los procesos de ajuste hacia el equilibrio es el del aprendizaje de agentes en situaciones de interacción estratégica. De entrada, un cambio sutil, pero crucial, se da en el tipo de investigación que se pretende adelantar. Si se quiere averiguar cómo aprenden a jugar los agentes de un cierto juego, es porque la racionalidad sustantiva ha dejado de ser un supuesto, y porque ya no se trata de aplicar en forma práctica los algoritmos de la optimización, sino de investigar cómo pueden aprender los agentes a escoger el perfil de estrategias apropiado en cada situación. Nos encontramos, entonces, en el campo de la racionalidad epistémica (Bicchieri, 1993), en el que lo importante es saber cómo aprenden los agentes a jugar en una cierta situación, es decir, cómo logran alcanzar expectativas mutuamente consistentes en una cierta situación de interacción estratégica.

Creo no equivocarme al acreditar a Ken Binmore con la introducción, en el campo de la teoría de juegos convencional, del viejo problema de la equilibración’ o de la investigación de los procesos de ajuste que conducían a un equilibrio o a múltiples equilibrios en la teoría convencional. En su artículo publicado a finales de los ochenta (1988), Binmore señala las debilidades básicas de la sabiduría convencional en esa materia. Para dar cuenta de los procesos de equilibrio, la teoría del equilibrio general escogió la vía metafórica: ese subastador, que nadie ha visto ni sabe cómo actúa, sería la metáfora indispensable para llenar de alguna forma el vacío conformado por nuestra ignorancia con respecto a los procesos de ajuste al equilibrio. Pero además de acuñar la figura misma del subastador, la teoría convencional nunca investigó en serio las propiedades de esos procesos. Es decir, nunca le dio vida al subastador. Lo que en el mundo del equilibrio general quiere decir que nunca construyó los modelos apropiados ni investigó sus propiedades y, peor aún, nunca tomó en serio la idea del mercado como una institución económica. La metáfora acabó siendo sólo una metáfora, sin consecuencias prácticas ni epistemológicas para entender el carácter de los procesos de ajuste al equilibrio.

Para que se entienda un poco la distancia con respecto a lo que hoy se está haciendo, podemos describir, en forma breve, la propuesta de Binmore en ese momento. Para él, una metáfora más fuerte y más adecuada (y con superiores consecuencias prácticas en términos de su modelación) era la provista por los procesos evolutivos presentados más arriba. Citando en forma específica a Maynard Smith, Binmore propone modelar los procesos evolutivos mediante máquinas programadas como meta-jugadores’, dotadas de baja complejidad con respecto al entorno y, por lo tanto, situadas dentro de la racionalidad limitada de Simon. Estas máquinas tendrían en cuenta el costo de la racionalidad involucrada, es decir, tendrían en cuenta el costo de deliberación asociado a los procedimientos de búsqueda y de inferencia lógica usados por ellas en su interacción.

Un nuevo tipo de investigación implicaba nuevos problemas y nuevas herramientas. ¿Cómo decidir cuál es el nivel apropiado de racionalidad para modelar el aprendizaje en un contexto de teoría de juegos? El espectro de posibilidades era demasiado amplio y, al mismo tiempo, muy poco explorado. Era, además, un campo sobre el que casi no se disponía de información empírica. Por ejemplo, desplazarse hacia el extremo de la nula capacidad de deliberación de los agentes provenientes de la biología evolutiva implicaba, como ya vimos, suponer que los agentes, sin saber cómo, ya habían alcanzado alguna situación de máximo global y de equilibrio estable. Implicaba, además, que la evidencia disponible para la evolución humana era relevante para el caso de la economía. Pero no lo es. La escala temporal en la que actúa el principio de maximización de la capacidad de reproducción humana puede estar en los cientos de miles de años. Los cambios que aparecen en el comportamiento económico pueden llegar a situarse en la escala de fracciones de segundo: es el tiempo que un agente puede emplear en aprender una nueva estrategia en un mercado o en arribar a una solución de punto focal en ciertas situaciones de interacción estratégica (Sudgen, 1995; Schelling, 1960). Y entre los dos extremos pueden encontrarse muy diversas escalas temporales. Como resume Selten (1991), en su muy divertida presentación escénica de una discusión imaginaria acerca del aprendizaje y la evolución, los procesos dinámicos que conforman el comportamiento económico actúan en escalas temporales muy distintas. Selten los enumera en orden de velocidad creciente (de menor a mayor):

1. (el proceso más lento) sustitución genética por mutación,

2. adaptación de frecuencias de genotipos sin mutación,

3. transmisión cultural de generación a generación,

4. aprendizaje (incluyendo imitación), (Selten, 1991, 21).

Hallar una forma apropiada de tratar el problema se hace más difícil si tenemos en cuenta que la teoría convencional siempre ha mantenido una altísima exigencia formal en la construcción de los fundamentos básicos de la teoría. Pero es en estos mismos puntos (racionalidad, capacidad de computación y aprendizaje) en donde los fundamentos de la teoría convencional han mostrado una mayor debilidad. Friedman (1999, 7) ha señalado con precisión los dos puntos débiles esenciales de los fundamentos de la teoría convencional. Uno, tener que recurrir a la introspección para dar cuenta de los procesos de racionalidad seguidos por los agentes al tomar sus decisiones. Dos, el uso de la clásica argumentación teleológica: los agentes actúan como si maximizaran porque han arribado a una situación que es el resultado de la aplicación de algún procedimiento de maximización.

Estas debilidades en los fundamentos del enfoque convencional implicaban la necesidad de desarrollar nuevas bases para sus resultados de equilibrio. Era obvio que un nuevo programa de investigación debía ponerse en marcha. Como plantea George Mailath (1998), en su reseña panorámica de los avances recientes en la teoría de juegos evolutiva, dos son las preguntas básicas que motivaban su desarrollo: ¿juegan los agentes el equilibrio de Nash? Y si lo hacen, ¿cuál equilibrio juegan? Estas preguntas conducían a otros interrogantes metodológicos: ¿pueden construirse procesos dinámicos de adaptación y ajuste para el aprendizaje de agentes en contextos de interacción estratégica? ¿Qué forma deben tener esos procesos? ¿Qué propiedades? El criterio fundamental elegido fue el de la convergencia de los procesos subyacentes a la interacción estratégica entre agentes. Para ponerlo en acción se requerían nuevas herramientas, por supuesto. La mecánica estadística, las teorías de procesos estocásticos y, en general, los desarrollos contemporáneos de la estadística matemática se convirtieron en las nuevas herramientas teóricas. El cambio ocurrido tuvo otra implicación importante en la forma de hacer economía teórica. La poco usada economía experimental se convirtió, de pronto, en el espacio propicio para generar los datos empíricos necesarios para el desarrollo del nuevo programa de investigación. Los últimos años de los ochenta y la década siguiente vieron una explosión de investigaciones en varios campos relacionados: los fundamentos de la racionalidad, los procesos de aprendizaje en contextos de juego y los procesos estocásticos correspondientes a distintos tipos de racionalidad y diversos tipos de situaciones de juego. Por primera vez, las discusiones acerca de la racionalidad de los agentes y de la pertinencia descriptiva de la teoría del equilibrio dejaron de pertenecer al mundo olvidado de las oscuras discusiones metodológicas para pasar a la frontera de los desarrollos teóricos en economía.

Una ilustración de lo que significa aprender en el contexto de un juego de coordinación, y dentro del esfuerzo de fundamentar la racionalidad económica, puede verse en este ejemplo de Fudenberg y Levine (1998, 20-1).

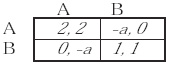

Considérese el siguiente juego simétrico de coordinación de 2 x 2, con el jugador 1 en las filas y el 2 en las columnas.

Es obvio que en este juego hay dos equilibrios de Nash estrictos (A, A) y (B, B). En condiciones normales, los dos jugadores sabrían que (2, 2) es superior, en términos de la eficiencia de Pareto, y debería ser preferido al otro perfil de equilibrio. Pero a no tiene un valor conocido. Por lo tanto, escoger el mejor perfil de equilibrio presenta un riesgo evidente. Si a, por ejemplo, es muy grande los jugadores correrían un riesgo muy alto al escoger A como estrategia dominante. Y allí está el problema que debería resolver la teoría del aprendizaje en juegos. Si la eliminación de estrategias estrictamente dominadas no es suficiente en este caso, ¿qué deben hacer los jugadores para aprender a jugar este juego? ¿Cómo pueden arribar a un equilibrio? El que a no tenga un valor conocido no implica, en realidad, un simple problema de falta de información. Aunque un número real representara el pago que estiman los jugadores por escoger ese perfil estratégico, la dificultad se mantendría. La razón es que este ejemplo ilustra las dificultades que deben enfrentar jugadores racionales cuando tienen que conjeturar qué es lo que va a jugar su oponente y qué es lo que el otro espera que el primero espera acerca de sus propias expectativas.

Una forma de atacar este problema es asignar probabilidades a las creencias y conjeturas del otro jugador. En este caso, se puede usar el criterio de dominio del riesgo de Harsanyi y Selten (1988). En juegos simétricos de 2 x 2, dice ese criterio, la estrategia dominante en riesgo se puede encontrar calculando la probabilidad mínima de que A sea la mejor respuesta si el oponente juega A, y de que B sea la mejor respuesta si el oponente juega B. A es óptima, entonces, si hay al menos una probabilidad de que el oponente juegue A igual a (a + 1)/(3 + a). B lo sería si la probabilidad de que el oponente juegue B es igual a 2/(3 + a). Entonces, A es dominante en riesgo si 1 + a > 2. Es decir, si a > 1.

Sin embargo, para llegar a este resultado hemos usado un criterio ya existente. Un criterio obtenido además por vía deductiva. La teoría del aprendizaje en juegos intenta resolver problemas de este tipo: ¿Cómo aprenden los agentes a jugar un equilibrio en ciertas condiciones? ¿Cómo aprenden a seleccionar un equilibrio cuando hay varios posibles? ¿Cómo lo hacen, además, cuando ni la introspección ni la racionalidad sustantiva ni el dominio público de la racionalidad son suficientes? ¿Coinciden algunos de los equilibrios de Nash del juego original con la cuenca de atracción seleccionada por el proceso de convergencia resultante de la interacción de los jugadores? Y no en el mismo nivel de abstracción, ¿qué implicaciones se pueden derivar para modelar procesos reales de interacción social?

Visto desde hoy, ¿cuál es el cuadro aproximado de los desarrollos ocurridos en los campos de los fundamentos de la racionalidad y del aprendizaje en la teoría de juegos y, en general, en la teoría de la interacción social? Un vistazo a los pasos constructivos que siguen la mayor parte de los modelos que suponen la presencia de perturbaciones aleatorias continuas, en el contexto de juegos evolutivos de 2 x 2, puede dar una idea inicial y aproximada del punto al que se ha llegado en la investigación del aprendizaje y la racionalidad. Lo que sigue tiene la forma de un recetario o de un libro de cocina (Fudenberg y Levine, 1998). Hay ingredientes, pasos, procedimientos, tiempos de cocción y plazos de espera. Como se verá, el énfasis está en los procedimientos y en los efectos que pueden derivarse de variaciones en los primeros. La presencia del investigador es aquí decisiva. Sus elecciones determinan una forma de modelar y unos resultados que difieren, por supuesto, de lo propuesto por otros investigadores. Sin embargo, hay un lenguaje común y ciertas reglas implícitas. Más aún, cierto aire autocrítico y un pesimismo razonable acerca de los efectos de lo que están haciendo pueden detectarse con facilidad en sus practicantes (Mailath, 1998; Kandori, 1997). Y lo que es más llamativo, los que provienen de otra tradición más radical, como Friedman (1999), sugieren otra hipótesis: la sabiduría convencional, el mainstream, está a punto de ser captada, o tomada, en forma pacífica, por una nueva manera de fundamentar el equilibrio. He aquí una secuencia aproximada y esquemática, sin la gracia suprema de los libros de cocina, pero con una estructura que permite ver lo que se puede hacer y sus múltiples variaciones.

Primer paso, diseño de un juego simétrico de 2 x 2 (estrategias y agentes). El juego puede ser de coordinación, de estrategias estrictamente dominadas o de negociación implícita.

Segundo paso, encontrar el equilibrio o equilibrios de Nash correspondientes al juego de 2 x 2, en forma normal, siguiendo los procedimientos usuales de la teoría de juegos: eliminación de estrategias estricta o débilmente dominadas, mejor respuesta. Una pregunta válida: ¿Pueden usarse otras justificaciones, como los puntos focales, los acuerdos previos o la introspección? Sí, por supuesto, pero el criterio de la mejor respuesta, en sus diversas formas, parece ser más universal.

Tercer paso, formulación de un espacio de estados para el sistema propuesto y construcción de un proceso dinámico de ajuste. El proceso puede ser de tipo determinístico o puede incluir, de acuerdo con las preferencias y metas del investigador, algún tipo de elemento estocástico o de mutación, si se quiere seguir el lenguaje de los juegos evolutivos. La mutación, perturbación o experimentación puede ser continua o discreta (choques por una sola vez). El proceso se puede modelar en tiempo continuo o en tiempo discreto.

Cuarto paso, definir el tipo de interacción que el investigador considera relevante: local o global. Buena parte de la investigación más interesante, y con más consecuencias prácticas, se ha realizado en esta área. Los modelos de interacción local, que se construyen de abajo hacia arriba, se están extendiendo a la modelación de procesos de localización, de interacción social, de conflicto y aun a la emergencia de clases sociales (Axtell et al., 2000). En esa misma dirección, las redes sociales se han comenzado a usar para modelar las interacciones locales (Chwe, 2000). Incluso la formación de una red social puede ser una de las cuencas de atracción o de las estrategias estables de los modelos evolutivos que describimos (Jackson y Watts, 1999). En el plano estrictamente teórico, Ellinson (1993) ha demostrado que si se escoge interacción local, en lugar de global, la velocidad de convergencia del proceso es mucho más rápida, y la historia, es decir, las condiciones iniciales, cuenta de manera decisiva. En otras palabras, una vez situados en un estado de equilibrio es cada vez más difícil, y más improbable, que el sistema se aleje de él.

Quinto paso, estudiar las propiedades dinámicas del proceso. Si hay o no convergencia, el tipo de convergencia, el tiempo o plazo de la convergencia. Aquí la diversidad existente implica diferencias grandes en el grado de fe de los investigadores, en las posibilidades de la racionalidad humana y en su capacidad para aprender. Los procesos dotados de propiedades asintóticas estables de mejor familia dicen muy poco, sin embargo, acerca de la realidad de los procesos a escala temporal humana que más nos interesan. Si se requieren mil años para converger a un atractor asintóticamente estable, el modelo dice muy poco para entender los procesos sociales y económicos relevantes. De nuevo, en este punto aparece cierto trade-off entre relevancia y formalismo.

Sexto paso, estudiar las propiedades del equilibrio o de los equilibrios resultantes: estabilidad, robustez, ergodicidad.

Séptimo paso, plantear algunas conclusiones provisionales con respecto al desarrollo y el estado actual del tema del aprendizaje en contextos de juego. En particular, si el proceso indicado converge o no a un equilibrio de Nash, y si lo hace, debido a qué propiedades del diseño adoptado.

¿Qué es lo que aprenden los agentes de estos modelos? A seleccionar los equilibrios correspondientes a distintas situaciones de juego. Pero ya no lo hacen a través de las conocidas armas de la deducción, la introspección y el dominio público de las reglas del juego, de la racionalidad de los jugadores y de sus funciones de pago. Lo hacen a través de múltiples procesos que pueden converger o no a equilibrios estables, en escalas temporales que van desde lo inmediato hasta los miles de años. En un rango tan amplio de posibilidades es sorprendente, también, que los estilos de modelar, las herramientas y las preguntas planteadas tiendan tan rápido a cierta convergencia, apenas con diferencias de acento y estilo. Es cierto que en un mundo en el que el equilibrio sigue siendo el criterio central que anima todo nuevo desarrollo, y en el que el equilibrio de Nash sigue siendo el núcleo unificador del trabajo teórico, la convergencia en las formas de modelar podía ser un hecho razonable, incluso predecible. Pero lo que no resultaba tan predecible era que, en ese contexto, y dentro de esa tradición, la búsqueda de fundamentos para la teoría del equilibrio acabara privilegiando el uso práctico y la modelación, no sólo de tipos de racionalidad distintos al tradicional, sino que buscara, y encontrara fuentes de orden y de estabilidad en el carácter estocástico de los procesos, en los efectos de la introducción de perturbaciones o de ruido o en la imperfección de la memoria de los agentes.

El punto decisivo no es que este hecho no fuera predecible. Es, más bien, la forma de enfrentar los problemas. En vez de intentar un regreso a la ortodoxia (lo que habría podido significar un abandono del problema, su desaparición como problema real), se han intentado soluciones que van por el camino de la heterodoxia y que ligan este programa de investigación a otros programas de filiación y de genealogías muy distintas (Friedman, 1999).

Considérese el desarrollo y el impacto de los modelos de aprendizaje con interacción local y perturbaciones aleatorias continuas. Como plantean Fudenberg y Levine (1998, 137), la introducción de aleatoriedad a todo lo largo de los procesos de ajuste en modelos de aprendizaje permite (y está diseñado para) la selección de un equilibrio entre muchos posibles. Los trabajos pioneros en este campo son los de Foster y Young (1990), Young (1993, 1996, 1998), Ellinson (1993, 1995, 2000) y Kandori, Mailath y Rob (1993). Todos buscan superar tres debilidades básicas de los modelos evolutivos tradicionales: su carácter determinístico extremo, su falta de criterio para elegir en situaciones de equilibrios múltiples y su escala temporal irreal para predecir procesos de aprendizaje económico y social. Lo hacen introduciendo procesos estocásticos de carácter permanente en un contexto en el que sólo se usaban dinámicas de tipo determinístico, con mutaciones o con choques aleatorios que ocurrían una sola vez. ¿Qué se ganaba al introducir comportamiento estocástico en los modelos de aprendizaje? Capturar uno de los aspectos básicos de cualquier proceso de aprendizaje que, hasta el momento, no había entrado en forma explícita en los modelos: la experimentación o la aparición de nuevas estrategias. Esto, que en el lenguaje de los juegos evolutivos se conoce como mutación de estrategias, no hacía sino recoger, en términos formales, una intuición sencilla: en procesos reales de aprendizaje, el ruido y la experimentación de nuevas estrategias son necesarios e indispensables para que el espacio de búsqueda se amplíe y para que el conjunto de búsqueda incluya máximos globales y no se quede atrapado en máximos locales. Pero el realismo por sí mismo no implica una ganancia definitiva. Había que encontrar, también, los procedimientos formales que mostraran la superioridad de este tipo de enfoque sobre otros más tradicionales.

Situados en la misma familia de modelos de aprendizaje en juegos simétricos de 2 x 2, los pertenecientes a este grupo presentan ciertos rasgos formales básicos. Primero, se trabaja sobre poblaciones finitas, de forma que la mutación introducida por un agente, o un conjunto de agentes, tenga efectos reales sobre las estrategias que la población elige. Segundo, los modelos especifican un espacio de estado’, que puede estar compuesto por la proporción de jugadores que eligen una de las acciones disponibles en cada momento o por la proporción del tiempo que los jugadores eligen una estrategia u otra. Tercero, este tipo de modelos especifica una dinámica de ajuste, de la forma de mejor respuesta frente a una muestra de la historia de las interacciones anteriores o frente a la historia de interacciones. Cuarto, se introduce algún tipo de perturbación permanente en el proceso y se averiguan sus efectos sobre el proceso de ajuste del sistema. Quinto, la ergodicidad se considera como una propiedad fundamental de estos procesos. Para hacerlo, se requiere usar la idea de proceso aleatorio de Markov. Como plantean Fudenberg y Levine (1998, 139), si hay suficiente ruido en el sistema, el proceso aleatorio de Markov tendrá una única distribución y habrá una probabilidad idéntica de que el sistema se encuentre en cualquiera de los estados posibles. Esto no implica, por supuesto, ningún tipo de predicción. Es sólo una condición necesaria para iniciar el estudio de si, en realidad, el proceso converge a algún tipo de acción o de estrategia en forma estocástica.

¿No es extraño, sin embargo, que estos nuevos desarrollos no dejaran de realizarse dentro de los límites de la teoría convencional? Nótese que al investigar los procesos de convergencia hacia algún estado de equilibrio se está conservando el equilibrio como un elemento fundamental para modelar la interacción entre agentes en diversos contextos de juego. Recuérdese, al mismo tiempo, que los intentos anteriores de hacer teoría evolutiva, o teorías basadas en la racionalidad procesal o limitada, en economía (Simon, 1955, 1982; Nelson y Winter, 1982) no habían tenido mucha acogida y nunca habían conseguido la atención suficiente para ser considerados como parte de la frontera del desarrollo teórico en el programa de investigación predominante. Es sólo cuando desde el campo convencional se empiezan a poner en duda los fundamentos de la racionalidad sustantiva que los problemas de investigación que habían permanecido en los márgenes pasan a hacer parte del desarrollo del núcleo duro del programa de investigación neoclásico. Una hipótesis provisional diría que los intentos de fundamentar, en términos empíricos y teóricos, los postulados de racionalidad de la teoría convencional están relacionados con el agotamiento de la aplicación juiciosa del aparato de maximización y equilibrio a otros campos del conocimiento y de la vida social. En otras palabras: en la frontera del conocimiento, los problemas esenciales se estaban agotando y un programa de investigación que dependiera en forma exclusiva de su avance en el cinturón protector’ no era signo de buena salud. Esta hipótesis tiene una confirmación adicional, e indirecta, en el hecho evidente de que el problema de la falta de fundamentos sólidos para la racionalidad en la teoría convencional de alguna forma siempre había estado allí. Tanto Hahn como Arrow habían señalado en repetidas ocasiones el malestar que causaba saberlo todo acerca de un estado de equilibrio, sin saber nada acerca de cómo se podía arribar a él.

No es de extrañar, entonces, que uno de los libros fundamentales de este nuevo programa de investigación, The Theory of Learning in Games, de Fudenberg y Levine (1998), y la importante reseña de Mailath (1998) sobre el mismo campo, propongan las siguientes preguntas como básicas para iniciar un proceso de investigación acerca del aprendizaje en contextos de juego: ¿cuándo y por qué deberíamos esperar que el juego sea un equilibrio de Nash? Y si hay varios equilibrios de Nash, ¿cuáles deberían ocurrir? Las dos preguntas reflejan una decisión metodológica fundamental. Si el problema es investigar la racionalidad de los agentes económicos en condiciones de interacción estratégica, el contexto natural es el del aprendizaje y lo que deben aprender es a seleccionar un equilibrio en cualesquiera de los escenarios escogidos para esa tarea. Pero como lo muestra en forma amplia su propio libro, el proceso de búsqueda de fundamentos para la teoría del equilibrio los ha llevado hacia otros lugares, y ha colocado el énfasis en el estudio y la investigación de los procesos de aprendizaje, en la relevancia de los elementos elegidos para modelar, en la importancia del ruido y de lo estocástico para construir modelos de aprendizaje. El compromiso de darle fundamentos de racionalidad a la teoría neoclásica del equilibrio sigue en pie, pero la investigación real y el desarrollo de las herramientas y los instrumentos requeridos para entender el aprendizaje de agentes reales fluyen hacia otros lugares. Debe reconocerse, de paso, que la tensión fundamental, entre la búsqueda de fundamentos para el equilibrio y la racionalidad en la teoría convencional, y la modelación del aprendizaje a través de la interacción social, no ha sido resuelta todavía. Como plantea Silverberg (1997, 2), el hecho de que la teoría de juegos evolutiva haya penetrado más rápido y esté recorriendo a mayor velocidad la super-autopista de las grandes revistas’, dejando en un segundo plano a las teorías de los sistemas complejos adaptativos, tiene que ver con dos elementos fundamentales: primero, el que intenta resolver un problema inmanente de la teoría de juegos convencional y, segundo, el que podría correr con la suerte de brindar fundamentos estocásticos a la vieja idea del equilibrio único de la teoría económica convencional.

El que haya diversos caminos y trayectorias disponibles en el nuevo mundo que se está desarrollando, permite pensar en que las elecciones de los investigadores pueden conducirlos a lugares distintos y a construcciones teóricas muy diversas. Piénsese otra vez en el camino desarrollado por Peyton Young en sus modelos evolutivos de interacción social. Su trabajo es una muestra muy clara de cómo este tipo de modelación es en extremo sensible: pequeños cambios en su formato o en los elementos considerados pueden generar grandes cambios en los resultados dinámicos obtenidos. Como él mismo lo plantea, el enfoque evolutivo es una forma de reconstruir la teoría de juegos con mínimas exigencias de conocimiento y racionalidad (1998, 144). ¿A dónde se ha arribado por esa vía y qué está por hacer?

Lo que ha hecho Young (1993, 1996, 1998) es usar este potencial de variación para dar cuenta del problema de la formación de convenciones sociales en condiciones de interacción estratégica. ¿Qué es lo que cambia cuando se introduce la interacción social? En principio, los elementos son los mismos: agentes con racionalidad limitada, que interactúan en parejas elegidas en forma aleatoria, en un juego de coordinación simétrico de 2 x 2, y cuya conducta está sometida a choques aleatorios, intentan encontrar un perfil de estrategias común, cuando hay varios equilibrios posibles.

Pero hay varias diferencias cruciales. En primer lugar, los agentes sólo tienen interacción local. No se trata sólo del efecto obvio de una preferencia razonable por el realismo. De hecho, esta elección tiene consecuencias sobre la forma de modelar porque permite construir la emergencia de orden a partir de encuentros locales entre individuos, que tienen, por supuesto, una probabilidad más alta de interactuar entre sí y de aprender uno del otro, que si se tratara de agentes con muy baja o nula probabilidad de interacción. Se trata, entonces, de un aprendizaje de abajo hacia arriba, que explota de manera transparente la intuición de que el orden espontáneo tiende a surgir en contextos con altos grados de interacción entre sus agentes. El segundo elemento es el de la memoria limitada. Si los agentes sólo tienen en cuenta un cierto número, o una muestra limitada, de los resultados de sus experiencias o interacciones anteriores, de igual forma será más rápido el proceso de arribo a algún tipo de convención estable –al menos en lo local (Young, 1996, 108). Aquí la memoria tiene una relación directa con el aprendizaje. Es la longitud o el alcance de la memoria, y su incidencia sobre los costos de deliberación de los conjuntos de individuos, lo que determina cuánto pueden aprender los agentes en ciertas situaciones. Young ha acuñado el concepto clave de información suficientemente incompleta. Si m es la memoria potencial que tendría un agente acerca de una historia o de un conjunto de historias de interacción estratégica, y s es el tamaño de la muestra que él usa en la realidad, una relación s/m á 1/2 supone información suficientemente incompleta. ¿Qué consecuencias puede tener este detalle menor sobre la modelación de procesos de interacción? Una, al menos, y decisiva: permite alcanzar en forma más rápida expectativas coherentes en poblaciones enfrentadas a situaciones de interacción estratégica. Young (1996) ha mostrado, en forma teórica e intuitiva, cómo la información suficientemente incompleta ha contribuido a la formación de convenciones y de normas sociales.

Desde el punto de vista del papel de la racionalidad en la modelación de procesos sociales, los cambios son evidentes: procesos evolutivos de interacción social han comenzado a sustituir a los grados increíbles (e injustificados) de racionalidad individual propios del enfoque convencional de la racionalidad. El punto es que ahora se deben hacer explícitos los procesos mediante los cuales las estrategias escogidas por los agentes de una población se hacen compatibles entre sí en el tiempo. Antes, la compatibilidad era un efecto de la introspección y del dominio público de la racionalidad sustantiva individual. En el nuevo escenario, la introspección ya no es suficiente para alcanzar la consistencia social de las acciones de los agentes comprometidos en una situación de interacción estratégica. Es más: la introspección puede ser contraproducente e inútil.

Segundo, la dimensión temporal se ha vuelto decisiva en la modelación de los procesos de interacción social. Sí, la elección individual continúa siendo el bloque inicial de construcción de los modelos, pero ahora ese tipo de elección está restringido por el imperativo de consistencia entre las expectativas de los agentes, y este último sólo puede lograrse a través de procesos temporales de escalas diversas.

Ahora bien, ¿por qué la interacción social puede sustituir la búsqueda individual, a través de la introspección, en la búsqueda de acciones consistentes? Porque, en muchos casos, la búsqueda a través de la interacción social resulta menos costosa. Los procesos de orden emergente alcanzan soluciones situadas, en algún lugar, entre el óptimo global y arreglos inferiores alcanzados por agentes con altos costos de búsqueda individual. Como lo ha planteado Conlisk (1996), en un artículo decisivo, todo agente individual que se enfrente a la búsqueda de una acción óptima para resolver un determinado problema económico debe tener en cuenta los costos de deliberación involucrados en ese proceso de búsqueda. Al hacerlo, sin embargo, debe encontrar una regla de decisión que le permita detener la regresión al infinito que resulta de analizar la solución óptima al nuevo problema de optimización derivado de integrar el costo de deliberación dentro del problema original de optimización por resolver. Una solución natural para evitar la regresión al infinito mencionada es la que resulta de los procesos de interacción social modelados por Young y otros.

Una perspectiva de lo que puede ganarse con este enfoque de la racionalidad y de lo que se ha ganado, de forma efectiva, con él, puede verse comparando el ejercicio hipotético que John Conlisk propusiera en 1996 (p. 691) y lo que ha ocurrido en los últimos años en el campo de la interacción social. Conlisk proponía lo siguiente: ¿Qué tal si todo hubiera comenzado, no con la racionalidad sustantiva, como en la narrativa real ocurrida en los últimos cincuenta años, sino con el reconocimiento de la racionalidad limitada? En ese caso, convenciones estrictas para el tratamiento de la racionalidad limitada se hubieran desarrollado en la profesión. Aquellos que no siguieran las convenciones aceptadas o postularan la racionalidad sustantiva serían llamados a cuentas por seguir procedimientos ad hoc. El artículo de Conlisk fue publicado en 1996. Desde esa fecha (y desde antes, en verdad) puede apreciarse cómo, en la serie de artículos publicados en los campos de la teoría de juegos evolutiva y del aprendizaje en situaciones de interacción social en forma espontánea, han ido, y están, emergiendo las convenciones que Conlisk imaginaba en su ejercicio hipotético. Una señal inequívoca del muy rápido desarrollo ocurrido y de las dramáticas transformaciones vividas en la forma de tratar la racionalidad en la teoría económica contemporánea.

Un artículo de Ken Binmore y Larry Samuelson (1996) ilustra bien la nueva situación de la racionalidad en la teoría económica. Por un lado, los autores se declaran creyentes sin sombra de duda en las ventajas de la optimización como modelo de conducta racional. Y si bien aceptan los débiles resultados empíricos obtenidos por la teoría de juegos en algunas de sus predicciones más simples y fundamentales, los autores encuentran una salida a sus dificultades. El problema, dicen, no está en la hipótesis de optimización en sí misma. El punto está en que los agentes tienen que aprender a optimizar, y para ello requieren, al menos, de los incentivos, y del entorno, apropiados para lograrlo. Como bien se sabe, no siempre existen esas condiciones. Peor aún, que se sepa, nadie las conoce a ciencia cierta, por la razón evidente de que nadie se las había propuesto como una pregunta válida dentro del programa de investigación neoclásico. Y, aunque los autores no las especifican en su artículo, ni reparan en la novedad de la idea de aprender una conducta optimizadora (que antes pertenecía a la espontaneidad del sistema, o a los supuestos de la teoría), sí se comprometen con una estrategia de modelación. ¿Cuál es? Introducir perturbaciones aleatorias (drift) en el proceso de ajuste, con el objetivo de estabilizar los equilibrios de Nash correspondientes a la eliminación de estrategias débilmente dominadas. Más allá de discutir los resultados obtenidos por los autores, queda claro, sin embargo, que las estrategias de modelación, las preguntas, las herramientas, pertenecen al mismo campo de investigación que hemos analizado. El ruido sigue siendo ruido y es igual de creativo, aunque sea usado para apuntalar la idea de racionalidad como optimización. El punto es que sin ruido, sin perturbaciones y sin experimentación no podría fundamentarse la hipótesis de la racionalidad como solución de un problema de optimización. Algo impensable, por supuesto, unos pocos años antes. La caja de Pandora de la racionalidad va a estar abierta por mucho tiempo. Quizás esa súbita diversidad de formas de modelar la racionalidad sea un homenaje sutil a la pertinencia del principio de racionalidad de Popper.

NOTAS AL PIE

1. El texto de Popper sólo fue publicado en 1994. Hands (1985) fue el primer autor que llamó la atención sobre los verdaderos puntos de vista de Popper con respecto al método en economía. Oakley (1999) ha sugerido una interpretación alternativa. Salazar (2000) sugiere otra interpretación.

REFERENCIAS BIBLIOGRÁFICAS

1. Arrow, K. Toward a Theory of Price Adjustment, The Allocation of Economic Resources, 1959, pp. 41-51. [ Links ]

2. Arrow, K. y Debreu, G. Existence of equilibrium for a competitive economy, Econometrica 22, 1954, pp. 265-90. [ Links ]

3. Arrow, K. y Hahn, F. General Competitive Analysis, San Francisco, Holden Day, 1971. [ Links ]

4. Axtell, R.; Epstein, J. y H. P. Young. The Emergence of Classes in a Multi-agent Bargaining Model, Working Paper 9, Center on Social and Economic Dynamics, 2000. [ Links ]

5. Bicchieri, C. Rationality and Coordination, New York, Cambridge University Press, 1993. [ Links ]

6. Binmore, K y Samuelson, L. Evolutionary Drift and Equilibrium Selection, Mimeo, página web de Ken Binmore, 1996. [ Links ]

7. Binmore, K. Modeling Rational Players Part II, Economics and Philosophy 4, 1988, pp. 9-55. [ Links ]

8. Börgers, T. On the Relevance of Learning and Evolution to Economic Theory, Mimeo, página web del Center for Economic Learning and Social Evolution, 1996. [ Links ]

9. Bowles, S. y H. Gintis. Walrasian Economics in Retrospect, Quaterly Journal of Economics, noviembre, 2000. [ Links ]

10. Camerer, C. F. Progress in Behavioral Game Theory, Journal of Economic Perspectives 11, 1997, pp. 167-188. [ Links ]

11. Chwe, M. Communication and Coordination in Social Networks, Review of Economic Studies 67, 2000, pp. 1-16. [ Links ]

12. Conslick, J. Why Bounded Rationality?, Journal of Economic Literature 34, 1996, pp. 669-700. [ Links ]

13. Debreu, G. Theory of Value, New York, Wiley, 1959. [ Links ]

14. Ellinson, G. Learning, Local Interaction and Coordination, Econometrica 61, 1993, pp. 1047-1071. [ Links ]

15. Ellinson, G. Basins of Attraction, Long-Run Equilibria and the Speed of Step-by-Step Evolution, Working Paper, MIT, 1995. [ Links ]

16. Ellinson, G. Basins of Attraction, Long-Run Stochastic Stability, and the Speed of Step-by-Step Evolution, Review of Economic Studies 67, 2000, pp. 17-45. [ Links ]

17. Friedman, D. Evolutionary Economics Goes Mainstream: A Review of the Theory of Learning in Games , Mimeo, Santa Cruz, University of California, 1999. [ Links ]

18. Friedman, M. Essays in Positive Economics, Chicago, Chicago University Press, 1953. [ Links ]

19. Foster, D. y Young, H. Stochastic Evolutionary Game Dynamics, Theoretical Population Biology 38, 1990, pp. 219-32. [ Links ]

20. Fudenberg, D. y Levine, D. The Theory of Learning in Games, Cambridge, MIT Press, 1998 . [ Links ]

21. Hands, D. Karl Popper and Economic Methodology A New Look, Economics and Philosophy 1, 1985, pp. 83-99. [ Links ]

22. Hahn, F. Equilibrium and Macroeconomics, Cambridge, MIT Press, 1984. [ Links ]

23. Harsanyi, J. y Selten, R. A General Theory of Equilibrium Selection in Games, Cambridge, MIT Press, 1988. [ Links ]

24. Hayek, F. Economics and Knowledge, Economica NS 4, 1937, pp. 33-54. [ Links ]

25. Jackson, M. y Watts, A. On the Formation of Interaction Networks in Social Coordination Games, Mimeo, Caltech, 1999. [ Links ]

26. Kandori, M.; Mailath, G. y Rob, R. Learning, Mutation, and Long-run Equilibria in Games, Econometrica 61, 1993, pp. 29-56. [ Links ]

27. Kandori, M. Evolutionary game theory in economics, Kreps, D. y Wallis, K., editores, Advances in economics and econometrics: theory and applications, 1997, pp. 243-277. [ Links ]

28. Koopmans. Three Essays in the State of Economic Science, New York, McGraw Hill, 1957. [ Links ]

29. Krugman, P. What Economists Can Learn From Evolutionary Theorists, conferencia para la European Association for Evolutionary Political Economy, 1996. [ Links ]

30. Mailath, G. Do People Play Nash Equilibrium? Lessons from Evolutionary Game Theory, Journal of Economic Literature 36, 1998, pp. 1347-1374. [ Links ]

31. Nelson, R. y S. Winter. An Evolutionary Theory of Economic Change, Cambridge, Harvard University Press, 1982. [ Links ]

32. Oakley, A. Economics and the origin of Popper’s situational analysis, History of Economics Review 31, 1999, pp. 25-40.

33. Popper, K. The Myth of the Framework, London, Routledge, 1994. [ Links ]

34. Salazar, B. How Rational is Popper’s Rationality Principle?: A Critical Note on Oakley, History of Economics Review 32, 2000, pp. 48-52.

35. Schelling, T. The Strategy of Conflict, Cambridge, Harvard University Press, 1960. [ Links ]

36. Selten, R. Evolution, Learning and Economic Behavior, Games and Economic Behavior 3, 1991, pp. 3-24. [ Links ]

37. Silverberg, G. The Economy as an Evolving Complex System II, W.B., Arthur, et al., editores, Proceedings XXVII, Santa Fe Institute Studies in the Sciences of Complexity, página web de Gerald Silverberg, 1997. [ Links ]

38. Simon, H. A. A Behavioral Model of Rational Choice, Quaterly Journal of Economics 69, 1955, pp. 99-118. [ Links ]

39. Simon, H. From Sustantive to Procedural Rationality, S. J. Latsis, editor, Methods and Appraisal in Economics, Nueva York, Cambridge University Press, 1976, pp. 129-148. [ Links ]

40. Simon, H. Models of Bounded Rationality, 2, Cambridge, MIT Press, 1982. [ Links ]

41. Simon, H. Models of Bounded Rationality, 3, Cambridge, MIT Press, 1997. [ Links ]

42. Smith, Maynard. Evolution and the Theory of Games, New York, Cambridge University Press, 1982. [ Links ]

43. Sudgen, R. A Theory of Focal Points, The Economic Journal 105, 1995, pp. 533-550. [ Links ]

44. Young, H. Individual Strategy and Social Structure, Princeton, Princeton University Press, 1998. [ Links ]

45. Young, H. The Economics of Convention, Journal of Economic Perspectives 10, 1996, pp. 105-22. [ Links ]

46. Young, H. The Evolution of Conventions, Econometrica 61, 1993, pp. 57-84. [ Links ]