Introducción

El campo de la Gestión del Conocimiento (GC) está en pleno desarrollo. En un análisis cienciométrico de la producción académica durante el período 1994 - 2008, elaborado por (Serenko, Bontis, Booker, Sadeddin, & Hardie, 2010), se presentan conclusiones que demuestran el avance del área. Allí, se destaca el hecho de que, a pesar de su corta historia, la GC está conformada por un amplio cuerpo de conocimiento en continuo crecimiento. Además, se evidencia que la producción se ha realizado por una amplia gama de personas e instituciones académicas y no académicas. También, (Serenko et al., 2010) identifican hechos que muestran la evolución de este campo de estudio, como el incremento del índice de coautoría, la rigurosidad de los métodos de investigación y el predominio en la producción hecha en entornos académicos.

En particular, la evaluación de la GC ha sido un tema de interés para investigadores y practicantes durante la última década. Hace parte de las temáticas identificadas por Dwivedi, Venkitachalam, Sharif, Al-Karaghouli, & Weerakkody, (2011) como tendencias de investigación en los próximos años, específicamente sobre la efectividad en la GC y el soporte organizacional y tecnológico necesario para lograrla. Por tal razón, para construir una visión general sobre la evaluación de la GC se presenta esta revisión sistemática de literatura (RSL) que abarca aportes publicados en la literatura científica durante la última década. Así, el alcance de esta revisión se centró en buscar conclusiones para las siguientes preguntas de interés:

¿Qué modelos existen para evaluar la GC en una organización?

¿En qué escuelas de GC se ubica el contenido evaluado por los modelos?

¿En qué sectores de aplicación fueron utilizados los modelos?

¿Cuáles de los modelos se centran en la evaluación de procesos de GC?

¿Cuáles modelos se aplicaron en la industria del software?

Para presentar la RSL desarrollada, este documento se estructuró de la siguiente forma. En la sección dos se presenta la fundamentación teórica necesaria para dar sentido al análisis de los modelos de evaluación revisados. El centro de esta fundamentación teórica es una propuesta de escuelas de pensamiento de la GC y una clasificación de las capacidades organizacionales de GC. En la sección tres se describe la metodología utilizada para realizar la RSL. En la sección cuatro se presenta el detalle de los resultados obtenidos con el análisis de los 43 artículos incluidos en la RSL. Al final, en la sección cinco se presentan las conclusiones del trabajo y por último, las referencias bibliográficas utilizadas.

Fundamentación Teórica

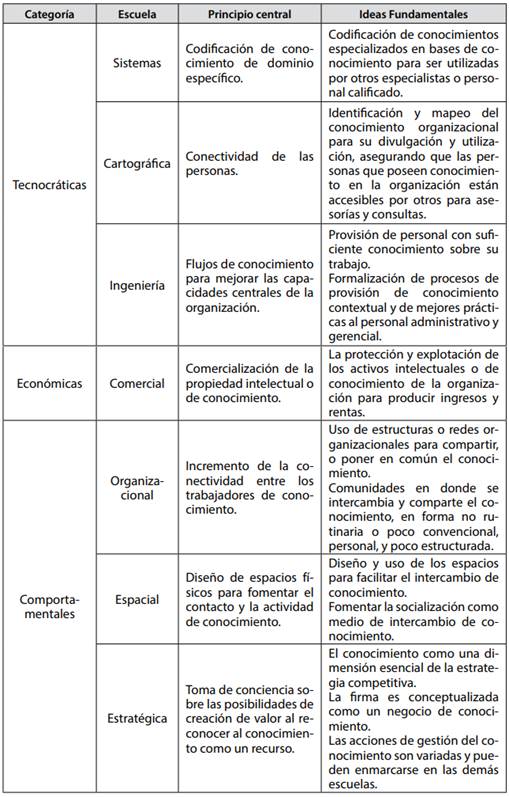

Al considerar el reciente surgimiento y la diversidad conceptual del campo de la GC, una forma de llegar a una primera noción sobre lo que significa GC es abordar el análisis a través de enfoques y escuelas de pensamiento. Por esto, se tomó la taxonomía de (Earl, 2001) como uno de los referentes base pues es un esquema detallado en donde el componente conceptual es sustentado con estudios empíricos como: seis casos de estudio en organizaciones, interacción con 20 gerentes de conocimiento sobre la implementación de iniciativas de GC, un taller sobre programas de GC con la red de gerentes de conocimiento del Reino Unido, y el análisis de programas de GC publicados en revistas académicas y profesionales. Además, es importante destacar que, aunque cada escuela representa un propósito o enfoque particular, no son competencia entre sí. Por el contrario, en la práctica se implementan estrategias y herramientas de varias escuelas (Earl, 2001).

Las escuelas Tecnocráticas se enfocan en herramientas de tecnologías de información (TI) que brindan soporte y, en cierto grado, condicionan a los miembros de la organización, en la realización de actividades de conocimiento. Las escuelas Económicas se orientan en aprovechar la relación entre los ingresos de la organización con la explotación de los activos de conocimiento y, en general, el capital intelectual que posee. Las escuelas Comportamentales se centran en la promoción y estímulo, para que las personas construyan, compartan y utilicen el conocimiento como un recurso. En la Tabla 1 se resume la taxonomía de Earl (2001).

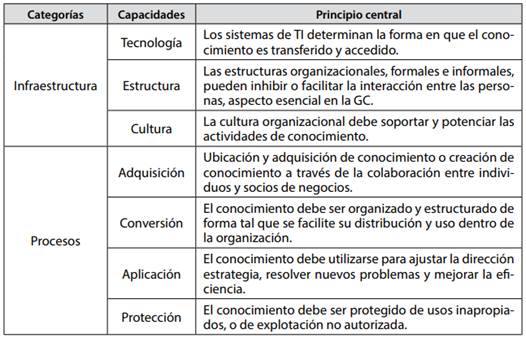

El segundo referente es el trabajo de Gold, Malhotra, & Segars (2001), quienes argumentan que las organizaciones deben aprovechar el conocimiento existente y crear conocimiento para competir en el mercado. Para lograr esto, las organizaciones deben desarrollar dos tipos de capacidades: capacidades de infraestructura de conocimiento y capacidades de procesos de conocimiento. Las capacidades de infraestructura permiten la maximización del capital social, entendido como “la suma de los recursos actuales y potenciales que están embebidos dentro de, disponibles a través de, y derivados de la red de relaciones que posee una unidad social” (Gold et al., 2001). De forma complementaria, las capacidades de procesos son los elementos dinámicos que aprovechan las capacidades de infraestructura para hacer del conocimiento un recurso organizacional activo. En la Tabla 2 se sintetizan los planteamientos de esta propuesta.

Metodología

En esta revisión se utilizó el método propuesto por B. A. Kitchenham, Dybå, & Jørgensen (2004); B. Kitchenham & Charters (2007); B. Kitchenham et al (2009, 2010). Este método inicia con la elaboración de un protocolo para la revisión cuyo propósito es la especificación de preguntas de interés, estrategias de búsqueda, criterios de inclusión, criterios para evaluar la calidad de los estudios, y el procedimiento de extracción y síntesis de datos. Por tanto, para cumplir con el propósito de esta RSL se propusieron las preguntas de interés enumeradas en la introducción de este artículo.

La definición de estrategias de búsquedas comprende dos elementos: la determinación de las fuentes a consultar y de las expresiones de búsqueda que se utilizan en los motores de búsqueda de las fuentes seleccionadas. Las fuentes utilizadas en la revisión se seleccionaron por ser bases de datos que recogen la mayoría de la producción científica en el tema: SCOPUS, ISI Web of Science, Sciencedirect, IEEE Explorer, ACM DL, Emerald, Springerlink, y EI Compendex.

Por otra parte, la construcción de las ecuaciones de búsqueda se desarrolló realizando prototipos de términos y expresiones. El resultado de este proceso iterativo de construcción dio como resultado una expresión de búsqueda con palabras clave, sintagmas y conectores booleanos. Es importante destacar que las expresiones de búsqueda se construyeron partiendo de cada una de las preguntas de interés para esta revisión. Para esto, se tomaron palabras clave y sintagmas a partir de las preguntas. Luego, se fueron refinando, a partir de la evaluación de los resultados de cada expresión, con la incorporación de sinónimos y alternativas para la escritura de los términos, palabras clave obtenidas de artículos relevantes revisados previamente, y la incorporación de filtros proporcionados por las diferentes fuentes, como los relativos al tipo de artículo, a las fechas de publicación, y referencias. La ecuación de búsqueda definitiva fue la siguiente:

(“knowledge management capability” OR “knowledge management capabilities” OR “capability of knowledge management” OR “capabilities of knowledge management” OR “capability for knowledge management” OR “knowledge management capacity” OR “capacity of knowledge management” OR “knowledge management capacities” OR “capacities of knowledge management” OR “Knowledge management maturity” OR “maturity of knowledge management” OR “Knowledge management evaluation” OR “evaluation of knowledge management” OR “evaluating knowledge management” OR “knowledge management assessment” OR “assessment of knowledge management” OR “assessing knowledge management” OR “knowledge management measurement” OR “measurement of knowledge management” OR “measuring knowledge management” OR “knowledge management metrics” OR “metrics of knowledge management” OR “metrics for knowledge management” OR “knowledge management performance” OR “performance of knowledge management” OR “KM capability” OR “KM capabilities” OR “capability of KM” OR “capability for KM” OR “capabilities of KM” OR “KM capacity” OR “capacity of KM” OR “KM capacities” OR “capacities of KM” OR “KM maturity” OR “maturity of KM” OR “KM evaluation” OR “evaluation of KM” OR “evaluating KM” OR “KM assessment” OR “assessment of KM” OR “assessing KM” OR “KM measurement” OR “measurement of KM” OR “measuring KM” OR “KM metrics” OR “metrics of KM” OR “metrics for KM” OR “km performance” OR “performance of km”) OR ((“knowledge management” OR “KM”) AND (“organizational capabilities” OR “organizational capability” OR “enterprise capabilities” OR “enterprise capability”)) OR (“knowledge management systems” AND (“evaluation” OR assessment OR measurement)).

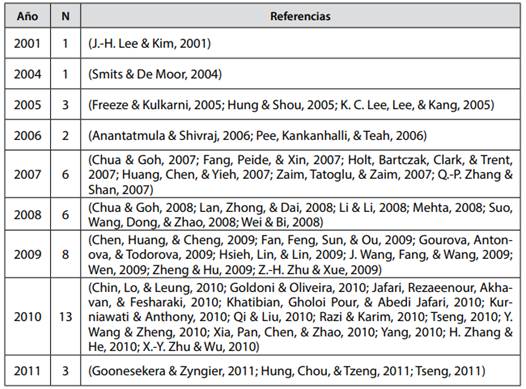

El resultado del uso de la ecuación de búsqueda en las ocho fuentes fueron 2503 registros bibliográficos potencialmente relevantes. Luego, los registros recopilados fueron sometidos a un proceso de depuración para eliminar duplicados, obteniéndose 754. Posteriormente, se aplicaron como criterios de inclusión en el análisis dos aspectos: que el artículo presente un modelo en el cual se describa el contenido a evaluar, y que su construcción sea resultado de investigación y no de una opinión de un experto o del reporte de un caso particular, obteniendo como resultado 177 registros. Seguidamente se realizó una evaluación de calidad de cada documento, que consistió en la revisión del texto completo para identificar si el artículo trataba aspectos como el contenido del modelo, la metodología utilizada para construirlo, la aplicación y los resultados de la misma, y el contexto de aplicación en el que se llevó a cabo el trabajo. El resultado de esta evaluación de calidad fue la selección de 43 artículos que finalmente fueron los estudiados en esta RSL. En la Tabla 3 se presentan las referencias bibliográficas de los artículos seleccionados ordenados por el año de publicación.

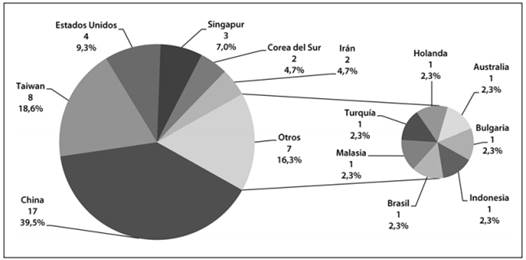

El origen de los artículos seleccionados, determinado a partir de la ubicación geográfica de las instituciones a las que están afiliados los autores mostró una alta diversidad. Como se ve en la Figura 1, se encontró que la mayoría de los documentos revisados provenían de China, con 17 artículos, seguida por Taiwán, Estados Unidos, Singapur y Corea del Sur. Solamente se identificaron tres documentos de Europa y uno de América Latina, específicamente de Brasil.

Por último, para la extracción y síntesis de datos se construyó una hoja de cálculo en Excel para registrar, el objeto y la función de la evaluación, el método usado para la construcción del modelo, si se presenta un modelo de referencia para la evaluación, el método de evaluación, si se proponen niveles de madurez, el sector de la industria en que se aplicó, si se tuvieron en cuenta características propias de la organización en que se aplicó, la ubicación del contenido evaluado en las escuelas de GC y en las capacidades de GC descritas en la fundamentación teórica, y la identificación de fortalezas y limitaciones de los modelos.

Resultados

La descripción de los resultados obtenidos para dar respuesta a las preguntas de interés inicia con algunos aspectos generales que permiten caracterizar los modelos de evaluación de GC. Esto apunta a responder la primera pregunta de interés:

¿Qué modelos existen para evaluar la GC en una organización? En primer lugar, se presenta el análisis sobre el objeto a evaluar, pues los modelos podrían orientarse a evaluar aspectos como: (1) la disposición de una organización para implementar la GC, (2) los resultados obtenidos con la implementación de la GC, (3) la forma en que están implementados los procesos de GC, y (4) una mezcla que incluye procesos, resultados e impacto de la GC sobre el desempeño organizacional. Aquí se encontró que el 69.8% de los modelos se enfocaban en evaluar los resultados, el 18.6% a los procesos, y el 4,7% a la disposición para implementar la GC.

Luego, se analizaron los modelos de acuerdo a la función de la evaluación. Para esto se definieron dos tipos de evaluación, la sumativa que se centra en obtener valoraciones sobre el desempeño, y la formativa, que se usa para identificar aspectos a mejorar. La diferencia en la función de la evaluación no está determinada por el contenido a evaluar, sino en el uso que se le da al resultado de la misma. Aquí, se encontró que el 58.1% de los modelos se orientaban a una función sumativa para la evaluación, y el restante 41.9% una función formativa. Además, incluyendo el objeto de la evaluación dentro del análisis, se encontró que el 80% de los modelos enfocados a evaluar resultados asumían la función sumativa de la evaluación y el 20% una función formativa. Para los otros objetos de evaluación, la mayoría de modelos asumían la función formativa de la evaluación.

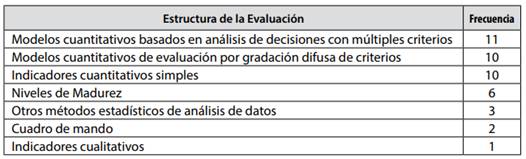

Luego, se construyó el análisis sobre la estructura de los modelos, en donde se encontró que el 25,6% tienen una estructura con múltiples criterios organizados jerárquicamente o en red, aplicando el enfoque de análisis de decisiones con múltiples criterios de la investigación de operaciones. El 23,3% utiliza técnicas de valoraciones con base en conjuntos difusos y el 23,3% proponen conjuntos de indicadores cuantitativos con estructura simple y pesos equivalentes para los criterios de evaluación. Además, el 14% tiene una estructura de niveles de madurez. En la Tabla 4, se presenta la distribución de acuerdo a la estructura.

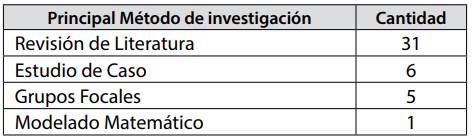

Sumado a esto, como se ve en la Tabla 5, la mayoría de los modelos fueron construidos a partir de revisión de literatura y luego validados en contextos de práctica. Sin embargo, también se ve el uso de métodos empíricos, como los estudios de caso y grupos focales.

Tabla 5: Métodos de investigación empleados en la construcción de los modelos

Fuente: Elaboración propia.

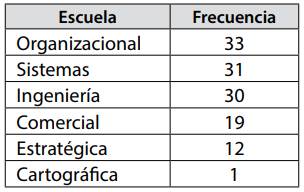

El segundo elemento de indagación fue la ubicación del contenido de la evaluación dentro de las escuelas de GC (Earl, 2001). En este sentido, se identificó que en los 43 modelos estudiados, el contenido de la evaluación está organizado en categorías, y en algunos casos, esta organización tiene varios niveles de desagregación. Esas categorías y subcategorías fueron revisadas para modelo incluía o no elementos de cada escuela de GC. En este sentido, como se observa en la Tabla 6, 33 de los 43 modelos (76.7%) incluyen aspectos de la escuela organizacional. Luego se encuentran las escuelas de Sistemas y de Ingeniería, que están incluidas en 31 (72.1%) y 30 (69.8%) modelos respectivamente. Luego está la escuela Comercial con 19 modelos (44.2%) y la escuela Estratégica con 12 (27.9%). Por último, se encuentra la escuela Cartográfica, que está incluida únicamente en un modelo. Es de notar que los planteamientos de la escuela Espacial no hacen parte del contenido evaluado.

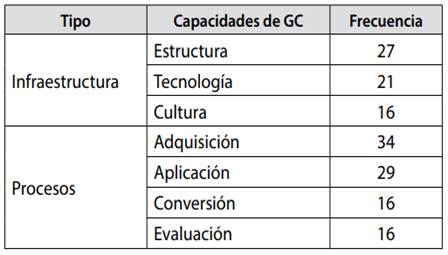

Por otra parte, tomando como base el trabajo de Gold et al (2001), sobre capacidades organizacionales de GC, se realizó la clasificación del contenido evaluado mapeando las categorías propuestas en cada modelo con las tres capacidades de infraestructura de conocimiento (tecnología, estructura y cultura organizacional), y las cuatro capacidades de procesos de conocimiento (adquisición, conversión, aplicación, y protección del conocimiento). En la Tabla 7 se presenta el resultado de este análisis.

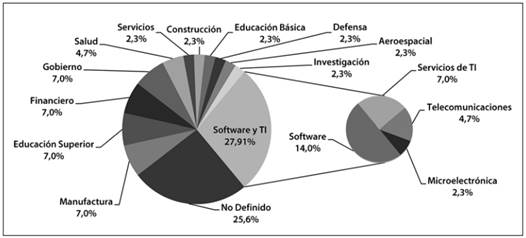

El tercer elemento de indagación fue la identificación de los sectores de la industria en donde fueron construidos o aplicados los modelos. Aquí se encontró gran diversidad de sectores que incluyen la industria manufacturera de diferentes tipos, el sector de servicios, la educación e investigación, y el sector gubernamental. Como se ve en la Figura 2, en el 25,6 % no se hace explícito el sector de aplicación. Además, se evidencia que dentro de los modelos en los cuales se enuncia el sector de aplicación, el mayor porcentaje está en la industria del software, con un 14%. Los siguientes cinco sectores con mayor aplicación de los modelos son los de manufactura, gobierno, educación superior, servicios de TI y, servicios financieros, con 6.98% cada uno. Sin embargo, si se suman los porcentajes del sector de software y los servicios de TI, dada su afinidad, se evidencia que hay un gran interés en la evaluación de GC en comparación con otras industrias. Además, de los seis sectores con mayor porcentaje, solamente uno, el de manufactura, se ubica en la franja de industrias tradicionales de transformación de materias primas en productos, y los demás, son organizaciones que ofrecen servicios basados en el conocimiento.

Fuente: Elaboración propia.

Figura 2: Sectores de aplicación de los modelos de evaluación de GC estudiados.

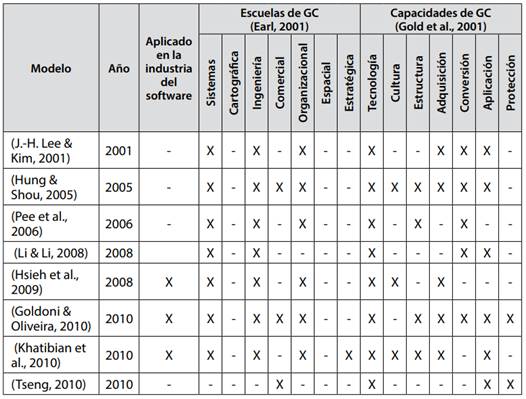

Otro de los aspectos tenidos en cuenta dentro del análisis de contenido fue el hecho de si los modelos de evaluación se centran en los procesos de GC en las organizaciones. Aquí se encontró que ocho modelos se centran en la evaluación de procesos de GC, y en algunos casos toman como referente el modelo de evaluación de procesos de software CMMI (Capability Maturity Model Integration - CMMI) propuesto por el Instituto de Ingeniería de Software de la Universidad Carnegie Mellon (CMMI Product Team, 2010). Como se ve en la Tabla 8, al tomar como referencia las escuelas de GC, se observa que hay una concentración en los aspectos relacionados con las escuelas de Sistemas, Ingeniería y Organizacional y, por el contrario, los postulados de las escuelas Cartográfica y Espacial no tienen lugar dentro de los modelos. Así mismo, respecto de las capacidades de GC incluidas, se ve que la capacidad de infraestructura de tecnología está incluida en los ocho modelos. Por último, se ve que las propuestas de Hung & Shou (2005) y Khatibian et al. (2010), son las que incluyen aspectos de cuatro de las siete escuelas de GC y de seis de las siete capacidades de GC.

Por otra parte, se encontró que tres de los modelos fueron aplicados en organizaciones desarrolladoras de software, sin embargo, en el trabajo de Hsieh et al. (2009), no se brindan detalles de la aplicación pues simplemente se dice que en el grupo de 30 compañías en donde se utilizó el modelo, una era de la industria del software. Así mismo, en el trabajo de Khatibian et al. (2010), se describen la aplicación de un instrumento, pero no se dan detalles sobre las características de la organización objeto de estudio, ni se evidencian argumentos relativos a los enfoques metodológicos o a la cultura de la organización. Además, estos tres modelos no incluyeron características organizacionales determinantes del estilo de GC implementado, como el tamaño de la organización o el enfoque para el desarrollo de software (tradicional-ágil).

Discusión

Como se ve en los resultados, hay una gran variedad de propuestas para evaluar la GC en las organizaciones. Sin embargo, se encuentran varias brechas en el conocimiento en el área. En primer lugar, se encontró que el 69,8% de los modelos centran la evaluación en los resultados y, solamente, el 18,6% se enfoca en los procesos. Además, la mayoría de los modelos tiene una estructura sustentada en métodos de análisis cuantitativo y únicamente el 14% propone una estructura orientada a la mejora y madurez de la GC en la organización. Esto indica que el interés principal de la evaluación es obtener calificaciones que permitan juzgar el estado de la GC en la organización, en lugar de asumir una función formativa.

Por otra parte, la gran mayoría de los modelos fue construida a partir de una revisión de literatura y luego fueron puestos a prueba en organizaciones, y solamente 11 de los 43 modelos fueron construidos utilizando un método de intervención organizacional. Esto evidencia la tendencia hacia el enfoque positivista, en lugar del enfoque cualitativo, que, teniendo en cuenta la naturaleza del fenómeno en estudio, enriquecería más el contenido de los modelos (Bjørnson & Dingsøyr, 2008; Checkland & Holwell, 1998).

Sobre el contenido de la evaluación, se encontró que las escuelas Organizacional, Sistemas, e Ingeniería, aparecen en más del 70% de los modelos. Además, se evidencia mayor interés en aspectos de la escuela Comercial, sin llegar a ser un consenso. Sin embargo, se identifican brechas pues no se incluyen aspectos de la escuela Espacial, y se abordan, muy someramente, los aspectos de las escuelas Cartográfica y Estratégica. Sin embargo, no se encontró un solo modelo que incluyera aspectos de todas las escuelas de GC. En este sentido, se encontró que el máximo número de escuelas incluidas en un modelo es cuatro, y los siete modelos que tienen ese contenido (Goldoni & Oliveira, 2010; Hung & Shou, 2005; Khatibian et al., 2010; Suo et al., 2008; Wen, 2009; Xia et al., 2010; Zaim et al., 2007), se centran en las escuelas Organizacional, Ingeniería, Sistemas y Comercial.

Así mismo, al tomar como referencia los planteamiento de las capacidades de GC (Gold et al., 2001), se encontró que la capacidad de infraestructura relacionada con la cultura organizacional de aprovechamiento del conocimiento es la menos abordada. Además, se evidencia que las capacidades de procesos de conversión y protección del conocimiento no son abordadas por la mayoría de modelos. Así mismo, se encuentran dos modelos (Fan et al., 2009; Zaim et al., 2007) que cubren las siete capacidades de GC, lo cual se explica porque tomaron como referencia el trabajo de Gold et al (Gold et al., 2001) para construir la estructura del modelo. Sin embargo, estos dos modelos no establecen con detalle los elementos constituyentes del modelo de evaluación, y están orientados exclusivamente a la evaluación cuantitativa.

Otra dimensión de la revisión mostró la diversidad de contextos de aplicación que tuvieron los modelos durante su construcción o su validación. Sin embargo, en el 25,6% de los modelos no se hace distinción sobre el tipo de organización y el sector económico al que pertenece. Esto puede explicarse al revisar los métodos de investigación utilizados en la formulación de los modelos, pues al estar ubicados en el enfoque positivista, poseen la intención resultados son repetibles en cualquier contexto de aplicación. No obstante, se ve que el sector de software y servicios de TI ha sido el contexto de aplicación más trabajado. Esto, sumado al hecho de que los modelos construidos y aplicados en la industria del software y servicios de TI han surgido durante los últimos tres años, muestra la importancia que tiene la temática de evaluación de GC para este sector de la economía.

Sin embargo, al analizar la estructura y contenido de los modelos utilizados en el sector de software y servicios de TI se encuentra que la aplicación en el contexto de una organización desarrolladora de software no incluyen características específicas de la organización, formadas a partir de la naturaleza y el enfoque asumido para realizar su actividad principal: desarrollar software. Esta distinción sobre el enfoque metodológico es un aspecto importante pues en la actualidad existen tendencias fuertes, generadas a partir del surgimiento y rápido posicionamiento de los métodos ágiles para el desarrollo de software, que han transformado la práctica cotidiana de las organizaciones desarrolladoras de software. Esto es importante como quiera que el origen de estos métodos, formulados como reacción a los métodos tradicionales, se sustenta en la idea construir software en un mundo impredecible centrándose en las personas y su creatividad en lugar de los procesos rígidamente definidos Dybå & Dingsøyr (2008). En este sentido, la idea de Dingsøyr, Bjornson, & Shull (2009), de que la forma en que se implementa la GC en una organización desarrolladora de software está determinada por el enfoque metodológico asumido, debe contemplarse como aspecto esencial de las propuestas que pretendan definir la forma en que se deben evaluar los procesos de GC en una organización desarrolladora de software, con el fin de lograr mayor efectividad en la aplicación de los modelos.

Ahora bien, al centrar el análisis en aquellos modelos centrados en la evaluación de procesos de GC, se encontraron varios aspectos susceptibles de mejora. Por ejemplo, no están incluidos aspectos de las escuelas Cartográfica, Comercial, Espacial y Estratégica. También, al revisar la ubicación del contenido evaluado con respecto a las capacidades de GC, se evidencia que, en conjunto, los modelos contemplan aspectos de todas las capacidades, con excepción de la capacidad relacionada con la protección del conocimiento organizacional. Esta brecha resulta, particularmente, problemática en el contexto de la industria del software toda vez que es una industria intensiva en conocimiento. Por lo tanto, si una organización desarrolladora de software que ha implementado estrategias ubicadas en las escuelas que no se incluyen en el modelo, desea utilizarlo como base para la determinación de las capacidades de procesos o la mejora de procesos, no va a obtener la caracterización completa de sus procesos.

En síntesis, se identifican tres aspectos percibidos como problemáticos. En primer lugar, los modelos de evaluación de la GC propuestos en la literatura académica sobre GC no integran los diferentes enfoques desde los que se implementa la GC en una organización. Como segundo punto, en los modelos de evaluación enfocados en procesos de GC se excluye de su contenido aspectos de varias escuelas de GC y capacidades organizacionales de GC. Y en tercer lugar, la formulación y aplicación de los modelos de evaluación de GC en organizaciones de la industria del software no toma en cuenta características como el tamaño y la tendencia del enfoque metodológico para el desarrollo de software.

Conclusiones

Esta revisión sistemática de literatura es un aporte inicial a la búsqueda de consensos en el campo de la Gestión de Conocimiento. Particularmente, se identificaron modelos de evaluación de la GC enfocados a diferentes tipos y objetos de evaluación. Los modelos identificados fueron sometidos a los análisis necesarios para dar respuesta a las preguntas de interés que motivaron el desarrollo de este trabajo, evidenciando el logro del objetivo trazado para este estudio.

Sumado a esto, los argumentos presentados en la discusión permiten formular varios cuestionamientos que sirven como motivación para desarrollar un programa de investigación sobre evaluación de GC, y en particular sobre la evaluación de procesos de GC en organizaciones desarrolladoras de software de los contextos colombiano y latinoamericano. El primer cuestionamiento se centra en la identificación de los aspectos que se deben incluir en la evaluación de procesos de GC en una organización desarrolladora de software. Sumado a esto, se debe indagar sobre qué características particulares de las organizaciones de la industria del software en Colombia y Latinoamérica, se deben tener en cuenta al definir el contenido de la evaluación de procesos de GC. Ahora bien, en el plano operacional de la evaluación, se debe resolver el cuestionamiento sobre cómo se debe realizar la evaluación de procesos de GC en una organización que desea determinar la capacidad de sus procesos, u orientar y priorizar la mejora de procesos. Así mismo, se debe definir qué herramientas metodológicas y tecnológicas se deben utilizar para facilitar la evaluación.

Por otra parte, y teniendo en cuenta que la evaluación de procesos no es un tema nuevo para la industria del software, se debe responder cómo se puede articular la evaluación de GC con otras iniciativas de evaluación de procesos guiadas por modelos basados en la norma ISO/IEC 15504, como la Integración del Modelo de Madurez de Capacidad (Capability Maturity Model Integration - CMMI) propuesto por el Instituto de Ingeniería de Software de la Universidad Carnegie Mellon (Software Engineering Institute - SEI), el Modelo de Mejora de Proceso del Software Brasileño - MPS.BR propuesto por la Asociación para la Promoción y la Excelencia del Software Brasileño - Softex, el Modelo de Procesos para la Industria del Software - MoProSoft propuesto como la norma técnica NMX-059/01-NYCE-2005 de la república de México, y el Modelo para la Mejora de Procesos para Fomentar la Competitividad de la Pequeña y Mediana Industria del Software de Iberoamérica - Competisoft.