Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO -

Similars in Google

Similars in Google

Share

Universitas Psychologica

Print version ISSN 1657-9267

Univ. Psychol. vol.15 no.1 Bogotá Jan./Mar. 2016

https://doi.org/10.11144/Javeriana.upsy15-1.meda

'Método de evaluación dinámica automatizado' de competencias lectoras para educación secundaria (EdiLEC)*

Method of Automated Dynamic Assessment of reading literacy for Secondary Education (EdilLEC)

Vicenta Ávila Clemente**

Laura Gil Pelluch***

Ramiro Gilabert Pérez****

Amelia Maña Lloria*****

Ana C. Llorens Tatay******

Eduardo Vidal-Abarca Gamez*******

Universidad de Valencia, España

*Artículo de desarrollo de una prueba de competencia lectora. Investigación realizada con fondos del Ministerio de Ciencia e Innovación. Referencia: EDU2011-27091.

**Departamento de Psicología Evolutiva y de la Educación, ERI Lectura. Profesora titular de dicha Universidad. Correo electrónico: vicenta.avila@uv.es.

***Profesora ayudante Doctor. Correo electrónico: laura.gil@uv.es.

****Profesor titular. Correo electrónico: ramiro.gilabert@uv.es.

*****Profesora ayudante doctor. Correo electrónico: amelia.mana@uv.es.

******Becaria FPI. Correo electrónico: a.cristina.llorens@uv.es

*******Catedrático Universidad. Correo electrónico: vidala@uv.es

Recibido: 16 de abril de 2014 | Aceptado: 28 de septiembre de 2015

Para citar este artículo

Avila Clemente, V., Gil Pelluch, L., Gilabert, R., Mañá, A., & Vidal-Abarca, E. (2016). Método de evaluación dinámica automatizado' de competencias lectoras para educación secundaria (EdiLEC). Universitas Psychologica, 15(1), 219-232. http://dx.doi.org/10.11144/Javeriana.upsy15-1.meda

Resumen

Se presenta un nuevo método de evaluación dinámica de la competencia lectora automatizado para educación secundaria (EdiLEC). Su diseño se ajusta al marco teórico propuesto por el Informe PISA-2009 (OCDE, 2010) y los principios de la evaluación dinámica (Sternberg & Grigorenko, 2002). Esta herramienta electrónica proporciona automáticamente mensajes de retroalimentación adaptados a cada individuo sobre el proceso y ejecución a lo largo de la prueba, añadiendo a los resultados de la evaluación tradicional de la competencia lectora la posibilidad de explorar las potencialidades de aprendizaje del estudiante. El método ha sido baremado con una muestra de 1008 estudiantes de entre 11 y 14 años. Los resultados muestran que consta de propiedades psicométricas de fiabilidad, homogeneidad y validez satisfactorias.

Palabras clave: competencia lectora; PISA; evaluación dinámica; educación secundaria

Abstract

A new method to evaluate students' reading literacy, the Method of Dynamic Assessment for Secondary Education (EdilLEC) is presented. EdilLEC is based on PISA assessment framework and the principles of dynamic assessment. In a computer-based environment, automatically provides adaptive intervention elements (feedback and user's aids), in order to add to the reading literacy traditional assessment the possibility to explore the potential of student's learning. The method has been standarized with a sample of 1008 students between 11 and 14 years of aged. Conclusions: The results show satisfactory psychometric properties of reliability, validity and homogeneity.

Keywords: reading literacy; PISA; dynamic assessment; Secondary Education

Introducción

La importancia de la evaluación reside en que es un elemento crucial del proceso de enseñanza-aprendizaje, por cuanto aporta información acerca del nivel de aprendizaje alcanzado por el estudiante (Pellegrino, Chudowsky, & Glaser, 2001). La práctica docente hace uso de la evaluación en diferentes momentos del proceso de enseñanza (p. ej., para evaluar conocimientos previos, como ayuda para el aprendizaje o como indicador del rendimiento final). Sin embargo, el procedimiento de evaluación clásico, llevado a cabo mediante pruebas estandarizadas, está sometido a revisión por una serie de limitaciones (Utley, Haywood, & Masters, 1992) que, en general, se refieren a las restricciones derivadas de describir al sujeto en términos generales a partir de la comparación con una muestra de referencia, soslayando información sobre los procesos cognitivos implicados en la resolución de la tarea y, consecuentemente, obviando información sobre proceso y capacidad de aprendizaje del estudiante (Guthke & Stein, 1996).

Para paliar estas insuficiencias, surge la denominada evaluación dinámica (ED en adelante). Desde el punto de vista teórico, encontramos antecedentes a este tipo de evaluación que se sustentan en la idea de potencialidad de aprendizaje, como son el concepto de desarrollo próximo de Vygotsky (1931) o el aprendizaje mediado de Feuerstein (1979). La ED engloba un conjunto heterogéneo de enfoques unidos por un elemento común: la incorporación a la evaluación de un proceso de instrucción y retroalimentación asociado, que se va adaptando dinámicamente al rendimiento individual del alumno y que permite explorar sus potencialidades de aprendizaje (Lidz & Elliott, 2000).

Tipos de evaluación de dinámica

Existen dos formatos fundamentales de evaluación dinámica, el formato tipo sándwich y el formato tipo tarta (Sternberg & Grigorenko, 2002). La ED tipo sándwich consta de tres fases fundamentales: pretest, mediación y postest. En la fase de pretest se evalúa al alumno con pruebas convencionales, obteniendo un indicador de su rendimiento (i.e. habilidades que muestra sin ayuda). En la fase de mediación se entrena al estudiante en la resolución de la tarea. Finalmente, en la fase de postest se obtiene una medida de aprendizaje potencial, es decir, referida al progreso conseguido por el alumno tras haber recibido entrenamiento. En el formato tipo tarta las fases de evaluación y mediación se suceden unas a otras en función del progreso que muestra cada alumno. Así, en este formato de ED se presenta al estudiante la tarea y, tan pronto como tiene dificultades, se le proporciona asistencia. Una vez que el estudiante contesta correctamente, se le presenta la siguiente tarea (i.e., se van poniendo capas en la tarta). El tipo de asistencia ofrecida puede variar desde completamente estándar, implicando un conjunto predeterminado de ayudas o retroalimentación (Guthke & Beckman, 2000), o individualizada con fines de diagnóstico e intervención individual (Feuerstein, 1979). La naturaleza del formato tipo tarta se considera especialmente apropiada para ser aplicada a través de contextos electrónicos que permiten una adaptación individualizada y acomodada a las necesidades individuales. En este sentido Guthke & Beckmann (2000) por ejemplo, desarrollaron una prueba que proporciona mensajes cuando se cometen errores y que ajusta la dificultad de los ítems que se presentan al estudiante según su rendimiento a lo largo de la prueba.

La evaluación dinámica dentro del marco teórico de PISA

Las pruebas PISA contemplan tres grandes competencias lectoras: acceso y adquisición de información (referida a la localización de información textual de unidades discretas más o menos explícitas), integración de información (referida al establecimiento de relaciones entre ideas textuales) y reflexión-evaluación de la información (referida al análisis sobre el contenido y la forma de la información). Hay gran consenso entre expertos en que éstas son las tres competencias esenciales a aplicar en la lectura de textos representativos de cualquier situación (pública, personal, educativa u ocupacional), en cualquier soporte (impreso o electrónico), ya sean textos continuos (frases distribuidas en párrafos) o discontinuos (p. ej., textos que incluyen gráficos o tablas).

PISA evalúa estas tres competencias básicas en un entorno de comprensión-orientada-a-tareas (Vidal-Abarca, Mañá, & Gil, 2010). Así, los estudiantes reciben un texto con preguntas y su tarea consiste en utilizar el texto para responder. Ante este formato de evaluación, los estudiantes tienen que monitorizar su conducta y tomar decisiones: cuándo y cómo leer el texto y las preguntas (i.e., si es mejor leer completamente el texto y luego pasar a las preguntas, leerlo parcialmente, o incluso comenzar leyendo las preguntas); si es necesaria o no una búsqueda adicional de información en el texto y qué información textual es pertinente para contestar. En suma, este entorno de lectura-orientada-a-tareas se parece mucho al contexto natural de aprendizaje mediante textos, lo cual hace especialmente interesante la aplicación de un procedimiento de ED con formato tipo tarta a la evaluación de la competencia lectora mediante tareas tipo PISA. Hasta el momento, las pruebas PISA, al igual que las pruebas estandarizadas CompLEC (Llorens et al., 2011) y e-CompLEC (Gil, Serrano, Martínez, & Llorens, 2012), evalúan la competencia lectora de una forma estática.

En este artículo presentamos una prueba de evaluación dinámica tipo tarta basada en el marco teórico de PISA que complementa las anteriores, creando así un procedimiento de evaluación más cercano a las situaciones de enseñanza aprendizaje en que los alumnos reciben asistencia mediante mensajes de retroalimentación y ayuda. De esta forma, esperamos observar cómo los alumnos se benefician de los mensajes, o lo que es lo mismo, identificar su capacidad de aprendizaje en situaciones de lectura-orientada-a-tareas. Así, por ejemplo, se observa cómo dos alumnos con un nivel similar de competencia lectora, medida con un procedimiento estático, se benefician de forma diferente de la asistencia recibida y obtienen puntuaciones diferentes en la evaluación dinámica, concluyendo, por tanto, que poseen diferentes potencialidades de aprendizaje.

Los mensajes de retroalimentación y ayuda en la ED

Desde la perspectiva de la ED, los mensajes de retroalimentación (feedback en adelante) y ayuda son un factor favorecedor del proceso de aprendizaje y de la motivación de los estudiantes (p. ej., Corbetty & Anderson, 2001; Narciss & Huth, 2004).

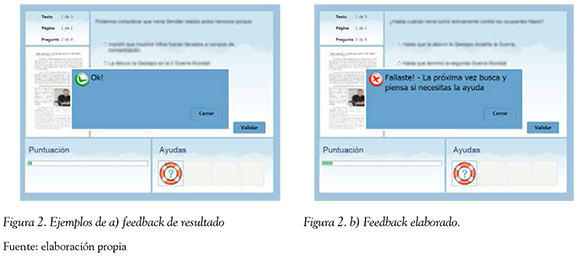

Respecto a los mensajes de feedback, existe consenso entre los expertos en definirlos como "la información que recibe el estudiante tras emitir una respuesta, dirigida a modificar su conocimiento o su conducta con el propósito final de mejorar su aprendizaje" (Mory, 2004; Shute, 2008). Los meta-análisis realizados sobre el tema (p. ej., Shute, 2008) coinciden en subrayar la naturaleza y la calidad del mensaje como uno de los factores fundamentales que determinan la eficacia de los mismos. Así, los mensajes de feedback se clasifican en dos categorías fundamentales: feedback de resultado y feedback elaborado. El feedback de resultado informa exclusivamente acerca de la ejecución en la tarea. Mientras que los mensajes de feedback elaborado proporcionan información pertinente para orientar la conducta hacia la respuesta correcta y pueden incluir información de diversa índole: explicaciones sobre la respuesta correcta, información sobre el tipo de error, consejos para resolver la tarea o ejemplos de cómo es una ejecución correcta. Una cuestión importante es qué tipo de feedback resulta más eficaz para mejorar el aprendizaje. Los estudios sugieren que la función más importante que los mensajes deben abordar es ayudar al estudiante a monitorizar el proceso de aprendizaje adecuadamente (Butler & Winne, 1995). Por tanto, su contenido debe focalizarse en la enseñanza de estrategias de autorregulación. Así mismo, los estudios defienden que resultan más adecuados los mensajes con contenido específico que general, pues suponen un exceso de carga cognitiva para aquellos que los reciben (Kluger & DeNisi, 1998).

En cuanto a los mensajes de ayuda, son dos las características fundamentales que los definen: la primera son mensajes que facilitan al estudiante la resolución de la tarea; la segunda, su emisión depende de la voluntad del estudiante, es decir, a diferencia de los mensajes de feedback, es el lector quien decide si los necesita. En contextos de lectura orientada a tareas como el que nos ocupa, diversos estudios han constatado que los estudiantes tienen dificultades para comprender el contenido de las preguntas (Hannon & Daneman, 2004; Vidal-Abarca et al., 2011). El empleo de ayudas escritas en forma de paráfrasis de la pregunta ha mostrado ser un elemento de asistencia eficaz para comprender las demandas de la tarea (Cerdán, Gilabert, Vidal-Abarca, & Cuñat, 2010), especialmente para aquellos estudiantes con mayores dificultades de comprensión lectora (Cerdán, Llorens, Ávila, Gilabert, & Vidal-Abarca, 2011).

En síntesis, y atendiendo a estos resultados, parece adecuado, e incluso necesario, proporcionar mensajes de feedback con contenido específico referido a la autorregulación de la tarea junto a mensajes de ayuda dirigidos a mejorar la comprensión de la misma. Ambos tipos de mensaje resultan adecuados para favorecer el aprendizaje de los estudiantes en contextos de ED, ajustándose especialmente al modelo tipo tarta descrito previamente.

Objetivos del estudio

El objetivo de este estudio, es la presentación de una prueba de evaluación dinámica de la competencia lectora en un entorno digital para estudiantes de secundaria. Se describe el proceso de desarrollo de EdiLEC y la validación de la prueba mediante instrumentos estandarizados de competencia lectora, y medidas de rendimiento académico, así como la baremación para estudiantes de ESO.

Instrumento

Entorno de trabajo

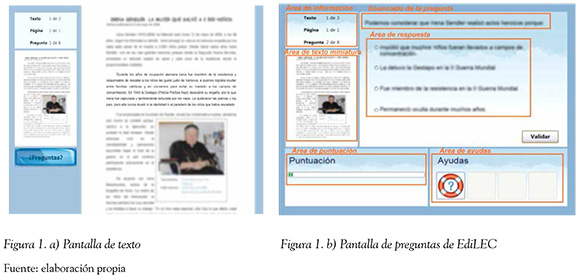

EdiLEC, haciendo uso de la tecnología R&A (Vidal-Abarca et al., 2011), presenta inicialmente información textual (i.e., textos, enunciados de preguntas y alternativas de respuesta) enmascarada. Cuando el lector hace clic en la parte del texto que desea leer, la información se desenmascara y se vuelve legible. De esta forma, solo hay un trozo de texto activo en cada momento. Gracias a la tecnología R&A se pueden registrar en milisegundos todas las acciones que realiza el lector durante el proceso de lectura y contestación a preguntas.

EdiLEC tiene dos pantallas de trabajo: la pantalla de texto (Figura 1a) y la pantalla de preguntas (Figura 1b) que están divididas en distintas áreas. Las dos pantallas comparten el área de información sobre el número de texto, página y pregunta (sin enmascaramiento), y el área de texto en miniatura. En la pantalla de texto, los estudiantes pueden consultar el texto segmento a segmento haciendo uso del ratón. Cuando lo deseen, pueden pasar a consultar las preguntas haciendo uso del botón "preguntas". Por su parte, en la pantalla de preguntas pueden pulsar el texto en miniatura para volver a la pantalla de texto. Así mismo, se muestran también el enunciado de la pregunta, las alternativas de respuesta, el área de puntuación y el área de ayudas (ver información detallada más adelante).

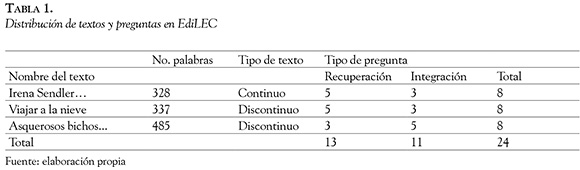

Textos y preguntas

Las tareas de lectura de textos y contestación a preguntas han sido elaboradas siguiendo los principios del esquema PISA y de la ED, tomando en cuenta las siguientes consideraciones: 1) inclusión de textos y preguntas representativos de las diferentes situaciones de lectura contempladas en PISA, con distintos formatos textuales (continuos y discontinuos); 2) extensión que permite su resolución en una sesión clase (aproximadamente 50 minutos); 3) preguntas de respuesta cerrada con tres alternativas, de forma que la corrección es automática.

Para llegar a la versión definitiva de la prueba, realizamos una aplicación piloto en la que probamos diversos textos y preguntas. La aplicación se realizó en papel y lápiz a 40 estudiantes de 2° y 3° de ESO. Los participantes evaluaron también su interés, dificultad percibida y conocimiento previo sobre los textos. Con los resultados de esta aplicación, EdiLEC quedó compuesto por tres textos y ocho preguntas en cada uno, cuya dificultad percibida fue media y con un interés alto. En la Tabla 1 se presentan las características de los tres textos y las 24 preguntas seleccionadas.

Mensajes de retroalimentación y ayuda

Basado en la tecnología TuinLEC (Gil, Serrano, Mañá, Ferrer, & Ávila, 2012), tutor automatizado de enseñanza de estrategias de competencia lectora. EdiLEC dispone de mensajes de retroalimentación y ayuda que "asisten" al estudiante durante la realización de la prueba. En cuanto a los mensajes de retroalimentación, son de dos tipos: feedback de resultado y feedback elaborado. Tras responder a cada pregunta, los estudiantes son informados sobre la corrección de su respuesta (acierto Vs. fallo). Además, si fallan, se informa acerca de por qué han fallado. Este mensaje depende de las acciones llevadas a cabo por el estudiante durante la contestación a la pregunta y se presenta en forma de consejo sobre cómo mejorar su ejecución. El algoritmo automático que genera el mensaje tiene en cuenta si el estudiante ha releído el texto para buscar la información pertinente y si ha empleado la ayuda para contestar (Figura 2).

Antes de responder a cada pregunta, y después de haber leído el enunciado, el estudiante puede optar por utilizar el ícono de Ayudas. Los mensajes de ayuda incluyen una reformulación o paráfrasis de la pregunta. Para ilustrar en qué consisten, a continuación presentamos un ejemplo extraído del texto "Irena Sendler". Para contestar a la pregunta ¿en qué fecha se descubrió la historia de la heroína polaca?, el estudiante dispone del siguiente mensaje de ayuda: "encuentra en el texto el año en que se conoció la historia de Irena" (Figura 3).

Sistema de puntuación

Además de los mensajes de feedback y ayuda descritos, EdiLEC incluye un sistema de retroalimentación de tipo cálido (Sánchez et ál., 2008) basado en la acumulación de puntos por cada pregunta acertada, que se reflejan en el área de puntuación. Se ha constatado que los sistemas de puntos que indican el progreso del alumno a lo largo del proceso de aprendizaje son beneficiosos para su autorregulación y motivación (McNamara, Jackson, G. T., & Graesser, 2010).

Informe de resultados

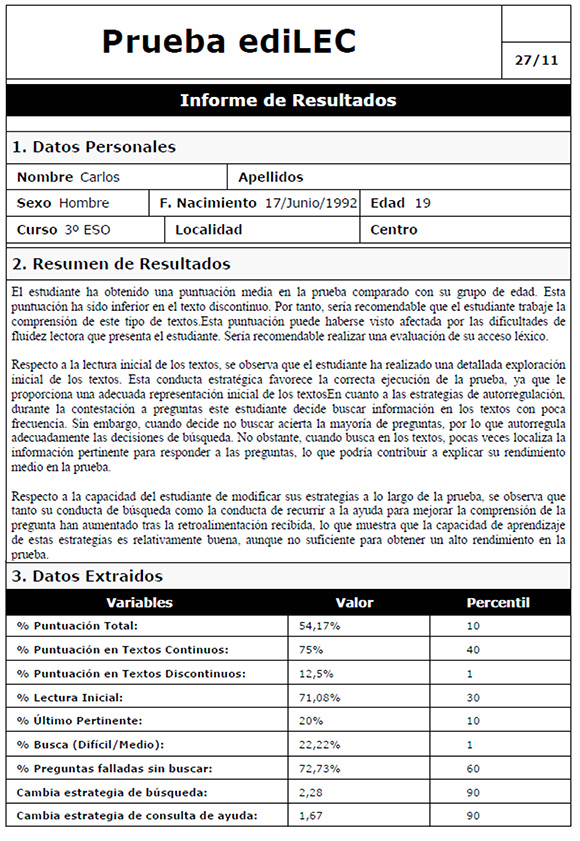

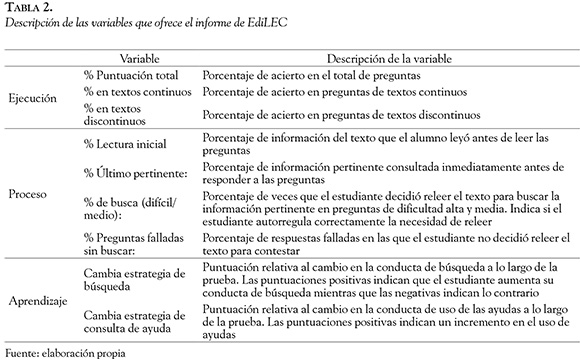

EdiLEC genera un informe individualizado (véase el Anexo 1), dividido en tres apartados: 1) datos personales; 2) resumen de resultados; 3) datos extraídos. El resumen de resultados informa sobre el nivel de ejecución alcanzado por el alumno en la prueba, las estrategias empleadas y su potencialidad de aprendizaje. También, aporta consejos sobre cómo trabajar algunos procesos deficitarios. En los datos extraídos se muestran los valores de los índices relativos a las distintas variables de ejecución y proceso (decisiones tomadas por el alumno durante la lectura y resolución de preguntas); variables de aprendizaje registradas por el sistema y los baremos correspondientes. En la Tabla 2 se presenta una descripción de todas ellas.

Las variables de ejecución indican el rendimiento del estudiante en la contestación de preguntas y se corresponden con las aportadas en pruebas tradicionales de evaluación estática de comprensión lectora. Gracias al empleo de la tecnología Read&Answer, EdiLEC incluye variables de proceso. Así, la lectura inicial favorece tanto la comprensión final del texto, como la selección y procesamiento de la información relevante para responder a las preguntas (Cerdán, Vidal-Abarca, Martínez, Gilabert, & Gil, 2009). Por otra parte, también se ha demostrado que el uso de la información pertinente antes de responder, correlaciona significativamente con medidas de búsqueda eficaz (Mañá, Vidal-Abarca, Domínguez, Gil, & Cerdán, 2009; Vidal-Abarca et al., 2010). En cuanto a los índices relativos a la búsqueda de información, Vidal-Abarca et al. (2010) encontraron que decidir buscar información en el texto para responder es una fuente de diferencias individuales que ayuda a los estudiantes a responder correctamente.

Por último, EdiLEC registra en los índices de aprendizaje los cambios en las estrategias lectoras relacionadas con la búsqueda de información para responder a las preguntas y las decisiones respecto al uso de ayudas durante el proceso de evaluación. Este tipo de variables son totalmente novedosas en los sistemas de evaluación de comprensión y propias del proceso de instrucción que conlleva la evaluación dinámica. Asumimos que los cambios observados en la conducta del estudiante responden a los mensajes de feedback elaborado relativos a su conducta de búsqueda y de empleo de las ayudas que reciben tras las respuestas incorrectas.

Método

Participantes

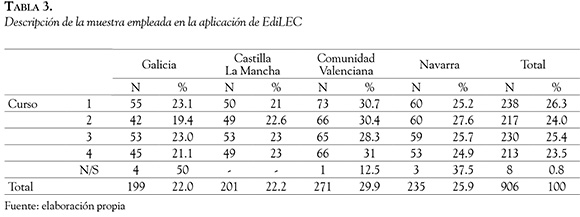

La prueba se aplicó a 1008 estudiantes de todos los cursos de ESO en centros de cuatro Comunidades Autónomas (Galicia, Castilla La Mancha, Comunidad Valenciana y Navarra). Se eliminaron 102 estudiantes debido a errores en la cumplimentación de las pruebas, quedando la muestra compuesta por 906 sujetos: 444 chicos, 451 chicas y 11 sin cumplimentar dicho campo (véase la Tabla 3).

Materiales y aplicación

EdiLEC: los estudiantes completaron la versión definitiva de EdiLEC. Las instrucciones fueron dadas en voz alta por un investigador del grupo con un soporte de Power Point. Se explicaba la estructura de la prueba y cómo usar el programa.

CompLEC: prueba de evaluación de la competencia lectora en formato papel y lápiz (Llorens et al., 2011, para una descripción detallada de la prueba).

Las diferentes pruebas se aplicaron el mismo día, de forma grupal, en dos sesiones de 50 minutos, con un intervalo de tiempo mínimo de 50 minutos entre ambas. En la primera sesión se aplicó CompLEC y en la segunda EdiLEC.

Resultados

A continuación se presentan los resultados relativos a la fiabilidad y validez de la prueba, así como la baremación de la misma.

Consistencia interna

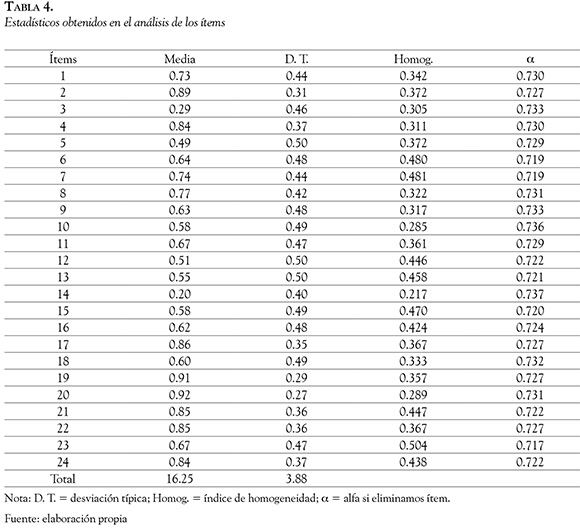

El coeficiente alfa de Cronbach se ha calculado a partir de la puntuación global en la prueba. Se obtuvo un índice global de 0.735, lo que supone un índice alto de fiabilidad.

Análisis de ítems

Los datos más relevantes obtenidos en este apartado se incluyen en la Tabla 4. En primer lugar, se muestran los índices de dificultad de los ítems, que presentan valores entre 0.20 y 0.92. En segundo lugar, aparecen los índices de homogeneidad, cuyos valores (entre 0.22 y 0.50) evidencian un alto nivel de consistencia interna. Respecto a la dificultad de los ítems, dos resultaron ligeramente más difíciles que el resto (ítems 3 y 14), con una media de acierto de 0.29 y 0.20, respectivamente. En cuanto la dificultad de cada texto, el segundo texto (M=4.34; DT=1.79) resulta más difícil que el primero (M=5.40; D.T =1.59) y el tercero (M=6.51; DT=1.52).

Validez

La validez de constructo fue establecida mediante el análisis de la relación entre EdiLEC y CompLEC (Llorens et al., 2011). El índice de correlación de Pearson entre ambas pruebas es de 0.66 (p < 0.01). La validez criterial fue analizada a partir de la relación entre la puntuación global de EdiLEC y el rendimiento académico de los alumnos. Se calculó el índice de correlación entre la puntuación de Edi-LEC y la calificación numérica (1-10) en distintas materias. Los resultados muestran correlaciones estadísticamente significativas (p < 0.01) en todos los casos: el índice de correlación entre la puntuación en EdiLEC y la calificación en Lengua Española y Literatura es de 0.363, de 0.271 en Matemáticas, de 0.336 en Ciencias Sociales, de 0.437 en Ciencias Naturales, de 0.402 en Física y Química y de 0.297 en Biología.

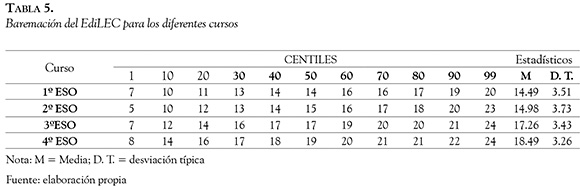

Baremación

Por último, se realizó la baremación de la prueba según las puntuaciones totales obtenidas en los cuatro niveles de ESO (véase la Tabla 5).

Conclusiones

EdiLEC ha sido desarrollado con éxito y la aplicación realizada a una muestra de más de mil estudiantes ha ofrecido resultados que suponen un avance conceptual, metodológico y tecnológico en la evaluación del nivel de competencia lectora del alumnado de ESO. El avance conceptual se refiere al uso de evaluación dinámica cuya principal ventaja estriba en la posibilidad de obtener información de procesos de aprendizaje y no sólo de rendimiento. Así, EdiLEC, además de proporcionar información acerca del nivel de competencia lectora, ofrece información valiosa acerca de los cambios que se producen en los procesos y estrategias de aprendizaje del estudiante durante la realización de la prueba. Estos cambios se producen como respuesta a los mensajes de retroalimentación y ayuda que incluye el programa. La inclusión de intervención, dentro del procedimiento de evaluación, mediante mensajes individualizados y dinámicos referidos a la ejecución y el comportamiento del estudiante durante la realización de tareas tipo PISA, supone un importante avance metodológico respecto a los métodos más tradicionales de evaluación de la competencia lectora.

Para terminar, el avance tecnológico se ha logrado gracias a la combinación de la tecnología Read&Answer (Vidal-Abarca et al., 2011) y la tecnología TuinLEC (Gil et al., 2012). La integración de ambas aplicaciones permite que EdiLEC genere un registro on-line de todas las acciones realizadas por el lector para resolver las preguntas, ofrezca mensajes automáticos y adaptados a la conducta del estudiante, permita la utilización de ayudas durante el proceso de contestación a preguntas y, finalmente, se elabore un informe automático de resultados.

Referencias

Butler, D. L., & Winne, P. H. (1995). Feedback and Self-Regulated Learning: A Theoretical Synthesis. Review of Educational Research, 65(3), 245-281. [ Links ]

Cerdán, R., Vidal-Abarca, E., Martínez, T., Gilabert, R., & Gil, L. (2009). Impact of question-answering tasks on search processes and reading comprehension. Learning and Instruction, 19(1), 13-27. [ Links ]

Cerdán, R., Gilabert, R., Vidal-Abarca, E., & Cuñat, M. L. (2010). "Please, read what the question is asking for you". How textual aids may increase awareness of question demands. 4th Biennial Meeting of the EARLISIG-16 on Metacognition. Muenster, Alemania. [ Links ]

Cerdán, R., Llorens A. C., Avila, V., Gilabert, R., & Vidal-Abarca, E. (2011). Using textual aids to foster the comprehension of task demands in skilled and less-skilled comprehenders. Poster presented at the 21th Annual Meeting of the Society for Text & Discourse. Poitiers, France. [ Links ]

Corbetty, A. T., & Anderson, J. R. (2001). Locus of feedback control in computer-based tutoring: Impact on learning rate, achievement and attitudes. In Proceedings of ACMCHI 2001 Conference on Human Factors in Computing Systems (pp. 245-252). New York: Association for Computing Machinery Press. [ Links ]

Feuerstein, R. (1979). The dynamic assessment of retarded performers: The Learning Potential Assessment Device. Baltimore: University Park Press. [ Links ]

Gil, L., Serrano, M. A., Martínez, T., & Llorens, A. C. (2012). La evaluación on-line de la competencia lectora. Quaderns digitals (71) 1-15. Recuperado de http://www.quadernsdigitals.net/index.php?accionMenu=hemeroteca.VisualizaArticuloIU.visualiza&articulo_id=11148 [ Links ]

Gil, L., Serrano, M. A., Mañá, A., Ferrer, A., & Avila, V. (2012). Intervención en las dificultades en competencia lectora. Quaderns digitals, (71) 1-17. Recuperado de http://www.quadernsdigitals.net/index.php?accionMenu=hemeroteca.VisualizaAr-ticuloIU.visualiza&articulo_id=11153 [ Links ]

Guthke J., & Stein, H. (1996). Are Learning Tests the Better Version of Intelligence Tests? European Journal of Psychological Assessment, 12(1), 1-13. [ Links ]

Guthke, J., & Beckman, J. F. (2000). Learning Test Concepts and Dynamic Assessment. En A. Kozulin & R. Yaacov (Eds.), Experience of Mediated Learning: An Impact of Feuersteins Theory in Education and Psychology. Advances in Learning and Instruction (pp. 175-90). Elmsford, NY: Pergamon Press. [ Links ]

Hannon, B., & Daneman, M. (2004). Shallow Semantic Processing of Text: An individual-Differences Account. Discourse Processes, 37(3), 187-204. [ Links ]

Kluger, A. N., & DeNisi, A. (1998). Feedback interventions: Toward the understanding of a double-edged sword. Current Directions in Psychological Science, 7, 67-72. [ Links ]

Lidz, C. S., & Elliot, J. G. (2000). Advances in cognition and educational practice. En J. Carlson (Ed.), Dynamic assessment: Prevailing Models and Applications (pp. 323-340). New York: Elsevier. [ Links ]

Llorens, A. C., Gil, L., Vidal-Abarca, E., Martínez, T., Mañá, A., & Gilabert, R. (2011). Evaluación de la Competencia Lectora: La Prueba de Competencia Lectora para Educación Secundaria (CompLEC). Psicothema, 23(4), 809-818. [ Links ]

Mañá, A., Vidal-Abarca, E., Domínguez, C., Gil, L., & Cerdán, R. (2009). Papel de los procesos metacognitivos en una tarea de pregunta-respuesta con textos escritos. Infancia y Aprendizaje, 32(4), 553-565. [ Links ]

McNamara, D. S., Jackson, G. T., & Graesser, A. C. (2010). Intelligent tutoring and games (ITaG). In Y. Baek (Ed.), Gaming for Classroom-Based Learning: Digital Role Playing as a Motivator of Study (pp. 44-65). Plainsboro, NJ: IGE Global Press. [ Links ]

Moreno, R. (2004). Decreasing cognitive load for novice students: Effects of explanatory versus corrective feedback in discovery-based multimedia. Instructional Science, 32, 99-113. [ Links ]

Mory, E. H. (2004). Feedback research review. In D. Jonassen (Ed.), Handbook of research on educational communications and technology (pp. 745-783). Mahwah, NJ: Lawrence Erlbaum. [ Links ]

Narciss, S., & Huth, K. (2004). How to design informative tutoring feedback for multimedia learning. En H. M. Niegemann, D. Leutner, & R. Brunken (Ed.), Instructional design for multimedia learning (pp. 181-195). Munster, NY: Waxmann. [ Links ]

OCDE (2010). PISA 2009. Programa para la evalución Internacional de los Alumnos OCDE. Informe Español. MEC. Madrid. [ Links ]

Pellegrino, J. W., Chudowsky, N., & Glaser, R. (2001). Knowing what students know: The science and design of educational assessment. Washington, DC: National Academy Press. [ Links ]

Sánchez, E., García, J. R., Castellano, N., De Sixte, R., Bustos, A., & García-Rodicio, H. (2008). Qué, cómo y quién: tres dimensiones para analizar la práctica educativa. Cultura y Educación, 20(1), 95-118. [ Links ]

Shute, V. J. (2008). Focus on formative feedback. Review of Educational Research, 78(1), 153-189. [ Links ]

Sternberg, R. J., & Grigorenko, E. L. (2002). Dynamic testing. New York: Cambridge University Press. [ Links ]

Utley, C. A., Haywood, H. C. & Masters, J. C. (1992). Policy implications of psychological assessment of minority children. En H. C. Haywood & D. Tzuriel (Eds.), Interactive assessment (pp. 445-469). New York: Springer-Verlag. [ Links ]

Vidal-Abarca, E., Mañá, A., & Gil, L. (2010). Individual differences for self-regulating task-oriented reading activities. Journal of Educational Psychology. 102(4), 817-826. [ Links ]

Vidal-Abarca, E., Martinez, T., Salmerón, L., Cerdán, R., Gilabert, R., Gil, L., Mañá, A., Lloréns, A., & Ferris, R. (2011). Recording online processes in task-oriented reading with Read&Answer. Behavior research methods, 43(1), 179-132. [ Links ]

Vygotsky, L. S. (1931). Ilprocesso cognitivo. [Pensamiento y Lenguaje]. Torino: Boringhieri. [ Links ]

ANEXO A. Ejemplo de Informe