Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO -

Similars in Google

Similars in Google

Share

Revista Ingenierías Universidad de Medellín

Print version ISSN 1692-3324On-line version ISSN 2248-4094

Rev. ing. univ. Medellín vol.9 no.17 Medellín July/Dec. 2010

Extracción de puntos característicos del rostro para medidas antropométricas

Face landmarks extraction for anthropometric measures

Alejandro González*; Flavio Prieto**

* Ingeniero electrónico. Universidad Nacional de Colombia, Sede Bogotá. Colombia.

** Profesor del Departamento de Ingeniería Mecánica y Mecatrónica, Universidad Nacional de Colombia.Bogotá, Colombia. Correo electrónico: faprieto@unal.edu.co.

Resumen

En este documento se propone una técnica para la extracción de 22 puntos característicos del rostro, orientada a aplicaciones de antropometría. La técnica se fundamenta en la transformada wavelets-Gabor y el uso del algoritmo EBGM (del término en inglés: Elastic Bunch Graph Matching). Este último algoritmo fue modificado para que los puntos extraídos correspondan a puntos característicos del rostro, los cuales se utilizan comúnmente en medidas antropométricas faciales. Las modificaciones consisten en un conjunto de restricciones geométricas para ajustar inicialmente la ubicación de los centros de búsqueda, y posteriormente para la definición de la región de esta búsqueda. Los resultados mostraron que los puntos centrales del rostro presentan errores de ubicación inferiores al milímetro, lo cual es consistente con las medidas en antropometría facial directa.

Palabras clave: antropometría facial, transformada wavelets, algoritmo EBGM.Abstract

In this research, a technique for the extraction of a 22 face landmarks set oriented to anthropometry applications has been proposed. The technique is based on wavelets Gabor transformation and the Elastic Bunch Graph Matching (EBGM) algorithm. The EBGM algorithm was modified so that the extracted points correspond to face landmarks which are commonly used in face anthropometric measures. Modifications were: some geometric restrictions to initially fit the centers location of the region search, and later for the definition of the region. Results show that the face central points present location errors smaller than a millimeter, which is consistent with the measures in direct face anthropometry.

Key words: facial anthropometry, wavelets transformation, EBGM algorithm.

INTRODUCCIÓN

El procesamiento de imágenes faciales es una de las áreas de mayor desarrollo dentro de los sistemas de visión artificial [1-3]. Las medidas faciales han sido variables fundamentales en aplicaciones de reconocimiento facial [4, 5], antropometría [6], seguimiento [7], animaciones [8], etc. La antropometría hace referencia al estudio de las dimensiones y proporciones de las partes del cuerpo humano; esto se hace con el propósito de comprender los cambios físicos del hombre y obtener una medida de las diferencias entre las razas. La evaluación antropométrica facial está basada en la determinación de puntos característicos del rostro, definidos en términos de las características visibles o palpables del complejo facial. Los estudios han determinado que los ojos, la boca y la nariz se encuentran entre las partes más importantes para recordar rostros. Esto quiere decir que presentan características distinguibles que no se pueden encontrar en otras partes como la frente o las mejillas.

Dentro de los diversos tipos de métodos para extracción de características faciales se destacan los basados en geometría [9, 10], los basados en plantillas [11-13] y los basados en la apariencia [14, 15]. En los primeros las características son extraídas basándose en información geométrica tal como la posición y tamaño de los componentes de la cara; generalmente estos métodos requieren la selección cuidadosa de umbrales. En los segundos, se realiza una correspondencia con alguna plantilla previamente diseñada, la mejor correspondencia debe producir la energía mínima; además de los altos costos computacionales estos métodos presentan dificultades cuando las características cambian significativamente, por ejemplo en el caso de los ojos cerrados, los ojos con gafas y la boca abierta. Finalmente, la técnica de segmentación por color hace uso del color de la piel para aislar la región facial; dentro de la región facial cualquier región que no tenga el color de la piel es aceptada como una posible zona para la ubicación de los ojos o la boca. El rendimiento de esta técnica se limita a causa de la diversidad étnica.

La orientación de los trabajos en extracción de características faciales ha sido tradicionalmente hacia el reconocimiento de rostros, esto debido posiblemente al importante número de aplicaciones comerciales y de seguridad, dejando un vacío en aplicaciones de antropometría para cirugía reconstructiva facial [16, 17]. En este trabajo se propone una técnica de para la localización de características del rostro, por lo que se enmarca dentro de la antropometría facial. La técnica emplea el algoritmo Elastic Bunch Graph Matching (EBGM), desarrollado en la Universidad Estatal de Colorado y publicado para libre uso en investigación [18]. La finalidad de EBGM es el reconocimiento facial y para esto, en una etapa inicial, este realiza la extracción de características faciales locales. Debido a que EBGM no fue diseñado para aplicaciones en antropometría, su exactitud no es la deseada y es por esto que se han examinado los parámetros que influencian la ubicación de las características y se han realizado modificaciones de interés buscando mejorar el desempeño.

El resto del documento está estructurado de la siguiente manera: en la sección 2 se presentan algunos breves fundamentos en wavelets Gabor y el algoritmo EBGM. La sección 3 describe la técnica propuesta para la extracción de puntos característicos del rostro. Los resultados obtenidos son presentados en la sección 4. Finalmente se presentan las conclusiones.

1. FUNDAMENTOS TEÓRICOS

1.1 Wavelets Gabor

Desde el descubrimiento de la organización cristalina de la corteza visual en el cerebro de mamíferos hace aproximadamente treinta años, una enorme cantidad de investigaciones experimentales y teóricas han permitido un mejor entendimiento del cerebro y de las propiedades de respuesta de sus células. En particular, en los trabajos teóricos de Marcelja [19], se han desarrollado avances bajo la premisa que las células simples en la corteza visual pueden ser modeladas por funciones de Gabor.

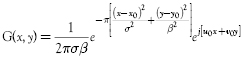

Las funciones bidimensionales de Gabor son filtros espaciales pasa-banda, que permiten alcanzar la resolución conjunta de información máxima en los espacios bidimensionales espacial y frecuencial. Gabor mostró que existe un fenómeno análogo al principio de incertidumbre de Heisenberg de la física, que se aplica al dominio espacio-frecuencia. Este fenómeno indica que existe una relación entre la resolución en el dominio temporal y frecuencial, ya que existe un límite inferior para el producto de estas dos cantidades [20]. Gabor descubrió que las funciones gaussianas moduladas por exponenciales complejas resultan tener la mejor relación entre la resolución en los dominios temporal y frecuencial. Daugman generalizó la función de Gabor como se presenta en la ecuación 1, para modelar el campo receptivo de células simples sensitivas a la orientación [21].

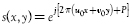

La ecuación 1 se puede reescribir como una función compuesta por una sinusoidal compleja (s(x,y)), conocida como la portadora y una función gaussiana (w(x,y)), conocida como la envolvente, como se puede ver en la ecuación 2.

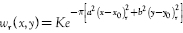

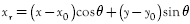

con  y

y

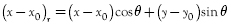

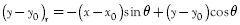

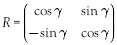

, donde el sufijo r representa la operación de rotación siguiente:

, donde el sufijo r representa la operación de rotación siguiente:  y

y  ; u0, v0 definen la frecuencia espacial de la portadora; K escala la magnitud de la envolvente gaussiana; a, b escala los dos ejes de la envolvente; x0, y0 determinan la ubicación del valor pico de la función gaussiana; y θ representa la orientación de la portadora.

; u0, v0 definen la frecuencia espacial de la portadora; K escala la magnitud de la envolvente gaussiana; a, b escala los dos ejes de la envolvente; x0, y0 determinan la ubicación del valor pico de la función gaussiana; y θ representa la orientación de la portadora.

1.2 EBGM: Elastic Bunch Graph Matching

El algoritmo Elastic Bunch Graph Matching (EBGM) [22] fue diseñado para realizar tareas de reconocimiento facial, utilizando solamente algunos puntos de interés y no la cara en su totalidad. La primera parte del algoritmo trata la extracción de características locales, razón por la cual se utiliza en este trabajo como herramienta en la detección de puntos de interés en antropometría.

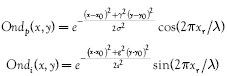

La implementación del algoritmo EBGM requiere el uso de las wavelets mencionadas en la subsección precedente, ya que estas brindan una descripción de la información en frecuencia, en una región específica de la imagen. Para esto es necesario realizar la operación de convolución de la región con una variedad de wavelets; estas waveletsson almacenadas como máscaras en arreglos bidimensionales. Las máscaras se pueden definir mediante la ecuación 3, donde las wavelets se separan en parte par y parte impar.

con:  ; donde λ define la longitud de onda, σ define el radio de la gausiana, γ define la relación de aspecto de la gaussiana. θ y x0, y0 fueron definidos precedentemente.

; donde λ define la longitud de onda, σ define el radio de la gausiana, γ define la relación de aspecto de la gaussiana. θ y x0, y0 fueron definidos precedentemente.

A continuación se describe la sección del algoritmo EBGM que se refiere a la localización de características, por ser la parte de interés en este trabajo.

1. Se define una estructura de grafo sobre la cara, cuyos nodos son puntos de interés, que se puedan localizar fácilmente y que posean la misma estructura en todos los rostros.

2. Cada nodo del grafo es caracterizado utilizando un banco de filtros de Gabor de diferentes frecuencias y orientaciones. En cada nodo, se calcula la respuesta de todos los filtros, a lo que se da el nombre de Jet. Por consiguiente, cada nodo queda etiquetado con sus coordenadas y su Jet asociado.

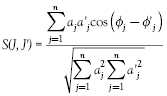

3. Para una imagen nueva se busca en la base de datos el conjunto de Jets que sean más similares. Para esto se centra el grafo en los ojos de la nueva imagen, se calculan los jets de estos puntos y se comparan contra los jets de los ojos en la base de datos. Para la comparación de los jets se utiliza una función de similitud por fase, ésta es similar a una correlación, y está definida como se describe en la ecuación 4.

donde: a' es la magnitud del Jet de la base de datos, a la magnitud del Jet de la imagen nueva, θ' la fase del Jet de la base de datos, θ la fase del Jet de la imagen nueva y n el número de coeficientes del Jet.

2. EXTRACCIÓN DE PUNTOS CARACTERÍSTICOS DEL ROSTRO

La fotogrametría, a diferencia de la antropometría directa, se basa en la realización de medidas a partir de las imágenes o fotografías 2D de los sujetos; con esta técnica se busca evitar las marcas a priori en el rostro. En esta sección se expone la técnica propuesta para la extracción de los puntos característicos para antropometría facial.

2.1 Base de características

Se tomaron 50 imágenes de niños en posición frontal, extraídas de una base de datos de población infantil en Manizales, Colombia [23]. Para estas imágenes se conoce la equivalencia de un píxel en milímetros; además, ellas fueron adquiridas a una distancia fija de la cámara y bajo condiciones de iluminación controladas. Las imágenes, originalmente en color y con una resolución de aproximada de 1200 por 2500 píxeles, fueron llevadas a niveles de gris con una resolución de 512 por 512 píxeles.

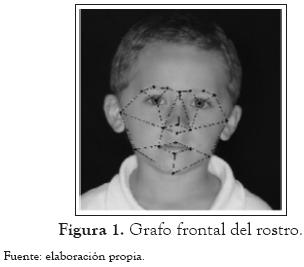

Con estas imágenes se generaron los grafos del rostro en posición frontal (paso 1 descrito en la sección 1.2), mediante la marcación manual de los puntos del grafo en todas las imágenes, y hallando los valores promedio. Los puntos que se utilizan para la identificación son preferentemente aquellos que están localizados en zonas en las que el grosor de los tejidos blandos es menor, ya que tienen menos variación como consecuencia de cambios debidos a la edad, peso o expresiones faciales. Adicionalmente, los puntos deben mantener la simetría del rostro, esto se logra con 22 puntos [24]. Los 22 puntos de interés son: iris izquierdo, iris derecho, punta de la nariz, fosa izquierda, fosa derecha, puente nasal, comisura izquierda del labio, comisura derecha del labio, labio superior, labio inferior, entrecejo, ceja izquierda-lado derecho, ceja izquierda-centro, ceja izquierda-lado izquierdo, ceja derecha-lado izquierdo, ceja derecha-centro, ceja derecha-lado derecho, oreja izquierda, oreja derecha, mandíbula lado izquierdo, mandíbula lado derecho y mentón. El grafo se ilustra en la figura 1.

Con las imágenes y los puntos del grafo se calculan los Jets en cada punto (paso 2 descrito en la sección 1.2). Los Jets utilizados son un banco de máscaras de Gabor de diferentes frecuencias y orientaciones (5 frecuencias y 8 orientaciones). Teniendo en cuenta que se trabaja con máscaras de wavelets par e impar, se tienen 80 máscaras. El tamaño de la máscara está relacionado con la frecuencia de tal manera que λ es igual a un cuarto del tamaño; los tamaños son 50, 38, 25, 19 y 13 píxeles. Se utilizan 8 orientaciones que varían de 0 a π cada π/8, además se hace σ = 3λ. En cada nodo del grafo se calcula la respuesta de los 80 filtros mediante la convolución de las máscaras de las 80 wavelets. Se toma la respuesta de los filtros par (wavelets par) como parte real y la respuesta de los filtros impar como parte imaginaria; con estos valores se calcula la magnitud y la fase; esto constituye el Jet. En consecuencia, cada nodo queda etiquetado con las coordenadas del punto característico y los 80 Jets asociados al mismo (40 magnitudes y 40 fases); estos forman la base de características.

Para tener invariancia a la rotación las máscaras se generaron con una rotación equivalente al ángulo de inclinación de los ojos (debido a que es en estos donde se centra el grafo). Esto se logra incrementando θ en la ecuación 3, en el ángulo de los ojos.

2.2 Estimación inicial del grafo

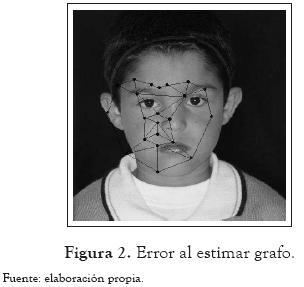

El algoritmo EBGM requiere que los puntos del grafo, correspondientes al centro de las pupilas de los ojos, sean suministrados inicialmente. Como se busca encontrar características del rostro de manera automática, se implementó un algoritmo que detecta la ubicación del centro de las pupilas de manera automática, mediante el uso de un filtro de Gabor elíptico [25].Una vez identificados los nodos correspondientes al centro de las pupilas de los ojos, se asigna el grafo estándar a cada imagen de rostro. En esta superposición, el grafo no está en la posición adecuada (ver la figura 2), debido a que las imágenes no están normalizadas.

Este problema se soluciona aplicando al grafo una transformación espacial compuesta de una matriz de rotación R, una constante de escalado K y un vector de traslación T, para ajustar los nodos correspondientes al centro de las pupilas. Para la matriz de rotación se determina el ángulo θ entre la línea que une el centro de las pupilas de los ojos en la imagen y la línea que une los nodos que representan estos centros de pupila en el grafo. Con este ángulo, la transformada de rotación está definida como:  . Para el escalado se encuentra la relación entre la distancia de los centros de pupila en la imagen (di) y la distancia de los nodos que representan los centros de pupila en el grafo (dg). Así, la constante de escalado es: K = di/dg. Finalmente, el vector de traslación T permite superponer el nodo que representa el centro de pupila del ojo izquierdo en el grafo y su equivalente en la imagen, y se determina hallando la distancia x y y entre ellos. Teniendo R, K y T, cada nodo del grafo (Pg) es llevado a las coordenadas del píxel asociado en la imagen (Pi), aplicando la siguiente transformación descrita en la ecuación 5.

. Para el escalado se encuentra la relación entre la distancia de los centros de pupila en la imagen (di) y la distancia de los nodos que representan los centros de pupila en el grafo (dg). Así, la constante de escalado es: K = di/dg. Finalmente, el vector de traslación T permite superponer el nodo que representa el centro de pupila del ojo izquierdo en el grafo y su equivalente en la imagen, y se determina hallando la distancia x y y entre ellos. Teniendo R, K y T, cada nodo del grafo (Pg) es llevado a las coordenadas del píxel asociado en la imagen (Pi), aplicando la siguiente transformación descrita en la ecuación 5.

2.3 Refinamiento del punto

El algoritmo original solo extrae los Jets a partir de los puntos de la estimación inicial, mediante la maximización de la función de similitud de la ecuación 4. Sin embargo, como en aplicaciones de antropometría es importante encontrar los mejores puntos característicos, se propone la extracción de Jets a un vecindario a x b, sobre el cual se realiza una búsqueda exhaustiva. Se selecciona el punto del vecindario que presente mayor similitud, y es ahí donde se ubica el nodo del grafo, obteniendo así el punto refinado. Esta forma de búsqueda se implementó de manera general con entradas a y b, con el fin de definir zonas de búsqueda de diversos tamaños, de acuerdo con el punto a refinar.

Como el proceso de búsqueda en estos vecindarios es exhaustivo, tratando de disminuir los tamaños de las zonas de búsqueda, se propuso un algoritmo para el refinamiento de los puntos, el cual considera los puntos que ya han sido refinados. Es decir, que el desplazamiento requerido en el proceso de refinamiento de un punto afecta los siguientes puntos con el mismo desplazamiento, con el fin de lograr un acercamiento de la estimación al siguiente punto y así disminuir el tamaño de la zona de búsqueda. Este algoritmo de refinamiento sistemático se presenta es la siguiente subsección.

2.4 Búsqueda sistemática de los puntos característicos

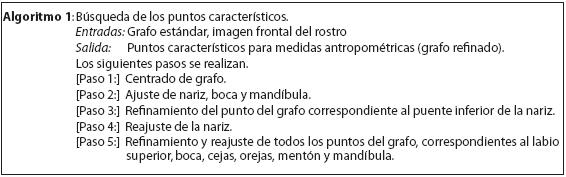

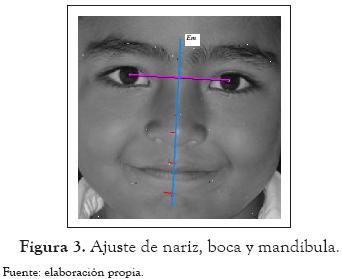

El Algoritmo 1 ilustra es proceso propuesto para la búsqueda sistemática de los puntos característicos en el rostro.

En el paso inicial se centra el grafo, aplicando una transformación espacial compuesta de una rotación, una traslación y un escalado. Posteriormente (paso 2), se ajusta la nariz, boca y mandíbula; para ello se traza una línea llamada Em, perpendicular a la recta que une los puntos del grafo correspondientes a los ojos, y que cruza por el punto medio entre ellos. Como el eje medio del rostro contiene algunos puntos del grafo, se selecciona el punto del grafo correspondiente al puente nasal PGpn y se proyecta a la recta Em. La transformación requerida para llevar el punto PGpn al eje medio es aplicada también a los puntos del grafo relacionados con la nariz, el labio superior y el mentón. La figura 3 ilustra el proceso de ajuste de nariz, boca y mandíbula.

Posteriormente, en el paso 3, se refina el punto del grafo correspondiente al puente inferior de la nariz. Este refinamiento se realiza como se explicó en la subsección 3.3. Como el punto debe estar sobre el eje medio del rostro, el vecindario de búsqueda es alargado en esta dirección. Una vez identificado el punto más similar de la imagen, al nodo del grafo correspondiente al puente inferior de la nariz, se determina la transformación que permite llevar este punto del grafo a su similar en la imagen. Esta última transformación se aplica en el paso 4, al reajuste de los puntos del grafo de la nariz.

Seguidamente, en el paso 5, se realiza el mismo procedimiento de ajuste y refinamiento de los puntos del grafo correspondientes al labio superior, boca, cejas, orejas, mentón y mandíbula. Después del refinamiento final se llega a los puntos característicos del grafo, los cuales pueden ser utilizados para las medidas antropométricas.

3. RESULTADOS

En esta sección se presentan los resultados obtenidos por el algoritmo de búsqueda sistemática de los puntos característicos (nodos del grafo), orientados a medidas antropométricas. Como ya se mencionó, se trabajó con una base de datos de población infantil en Manizales, Colombia [23]. En el proceso de adquisición de estas imágenes se utilizó un patrón de calibración; éste permitió determinar que, en las imágenes, 1 píxel corresponde a 0.128 mm.

3.1 Búsqueda de los puntos del grafo en la imagen facial

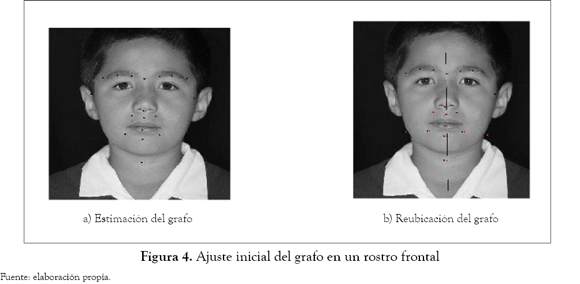

Como se explicó en la sección anterior se inicia con la estimación del grafo estándar (ver figura 4(a)), este grafo se aproxima a la línea perpendicular a los ojos que pasa por el punto medio de estos como se muestra en la figura 4(b).

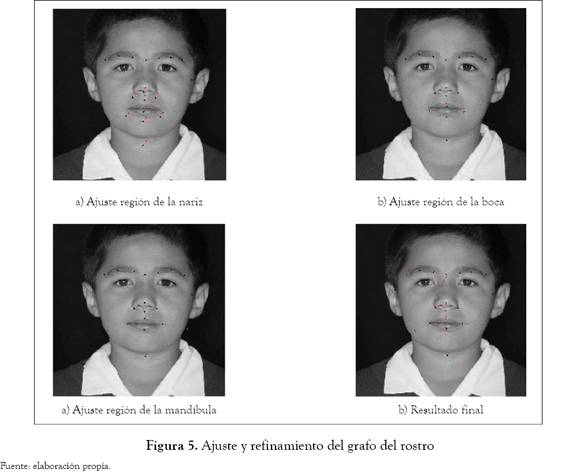

Seguidamente se realiza el refinamiento del punto del puente inferior de la nariz para, posteriormente, ajustar los puntos de la nariz según el desplazamiento que este haya tenido (ver figura 5(a)).

Luego se realiza el mismo procedimiento aplicado sobre la región de la nariz, pero ahora a la región de la boca (ver figura 5 (b)) y a la región de la mandíbula (ver figura 5(c)). Finalmente se refinan todos los puntos del rostro, y se obtiene el resultado final (ver figura 5(d)).

3.2 Análisis

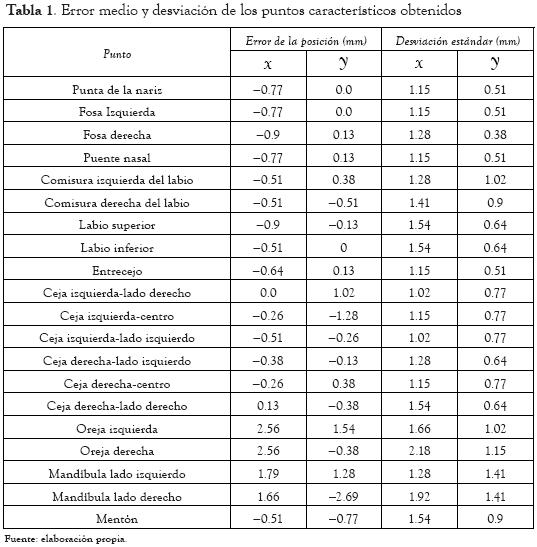

Se realizó un estudio estadístico sobre 124 imágenes faciales de la base de datos. Los puntos característicos obtenidos con el algoritmo implementado fueron comparados contra los puntos marcados por un especialista. En la tabla 1 se presentan los resultados; en ella se incluye el error medio en milímetros en las coordenadas x y y de la posición de cada nodo del grafo o punto característico. También se incluye la dispersión obtenida sobre el conjunto de las 124 imágenes. Como se puede observar en la tabla 1, en general el error es menor a 1 milímetro. Este error es aceptable en aplicaciones de antropometría y está muy cercano al obtenido en la antropometría directa. Los errores superiores al milímetro se presentaron en los nodos correspondientes a partes externas del rostro como son la oreja o la mandíbula. En general estos puntos no son utilizados en aplicaciones de antro-pometría.

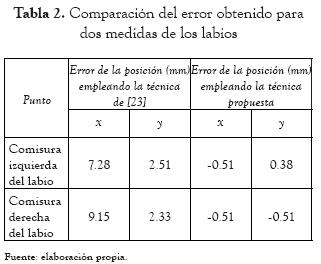

En [23] se desarrolló un trabajo similar pero empleando técnicas de segmentación y proyección de imágenes. Los puntos característicos que se extrajeron allí estaban relacionados con los ojos y los labios. En la tabla 2 se presenta la comparación de los únicos puntos equivalentes en los dos trabajos, estos son las comisuras de los labios. Como se observa, los resultados obtenidos por la técnica propuesta son inferiores en un orden de magnitud, a los resultados reportados en [23].

4. CONCLUSIONES

Se propuso una técnica para la extracción de características faciales orientadas a aplicaciones antropométricas. Esta técnica emplea el algoritmo EBGM, basado en transformada wavelets, técnica que se emplea en aplicaciones de reconocimientos de rostros. Siendo el propósito final las aplicaciones antropométricas, el algoritmo EBGM fue modificado introduciendo etapas de ajuste finos, las cuales se basan en propiedades morfológicas del rostro.

Los resultados mostraron, en general, extracción de puntos con errores menores al milímetro, lo cual se corresponde con la magnitud de los errores que se obtienen en las medidas manuales. Los puntos que presentaron un mayor error corresponden a puntos externos del rostro. El mejor ajuste en los puntos internos, que en general son los puntos más representativos en medidas antropométricas, fue resultado del proceso de ajuste fino que se aplicó a estos.

Como trabajo futuro se plantea definir una mejor estrategia de ajuste fino a los puntos externos del rostro, buscando disminuir el error en los puntos extraídos. Igualmente se propone extender el método a imágenes de rostros de perfil y, en ese mismo sentido, hacer una extensión a medidas antropométricas en imágenes tridimensionales obtenidas a partir de estereovisión.

REFERENCIAS

[1]. K. W. Bowyer et al., “A survey of approaches and challenges in 3D and multimodal 3D+2D face recognition”. Computer Vision and Image Understanding, Vol. 101, no. 1, pp. 1-15, enero de 2006. [ Links ]

[2]. A. N. Ansari y M. Abdel-Mottaleb. “Automatic facial feature extraction and 3D face modeling using two orthogonal views with application to 3D face recognition”. PatternRecognition, vol. 38, no. 12, pp. 2549-2563, diciembre de 2005. [ Links ]

[3]. W. Zhao et al., “Face recognition: A literature survey”. ACM Computing Surveys, vol. 35, no. 4, pp. 399-458, 2003. [ Links ]

[4]. Y. Jiang y P. Guo. “Comparative studies of extraction methods with application to face recognition”. Proceedings of the IEEE International Conference on Systems, Man and Cybernetics, Montreal, Quebec, pp. 627–3632. 7-10 de octubre de 2007. [ Links ]

[5]. Y. Zheng, et al., “A complete rapid feature extraction method for face recognition”. Proceedings of the 18th International Conference on Pattern Recogition, Hong Kong, China, vol. 3, pp. 469–472, 10-14 de agosto de 2006. [ Links ]

[6]. M. Tistarelli. “Advanced techniques for face-based biometrics”. Proceedings of the 19th International Conference on Pattern Recognition, Tampa, USA, pp. 1–1.8-11 de diciembre de 2008. [ Links ]

[7]. Z. Feng, et al., “Research on features extraction from frame image sequences”. Proceedings of the International Symposium on Computer Science and Computational Technology. Shanghai, China, pp. 762–766, 20-22 de diciembre de 2008. [ Links ]

[8]. C. Lau, W. Cham, H. Tsui y K. Ngan. “An energy function for facial feature extraction”. Proceedings of the 2001 International Symposium on Intelligent Multimedia, Video and Speech Processing. Hong Kong, China, pp. 348–351, 2-4 de mayo de 2001. [ Links ]

[9]. G.G. Yen y N. Nithianandan. “Facial feature extraction using genetic algorithm”,presentado a Congress on Evolutionary Computation. Honolulu, USA, Vol. 2, pp. 1895–1900, 12-17 Mayo de 2002. [ Links ]

[10]. B. Amarapur y N. Patil. “The facial features extraction for face recognition based on geometrical approach”. In IEEE CCECE/CCGEI, 1936–1939, Ottawa, Canada, Mayo de 2006. [ Links ]

[11]. Y. Yokogawa, et al., “A proposal of improved lip contour extraction method using deformable template matching and its application to dental treatment”. Systems and Computers in Japan, Vol. 38, no. 5, pp. 80–89, 2007. [ Links ]

[12]. T.F. Cootes, et al., “Active appearance models”. IEEE Transactions on PAMI. Vol. 23, no. 6, pp. 681–685, 2001. [ Links ]

[13]. M. H. Mahoor y M. Abdel-Mottaleb. “Facial features extraction in color images using enhanced active shape model”, presentado a 7th International Conference on Automatic Face and Gesture Recognition (FGR'06), Southampton, UK, 10-12 de abril de 2006. [ Links ]

[14]. K-A. Kim, et al., “Facial feature extraction using PCA and wavelet multi-resolution images”, presentado a Sixth IEEE International Conference on Automatic Face and Gesture Recognition. Seoul, Korea, 17-19 de Mayo de 2004. [ Links ]

[15]. Y. Zhao, et al., “Part-based PCA for facial feature extraction and classification”, presentadoa International Workshop in Haptic Audio visual Environments and Games. Milano, Italy, pp. 99 –104, 7-8 de Noviembre de 2009. [ Links ]

[16]. J. Carnicky y D. Chorvát. “Three-dimensional measurement of human face with structured-light illumination”. MeasurementScienceReview, vol. 6, no. 1, pp. 1-4, 2006. [ Links ]

[17]. S. D. Bianchi, et al., “Evaluation of scanning parameters for a surface colour laser scanner”. Proceedings of the 18th International Congress and Exhibition: Computer Assisted Radiology and Surgery. Vol 1268, pp.1162–1167, junio de 2004. [ Links ]

[18]. D. S. Bolme. “Elastic Bunch Graph Matching”. MSc. Thesis: Department of Computer Science, Colorado State University, mayo de 2003. [ Links ]

[19]. S. Marcelja. “Mathematical Description of the Responses of Simple Cortical Cells”. Journal of the Optical Society of America. vol. 70, no. 11, pp.297-300, noviembre de 1980. [ Links ]

[20]. D. Gabor, “Theory of communication”. Journal IEEE. Vol. 93, part. 3, pp. 429-459, noviembre de 1946. [ Links ]

[21]. J. Daugman. “Uncertainty relation for resolution in space, spatial frequency, and orientation optimized by two-dimensional visual cortical filters”. Journal of the Optical Society of America A. vol. 2, no. 7, pp. 1160-1169, julio de 1985. [ Links ]

[22]. I. Wiskott, et al., “Face recognition by Elastic Bunch Graph Matching”. IEEE Transactions on Pattern Analysis and Machine Intelligence,vol. 19, no. 7, pp. 775-779, Julio de 1997. [ Links ]

[23]. I. M. Mejia, et al., “Caracterización automática de imágenes faciales”. Revista Ingeniería Universidad Distrital Francisco José de Caldas. vol. 12, no. 1, pp. 14-21, enero-junio de 2007. [ Links ]

[24]. I. Alemán, et al., “Identificación humana mediante superposición de imágenes. Una propuesta metodológica”. Cuadernos de Medicina Forense. Vol. 14, no. 53-54, pp. 309-315, Julio-Octubre de 2008. [ Links ]

[25]. Y. Zhang, et al., “A new eye location method based on Ring Gabor Filter”. Proceedings of the International Conference on Automation and Logistics. Qingdao, China, pp. 301-305, 1-3 de septiembre de 2008. [ Links ]

Recibido: 16/02/2010.

Aceptado: 08/10/2010.

(1)

(1) (3)

(3) (4)

(4)