Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO -

Similars in Google

Similars in Google

Share

Revista Lasallista de Investigación

Print version ISSN 1794-4449

Rev. Lasallista Investig. vol.13 no.1 Caldas Jan./June 2016

Evaluación auténtica del impacto social de procesos, proyectos y productos de investigación universitaria: un acercamiento desde los grupos de investigación*

Authentic evaluation of the social impact of university research's processes, projects and products: an approach from the research groups

Avaliação autêntica do impacto social de processos, projetos e produtos de investigação universitária: Uma aproximação desde os grupos de investigação

Julia Victoria Escobar Londoño**, Diego Alberto Castaño***, Marilza Piedad Ruiz Ruiz****, Juan Carlos Restrepo Botero*****

* Este artículo original parte del proyecto denominado Generación de una metodología para la evaluación del impacto social de los proyectos y productos de investigación Fase I y Fase II que hace parte del Plan de Desarrollo Institucional 2011-2015 de la Corporación Universitaria Lasallista. En tal proyecto participan grupos de investigación de las diferentes facultades en el marco del proyecto en el cual los autores son investigadores y docentes. En la primera etapa de este proceso participaron las docentes Kristy Evelyn de la Rojas Arbeláez y Luz Beatriz Orrego. Se agradece el acompañamiento durante este proceso del doctor Iván Montes Iturrizaga- Rector Universidad La Salle de Arequipa - Perú.

** Doctora en Educación de la Universidad de Antioquia. Magíster en Educación de la Pontificia Universidad Javeriana en convenio con la Universidad de Medellín. Licenciada en Matemáticas y Física de la Universidad Pontifica Bolivariana. Docente de tiempo completo y Directora del grupo de investigación Educación y Subjetividad de la Corporación Universitaria Lasallista. Docente de cátedra de la Maestría en Enseñanza de las Ciencias en la Universidad Nacional de Colombia, sede Medellín, Colombia. Correo: juescobar@lasallistadocentes.edu.co.

*** Candidato a magíster en Ingeniería de Nuevos Materiales de la Universidad Pontificia Bolivariana. Ingeniero Químico de la Universidad Nacional de Colombia. Especialista en Combustibles Gaseosos de la Universidad de Antioquia. Coordinador del programa de Ingeniería Industrial y docente de la Corporación Universitaria Lasallista, Caldas, Antioquia, Colombia.

**** Candidata a Doctora en Ciencias Agrarias de la Universidad Nacional de Colombia. Magíster en Ciencia y Tecnología de Alimentos de la Universidad Nacional de Colombia. Zootecnista de la Universidad Nacional de Colombia. Docente de la Corporación Universitaria Lasallista del programa de Zootecnia, Caldas, Antioquia, Colombia.

***** Doctor en Neurociencias de la Universidad Maimónides (Argentina). Licenciado en Filosofía y Psicólogo de la Pontificia Universidad Javeriana. Docente de tiempo completo del programa de Psicología. Director del Grupo de Investigación en Psicología Aplicada GIPA de la Corporación Universitaria Lasallista, Caldas, Antioquia, Colombia.

Autor para correspondencia: Julia Victoria Escobar Londoño, e-mail: juescobar@lasallistadocentes.edu.co.

Artículo recibido: 15/ 06/ 2015; Artículo aprobado: 29/ 02/ 2016

Resumen

Introducción. Al lograr que docentes y estudiantes universitarios apoyen sus prácticas de investigación en clave de una evaluación del impacto social de los procesos, proyectos y productos de investigación, se avanza en el ideal de la formación integral de profesionales, ciudadanos de Colombia y del mundo. Tales profesionales requieren alcanzar altos niveles de transformación en las diversas dimensiones del ser para promover procesos de mantenimiento y mejora integral en su proyecto de vida y en su ejercicio profesional. Objetivo. Describir elementos centrales para la generación de una metodología para la evaluación del impacto social de los proyectos y productos de investigación científica y tecnológica de la instituciones de Educación Superior. Materiales y métodos. El abordaje metodológico se basó en la aplicación de enfoques cualitativo-cuantitativos. Las técnicas utilizadas fueron revisión documental, entrevista a través de grupos focales, diseño de indicadores para capital humano, estructural y relacional, escala de cotejo a directivos, matriz DOFA, entre otros. Resultados. La Universidad actual tiene el reto de cumplir con el encargo ético inherente a su creación. Es evaluar el impacto social de procesos, productos y proyectos de investigación cuando se asume el compromiso y la responsabilidad consigo mismo, el otro y lo otro. Conclusión. El reto es, ahora, la formación de investigadores que no se alejen de la responsabilidad histórica de la universidad y que logren altos niveles de cualificación y dominio de estrategias, técnicas e instrumentos de evaluación de impacto social, que orienten la toma de decisiones institucionales y que contribuyan a construir un nuevo orden social donde la equidad y la justicia sean realidad. Se logra avanzar hacia una evaluación auténtica del impacto social de los procesos, proyectos y productos, más allá de la simple medición cienciométrica y transitar por senderos de responsabilidad y compromiso social de quienes lideran la investigación universitaria en Colombia.

Palabras clave: Evaluación de impacto social, formación, responsabilidad social, educación superior, grupos de investigación.

Abstract

Introduction. By achieving the goal of having professors and students support their research practices according to an assessment of the social impacts of their research processes, projects and products, there is an advance towards an integral formation of the professionals as Colombian and worldwide citizens. Such professionals are required to reach high transformation levels in the diverse dimensions, in order to promote processes for maintaining and improving their life projects and professional practices. Objective. To describe crucial elements for the generation of a methodology for assessing the social impact of the scientific and technological research projects and products developed in higher education institutions. Materials and methods. The methodological approach was based on the application of quantitative and qualitative focuses. The techniques used were documental revision, interviews to focus groups, design of human, structural and relational capital indicators, a comparison scale for directors and SWOT, among others. Results. Nowadays, universities have the challenge of fulfilling the ethical commitment that is the base of their creation. They must assess the social impact of their research processes, projects and products when that commitment is assumed towards themselves and to other social actors. Conclusion. The challenge now is to form researchers who do not move away from the university's historical responsibility and achieve high qualification levels and a high mastery of strategic, technical and assessing instruments for measuring social impacts, thus orienting institutional choice making and contributing to a new social order in which equity and justice can be real. An advance towards an authentic assessment of the social impact of the processes, projects and products is achieved, as those who lead university research in Colombia can go beyond the simple scientometric measuring and take responsibility and social commitment paths.

Key words: Social impact assessment, formation, social responsibility, higher education, research groups.

Resumo

Introdução. Ao conseguir que docentes e estudantes universitários apoiem suas práticas de investigação em chave de uma avaliação do impacto social dos processos, projetos e produtos de investigação, se avança no ideal da formação integral de profissionais, cidadãos da Colômbia e do mundo. Tais profissionais requerem alcançar altos níveis de transformação nas diversas dimensões do ser para promover processos de manutenção e melhoria integral no seu projeto de vida e em seu exercício profissional. Objetivo. Descrever elementos centrais para a geração de uma metodologia para a avaliação do impacto social dos projetos e produtos de investigação científica e tecnológica da instituições de Educação Superior. Materiais e métodos. A abordagem metodológica se baseou na aplicação de enfoques qualitativo-quantitativos. As técnicas utilizadas foram revisão documental, entrevista através de grupos focais, desenho de indicadores para capital humano, estrutural e relacional, escala de cotejo a diretivos, matriz DOFA, entre outros. Resultados. A Universidade atual tem o desafio de cumprir com o encargo ético inerente a sua criação. É avaliar o impacto social de processos, produtos e projetos de investigação quando se assume o compromisso e a responsabilidade consigo mesmo, o outro e o outro. Conclusão. O desafio é, agora, a formação de investigadores que não se distanciem da responsabilidade histórica da universidade e que consigam altos níveis de qualificação e domínio de estratégias, técnicas e instrumentos de avaliação de impacto social, que orientem a toma de decisões institucionais e que contribuam a construir uma nova ordem social onde a equidade e a justiça sejam realidade. Se consegue avançar para uma avaliação autêntica do impacto social dos processos, projetos e produtos, além da simples medição cienciométrica e transitar por sendeiros de responsabilidade e compromisso social de quem lideram a investigação universitária na Colômbia.

Palavras chave: Avaliação de impacto social, formação, responsabilidade social, educação superior, grupos de investigação.

Introducción

La experiencia en investigación en instituciones de Educación Superior colombianas permite afirmar que, a pesar de las transformaciones de las últimas décadas y de las orientaciones del Departamento Administrativo de Ciencia, Tecnología e Innovación en Colombia - Colciencias-, aún se identifica la necesidad de formar a administrativos, docentes y estudiantes universitarios en procesos de evaluación de impacto, especialmente impacto social, debido a que, si bien se han tenido avances en propuestas teóricas, aumento en publicaciones científicas y se ha incrementado la cantidad de proyectos y productos de diversas áreas, persisten situaciones de confusión que limitan o empobrecen tales procesos de evaluación y las decisiones que con base en ellos han de tomarse.

Lo anterior supone retos para el desarrollo curricular en la Educación Superior colombiana. Esto obedece, básicamente, al predominio de enfoques de administración legalistas, carentes de seguimiento y concertación con las instituciones, y al poco desarrollo logrado en la articulación con las grandes tendencias al nivel mundial (Escorcia, Gutiérrez & Enríquez, 2007). Estas limitaciones han de superarse en pro de mejorar las prácticas investigativas en coherencia con la función de la universidad para el siglo XXI, debido entre otras razones a las siguientes1:

-

No es común hallar en la comunidad de investigadores un amplio dominio conceptual y metodológico en estrategias, técnicas e instrumentos de evaluación de impacto debido a confusiones e intereses particulares, y a la novedad de este tipo de evaluación y de su intencionalidad, más allá de una rendición de cuentas económicas.

-

Son pocos los procesos de sistematización de experiencias significativas centradas en la evaluación de impacto que permitan tomar de ellas las lecciones aprendidas, especialmente en impacto social.

-

Se identifica poca claridad acerca de cuándo se debe aplicar una evaluación cuantitativa y cuándo una evaluación cualitativa o cuándo una evaluación mixta. Asimismo, se identifican prácticas evaluativas en las cuales se deja de lado la intencionalidad formativa de la universidad, de las facultades, de los programas e, incluso, de la investigación científica misma.

-

Son pocas las instituciones de Educación Superior en las que existen políticas que soliciten la realización de la evaluación del impacto social en los proyectos de investigación. Una de las excepciones es la Universidad de los Andes.

-

De igual manera, se hallaron pocas evidencias de la existencia de directrices institucionales de evaluación de impacto social para incluir en el proyecto de investigación apoyado en el diligenciamiento de formatos requeridos por Colciencias2. Por ejemplo, no se requiere la inclusión de un objetivo que se centre en la evaluación del impacto social como condición para la aprobación de los proyectos de investigación tanto en convocatorias internas como externas.

-

Dado que la evaluación de impacto en muchos casos no se asume como un proceso, es poco común hallar proyectos en los cuales se dedique un porcentaje del presupuesto de investigación para desarrollar en los proyectos de investigación evaluaciones de impacto social desde el diseño del mismo. Como consecuencia no existen, o son escasas, condiciones y estrategias de seguimiento a corto, mediano y largo plazo del impacto social de procesos, productos y proyecto de investigación. Esta situación puede presentarse con mayor frecuencia en proyectos de intervención, programas o políticas públicas.

-

Por lo anterior, no es común que se sistematice la información obtenida del seguimiento a corto, mediano y largo plazo del impacto social de procesos, productos y proyectos de investigación. Se deduce entonces que no se optimiza la interpretación de la información obtenida del seguimiento a corto, mediano y largo plazo del impacto social de dichos procesos, productos y proyectos de investigación para orientar la toma de decisiones institucionales y gremiales.

-

Son escasas las instituciones de Educación Superior en las cuales se tienen evidencias de transformaciones verificables como consecuencia de un proceso de evaluación del impacto social de procesos, productos y proyecto de investigación considerando para ello tanto a beneficiarios internos como a beneficiarios externos.

-

Los planes de mantenimiento y mejoramiento, tanto para los semilleros, como para los grupos de investigación, facultades e instituciones se redactan, en la mayor parte de los casos, sin considerar como base los resultados de la evaluación periódica del impacto social de procesos, productos y proyectos de investigación para así analizar la pertinencia de los mismos.

Entre las consecuencias de tal situación, está el hecho de que hace falta la evaluación del impacto social y los datos de allí derivados para que orienten las estrategias institucionales para apoyar la generación, la difusión y la apropiación social del conocimiento, ya que los resultados de tal evaluación reflejan los niveles de compromiso y responsabilidad social institucional, así "su puesta en práctica contribuiría a potenciar tres requisitos de la buena evaluación: que sea motivadora, continua y formativa" (Bretones, 2008).

En coherencia con los planteamientos anteriores, Albornoz, Estébanez & Alfaraz (2005, 79) afirman que:

La necesidad de desarrollar herramientas que constituyan el sustento de las políticas de ciencia y tecnología justifica la elaboración de una estrategia que permita, mientras se prosigue la discusión teórica, avanzar hacia el desarrollo de una definición que pueda operacionalizarse de impacto social de la ciencia y la tecnología y de una metodología para su medición. El hecho de que los sistemas de ciencia y tecnología, principalmente en los países en desarrollo, suelen estar basados en el modelo lineal de producción y aplicación del conocimiento legitima este intento y abona la necesidad de desarrollar estudios acerca del impacto.

Se espera entonces que al compartir con la comunidad académica procesos investigativos colaborativos, realizados por docentes e investigadores universitarios en ejercicio, con la participación activa de estudiantes, sus resultados y productos ofrezcan oportunidades para la reflexión y transformación crítica de prácticas evaluativas de los procesos, proyectos y productos de investigación para así orientar conceptual y metodológicamente posibles ajustes en dichas prácticas y avanzar hacia una evaluación auténtica de impacto social a través del uso intencionado de estrategias, técnicas e instrumentos de evaluación que respondan a los desempeños, habilidades y competencias investigativas que la Colombia del siglo XXI requiere para ser capaz de plantear y solucionar problemas y de contribuir en la construcción de un nuevo orden social, no solo para el país sino, especialmente, para la región de América Latina y el Caribe.

Con lo anterior se promueven los planteamientos de Albornoz (2001) cuando defiende la consolidación de liderazgo para América Latina y el Caribe mediante una política científica, tecnológica y de innovación y cuando, desde una postura crítica, describe las posibles políticas de aplicación, que incluyen el uso de la Política Científica tradicional, el uso de la Política Sistémica de innovación, el uso de la Política para la sociedad de la información y el uso de la Política de fortalecimiento de capacidades en ciencia y tecnología, pero enfocadas a nuestras características de región, una región con una debilidad estructural en materia de ciencia y tecnología, asociada, no solo a la disposición de bajos recursos financieros y de la alta heterogeneidad de los países, sino también a la falta de conservación del principio de desarrollo económico y social en simultáneo.

Materiales y métodos

El abordaje metodológico del presente artículo se basó en la aplicación de enfoques cualitativo-cuantitativos, con un diseño de investigación no experimental y corte bibliográfico, lo cual, siendo una investigación explicativa en el contexto de la Educación Superior, posibilitó, en su primera fase, reconocer elementos que permitan -a los grupos de investigación universitarios- avanzar hacia una cultura de evaluación auténtica del impacto social de los procesos, proyectos y productos, más allá de la simple medición cienciométrica, para así transitar por senderos de responsabilidad y compromiso social de quienes lideran la investigación universitaria en Colombia. Las técnicas utilizadas: revisión documental, entrevista a través de grupos focales, diseño de indicadores para capital humano, estructural y relacional, escala de cotejo a directivos, matriz DOFA, entre otros.

Propuesta inicial

Para el desarrollo de la propuesta se parte de responder dos interrogantes centrales ¿Cuál es la función de la universidad? ¿Cuáles son los riesgos de alejarse de ella?

Para avanzar en esta reflexión, comenzamos citando a Houssay (1941) cuando recuerda que la universidad es el centro de la actividad intelectual superior y cumple así un papel social de la más elevada jerarquía. Su función consiste en crear los conocimientos, propagarlos, desarrollar y disciplinar a la inteligencia, formar los cuidadanos más selectos por su cultura y su capacidad. La función primera y principal de la universidad es la investigación, o sea, la búsqueda continua de verdades, que es permanente porque las ciencias están en incesante progreso y perfeccionamiento. Los problemas a resolver son y serán infinitos, y corresponde su estudio a la universidad como centro superior del conocimiento. De acuerdo con Hincapié Noreña, (2005):

La universidad es, por principio, el paradigma de la organización especializada en el manejo del conocimiento avanzado, por medio de sus tres actividades principales: la investigación, la docencia y la extensión. Más aún, en Latinoamérica la institución donde se produce un porcentaje excluyente del conocimiento científico y tecnológico es la universidad.

Para la región de América Latina y el Caribe el llamado cobra mayor relevancia cuando la esperanza en la transformación social habita en las aulas de clase, en los laboratorios, grupos y semilleros de investigación universitarios.

Y, ¿cuáles son los riesgos de alejarse de esta función? La universidad tendrá dificultades para mantener una postura crítica frente a horizontes pedagógicos, sistemas evaluativos, funciones sustantivas (docencia, investigación y proyección social).

Una tercera pregunta es ¿Qué es evaluar? Es un proceso y un resultado. El verdadero papel del evaluador, según Michael Scriven (1967), es el de un "sustituto informado del consumidor" que está provisto de técnicas para obtener una información pertinente y exacta y con un punto de vista profundamente razonado acerca de la ética y el bien común; el evaluador debe ayudar a los profesionales a proporcionar productos y servicios de alta calidad y gran utilidad para los consumidores. Y lo que es aún más importante, el evaluador debe ayudar a los consumidores a identificar y valorar los bienes y servicios alternativos (Stufflebeam & Schinkfield, 1985, 341). Para el caso que nos ocupa: proyectos y productos de investigación en el contexto universitario.

Para este artículo se parte de reconocer la dualidad de la evaluación como proceso y resultado; así, en el primer acercamiento evaluar es "el proceso de obtener información y usarla para formar juicios que, a su vez, se utilizarán en la toma de decisiones" (Tenbrink, 1998). Y como resultado se parte de considerar que el propósito primario de la evaluación es valorar la congruencia de los objetivos con los resultados finales del proceso. Y desde esta dualidad se hace necesario asumir que "el desafío de esta última década en relación con la calidad de la evaluación en Educación Superior está en la necesidad de impregnar la evaluación de realismo, conseguir evaluar el aprendizaje de los estudiantes universitarios a través de tareas profesionales auténticas correlativas o próximas al practicum" (Álvarez, 2008, 253-272). Tal desafío se extiende a la evaluación de impacto.

Entonces, se plantea un cuarto interrogante, ¿Qué implica una evaluación del impacto social de procesos, productos y proyectos de investigación?

Para responder se hace necesario aclarar que este capítulo se construye desde un referente institucional que se apoya en una propuesta pedagógica crítica como un abordaje emancipador de la formación para comprender y resolver problemas relacionados con la práctica pedagógica, mediante la investigación, la reflexión crítica y la toma de conciencia orientada a transformar la praxis, "donde la verdad se pone en tela de juicio en el ámbito de la práctica, no de la teoría" (Grundy, 1998, 215). Tal referente da cuenta de prácticas investigativas reflexivas, críticas, con la intencionalidad de transformar condiciones sociales para mejorar integralmente, en coherencia con los ideales de formación de las Instituciones de Educación Superior.

Se resalta que la Educación Superior hace parte del proceso de formación del futuro profesional, proceso que se respalda a través de experiencias que dan cuenta del para qué, con quién, quién, por qué, cómo, cuándo y dónde se desarrollan determinadas prácticas investigativas, centradas en procesos de evaluación de impacto social.

Desde esta perspectiva la evaluación de impacto social implica contribuir con procesos de transformación, reflexión crítica, concienciación, entre otros procesos, en pro de una mejora integral en la calidad de vida de los beneficiarios de la investigación. También implica claridades conceptuales y metodológicas que se concretan en retos para las prácticas evaluativas de proyectos de investigación y de sus productos.

La Asociación Internacional de Evaluación de Impacto ofrece, en los Principios Internacionales de la Evaluación del Impacto, la siguiente definición:

La evaluación del impacto social (EIS) comprende los procesos de análisis, seguimiento y gestión de las consecuencias sociales, voluntarias e involuntarias, tanto positivas como negativas, de las intervenciones planeadas (políticas, programas, planes, proyectos), así como cualquier proceso de cambio social, invocado por dichas intervenciones.

Esta definición refleja variedad en los posibles cambios que puede producir una acción, para nuestro caso, derivados de procesos y productos de investigación, en determinados contextos. Para este fin, es indispensable aclarar que la evaluación del impacto social puede llevarse a cabo en dos momentos diferentes: ex ante y ex post, entendidas como las evaluaciones realizadas antes y después del impacto, respectivamente (Albornoz et al., 2005). La evaluación ex ante es empleada con frecuencia en proyectos que requieren anticipar o dimensionar los impactos a generar, que pueden ser aplicados a políticas y riesgos de cualquier índole con fuertes efectos ambientales y sociales, por ejemplo, proyectos de minería, considerados ahora "dentro de la locomotora del desarrollo por las políticas nacionales y de Colciencias". En tanto, la evaluación ex post es determinada solo después de la ejecución del proyecto.

Acerca de la educación

De acuerdo con Delors (1997), la educación se concibe como un conjunto de procesos dialécticos de relaciones en las que se producen sucesivas tomas de conciencia individual y colectiva, tomas de decisiones, transformaciones y deseos de armonía, felicidad y trascendencia. Para el contexto colombiano cobra importancia cuando se espera que los estudiantes y egresados universitarios, futuros profesionales, contribuyan a construir nuevos órdenes sociales en los cuales la justicia y la equidad se reflejan en mejores condiciones para los habitantes del territorio nacional.

Según Delors (1997), en estas relaciones se reconoce el movimiento, el cambio y la transformación de los sujetos en diversos niveles; tal dinamismo se da como producto de la práctica reflexiva y de la práctica social, situación dinámica que también se refleja en los procesos de investigación. En relación con lo anterior, Albornoz (2001) concluye su artículo titulado "Política científica y tecnológica: una visión desde América Latina" con las siguientes palabras:

Los esfuerzos que se realicen en ciencia y tecnología son inseparables de una reforma del sistema educativo en su conjunto, con el objeto de elevar el nivel medio de conocimientos y calificar la fuerza de trabajo. Al mismo tiempo, es preciso formar profesionales, investigadores y tecnólogos de alto nivel. Claramente, todo ello será posible sólo en un marco general de políticas que, más allá del ajuste, tengan como objetivo retomar un camino propio hacia el tan ansiado desarrollo económico y social.

De igual manera Bianco, Lugones, Peirano & Salazar (2003) enfatizan el papel de la educación y el aprendizaje como ejes para la construcción de una Sociedad del Conocimiento, y señalan cómo los procesos de aprendizaje social son necesarios para la generación, aplicación y apropiación de ese conocimiento. En Colombia, de acuerdo con el artículo 1 de la Ley 115 de 1994, la educación se asume como "un proceso de formación permanente, personal, cultural y social que se fundamenta en una concepción integral de la persona humana, de su dignidad, de sus derechos y de sus deberes". Se ratifica la estrecha relación entre Educación Superior e investigación para cumplir con el encargo social asumiendo como fundamento que en el actual siglo la Educación Superior constituye un importante medio con que cuenta un país para promover su desarrollo y fortalecer su identidad nacional y autodeterminación (Escorcia y otros, 2007).

La evaluación cumple funciones formativas en los sujetos y en las instituciones, por ello es importante que las universidades y sus grupos de investigación consideren que

[...] Uno de los efectos más relevantes de la evaluación sobre el aprendizaje, se refiere a su contribución en la formación de cualidades en los estudiantes como la autonomía, la reflexión, la responsabilidad ante sus decisiones, la crítica, que forman parte de los objetivos de la enseñanza universitaria (González, 1998).

Estas cualidades se requieren para que la Universidad cumpla su función social, especialmente con los procesos, proyectos y productos derivados de la investigación.

Prácticas de evaluación de las investigaciones: procesos, productos y proyectos según propósitos de la educación superior

Es necesario tener presente lo que señala la Ley 30 de 1992 en su artículo 1 cuando afirma que "la Educación Superior es un proceso permanente que posibilita el desarrollo de las potencialidades del ser humano de una manera integral, y tiene por objeto el pleno desarrollo de los alumnos y su formación académica o profesional". Aquí es pertinente plantearse este interrogante: ¿las prácticas de evaluación de impacto han ayudado a alcanzar los propósitos de la Educación Superior? Antes de responder al interrogante, revisemos qué busca la universidad colombiana. En esta se encuentra un compromiso específico su artículo 4 así:

La Educación Superior, sin perjuicio de los fines específicos de cada campo del saber, despertará en los educandos un espíritu reflexivo, orientado al logro de la autonomía personal, en un marco de libertad de pensamiento y de pluralismo ideológico que tenga en cuenta la universalidad de los saberes y la particularidad de las formas culturales existentes en el país. Por ello, la Educación Superior se desarrollará en un marco de libertades de enseñanza, de aprendizaje, de investigación y de cátedra.

Dicho compromiso se centra en procesos reflexivos, autonomía, pluralidad y libertad. Estos componentes ofrecen un ambiente propicio para la investigación y para la evaluación del impacto social de la misma. Además, en el artículo 6, al plantear los objetivos de la Educación Superior y de sus instituciones, expresa qué se busca, así:

a) Profundizar en la formación integral de los colombianos dentro de las modalidades y calidades de la Educación Superior, capacitándolos para cumplir las funciones profesionales, investigativas y de servicio social que requiere el país [...] d) Ser factor de desarrollo científico, cultural, económico, político y ético a nivel nacional y regional.

Aquí se invita a cuestionar las prácticas institucionales en torno a los esfuerzos para alcanzar altos niveles de calidad, y de estos objetivos en pro de contribuir al desarrollo sostenible de Colombia y la región. Por situaciones que padece la Colombia de hoy, como inequidad social, despilfarro de los dineros públicos, impunidad, entre otros, parece entonces que las prácticas de evaluación de procesos de investigación universitarios no han ayudado a solucionar de manera efectiva situaciones de vulneración de derechos y, con ello, tampoco a alcanzar, con alta calidad, los propósitos de la Educación Superior descritos en párrafos anteriores. Tal situación plantea grandes desafíos para las instituciones de Educación Superior que dan cuenta de su responsabilidad y compromiso social. La investigación universitaria contribuye con la formación de ciudadanos, entendiendo formación como una aproximación al concepto alemán de bildung. Se refiera a una actividad de emancipación, de autocontrol y de responsabilidad con los demás, el entorno y ante todo consigo mismo.

Resultados: retos iniciales e intencionalidad de la evaluación del impacto social en investigación

A continuación se plantean dos aspectos centrales de los resultados parciales de la investigación: en primer lugar, retos iniciales para las instituciones de Educación Superior que buscan cumplir con el encargo ético de la Universidad. En segundo lugar, algunas pistas para dar respuesta a la pregunta ¿para qué evaluar el impacto social de procesos, productos y proyectos de investigación?

Retos iniciales

En primer lugar, se propone un reto que contribuya a superar la evaluación mecanicista y acrítica que por años ha recorrido y habitado las investigaciones universitarias. Se invita a superar la pasividad de administrativos, docentes y estudiantes, a cuestionar sentidos, prácticas, materiales, procesos, a interrogarse por su compromiso con las estrategias de generación, difusión y apropiación social de conocimiento y a reflexionar de manera crítica sobre el componente ético de sus investigaciones antes, durante y después de las mismas. Se plantea la importancia de avanzar hacia propuestas de evaluación que procuren el mejoramiento integral tanto de los actuales investigadores como de los futuros profesionales. ¿Será acaso desde un abordaje de competencias? ¿Cuáles definiciones de competencias investigativas son coherentes con estos planteamientos? Se opta en este apartado, por un acercamiento a una definición de competencia como:

Capacidad para responder a las exigencias individuales o sociales o para realizar una actividad o tarea, cada competencia reposa sobre una combinación de habilidades prácticas y cognitivas interrelacionadas, conocimientos, motivación, valores, actitudes, emociones y otros elementos sociales de comportamiento que pueden ser movilizados conjuntamente para actuar de manera eficaz (Rychen & Salganik, 2003).

Este acercamiento a competencias es coherente con los objetivos de la Educación Superior ya que va más allá de un simple hacer y se compromete con el ser, el saber, el vivir juntos, es decir, con un ser integral y situado. En coherencia con lo anterior cobran sentido, para las instituciones de Educación Superior, los aportes de Albornoz et al. (2005) cuando afirman que:

Concebir los conocimientos científicos y tecnológicos como productos cuyo impacto puede ser analizado, implica describir el carácter y el objeto de un tipo especial de conocimiento, tanto en función de las relaciones de producción y vinculación que establece como de los resultados que puede alcanzar.

En segundo lugar, se propone un reto que parte del reconocimiento de que hablar de competencias implica un entramado de factores ya que para los administrativos, docentes y estudiantes universitarios bien vale la pena recordar que, a la hora de considerar las competencias investigativas, hay que tener presente que:

Una competencia técnica en una especialidad dada es raramente útil si no va acompañada de competencias no técnicas: el saber ser (motivación, decisión, actitud, responsabilidad, etc.), el saber ser hacer con las personas (las relaciones entre las personas, la comunicación y el espíritu de equipo, etc.), el saber hacer con un sistema (resolver los problemas, la polivalencia, la adaptabilidad, entre otros ) (Albornoz et al., 2005).

Este entramado de factores, procesos o condiciones permite que se pueda valorar integralmente el proceso de formación alcanzado por un sujeto, un grupo y una sociedad en un momento y en territorios particulares para enfrentar el reto de investigar con sentido.

El tercer reto se centra en el desarrollo de competencias investigativas en tanto invita a ir más allá de lo teórico e instrumental, es decir, construir sentidos, cuestionar, poner en tensión situaciones que parecen naturales o situaciones que han ocurrido de una manera particular durante un tiempo determinado y que a pesar de presentar irregularidades, limitaciones o contradicciones han sido naturalizadas. Estas competencias investigativas "están relacionadas con el proceso de formación profesional, afianzando habilidades para observar, preguntar, registrar notas de campo, experimentar, interpretar información y escribir acerca de su práctica profesional" (Maldonado, 2007). Y solo a través de un uso intencionado de ellas se podrán enfrentar los retos centrales para el siglo XXI en la formación de profesionales y en el encargo de la Educación Superior.

Tales retos invitan a evaluar, como proceso y resultado, los proyectos de investigación científica como un componente del compromiso y la responsabilidad social universitaria. De acuerdo con Albornoz (2001) "se requiere consolidar la cooperación para la innovación, la cooperación para desarrollar la capacidad de I+D y la desburocratización, donde se vea reforzado el protagonismo de los distintos actores sociales".

El reto central invita entonces a investigar con sentido, con flexibilidad de pensamiento y honestidad para asumir las consecuencias derivadas de los procesos y productos de investigación, previstos e imprevistos.

Intencionalidad de la evaluación del impacto social en investigación

Al preguntar ¿para qué evaluar el impacto social de procesos, productos y proyectos de investigación? Una respuesta a esta pregunta inicia con una reflexión acerca de las características del momento actual, referido a las sociedades del conocimiento, definidas por Hincapié (2009, 3) "como aquellas que se apoderan de las posibilidades del conocimiento como el factor más importante de progreso y bienestar social, y asumen las medidas necesarias para asegurar su adquisición, generación, aplicación, distribución social y reproducción en todas las capas de la sociedad". Se plantea como la primera necesidad de evaluar el impacto social de procesos, productos y proyectos de investigación al buscar esa permeabilidad del conocimiento y generación de bienestar social.

Esta sociedad del conocimiento considera para su funcionamiento los procesos de evaluación con un propósito inicial:

La finalidad que se le ha asignado a la evaluación, en la última década ha sido la de mejorar la evaluación aplicada al proceso (de investigación) consiste en un proceso de recoger de forma sistemática y rigurosa información relevante y continua sobre la situación, formular juicios de valor y tomar decisiones adecuadas para mejorar cualquiera o todos sus componentes (Cabra, 2008, 7).

Y para alcanzar tal intencionalidad es necesario identificar algunas alternativas de transformación, entre ellas: otorgar nuevos sentidos y significados a la evaluación de impacto social "auténtica", dar respuestas a exigencias mundiales, esbozar algunos elementos básicos para fundamentar tal autenticidad en la evaluación.

Se parte de identificar el desarrollo de iniciativas que ofrecen alternativas en las cuales se avanza en reconocerle una dualidad a la evaluación, ya que es tanto proceso como resultado (Escobar, 2007). Dicha situación permite un acompañamiento antes, durante y después del proyecto de investigación, para nuestro caso.

Al tomar decisiones antes, durante y después del diseño y de la aplicación de prácticas evaluativas es importante considerar las particularidades que otorgan los sujetos, lugares, procesos, objetos, momentos. Además, es necesario tener presente que no hay recetas únicas ni mágicas. Las Instituciones de Educación Superior, a través de sus grupos de investigación, leerán los contextos y las realidades para construir alternativas de evaluación, teniendo en cuenta los avances globales y las condiciones locales.

Discusión ¿cómo evaluar el impacto social de procesos, productos y proyectos de investigación?

El estudio del impacto social del conocimiento puede enfocarse en tres niveles de análisis: macro, cuando se lleva a cabo al nivel de país o de una cierta región; meso o intermedio cuando se lleva a cabo al nivel de departamento o municipio, y microsocial cuando se realiza al nivel de instituciones, grupos, minorías, etnias o comunidades específicas. Cada uno de estos niveles puede presentar diversas dimensiones e intereses para la medición y caracterización de las variables, indicadores y procesos considerados, por lo cual se requieren metodologías específicas para cada nivel con el propósito de acercarse a una medición más objetiva, dada su singularidad (Albornoz et al., 2005). Es decir, es necesario considerar la particularidad de los contextos, los territorios, las instituciones de Educación Superior, entre otros aspectos.

Villaveces, Orozco, Olaya, Chavarro & Suárez (2005) también establecen los mismos niveles de análisis, y consideran que el nivel micro de análisis está centrado sobre el grupo de investigación y sus productos, pero que los efectos sociales se logran por la acción de varios grupos y de muchos proyectos. Por otra parte, Albornoz et al. (2005) indican que:

Además, a fin de analizar con mayor detalle los encadenamientos sociales que producen fenómenos de impacto es necesario seleccionar ámbitos de interacción acotados, centrando la atención sobre su vinculación con los problemas sociales. Tres tipos de estudios se corresponden con este enfoque: los estudios de usuarios de conocimiento científico en el campo del desarrollo local, los análisis de estructuras de intermediación con relación a las políticas sociales, y los estudios de caso.

Una alternativa para considerar: la evaluación auténtica

Una respuesta al cómo se concreta la evaluación auténtica se encuentra en las varias alternativas que ofrecen algunos aportes de Scriven (1975) quien propone una lista de control de indicadores que reflejan "su concepto de que la evaluación supone múltiples dimensiones, debe emplear múltiples perspectivas, introducir múltiples niveles de valoración y utilizar múltiples métodos" (348-351). Formula dieciocho aspectos para considerar una evaluación, entendida como investigación evaluativa, que contribuya con procesos de mejoramiento.

Los aspectos centrales de su propuesta son: una descripción del proceso integral de evaluación, asimismo del sujeto -para nuestro caso, investigadores (estudiantes, docentes, administrativos)-, grupos de investigación, programas, facultades, así como la institución de Educación Superior en general. También considera los antecedentes y contexto lo que incluye la identificación de las fuentes de financiación, habilidades, experiencias previas, la tecnología y las consideraciones sobre la flexibilidad en los procesos mismos de evaluación. Para la propuesta de la Corporación Universitaria Lasallista están asociados los indicadores de los capitales humano, estructural y relacional, aspectos centrales al considerar el capital intelectual institucional asociado a procesos y productos de investigación teniendo en cuenta beneficiarios internos y externos. Como aspecto a resaltar en la propuesta de Evaluación de impacto Social Auténtica se ha de diseñar un sistema de difusión y apropiación social de conocimiento con respaldo en los productos de investigación. ¿Cómo llegan al medio académico, económico, social, entre otros, los resultados y productos de la investigación? ¿Cómo se mantienen vigentes y/o en servicio? ¿Cómo se perfecciona o se actualiza según tiempos, lugares y sujetos? ¿Cómo son sus beneficiarios internos y externos? ¿Cómo se lleva a cabo su realización, control y mantenimiento? ¿Quién hace todo esto? Todo ello desde consideraciones éticas. Este proceso cobra sentido en tanto se realicen procesos de meta-evaluación, es decir, evaluar la evaluación de impacto social. Estos resultados deben ser utilizados formativamente pero también pueden ser incorporados al informe y socializados con otras audiencias para resaltar lecciones aprendidas y retos metodológicos.

Los componentes mencionados dan cuenta de aspectos a considerar en una metodología de evaluación del impacto social y llevan a plantear un gran interrogante: ¿cómo se adaptaría para evaluar el impacto social de proyectos, productos y procesos de investigación, si se desea una evaluación auténtica? Según los planteamientos de Ahumada (2005), buscando interrogar las realidades a la luz de los proyectos de educación, con transparencia y responsabilidad.

Una oportunidad integradora de adaptación en la búsqueda de técnicas e instrumentos de evaluación: rúbricas o matrices

En primer lugar, al buscar una técnica o un instrumento de evaluación que permita incluir procesos y resultados tanto cuantitativos como cualitativos, el camino no es fácil y son escasas las alternativas. Se requiere flexibilidad de pensamiento y claridad sobre las condiciones iniciales de cada grupo e investigador.

En segundo lugar, al ampliar la mirada hacia procesos de evaluación de impacto, se encontró una opción con las rúbricas o matrices de evaluación, especialmente en el contexto de Evaluación Auténtica3. Lo anterior en pro de responder a

El desafío de esta última década en relación con la calidad de la evaluación en Educación Superior está en la necesidad de impregnar la evaluación de realismo, conseguir evaluar el aprendizaje de los estudiantes universitarios a través de tareas profesionales auténticas correlativas o próximas al practicum (Álvarez, 2008, 253-272)

Pero ¿qué es una matriz rúbrica? Para mayor comprensión se entiende como una guía de puntuación, tabla de doble entrada, usada en evaluación y en ella se describen las características específicas de un producto, proyecto o tarea en varios niveles de rendimiento, con el fin de clarificar lo que se espera del trabajo, de valorar su ejecución y de facilitar realimentación (Gobierno de Canarias, s. f.).

Además, se resalta que:

La rúbrica es una opción viable para otorgar criterios evaluativos cuantitativos, cualitativos o mixtos, que permitan conocer el desempeño durante el desarrollo de un proyecto, a lo largo de un curso, en temas o actividades de carácter complejo, durante la resolución de problemas o en términos de la determinación de evidencias de aprendizaje. De esta forma la rúbrica se convierte en la guía necesaria para fomentar el aprendizaje por su carácter retro alimentador (López Carrasco, 2007).

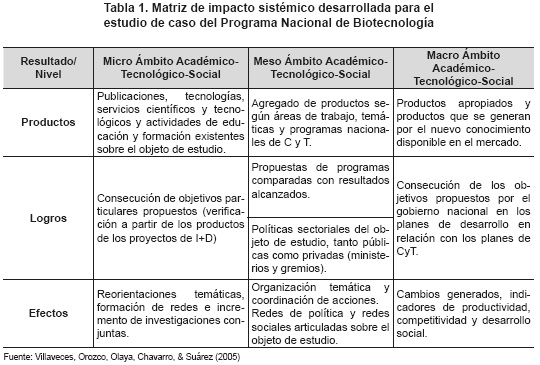

Esta alternativa es coherente con los objetivos de la Educación Superior, con las competencias investigativas y con la intencionalidad de la evaluación: mejorar desde la singularidad y la excelencia. En este sentido se presenta, en la tabla 1, el caso de la matriz de impacto sistémico desarrollada por Villaveces et al., para medir el impacto alcanzado en el estudio de caso del Programa Nacional de Biotecnología. Esta matriz fue definida por los autores como:

Un instrumento que permite organizar y estructurar la información obtenida del objeto de estudio, de forma tal que se pueda evidenciar la producción en ciencia y tecnología, la producción en biotecnología, las políticas y regulaciones y la intervención de éstas en la aparición de efectos como la articulación de redes, las reorientaciones temáticas y los cambios en otra serie de indicadores (2005, 136).

La matriz fue construida bajo la valoración de niveles micro, intermedio y macro, cruzada con productos, logros y efectos, considerando que en la diagonal es donde se evidencian los impactos.

Como había sido señalado con anterioridad, las rúbricas forman parte de la denominada evaluación auténtica. Se trata de una forma de valoración en la que los sujetos llevan a cabo actividades del "mundo real" para dar a conocer aplicaciones significativas de sus conocimientos y habilidades, ofreciendo a otros sujetos (profesores, padres, entre otros) compañeros y comunidad en general "evidencias" de su desempeño y su comprensión (Muller, 2003).

A partir de estos elementos aumenta la comprensión de las razones que permiten afirmar que "a la rúbrica se le considera como una herramienta de evaluación formativa que hace parte integral del proceso de aprendizaje desde una perspectiva socio-constructivista" (López, 2007). Es necesario resaltar que un aporte significativo de este proyecto se deriva de las matrices rúbrica construidas de manera dialogada y colaborativa, fruto de acuerdo que

Ofrece una evaluación detallada de qué indicador o criterio ha superado cada alumno o alumna y en qué grado, con lo que permite ser una herramienta tanto evaluativa como de aprendizaje. Es una herramienta que permite al alumnado conocer lo que se espera de él en cada tarea actividad y en qué grado (Gobierno de Canarias, s. f.).

Para el diseño, la utilización y la evaluación de las rúbricas es necesario un trabajo multidisciplinar. Lo anterior ya que:

A partir de que se han aceptado nuevas formas de aprender, hoy día se reconoce lo que se ha denominado como la "sabiduría de la práctica", en la que los estudiantes se conviertan en aprendices activos que comprenden materias complejas, preparados para la transferencia a problemas y escenarios nuevos y reales (National Research Council, 2000)

Igual situación aplica para los docentes y administrativos que se dedican a procesos de investigación.

Conclusión

Asumir que la evaluación es un proceso sistemático, permanente y continuo que desde su función formativa y formadora dinamiza los procesos investigativos, la reflexión crítica sobre los mismos y la toma de decisiones institucionales, en clave de compromiso y responsabilidad frente a los procesos de apropiación social del conocimiento, implica considerar que:

Como punto de partida se debe identificar la finalidad de la evaluación, es decir, su intencionalidad en coherencia con el Proyecto Educativo Institucional -PEI-, con los planes de desarrollo del nivel local, del departamental y del nacional, así como con las tendencias mundiales en Educación Superior de calidad.

Luego, es necesario conocer y comprender las funciones de la evaluación, entendidas más allá de la calificación o medición, ya que buscan acompañar y ofrecer información que permita orientar la toma de decisiones en diferentes estamentos comprometidos con la investigación y su impacto social. Asimismo, se ha de reflexionar acerca de la pertinencia en la formulación, diseño y aplicación de estrategias, técnicas e instrumentos de evaluación de impacto social, especialmente al cuestionar su contribución al avance hacia prácticas investigativas auténticas.

Considerar la ética y la responsabilidad social en las prácticas evaluativas de impacto social de los proyectos y productos de investigación en coherencia con los propósitos de la Educación Superior y de la universidad, requiere de un alto nivel de compromiso político, especialmente en un país con los altos niveles de inequidad.

En las instituciones de Educación Superior, el diseño y aplicación de metodologías para la evaluación del impacto social de los proyectos, procesos y productos de investigación ha de ser fruto de un trabajo en comunidades académicas de docentes y estudiantes universitarios, investigadores y administrativos, y de la reflexión acerca de prácticas evaluativas colaborativas que han sido sistematizadas como un proceso permanente, que da cuenta del compromiso y responsabilidad social de las universidades y de su coherencia con estrategias para la apropiación social del conocimiento.

Los aspectos anteriores coinciden con la invitación de Albornoz et al., en el sentido de que:

Desde el punto de vista metodológico, la noción de impacto social de la ciencia y la tecnología es requerida, tanto como una preceptiva a seguir para la anticipación de resultados sociales -positivos y negativos- a la hora de tomar decisiones de política, tales como la decisión de financiar proyectos de I+D, como bajo la forma de un conjunto de indicadores que puedan dar cuenta, a nivel "macro", de los resultados globales de ciertas políticas en términos de su utilidad social (2005)

Para transformar la evaluación de impacto se requiere que el pensamiento, la actualización y la reflexión docente se transformen, es decir, los cambios en las prácticas evaluativas universitarias, especialmente en investigación, serán posibles solo cuando los evaluadores se cualifiquen y amplíen la comprensión acerca de las múltiples funciones que ellas pueden cumplir. Para realizar evaluaciones de impacto social auténticas, se requiere un alto compromiso institucional y personal.

Los procesos de evaluación auténtica de impacto social son centrales al analizar alternativas para la transformación en la universidad, ya que una vez que estas se examinan emergen aspectos centrales relacionados con los contenidos, las prácticas, las políticas públicas, los reglamentos, entre otros tantos, y es por ello que la utilización de tecnologías de información y comunicación - TIC- mediante el uso de software especializado es útil tanto para la recolección como para el procesamiento, interpretación y valoración de información. Todo esto, orientado a la toma de decisiones institucionales relacionadas con procesos de mantenimiento y mejoramiento de los sistemas de investigación institucionales, sus grupos e investigadores en estrecho compromiso con las comunidades académicas y la ciudadanía en general.

Por último, se requiere dar atención a las problemáticas sociales, mediante el diseño, ejecución y evaluación de las acciones de los grupos de investigación que generan, transfieren y utilizan conocimientos científicos y tecnológicos mediante una auténtica valoración social de los procesos, proyectos y productos de investigación.

Notas

1 Este material es producto de la construcción de antecedentes de la investigación Generación de una metodología para la evaluación del impacto social de los proyectos y productos de investigación científica y tecnológica de la Corporación Universitaria Lasallista, fases I y II, desarrollada entre 2012 y 2015 por un equipo multidisciplinario de la institución, apoyados en revisión documental.

2 Colciencias, considera para los proyectos e informes los siguientes impactos que deben ir acompañados de una descripción y de una proyección de los mismos: Científicos, tecnológicos o de innovación del proyecto o programa estratégico Considere entre otros, los siguientes criterios: formación de recursos humanos en nuevas tecnologías, registro y homologación de patentes o software, certificado de obtentor de variedades vegetales, licenciamiento de tecnologías, registro y documentación técnica del Know-How. Económicos: productividad y competitividad Considere entre otros, los siguientes criterios: acceso a nuevos mercados nacionales o internacionales, empleo generado, establecimiento de alianzas estratégicas (I+D+I conjunta con empresas e instituciones de al menos otro país, Joint Ventures, franquicias, otros, mejoramiento de la productividad y la calidad, mejoramiento del clima organizacional, regiones y comunidades beneficiadas por el proyecto, desarrollo tecnológico de proveedores. Impactos sobre el medio ambiente y la sociedad. Considere entre otros, los siguientes criterios: reducción en el consumo de energía y agua, reducción en el consumo de recursos naturales, reducción en la generación de emisiones, vertimientos y residuos sólidos, mejoramiento de la calidad del medio ambiente, eliminación o reducción de riesgos para la salud humana, aprovechamiento sostenible de nuevos recursos naturales. Impactos en la economía nacional y/o regional. Considere entre otros, los siguientes criterios: creación de nuevos sectores económicos en la estructura nacional y/o regional, sustitución de materiales e insumos, generación de exportaciones. Tomado de www.colciencias.gov.co. Consultado junio 17 de 2015.

3 Se denomina así la evaluación que es capaz de otorgar más importancia al trabajo autónomo del estudiante, apoyado en el uso intencionado de metodologías activas que permiten no sólo un acompañamiento integral por parte del docente, sino que promueve procesos de autoevaluación de los desempeños del estudiantes considerando las actividades propuestas ( Escobar, 2011).

Referencias bibliográficas

Ahumada, P. (2005). Hacia una evaluación auténtica del aprendizaje. México: Paidós. [ Links ]

Albornoz, M. (2001). Política científica y tecnológica: una visión desde América Latina. CTS+ I: Revista Iberoamericana de Ciencia, Tecnología, Sociedad e Innovación, (1). Recuperado de: http://www.oei.es/revistactsi/numero1/albornoz.htm. [ Links ]

Albornoz, M.; Estébanez, M. E. & Alfaraz, C. (2005). Alcances y limitaciones de la noción de impacto social de la ciencia y la tecnología. Revista Iberoamericana de Ciencia Tecnología y Sociedad, 2 (4), 73-95. [ Links ]

Álvarez, I. (2008). Evaluación del aprendizaje en la universidad: una mirada retrospectiva y prospectiva de la divulgación científica. Revista Electrónica de Investigación Psicoeducativa, 6 (14), 235-271. [ Links ]

Arends, R. (2004). Learning to teach. 6th Ed. Boston: Mc GrawHill. [ Links ]

Bianco, C.; Lugones, G.; Peirano, F. & Salazar, M. (2002). Indicadores de la sociedad del conocimiento e indicadores de innovación: vinculaciones e implicancias conceptuales y metodológicas. [En línea] Recuperado de http://www.littec.ungs.edu.ar/eventos/UNGS2Lugones%20et.al.pdf. [ Links ]

Biggs, J. (2005). El profesorado de educación superior: formación para la excelencia. Madrid: Narcea. [ Links ]

Bretones, A. (2008). Participación del alumnado de Educación Superior en su evaluación. Revista de Educación (347), 181-202. [ Links ]

Cabra, F. (2008). Evaluación en Educación Superior. Bogotá: Universidad Javeriana. [ Links ]

Colombia. Congreso de la República. (1992). Ley 30 del 28 de diciembre de 1992 por la cual se organiza el servicio público de la Educación Superior. Bogotá: Diario Oficial N.° 40700. [ Links ]

Colombia. Congreso de la República. (1994). Ley 115 de febrero 8 de 1994 por la cual se expide la ley general de educación. Bogotá: Diario Oficial N.° 41214. [ Links ]

Delors, J. (1997). La educación encierra un tesoro: informe de la Comisión Internacional para el Desarrollo de la Educación. Madrid: Unesco-Alianza Editorial. [ Links ]

Díaz Barriga, F. (2006). Enseñanza situada: vínculo entre la escuela y la vida. México: McGraw Hill. [ Links ]

Escobar, J. (2007). Evaluación de aprendizajes: un asunto vital en la educación superior. Revista Lasallista de Investigación, 4 (2), 50-58. [ Links ]

Escobar, J. (2011). Propuesta de evaluación de aprendizajes en Educación Superior POPE. Tesis doctoral. Universidad de Antioquia. [ Links ]

Escorcia Caballero, R. E.; Gutiérrez Moreno, A. V. & Henríquez Algarín, H. (2007). La Educación Superior frente a las tendencias sociales del contexto. Educación y Educadores, 10 (1), 63-77. [ Links ]

Gobierno de Canarias. (s. f.). Anexo I. Algunos de los recursos didácticos para las CCMC. [En línea] Recuperado de: http://www3.gobiernodecanarias.org/aciisi/cienciasmc/web/anexos/30_rubricas.html. [ Links ]

González, M. (1998). La evaluación de aprendizajes en Educación Superior. La Habana: Centro de Estudio para el Perfeccionamiento de la Educación Superior, CEPES. [ Links ]

Grundy, S. (1998). Producto o praxis del currículum. 3.ª ed. Madrid: Morata. [ Links ]

Houssay, B. (1941). Función social de la Universidad: dedicado a la Universidad Nacional de Cuyo. Mendoza: Editorial Mendoza. [ Links ]

Hincapié Noreña, C. A. (2009). Gestión del conocimiento, capital intelectual y comunicación en grupos de investigación. Revista Virtual Universidad Católica del Norte, (27), 1-25. [ Links ]

López Carrasco, M. A. (2007). Guía básica para la elaboración de rúbricas. [En línea] Recuperado de: http://www.orientacionandujar.es/wpcontent/uploads/2014/05/guiabasicaelaborarubrica1.pdf. [ Links ]

Maldonado, L. et al. (2007). Visibilidad y formación en investigación: estrategias para el desarrollo de competencias investigativas. Revista Studiositas, 2 (2), 43 - 56. [ Links ]

National Research Council (2000). How people learn. Brain, mind, experience and school. Washington: National Academy Press. [ Links ]

Rychen, D. S. & Salganik, L. H. (2003). Key Competencies for a successful life and a wellfunctioning society. Göttingen: Hogrefe & Huber. [ Links ]

Scriven, M. (1967). The methodology of evaluation. Perspectives on Curriculum Evaluation (1). [ Links ]

Scriven, M. (1975). Evaluation bias and its control. Journal of Multidisciplinary Evaluation, 7 (15), 79 - 98. Recuperado de: http://journals.sfu.ca/jmde/index.php/jmde_1/article/viewFile/299/294. [ Links ]

Stufflebeam, D. & Shinkfield, A. (1985). Evaluación sistemática: guía teórica y práctica. Barcelona: Paidós. [ Links ]

Tenbrink, T. D. (1988). Evaluación: guía práctica para profesores. Madrid: Narcea. [ Links ]

Villaveces, J. L.; Orozco, L. A.; Olaya, D. L.; Chavarro, D. & Suárez, E. (2005). ¿Cómo medir el impacto de las políticas de ciencia y tecnología? Revista iberoamericana de ciencia tecnología y sociedad, 2(4), 125-146. [ Links ]