Introducción

La incorporación de la tecnología a la investigación en psicología y ciencias del comportamiento ha traído como consecuencia la adaptación de los instrumentos y métodos a versiones computacionales e instrumentos tecnológicos avanzados (Millsap, 2000; Piper et al., 2015). En psicología esto ha significado por ejemplo, establecer nuevas formas de psicoterapia (Richards, 2013), realización de experimentos e investigaciones on-line (Garaizar, Vadillo, López-de-Ipiña y Matute, 2012), aplicación de pruebas psicométricas para selección de personal en versiones on-line (Joubert y Kriek, 2009) e incluso intentar mejorar el desempeño cognitivo mediante “entrenamiento asistido por computador” (Lampit, Hallock y Valenzuela, 2014; Prada Sarmiento, Pineda Garzón, Mejía Orduz y Conde Cotés, 2010; Toril, Reales, Mayas y Ballesteros, 2016; Vianin, 2016). En el campo de la psicometría las pruebas computarizadas (o informatizadas) (Olea, Abad y Barrada, 2010) permitieron un avance importante en el desarrollo de nuevas pruebas y tareas, mejoramiento en la velocidad de aplicación, el aumento de la información recolectada, la puntuación inmediata, la seguridad, la cobertura y el control de fuentes de error con respecto a las tradicionales aplicaciones de lápiz y papel (Bugbee, 1996; Jeong, 2014; Joubert y Kriek, 2009). Así mismo, ha habido un esfuerzo para mantener estándares de validez y confiabilidad de las pruebas psicológicass y psicométricas, también importantes avances por adaptar, validar y normalizar las pruebas en sus diferentes versiones (Ison y Carrada, 2010; Leal-Soto & Alonso-Tapia, 2017).

Como un ejemplo de lo anterior, se ha mostrado que algunas pruebas en formato de lápiz y papel no logran medir adecuadamente los tiempos de reacción o sutiles habilidades de desempeño motor a comparación de las pruebas y simulaciones computarizadas (Bieri et al., 2014). Este tipo de cuestionamientos sugiere indagar por las características de validez de las pruebas bajo diferentes formatos. Además, no en vano se encuentra que a la fecha son cientos las pruebas que han sido construidas en versiones informatizadas, dentro de varias razones metodológicas también se encuentran razones de facilidad en su uso, acceso abierto, replicabilidad de las investigaciones y limitaciones en el acceso a las mismas pruebas pero en formato de lápiz y papel y a nivel comercial (Mueller y Piper, 2014; Open Science Collaboration, 2012, 2015; Piper, Mueller, Talebzadeh y Ki, 2016; Reips, 2001). A este esfuerzo por mejorar la aplicación de las pruebas, también se ha generado el concepto de Psicología 2.0 para denotar todas aquellas herramientas que adoptan la tecnología y actualizan sus procedimientos e instrumentos, así como el abordaje de cantidades de datos en la era de los grandes volúmenes de datos (big data) (Armayones Ruiz et al., 2015; Markowetz, Błaszkiewicz, Montag, Switala y Schlaepfer, 2014).

Una de las preguntas clave con respecto a esta implementación es si existe una equivalencia entre las pruebas en versión de lápiz y papel e informatizadas (Bugbee, 1996; Noyes y Garland, 2008; Olea, Revuelta, Ximénez y Abad, 2000). Se han reportado estudios que identifican la necesidad de evaluación de esta caraterística de equivalencia, desde pruebas de personalidad hasta pruebas de habilidad o destreza (Baumer, Roded y Gafni, 2009; Collerton et al., 2007; Holländare, Andersson y Engström, 2010). En algunos de estos estudios se ha encontrado una diferencia en la puntuación de los test que ha sido atribuída a los aspectos formales de la presentación (es decir, las instrucciones, la acción a realizar durante la prueba, la solución de inquietudes o componentes gráficos y visuales) (Baumer et al., 2009; Noyes y Garland, 2008) o aspectos relacionados con la familiaridad tecnológica de los sujetos (Baumer et al., 2009; Joubert y Kriek, 2009). Sin embargo, no todas las comparaciones resultan con puntuaciones diferentes, por ejemplo, algunas pruebas de medición de conocimiento o habilidades comunicativas muestran equivalencia a lo largo de comparar diferentes individuos por grados escolares de secundaria y universitarios (Baumer et al., 2009; Millsap, 2000; Vallejo, Jordán, Díaz, Comeche y Ortega, 2007; Wang, Jiao, Young, Brooks y Olson, 2007). Incluso existen reportes de la medición de características cognitivas en adultos mayores que podrían ser más sensibles que las realizadas en formatos tradicionales (Bieri et al., 2014; Collerton et al., 2007; Mead y Drasgow, 1993).

Uno de los principales problemas de la equivalencia se ha relacionado con que el proceso (cogntivo o motor) que el individuo realiza para la solución o respuesta de la prueba difiere entre las versiones, por lo que pruebas incluso con una gran similitud podrían no tener una equivalencia psicométrica (Lozzia et al., 2009; Noyes y Garland, 2008). Una explicación tentativa es suponer que las dos versiones requieren de procesos o funciones diferentes a las que estarían involucradas en cada modalidad, por lo que la comparación de la prueba per se no es posible, antes de determinar la validez de cada versión (Muñiz, Hernández y Ponsoda, 2015).

En el campo de la neuropsicología, la evaluación de las características psicométricas de las pruebas, indican que existen variables de los instrumentos que requieren ser evaluadas, antes de suponer su funcionamiento estandarizado (García et al., 2018). Esto sumado a la tendencia a aumentar el uso de las pruebas informatizadas debido a las ventajas relacionadas con la adaptación de ítems a diferentes condiciones y grupos de edad, medición de tiempos en escala más precisas, calificación automática y la versatilidad en la aplicación de múltiples pruebas de forma sencilla en un solo ordenador (Collerton et al., 2007; Hurtado-Parrado et al., 2016; Montoya-Arenas, Trujillo-Orrego y Pineda-Salazar, 2010; Ployhart, Weekley, Holtz y Kemp, 2003). Adicional a estas ventajas, algunos estudios han planteado que este tipo de implementaciones estan relacionadas con favorecer y facilitar los estudios longitudinales, disminuyendo la deserción y aumentando la accesibilidad (Collerton et al., 2007). También se han planteado resultados importantes evaluando la predicción de pruebas en desempeños cognitivos con resultados positivos (Ployhart et al., 2003). Uno de los resultados del uso de imágenes cerebrales en pacientes que están desarrollando pruebas neuropsicológicas es el establecimiento de estructuras cerebrales implicadas durante la realización de las tareas (Alvarez & Emory, 2006; Johnson, Saykin, Flashman, McAllister y Sparling, 2001; Moll, Oliveira-Souza, Moll, Bramati y Andreiuolo, 2002; Rubia et al., 2001; Zakzanis, Mraz y Graham, 2005). Ahora bien, la aplicación de dos modalidades de la misma prueba puede responder a estructuras diferentes por lo que la evaluación de las modalidades podría considerarse una forma de validación de los constructos.

Así, se ha señalado que la equivalencia de dos pruebas esta dada por el cumplimiento de condiciones como la fiabilidad comparable de las pruebas; correlación entre los estimados de fiabilidad, correlación con otros test y subpruebas o criterios externos y medidas de tendencia central y dispersión similares (Joubert y Kriek, 2009). Con base en lo anterior los objetivos de este artículo fueron: 1) Comparar el desempeño de los individuos en las pruebas de funciones ejecutivas en las modalidades de lápiz y papel e informatizadas; 2) Es establecer la equivalencia por medio de las correlaciones entre las pruebas aplicadas.

Método

Participantes

Participaron 41 estudiantes jóvenes (edad M = 17.95; sd = 0.86) de pregrado de psicología de la Pontificia Universidad Javeriana, Bogotá, Colombia. Fueron seleccionados por conveniencia e invitados por correo electrónico. Los sujetos no recibieron remuneración por la participación en el estudio, se controló que no conocieran las pruebas ni que tuvieran formación en áreas de psicometría.

Instrumentos

Pruebas neuropsicológicas

Para la evaluación de la función de atención y velocidad de procesamiento se usó del test d2 (Brickenkamp y Zillmer, 2002), el cual permitió medir la velocidad de procesamiento de estímulos visuales en una tarea de cancelación de ítems y ofreció una medida de la capacidad de concentración del sujeto. La prueba consitió en tachar las letras “d” con 2 líneas a su alrededor en una hoja llena de elementos distractores. Se reportó la efectividad total en la prueba y el índice de concentración indicado como una medida de la atención (Budde, Voelcker-Rehage, Pietraßyk-Kendziorra, Ribeiro y Tidow, 2008; Jiménez et al., 2012). Para la versión informatizada se utilizó una versión de la prueba programada en el software SuperLab (Cedrus, Inc., Versión 4.5).

La memoria de trabajo fue evaluada por la subprueba de Dígitos del Wechsler Adults Intelligence Scale (wais) en su versión iv, la cual, a partir de la repetición de ítems en orden directo, inverso y en secuencia evaluó la atención y la memoria de trabajo verbal (Pisoni y Cleary, 2003; Rosenthal, Riccio, Gsanger y Jarratt, 2006; Wechsler, 1997). Para evaluar memoria de trabajo visual se utilizó la subprueba de localización espacial del Wechsler Memory Scale (wms) en su versión iii, que es una prueba equivalente a la versión visual de la prueba de dígitos del wais (Ardila, Rosselli y Strumwasser, 2009; Millis, Malina, Bowers y Ricker, 2010). Finalmente se aplicó la subprueba Números y Letras en el que se le pide a los sujetos ordenar números y letras según la instrucción que han sido presentados en orden, se piden en forma directa o inversa para evaluar memoria de trabajo verbal (Cadavid-Ruiz, Del Rio, Egido y Galindo, 2016; Cadavid y Del Rio, 2012). Las pruebas informatizadas para esta función fueron programadas en el software SuperLab (Cedrus, Inc, Versión 4.5) siguiendo la misma distribución de tareas que la versión en físico.

Para la función de planificación se usó el test Tower of London (ToL) en el cual los sujetos tenían que planear en orden el movimiento de unos anillos de colores para completar un patrón, se midió la cantidad de movimientos y el tiempo promedio de ejecución (Dockery, Hueckel-Weng, Birbaumer y Plewnia, 2009; Piper et al., 2015). En la versión en papel y lápiz se utilizó la prueba de las Anillas realizada por Portellano, Díez y García (2007). Para la versión informatizada se utilizó el test automatizado del software de The Psychology Experiment Building Language (pebl) (Mueller y Piper, 2014; Piper et al., 2012, 2015).

Para la evaluación de la función de rotación mental y habilidades visuoconstructivas se usó la subprueba de “Cubos” del Wechsler Adults Intelligence Scale (wais) (Wechsler, 1997); que estuvo compuesta por nueve cubos de madera pintados de color rojo y blanco (dos caras rojas, dos caras blancas y dos caras divididas en diagonal, con una mitad roja y la otra blanca) y un cuadernillo con nueve diseños bidimensionales que el sujeto debía reproducir con los cubos. La prueba aumentó de complejidad a medida de su avance y evaluó variables de tiempo y ejecución (Rosas, 2013; Savage, 2016). Para la versión informatizada se utilizó una versión de la prueba programada en el software SuperLab (Cedrus, Inc., Versión 4.5.).

Para la evaluación del efecto de re-aplicación y el reaprendizaje se hizo uso de las pruebas de Cubos del wais iii, la prueba de Automatic Mirror Trace donde los sujetos debían realizar la forma de una estrella pero con información visual obtenida desde un espejo y por lo tanto de forma invertida (Cellini, 2016) y el Test de rapidez motora (Clavijas) donde se pidió a los sujetos que completaran tareas de destreza motora fina de forma unimanual y bimanual (Roy y Park, 2010).

Procedimiento

Se realizó una primera aplicación piloto a 5 estudiantes de pregrado de la Facultad de Psicología con el ánimo de evaluar la claridad de las instrucciones, la comprensión de las tareas y el tiempo de aplicación. Luego de este procedimiento se analizaron los resultados y se ajustaron los términos desconocidos y claridad en las aplicaciones. No se realizaron cambios sustanciales ni en la programación de las pruebas ni en las funciones evaluadas. Cada una de las pruebas computarizadas fue evaluada por un experto que emitió su concepto sobre la validez de las tareas.

Para la aplicación final, los participantes aceptaron y firmaron estar de acuerdo con la participación en el estudio el día 1 de aplicación de pruebas, se recolectaron algunos datos sociodemográficos. El orden de aplicación de la pruebas fue contrabalanceado (virtual y físico vs físico y virtual) entre los sujetos. Esta aplicación tuvo una duración promedio de una hora y cuarenta minutos entre las 7 am y 5 pm. Luego de una semana se realizó la aplicación de las mismas pruebas realizadas en la aplicación inicial pero en la modalidad contraria a la inicialmente realizada. Todos los procedimientos y protocolos fueron realizados cumpliendo con la Resolución 8430/1993 de la ley Colombiana y respetando los principios internacionales de Helsinki para la investigación en humanos. Los resultados fueron analizados mediante pruebas t para muestras relacionadas para cada una de las modalidades y las pruebas y una prueba de anova de una vía tomando como factor el orden de aplicación de las pruebas en spss.

Resultados

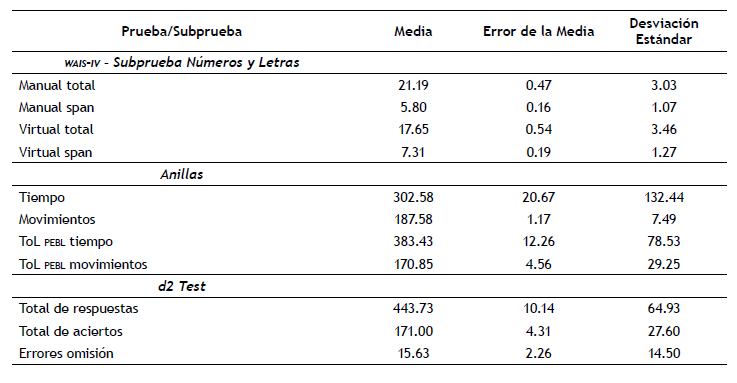

En la tabla 1 se reportan los valores medios y desviación estándar de las pruebas realizadas.

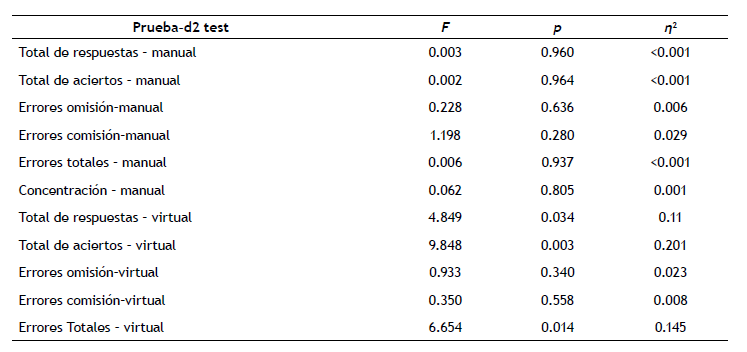

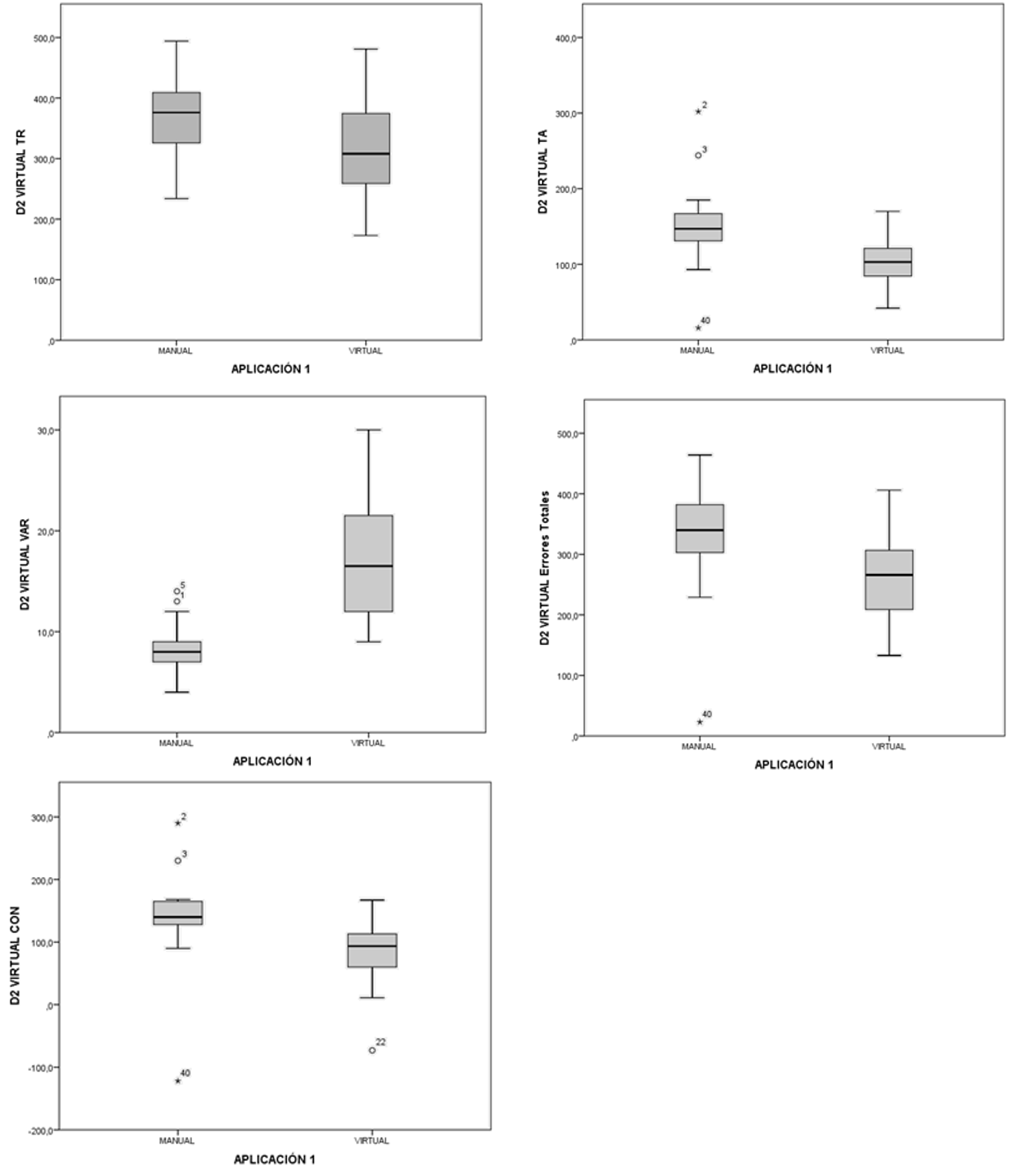

Atención

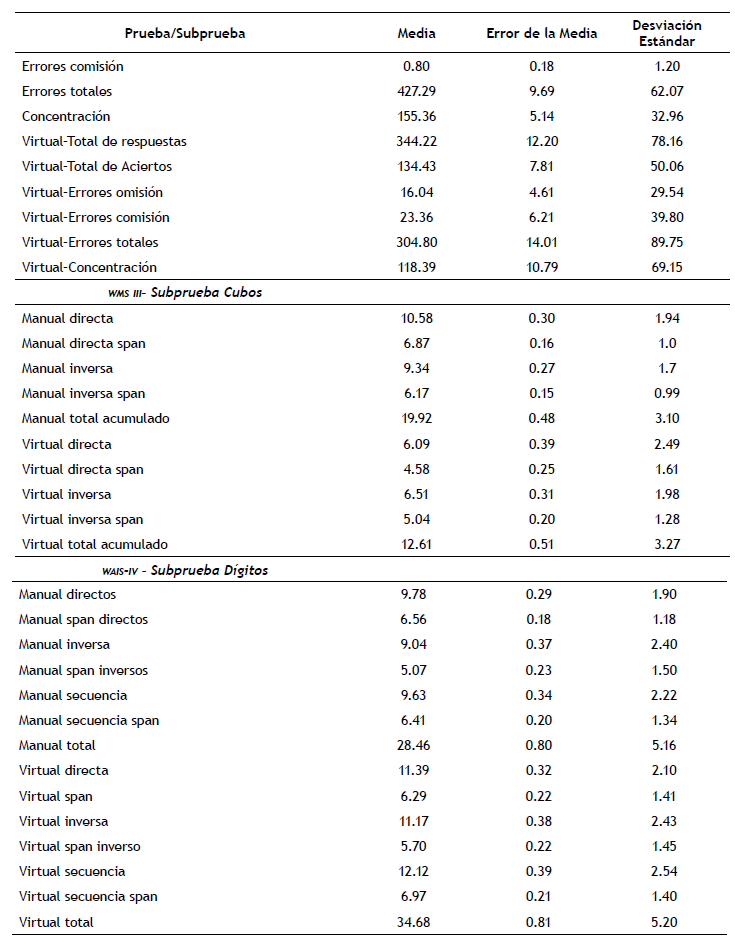

Para analizar la atención se utilizó la prueba d2 y la subprueba retención de dígitos. Se realizó un anova de un factor, siendo el factor el orden de aplicación de las pruebas en sus diferentes modalidades (físico vs informatizado). Las variables que mostraron ser afectadas por el orden de la aplicación fueron únicamente de la prueba d2 en su formato virtual, siendo las variables: total de respuestas (F (1, 40) = 4.849; p = 0.034; η2 = 0.11), total de aciertos (F (1, 40) = 9.848; p = 0.003; η2 = 0.201), total de errores (F (1,40) = 6.654; p = 0.01; η2 = 0.14), índice de concentración (F (1, 40) = 7.011; p = 0.01; η2 = 0.15) e índice de variación (F(1, 40) = 35.02; p < 0.001; η2 = 0.47) (ver tabla 2). En este caso se observó un mejor rendimiento en los participantes que tuvieron el orden de aplicación primero en la modalidad a lápiz y papel luego modalidad virtual, no se observa este fenómeno en individuos con el orden contrario (figura 1 y 3).

Tabla 2. Análisis de varianza para la prueba de atención (d2 test) comparando el tipo de aplicación manual versus virtual (grupo 1) y virtual versus manual (grupo 2).

Fuente: elaboración propia.

Fuente: elaboración propia

Figura 1. Diagramas de cajas y bigotes de variables que mostraron ser afectadas por el orden de la aplicación.

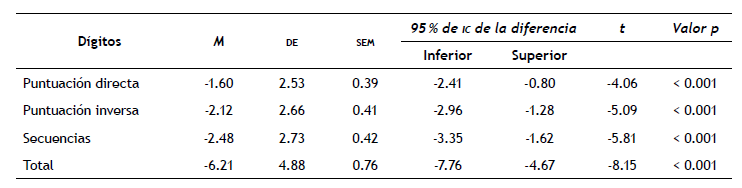

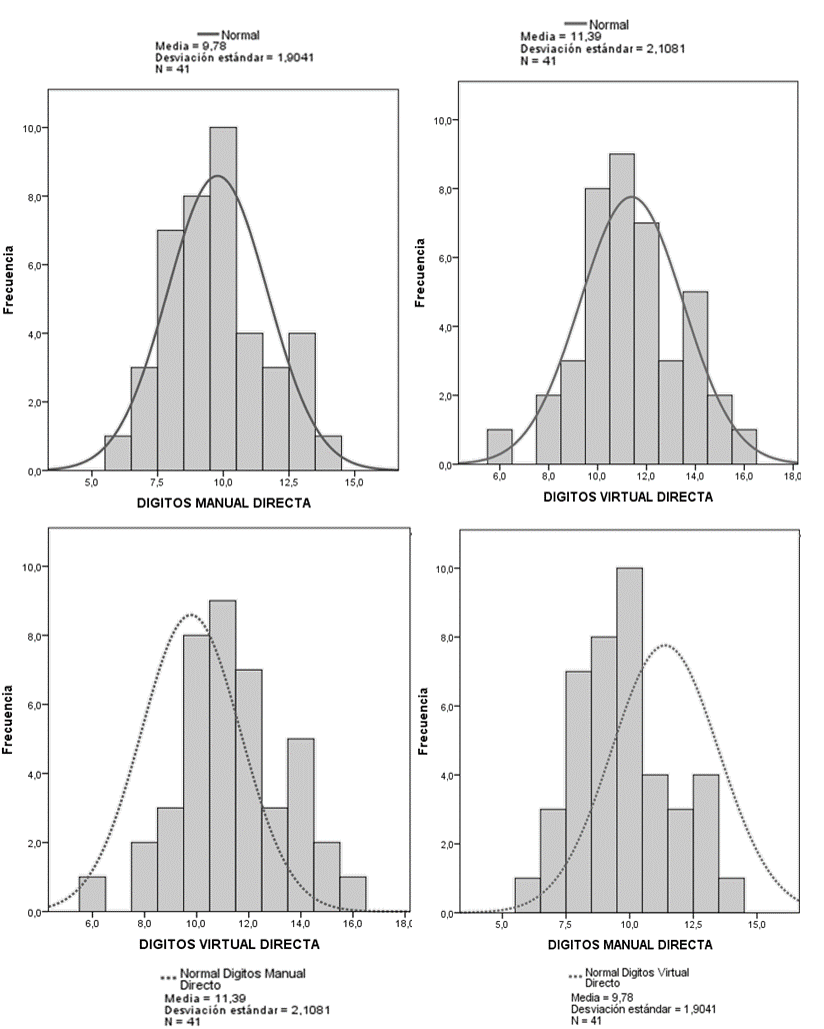

Así mismo, se realizó una prueba t para comparar las medias de las puntuaciones directas de la subprueba de dígitos. Se encontró que la puntuación directa tenía diferencias significativas, (t=-4.06; p < .01; ic 95 % [-2.41, -0.81]) (tabla 3). En cuanto a la variable de span atencional directo, el cual hace referencia a la cantidad de estímulos que lograron retener los sujetos, no presenta diferencia (t = 1.05; p = 0.298; ic 95 % [-0.24, 0.78] (tabla 3). Se presentó un aumento de errores en la modalidad manual pero una similitud en los alcances de las dos modalidades (figura 2).

Tabla 3. Diferencia entre los grupos en las aplicaciones de la prueba de dígitos mediante la prueba de diferencia de medias para muestras emparejadas

Fuente: elaboración propia.

Fuente: elaboración propia.

Figura 2. Histogramas de variables que mostraron diferencias significativas por la modalidad de aplicación.

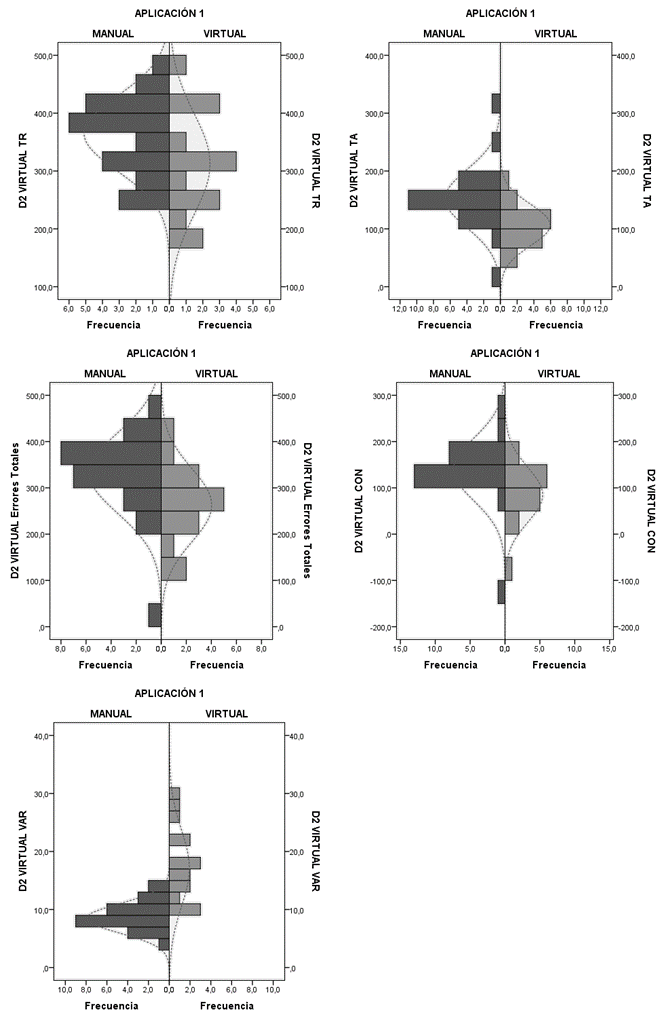

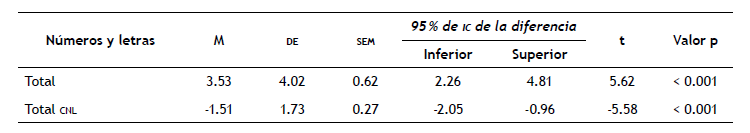

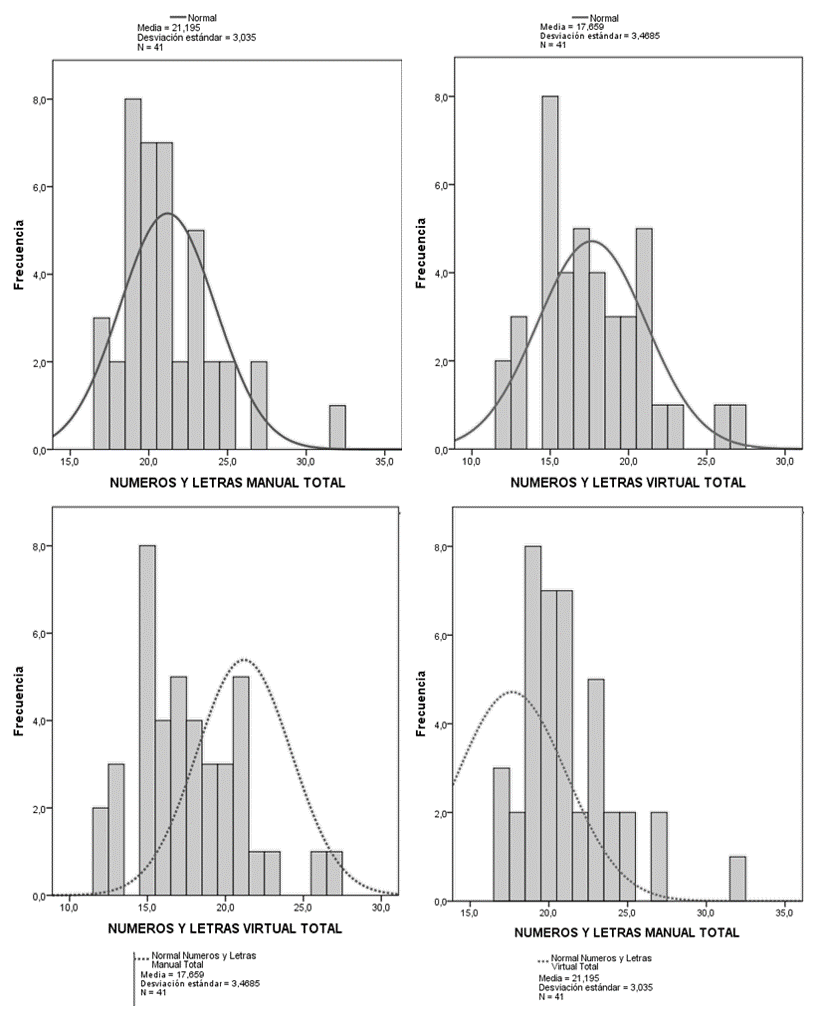

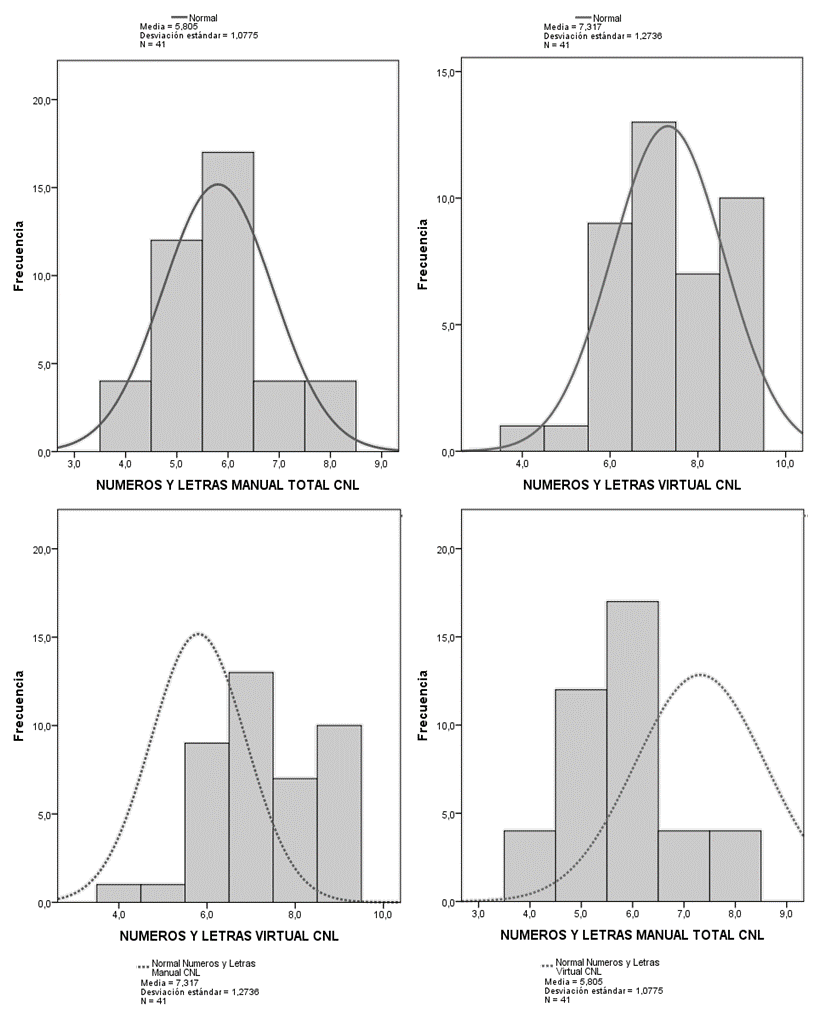

Memoria de trabajo

Para analizar la memoria de trabajo se utilizaron las subprueba de números y letras, retención de dígitos inversos, retención de dígitos en secuencia y localización espacial inversa. A continuación se presentan los datos que mostraron una diferencia significativa entre las aplicaciones. En cuanto al puntaje directo obtenido en la prueba números y letras, se encontró una diferencia entre las dos versiones en el puntaje directo (t =-5.585; p < 0.001; ic 95 % [-2.06, -0.96]), teniendo en la modalidad manual un promedio de 21.2, mientras que la modalidad informatizada el promedio fue de 17.2. Pese a esto, el span atencional fue mayor en el formato virtual (M = 7.32) con respecto a la versión en lápiz y papel (M = 5.8) (figura 4), lo que muestra en la modalidad virtual una mayor cantidad de estímulos que se pueden recordar, pero una mayor posibilidad de cometer un error en la prueba (tabla 4).

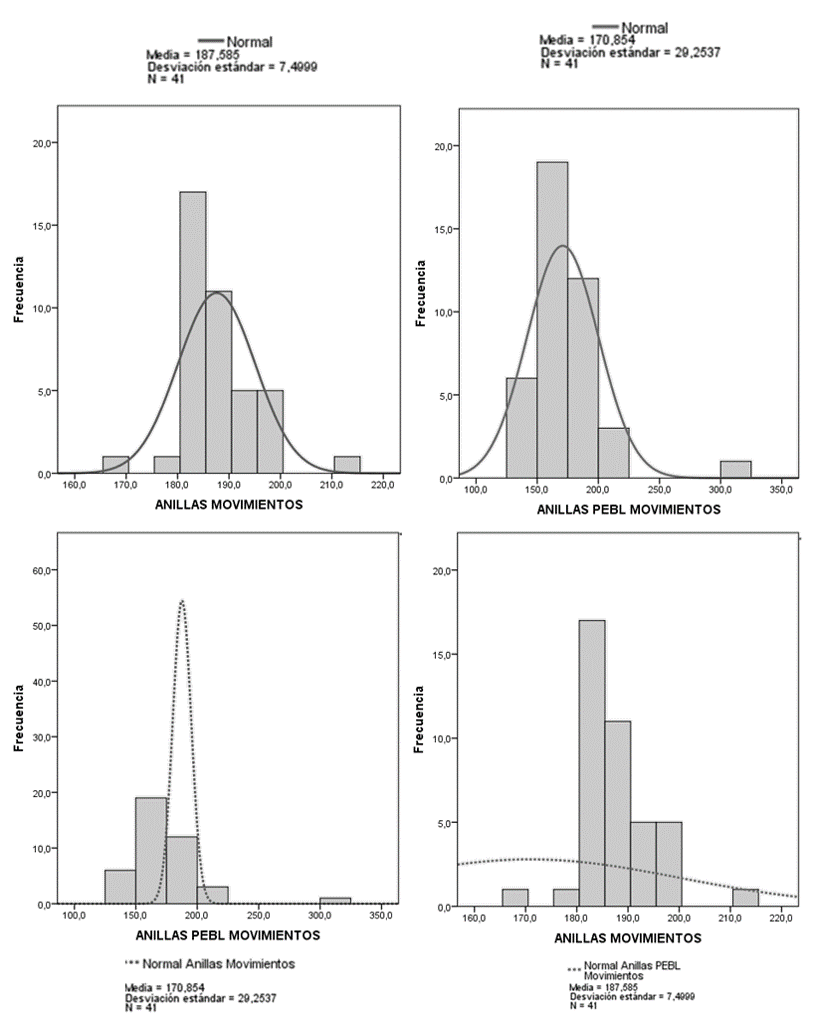

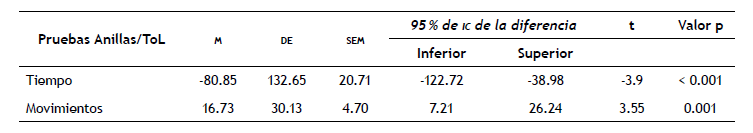

Planificación

Para evaluar la planificación se compararon las pruebas ToL en pebl y la prueba de anillas. El desempeño en el componente de “movimientos” se encontró cercano en las dos versiones y sin diferencia estadística (M(manual) = 187.58; pebl: M(informatizada) = 170.85). Sin embargo, las desviaciones estándar del componente manual y virtual (de (manual) = 7.5 y de (informatizada) = 29.25) muestran que la desviación estándar de la modalidad informatizada contiene 4 desviaciones estándar de la modalidad manual presentando una diferencia significativa (t= 3.55; p = 0.001; ic 95 % [7.22, 26.24]) (tabla 5 y figura 6).

Tabla 5. Prueba t para muestras relacionadas de la prueba anillas y su versión virtual en pebl.

Fuente: elaboración propia.

Fuente: elaboración propia.

Figura 4. Histogramas que muestran las diferencias entre los puntajes de la prueba números y letras.

Fuente: elaboración propia.

Figura 5. Histogramas que muestran las diferencias entre modalidades del Span atencional de la prueba números y letras.

Discusión

El objetivo principal de este estudio fue comparar las aplicaciones entre las pruebas neuropsicológicas en modalidad de lápiz y papel e informatizadas. Los resultados mostraron en general que a lo largo de las pruebas no es posible establecer un desempeño similar en la ejecución de las dos versiones, probablemente debido a factores externos que son implementados en las versiones informatizadas y que pueden servir de claves adicionales para la ejecución de las mismas (Sands, Waters y Mcbride, 1999). En cuanto a la aplicación en físico se han denominado algunas claves importantes que facilitan la la identificación de palabras clave por parte de los sujetos por variaciones en la entonación (Campos y Ameijide, 2014). En este mismo sentido, diferencias en cuanto al lugar de aplicación puede influir en la variación debido a la naturaleza misma de las pruebas y que se ha sustentado bajo estudios sobre ergonomía (Salmerón y Cañas, 2004).

En el caso de la atención medida en la prueba d2 se plantea que la influencia del tipo de tarea que se debe realizar en cada modalidad (tachar manualmente la letra en un papel o elegir una respuesta con el teclado en la versión informatizada) puede explicar las diferencias. Así, el hecho de tener un estímulo visual que se debe leer linealmente y convertir en respuesta motora (tachar o no tachar el estímulo) inhibiendo estímulos irrelevantes como primera aproximación a la tarea, puede facilitar el proceso de respuesta de la tarea virtual. Esto, debido a que en la modalidad informatizada se presenta un estímulo de manera aislada y se debe responder a este por medio de un teclado. La diferencia principal radica en que en la modalidad virtual no se deben inhibir los demás estímulos que están al lado y la instrucción se facilita en este aspecto, esto es coherente con los componentes de la atención expresados por Sohlberg y Mateer, (2001) ya que la atención focalizada se considera como un proceso mucho más básico y menos complejo que la selectiva, la cual sería necesaria para inhibir el estímulo relevante dentro de una lista larga.

En cuanto a la prueba de números y letras se presentó una diferencia en la puntuación directa según el orden de aplicación, en donde, aunque se evidenció un puntaje inferior en las pruebas virtuales, se encontró que estas contaban con un span atencional mayor; por lo que se plantea la posibilidad de que este cambio se deba a una mayor distractibilidad en el formato virtual al no tener una interacción personal con el evaluador. Esto, debido a que pese a cometer más errores en la ejecución virtual en algunos reactivos se lograba avanzar más recordando y ordenando una mayor cantidad de ítems. Esta característica podría indicarse como un costo de las pruebas informatizadas que previamente ha sido señalado (Baumer et al., 2009; Noyes y Garland, 2008). Seguido a esto, el span atencional en la modalidad informatizada podría haber sido mayor debido a que los elementos físicos de la prueba virtual, tales como el teclado, pueden brindar claves mnemotécnicas de aprendizaje que significa una ayuda en la tarea que involucra el span atencional como las ejemplificadas en los estudios de Campos y Ameijide (2014).

Basados en los resultados adquiridos en la comparación de la prueba de Anillas, se plantea que la versión informatizada de Anillas “ToL” (pebl) favorece la planeación, debido a que aumenta la cantidad de tiempo con una reducción significativa de movimientos (Piper et al., 2012, 2015). Así mismo, se plantea que el aumento en el tiempo se puede deber a una dificultad en la realización de dicha tarea puesto que su instrumento es el cursor táctil de un computador. Esto significa que en la modalidad virtual se da un proceso motriz diferente al movimiento del brazo y el agarre, acciones necesarias para realizar la tarea de manera física (Benjumea, 2009), por lo tanto se vería la influencia de la actividad motora para mejorar el desempeño de planeación.

En cuanto a la prueba de localización espacial, al notar que los resultados no muestran una diferencia en relación a la modalidad de aplicación, se plantea que el instrumento virtual puede contar con una consistencia con respecto a la modalidad manual, sin que esto implique que ambos instrumentos realicen la medición de la misma manera. Esto, debido a que la diferencia se puede ver reflejada en los resultados en la modalidad virtual. Se sugiere que entre las versiones puede presentarse una diferencia entre los componentes práxico y la necesidad de motricidad que podría ser un indicador de diferencia en la evaluación de las pruebas (Vecchi y Richardson, 2001).

Por otro lado, otros factores que pudieron tener efecto sobre los resultados fueron el agotamiento de los participantes afectando los procesos de atención focalizada y los tipos jerarquizados de la atención explicarían las facilidades o dificultades de un evaluado para realizar una tarea en concordancia con la implicaciones en términos atencionales que estas requieran (Sohlberg y Mateer, 2001).

En la prueba dígitos, al observar que el span atencional y de memoria de trabajo es similar en ambas modalidades, a pesar que la puntuación directa muestra una diferencia evidente, se plantea la hipótesis de que la diferencia entre la puntuación se debe a que el participante puede llegar a perder interés o atención en la prueba debido a la facilidad o repetitividad de esta, por lo tanto, la dificultad de la tarea inicial de dígitos directos puede generar que el participante no tenga motivación frente a la tarea, mientras que en la tarea inversa que implica memoria de trabajo, se presentó mayor dificultad, lo cual puede llevar a que los sujetos tengan un esfuerzo mayor y un mejor desempeño.Esto se puede ver mencionado en estudios como los realizados por Herczeg y Lapegna, (2012) en donde afirman que en términos de aprendizaje, la motivación es determinante sobre todo en el modo de pensar y actuar de manera intrínseca y extrínseca. En este mismo sentido, Pinrich (1991, citado en Herczeg y Lapegna, 2012) afirma que una valoración positiva de la tarea conlleva a un compromiso más intenso con las mismas, es decir, que la considerar la tarea como novedosa o útil el sujeto tendrá mayor motivación y esta a su vez influenciará en términos positivos su puntaje en las pruebas.

A partir de lo anterior y en forma de conclusión, es posible afirmar que la comparación del desempeño y las diferencias de cada proceso de aplicación de las pruebas neuropsicológicas implementadas no son equiparables, debido a que los procesos implicados para la resolución de pruebas manuales y virtuales son diferentes, tanto en la recepción del estímulo como en codificación y evocación de respuestas (Baumer et al., 2009; Jeong, 2014; Noyes y Garland, 2008).

Se observó que el uso de pruebas informatizadas presentó ventajas y desventajas. Dentro de las ventajas se encontró que las pruebas virtuales pueden presentar más versatilidad en la investigación (Garaizar et al., 2012; Matute, Vadillo y Bárcena, 2007; Sands et al., 1999) destacándose la cantidad de tiempo empleado, aumento en la población que se evalua y un mayor control de variables al permitir eliminar sesgos producidos por el evaluador. Ahora bien, es necesario establecer la validez predictiva, de constructo, de criterio y de contenido en las pruebas y tareas virtuales para favorecer, de esta forma, que instrumentos virtuales lleguen a ser equiparables con los instrumentos manuales y puedan ser utilizados y estandarizados.

Es de resaltar que el formato virtual de las pruebas introduce una serie de variables novedosas que diferencian las pruebas virtuales de la forma tradicional. Dentro de estas variables, se reconoce como una limitación el hecho de perder en las pruebas informatizadas los datos cualitativos, que solo se pueden obtener por medio de la interacción directa con el evaluado y se pierde el rol del evaluador dentro de las pruebas (Chan, Shum, Toulopoulou y Chen, 2008; Rabin, Barr y Burton, 2005; Reynolds y Fletcher-Janzen, 2013). Esto sugiere una consideración en torno a la pertinencia del uso de este tipo de instrumentos en ámbitos clínicos, educativos o de evaluación en general, donde no se considera que la modalidad virtual sea la más apropiada puesto que se correría el riesgo de perder información cualitativa que complementa y ayuda a profundizar la información obtenida.

A pesar de no ser representativa la población del estudio, se encuentra que los resultados aportan a la evaluación de las modalidades de pruebas aplicadas tradicionalmente en diferentes campos en neuropsicología y que se suman al esfuerzo de optimizar y automatizar procesos de evaluación que superen limitaciones de espacio, acceso y aplicación a gran escala (Mueller y Piper, 2014; Piper et al., 2012, 2015; Prada Sarmiento et al., 2010).