Introducción

Los rostros son estímulos muy importantes para los humanos puesto que conllevan información esencial relacionada con la identidad, la expresión emocional, la intencionalidad, lo cual es base de la interacción social (Itier & Taylor, 2002). Los adultos son expertos en el procesamiento de rostros y pueden reconocer de forma rápida y con exactitud rostros individuales. El reconocimiento de rostros es procesado por módulos de procesamiento específicos, se ha descrito el área fusiforme la cual se activa cuando se presentan rostros, pero no responden por ejemplo ante casas, rostros mezclados o manos. Maurer, Grand, y Mondloch (2002) han sugerido que el procesamiento de rostros implica dos niveles de procesamiento configuracional, una etapa inicial que codifica la información relacional de primer orden, esto es, las relaciones espaciales cualitativas entre los rasgos faciales y se refleja a nivel electrofisiológico en el componente P1. Esta etapa es sensible a la violación de la configuración de primer orden como la orientación del rostro, la thatcherización (Milivojevic, Clapp, Johnson, & Corballis, 2003) y la presentación de los rostros Mooney. Una segunda etapa holística integra los rasgos faciales, en esta etapa el cerebro codificaría las relaciones espaciales finas entre los rasgos. Esta etapa es sensible a la presentación de rostros invertidos (Rossion et al., 2000; Sadeh & Yovel, 2010) y ante la presentación de rostros desalineados (Jacques & Rossion, 2010). A nivel electrofisiológico se ha observado en esta etapa la aparición de un componente negativo con una latencia de 170 ms en electrodos posterolaterales (Eimer, 2000). Este componente aparece con máxima amplitud con rostros presentados de frente, de perfil y con rasgos internos y externos. Se plantea que este componente es específico para rostros, puesto que no se presenta al observar objetos o rostros mezclados.

De acuerdo con el modelo de procesamiento de rostros en dos etapas, el componente N170 está vinculado solo a la integración estructural de los rasgos de los rostros, sin embargo, esta posición ha sido cuestionada por investigaciones que sugieren que el N170 no es estrictamente sensible a los rasgos de los rostros sino que también es modulado por la expresión emocional del mismo, por ejemplo Blau, Maurer, Tottenham y McCandliss (2007) encontraron una fuerte modulación de este componente por la expresión emocional de miedo. En otro estudio realizado por Batty y Taylor (2003) encontraron que las emociones positivas (sorpresa y felicidad) evocaron un componente N170 significativamente más temprano que las emociones negativas (tristeza, miedo, asco y enfado) y que la amplitud de N170 fue mayor para las emociones de miedo en comparación con los rostros neutros o que expresan sorpresa.

Existen también estudios sobre rostros con la técnica de resonancia magnética funcional. Blair, Morris, Frith, Perrett y Dolan (1999) encontraron que el incremento de la intensidad de la expresión facial de ira se asociaba con aumento de la actividad en la corteza orbitofrontal y el cíngulo anterior. La amígdala parece ser una estructura importante para procesar estímulos que elicitan miedo, así mismo, encontraron que el incremento en la presentación de la intensidad de la expresión facial de tristeza se asociaba con incremento de la actividad de la amígdala izquierda y el polo temporal derecho. Morris et al. (1998), demostraron el compromiso de la amígdala ante la presentación de rostros con expresiones de temor. Estos autores encontraron también activación en el núcleo pulvinar del tálamo, la ínsula anterior y el cíngulo anterior, los autores afirman que estas estructuras junto con la amígdala conforman el sistema neural filogenéticamente determinado que responde ante estímulos amenazantes. El colículo superior y el núcleo pulvinar del tálamo proporcionan entradas a la amígdala, lo cual sugiere que existe un mecanismo potencial para el procesamiento visual residual del afecto facial sin conciencia (Blau et al., 2007). Con esta técnica también se ha encontrado una comunicación bidireccional entre la amígdala y el giro fusiforme durante el reconocimiento de rostros emocionales; por ejemplo Herrington, Taylor, Grupe, Curby y Schultz (2011) encontraron conexiones entre el giro fusiforme y la amígdala, y afirman que la amígdala influye sobre la función del giro fusiforme durante la percepción de rostros y que esta modulación está mediada por la experiencia y la saliencia del estímulo. Britton, Shin, Barrett, Rauch y Wright (2008) encontraron activación en el giro fusiforme y la amígdala ante expresiones faciales de ira presentados de forma esquemática.

En el presente estudio se pretende observar si existen diferencias en el procesamiento cortical reflejadas por la modulación de la amplitud y la latencia del componente N170 ante imágenes de rostros que expresan ira y miedo intensos. Se espera encontrar una mayor amplitud para el procesamiento de rostros con expresión de ira intensa en comparación con el procesamiento de rostros con expresión de miedo intenso.

Método

Participantes

La muestra estuvo conformada por 34 estudiantes de la Universidad El Bosque, todas mujeres seleccionadas por conveniencia, con edades comprendidas entre 18 y 24 años, con una media de edad de 21 años. Se determinó realizar el estudio con una población femenina puesto que las mujeres tienen mejor ejecución que los hombres en la detección de rostros, en el reconocimiento de emociones faciales y en la discriminación de la identidad facial (McBain, Norton, & Chen, 2009). Los participantes debían tener visión normal o corregida, con edades entre 18 a 24 años, sin enfermedad psiquiátrica y no estar bajo los efectos de sustancias psicoactivas. Se seleccionaron participantes diestras a través del Inventario de Lateralidad Manual de Edimburgo (Oldfield, 1971).

De las 34 participantes, se excluyeron los resultados de una persona, pues sus valores fueron anormales (sus medias tanto de latencia como de amplitud, estaban a más de tres desviaciones estándar de las medias de la muestra). Por esta razón, la muestra final estuvo conformada por 33 estudiantes.

Instrumentos

Se utilizó el conjunto de caras con expresiones emocionales del manual FEEST (Facial Expressions of Emotion Stimuli and Test; Young, Perrett, Calder, Sprengelmeyer, & Ekman, 2001) con dimensiones de 6.5 cm de ancho por 10.5 cm de altura, presentadas de forma aleatoria. Se utilizaron rostros con expresión neutra (6), rostros con expresión marcada de ira (6), rostros con expresión marcada de miedo (6). La presentación se realizó con el programa E-Prime.

Procedimiento

Se presentó a cada participante una serie de imágenes de rostros neutros sin ninguna expresión emocional (rostros neutros) y rostros emocionales (ira intensa, y miedo intenso). El participante oprimía la tecla 1 (rostro neutro), la tecla 2 (rostro con ira intensa y la tecla 3 (rostro con emoción de miedo intenso) inmediatamente después de percibir cada tipo de rostro. Se realizaron 570 ensayos, 190 rostros neutros, 190 rostros de ira, 190 rostros de miedo. El tiempo de exposición de los estímulos fue de 1 segundo con espacios de 2 segundos entre las imágenes, precedidas de una cruz ( + ). La presentación secuencial de estímulos se realizó en una pantalla de 14 pulgadas sobre fondo negro a 100 cm del participante. Los 34 registros se realizaron con un montaje de 32 canales, con electrodos acticap, se utilizó gel hipertónico para obtener una impedância por debajo de 10 kΩ. Para la obtención del componente N170, las señales EEG se digitalizaron online con una amplificación de 10.000 en un amplificador BrainAmp. Se utilizó un filtro de paso de banda entre 2 y 12 Hz para el componente N170. Se realizó un segmentado global donde solo se tuvieron en cuenta la presentación de estímulos para cada tarea. Las épocas que se tomaron para la extracción del componente fue desde los -200 ms previos hasta los 600 ms antes de la respuesta para un total de 800 ms. Se rechazaron los ensayos con ruido que tuvieran una amplitud mayor a 70 mV Se realizó la corrección de los artefactos oculares según el método de Graton (Coles & Donchin, 1983) y corrección de línea de base desde los -200 a 0 ms. El tratamiento de la señal EEG (corrección de los artefactos oculares, segmentación, filtrado, rechazo de las épocas con ruido con amplitudes mayores a 70 mV y el promediado de los segmentos) se llevó a cabo con el programa Vision Analyzer. El procedimiento para la presentación de la tarea y la obtención de los registros no implicaron ningún riesgo para los participantes puesto que no fueron procedimientos invasivos. Antes de iniciar la sesión se le solicitó a cada participante leer un consentimiento informado el cual podía no firmar si no estaba de acuerdo con el procedimiento. La presentación se realizó de forma aleatoria y diferente para cada participante, controlando la repetición de los mismos estímulos, evitando así la aparición del componente N250r.

Diseño y análisis estadísticos

En el presente estudio se analizaron la latencia y amplitud (variables dependientes) en el componente N170 en respuesta ante imágenes de rostros neutros, con expresiones de ira intensa y con expresiones de miedo intenso. Dado que se midió la respuesta de cada participante a todas las imágenes, este estudio tiene un diseño de medidas repetidas, en el que se compararon la amplitud y latencia media de cada participante frente a los rostros según su expresión (neutral, ira, miedo).

Para analizar diferencias en el procesamiento cortical de rostros según emoción, se usaron 2 análisis separados, uno para cada una de las variables dependientes (latencia y amplitud). En ambos casos, se usó un análisis de varianza (ANOVA) de medidas repetidas con un factor (expresión de los rostros), comparando las respuesta intra-sujeto a los rostros de ira, miedo y neutrales. Así mismo, para comparar los efectos de los rostros según la emoción, se realizaron contrastes planeados (Helmert), comparando primero la respuesta (latencia o amplitud) a rostros neutrales versus rostros de miedo e ira combinadas, y después la respuesta a rostros de miedo versus rostros de ira. Los contrastes planeados son más adecuados que las pruebas post hoc dado que son análisis ortogonales, aumentan el poder estadístico contra la tasa de errores tipo II sin aumentar la probabilidad de errores tipo I, pues son pruebas a priori (en vez de a posteriori, como en el caso de las pruebas post-hoc) que se ajustan al diseño de éste estudio (e.g. Ruxton & Beauchamp, 2008).

Resultados

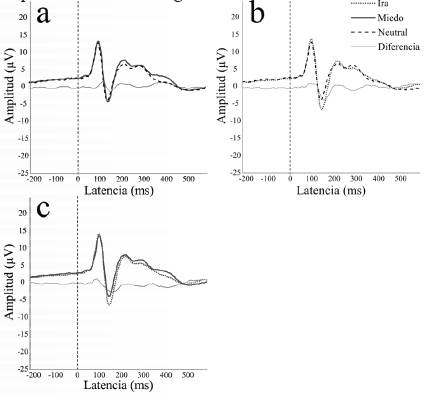

Dado que la literatura predice diferencias en la latencia y amplitud ante la presentación de rostros emocionales de ira y miedo, se estudiaron las diferencias promedio en estas variables ante rostros con dichas emociones, así como en comparación con rostros sin expresión emocional (fig. 1).

Figura 1 Amplitud y latencia en respuesta a rostros con expresiones neutras (línea entrecortada), de ira (línea punteada) y de miedo (línea negra sólida). (a) Miedo intenso versus sin expresión emocional (neutral); (b) ira intensa versus sin expresión emocional (neutral); (c) ira intensa versus miedo intenso. La línea gris delgada representa la diferencia en amplitud para cada momento, entre emociones comparadas en cada panel.

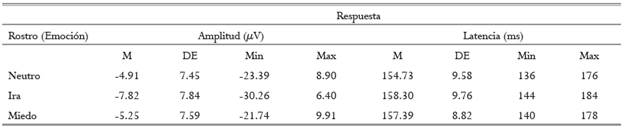

Para realizar los análisis estadísticos, primero se estableció que todas las variables (amplitud y latencia frente a rostros neutros, de ira y miedo) eran apropiadas para un análisis paramétrico; pruebas W de Shapiro-Wilk mostraron que la amplitud frente a rostros neutros (W(33) = .97, p = .37), de ira (W(33) = .97, p = .09), y miedo (W(33) = .94, p = .45), así como la latencia (frente a rostros neutros: W(33) = .96; de ira: W(33) = .94; y miedo: W(33) = .94; p > .05 en todos los casos), tenían distribuciones que no se diferenciaban significativamente de una distribución normal. Estadísticos descriptivos de las variables se presentan en la tabla 1.

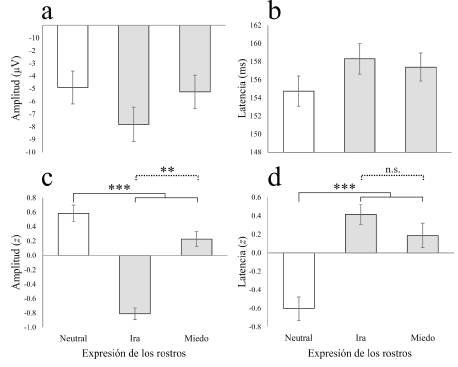

En todos los casos, n = 33. Medias estimadas marginales y errores estándar están representados gráficamente en la fig. 2a y 2b.

Figura 2 Amplitud y latencia en respuesta a rostros con expresiones neutras (barras blancas) y de ira y miedo (barras grises). (a) Amplitud en uV; (b) latencia en ms; (c) Amplitud en desviaciones estándar; (d) latencia en desviaciones estándar. Para los paneles c y d los valores fueron transformados a desviaciones estándar (z) para cada participante para representar variaciones intrasujeto y tendencias generales. Las barras representan medias marginales estimadas ± error estándar. Para contrastes planeados, las líneas sólidas representan diferencias en la respuesta a rostros neutros versus rostros con emoción (ira, miedo); las líneas punteadas representan la diferencia entre la respuesta a rostros de ira y miedo. **p < .01, ***p < .001, n.s. = no significativa.

El análisis de varianza mostró que la amplitud en el componente N170 varía significativamente dependiendo de la expresión del rostro presentado (F (2, 64) = 17.36, p < .001, η 2 p = .35; fig. 2a). Contrastes planeados (Helmert) revelaron que la amplitud fue significativamente más alta frente a rostros neutros, que frente a rostros con una expresión intensa (ira, miedo) (F (1, 32) = 12.40,p = .001, η 2 p = .28; Fig. 2c), y que fue significativamente más baja frente a rostros de ira que frente a rostros con expresiones de miedo (F (1, 32) = 217.29, p < .001, η 2 p = .41; fig. 2c), lo que sugiere una mayor activación de la red cortical que procesa los rostros emocionales, frente a la red que procesa solamente los rostros como integración de elementos internos a ellos, es decir, los rostros neutros.

Así mismo, el Anova de medidas repetidas mostró que la latencia en el componente N170 varía significativamente dependiendo de la expresión del rostro presentado (F (2, 64) = 8.78, p < .001, η 2 p = .35; Fig. 2b). Contrastes planeados (Helmert) mostraron que la latencia fue significativamente más baja frente a rostros neutros, que frente a rostros con una expresión intensa (ira, miedo) (F (1, 32) = 10.81, p = .002, η 2 p = .25; Fig. 2d), pero que no cambió significativamente frente a rostros de ira o miedo (F (1, 32) = 2.22, p = .15, = .06; Fig. 2d). Esto sugiere que la velocidad de la red cortical que procesa las características emocionales al interior de los rostros es mayor ante las imágenes de rostros que expresan emociones intensas.

Discusión

La discriminación de las emociones expresadas a nivel facial constituye una clave importante para la interacción social. El presente estudio pretendió investigar las diferencias en el procesamiento cortical de rostros ante imágenes de rostros que expresan ira intensa frente a rostros con expresión de miedo intenso. La técnica de los potenciales evocados es una técnica que puede diferenciar el curso temporal ante la presentación de imágenes de rostros con diferentes expresiones emocionales y permite examinar si los aspectos estructurales y emocionales de la codificación cerebral de rostros son procesos seriales o en paralelo. Varios autores (e. g. Eimer & Holmes, 2002; Sergent, Ohta, Macdonald, & Zuck, 1994) proponen que para reconocer rostros, el cerebro realiza dos etapas: la primera la codificación estructural de los rasgos faciales, la segunda es la integración de dichos rasgos. Algunos estudios apoyan la existencia de esta segunda etapa, por ejemplo Bentin, Allison, Puce, Perez, y McCarthy (1996) demostraron que el componente N170 no se presenta exclusivamente ante estímulos de rostros en posición vertical, sino que también aparece ante estímulos de rostros presentados de forma invertida o ante rostros con ojos presentados de forma separada, ante esta forma de presentación el componente N170 tiene una mayor amplitud. Una serie de estudios han encontrado que de forma paralela el reconocimiento de la expresión emocional del rostro puede modular el componente N170 tanto en amplitud como en latencia. Aguado et al. (2012), compararon rostros con expresiones emocionales de ira y felicidad contra rostros neutros y encontraron mayor amplitud ante rostros de ira comparados con los rostros de felicidad y neutros. Baggott, Palermo y Fox (2011), detectaron mayor amplitud de rostros que expresaban miedo, ira y tristeza comparados con los rostros neutros. Blau y et al. (2007), encontraron modulación del componente N170 ante la emoción de miedo. Blechert, Sheppes, Di Tella, Williams y Gross (2012), encontraron una modulación del componente N170 ante la presentación de rostros con expresión de ira. Brenner, Rumak, Burns y Kieffaber (2014), no encontraron diferencias en amplitud entre los rostros neutros y los felices, pero sí encontraron mayor amplitud en N170 de los rostros de ira, miedo y tristeza comparados con los neutros y felices. Caharel, Courtay, Bernard, Lalonde y Reba'i (2005), encontraron mayor amplitud de N170 ante la presentación de rostros de asco comparados con los rostros neutros y que expresaban felicidad. Calvo y Beltrán (2013), no encontraron diferencias en amplitud entre las emociones de enfado, miedo y tristeza sin embargo, estas amplitudes fueron mayores en comparación con la condición de rostro neutro. Frühholz, Jellinghaus y Herrmann (2011), encontraron mayor amplitud del componente N170 ante rostros que expresaban miedo comparado con rostros neutros. Luo, Feng, He, Wang y Luo (2010), encontraron que la amplitud de N170 fue mayor ante la expresión de miedo en comparación con los rostros neutros, pero la expresión de felicidad no mostró diferencias en N170 comparado con la condición de rostro neutro.

La presentación de emociones pronunciadas también modula el componente N170. Leppánen, Kauppinen, Peltola y Hietanen (2007), encontraron que la velocidad y exactitud de la categorización de la emoción mejoró con el incremento en los niveles de la intensidad de la expresión emocional. Sprengelmeyer y Jentzsch (2006), estudiaron los potenciales relacionados a eventos con la presentación de rostros con expresión de ira, asco y miedo en diferentes intensidades (50 %, 100 % y 150 %) los resultados mostraron un incremento significativo en la amplitud de N170 causado por la intensidad, pero no por el tipo de emoción. En el presente estudio se observan una mayor amplitud del componente N170 ante la presentación de rostros con ira intensa que concuerdan con el estudio de Eimer y Holmes (2002) en donde los rostros emocionales desencadenaron una mayor amplitud del componente N170 en comparación con los rostros neutros. Los autores plantean que dado este inicio temprano de los efectos de la emoción específica expresada por los estímulos de rostros, es probable que este sistema se active en paralelo y de forma rápida con la evaluación del contenido emocional en la amígdala y circuitos subcorticales relacionados. Se muestra una mayor amplitud con diferencias estadísticamente significativas ante la emoción de ira intensa en comparación con el miedo intenso, lo cual nos muestra que las estructuras cerebrales relacionadas tanto con el procesamiento de rostros como de las estructuras que procesan la emoción a nivel subcortical funcionan de manera rápida pero con mayor activación ante rostros con expresión de enfado pronunciado o agresivos que ante emociones negativas pronunciadas como el miedo.

Los resultados del presente estudio apoyan la posición de que se presenta un proceso rápido y en paralelo para las características emocionales expresadas por rostros y sugiere que el componente N170 puede ser modulado por la valencia emocional expresada por el rostro. Estos resultados son consistentes con los reportes de estudios en neuroimagen como los de Morris et al. (1998), que muestran sistemas neuronales asociados con el análisis perceptual rápido de estímulos emocionales salientes. La amígdala se considera una estructura principal para el procesamiento de estímulos relacionados con amenaza. Sin embargo, en un estudio realizado por Fitzgerald et al. (2006), en donde emplearon cinco categorías de emociones (miedo, ira, asco, felicidad y tristeza), encontraron que la amígdala izquierda se activó en todas las categorías emocionales. Los resultados del presente estudio respaldan este punto de vista en el sentido de que apuntan a un mecanismo corticosubcortical que modula el análisis de la información visual facial como lo indica el componente N170 en la presencia de información emocional. Una probable explicación para la mayor modulación del componente N170 ante la presentación de rostros con ira intensa es la activación de la corteza orbitofrontal además de la activación de la amígdala (Blair et al., 1999).

Smith, Weinberg, Moran y Hajcak (2013), argumentan que los rostros emocionales son estímulos motivacionalmente salientes que capturan automáticamente la atención. Afirman los autores que los rostros que expresan miedo e ira pueden ser expresiones emocionales salientes que capturan la atención y se procesan automáticamente. En el caso de este estudio los rostros que expresan enfado pronunciado pueden capturar la atención y movilizar reacciones fisiológicas ya que señalan una amenaza potencial, por lo tanto es posible que la relevancia motivacional pueda ser un factor clave que influya en el procesamiento neuronal. Las expresiones de miedo e ira podrían aumentar el procesamiento automático, mientras que la expresión neutra podría depender de claves explícitas para capturar la atención dependiente de la demanda de la tarea.

En cuanto a limitaciones del presente estudio, es necesario tener en cuenta que la presentación de rostros que se utilizó no separó las características intrínsecas de los mismos como por ejemplo el atractivo de los rostros. Lo anterior es necesario tenerlo presente ya que se ha encontrado que el atractivo del rostro puede modular el componente N170, por ejemplo Werheid et al. (2007), presentaron una tarea de clasificación de retratos faciales estandarizados de acuerdo con la expresión facial, en la que los rostros eran precedidos por otro rostro de alto o bajo atractivo o por un objeto afectivamente neutro. Los autores encontraron que los rostros atractivos a diferencia de los no atractivos causaron una negatividad posterior temprana (NPT; 250 ms.) y una positividad parietal tardía (NPT; 400-600 ms.) que no fueron modulados por los rostros señalizados (primed) afectivamente congruentes; los autores concluyen que la evaluación de las características atractivas de los rostros se inicia en etapas de procesamiento asociadas con la selección del estímulo. En la misma línea del estudio arriba mencionado, se ha encontrado que los rostros altamente atractivos provocan un componente positivo temprano en zonas frontales, y que existe una modulación del componente N170 en el siguiente orden: mayor modulación ante los rostros altamente atractivos, seguido por los juzgados como medianamente atractivos, los juzgados con bajo atractivo y con menor amplitud los rostros no atractivos (Marzi & Viggiano, 2010). Chen et al. (2012), estudiaron la influencia del atractivo facial en el procesamiento cortical para estos estímulos, encontrando que los rostros atractivos provocaron una mayor amplitud del componente N2 y menores amplitudes del componente tardío (CPT).

Lu, Wang, Wang, Wang y Qin (2014), investigaron el curso temporal de la respuesta cerebral ante la evaluación del atractivo de rostros de caricaturas, encontrando que la amplitud de N170 fue mayor para los rostros atractivos en hombres, mientras que se encontró lo opuesto en mujeres. El atractivo del rostro moduló notablemente el componente positivo tardío (CPT), lo que podría reflejar el proceso de evaluación de la belleza. El promedio de la amplitud del CPT en hombres fue significativamente mayor para las caricaturas atractivas en comparación con los rostros no atractivos, mientras que la amplitud del CPT en mujeres no difirió significativamente entre los rostros de caricaturas atractivas y no atractivas. Los autores de ese estudio concluyen que la selección de información de lo atractivo del rostro ocurre en etapas tempranas y que el incremento atencional de los rostros atractivos que ocurre en etapas tardías solo existe en hombres, lo cual sugiere que el cerebro del hombre tiene más redes que procesan a la belleza facial, incluso en caricaturas. En otro estudio, se pidió a 20 participantes diestros evaluar imágenes en un rango desde muy feas a muy hermosas, lo que fue usado para generar tres conjuntos de rostros y cuerpos hermosos, feos y neutros (Muñoz & Martín-Loeches, 2015). En el procedimiento de registro los participantes llevaron a cabo una tarea que consistía en juzgar las imágenes como bellas, neutras o feas. Los autores encontraron que la amplitud de P200 se incrementó ante las imágenes feas. De acuerdo con los autores lo anterior puede ser el resultado de un sesgo en el procesamiento atencional. Los autores también encontraron un incremento en el componente P300 sobre todo en las imágenes hermosas, particularmente para la categorización de los estímulos. El componente tardío fue significativamente mayor en amplitud tanto para las imágenes feas y hermosas. Según los autores esta modulación refleja un proceso de decisión tardía vinculado con mantener la información en la memoria de trabajo. Otros autores realizaron un estudio en la línea de los estudios anteriormente expuestos. Schacht et al. (2008), solicitaron a 18 participantes clasificar retratos en color de personas no familiares de acuerdo con el sexo y atractivo facial. Los autores encontraron que el atractivo facial puede modular los procesos cerebrales tempranamente (150 ms). Estos primeros efectos toman lugar en una red que es independiente de la responsable para el análisis visual y estructural (i. e. P100 y N170), y es seguido por una modulación del componente tardío. Tanto los efectos tempranos como tardíos son prominentes para los rostros atractivos y no atractivos en relación con los rostros intermedios.

En conclusión, los estudios relacionados con el atractivo y el curso temporal cerebral muestran que hay modulación tanto en el componente temprano como en el tardío. En este último probablemente se deba a un proceso de evaluación o atención ante la belleza.