Introducción

La medición del desempeño de las universidades representa un desafío en atención a la multidimensionalidad del mismo concepto y a la diversidad misional a la que aspiran estas instituciones. El desempeño de la universidad como organización generadora de bienes comunes debería reflejarse a través de los beneficios logrados por las partes interesadas, teniendo en consideración los recursos puestos a disposición para su consecución.

Hace algunas décadas se creó el sistema de rankings universitarios con el propósito de medir la efectividad de las universidades en ciertas áreas consideradas relevantes, para promover acciones de mejoramiento al permitirse la comparación entre instituciones, convirtiéndose en la actualidad en uno de los mecanismos reguladores del mercado de la educación superior. Ante la necesidad de instrumentos estandarizados que permitan medir el desempeño de las universidades, los rankings universitarios y sus indicadores se han posicionado como una adecuada medida de los niveles de eficiencia de las universidades, cuestión que es necesario poner en duda. Esta argumentación es la base del presente trabajo de investigación, pues el objetivo central es analizar si los indicadores que son parte de los rankings universitarios mundiales reflejan una medición del desempeño de las universidades. La discusión no es inapreciable si se tiene en cuenta que la medición tiene efectos en todo el sistema universitario. Una elección errónea del indicador generará perturbaciones en la valoración de las instituciones y consecuencias en las decisiones que se tomen internamente y, en algunos casos, se pueden perder de vista los objetivos misionales de la universidad.

Para llevar adelante este estudio, se revisaron los indicadores de nueve rankings universitarios mundiales: Academic Ranking World Universities; Times Higher Education Ranking; Quacquarelli Symonds Ranking; Scimago Institutions Ranking; University Ranking by Academic Performance; Performance Ranking of Scientific Papers for World Universities; CWTS Leiden Ranking; Ranking U.S. News & World Report y U-Multirank. El periodo analizado comprende los años 2017 y 2018, dependiendo del listado. Los indicadores fueron analizados como inputs o insumos con los que cuentan las universidades para realizar sus actividades, tales como la capacidad académica, la capacidad administrativa, los recursos materiales, financieros y la infraestructura. También se identificaron las variables que representan outputs o productos que generan las instituciones, así como la generación de capital humano y de conocimiento reflejado en proyectos científicos y sus publicaciones, además de patentes y productos que reflejen el compromiso con su entorno significativo, como la colaboración y vinculación con la comunidad, la transferencia del conocimiento, entre otros.

Este trabajo presenta la siguiente estructura: en el marco conceptual se establecen los conceptos esenciales de esta investigación, para la organización y análisis de los datos recabados; a continuación, en la sección de metodología se proporcionan algunos detalles de los rankings analizados y, finalmente, se presentan los resultados y las conclusiones.

Marco conceptual

El desempeño de las universidades representa la capacidad que estas tienen para lograr sus diversos objetivos misionales, y con ello responder a las expectativas de un entorno significativo representado por las partes interesadas, es decir, académicos, estudiantes, egresados, equipo rectoral, funcionarios, comunidad local, empresarios, gobiernos locales y nacionales y en general todos aquellos grupos o individuos que pueden afectar o verse afectados por el logro de los objetivos de la institución (Alarcón et ál., 2016; Caballero et ál., 2007; Freeman, 1984). Para evaluar esta capacidad, es necesario determinar los componentes del buen desempeño, utilizando indicadores específicos. La calificación del desempeño institucional deberá evaluar lo actuado, considerando los recursos a disposición de la institución, haciendo énfasis en la economía, efectividad y eficiencia (Ball y Halwachi, 1987; Sarrico et ál., 2010; Nazari-Shirkouhi et ál., 2020; Roessler y Catacutan, 2020).

Las universidades son organizaciones complejas (Aziz et ál., 2013; Svensson y Hvolby, 2012; Stake et ál., 2017) que producen bienes comunes (Licandro y Yepes, 2018; Rodríguez, 2017; Gibbs, 2019). Estos recursos colectivos benefician a todos los miembros de la institución, independientemente de si han contribuido a la creación de ese recurso o no (Frost y Hattke, 2018; Ostrom, 1990). Según Ostrom (1990), un bien común como la educación superior requiere de una gestión comunitaria; esto implica que la gestión y la evaluación del desempeño debe ser congruente con la naturaleza del mismo bien (Zamagni, 2014).

En el caso de las universidades, su actuar es multidimensional (García-Aracil y Palomares-Montero, 2012). De acuerdo con Bengoetxea y Buela-Casal (2013), la Comisión Europea considera a la multidimensionalidad como un principio para establecer una metodología de la clasificación de la educación superior, que implica dar cuenta de la diversidad misional de las universidades; así, se reconocen cinco dimensiones: 1) formación, 2) investigación, 3) internacionalización, 4) innovación y transferencia de conocimiento, y 5) compromiso regional. Para el caso australiano, Erdogmus y Esen (2016) indican que en ese país se tienen igualmente cinco dimensiones para calificar el desempeño de las universidades: 1) enseñanza y aprendizaje, 2) perfil del estudiante, 3) participación en la investigación, 4) intercambio de conocimientos, y 5) orientación internacional. Gregorutti (2014) propone que la diversidad misional de las universidades se puede dividir en tres: 1) enseñar, 2) investigar, y 3) comercializar el conocimiento. Por su parte, Urdari et ál. (2017) identifican dichas misiones con: 1) enseñanza, 2) investigación y, recientemente, 3) contribución a la sociedad. Estos autores proponen también otros elementos que deben considerarse para medir el desempeño, entre ellos se encuentran: 1) investigación generada por contratos con clientes no académicos, 2) comercialización de la tecnología, 3) empleabilidad de los estudiantes, 4) actividades de aprendizaje, 5) emprendimientos, y 6) generación de redes sociales. Otro aporte es el que hace Shin (2008), para el caso coreano, clasificando las instituciones en universidades de docentes, universidades politécnicas, universidades abiertas y universidades convencionales. La distinción misional no es un problema para los tres primeros tipos, ya que las primeras tienen la misión de formar profesores, las segundas forman personas para la industria y las terceras corresponden a la formación de adultos. En lo que respecta a las universidades convencionales, la definición de la misión plantea un problema en la medida en que la institución se focaliza en la investigación, sin dejar de lado los otros quehaceres misionales, como son la enseñanza o la prestación de servicios.

Otro aspecto relevante sobre el desempeño de las universidades es la capacidad de cumplir con las expectativas de la sociedad, representada por diversos grupos de interés, sean estos reales o potenciales (Alarcón et ál., 2016). Para determinar este aspecto se debe realizar una evaluación del desempeño basada en indicadores propios, los cuales pueden ser definidos como atajos, abreviaturas o sustitutos de un activo que subyace en la realidad. Un indicador constituye una síntesis de los datos que pueden ser analizados, y se calcula a partir de datos brutos, utilizando herramientas estadísticas tales como: porcentajes, tasas, razones e índices. Es muy recomendable que un sistema de indicadores incluya antecedentes a gran escala, así como la población total de estudiantes por nivel o disciplina que puede servir de base para su cálculo. Los indicadores deben resumir también una cantidad considerable de datos, con el objetivo de presentar una visión o indicación general de la situación que se está analizando, sin que necesariamente deba incluir comentarios respecto a la calificación positiva o negativa de dicha situación. En ese sentido, ofrecen una instantánea o un perfil de las condiciones existentes en un momento dado, describiendo el estado de un sistema educativo en varios niveles. Los tipos de indicadores fueron organizados por Hüfner (1991) en cuatro categorías: de rendimiento interno, de rendimiento operacional, de rendimiento generados por factores externos y de desempeño en investigación.

Respecto a la definición de la Unesco reportada por Vlasceanu et ál. (2004), los ámbitos de aplicación de los Indicadores Claves de Desempeño (Key Performance Indicators, KPI) permiten a las instituciones realizar benchmarking, evaluando su desempeño y estableciendo comparaciones con otras instituciones de educación superior (rankings y clasificaciones). En la misma línea, para el Council for Higher Education Accreditation (CHEA) (2001), los llamados indicadores de gesíión son considerados un conjunto de medidas concretas destinadas a facilitar la rendición de cuentas públicas (accouníabiliíy).

La accouníabiliíy es una aplicación posible de los indicadores de desempeño que se puede definir mediante la evaluación interna y externa de la institución; esta estudia tanto los efectos específicos como los globales en relación con el sistema de objetivos, procesos y resultados de la práctica universitaria (Hüfner, 1991; Hazelkorn y Gibson, 2019; Oancea, 2019). Shin (2010) señala que la adopción del sistema de rendición de cuentas basado en el rendimiento no tendrá efecto si no está fundado en las prácticas institucionales.

Por otra parte, la información proveniente de los indicadores de desempeño potencia las buenas prácticas (benchmarking) y facilita la decisión de movilidad de estudiantes, docentes e investigadores (Pérez-Esparrells y López, 2009). Además, ayuda a asignar fondos de manera racional, priorizando la investigación y la inversión en formación, al tiempo que informa al público, orienta el creciente mercado de los postulantes a pregrado y de los jóvenes investigadores, y ayuda a las instituciones en su proceso de autoevaluación y mejora. Thakur (2007) concluye que dentro de un país o área de influencia se pueden elaborar indicadores de desempeño para la asignación de financiamiento público, basados en los resultados de investigación o docencia.

En concreto, los indicadores de desempeño deben explicitar la relación causaefecto entre los productos y recursos utilizados por la institución; además, deben ser objetivos, es decir, son la evidencia de lo logrado. Cuando el indicador refleja solo el logro, se considera como output; cuando especifica el insumo, se reconoce como inpuí. Sin embargo, estos tipos de indicadores no miden eficiencia, ya que no representan la relación insumo-producto, sino meramente eficacia, que es la obtención del logro, en el mejor de los casos.

Algunas clasificaciones o rankings de universidades comparan y ordenan de manera descendente las instituciones que las integran, según un conjunto común de indicadores (Usher y Savino, 2007). Si bien ahora se consideran como novedad en el ámbito universitario, lo cierto es que su existencia se remonta a varias décadas atrás, con la publicación local de las mejores instituciones de Estados Unidos por U.S. News & World Report en el año 1983 (Dill, 2006), iniciativa pionera respecto de la forma como se conciben los rankings en la actualidad. Lo cierto es que en los últimos años estas mediciones han proliferado, captando así la atención de los sectores de la sociedad interesados en la educación superior, en la medida en que coexisten clasificaciones de orden mundial y otras enfocadas en lo local.

En su origen, los rankings se diseñaron para medir la efectividad de las universidades (Ramírez-Gutiérrez et ál., 2019; Bustos-González, 2019). Hoy, lejos de su propósito inicial, se han convertido en mecanismos reguladores del mercado de la educación (Pérez-Esparrells y López, 2009; Ramírez-Gutiérrez et ál., 2019) e inductores de la lucha por la excelencia institucional (Hazelkorn, 2009). También se les atribuye la capacidad de medir la calidad (Reyes, 2016; Yoguez-Seoane, 2009; FloresOrozco et ál., 2015; Thompson-Whitside, 2016) y, asimismo, representan una herramienta para aumentar la transparencia del quehacer de la institución (Jongbloed et ál., 2018). Dearden et ál. (2019) señalan que detrás de todo ranking hay un modelo teórico que maximiza la utilidad de las partes interesadas, entes gubernamentales y directivos, pero en especial del estamento estudiantil.

Los indicadores han sido la base para generar estos rankings internacionales. Como indican Kroth y Daniel (2008), a pesar del desacuerdo acerca de su validez, fiabilidad y efectos, las clasificaciones internacionales de las universidades han sido cada vez más utilizadas por los estudiantes y los centros de enseñanza. Un ranking basado en indicadores como el arwu (también conocido como ranking de Shanghai) genera en las instituciones universitarias incentivos para influenciar su clasificación y, con ello, mejorar su visibilidad internacional, pero esto puede resultar incoherente con aspectos misionales de la universidad (Siganos, 2008) e incluso ser perjudicial para la propia clasificación.

El ranking universitario puede también afectar la asignación de recursos (Lang et ál., 2019) con distribuciones desiguales que privilegian a las entidades con mejores clasificaciones, estableciendo, como indican Pusser y Marginson (2013), relaciones de poder para dar legitimidad a las decisiones de distribución de recursos. Esto, incluso, puede generar sesgos geográficos, como lo indican Jöns y Hoyler (2013). El diseño de este tipo de clasificaciones debe lidiar con una gran cantidad de datos difíciles de precisar; además, algunos indicadores pueden ser poco confiables, subjetivos y difíciles de obtener, por lo que los resultados se pueden cuestionar fácilmente. Por tanto, es de suma importancia comprender el funcionamiento de estas mediciones, ya que un ranking preciso coadyuva y da confianza en el proceso de toma de decisiones. En este sentido, las instituciones pueden utilizar estas clasificaciones como una manera de visibilizar y alcanzar prestigio (Zapata, 2006), lo cual puede generar incentivos para que sus creadores elijan ponderaciones de atributos que potencien la buena opinión de una institución particular, en desmedro de los intereses estudiantiles, para maximizar con ello el beneficio de la publicación (Dearden et ál., 2019).

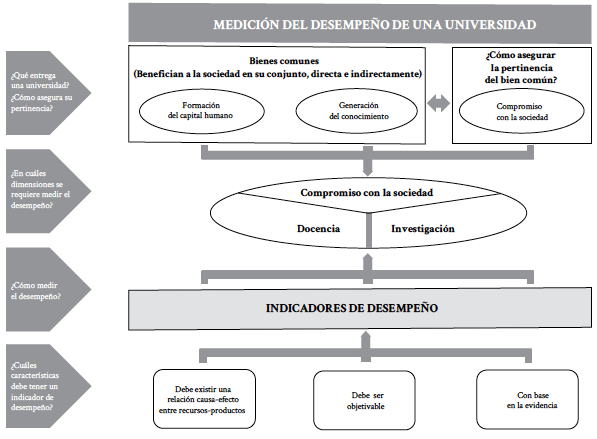

Para estructurar el análisis de desempeño, las universidades se entienden como instituciones comprometidas con su entorno significativo, que proveen a la sociedad de bienes comunes, como son la formación de capital humano y la generación de conocimiento. En la figura 1 se plantean tres dimensiones de desempeño: 1) la docencia, 2) la investigación y 3) el compromiso con la sociedad. Las dos primeras reflejan el quehacer esencial de las universidades, de lo cual interesa particularmente dimensionar la calidad y la eficiencia, y la tercera representa lo significativo que es para la sociedad la generación de esos bienes comunes, el sentido, la trascendencia y el impacto bidireccional de la relación de la universidad con su entorno significativo, concretamente reflejado en la pertinencia del capital humano formado por las universidades, y en una investigación con sentido, es decir, aquella que se hace cargo de las grandes problemáticas de la sociedad o territorio donde se encuentra inserta (García-Alsina y Vargas, 2015; Bernasconi y Rodríguez-Ponce, 2018; Gralka et ál., 2019; Miranda-Zea et ál., 2019; Ramírez-Gutiérrez et ál., 2019). La exigencia metodológica de las dimensiones de desempeño se fundamenta en su capacidad para medir sobre lo actuado o producido, considerando los recursos que se han puesto a disposición. Dicha exigencia resulta clave para distinguir los indicadores de desempeño, además de garantizar que estos sean objetivos y tangibles (representen evidencias).

Metodología

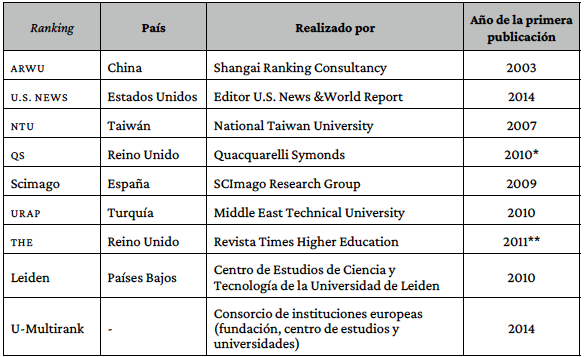

Para llevar adelante este estudio se revisaron los indicadores propuestos por nueve rankings universitarios mundiales, utilizando la versión 2017 para el Academic Ranking World Universities (arwu), Performance Ranking of Scientific Papers for World Universities ( 31), Scimago Institutions Ranking, University Ranking by Academic Performance (urap), cwts Leiden Ranking y U-Multirank; y la edición 2018 para el Times Higher Education Ranking (the), Quacquarelli Symonds Ranking (qs) y Ranking U.S. News & World Report, referenciados en la tabla 1, que además incluye el país de origen, el realizador y el año de su primera publicación (se contempla solo la versión mundial del listado). Las variables utilizadas representan inputs o insumos con que cuentan las universidades (capacidad académica, capacidad administrativa, recursos materiales, financieros e infraestructura), así como outputs o productos generados (capital humano, conocimiento reflejado en publicaciones de proyectos científicos, patentes y productos que reflejen el compromiso con su entorno significativo).

Tabla 1. Información de los rankings estudiados.

*Año de primera publicación en solitario, ya que desde el 2004 el ranking mundial se publica en conjuntocon la revista Times Higher Education

**Año de primera publicación en solitario, ya que desde el 2004 el ranking mundial se publica en conjuntoa Quacquarelli Symonds.

Fuente: elaboración propia, con información extraída en 2020 desde los rankings estudiados.

Resultados

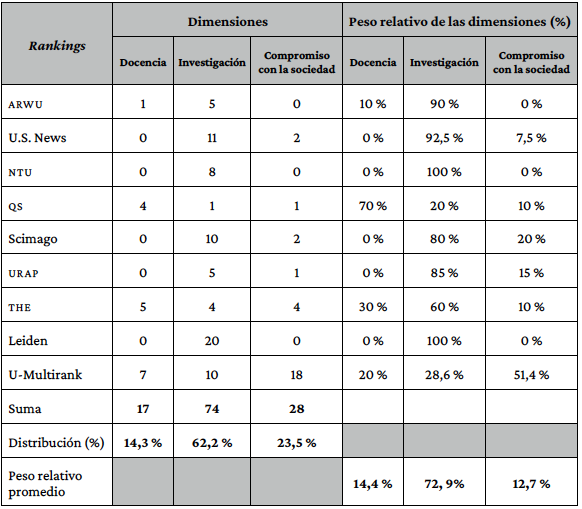

A continuación, se presentan los resultados respecto a los dos aspectos que debe contener la dimensión del desempeño de las universidades. La tabla 2 describe la manera como se refleja la condición multidimensional del desempeño en los rankings e indicadores en estudio.

Tabla 2. Dimensiones abordadas por los rankings y peso relativo.

Fuente: elaboración propia, con información extraída en 2020 desde los rankings estudiados.

De los 119 indicadores contabilizados entre los nueve rankings, el 62,2 % corresponde a la dimensión de investigación, un 23,5 % refleja el compromiso con la sociedad, mientras que la docencia es la menos representativa, con tan solo 14,3 %. Al determinar el peso relativo asignado se incrementa la importancia de la investigación, que en promedio llega a 72,9 %, en detrimento del compromiso con la sociedad, que disminuye 10 puntos. Se destaca que la mayoría de los rankings (5 de 9) no consideran la docencia como una dimensión que se deba destacar en las actividades que desarrollan las universidades. El U-Multirank es el que presenta un mejor desempeño en el ámbito de la multidimensionalidad, ya que todas las dimensiones son representadas sobre un 20 %, resaltando el compromiso con la sociedad con un 51,4 %, además de ser el que utiliza más indicadores (35), representando el 29,4 % del total. Todos los rankings consideran la dimensión de investigación, mientras que la dimensión de docencia es la menos reflejada, lo cual resulta paradójico, dado que esta es muy relevante en el desempeño de las universidades. Del mismo modo, los datos que reflejan el valor relativo de las dimensiones confirman la poca importancia que tiene la docencia. Por ejemplo, THE tiene la mayor cantidad de indicadores de docencia, pero su peso relativo es inferior; esto se constata si se observa el promedio del peso relativo, pues la investigación aumenta diez puntos en importancia relativa, mientras el compromiso con la sociedad disminuye diez puntos. ntu y Leiden no abordan la multidimensionalidad de las universidades, ya que sus indicadores pertenecen exclusivamente a una dimensión: la investigación.

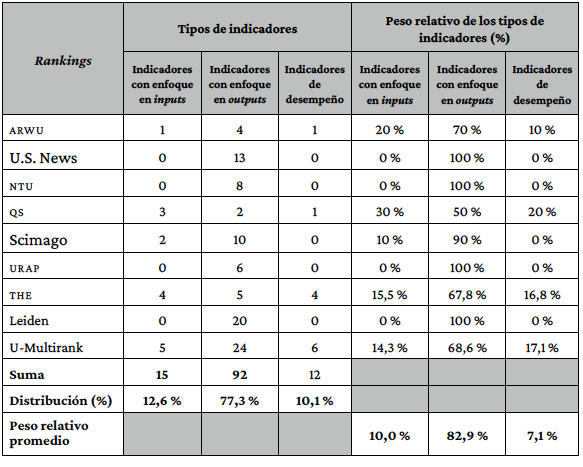

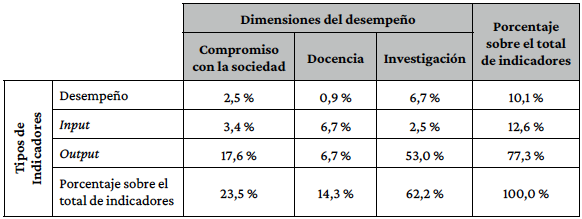

La tabla 3 refleja los distintos tipos de indicadores utilizados y clasificados con enfoque en el input, los cuales representan, entre otros, la calidad de los estudiantes, la cantidad y calidad de recursos humanos, académicos, financieros y materiales, y la infraestructura de las universidades. Los otros indicadores clasificados se enfocan en los outputs, entre los cuales se cuentan el impacto de la producción científica, la vinculación, la formación de capital humano, la transferencia de conocimiento, la colaboración y el fin del proceso académico. Este último es el que efectivamente mide el desempeño en algún ámbito de la actividad universitaria en términos de la relación output-input.

Los datos de la tabla 3 representan con claridad el bajo nivel de los indicadores de desempeño: solo 12 de 119 responden a las condiciones para ser contemplados como indicadores de desempeño, es decir, solo un 10,1 %. Sin embargo, la importancia relativa que se les otorga a esos indicadores, según el valor porcentual equivale solo al 7,1 %. Se puede concluir que el desempeño de las universidades es dimensionado parcialmente, si se considera el logro por la vía de indicadores de output, con un 77,3 % respecto a la cantidad y un 82,9 % respecto al peso relativo asignado. En cinco rankings no se considera ningún indicador de desempeño, mientras que el 83,3 % de los indicadores lo aportan dos de ellos: U-Multirank (6) y the (4). Al revisar el peso relativo de los indicadores para cada uno de los rankings, se aprecia una disminución de su relevancia en casi todas las mediciones que tienen indicadores de desempeño. El Quacquarelli Symonds Ranking es el que tiene una mayor ponderación al desempeño, llegando al 20 %.

Tabla 3. Tipos de indicadores de los rankings.

Fuente: elaboración propia, con información extraída en 2020 desde los rankings estudiados.

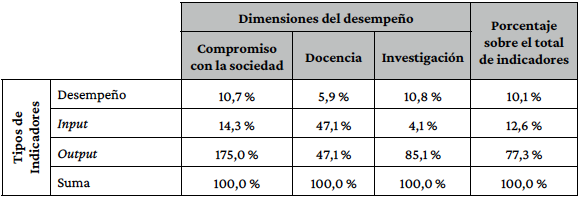

La tabla 4 presenta datos con relación a la asociación entre las variables de análisis. En estos, expresados como distribución porcentual sobre el total de indicadores, se visualiza un grado de asociación entre las dos variables (dimensión y tipo), en especial en lo que corresponde a los indicadores tipo output y la dimensión de investigación. Al aplicar la prueba Chi-2 se obtiene un valor de 23,33 (con 4 grados de libertad), con un p-valor < 0,0001. De esta manera, un nivel de significancia inferior al 1 % rechaza la hipótesis nula de independencia y aporta evidencia en favor de la hipótesis alternativa, que indicaría que las variables tienen algún grado de asociación o relación.

Es decir, la distribución del tipo de indicadores no es independiente de la dimensión de desempeño que se analiza. En la tabla hay un dato que se destaca; esto tiene que ver con el hecho de que más de la mitad de los indicadores (53 %) correspºnde a tipo output de investigación.

Tabla 4. Porcentaje de la intersección de variables con respecto al total de datos (asociación de variables).

Fuente: elaboración propia, con información extraída en 2020 desde los rankings estudiados.

Para una mejor comprensión de lo anterior, se observa en la tabla 5 la distribución de los tipos de indicadores en cada una de las dimensiones. El énfasis que existe en el tipo de indicadores en cada dimensión se puede apreciar ahora con mejor claridad, y se hace evidente que en la investigación los indicadores del tipo output representan el 85,1 %, mientras que en el compromiso con la sociedad son el 75 %.

Tabla 5. Distribución tipo de indicadores por dimensión del desempeño (asociación de tipos de variables).

Fuente: elaboración propia, con información extraída en 2020 desde los rankings estudiados.

Estos datos confirman que las actuales clasificaciones dan más cuenta de los logros o productos de las instituciones de educación superior que de una medición real sobre la efectividad. Así, desde esta perspectiva parece razonable proponer la construcción, la incorporación o el incremento de la ponderación de indicadores que midan de manera más efectiva el desempeño de las universidades.

Conclusiones

El desempeño de las instituciones de educación superior se debe considerar principalmente por los aspectos misionales y por las expectativas de las partes involucradas, de modo que su medición relacione el producto logrado (lo actuado) con los insumos puestos a disposición para tal fin, por medio de indicadores que midan la eficiencia. Dichos indicadores no son neutrales, ni en su definición ni en su interpretación, pues requieren de una cantidad considerable de datos difíciles de obtener y el entorno en el que se desempeñan las instituciones puede ser muy variado.

En este contexto surgen los rankings universitarios, que se basan en los datos disponibles que entregan dichos indicadores. La información suministrada en estas bases de datos determina cómo los diversos actores vinculados a la educación superior establecen instrumentos para la toma de decisiones, en especial para guiar a los futuros alumnos y sus familias en la elección de una institución.

Originalmente, los rankings fueron creados para medir la efectividad de las universidades, pero su divulgación ha ocasionado diversos impactos, llegando incluso en algunos casos a convertirse en mecanismos reguladores del mercado de la educación. Algunos les adjudican atributos más positivos como la medición de la calidad y el aumento de la transparencia. También se usan como un antecedente para la asignación de recursos, lo que genera distorsiones, en especial si los tomadores de decisiones les otorgan atributos que no poseen, como el hecho de ser mecanismos para medir el desempeño de las universidades.

Los datos de los nueve rankings analizados en este trabajo aportan evidencia suficiente para considerar que la mayoría no miden completamente el desempeño, ya que no recogen las dimensiones del mismo, en especial sus aspectos misionales, sino que se enfocan sobre todo en el producto logrado, es decir, en la efectividad y no en la eficiencia. Además, existe una asociación entre las dimensiones y los tipos de indicadores, principalmente entre outputs y la dimensión de investigación.

Esta investigación abre la posibilidad de diversas vertientes, entre ellas la determinación de los indicadores de desempeño que mejor representen las dimensiones misionales de las universidades, la importancia del contexto en que se desarrollan y la forma como este afecta el desempeño de las mismas, además de las posibles distorsiones que generan los rankingsen las decisiones estratégicas de los cuerpos colegiados de las universidades.